如何讓大型語言模型部署更高效?Run:ai Model Streamer的革命性突破 原創

01、概述

在人工智能的迅速發展中,大型語言模型(Large Language Models,簡稱LLMs)正成為各類應用的核心。然而,面對強大模型帶來的復雜計算需求,如何高效部署成為了一個關鍵問題。尤其是在加載模型時,大部分用戶會遭遇“冷啟動問題”——即模型從存儲器加載到GPU內存的時間延遲。這種延遲不僅影響用戶體驗,還直接影響模型的可擴展性和實時性。

針對這一挑戰,Run公司推出了一款革命性工具——Run Model Streamer。該工具通過并行處理和流式傳輸模型權重至GPU內存的方式,大幅減少了模型加載的時間。今天,我們就深入探討Run Model Streamer如何改變模型部署的游戲規則,為LLMs的未來發展帶來新的可能。

02、Run Model Streamer:突破傳統,重塑部署效率

在傳統的模型加載方式中,模型權重數據需要從存儲器逐步傳輸至CPU,再從CPU傳遞至GPU。這種串行的加載流程存在多個瓶頸,尤其在處理大規模模型時,加載時間往往較長,影響了實際使用的流暢度。

Run Model Streamer打破了這一傳統做法,通過“并行+流式傳輸”的創新思路,改變了模型權重加載的路徑。模型數據從存儲器直接流式傳輸至GPU內存,不再依賴于CPU的中轉步驟。這種改變不僅提升了加載速度,還讓GPU資源能夠更有效地得到利用。Run Model Streamer通過并行讀取模型權重的方式,大幅提高了加載效率,尤其在對大規模模型的實際應用中,具有顯著優勢。

03、Run Model Streamer的核心優勢

1. 并發處理,提升加載速度

Run Model Streamer通過使用多個線程并發地讀取模型文件,將模型權重數據高效加載至GPU,極大地減少了等待時間。這種并發處理模式通過優化存儲和GPU之間的傳輸,確保GPU在加載時不會“閑置”,從而實現更高效的利用。

2. 動態負載平衡

每個語言模型的張量大小不一,通常較大的張量文件可能會造成加載過程中的瓶頸。Run Model Streamer對各個張量的加載進行了動態分配,確保不同大小的張量在加載時得到合理分配,從而平衡了存儲帶寬的消耗。這一動態負載平衡的特點讓它在處理超大規模模型時依然能保持高效。

3. 支持多種存儲類型

Run Model Streamer兼容多種存儲解決方案,無論是本地SSD還是基于云的對象存儲(如Amazon S3)。這種多樣化的兼容性,使得它能夠適應不同企業的技術環境,進一步拓展了模型部署的靈活性。

4. 消除格式轉換帶來的性能開銷

Run Model Streamer直接支持safetensors格式,使得模型在加載時無需額外的格式轉換,節省了大量時間。這種“即拿即用”的模式,使模型加載更為簡便。

5. 易于集成,拓展性強

Run Model Streamer為用戶提供了與safetensors原生迭代器類似的API,支持并行讀取功能,與當前主流的推理引擎(如vLLM和Text Generation Inference,TGI)都可以快速整合。這種便捷的集成方式,使得Run Model Streamer適合多種模型部署場景。

04、實驗分析:Run Model Streamer vs. 傳統加載器

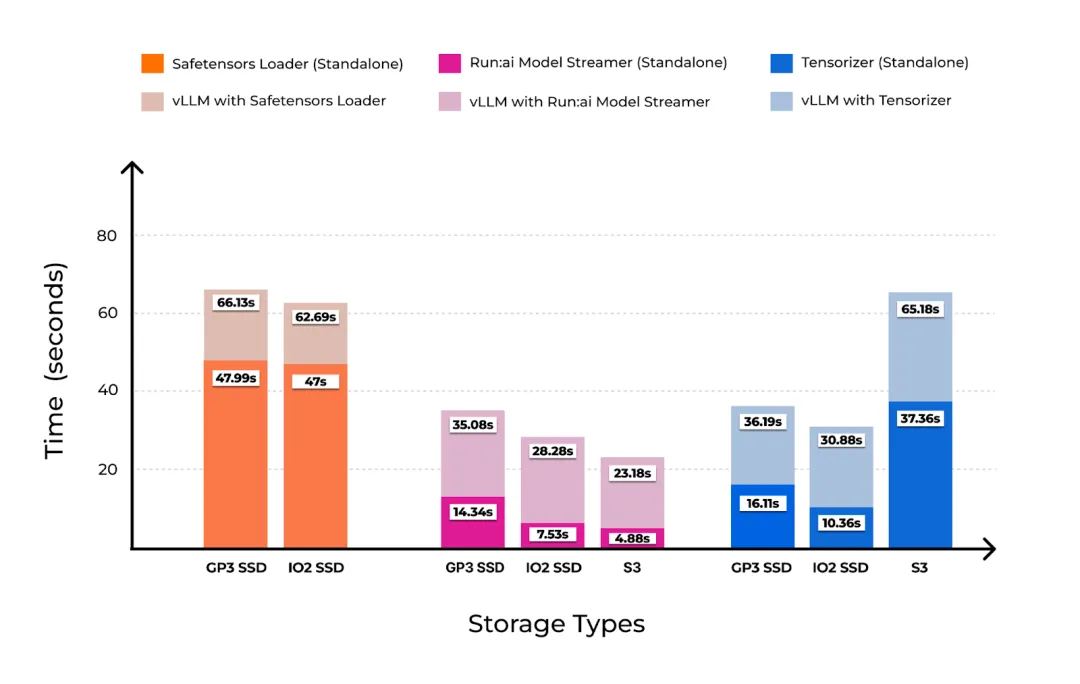

為了驗證Run Model Streamer在實際應用中的性能表現,研究團隊在一臺AWS g5.12xlarge實例上進行了詳盡的實驗。該實例配備4個NVIDIA A10G GPU,實驗使用了Meta的Llama-3-8B模型(模型大小為15GB,采用safetensors格式存儲),并且選擇了多種存儲條件以驗證其適用性,包括本地SSD和Amazon S3。

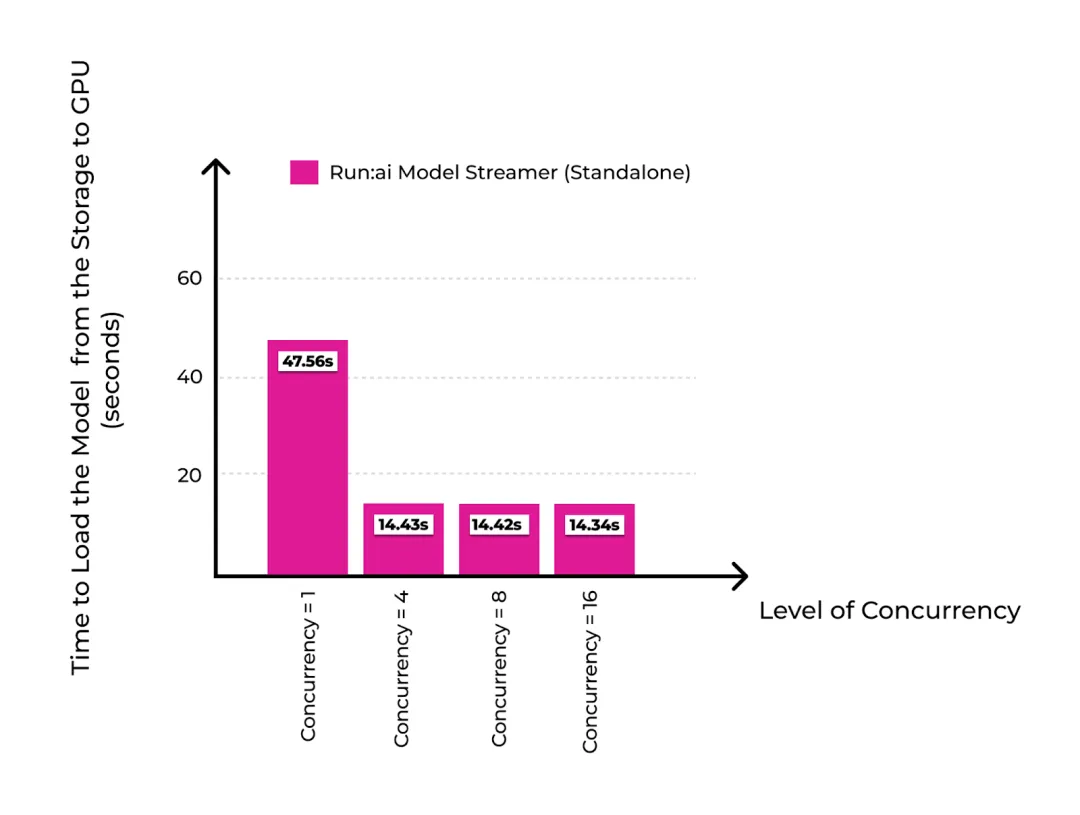

1. 在本地SSD上的表現

在使用本地GP3 SSD存儲的情況下,當并發度設置為16時,Run Model Streamer將模型加載時間從47.56秒降低至14.34秒,達到了GP3 SSD的接近最大傳輸吞吐量(1 GiB/s)。相比傳統的加載工具,Run Model Streamer顯然更具優勢。

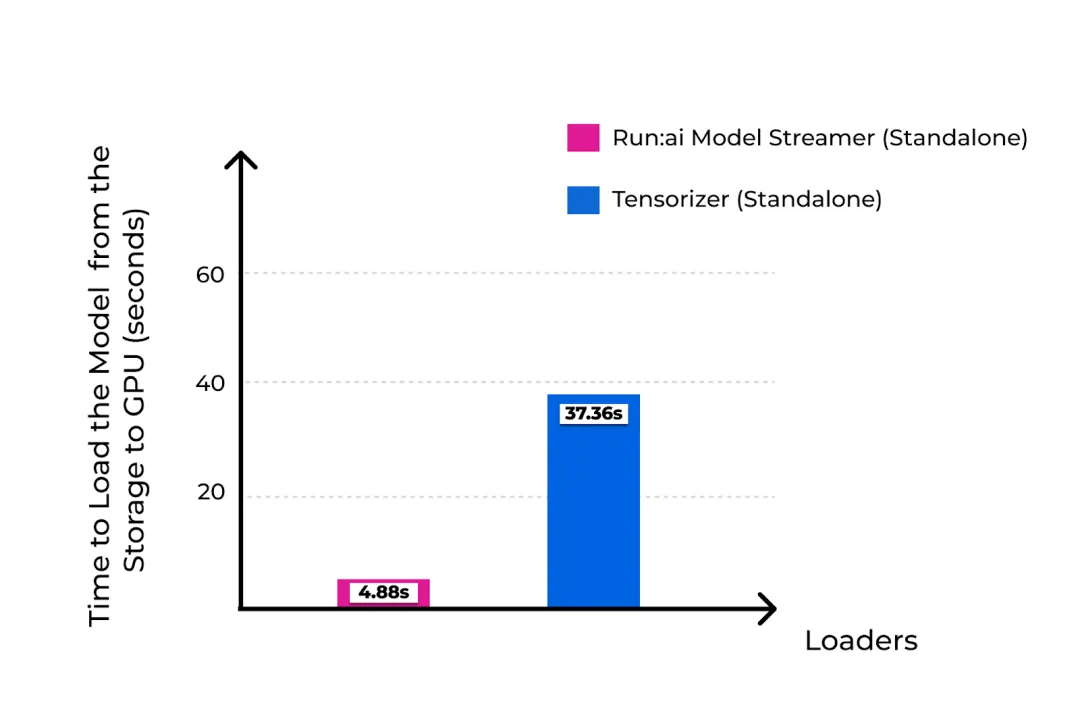

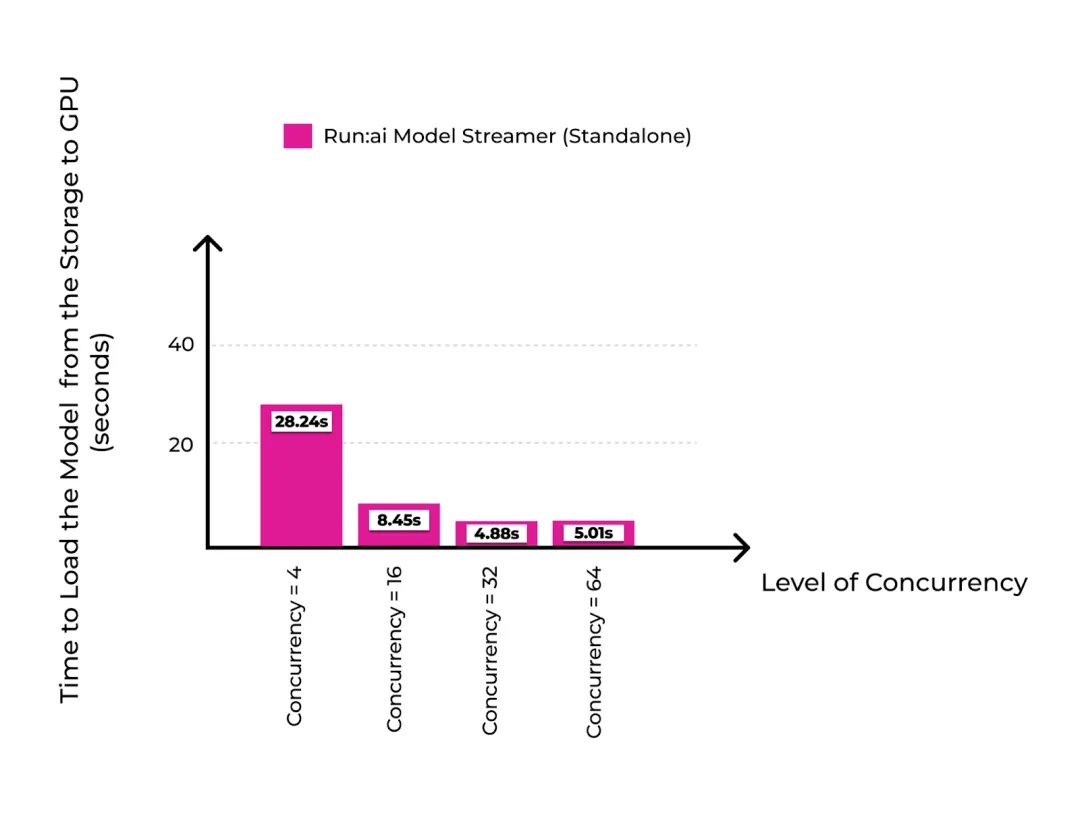

2. 在云端Amazon S3上的表現

在云存儲環境下,Run Model Streamer也表現出色。在使用Amazon S3時,實驗設置了32個并發線程,在此配置下模型加載時間僅為4.88秒,遠優于傳統加載器Tensorizer在最佳配置下的表現。這一結果表明,Run Model Streamer不僅適合本地存儲環境,同樣能在云存儲場景中保持高性能。

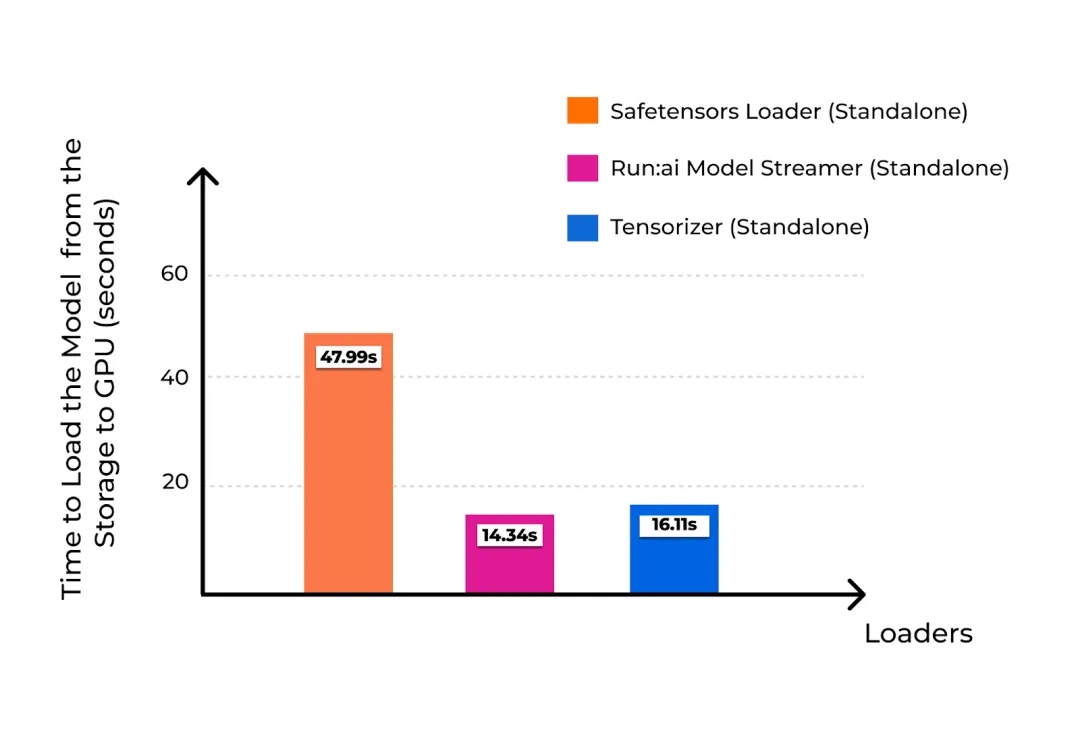

3. 與其他加載工具的對比

實驗將Run Model Streamer的加載速度與Hugging Face的safetensors loader和Tensorizer進行了比較。在多種存儲場景下,Run Model Streamer的加載時間均顯著短于其他工具,特別是在并發線程增加的情況下,性能提升更加明顯。

05、Run Model Streamer的未來展望

通過實驗結果不難發現,Run Model Streamer在大幅縮短模型加載時間方面表現出色。但其潛力并不僅限于此。以下是一些未來的擴展方向:

- 集成更多推理引擎:Run Model Streamer目前已與vLLM集成,未來還可以進一步拓展至如Hugging Face的Text Generation Inference (TGI)等推理引擎,提供更強大的推理功能。

- 支持多GPU模型并行加載:目前的實驗集中在單個GPU的加載效率上,未來Run Model Streamer可以探索多GPU并行處理的潛力,以支持更大規模的模型。

- 適配Kubernetes集群的自動擴展:在云計算環境中,通過Kubernetes集群實現彈性擴展已經成為趨勢。Run Model Streamer若能在Kubernetes環境中實現自動擴展,將進一步提升其在企業級部署中的應用價值。

- 優化存儲方案:在未來,可以針對不同的存儲方案設計更加針對性的加載優化策略,以進一步提升加載性能。

06、結語

Run Model Streamer的推出,為大型語言模型的部署提供了一個全新的解決方案。通過高效的并行處理和流式加載技術,Run

Model Streamer不僅顯著縮短了模型加載時間,還解決了傳統加載方式中存在的性能瓶頸。對于開發者和企業來說,Run Model Streamer不僅是一個加速模型部署的工具,更是降低成本、提升用戶體驗的有效方案。

未來,隨著Run Model Streamer不斷擴展至更多推理引擎、多GPU加載和Kubernetes自動擴展的場景,我們有理由期待它在AI部署領域引領更多變革。Run Model Streamer的誕生,讓LLM的部署效率邁向了一個新的臺階,為人工智能的快速落地和應用提供了強大的支持。

參考:

?

本文轉載自公眾號Halo咯咯 作者:基咯咯