超越GPT-4!香港科技大學(xué)破解Transformer算術(shù)難題,乘法準(zhǔn)確率超99.9% 精華

探索Transformer在算術(shù)問(wèn)題中的局限性

在近年來(lái)的自然語(yǔ)言處理領(lǐng)域,基于Transformer的大型語(yǔ)言模型(LLMs)取得了顯著的成就。然而,當(dāng)這些模型被應(yīng)用到看似簡(jiǎn)單的算術(shù)問(wèn)題上時(shí),它們常常表現(xiàn)出意外的掙扎,尤其是在處理基本的整數(shù)乘法任務(wù)時(shí)。例如,盡管GPT-4等現(xiàn)代LLM在多種任務(wù)中表現(xiàn)出色,但在執(zhí)行簡(jiǎn)單的整數(shù)乘法時(shí)卻遇到了困難。這種明顯的能力差異引發(fā)了人們對(duì)于這些模型安全和倫理使用的擔(dān)憂,并阻礙了它們的廣泛應(yīng)用。

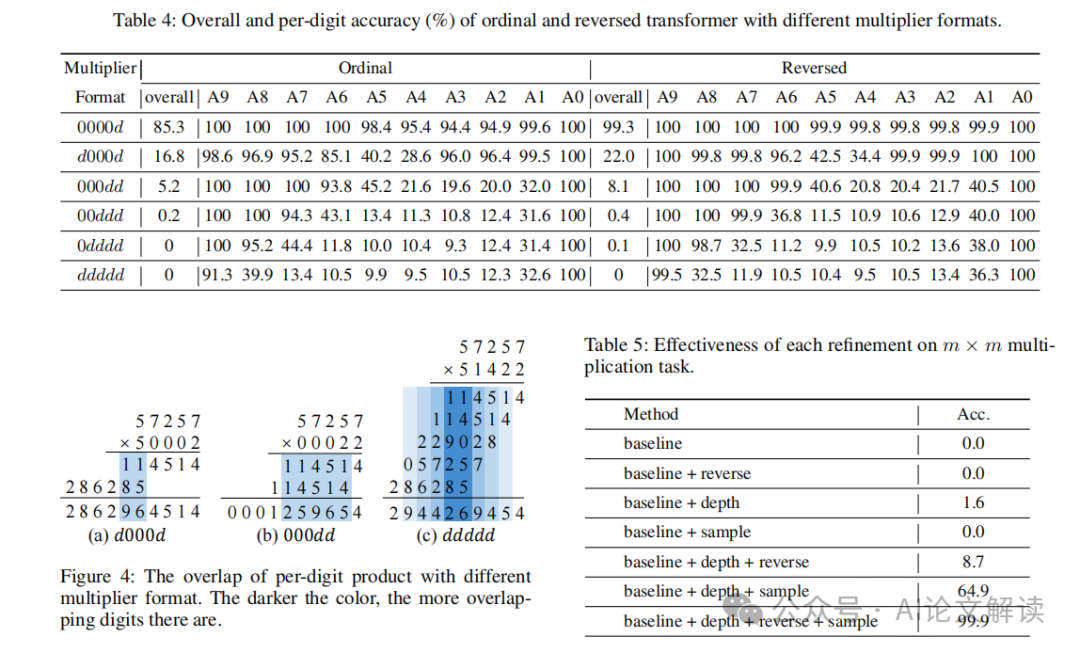

本文旨在通過(guò)探索和解釋Transformer在整數(shù)乘法任務(wù)中的不足,來(lái)深入理解這些模型在算術(shù)問(wèn)題上的局限性。我們通過(guò)對(duì)一個(gè)標(biāo)準(zhǔn)Transformer模型在n位整數(shù)乘法任務(wù)中的表現(xiàn)進(jìn)行全面分析,揭示了模型在處理連續(xù)進(jìn)位和緩存中間結(jié)果時(shí)的困難,并通過(guò)實(shí)驗(yàn)驗(yàn)證了這些推論。基于這些發(fā)現(xiàn),我們提出了改進(jìn)措施,以提升Transformer在乘法任務(wù)上的性能。這些改進(jìn)不僅增強(qiáng)了模型的解釋性,還通過(guò)嚴(yán)格的測(cè)試和數(shù)學(xué)建模得到了驗(yàn)證,例如,在5位整數(shù)乘法任務(wù)上,我們實(shí)現(xiàn)了超過(guò)99.9%的準(zhǔn)確率,超過(guò)了GPT-4等大型語(yǔ)言模型。

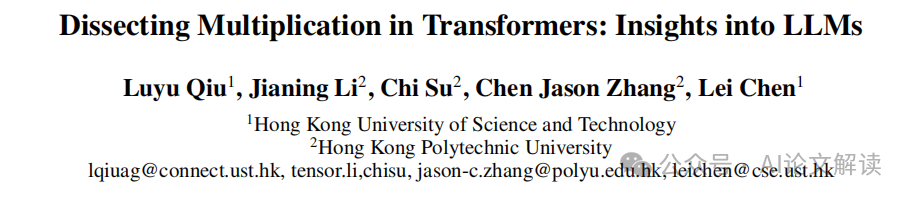

論文標(biāo)題:Dissecting Multiplication in Transformers: Insights into LLMs

機(jī)構(gòu):

- Hong Kong University of Science and Technology

- Hong Kong Polytechnic University

論文鏈接:??https://arxiv.org/pdf/2407.15360.pdf??

通過(guò)本研究,我們不僅提升了對(duì)Transformer模型在處理復(fù)雜算術(shù)任務(wù)中的理解,也為AI的安全性和可靠性研究提供了新的視角和方法論,推動(dòng)了可解釋AI(XAI)的發(fā)展,幫助構(gòu)建了對(duì)大型語(yǔ)言模型的信任,并促進(jìn)了它們?cè)陉P(guān)鍵應(yīng)用中的采用。

Transformer模型在算術(shù)任務(wù)中的表現(xiàn)

Transformer模型在自然語(yǔ)言處理任務(wù)中取得了顯著的成就,但在算術(shù)任務(wù),尤其是整數(shù)乘法方面,它們的表現(xiàn)卻常常不盡人意。盡管Transformer擁有龐大的模型能力,它在處理簡(jiǎn)單的整數(shù)乘法任務(wù)時(shí)卻表現(xiàn)出明顯的挑戰(zhàn)。這種能力的不對(duì)等引起了人們對(duì)其安全和道德使用的關(guān)注,并阻礙了其廣泛的應(yīng)用。

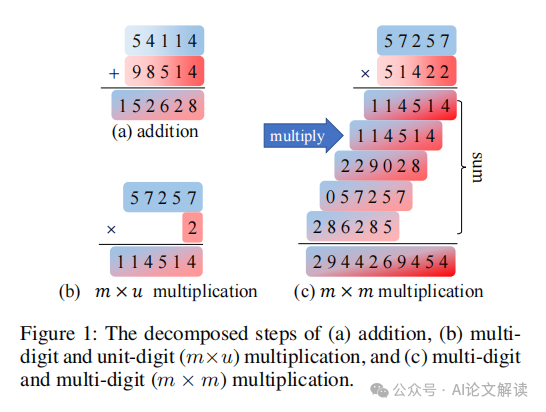

在本文中,我們專(zhuān)注于整數(shù)乘法任務(wù),探索和解釋Transformer在這一領(lǐng)域的不完美表現(xiàn)。我們對(duì)一個(gè)基本的Transformer模型進(jìn)行了全面分析,該模型被訓(xùn)練用于執(zhí)行n位整數(shù)乘法。我們的觀察表明,模型將乘法任務(wù)分解為多個(gè)并行的子任務(wù),每個(gè)子任務(wù)針對(duì)每個(gè)數(shù)字順序優(yōu)化,以完成最終的乘法計(jì)算。

基礎(chǔ)乘法分析:?jiǎn)挝粩?shù)乘法

在對(duì)Transformer在m×u(多位數(shù)乘以單位數(shù))乘法任務(wù)的表現(xiàn)進(jìn)行分析時(shí),我們發(fā)現(xiàn)Transformer利用幾個(gè)基本子任務(wù)來(lái)完成乘法計(jì)算。這些子任務(wù)包括:

基本乘法(BM):BM計(jì)算兩個(gè)單個(gè)數(shù)字在每個(gè)位置的乘積。根據(jù)是否產(chǎn)生進(jìn)位到下一個(gè)位置,BM可以分為BM(帶進(jìn)位)和BM(不帶進(jìn)位)。

使用進(jìn)位(UC):UC考慮前一個(gè)數(shù)字的進(jìn)位,并將進(jìn)位加到當(dāng)前位置的乘積上。

基于上述基本子任務(wù),Transformer可以將多個(gè)子任務(wù)鏈接在一起,實(shí)現(xiàn)復(fù)雜的功能,例如使用進(jìn)位和進(jìn)一步進(jìn)位(UCFC),考慮來(lái)自前一列的進(jìn)位,并進(jìn)一步產(chǎn)生到下一列的進(jìn)位。

總體分析

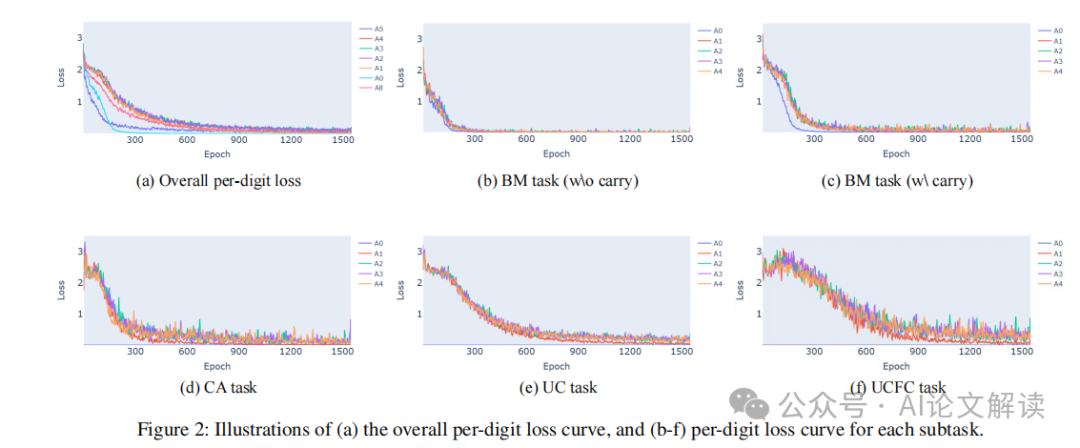

我們首先調(diào)查T(mén)ransformer如何學(xué)習(xí)每個(gè)子任務(wù)。通過(guò)觀察每個(gè)數(shù)字的訓(xùn)練損失,我們發(fā)現(xiàn)Transformer似乎是半獨(dú)立地學(xué)習(xí)每個(gè)答案數(shù)字的。單位數(shù)字(A0)和最高位數(shù)字(A5)的學(xué)習(xí)速度比其他數(shù)字快,且噪聲更少。這是因?yàn)锳0的計(jì)算不需要考慮進(jìn)位,從而簡(jiǎn)化了計(jì)算過(guò)程。與A0相比,A5的計(jì)算只需要考慮進(jìn)位。

每個(gè)任務(wù)的分析

我們進(jìn)一步分析每個(gè)子任務(wù)的訓(xùn)練數(shù)據(jù),將訓(xùn)練數(shù)據(jù)分為與每個(gè)子任務(wù)對(duì)應(yīng)的不重疊子集,并分別展示每個(gè)子任務(wù)的每個(gè)數(shù)字的損失曲線。從BM(不帶進(jìn)位)和BM(帶進(jìn)位)的訓(xùn)練曲線可以看出,所有任務(wù)開(kāi)始時(shí)損失都很高。隨著訓(xùn)練的進(jìn)行,所有損失曲線都有所下降,但不同任務(wù)之間存在“時(shí)間滯后”。BM(不帶進(jìn)位)的損失下降最快,這是因?yàn)樗撬衅渌蝿?wù)的基礎(chǔ),必須先準(zhǔn)確計(jì)算才能進(jìn)行后續(xù)計(jì)算。BM(帶進(jìn)位)和進(jìn)位損失的下降速度是第二快的,這兩個(gè)子任務(wù)是互補(bǔ)的計(jì)算,它們的收斂表明模型能夠準(zhǔn)確計(jì)算進(jìn)位。UC的損失在訓(xùn)練初期表現(xiàn)出顯著的平臺(tái)期,這符合我們的預(yù)期,即UC子任務(wù)需要準(zhǔn)確計(jì)算進(jìn)位,因此UC的損失只有在進(jìn)位任務(wù)收斂后才能下降。UCFC的損失下降最晚,因?yàn)閁CFC的計(jì)算跨越3個(gè)數(shù)字,即當(dāng)前數(shù)字的乘積、前一個(gè)數(shù)字的進(jìn)位和向下一個(gè)數(shù)字的進(jìn)位,因此其收斂發(fā)生在所有其他損失收斂之后。

從這些分析中,我們可以看出,盡管Transformer在處理簡(jiǎn)單的單位數(shù)乘法任務(wù)時(shí)表現(xiàn)出一定的能力,但在更復(fù)雜的多位數(shù)乘法任務(wù)中,其性能急劇下降,顯示出明顯的不足。這些發(fā)現(xiàn)為理解和改進(jìn)Transformer模型在算術(shù)任務(wù)中的表現(xiàn)提供了寶貴的見(jiàn)解。

多位數(shù)乘法的深入分析

在探討多位數(shù)乘法的處理中,我們發(fā)現(xiàn)轉(zhuǎn)換器(transformer)在執(zhí)行這一任務(wù)時(shí)會(huì)將其分解為多個(gè)子任務(wù),并行計(jì)算。這些子任務(wù)包括基本的數(shù)字乘法(Base Multiply, BM),使用進(jìn)位(Use Carry, UC),以及進(jìn)一步的進(jìn)位處理(Further Carry, UCFC)。通過(guò)對(duì)這些子任務(wù)的深入分析,我們可以更好地理解轉(zhuǎn)換器在處理多位數(shù)乘法時(shí)的行為模式及其局限性。

基本乘法和進(jìn)位處理

在多位數(shù)乘法中,轉(zhuǎn)換器首先處理基本的數(shù)字乘法,即單個(gè)數(shù)字間的乘法。這一步驟相對(duì)簡(jiǎn)單,但關(guān)鍵在于如何處理和傳遞進(jìn)位。例如,在乘法??47134 × 9??中,每一位數(shù)字與9相乘后的結(jié)果需要考慮前一位的進(jìn)位,這增加了計(jì)算的復(fù)雜性。轉(zhuǎn)換器在這一過(guò)程中展示了分階段學(xué)習(xí)的特點(diǎn),即先學(xué)習(xí)無(wú)需進(jìn)位的乘法,然后逐漸學(xué)習(xí)如何處理進(jìn)位。

子任務(wù)的學(xué)習(xí)順序

通過(guò)觀察損失曲線,我們發(fā)現(xiàn)轉(zhuǎn)換器在學(xué)習(xí)各個(gè)子任務(wù)時(shí)存在順序性。基本的乘法(BM)通常是最先被學(xué)習(xí)的,因?yàn)樗瞧渌?jì)算的基礎(chǔ)。隨后,轉(zhuǎn)換器學(xué)習(xí)如何處理進(jìn)位(UC),最后是更復(fù)雜的進(jìn)位傳遞(UCFC)。這種學(xué)習(xí)順序反映了任務(wù)的內(nèi)在復(fù)雜性和依賴關(guān)系。

提出改進(jìn)措施

基于上述分析,我們提出以下幾點(diǎn)改進(jìn)措施,以增強(qiáng)轉(zhuǎn)換器在多位數(shù)乘法任務(wù)上的表現(xiàn):

1. 反轉(zhuǎn)答案數(shù)字

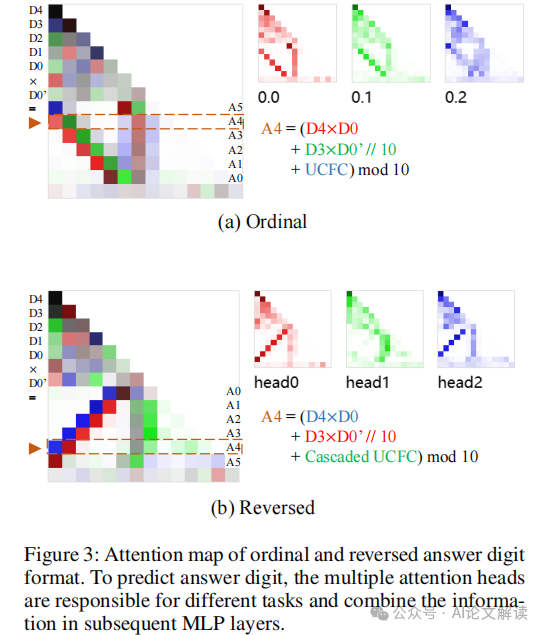

研究表明,將答案數(shù)字反轉(zhuǎn)(即從低位到高位進(jìn)行計(jì)算)可以顯著提高模型的準(zhǔn)確率。這種方法模仿了人類(lèi)計(jì)算乘法的習(xí)慣,從而使得模型能夠更有效地利用已生成的低位數(shù)字來(lái)預(yù)測(cè)高位數(shù)字。

2. 增加模型深度

多位數(shù)乘法涉及復(fù)雜的中間步驟和多層次的計(jì)算,增加模型的深度可以提供更多的層次來(lái)處理這些中間結(jié)果,從而提高準(zhǔn)確性。實(shí)驗(yàn)表明,增加深度能夠顯著提升模型在處理多位數(shù)乘法時(shí)的表現(xiàn)。

3. 增加簡(jiǎn)單樣本的比例

在訓(xùn)練初期增加簡(jiǎn)單樣本(如單一位數(shù)乘法)的比例,可以幫助模型在學(xué)習(xí)更復(fù)雜的多位數(shù)乘法前,先掌握基本的乘法規(guī)則。這種漸進(jìn)式學(xué)習(xí)策略可以減少學(xué)習(xí)難度,提高模型的整體性能。

通過(guò)實(shí)施這些改進(jìn)措施,我們能夠顯著提高轉(zhuǎn)換器在多位數(shù)乘法任務(wù)上的準(zhǔn)確率和效率,從而推動(dòng)其在更廣泛的應(yīng)用場(chǎng)景中的部署和使用。

實(shí)驗(yàn)驗(yàn)證與結(jié)果分析

1. 實(shí)驗(yàn)設(shè)計(jì)與方法

本研究通過(guò)實(shí)驗(yàn)驗(yàn)證了Transformer在整數(shù)乘法任務(wù)上的性能。我們首先使用單層解碼器僅Transformer模型在m × u(多位數(shù)乘以單位數(shù))乘法任務(wù)上進(jìn)行訓(xùn)練,并逐步擴(kuò)展到多層Transformer模型在m × m(多位數(shù)乘以多位數(shù))乘法任務(wù)上的訓(xùn)練。實(shí)驗(yàn)中,每個(gè)數(shù)字在訓(xùn)練數(shù)據(jù)中獨(dú)立采樣自均勻分布{0,1,...,9}。我們使用Adam優(yōu)化器,學(xué)習(xí)率設(shè)置為1e-4。

2. 實(shí)驗(yàn)結(jié)果

實(shí)驗(yàn)結(jié)果顯示,在m × u乘法任務(wù)上,Transformer模型能夠通過(guò)學(xué)習(xí)不同的子任務(wù)(如基礎(chǔ)乘法、使用進(jìn)位等)逐步提高預(yù)測(cè)的準(zhǔn)確性。然而,在擴(kuò)展到更復(fù)雜的m × m乘法任務(wù)時(shí),模型的準(zhǔn)確率顯著下降。這表明單層Transformer模型在處理包含多個(gè)中間步驟的復(fù)雜任務(wù)時(shí)存在局限性。

3. 結(jié)果分析

通過(guò)對(duì)不同子任務(wù)的訓(xùn)練損失進(jìn)行分析(如圖2所示),我們觀察到不同子任務(wù)的學(xué)習(xí)速度存在顯著差異。基礎(chǔ)乘法(BM)任務(wù)的損失下降最快,而涉及多個(gè)計(jì)算步驟的子任務(wù)(如使用進(jìn)位和進(jìn)一步進(jìn)位的計(jì)算)的損失下降較慢。這些觀察結(jié)果支持了我們的假設(shè),即Transformer在處理復(fù)雜的算術(shù)任務(wù)時(shí),其性能受限于對(duì)中間計(jì)算結(jié)果的處理能力。

本文轉(zhuǎn)載自???AI論文解讀??

本文轉(zhuǎn)載自???AI論文解讀??