Agent Planning大揭秘:輕松拿捏多計(jì)劃選擇!

在人工智能的世界里,我們經(jīng)常面臨一個(gè)挑戰(zhàn):如何讓機(jī)器像人類一樣,面對(duì)復(fù)雜任務(wù)時(shí),能夠生成多種可能的解決方案,并從中選擇最優(yōu)的計(jì)劃呢?這正是“多計(jì)劃選擇”(Multi-Plan Selection)要解決的問題。今天,咱們就來聊聊這個(gè)有趣的話題。

首先,想象一下,如果我們的智能Agent面對(duì)一個(gè)復(fù)雜的問題,它可能會(huì)生成多個(gè)計(jì)劃。但是,這些計(jì)劃可能各不相同,甚至有些可能根本不可行。這時(shí)候,多計(jì)劃選擇就派上用場(chǎng)了。它包括兩個(gè)主要步驟:多計(jì)劃生成和最優(yōu)計(jì)劃選擇。

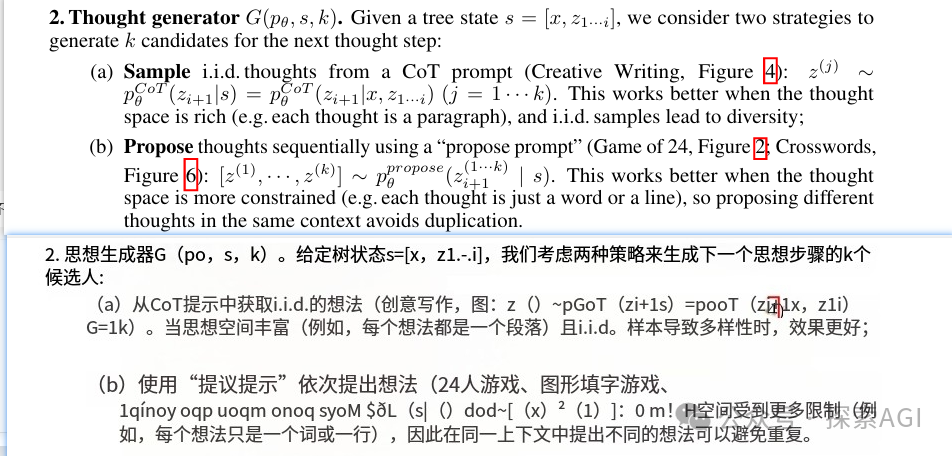

在多計(jì)劃生成階段,LLMs會(huì)嘗試生成一系列可能的計(jì)劃。這就像是在頭腦風(fēng)暴,盡可能多地提出解決方案。主流的方法會(huì)利用生成模型在解碼過程中的不確定性,比如通過溫度采樣或top-k采樣來獲得多個(gè)不同的推理路徑。在Tree-of-thought的研究中, 提到了2種生成planing的策略:sample、propose, sample策略與 Self-consistency策略一致,在解碼過程中,LLM會(huì)采樣多個(gè)plan。propose則是通過在提示中使用少量示例明確指導(dǎo)LLM生成各種plan。

接下來是最優(yōu)計(jì)劃選擇階段,這里Agent需要從多個(gè)候選計(jì)劃中選擇一個(gè)最好的。這個(gè)過程就像是在一堆方案中挑選出最閃亮的那一個(gè)。不同的策略會(huì)采用不同的啟發(fā)式搜索算法,比如簡(jiǎn)單的多數(shù)投票策略,或者利用樹結(jié)構(gòu)來輔助多計(jì)劃搜索。在Self-consistency中使用了一個(gè)簡(jiǎn)單的直覺,即復(fù)雜問題的解決方案很少且是唯一的。Self-consistency 應(yīng)用了一種樸素的多數(shù)投票策略,將得票最多的計(jì)劃視為最優(yōu)選擇。在Tree-of-Thought中利用樹狀結(jié)構(gòu)支持樹搜索算法,如傳統(tǒng)的bfs和dfs。在選擇要擴(kuò)展的節(jié)點(diǎn)時(shí),使用LLM評(píng)估多個(gè)動(dòng)作并選擇最優(yōu)的一個(gè)。

但是,多計(jì)劃選擇雖然在理論上看起來很美,實(shí)際上卻面臨著一些挑戰(zhàn)。首先,它會(huì)增加計(jì)算需求,尤其是對(duì)于大模型來說,計(jì)算成本可能會(huì)非常高。其次,依賴于LLM來評(píng)估計(jì)劃的性能,這本身還存在不確定性,需要進(jìn)一步的驗(yàn)證和調(diào)整。

不過,別擔(dān)心,盡管存在這些挑戰(zhàn),多計(jì)劃選擇的優(yōu)勢(shì)也是顯而易見的。它能夠提供更廣泛的潛在解決方案探索,幫助Agent在廣闊的搜索空間中找到最佳路徑。而且,隨著技術(shù)的發(fā)展,我們有理由相信,這些問題都將得到解決。

本文轉(zhuǎn)載自 ??探索AGI??,作者: 獼猴桃