開源視頻模型SV4D,一鍵創建8角度動態3D視頻

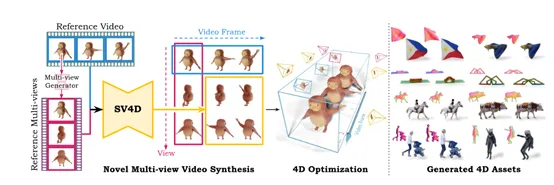

Stability.ai開源了創新視頻模型Stable Video 4D(簡稱“SV4D”),可將一個視頻輕松創建8個角度的動態3D視頻。

使用方法也非常簡單,用戶只需要上傳視頻然后選擇3D 相機姿勢,經過大約40秒左右的推理就能完成視頻創建。相比SV3D、STAG4D等同類模型,SV4D的推理效率和生成質量都獲得了大幅度提升。

開源地址:https://huggingface.co/stabilityai/sv4d

以目前的技術,用單個視頻生成動態3D視頻面臨不少難題。因為這涉及同時推理對象在未見過的相機視角下的外觀和運動,同時對單個給定視頻可能有多種合理的動態解釋進一步加大了生成難度。

此外,訓練一個能推廣到不同對象類型和運動的強大生成模型面臨兩大技術挑戰:1)缺乏大規模的動態3D對象數據集來訓練穩健的生成模型;2)問題的高維性質需要大量參數來表示對象的3D形狀、外觀和運動。

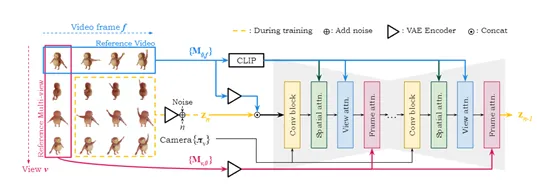

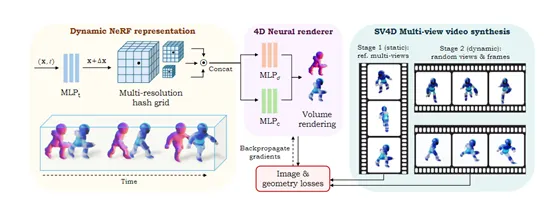

而SV4D與以往生成模型不同的是,以一個統一的擴散模型作為基礎,能夠同時處理視頻幀和視角的生成。這種架構解決了之前需要分別訓練視頻生成和新視角合成的模型,效率低下的問題,而且還保證生成內容的一致性。

在技術實現上,SV4D使用了Stability.ai之前開源的SVD和SV3D網絡結構,融合了視頻和多視角擴散模型的優勢。這個網絡結構包含一個多層的UNet,每層由一個殘差塊和三個帶有注意力層的transformer塊組成。

這些注意力層包括空間注意力、視角注意力和幀注意力,協同生成以確保生成的視頻在空間和時間上都具有高度的一致性。

視角注意力的設計是為了對每個視頻幀中的多視角圖像進行對齊,以參考視頻中的第一視角為條件。這種設計允許模型在生成新視角時,能夠保持與原始視角的一致性,從而確保了多視角視頻的連貫性。

幀注意力則進一步確保了視頻在時間維度上的連貫性,通過對每個視角的多幀圖像進行對齊,以每個視角的第一幀為條件,模型能夠生成在時間上連續且一致的視頻序列。

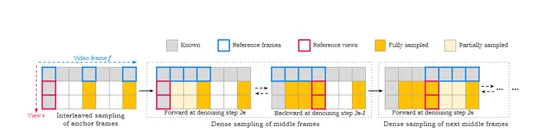

在模型訓練階段,SV4D面臨的一個關鍵難題是需要同時生成V×F的圖像網格,對于較長的輸入視頻算力會呈指數級增長。為了解決這個問題,研究人員通過順序處理交錯的輸入幀子集,同時保持輸出圖像網格的一致性。

在訓練數據方面,由于目前還沒有大規模的動態3D對象訓練數據集,研究人員就從現有的Objaverse數據集中精心整理了一個新訓練數據集ObjaverseDy。

在整理數據集時,進行大量數據篩選然后去除動畫幀數過少的對象。為了進一步過濾出運動極小的對象,研究人員對每個視頻的關鍵幀進行子采樣,并對這些幀之間的最大L1距離應用簡單閾值作為運動測量。在渲染訓練新視角視頻時,可靈活選擇相機與對象的距離,并動態調整時間采樣步驟,以確保獲得高質量的動態3D對象集合和渲染的多視角視頻。

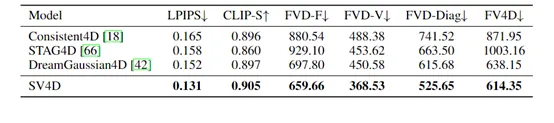

為了評估SV4D的性能,研究人員在ObjaverseDy、Consistent4D和真實世界視頻數據集DAVIS等進行了綜合測試,并與其他先進模型進行了比較。

在Consistent4D數據集上,SV4D在視頻幀一致性方面表現出色,同時保持了與其他方法相當的圖像質量。與SV3D和STAG4D相比,FVD - F分別降低了31.5%和21.4%。

在Objaverse數據集上,SV4D在視頻幀一致性和多視角一致性方面都有顯著優勢,FVD - F更低,FVD - V更好,在FVD - Diag和FV4D方面也超過了先前的先進方法,證明合成的新視角視頻在視頻幀和多視角一致性方面更好。

本文轉自 AIGC開放社區 ,作者:AIGC開放社區