登頂新SOTA!阿里新開源語音模型Qwen2-Audio ,實測優于 Gemini-1.5-pro,網友:離GPT-4o只差一步 原創

SOTA水準的Qwen2家族又迎來了新成員!

阿里云發布并開源語音模型Qwen2-Audio。

GitHub:

??https://github.com/QwenLM/Qwen2-Audio??

論文:

??https://arxiv.org/pdf/2407.10759??

作為大規模的音頻-語言模型,Qwen2-Audio能夠接受各種音頻信號輸入,并執行音頻分析或根據語音指令直接進行文字響應。

很妙的是,在Qwen2-Audio支持的語音聊天(但沒有音頻輸出)和音頻分析這兩種交互模式之間,模型可以自主判斷,并在這兩種模式之間智能地切換,無需系統提示。

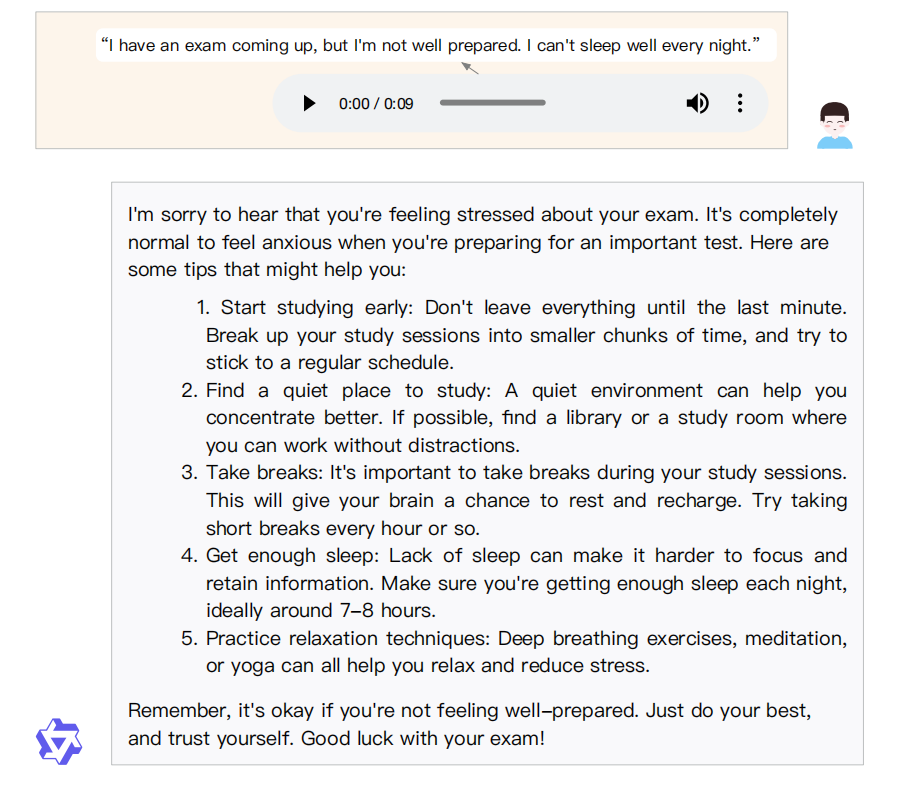

同樣讓人驚喜的是,Qwen2-Audio模型具備分析音頻情緒的能力。當用戶對模型說,自己馬上就要考試,總是睡不著覺的時候。Qwen2-Audio會識別用戶的焦慮情緒,并給予可行的建議。

圖片

圖片

1.Qwen2-Audio的兩種模式:音頻分析和語音聊天

Qwen2-Audio支持兩種截然不同的模式:音頻分析和語音聊天。

這兩種模式通過其功能區分,但模型會自動判斷,用戶無需感知和進行提示。

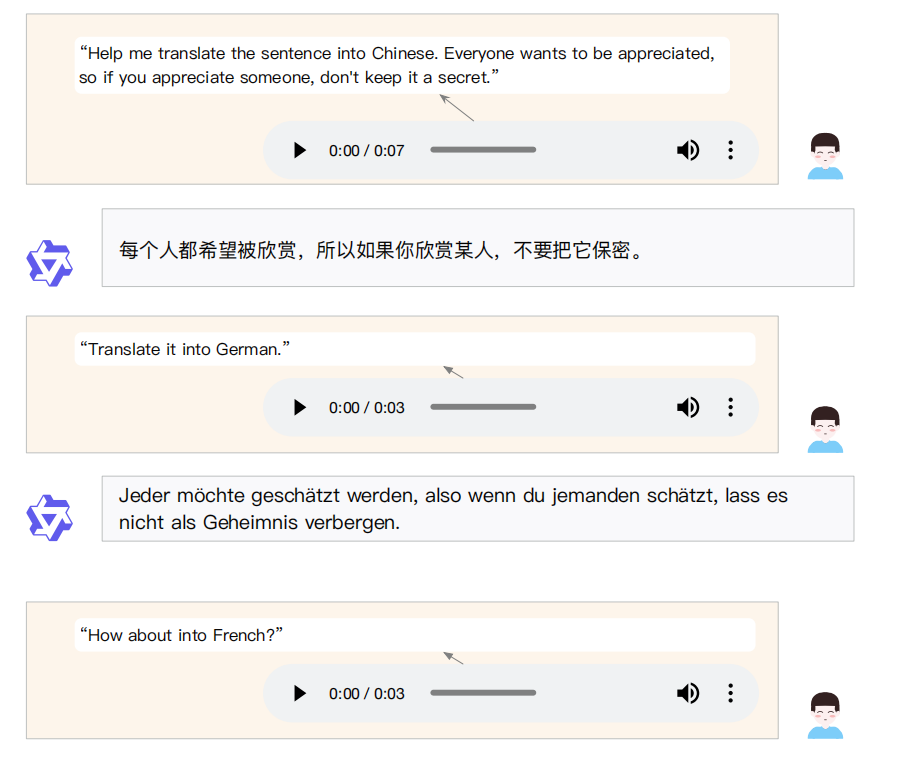

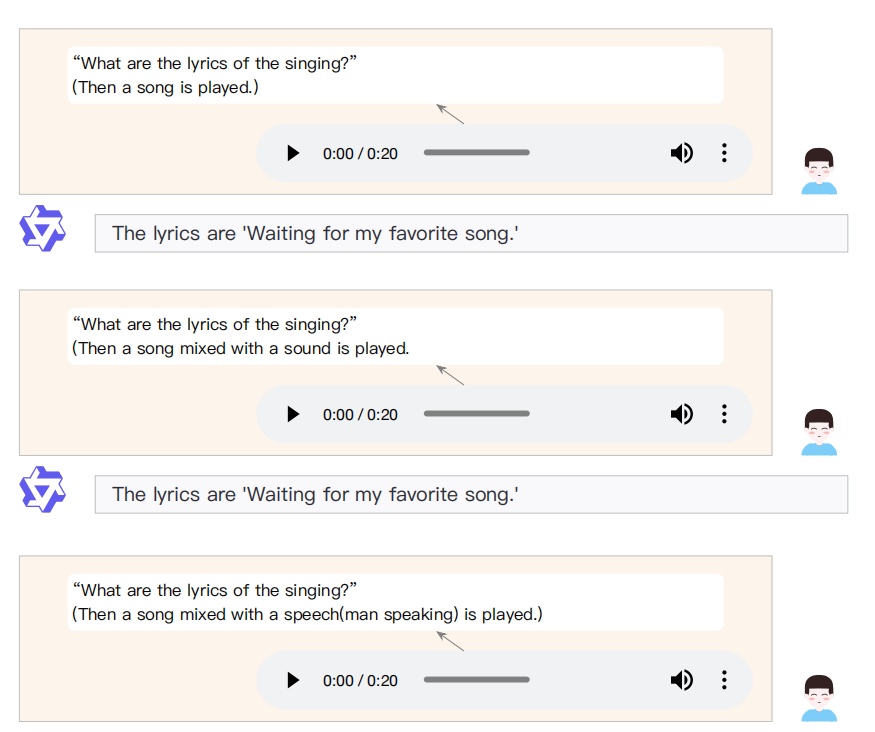

在音頻分析模式中,用戶可以利用Qwen2-Audio分析各種類型的音頻,包括語音、聲音、音樂或各種混合音頻形式。命令可以通過音頻或文本發出,Qwen2-Audio將自動識別音頻中的命令部分。

如下圖所示,Qwen2-Audio相應用戶語音發出的翻譯命令,通過文字相應完成了該任務。

圖片

圖片

而在語音聊天模式中,用戶可以與Qwen2-Audio進行交互,就像它是一個會話代理一樣,進行不受限制的對話。

音頻交互是可用的,用戶可以隨時選擇切換到文本交互。例如,如果用戶輸入一個音頻片段,其中初始部分是敲擊鍵盤的聲音,隨后用戶用口語問“這是什么聲音?”,Qwen2-Audio預計將直接回應“這是鍵盤的聲音。”

即使在較為嘈雜的環境,例如用戶一邊聽歌,一邊發出指令,讓模型提取出歌詞內容。Qwen2-Audio也能有較好的表現。

圖片

圖片

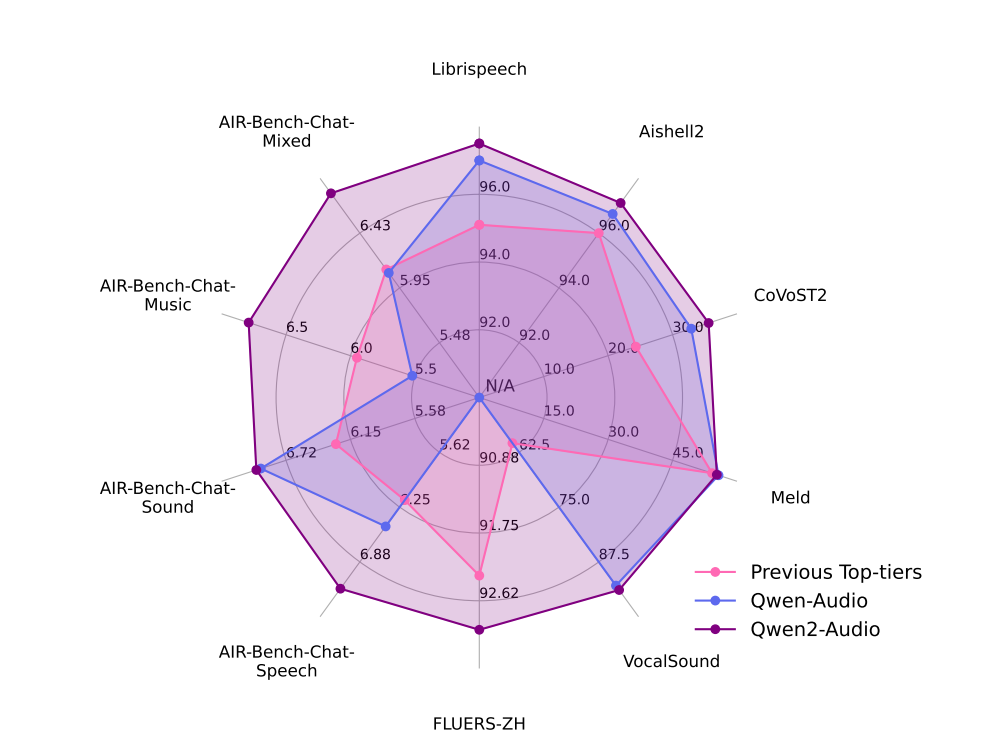

從論文中看,Qwen2-Audio在沒有特定任務微調的情況下,超越了之前的大型音頻-語言模型(LALMs),涵蓋了多種任務。

圖片

圖片

2.Qwen2-Audio是如何煉成的?

與Qwen-Audio不同的是,Qwen2-Audio的音頻編碼器基于Whisperlarge-v3模型初始化,負責將音頻信號轉換為模型可以理解的表示。

Qwen2-Audio使用了Qwen-7B作為其基礎組件,模型總參數量為82億。

在訓練素材上,Qwen2-Audio使用了多個數據集。

在對音頻數據進行預處理的階段,音頻被重新采樣到16 kHz的頻率,使用25ms的窗口大小和10ms的跳躍大小將原始波形轉換為128通道的mel-頻譜圖。

此外,還加入了一個步幅為2的池化層,以減少音頻表示的長度。最終,編碼器輸出的每一幀近似對應于原始音頻信號的40 ms段。

整個Qwen2-Audio分為三個階段:

- 第一階段:多任務預訓練,使用自然語言提示和大規模數據集進行預訓練。

- 第二階段:監督微調,通過高質量的SFT數據集進行微調,提高模型對人類指令的理解和響應能力。

- 第三階段:直接偏好優化,通過DPO進一步優化模型,使其輸出更符合人類的偏好。

3.寫在最后

Qwen2-Audio雖然很優秀,但遺憾在沒有涉及語音輸出。而無論是語音助手、情感陪伴還是更遠的具身智能,都迫切需要點亮這棵技能樹。

圖片

圖片

Sora的橫空出世,已經肉眼可見地催熟了文生視頻的模型技術。

下一個值得關注的模態,似乎正瞄準了GPT-4o,瞄準了語音交互。

根據專家預測,AI語音交互技術將在今年年底發展到基本成熟。

快手憑借可靈獲得了一片叫好,那么,語音界令我們驚艷的國產模型,又將花落誰家?

本文轉載自??51CTO技術棧??