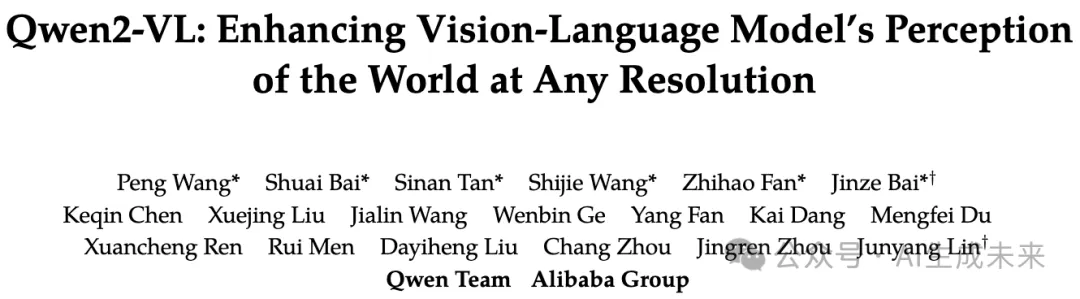

Qwen2-VL全面解讀!阿里開源多模態視覺語言模型,多項超越GPT4o與Claude 3.5-Sonnet

文章鏈接:https://arxiv.org/pdf/2409.12191

Github鏈接:https://github.com/QwenLM/Qwen2-VL

亮點直擊

本文介紹了Qwen系列大型視覺語言模型的最新成員:Qwen2-VL系列,該系列包括三款開放權重模型,總參數量分別為20億、80億和720億。如圖1所示,Qwen2-VL的關鍵進展包括:

- 在各種分辨率和寬高比上的最先進理解能力:Qwen2-VL在視覺基準測試中表現出色,包括DocVQA、InfoVQA、RealWorldQA、MTVQA、MathVista等。

- 對長時間視頻(超過20分鐘)的理解能力:Qwen2-VL能夠理解超過20分鐘的視頻,增強了其進行高質量視頻問答、對話、內容創作等的能力。

- 強大的設備操作代理能力:憑借先進的推理和決策能力,Qwen2-VL可以與手機、機器人等設備集成,實現基于視覺輸入和文本指令的自主操作。

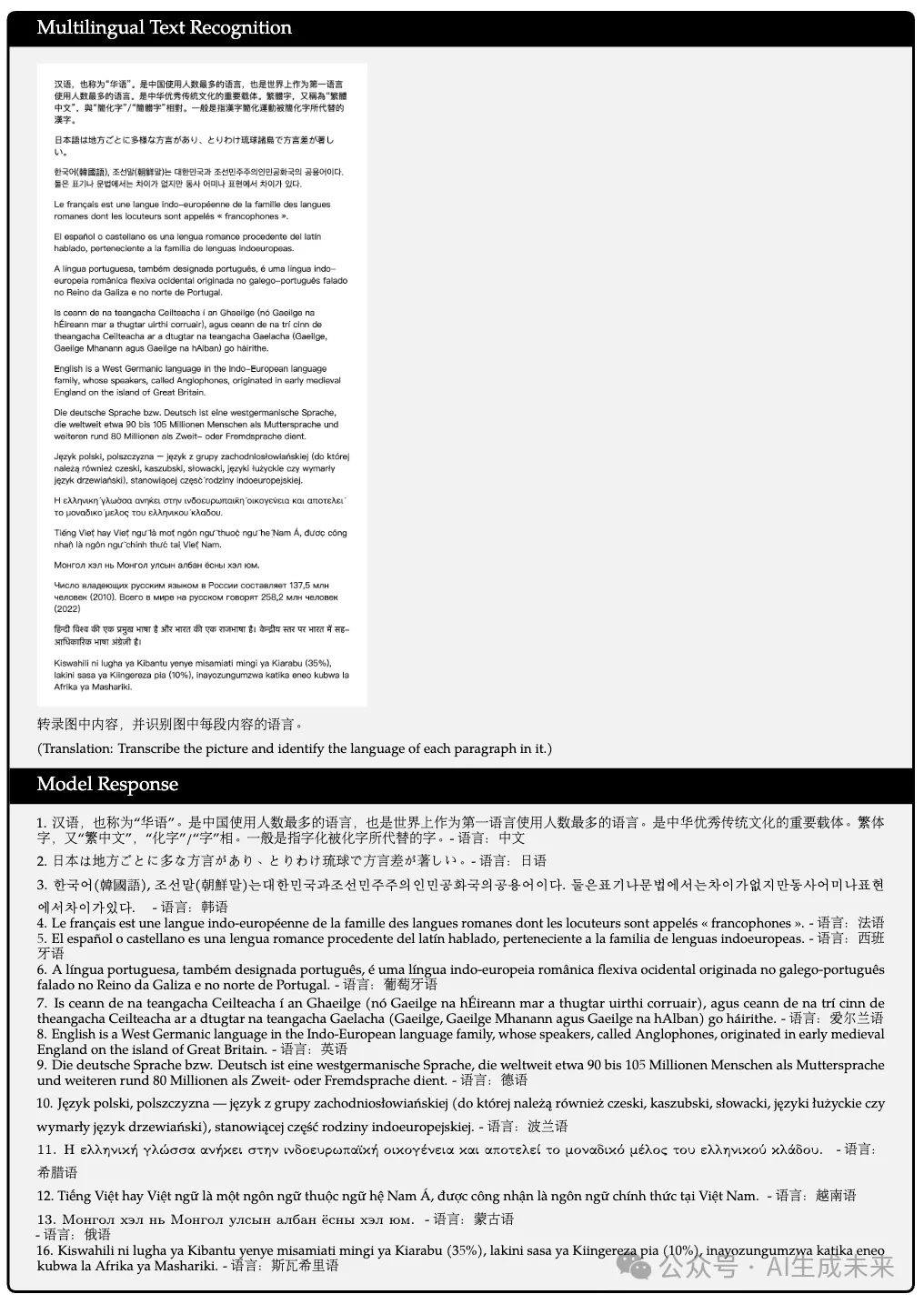

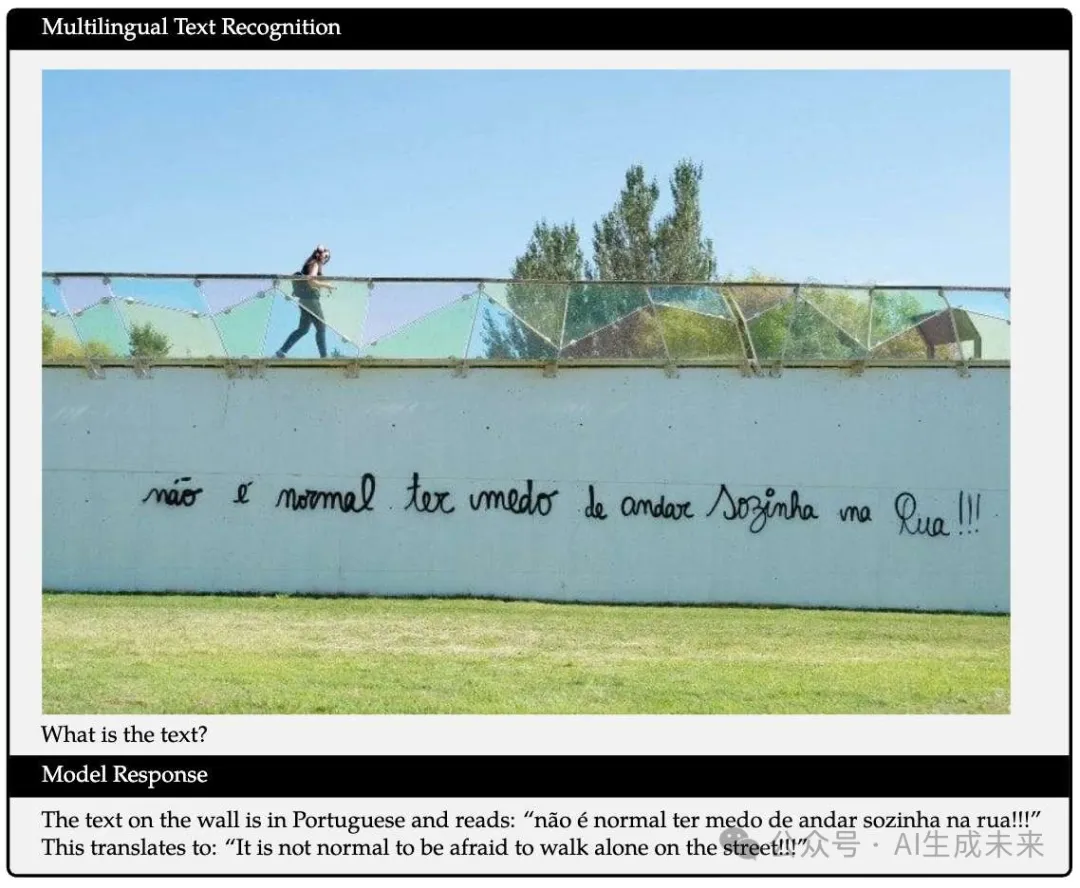

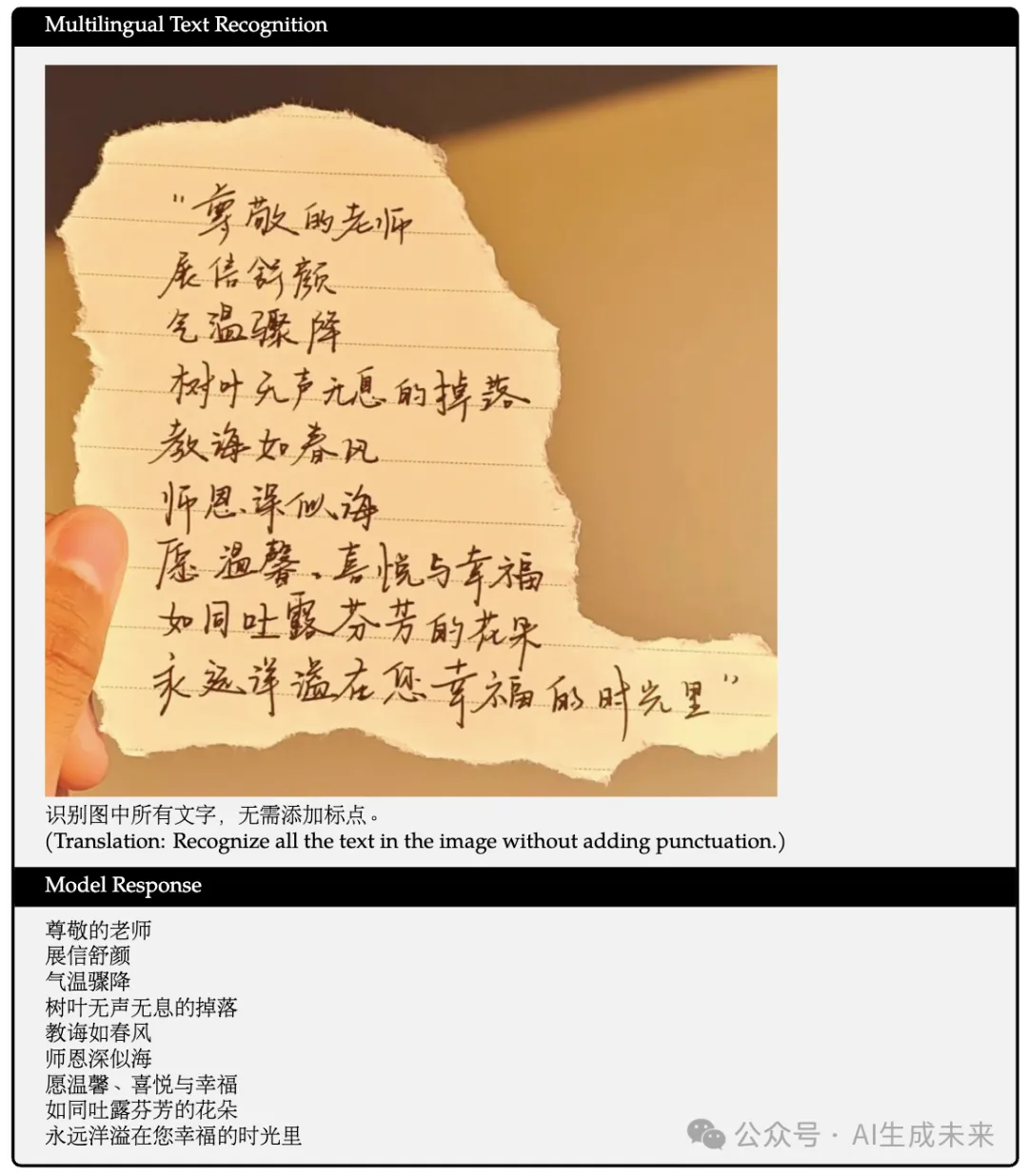

- 多語言支持:為了服務全球受眾,Qwen2-VL不僅支持英語和中文,還支持包括大多數歐洲語言、日語、韓語、阿拉伯語、越南語等在內的多語言上下文理解。

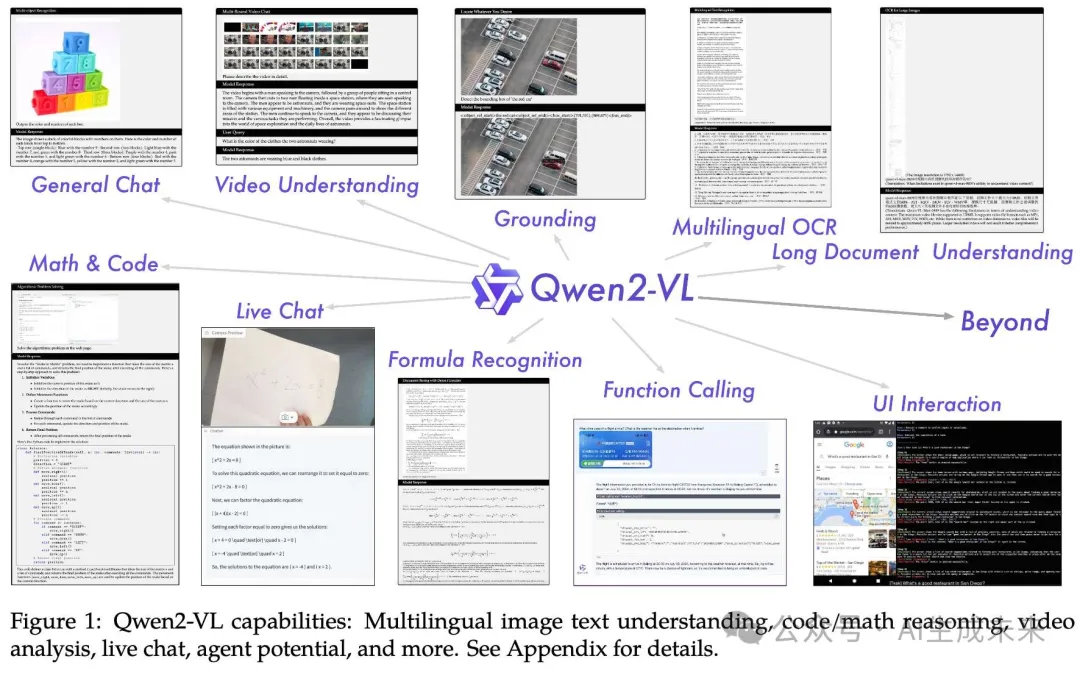

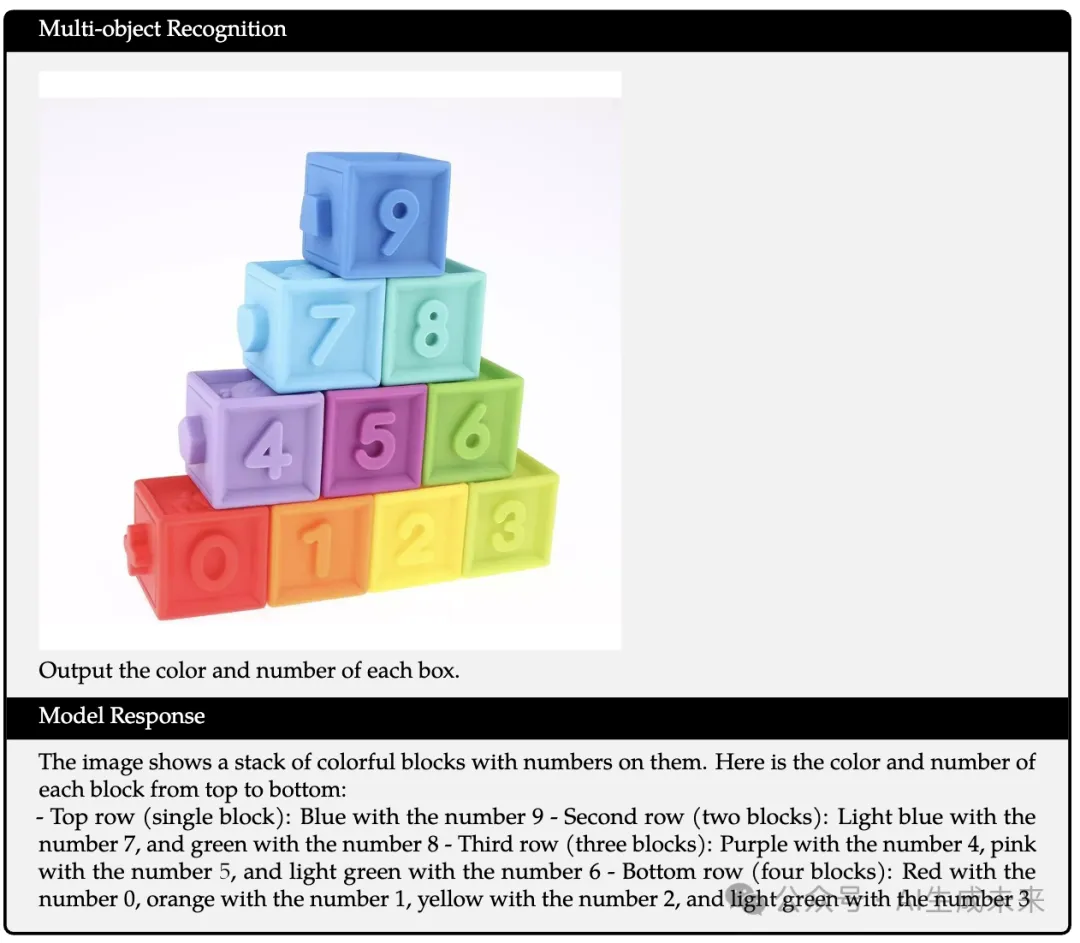

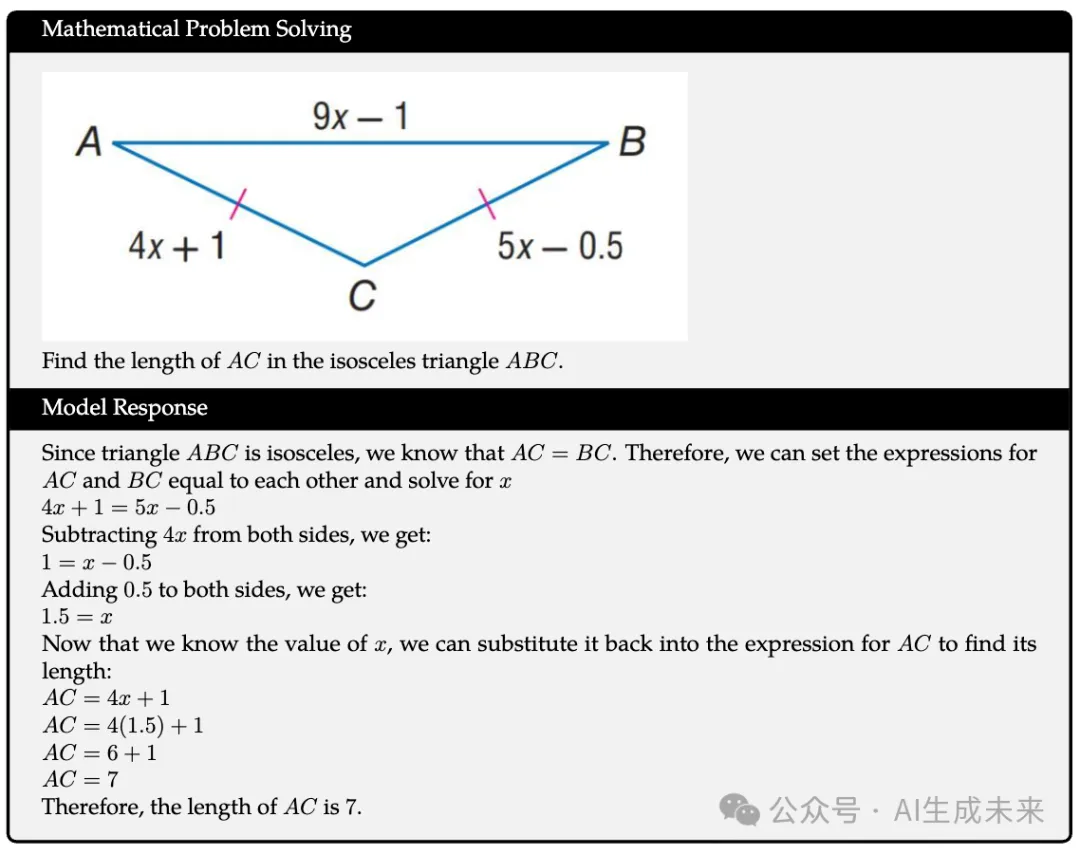

效果展示

總結速覽

解決的問題

Qwen2-VL系列旨在重新定義傳統的固定分辨率視覺處理方法,解決了在處理不同分辨率圖像時的效率和準確性問題。

提出的方案

引入了“Naive Dynamic Resolution”機制,使模型能夠動態處理不同分辨率的圖像,并生成不同數量的視覺tokens,從而提升視覺表示的效率和準確性。

應用的技術

- Naive Dynamic Resolution機制:動態處理圖像分辨率。

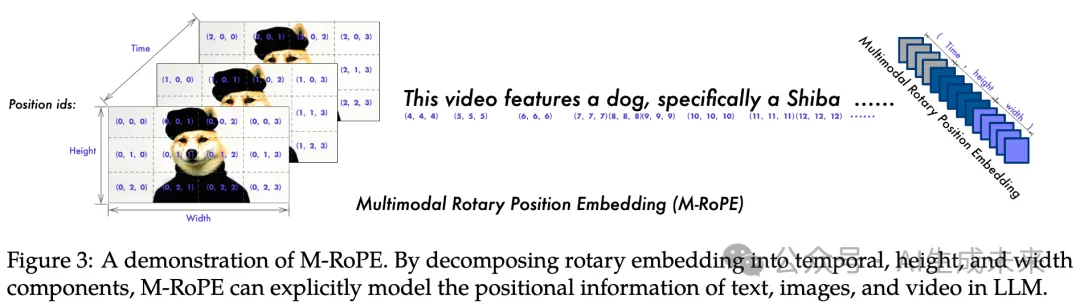

- Multimodal rotary position embedding (M-RoPE):有效融合文本、圖像和視頻的位置信息。

- 統一處理范式:同時處理圖像和視頻,增強視覺感知能力。

- 擴展規律:探索大規模視覺語言模型(LVLM)的擴展規律,通過模型大小(2B、8B和72B參數)和訓練數據的增加來提升性能。

達到的效果

Qwen2-VL系列在各類多模態基準測試中表現出色,特別是Qwen2-VL-72B模型,其性能與領先模型如GPT-4o和Claude3.5-Sonnet相當,超越了其他通用模型。

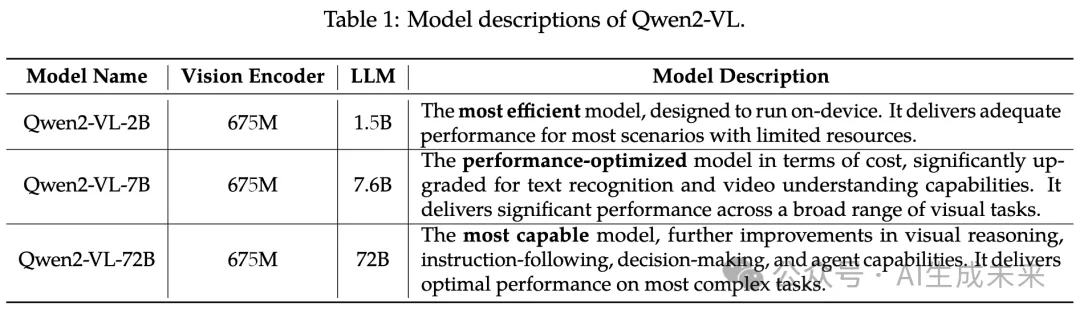

方法

Qwen2-VL系列由三種大小的模型組成,分別為Qwen2-VL-2B、Qwen2-VL-7B和Qwen2-VL-72B。下表1列出了超參數和重要信息。Qwen2-VL在各種規模的LLM中采用了675M參數的Vison Transformer(ViT),確保了ViT的計算負載在不同規模的LLM中保持恒定。

模型架構

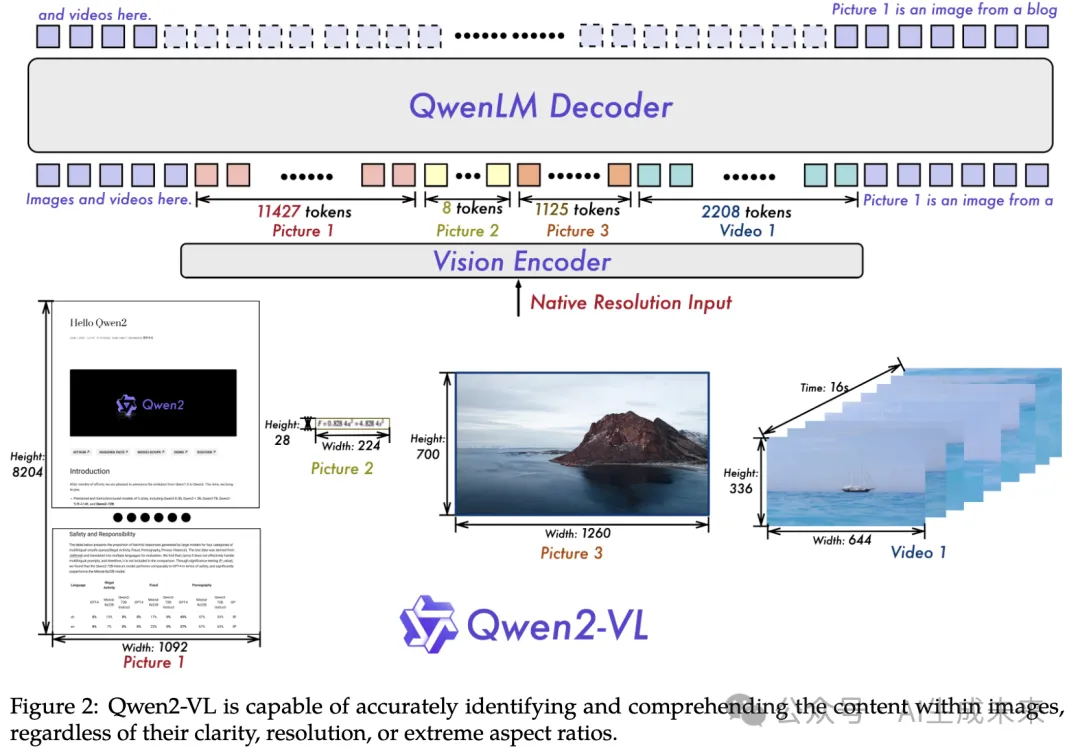

下圖2展示了Qwen2-VL的全面結構。保留了Qwen-VL框架,該框架集成了視覺編碼器和語言模型。

針對不同的規模適配,實現了一種具有大約675百萬參數的ViT,能夠處理圖像和視頻輸入。在語言處理方面,選擇了更強大的Qwen2語言模型系列。為了進一步增強模型有效感知和理解視頻中的視覺信息的能力,引入了幾個關鍵升級:

簡單動態分辨率:Qwen2-VL的一項關鍵架構改進是引入了簡單動態分辨率支持。與其前身不同,Qwen2-VL現在可以處理任意分辨率的圖像,動態將其轉換為可變數量的視覺tokens。為支持此功能,修改了ViT,去除了原始的絕對位置嵌入,并引入了2D-RoPE,以捕捉圖像的二維位置信息。

在推理階段,不同分辨率的圖像被打包成一個單一序列,打包長度受到控制,以限制GPU內存使用。此外,為減少每幅圖像的視覺tokens,在ViT后采用了一個簡單的多層感知器(MLP)層,將相鄰的2×2 token壓縮為一個token,并在壓縮的視覺tokens的開頭和結尾放置特殊的<|vision_start|>和<|vision_end|> tokens。因此,分辨率為224×224的圖像在使用patch_size=14的ViT編碼后,將在進入LLM之前壓縮為66個tokens。

Multimodal rotary position embedding (M-RoPE) 另一個關鍵架構增強是Multimodal Rotary Position Embedding(M-RoPE)的創新。與傳統的1D-RoPE(用于LLM)僅能編碼一維位置信息不同,M-RoPE有效地建模了多模態輸入的位置信息。這通過將原始旋轉embedding分解為三個組成部分:時間、高度和寬度實現。對于文本輸入,這些組件使用相同的位置ID,使得M-RoPE在功能上等同于1D-RoPE。

在處理圖像時,每個視覺token的時間ID保持不變,而高度和寬度組件則根據token在圖像中的位置分配不同的ID。對于視頻,視為一系列幀,每幀的時間ID遞增,而高度和寬度組件遵循與圖像相同的ID分配模式。在輸入包含多種模態的情況下,每種模態的位置編號通過將前一模態的最大位置ID加一來初始化。M-RoPE不僅增強了位置信息的建模,還減少了圖像和視頻的位置ID值,使模型在推理時能夠推斷更長的序列。

統一的圖像與視頻理解 Qwen2-VL采用混合訓練方案,結合圖像和視頻數據,確保在圖像理解和視頻理解方面的熟練度。為了盡可能完整地保留視頻信息,以每秒兩幀的頻率采樣每個視頻。此外,將3D卷積與深度為二的卷積結合,以處理視頻輸入,使模型能夠處理3D pipeline 而非2D塊,從而在不增加序列長度的情況下處理更多視頻幀。

為了保持一致性,每幅圖像被視為兩個相同的幀。為了平衡長視頻處理的計算需求與整體訓練效率,動態調整每個視頻幀的分辨率,將每個視頻的總tokens數限制為16384。該訓練方法在模型理解長視頻的能力與訓練效率之間取得了平衡。

訓練

遵循Qwen-VL,采用三階段訓練方法。在第一階段,專注于訓練ViT組件,利用大量圖像-文本對提升大型語言模型(LLM)的語義理解。在第二階段,解凍所有參數,使用更廣泛的數據進行更全面的學習。最后階段,鎖定ViT參數,專注于使用指令數據集進行LLM的微調。

模型在多樣化的數據集上進行預訓練,包括圖像-文本對、光學字符識別(OCR)數據、交錯的圖像-文本文章、視覺問答數據集、視頻對話和圖像知識數據集。數據源主要來自清理過的網頁、開源數據集和合成數據,數據截止日期為2023年6月。這種多樣的數據組成對發展強大的多模態理解能力至關重要。

在初始預訓練階段,Qwen2-VL接觸到約6000億個tokens。Qwen2-VL的LLM組件使用Qwen2中的參數初始化,而視覺編碼器則基于DFN的ViT初始化。原DFN ViT中的固定位置embedding被RoPE-2D替代。此階段主要學習圖像-文本關系、通過OCR進行文本內容識別以及圖像分類任務,為模型建立視覺-文本關聯的扎實基礎。

第二階段的預訓練標志著重要進展,涉及額外的8000億個與圖像相關的數據。此階段引入了更多混合圖像-文本內容,促進了對視覺和文本信息之間相互作用的更細致理解。視覺問答數據集的納入提升了模型對圖像相關查詢的響應能力,同時,多任務數據集的引入對模型同時處理多種任務的能力至關重要,這在處理復雜的現實世界數據集時尤為重要。純文本數據繼續在維持和提高模型語言能力方面發揮關鍵作用。

在整個預訓練階段,Qwen2-VL處理了總計1.4萬億個tokens,包括文本tokens和圖像tokens。然而,訓練過程中僅對文本tokens提供監督。這種對廣泛而多樣的語言和視覺場景的接觸確保模型深入理解視覺和文本信息之間的復雜關系,從而為各種多模態任務奠定堅實基礎。

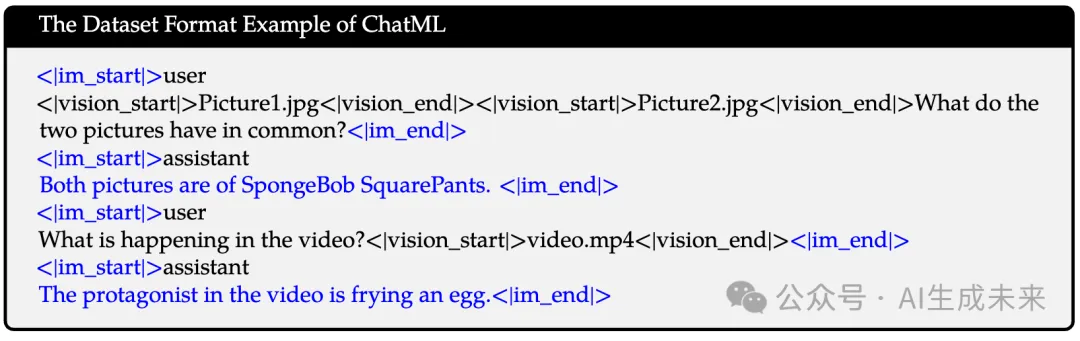

在指令微調階段,采用ChatML格式構建指令跟隨數據集。該數據集不僅包括純文本對話數據,還包含多模態對話數據。多模態組件包括圖像問答、文檔解析、多圖像比較、視頻理解、視頻流對話和基于代理的交互。對數據構建的綜合方法旨在增強模型理解和執行各種模態下廣泛指令的能力。通過納入多樣化的數據類型,希望開發出更具多樣性和魯棒性的語言模型,能夠處理復雜的多模態任務,以及傳統的基于文本的交互。

數據格式

與Qwen-VL一致,Qwen2-VL也使用特殊tokens來區分視覺和文本輸入。Tokens <|vision_start|>和<|vision_end|>插入在圖像特征序列的開始和結束,以劃定圖像內容。

對話數據 在對話格式方面,使用ChatML格式構建指令調優數據集,每個交互的陳述用兩個特殊tokens(<|im_start|>和<|im_end|>),以便于對話的結束。藍色tokens的部分表示受監督的部分。

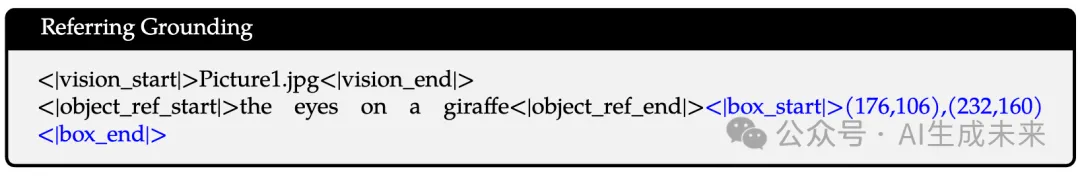

視覺定位 為了賦予模型視覺定位能力,邊界框坐標被標準化到[0, 1000)范圍內,并表示為"(, ), (, )"。Tokens <|box_start|>和<|box_end|>用于標記邊界框文本。為了準確地將邊界框與其文本描述聯系起來,引入了tokens <|object_ref_start|>和<|object_ref_end|>,以指示邊界框所引用的內容,從而使模型能夠有效地解釋和生成特定區域的精確描述。

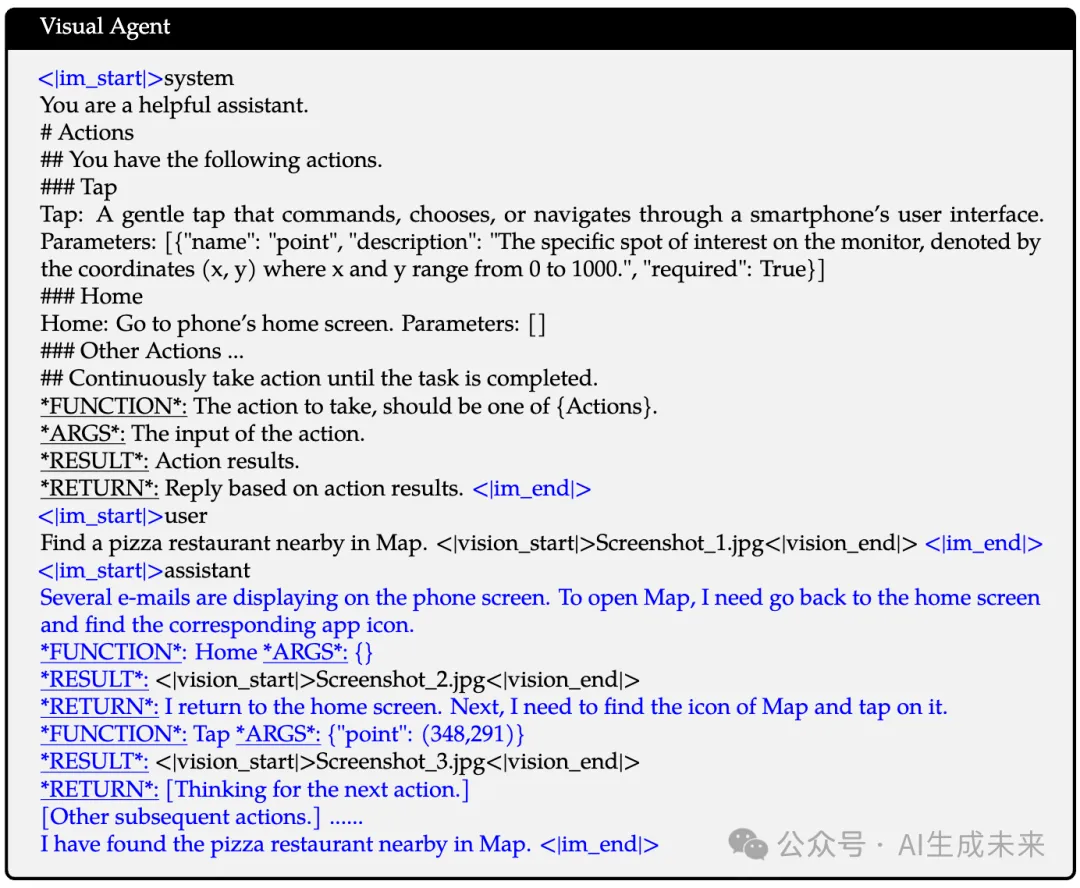

視覺Agent 為了將Qwen2-VL發展為通用的VL-Agent,將各種代理任務(如UI操作、機器人控制、游戲和導航)視為順序決策問題,使Qwen2-VL能夠通過多步行動執行來完成任務。對于每個任務,首先定義一組可允許的動作和關鍵詞模式(下劃線)以供功能調用。然后,Qwen2-VL分析觀察結果,進行推理和規劃,執行所選動作,并與環境互動以獲取新觀察。這一循環反復進行,直到任務成功完成。通過整合各種工具并利用大型視覺語言模型(LVLM)的視覺感知能力,Qwen2-VL能夠迭代執行涉及現實世界視覺交互的日益復雜的任務。

多模態模型基礎設施

Qwen2-VL模型在阿里云的PAI-Lingjun智能計算服務上進行訓練,利用其可擴展的計算、自動恢復和延遲檢測功能。

存儲 使用阿里云的超高速CPFS(云并行文件存儲)構建Qwen2-VL的預訓練和后訓練存儲系統。將文本數據和視覺數據存儲解耦。文本數據簡單地存儲在CPFS上,并使用mmap進行高效訪問。視覺數據使用阿里云的OSS(對象存儲服務)進行持久存儲。在訓練過程中,通過OSS的python-client并發訪問視覺數據,并調整并發和重試參數以避免達到QPS(每秒查詢次數)限制。視頻數據解碼是主要瓶頸,尤其是對于長視頻。在幾次嘗試開源(FFmpeg開發者)和內部軟件失敗后,研究者們選擇了緩存解碼技術。檢查點保存每個GPU的優化器和模型狀態在CPFS上。

并行性 使用3D并行性,結合數據并行性(DP)、張量并行性(TP)和 pipeline 并行性(PP)來擴展Qwen2-VL模型訓練。還利用DeepSpeed的zero-1冗余優化器進行狀態分片以節省內存。使用選擇性檢查點激活的序列并行性(SP)以減少內存使用。當啟用TP訓練時,總是將視覺編碼器和大型語言模型一起分片,但不對視覺合并進行分片,因為其參數相對較少。我們發現TP訓練會導致不同的模型共享權重,這是由于卷積操作的非確定性行為。我們通過對共享權重進行離線減少解決了這個問題,從而避免了額外的全歸約通信步驟。這種方法對性能的影響非常小。

研究者們利用1F1B PP進行Qwen2-VL 72B的訓練。我們將視覺編碼器、視覺適配器和幾個LLM的解碼器層組合為一個階段,并均勻分割剩余的解碼器層。請注意,視覺和文本序列長度對于每個數據點都是動態的。在啟動1F1B過程之前廣播動態序列長度,并使用批索引訪問形狀信息。還實現了交錯的1F1B PP,但發現其速度比標準1F1B設置慢。

軟件 使用PyTorch版本2.1.2與CUDA 11.8進行訓練。此外,在視覺編碼器和LLM的訓練中利用閃存注意力以提高效率。還利用了融合操作符,如LayerNorm、RMSNorm和Adam。此外,在訓練過程中利用矩陣乘法中的通信與計算重疊。

實驗

與現有技術的比較

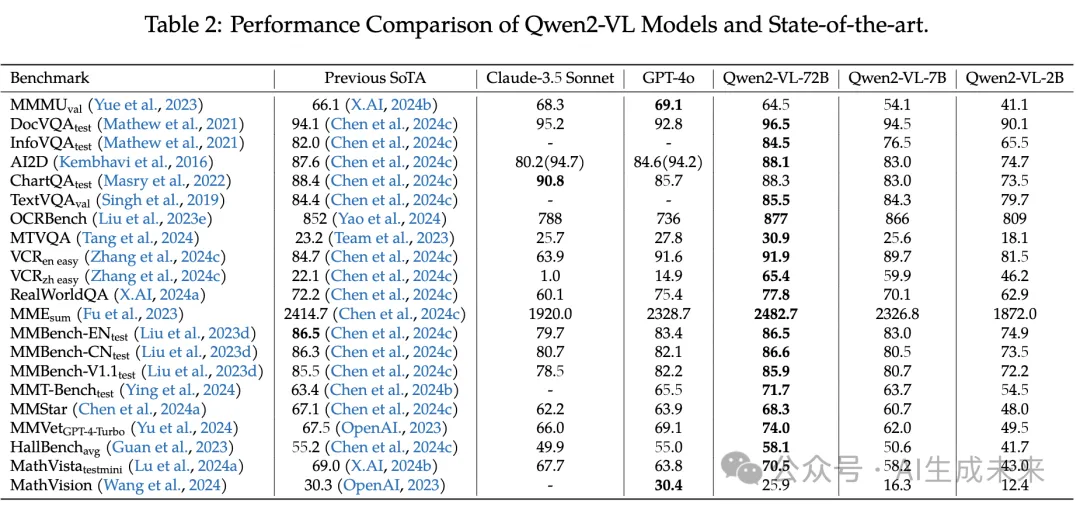

通過各種視覺基準、視頻任務和基于代理的評估來評估我們模型的視覺能力。Qwen2-VL在相同規模下表現出高度競爭力,取得了新的最先進(SoTA)結果。72B模型在大多數評估指標上始終提供頂尖性能,常常超越閉源模型,如GPT-4o和Claude 3.5-Sonnet。在文檔理解任務中,它表現出顯著優勢。然而,在MMM基準中,本文的模型在處理更復雜和具有挑戰性的問題集時仍然落后于GPT-4o,表明Qwen2-VL-72B還有改進的空間。

定量結果

對Qwen2-VL系列在多種數據集上的廣泛評估進行展示,提供對模型在各方面能力的全面理解。

一般視覺問答

為了嚴格評估本文模型在一般視覺問答任務中的能力,研究者們在多種最先進的基準上進行了廣泛評估:RealWorldQA、MMStar、MMVet、MMT-Bench、MMBench、MMbench-1.1、MME和HallusionBench。

Qwen2-VL系列在這些基準上表現出色,72B模型始終達到或超過最先進的結果,而7B和2B變體也表現出強大的能力。在評估真實世界空間理解的RealWorldQA上,Qwen2-VL-72B的得分為77.8,超過了之前的最先進(72.2)和強有力的基線,如GPT-4o(75.4),展示了其對物理環境的優越理解。

在評估真正多模態能力的MMStar基準中,Qwen2-VL-72B獲得68.3,超越了之前的最佳成績67.1,突顯了其在視覺和文本信息整合方面的能力。在MMVet上,Qwen2-VL-72B在16個復雜多模態任務中表現出色,取得了74.0,顯著超過強勁的競爭對手,包括GPT-4V(67.5),展示了其在應對多樣化多模態挑戰中的多功能性。

在評估先進推理和指令跟隨的MMT-Bench中,Qwen2-VL-72B獲得71.7,明顯超過之前的最佳(63.4),展示了其在應用專業知識和執行視覺識別、定位、推理及規劃方面的能力。在評估細粒度能力的MMBench中,Qwen2-VL-72B在英語測試集上獲得86.5,匹配了最先進的水平,而在中文測試集上取得86.6,創下新基準。對于測量14個子任務中廣泛感知和認知能力的MME,Qwen2-VL-72B獲得累計得分2482.7,顯著超過之前的最佳(2414.7),突顯了其在視覺感知和高級認知任務中的先進能力。

這些綜合結果突顯了Qwen2-VL系列在一般視覺問答任務中的卓越能力。模型在真實世界空間理解、真正多模態整合、復雜推理、指令跟隨以及廣泛的感知和認知任務方面展現出先進能力。特別是72B模型在多種基準上持續表現優越,使Qwen2-VL系列成為視覺問答領域的領先解決方案。我們的模型在處理視覺不可或缺的任務、整合核心視覺-語言能力以及在多樣化多模態場景中展現專業知識方面表現出色,涵蓋從基礎感知任務到復雜推理和規劃的廣泛能力。這一全面評估強調了Qwen2-VL系列在應對最先進多模態基準所帶來的多面挑戰中的多功能性和有效性,從而為大型視覺-語言模型設立了新的標準。

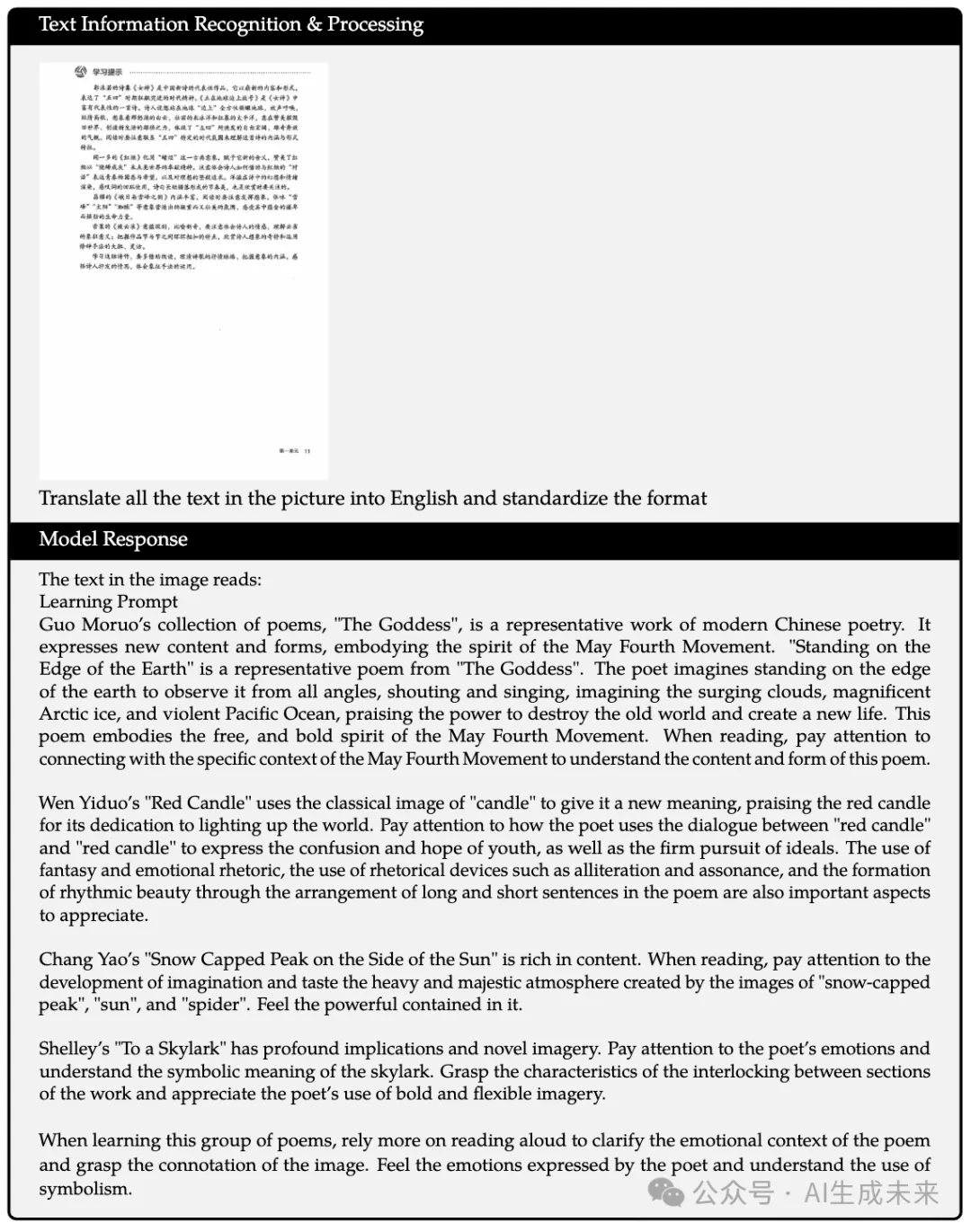

文檔和圖表閱讀

在DocVQA、ChartQA、InfoVQA、TextVQA和AI2D數據集上測試了模型的OCR以及文檔和圖表理解能力。DocVQA/InfoVQA/ChartQA數據集側重于模型理解文檔、高分辨率信息圖表和圖表中的文本能力,而TextVQA數據集考察了模型理解自然圖像中文本的能力。

OCRBench數據集是一個混合任務的數據集,除了基于文本的視覺問答外,還關注數學公式解析和信息提取。AI2D數據集側重于科學圖表中包含文本的多項選擇題。還在OCRBench上測試了模型的OCR和公式識別能力,以及在MTVQA數據集上測試了模型的多語言OCR能力。

實驗結果表明,本文的模型在多個指標上達到了最先進水平,包括DocVQA、InfoVQA、TextVQA和OCRBench,展示了模型對多個領域圖像中文本內容的良好理解能力。

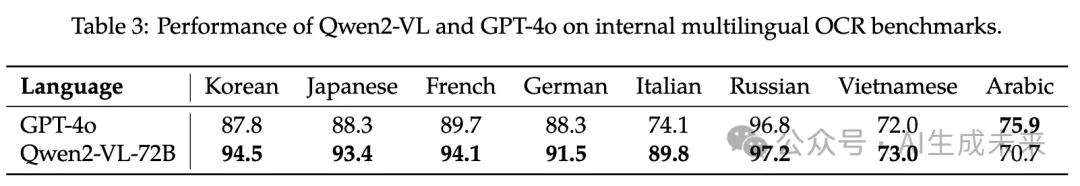

多語言文本識別與理解

在多語言OCR方面,本文的模型超越了所有現有的通用LVLM。本文的模型不僅在公開的MTVQA數據集上優于現有的LVLM(包括諸如GPT-4o、Claude 3.5 Sonnet等專有模型),還在內部基準測試中在除阿拉伯語外的所有外語上超越了GPT-4o(見下表3)。

數學推理

在MathVista和MathVision數據集上進行了實驗,以評估數學推理能力。MathVista是一個綜合基準,包含6,141個多樣的數學和視覺任務示例。MathVision數據集包括3,040個embeddings在實際數學競賽中的視覺背景下的數學問題,涵蓋16個數學學科,并在五個級別上具有不同的難度。這些挑戰強調了LVLM展現強大視覺理解、深刻數學理解和良好邏輯推理能力的必要性。Qwen2-VL系列在MathVista上表現出色,取得70.5的成績,超越了其他LVLM。此外,它在MathVision上設定了新的開源基準,得分為25.9。

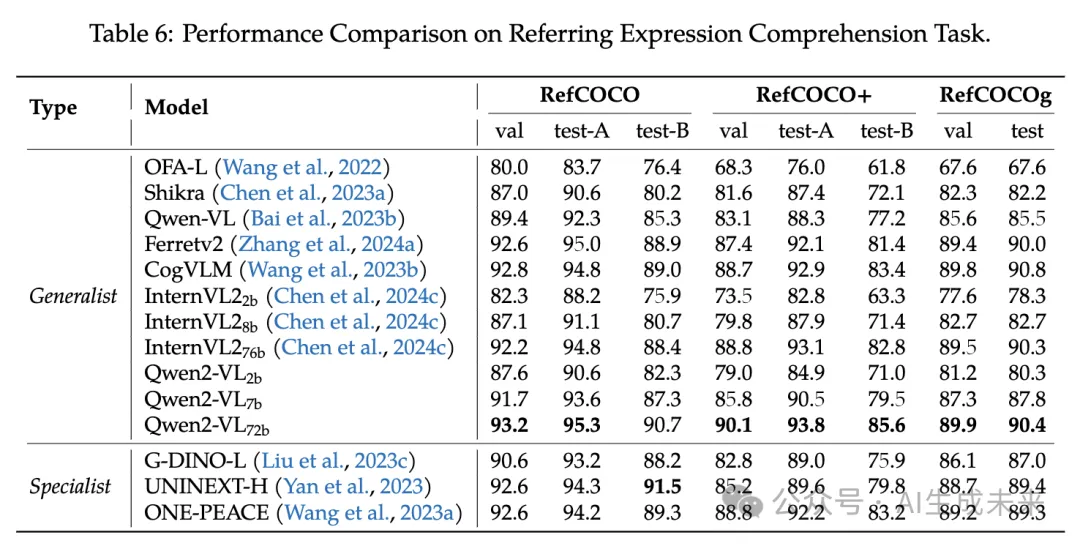

參照表達理解

在視覺定位任務方面,在RefCOCO、RefCOCO+和RefCOCOg數據集上評估了Qwen2-VL。結果如下表6所示,表明Qwen2-VL在通用模型中取得了頂級結果。得益于更合理的結構設計,Qwen2-VL能夠感知高分辨率圖像中的細節,從而顯著提高了性能。與通用和專用模型相比,這些模型的優越性突顯了它們在推進視覺定位領域和實際任務中實現精確視覺理解的潛力。

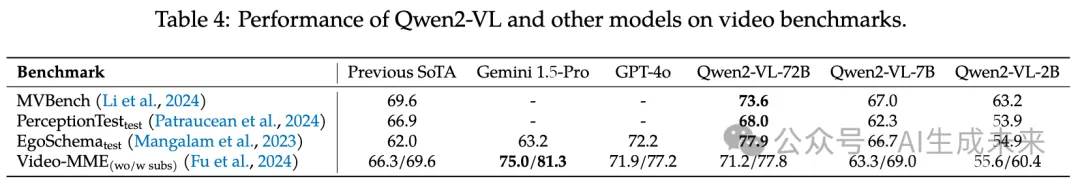

視頻理解

在各種視頻理解任務上也評估了本文的模型,相關基準覆蓋從幾秒到長達一小時的視頻。下表4展示了Qwen2-VL及基線模型的性能。總體而言,Qwen2-VL在2B、7B和72B尺寸上表現強勁,其中Qwen2-VL-72B在MVBench、PerceptionTest和EgoSchema上取得了最佳性能。這展示了Qwen2-VL在視頻理解任務中的優越能力,并且擴大Qwen2-VL的規模帶來了顯著的提升。對于具有挑戰性的Video-MME基準,該基準包括最長可達一小時的視頻,值得注意的是,我們在評估過程中將每個視頻提取的最大幀數限制為768,這可能影響了在較長視頻上的表現。未來的工作將集中在擴展Qwen2-VL以支持更長的序列,從而適應更長的視頻。

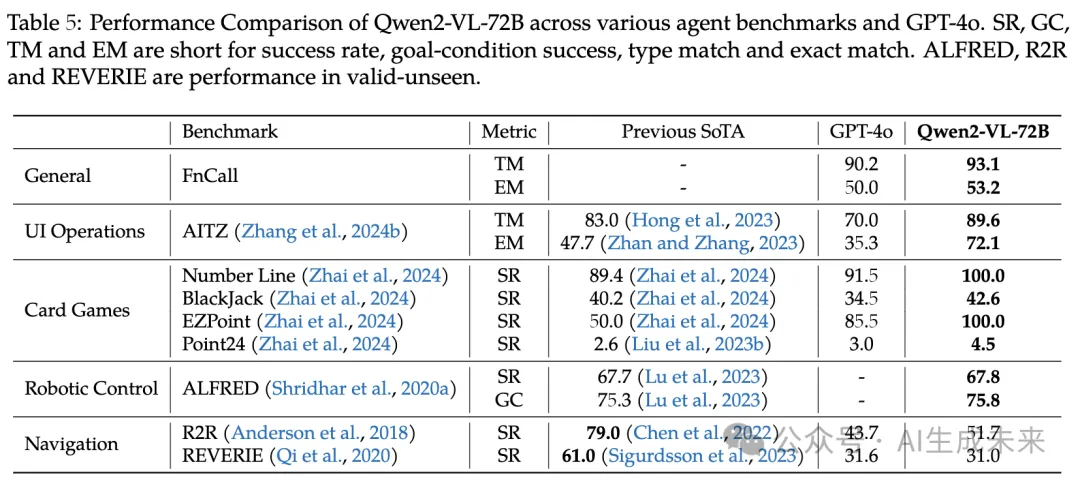

視覺智能體

首先評估Qwen2-VL在通過函數調用與環境互動的能力,然后評估其通過多輪交互完成復雜決策任務的能力。該實現基于Qwen-Agent框架。

函數調用 與LLM中的函數調用不同,LVLM中的函數調用通常涉及從視覺線索中提取信息。由于缺乏評估LVLM在函數調用能力方面的公共基準,我們構建了內部評估數據集。

為構建評估數據集,進行了以下程序:場景分類、圖像收集、圖像內容提取,以及問題/函數/參數生成。首先,我們根據不同的視覺應用將場景分類。隨后,從互聯網上下載并精心選擇每個類別的高質量代表性圖像。利用先進的LVLM,分析每張圖像以提取關鍵視覺元素和文本信息。最后,基于圖像的內容信息,使用先進的LLM生成一系列需要特定函數回答的問題,并指定這些函數調用所需的輸入參數。

研究者們設計了兩種指標來評估函數選擇的準確性和參數輸入的正確性:類型匹配(Type Match,TM)和精確匹配(Exact Match,EM)。

下表5所示,Qwen2-VL在Type Match(93.1對90.2)和Exact Match(53.2對50.0)上的表現優于GPT-4o,這證明了Qwen2-VL在函數調用能力上的有效性,凸顯了其通過外部工具集成擴展應用的顯著潛力。評估結果表明,GPT-4o的表現不佳,主要由于兩個因素:在不確定性場景中,GPT-4o表現出保守的態度,避免使用外部工具。此外,Qwen2-VL在光學字符識別(OCR)能力方面也優于GPT-4o,尤其是在中文字符的處理上。

用戶界面操作/游戲/機器人/導航 為了評估Qwen2-VL處理復雜任務的能力,在多個視覺語言代理任務上進行了評估,包括移動操作、機器人控制、紙牌游戲和視覺語言導航等。由于這些任務需要多次行動才能完成,通過Qwen2-VL支持32K上下文長度來保留歷史(觀察、動作),然后在每次行動后附加新的觀察圖像,以實現對后續步驟的連續推理。

用戶界面操作使用AITZ任務評估Qwen2-VL,該任務構建了一個基于AITW的核心干凈測試集。根據手機的常見操作模式,為Qwen2-VL定義了諸如點擊、輸入和滑動等操作,以便其與屏幕圖標進行交互以完成任務。例如,當Qwen2-VL被要求通過Google地圖尋找附近的披薩餐廳時,它應在搜索框中輸入“pizza”,滑動選擇適當的餐廳,并點擊對應的鏈接。根據AITZ設置,報告了操作類型匹配(點擊、輸入或滑動的正確性)和精確匹配(點擊位置、輸入文本或滑動方向的正確性)。借助于用戶界面的基礎能力,Qwen2-VL超越了GPT-4和之前的最新技術水平。

機器人控制 在AI2THOR的ALFRED任務中評估Qwen2-VL。該任務要求智能體執行復雜的家庭任務,例如烤面包和切蘋果以準備餐點。為了在虛擬環境中工作,定義了高層次的動作(GotoLocation、Pickup、PutDown、Open、Close、Clean、Heat、Cool、Slice)作為動作集。此外,智能體需要定位可操作的物體(例如,只有在識別到蘋果時才能拾取它)。為提高操作準確性,整合了SAM。ALFRED任務報告任務成功率(SR)(例如,準備晚餐)和子目標完成率(GC)(例如,面包是否被烤熟或蘋果是否被切)。

紙牌游戲 利用來自RL4VLM的紙牌游戲環境來評估Qwen2-VL在一系列紙牌游戲中的表現:Number Line、BlackJack、EZPoint和Point24。每個游戲提出了不同的挑戰:

- 通過+1或-1操作達到目標數字;

- 抽取或保留牌與莊家競爭;

- 應用基本算術運算達到總數12;

- 使用算術運算達到總數24。

報告任務的成功率,這不僅評估了智能體的能力,還需要強大的OCR技能來識別這些牌并理解游戲進程。Qwen2-VL在所有任務中表現優越。

視覺語言導航 在視覺語言導航(VLN)任務中評估Qwen2-VL,使用R2R和REVERIE。在VLN中,模型必須根據指令和當前觀察自主確定下一個位置。我們報告該任務中到達預定目的地的成功率(SR)。Qwen2-VL的表現與GPT-4o相當,但兩者都顯著落后于當前專門的VLN模型。將這一差距歸因于模型從多個圖像生成的不完整和非結構化的地圖信息。在三維環境中準確建模地圖和位置仍然是多模態模型面臨的重大挑戰。

消融研究

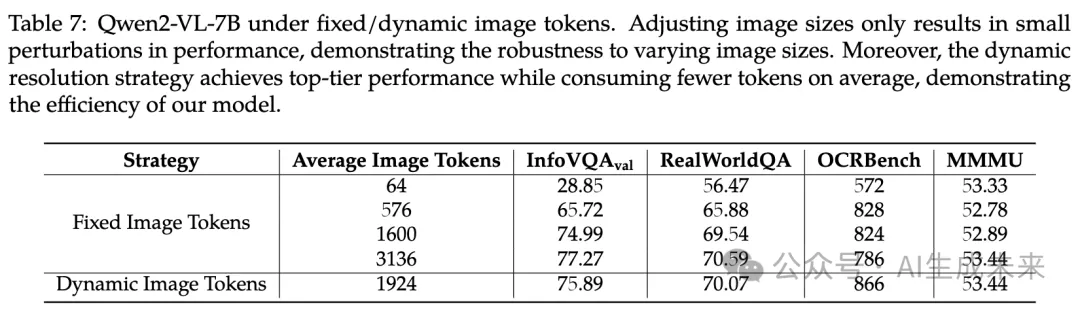

本節展示了關于圖像動態分辨率、M-RoPE和模型規模的消融研究。這些實驗旨在提供這些關鍵組件對模型性能影響的深入見解。

動態分辨率

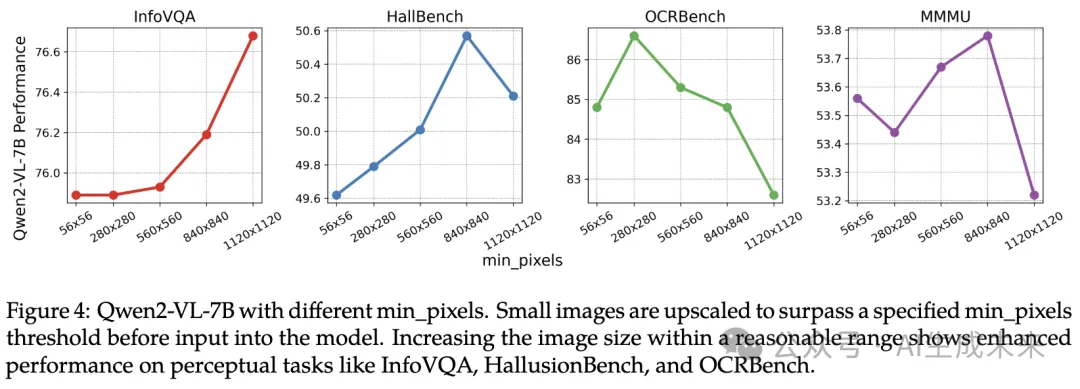

如下表7所示,比較了動態分辨率與固定分辨率的性能。在固定分辨率下,調整圖像大小,以確保輸入到模型的圖像tokens數量保持恒定,而不是調整到特定的高度和寬度,因為這會扭曲原始寬高比。在動態分辨率中,我們僅設置了min_pixels=100 × 28 × 28和max_pixels=16384 × 28 × 28,允許圖像tokens的數量主要依賴于圖像的原始分辨率。可以觀察到,調整圖像大小僅導致性能的小幅波動,表明模型對不同圖像大小的魯棒性。此外,動態分辨率的方法效率更高。我們發現沒有單一固定分辨率在所有基準測試中都能達到最佳性能。相比之下,動態分辨率方法在平均消耗更少tokens的情況下,始終實現頂級性能。

單純增加圖像大小并不總是導致性能的提升。選擇適當的分辨率對不同圖像更為重要。如下圖4所示,將小圖像放大到超過指定的min_pixels閾值。對放大圖像的評估顯示,在InfoVQA、HallusionBench和OCRBench等感知任務上性能增強。我們將這些增益歸因于增加的計算負載。然而,對于OCRBench,過高的min_pixels值導致嚴重的性能下降。這可能是因為OCRBench包含許多極小的圖像,過度放大會使這些圖像偏離訓練數據分布,變成超出分布的樣本。相反,增加min_pixels對MMMU基準的影響微乎其微。我們假設MMMU的性能瓶頸與模型的推理能力關系更大,而非圖像分辨率。

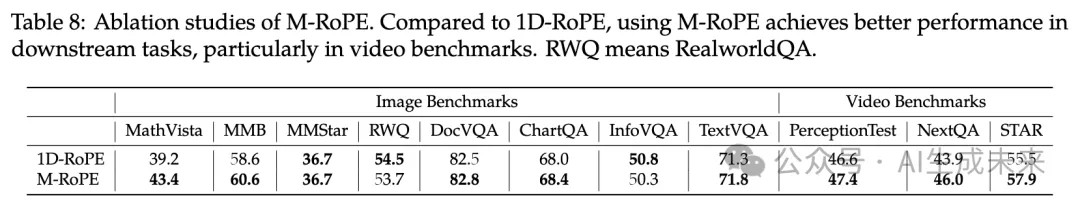

M-RoPE

本節展示了M-RoPE的有效性。首先,驗證其在各種下游任務中的能力。采用Qwen2-1.5B和ViT-L作為基礎,并報告預訓練模型的結果。如下表8所示,與1D-RoPE相比,使用M-RoPE在下游任務中表現更佳,特別是在視頻基準測試中。

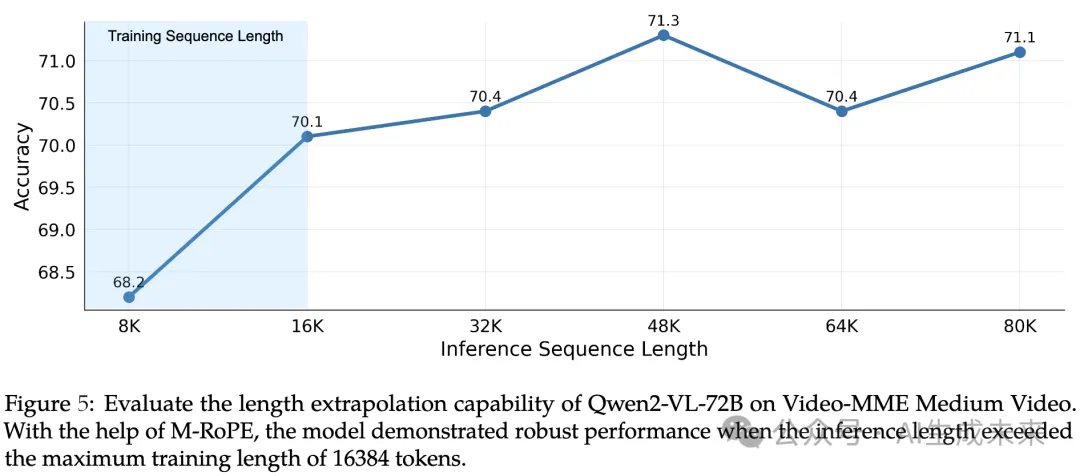

此外,在Video-MME中等長度視頻上評估了M-RoPE的長度外推能力。下圖5展示了Qwen2-VL-72B在不同推理長度下的性能。利用M-RoPE,模型在各種推理長度下表現穩健。值得注意的是,盡管在訓練期間每個視頻的最大tokens限制為16K,但模型在最大推理長度達到80K tokens時仍表現出色。

模型規模

評估了不同規模模型在多個能力維度上的表現。具體而言,將這些維度分類為復雜的大學水平問題解決能力、數學能力、文檔和表格理解、一般場景問答以及視頻理解。通過對與每個維度相關的不同基準測試的得分進行平均,我們評估了模型的整體能力。

具體來說, 使用MMMU基準來表示大學水平的問題解決能力,同時,MathVista和MathVision的平均得分作為數學能力的指標。對于一般場景問答,計算RealWorldQA、MMBench-V1.1、MMT-Bench、HallBench、MMVet和MMStar基準的平均得分。

文檔和表格理解能力通過DocVQA、InfoVQA、ChartQA、TextVQA、OCRBench和MTVQA基準的平均得分體現。最后,視頻理解能力通過MVBench、Perception-Test、EgoSchema和Video-MME的平均得分進行測量。

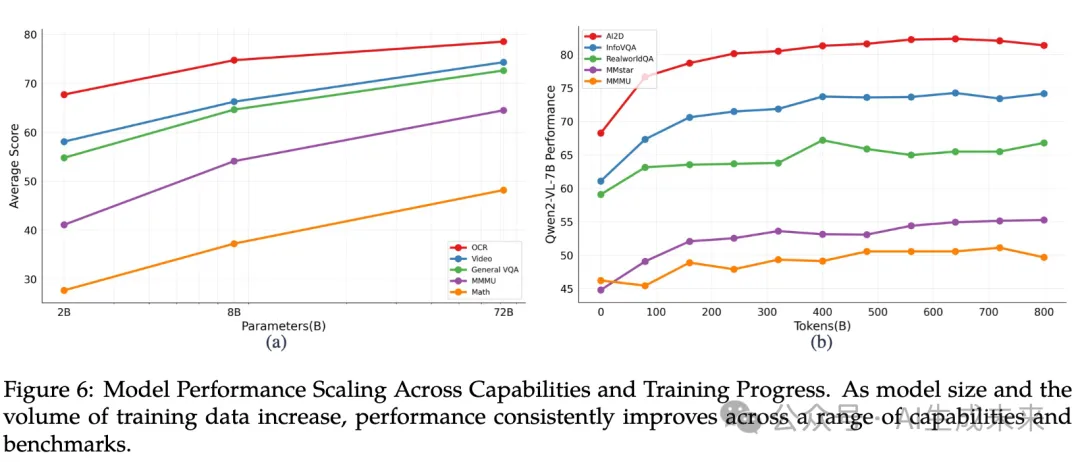

如下圖6(a)所示,隨著模型規模的增加,性能呈現出一致的提升,特別是在數學能力方面,這與模型參數的數量呈正相關。另一方面,對于光學字符識別(OCR)相關任務,即使是小規模模型的表現也相對強勁。

如上圖6(b)所示,我們可視化了Qwen2-VL-7B在預訓練第二階段中模型性能與訓練tokens數量之間的關系。隨著訓練tokens數量的增加,模型性能有所提升;然而,在視覺問答(VQA)任務上,性能卻表現出一定波動。相比之下,對于AI2D和InfoVQA等任務,這些任務涉及理解圖像中的文本和圖形信息,隨著訓練數據的增加,模型性能穩步提升。

結論

本文介紹了Qwen2-VL系列,這是多功能的大型視覺語言模型,包括三個開放權重模型,參數總量分別為20億、80億和720億。Qwen2-VL在多種多模態場景中的表現與頂尖模型如GPT-4o和Claude3.5-Sonnet相匹配,超越了所有其他開放權重的LVLM模型。Qwen2-VL系列引入了簡單的動態分辨率和Multimodal rotary position embedding (M-RoPE),有效融合跨模態信息,并能夠理解超過20分鐘長度的視頻。憑借先進的推理和決策能力,Qwen2-VL可以與移動設備、機器人等設備集成。此外,Qwen2-VL現已支持理解圖像中的多語言文本,包括大多數歐洲語言、日語、韓語、阿拉伯語、越南語等。

目前已將Qwen2-VL模型權重開放獲取,允許研究人員和開發者在各種應用和研究項目中充分利用其潛力。我們致力于推進人工智能技術,增強其對社會的積極影響。

本文轉自 AI生成未來 ,作者:AI生成未來