CVPR 2024 | 和馬賽克說拜拜!華為、清華等提出基于認知的萬物超分大模型

圖像超分辨率技術旨在將低分辨率圖像轉換為高分辨率圖像,從而提高圖像的清晰度和細節真實性。隨著超分技術的發展和手機硬件性能的提升,人們期望拍攝出更加清晰的照片。這項技術在手機影像等領域有著廣泛的應用和需求。

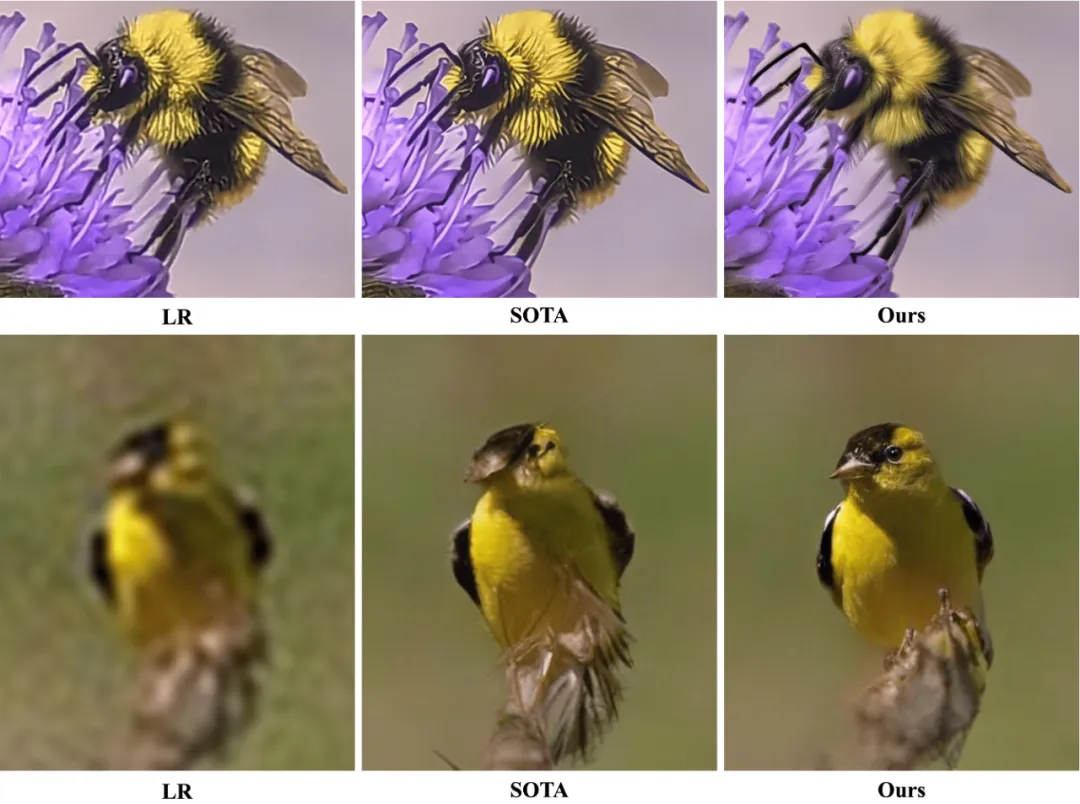

然而,現有的超分方法存在一些局限性,如下圖所示,主要有以下兩個方面:

一是缺乏泛化能力。為了實現更好的超分效果,通常需要針對特定場景使用特定傳感器采集到的數據來進行模型訓練,這種學習方式擬合了某種低清圖像和高清圖像間的映射,但在其他場景下表現不佳。此外,逐場景訓練的方式計算成本較高,不利于模型的部署和更新。

二是缺乏理解能力。現有的超分方法主要依賴于從大量數據中學習圖像的退化分布,忽視了對圖像內容的理解,無法利用常識來準確恢復物體的結構和紋理。

▲ 圖2. 真實場景超分 SOTA 方法的局限性:(行一)難以處理訓練集外的退化分布;(行二)難以利用常識恢復物體結構。

人類在處理信息時,有兩種不同的認知反饋系統。諾貝爾獎經濟學得主丹尼爾?卡爾曼在《思考,快與慢》中將它們稱為系統一和系統二,如圖 3 所示。

系統一是快速的、直覺的、基于記憶的反饋,比如,我們可以脫口而出十以內的加減運算。系統二是緩慢的、多步的反饋,比如,28x39 往往需要逐步運算。現有的超分方法更貼近系統一,它們主要依賴于從大量數據中學習圖像的退化分布,忽視了對圖像內容的理解,無法按照常識來準確恢復物體的結構和紋理,也無法處理域外的退化情況。

▲ 圖3. CoSeR 采用類似于人腦中系統二的修復方式

近日,由清華大學、華為諾亞方舟實驗室、香港科技大學等機構提出的研究,通過將圖像外觀和語言理解結合起來生成認知特征,實現了認知超分辨率框架,使 SR 模型能夠理解低分辨率圖像。

本文認為,真正能有效應用于真實場景的畫質大模型應該具備類似系統二的多步修復能力,即基于對圖像內容的認知,結合先驗知識來實現圖像超分(Cognitive Super-Resolution,CoSeR)。

項目主頁:

??https://coser-main.github.io/??

論文地址:

??https://arxiv.org/abs/2311.16512??

代碼地址:

??https://github.com/vinhyu/coser??

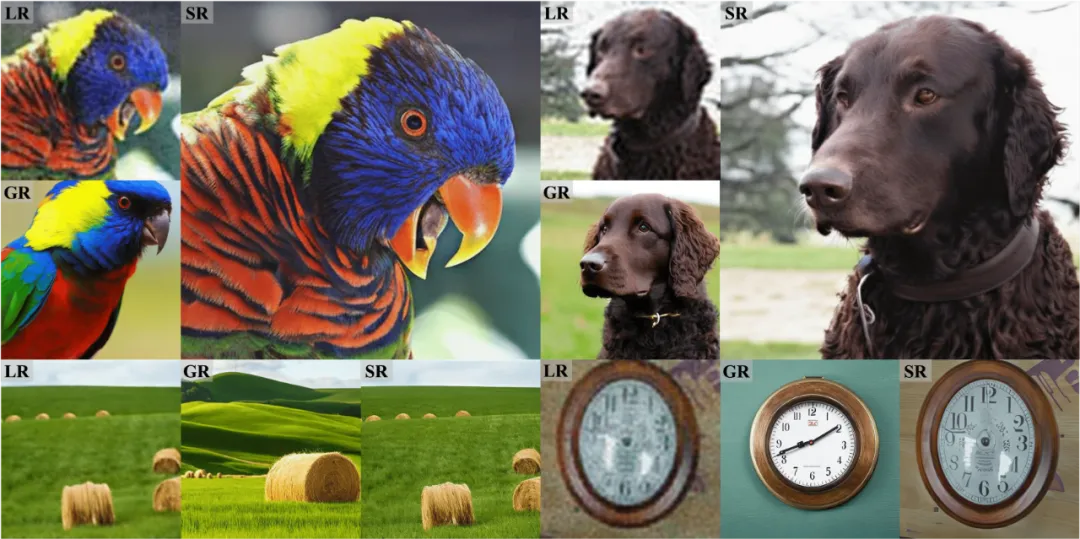

▲ 圖1. LR,GR 和 SR 分別為低清圖像、基于對低清圖像的認知生成的參考圖像和超分圖像。

CoSeR 模仿了人類專家修復低質量圖像自上而下的思維方式,首先建立對圖像內容的全面認知,包括識別場景和主要物體的特征,隨后將重點轉移到對圖像細節的檢查和還原。本文的主要貢獻如下:

1. 提出了一種通用的萬物超分畫質大模型 CoSeR,它能夠從低清圖像中提取認知特征,包括場景內容理解和紋理細節信息,從而提高模型的泛化能力和理解能力;

2. 提出了一種基于認知特征的參考圖像生成方法,它能夠生成與低清圖像內容一致的高質量參考圖像,用于指導圖像的恢復過程,增強圖像的保真度和美感度;

3. 提出了一種「All-in-Attention」模塊,它能夠將低清圖像、認知特征、參考圖像三個條件注入到模型當中,實現多源信息的融合和增強;

4. 在多個測試集和評價指標上,相較于現有方法,CoSeR 均取得了更好的效果。同時,CoSeR 在真實場景下也展現頗佳。

01 方法介紹

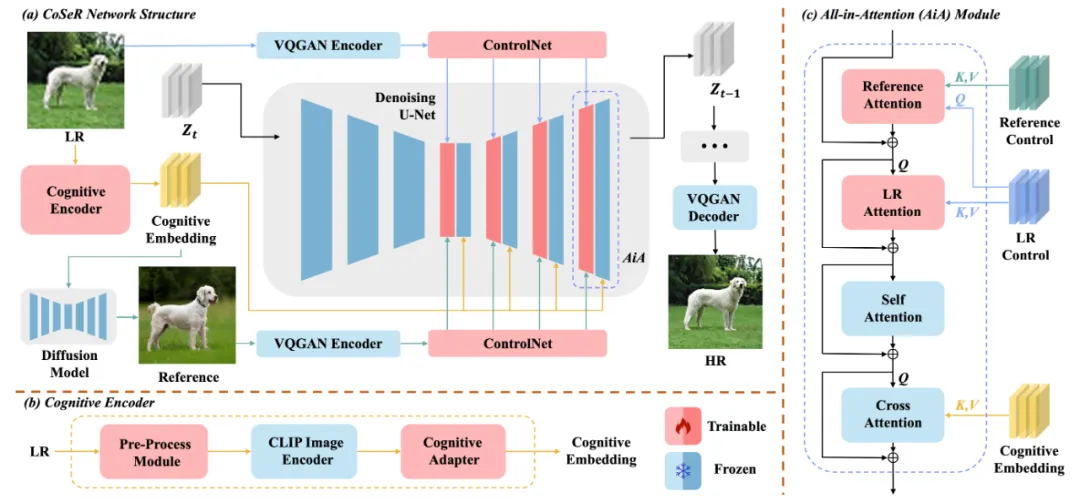

圖 4 展示了 CoSeR 的整體架構。CoSeR 首先使用認知編碼器來對低清圖像進行解析,將提取到的認知特征傳遞給 Stable Diffusion 模型,用以激活擴散模型中的圖像先驗,從而恢復更精細的細節。

此外,CoSeR 利用認知特征來生成與低清圖像內容一致的高質量參考圖像。這些參考圖像作為輔助信息,有助于提升超分辨率效果。最終,CoSeR 使用提出的「All-in-Attention」模塊,將低清圖像、認知特征、參考圖像三個條件注入到模型當中,進一步提升結果的保真度。

圖片

圖片

▲ 圖4. 本文提出的萬物超分畫質大模型CoSeR

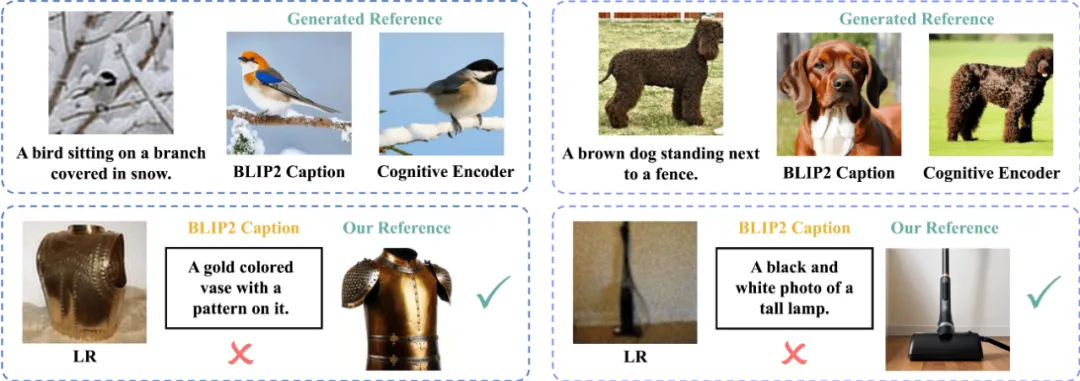

圖 5 展示了 CoSeR 參考圖像生成的效果。與直接從低清圖像中獲取描述的方法相比,CoSeR 的認知特征保留了細粒度的圖像特征,在生成具有高度相似內容的參考圖像時具有優勢。在圖 5 的第一行,使用 BLIP2 從低清圖像生成的描述無法準確識別動物的類別、顏色和紋理。

此外,CoSeR 的認知特征對于低清圖像更加魯棒。例如,在圖 5 的第二行,由于輸入分布的差異,BLIP2 會生成錯誤的圖像描述,而 CoSeR 生成了內容一致的高質量參考圖像。最后,相比于 BLIP2 大模型接近 7B 的參數量,CoSeR 的認知編碼器只有其 3% 的參數量,極大提升了推理速度。

圖片

圖片

▲ 圖5.(行一)使用 BLIP2 描述生成的參考圖和 CoSeR 生成的參考圖;(行二)CoSeR 的高魯棒性。

02 結果展示

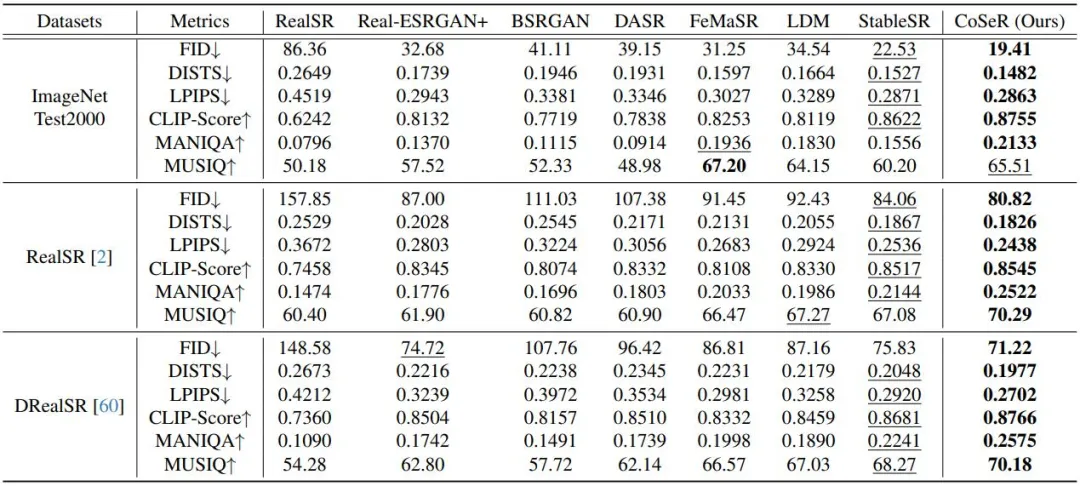

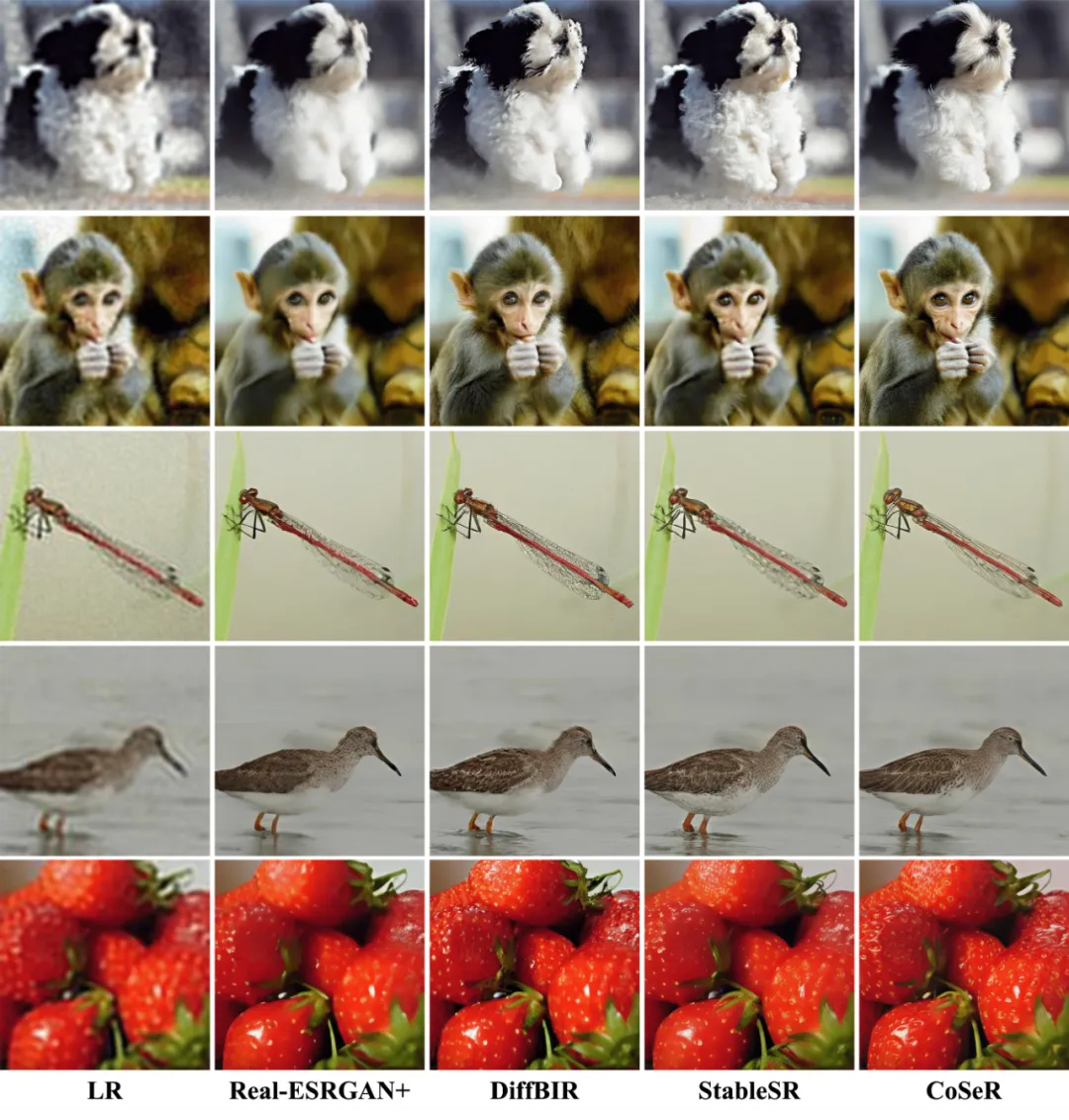

表 1 和圖 6 展示了 CoSeR 與其他方法的定量和定性結果對比。CoSeR 在含有豐富類別的 ImageNet 數據集及真實超分數據集 RealSR 和 DRealSR 上,都取得了不錯的結果。CoSeR 能夠恢復出更加清晰和自然的圖像細節,同時保持了圖像的內容一致性和結構完整性。

▲ 表1. 定量結果對比

▲ 圖6. 定性結果對比

本文提出的 CoSeR 模型為圖像超分辨率技術提供了一種新的思路和方法,它能夠從低清圖像中提取認知特征,用于激活圖像先驗、生成參考圖像,從而實現高質量的萬物超分效果。研究人員表示,未來的研究重點是如何在不影響超分性能的情況下加速采樣,以獲得更高的視覺質量。

此外,作者還將探索統一模型在更多樣化的圖像修復任務中的表現。

本文轉自 PaperWeekly ,作者:讓你更懂AI的