大神Aviral Kumar:價值學(xué)習(xí)真的是離線 RL 的主要瓶頸嗎? 原創(chuàng)

動機

- 離線強化學(xué)習(xí) (RL) 和模仿學(xué)習(xí)之間的主要區(qū)別在于使用價值函數(shù),并且離線 RL 中的大多數(shù)先前工作都側(cè)重于使用更好的技術(shù)學(xué)習(xí)更好的價值函數(shù)。

- 所以價值函數(shù)學(xué)習(xí)是離線 RL 的主要瓶頸……對嗎?

- 在這項工作中,研究人員表明,實踐中情況往往并非如此!

分析離線強化學(xué)習(xí)的瓶頸

這項工作的主要目標(biāo)是了解離線 RL 的性能在實踐中如何受到瓶頸限制。

離線 RL 有三個潛在瓶頸:

- (B1 )數(shù)據(jù)價值評估不完善

- (B2)從學(xué)習(xí)到的價值函數(shù)中提取不完善的策略

- (B3)測試時策略泛化不完善,表明策略在評估期間訪問

請注意,離線 RL 算法的瓶頸總是可以歸因于這些因素中的一個或幾個,因為如果所有因素都完美,代理將獲得最佳性能。因此需要做的就是分別剖析這些組件!

主要假設(shè)

首先陳述本項研究的主要研究假設(shè):

“離線 RL 的主要瓶頸是策略學(xué)習(xí),而不是價值學(xué)習(xí)。”

換句話說,盡管價值學(xué)習(xí)當(dāng)然很重要,如何從價值函數(shù)(B2 )中提取策略以及策略如何很好地推廣到它在評估時訪問的狀態(tài)(B3)通常是顯著影響許多問題中的性能和可擴(kuò)展性的主要因素。

為了驗證這一假設(shè),在本文中進(jìn)行了兩項主要分析:在第一次分析中,比較了價值學(xué)習(xí)和策略提取(B1和B2);在第二次分析中,分析了策略泛化的效果(B3)。

長話短說

這是本文分析的簡要內(nèi)容 ??:

- (1)策略提取通常比價值學(xué)習(xí)更重要:不要使用加權(quán)行為克隆(AWR);始終使用行為約束策略梯度(DDPG + BC)。

- (2)測試時間策略泛化是離線 RL 中最顯著的瓶頸之一:當(dāng)前的離線 RL 通常已經(jīng)擅長在數(shù)據(jù)集狀態(tài)下學(xué)習(xí)有效策略,而性能通常僅僅由其在分布外狀態(tài)下的性能決定。

分析1:是價值還是政策?(B1和B2)

- 價值學(xué)習(xí)還是策略提取哪個更重要?

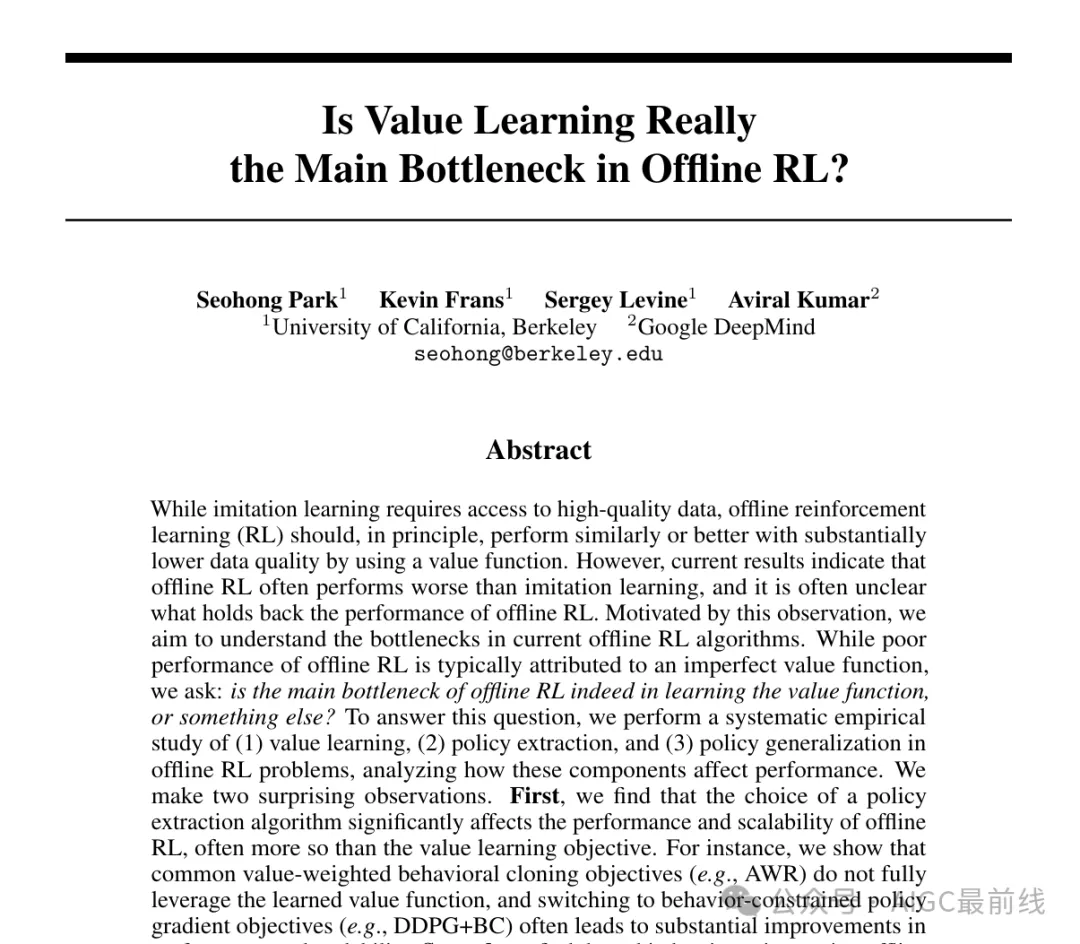

- 為了回答這個問題,研究人員使用不同數(shù)量的數(shù)據(jù)運行不同的算法進(jìn)行價值函數(shù)訓(xùn)練和策略提取,并繪制數(shù)據(jù)縮放矩陣來可視化結(jié)果。

- 這說明(1)性能的瓶頸在于價值還是策略;(2)各種價值學(xué)習(xí)和策略提取算法之間的性能差異。

- 為了清楚地剖析價值學(xué)習(xí)和策略提取,在本研究中重點關(guān)注具有解耦價值和策略學(xué)習(xí)階段的離線 RL 方法(例如IQL、一步式 RL、CRL 等)。這聽起來可能有點限制性,但即使在這些解耦方法中,策略學(xué)習(xí)通常也是主要瓶頸!

分析設(shè)置

在本分析中考慮以下算法和環(huán)境。

三種價值學(xué)習(xí)算法:

- (1)隱式 Q 學(xué)習(xí)(IQL)

- (2)一步 RL(SARSA)

- (3)對比 RL(CRL)。

三種策略提取算法:

- (1)加權(quán)行為克隆(例如AWR、RWR、AWAC 等)

- (2)行為約束策略梯度(例如DDPG+BC、TD3+BC 等)

- (3) 基于采樣的動作選擇(例如,SfBC,BCQ,IDQL 等)

八項任務(wù)(包括目標(biāo)條件(“ gc- ”)和基于像素的任務(wù)!):

- (1) gc-antmaze-large

- (2) antmaze-large

- (3) d4rl-hopper

- (4) d4rl-walker2d

- (5) exorl-walker

- (6) exorl-cheetah

- (7) kitchen

- (8)(基于像素的)gc-roboverse。

結(jié)果

顯示全部結(jié)果

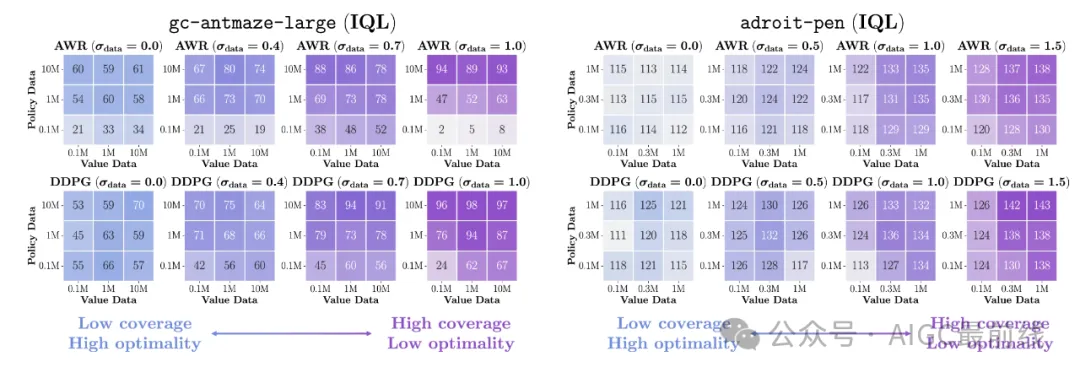

- 上圖顯示了數(shù)據(jù)縮放矩陣。重點介紹了exorl-walker和exorl-cheetah上的結(jié)果。單擊上面的按鈕可查看八個任務(wù)的完整數(shù)據(jù)縮放矩陣,這些矩陣是從總共 7744 次運行中匯總而來的。為每個矩陣條目單獨調(diào)整了策略提取超參數(shù)。

- 通過查看顏色漸變,可以看到每個算法的性能如何隨著更多數(shù)據(jù)的增加而擴(kuò)展以及/或者如何出現(xiàn)瓶頸。下面,重點介紹一些關(guān)鍵觀察結(jié)果。

- 首先,可以看到,策略提取算法通常對性能和數(shù)據(jù)擴(kuò)展趨勢的影響遠(yuǎn)遠(yuǎn)大于一般的價值學(xué)習(xí)目標(biāo)(也許除了antmaze-large),即使它們從相同的價值函數(shù)中提取策略!

- 在策略提取算法中,可以發(fā)現(xiàn)DDPG+BC 幾乎總是全面實現(xiàn)最佳性能和擴(kuò)展行為,其次是 SfBC,而 AWR 的性能在許多情況下明顯落后于其他兩種。

- 還可以看到,AWR 的數(shù)據(jù)縮放矩陣總是具有垂直或?qū)蔷€的顏色漸變,這表明它沒有充分利用價值函數(shù)(請參閱下文以獲得更明顯的證據(jù))。

分析2:策略泛化(B3)

- 現(xiàn)在,將注意力轉(zhuǎn)向離線 RL 中的第三個獨特瓶頸:策略泛化。

- 在離線 RL 中,代理在測試時會遇到新的、可能超出分布的狀態(tài),而它對這些新狀態(tài)的推廣程度會直接影響性能。

分析設(shè)置

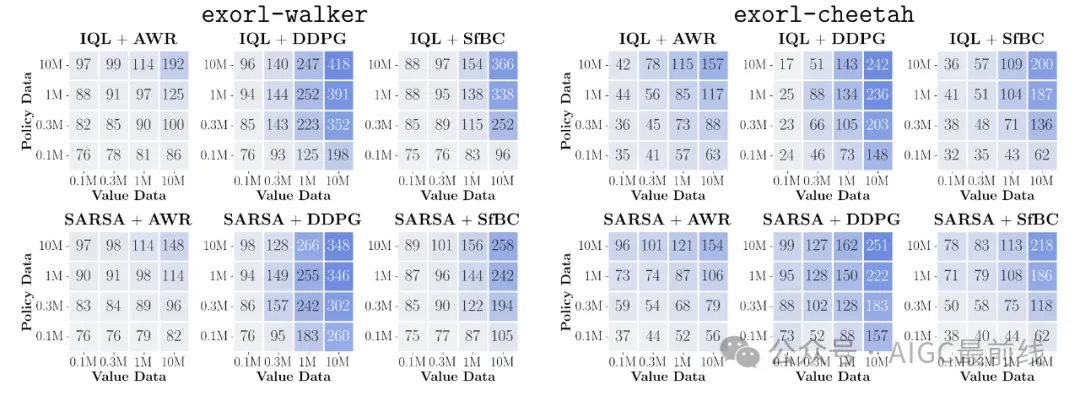

- 為了理解這個泛化瓶頸,首先定義三個量化策略準(zhǔn)確性的關(guān)鍵指標(biāo):

- 直觀地講,這些指標(biāo)衡量了該策略在三種不同分布上的準(zhǔn)確度。

- 也許你已經(jīng)熟悉訓(xùn)練 MSE和驗證 MSE。但還有另一個指標(biāo):評估 MSE,它看起來可能與驗證 MSE 相似,但實際上非常不同。

- 驗證 MSE 和評估 MSE 之間的關(guān)鍵區(qū)別在于,驗證 MSE 衡量的是分布內(nèi)的策略準(zhǔn)確率,而評估 MSE 衡量的是分布外的策略準(zhǔn)確率(見上圖)。評估 MSE 恰好對應(yīng)于要測量的泛化瓶頸。

- 為了了解這些數(shù)量與性能之間的關(guān)系,觀察了這些指標(biāo)和性能如何隨著額外的在線交互數(shù)據(jù)而發(fā)展(通常稱為離線到在線 RL設(shè)置)。

結(jié)果

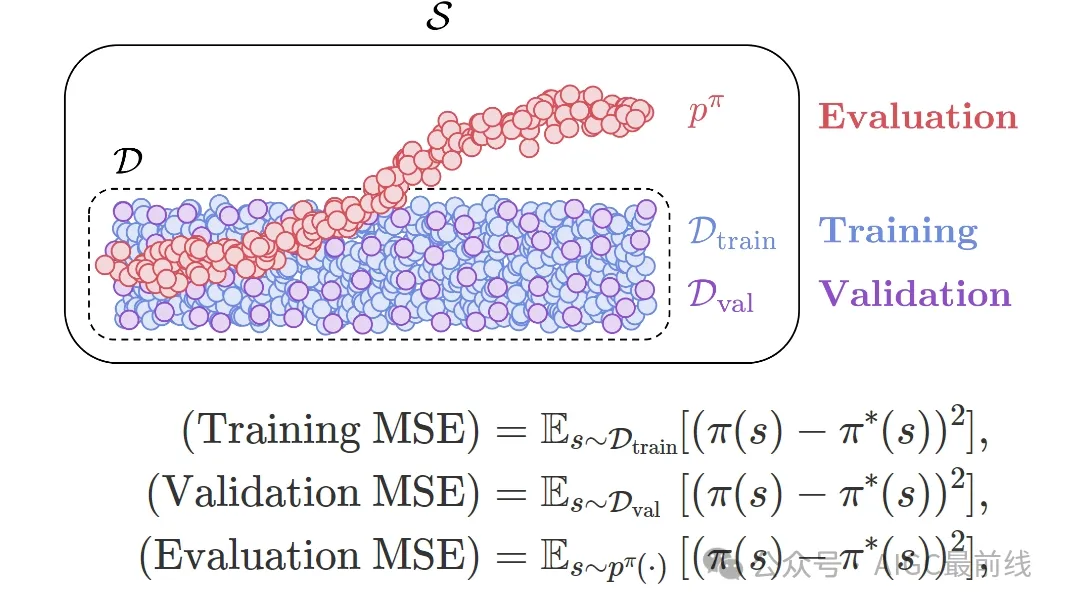

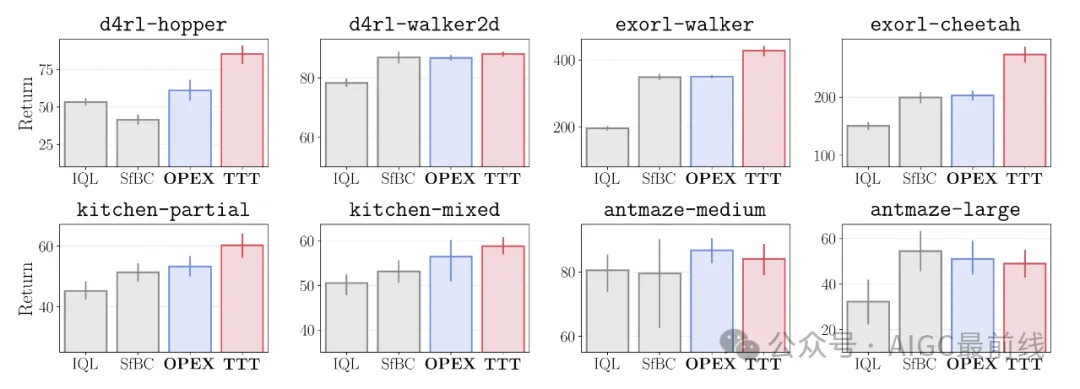

- 上圖顯示了回報和 MSE 指標(biāo)如何隨著更多在線互動數(shù)據(jù)而改善。用紅色表示在線訓(xùn)練步驟。

- 結(jié)果非常令人驚訝!可以看到:(1)離線到在線 RL 大多只會改善評估 MSE,而驗證 MSE 和訓(xùn)練 MSE 通常保持完全平坦;(2)離線 RL 的性能與評估 MSE指標(biāo)呈非常強(負(fù))相關(guān)性。

- 這是什么意思?這意味著當(dāng)前的離線 RL 算法可能已經(jīng)足夠擅長在離線數(shù)據(jù)集覆蓋的狀態(tài)分布中學(xué)習(xí)最佳策略,并且性能通常僅由代理在測試時遇到的新狀態(tài)的策略準(zhǔn)確性決定!

- 這為離線 RL 中的泛化提供了一個新的視角,這與之前對悲觀主義和行為正則化的關(guān)注有些不同。

- 那么,如何才能提高測試時策略的泛化能力呢?不幸的是,這在原則上非常困難,因為它需要泛化到一個可能完全不同的分布。盡管如此,如果稍微放寬假設(shè),就可以解決這個問題,在本文中提出了兩種這樣的解決方案。

解決方案 1:提高離線數(shù)據(jù)覆蓋率

- 第一個解決方案是使用高覆蓋率的數(shù)據(jù)集。

- 理由很簡單:如果測試時間分布外的泛化是瓶頸,可以簡單地使用更多數(shù)據(jù)使測試時間狀態(tài)分布內(nèi)(當(dāng)然,當(dāng)可以收集更多數(shù)據(jù)時??)!

- 在上面的圖中,盡管高覆蓋率數(shù)據(jù)集的次優(yōu)性有所增加,但它們確實提高了性能。另外,請注意,在這種情況下,使用正確的策略提取目標(biāo) (DDPG+BC) 也很重要!

解決方案 2:測試時策略改進(jìn)

- 如果無法控制數(shù)據(jù),那么提高測試時間策略準(zhǔn)確性的另一種方法就是在測試時間狀態(tài)下即時訓(xùn)練或指導(dǎo)策略。

- 為此,在論文中提出了一種非常簡單的方法,稱為即時策略提取(OPEX)。關(guān)鍵思想是在評估時簡單地按照價值梯度的方向調(diào)整策略動作。

- 具體來說,在測試時從策略?

- 中采樣一個動作后,會根據(jù)凍結(jié)的學(xué)習(xí)到的 Q 函數(shù)進(jìn)一步調(diào)整該動作,公式如下。

其中

是與測試時“學(xué)習(xí)率”相對應(yīng)的超參數(shù)。

- OPEX 在評估時只需要一行額外的代碼,并且根本不會改變訓(xùn)練程序!

- 在本文中,研究人員提出了另一種方法,即測試時訓(xùn)練(TTT),它在測試時推出期間進(jìn)一步更新策略參數(shù)。

- 這些即時策略改進(jìn)技術(shù)通過緩解測試時間策略泛化瓶頸,提高了各種任務(wù)的性能。

要點:測試時策略泛化是離線強化學(xué)習(xí)中最顯著的瓶頸之一。使用高覆蓋率數(shù)據(jù)集。使用即時策略改進(jìn)技術(shù)提高測試時狀態(tài)下的策略準(zhǔn)確性。

那么,這說明了什么?

- 與之前認(rèn)為價值學(xué)習(xí)是離線 RL 的主要瓶頸的觀點有些相反, 當(dāng)前的離線 RL 方法通常嚴(yán)重受限于從價值函數(shù)中提取策略的準(zhǔn)確性以及該策略推廣到測試時間狀態(tài)的準(zhǔn)確性。

- 對于實踐者來說,分析表明離線 RL 有一個明確的方案:在盡可能多樣化的數(shù)據(jù)上訓(xùn)練價值函數(shù),并允許策略最大限度地利用價值函數(shù),并采用最佳策略提取目標(biāo)(例如DDPG+BC)和/或潛在的測試時間策略改進(jìn)策略。

- 對于未來的算法研究,強調(diào)離線 RL 中的兩個重要開放問題:(1)從學(xué)習(xí)到的價值函數(shù)中提取策略的最佳方法是什么?有沒有比 DDPG+BC 更好的方法?(2)如何訓(xùn)練策略,使其在測試時間狀態(tài)下具有很好的泛化能力?

- 第二個問題特別有趣,因為它提出了與離線 RL 中普遍存在的悲觀主義主題截然相反的觀點,其中只有少數(shù)作品明確旨在解決離線 RL 的這種泛化方面!

譯自(有刪改):https://seohong.me/projects/offrl-bottlenecks/

本文轉(zhuǎn)載自公眾號AIGC最前線