模型調(diào)優(yōu)無需標(biāo)注數(shù)據(jù)!將Llama 3.3 70B直接提升到GPT-4o水平

現(xiàn)階段,微調(diào)大型語(yǔ)言模型(LLMs)的難點(diǎn)在于,人們通常沒有高質(zhì)量的標(biāo)注數(shù)據(jù)。

最近,AI 公司 Databricks 推出了一種新的調(diào)優(yōu)方法 TAO,只需要輸入數(shù)據(jù),無需標(biāo)注數(shù)據(jù)即可完成。更令人驚喜的是,TAO 在性能上甚至超過了基于標(biāo)注數(shù)據(jù)的監(jiān)督微調(diào)。

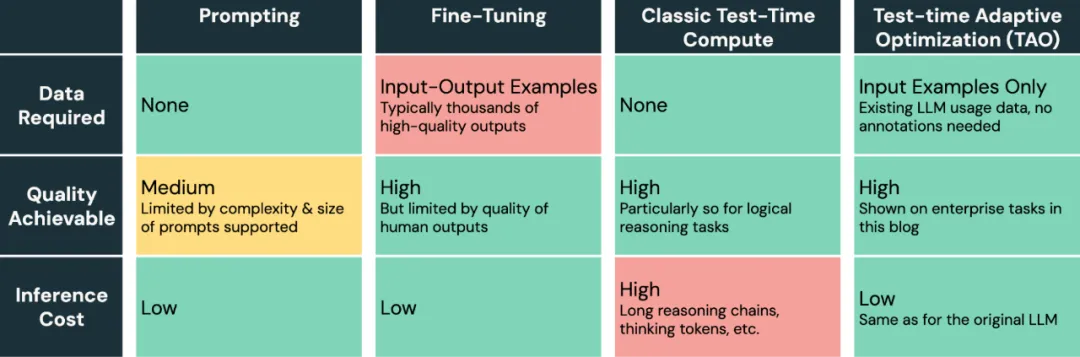

眾所周知,LLM 很難適應(yīng)新的企業(yè)級(jí)任務(wù)。提示(prompting)的方式容易出錯(cuò),且質(zhì)量提升有限,而微調(diào)(fine-tuning)則需要大量的標(biāo)注數(shù)據(jù),而這些數(shù)據(jù)在大多數(shù)企業(yè)任務(wù)中是不可用的。

Databricks 提出的模型調(diào)優(yōu)方法,只需要未標(biāo)注數(shù)據(jù),企業(yè)就可以利用現(xiàn)有的數(shù)據(jù)來提升 AI 的質(zhì)量并降低成本。

TAO(全稱 Test-time Adaptive Optimization)利用測(cè)試時(shí)計(jì)算(由 o1 和 R1 推廣)和強(qiáng)化學(xué)習(xí)(RL)算法,僅基于過去的輸入示例來教導(dǎo)模型更好地完成任務(wù)。

至關(guān)重要的是,盡管 TAO 使用了測(cè)試時(shí)計(jì)算,但它將其作為訓(xùn)練模型過程的一部分;然后,該模型以較低的推理成本(即在推理時(shí)不需要額外的計(jì)算)直接執(zhí)行任務(wù)。

更令人驚訝的是,即使沒有標(biāo)注數(shù)據(jù),TAO 也能實(shí)現(xiàn)比傳統(tǒng)調(diào)優(yōu)模型更好的質(zhì)量,并且它可以將像 Llama 這樣的開源模型提升到與專有模型(如 GPT-4o 和 o3-mini)相當(dāng)?shù)馁|(zhì)量水平。

借助 TAO,Databricks 已經(jīng)取得了三項(xiàng)突破性成果:

- 在文檔問答和 SQL 生成等專業(yè)企業(yè)任務(wù)中,TAO 的表現(xiàn)優(yōu)于需要數(shù)千標(biāo)注樣本的傳統(tǒng)微調(diào)方法。它讓 Llama 8B/70B 等高效開源模型達(dá)到了 GPT-4o/o3-mini1 等商業(yè)模型的同等水平,且無需任何標(biāo)注數(shù)據(jù);

- 在零標(biāo)注數(shù)據(jù)條件下,TAO 將 Llama 3.3 70B 模型在企業(yè)綜合基準(zhǔn)測(cè)試中的表現(xiàn)提升了 2.4%;

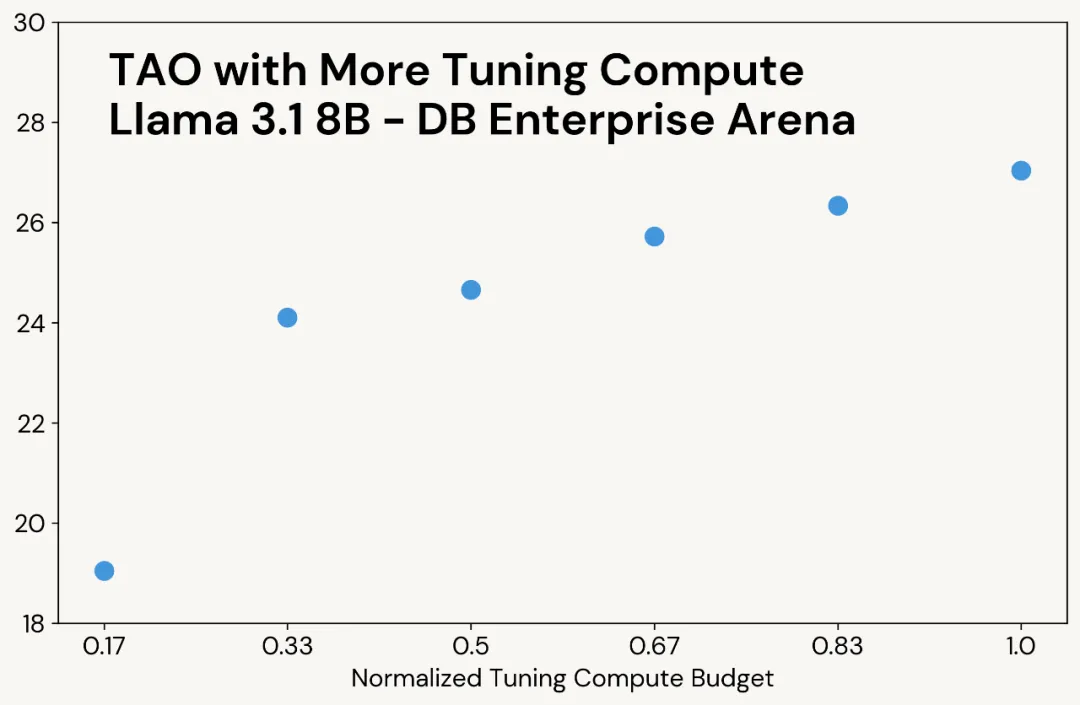

- 增加 TAO 訓(xùn)練階段的算力投入,可以在相同數(shù)據(jù)條件下獲得更優(yōu)模型質(zhì)量,且不會(huì)增加推理階段的成本消耗。

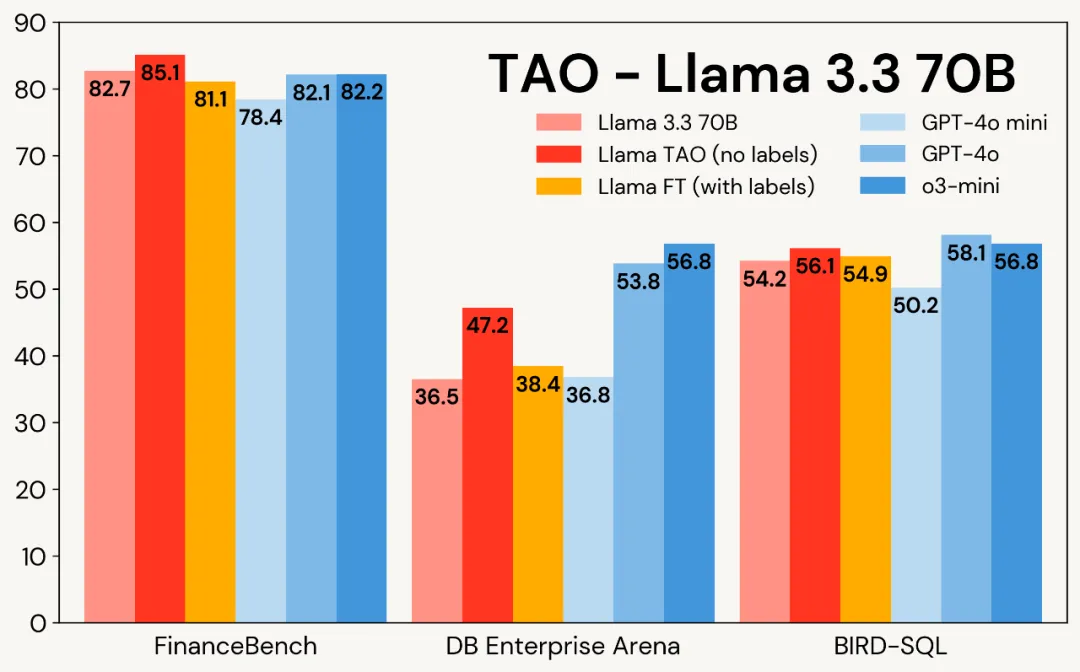

圖 1 展示了 TAO 在三個(gè)企業(yè)級(jí)任務(wù)中對(duì) Llama 模型的提升效果:盡管僅使用原始輸入數(shù)據(jù),TAO 不僅超越了需要數(shù)千標(biāo)注樣本的傳統(tǒng)微調(diào) (FT) 方法,更讓 Llama 系列模型達(dá)到了商業(yè)模型的性能水準(zhǔn)。

圖 1:Llama 3.1 8B 與 Llama 3.3 70B 在三大企業(yè)級(jí)基準(zhǔn)測(cè)試中應(yīng)用 TAO 的效果對(duì)比。TAO 帶來顯著的性能提升,不僅超越傳統(tǒng)微調(diào)方法,更直指高價(jià)商業(yè)大語(yǔ)言模型的性能水平

TAO 工作原理

基于測(cè)試時(shí)計(jì)算與強(qiáng)化學(xué)習(xí)的模型調(diào)優(yōu)

TAO 的核心創(chuàng)新在于摒棄了人工標(biāo)注數(shù)據(jù),轉(zhuǎn)而利用測(cè)試時(shí)計(jì)算引導(dǎo)模型探索任務(wù)的可能響應(yīng),再通過強(qiáng)化學(xué)習(xí)根據(jù)響應(yīng)評(píng)估結(jié)果更新模型參數(shù)。

該流程通過可擴(kuò)展的測(cè)試時(shí)計(jì)算(而非昂貴的人工標(biāo)注)實(shí)現(xiàn)質(zhì)量提升,并能靈活融入領(lǐng)域知識(shí)(如定制規(guī)則)。令人驚訝的是,在高質(zhì)量開源模型上應(yīng)用該方法時(shí),其效果往往優(yōu)于依賴人工標(biāo)注的傳統(tǒng)方案。

TAO pipeline

TAO 包含四個(gè)核心階段:

- 響應(yīng)生成:該階段首先收集任務(wù)相關(guān)的輸入提示或查詢樣本。在 Databricks 平臺(tái)上,這些提示可通過 AI Gateway 自動(dòng)采集;

- 響應(yīng)評(píng)分:系統(tǒng)化評(píng)估生成響應(yīng)的階段。評(píng)分方法包含多種策略,例如基于獎(jiǎng)勵(lì)模型、偏好評(píng)分,或利用 LLM 評(píng)判器及定制規(guī)則進(jìn)行任務(wù)特異性驗(yàn)證,確保每個(gè)響應(yīng)都做到最優(yōu);

- 強(qiáng)化學(xué)習(xí)(RL)訓(xùn)練:最終階段采用基于強(qiáng)化學(xué)習(xí)的方法更新大語(yǔ)言模型,引導(dǎo)模型生成與高分響應(yīng)高度契合的輸出。通過這一自適應(yīng)學(xué)習(xí)過程,模型持續(xù)優(yōu)化預(yù)測(cè)能力以提升質(zhì)量;

- 持續(xù)改進(jìn):TAO 僅需 LLM 輸入樣本作為數(shù)據(jù)源。用戶與 LLM 的日常交互自然形成該數(shù)據(jù) —— 一旦模型部署使用,即可自動(dòng)生成下一輪 TAO 訓(xùn)練數(shù)據(jù)。在 Databricks 平臺(tái)上,借助 TAO 機(jī)制,模型會(huì)隨著使用頻次增加而持續(xù)進(jìn)化。

雖然 TAO 在訓(xùn)練階段使用了測(cè)試時(shí)計(jì)算,但最終產(chǎn)出的模型在執(zhí)行任務(wù)時(shí)仍保持低推理成本。這意味著經(jīng)過 TAO 調(diào)優(yōu)的模型在推理階段 —— 與原版模型相比 —— 具有完全相同的計(jì)算開銷和響應(yīng)速度,顯著優(yōu)于 o1、o3 和 R1 等依賴測(cè)試時(shí)計(jì)算的模型。實(shí)驗(yàn)表明:采用 TAO 訓(xùn)練的高效開源模型,在質(zhì)量上足以比肩頂尖的商業(yè)閉源模型。

TAO 為 AI 模型調(diào)優(yōu)提供了一種突破性方法:

- 不同于耗時(shí)且易出錯(cuò)的提示工程;

- 也區(qū)別于需要昂貴人工標(biāo)注數(shù)據(jù)的傳統(tǒng)微調(diào);

- TAO 僅需工程師提供任務(wù)相關(guān)的典型輸入樣本,即可實(shí)現(xiàn)卓越性能。

LLM 不同調(diào)優(yōu)方法比較

實(shí)驗(yàn)及結(jié)果

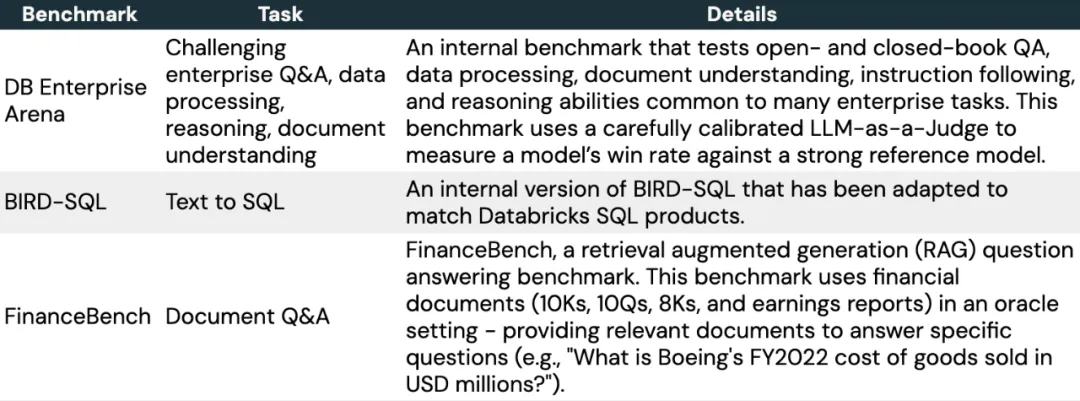

接下來,文章深入探討了如何使用 TAO 針對(duì)專門的企業(yè)任務(wù)調(diào)優(yōu) LLM。本文選擇了三個(gè)具有代表性的基準(zhǔn)。

表 2:該研究使用的基準(zhǔn)測(cè)試概覽

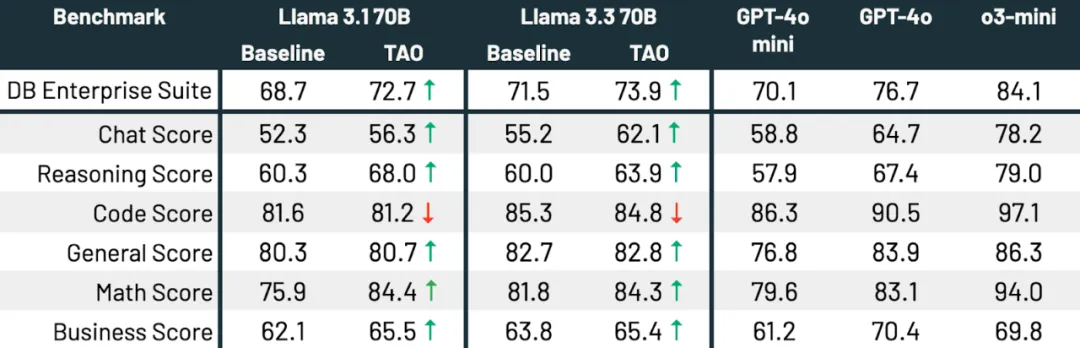

如表 3 所示,在所有三個(gè)基準(zhǔn)測(cè)試和兩種 Llama 模型中,TAO 顯著提升了基礎(chǔ) Llama 的性能,甚至超過了微調(diào)的效果。

表 3:在三個(gè)企業(yè)級(jí)基準(zhǔn)測(cè)試中使用 TAO 的 Llama 3.1 8B 和 Llama 3.3 70B 實(shí)驗(yàn)結(jié)果

與經(jīng)典的測(cè)試時(shí)計(jì)算類似,當(dāng) TAO 能夠使用更多的計(jì)算資源時(shí),它會(huì)產(chǎn)生更高質(zhì)量的結(jié)果(見圖 3 中的示例)。然而,與測(cè)試時(shí)計(jì)算不同的是,這種額外的計(jì)算資源僅在調(diào)優(yōu)階段使用;最終的語(yǔ)言模型的推理成本與原始語(yǔ)言模型相同。例如,o3-mini 生成的輸出 token 數(shù)量比其他模型多 5-10 倍,因此其推理成本也相應(yīng)更高,而 TAO 的推理成本與原始 Llama 模型相同。

利用 TAO 提高模型多任務(wù)性能

到目前為止,該研究已經(jīng)使用 TAO 來提升語(yǔ)言模型在單一任務(wù)(例如 SQL 生成)上的表現(xiàn)。接下來,該研究展示了 TAO 如何廣泛提升模型在一系列企業(yè)任務(wù)中的性能。

結(jié)果如下,TAO 顯著提升了兩個(gè)模型的性能,將 Llama 3.3 70B 和 Llama 3.1 70B 分別提升了 2.4 和 4.0 個(gè)百分點(diǎn)。TAO 使 Llama 3.3 70B 在企業(yè)級(jí)任務(wù)上的表現(xiàn)顯著接近 GPT-4o,所有這些改進(jìn)都沒有產(chǎn)生人工標(biāo)注成本。