如果想要在某個模型基礎上做全參數微調,需要多少顯存?

全參數微調(Full Parameter Fine-Tuning)的顯存需求取決于多個因素,包括模型的大小、數據的批量大小(Batch Size)、優化器的狀態存儲以及是否使用混合精度訓練等。以下是一個詳細的分析:

模型參數大小

模型參數顯存占用:模型的每個參數在顯存中占用一定的空間。通常,單精度浮點數(FP32)占用4字節,半精度浮點數(FP16)占用2字節。

計算公式:

模型參數顯存=模型參數數量×每個參數占用的字節數

示例:

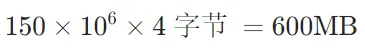

如果模型有1.5億個參數(如BERT-Base),使用FP32精度,顯存占用為:

梯度存儲

在反向傳播中,每個參數的梯度也需要存儲在顯存中。

計算公式:

梯度顯存=模型參數數量×每個參數占用的字節數

示例:

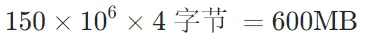

對于上述BERT-Base模型(FP32),梯度顯存占用為:

優化器狀態

常用的優化器(如Adam)會為每個參數存儲額外的狀態(如動量和方差估計)。

不同優化器的狀態倍數如下:

AdamW (2 states): 8 Bytes per parameter

AdamW (bitsandbytes Quantized): 2 Bytes per parameter

SGD (1 state): 4 Bytes per parameter

計算公式:

優化器狀態顯存=模型參數數量×每個參數占用的字節數×優化器狀態倍數

示例:

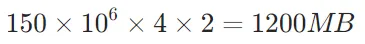

對于BERT-Base模型(FP32),優化器狀態顯存占用為:

激活值和臨時變量

在前向和反向傳播過程中,網絡的激活值(中間層輸出)和臨時變量也會占用顯存。

估算公式:

激活值顯存≈模型參數數量×每個參數占用的字節數×2

示例:

對于BERT-Base模型(FP32),激活值顯存占用為:

批量大小(Batch Size)

批量大小會顯著影響顯存占用。每個樣本的輸入、輸出和中間激活值都需要存儲。

估算公式:

Batch Size顯存=Batch Size×(輸入大小+輸出大小+中間激活值大小)

示例:

假設輸入為512個token的文本,每個token的嵌入維度為768(BERT-Base),Batch Size為32,則輸入顯存占用為:

總結公式

綜合以上因素,全參數微調的顯存需求估算公式為:

總顯存需求=(模型參數顯存+梯度顯存+優化器狀態顯存+激活值顯存)×精度倍數+Batch Size顯存

示例:BERT-Base全參數微調(FP32)

- 模型參數顯存:600MB

- 梯度顯存:600MB

- 優化器狀態顯存:1200MB

- 激活值顯存:1200MB

- Batch Size顯存:假設為100MB(根據輸入大小和Batch Size估算)

最終總顯存需求:

600+600+1200+1200+100=3700MB≈3.7GB