自動調整推理鏈長度,SCoT來了!為激發推理能力研究還提出了一個新架構

不怕推理模型簡單問題過度思考了,能動態調整CoT的新推理范式SCoT來了!

SCoT,即自結構化推理鏈(Self-structured Chain of Thought )。

它通過將推理過程分解為最小語義原子步驟,能動態生成適配不同復雜度問題的CoT結構,解決了現有方法在推理多樣性和效率上的不足。

另外,為了激發推理能力,研究人員還提出了AtomThink,這是一個包含數據構造、訓練、推理和評估的全過程框架,用來提升多模態大模型在復雜推理任務上的表現。

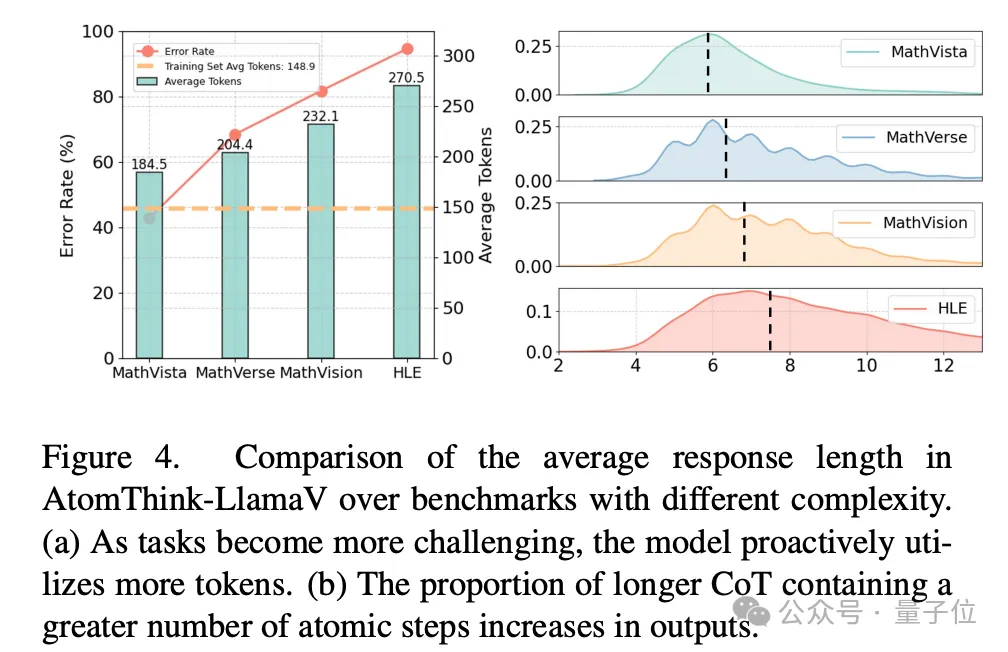

實驗中,SCoT使模型能根據問題復雜度自動調整推理鏈長度,復雜問題的推理步驟更長。

在多個數據集上,AtomThink框架顯著提升了基線模型的準確率,數據利用效率和推理效率也表現出顯著優勢。

并且,原子能力評估揭示了多模態模型在不同推理能力上的分布特征,為理解多模態推理模式提供了新視角。

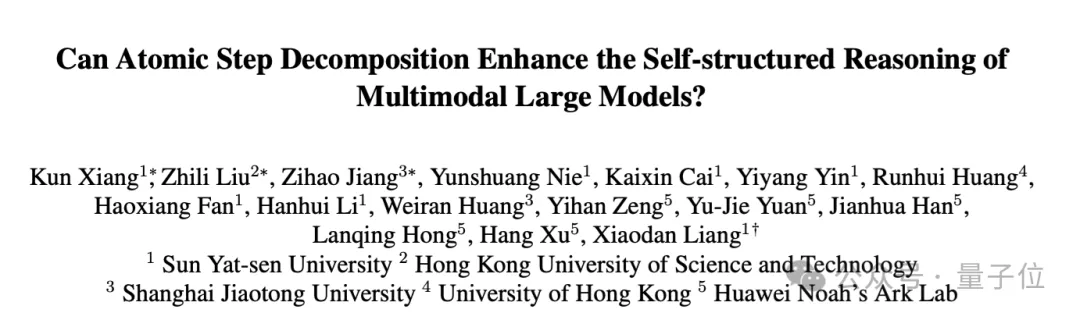

這項研究由來自中山大學、香港科技大學、上海交通大學、香港大學、華為諾亞方舟實驗室的研究人員聯合提出,以下是更多細節。

SCoT、AtomThink長啥樣?

當前,結構化和非結構化CoT面臨一定的挑戰。

現有方法或依賴于固定模板的結構化推理,或采用自由形式的非結構化推理,存在如推理行為單一、需要人工設計模版、計算效率低下或在簡單問題上過度思考的問題。

因此,團隊提出兩個假設:

- 不同類型的問題可能需要不同的推理能力;

- 推理的復雜性應與問題的難度相匹配。

為了為具有不同復雜性的問題動態生成適當的推理結構,團隊引入了自結構化思維鏈(SCoT)和一個全過程訓推框架AtomThink。

其中自結構化思維鏈(SCoT),即作者提出將推理過程分解為最小語義單元——原子步驟,并通過多輪預測方法動態生成推理鏈。

模型每次僅預測一個原子步驟,并將其附加到歷史推理步驟中,作為下一輪推理的輸入。

為應對模型推理異常(如重復、停滯等),引入基于規則的過濾機制和溫度累積策略,以增強推理的多樣性和流暢性。

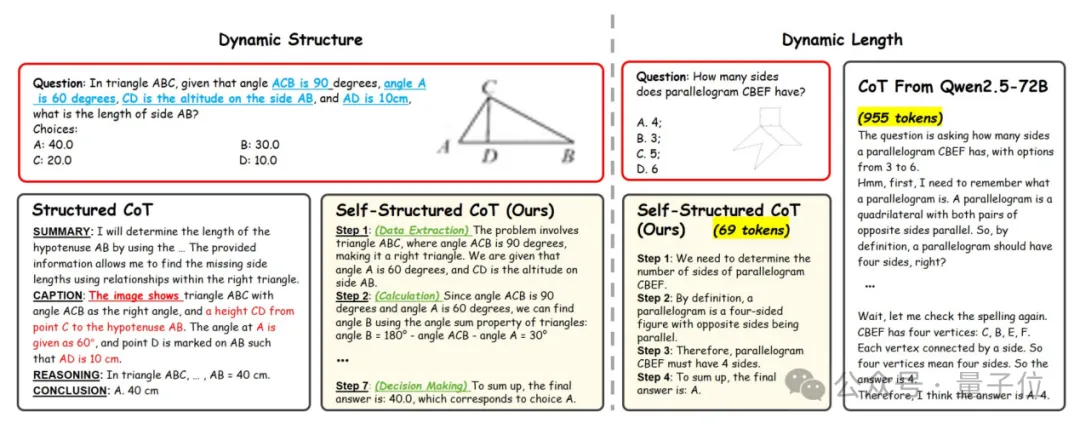

AtomThink框架則包含四個關鍵模塊:

- 數據引擎:通過動態提示策略和短推理增強方法生成高質量多步推理路徑,構建包含20k多模態數學問題和124k原子步驟標注的AMATH數據集。

- 原子步驟微調:采用步驟級掩碼訓練,迫使模型學習獨立推理步驟。

- 策略引導的多輪推理:在過程監督模型的基礎上,結合路徑搜索和步驟搜索策略(如多數投票、最佳候選選擇、貪婪算法和束搜索)擴展推理空間。

- 原子能力評估:基于推理行為聚類和步驟利用率計算,評估模型在不同推理能力上的表現。

實驗結果如何?

研究團隊選取不同規模的LLaVA1.5-7B和Llama3.2-Vision-11B作為基線模型,使用AMATH-SFT數據集進行微調,并在MathVista、MathVerse、MathVision和Humanity’s Last Exam基準數據集上進行評估。

實驗設置包括直接推理、普通推理鏈(CoT)、自結構化推理鏈(SCoT)以及結合過程獎勵模型(PRM)的SCoT推理。

在MathVista、MathVerse和MathVision數據集上,AtomThink框架顯著提升了基線模型Llama3.2-Vision-11B的準確率,分別提高10.9%、10.2%和7.2%。

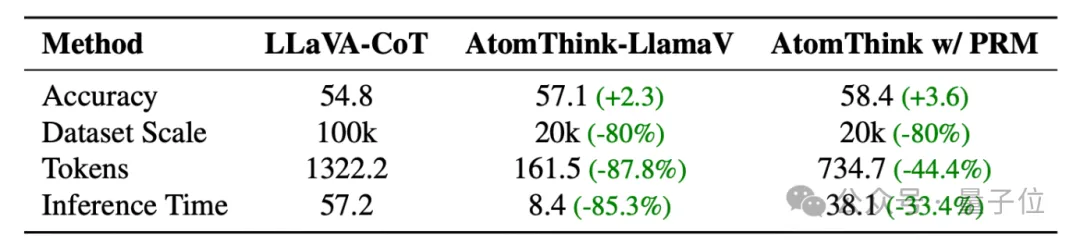

與現有結構化CoT方法相比,AtomThink在準確率、數據利用效率和推理效率上均表現出顯著優勢,在準確率超越LLaVA-CoT的條件下數據利用效率提升5倍,推理效率提升85.3%。

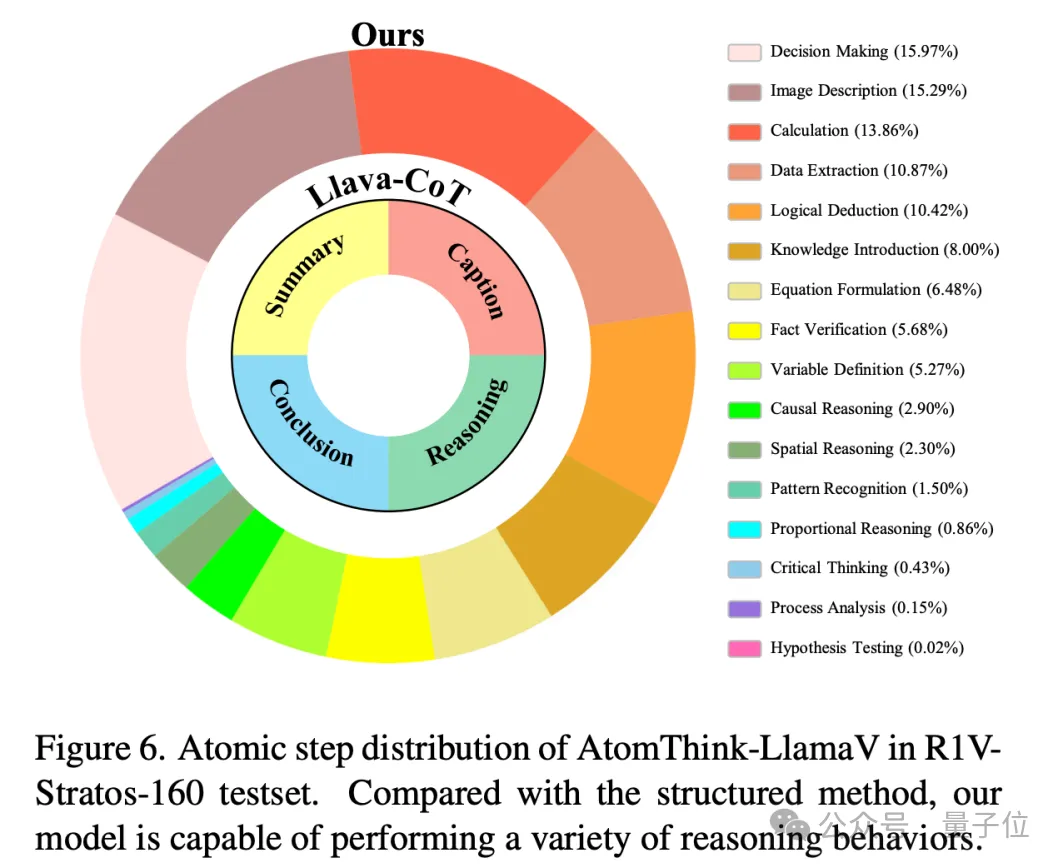

另外,與結構化方法相比,SCoT能夠動態生成更多樣化的推理結構,涵蓋圖像描述、數據提取、邏輯推理、因果推理等多種能力。

模型還能夠根據問題復雜度自動調整推理鏈長度,復雜問題的推理步驟更長,表現出自適應的深度探索能力。

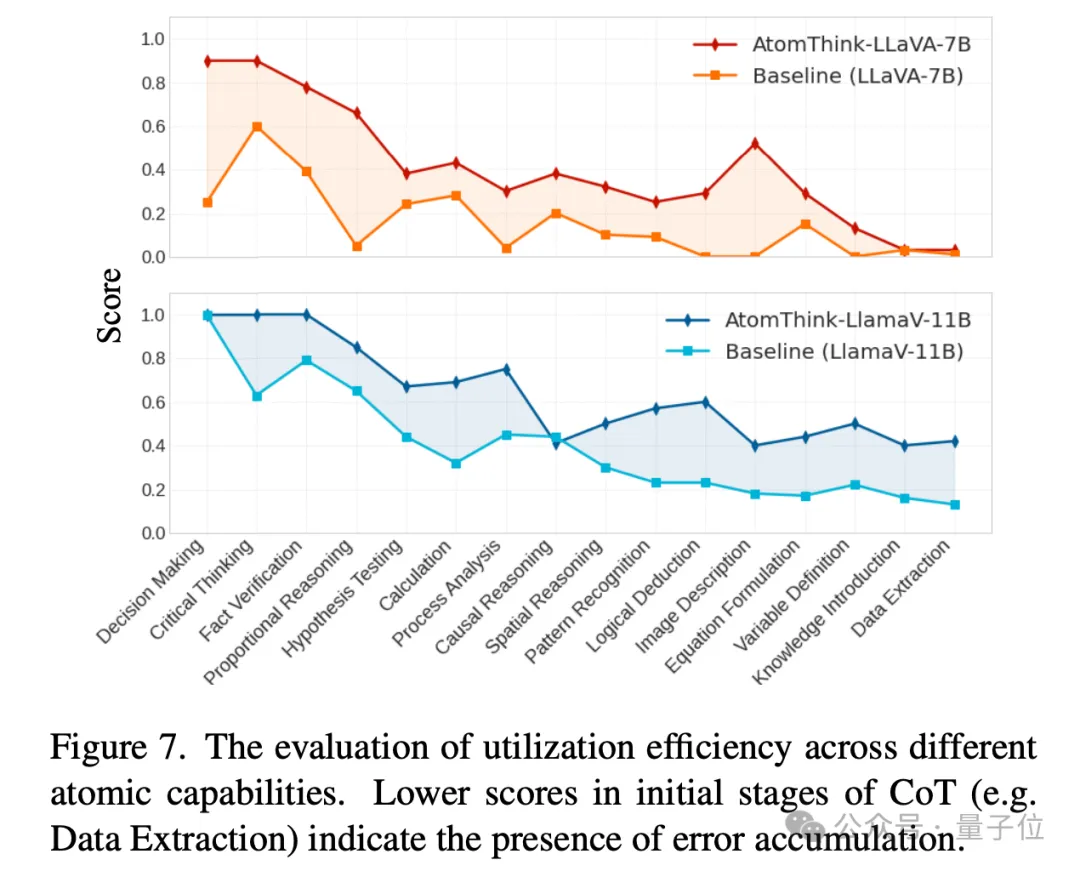

為了評估推理模型對于不同中間步驟的利用能力,團隊提出了一個新穎的評估方式。

首先通過聚類GPT-4o的推理行為來生成原子步驟分布集合(包含16種行為),構建歷史步驟后進行rollout來計算對最近步驟的利用效率。

通過原子能力評估發現模型存在推理誤差累計現象,在CoT早期階段(如數據提取和圖像描述)開始繼承推理的錯誤率較高,提示未來工作需關注推理初期的質量控制。

論文:https://arxiv.org/pdf/2503.06252

開源倉庫:https://github.com/Quinn777/AtomThink