揭秘大模型強(qiáng)推理能力幕后功臣“缺陷”,過(guò)程級(jí)獎(jiǎng)勵(lì)模型新基準(zhǔn)來(lái)了

截止目前,o1 等強(qiáng)推理模型的出現(xiàn)證明了 PRMs(過(guò)程級(jí)獎(jiǎng)勵(lì)模型)的有效性。

(“幕后功臣” PRMs 負(fù)責(zé)評(píng)估推理過(guò)程中的每一步是否正確和有效,從而引導(dǎo) LLMs 的學(xué)習(xí)方向。)

但關(guān)鍵問(wèn)題來(lái)了:我們?nèi)绾螠?zhǔn)確評(píng)估 PRMs 本身的性能?

作為回應(yīng),復(fù)旦大學(xué)、蘇州大學(xué),上海AI Lab等聯(lián)合提出了 PRMBench,它包含 6,216 條精心設(shè)計(jì)的問(wèn)題和 83,456 個(gè)步驟級(jí)標(biāo)簽,用于評(píng)測(cè)模型細(xì)粒度的錯(cuò)誤檢測(cè)能力。

具體而言,目前主流的評(píng)估方法往往側(cè)重于最終結(jié)果的正確性,而忽略了對(duì)推理過(guò)程中細(xì)致入微的錯(cuò)誤類型的識(shí)別。例如,一個(gè)推理步驟可能存在冗余、部分正確、 甚至完全錯(cuò)誤等多種狀態(tài),簡(jiǎn)單的“正確/錯(cuò)誤”標(biāo)簽難以捕捉其復(fù)雜性。

而 PRMBench 提供了一個(gè)更全面、更精細(xì)化的評(píng)估工具,可以更有效地識(shí)別 PRMs 的潛在缺陷,促進(jìn)相關(guān)算法的改進(jìn)。

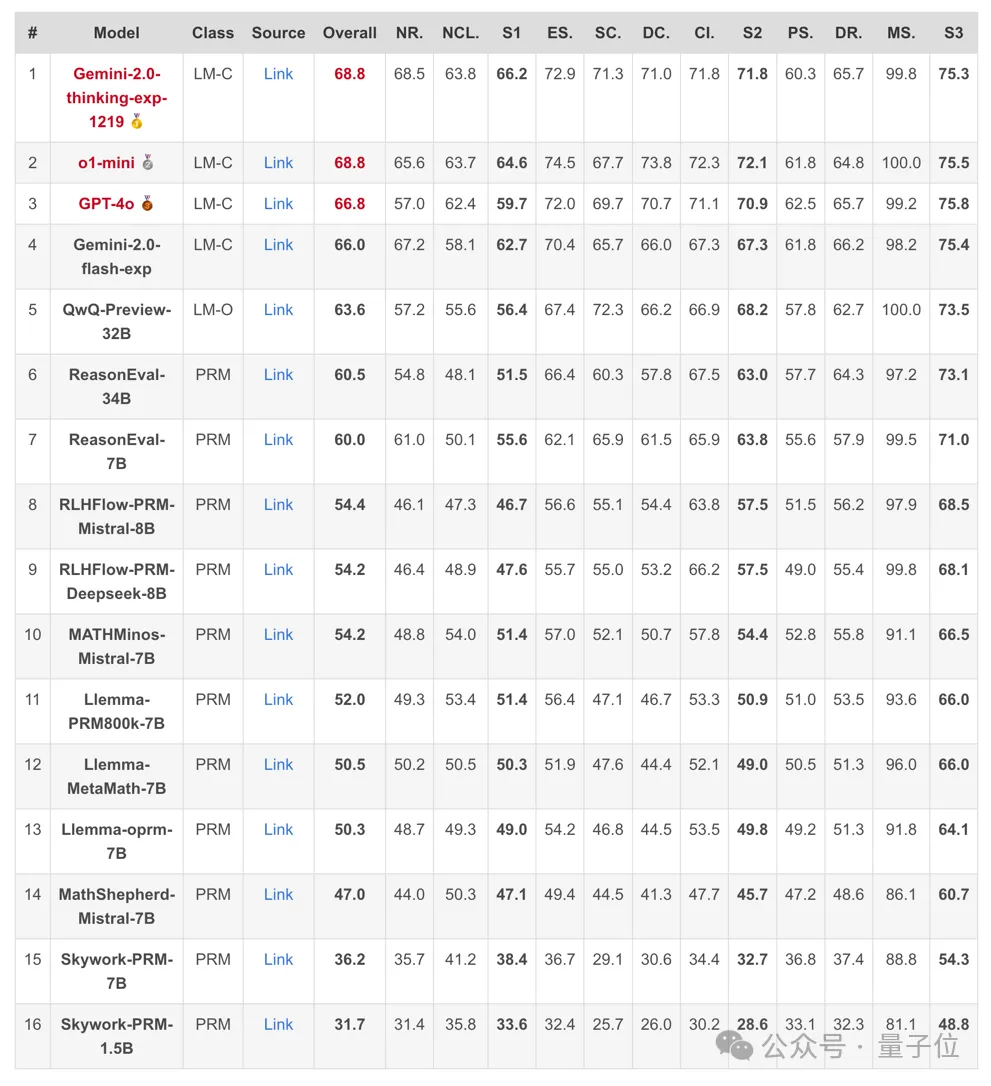

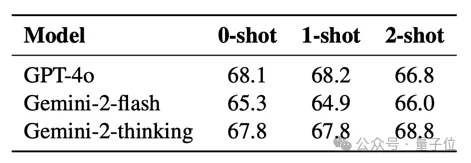

實(shí)驗(yàn)發(fā)現(xiàn),目前 PRMs 在細(xì)粒度錯(cuò)誤檢測(cè)上仍有較大提升空間。即使是表現(xiàn)最佳的模型 Gemini-2-Thinking,其 PRMScore 也僅為 68.8,勉強(qiáng)高于隨機(jī)猜測(cè)的 50.0。

即使是專門(mén)在步驟級(jí)數(shù)據(jù)上訓(xùn)練過(guò)的 PRMs,其表現(xiàn)仍不如優(yōu)秀的閉源通用模型,且多步推理能力專門(mén)增強(qiáng)過(guò)的模型表現(xiàn)優(yōu)于一般通用模型。

除此之外,研究人員還公布了一些其他發(fā)現(xiàn)和探討。

PRMBench:一次針對(duì)PRMs的“全方位體檢”

據(jù)介紹,PRMBench 并非簡(jiǎn)單的“升級(jí)版”評(píng)估數(shù)據(jù)集,而是一套經(jīng)過(guò)精心設(shè)計(jì)的“體檢方案”,目的是全面考察 PRMs 在不同維度上的能力。

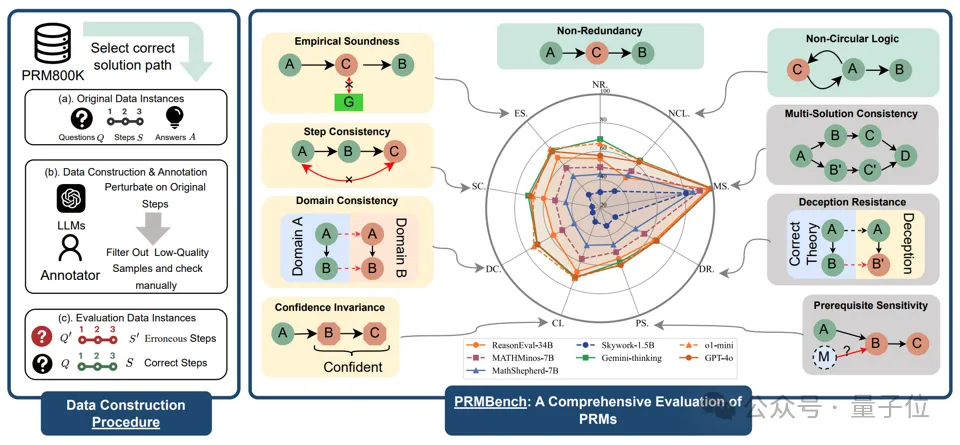

下圖為 PRMBench 的主要結(jié)構(gòu),左側(cè)部分展示了數(shù)據(jù)整理的流程,右側(cè)部分展示了評(píng)估主題的示例以及測(cè)試模型的相對(duì)性能表。

其主要特點(diǎn)包括:

- 海量且精細(xì)的標(biāo)注數(shù)據(jù):包含 6,216 個(gè)精心設(shè)計(jì)的問(wèn)題,并包含 83,456 個(gè)步驟級(jí)別的標(biāo)簽,確保評(píng)估的深度和廣度。

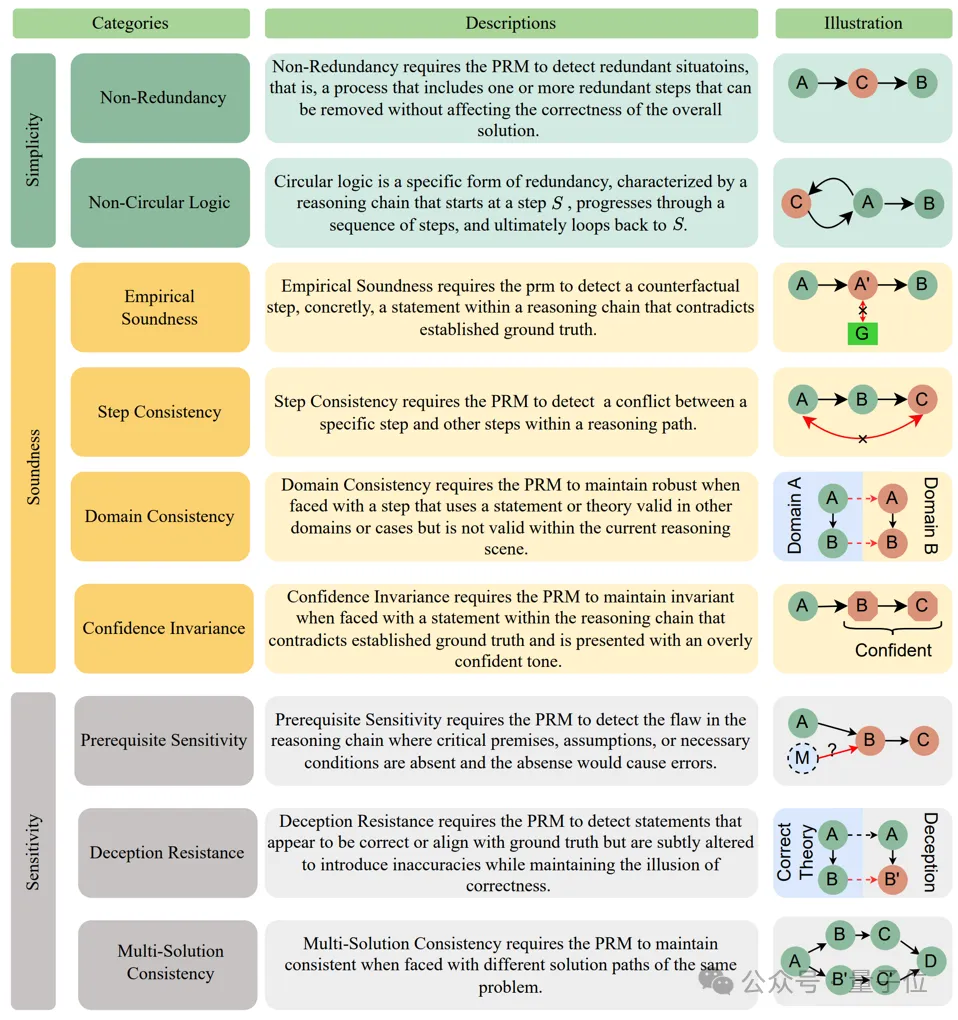

- 多維度、多層次的評(píng)估體系:從簡(jiǎn)潔性 (Simplicity)、合理性 (Soundness) 和敏感性 (Sensitivity) 三個(gè)主要維度出發(fā),進(jìn)一步細(xì)分為九個(gè)子類別,例如非冗余性、非循環(huán)邏輯、評(píng)價(jià)合理性、步驟一致性、領(lǐng)域一致性、置信度不變性、前提條件敏感性、 欺騙抵抗和一題多解一致性,力求全面覆蓋PRMs可能遇到的挑戰(zhàn)。

- 揭示現(xiàn)有 PRMs 的“盲區(qū)”:研究團(tuán)隊(duì)對(duì) 15 個(gè)代表性模型進(jìn)行了廣泛的實(shí)驗(yàn),包括開(kāi)源 PRMs 以及將強(qiáng)力通用語(yǔ)言模型提示作為 Critic Model 的模型。實(shí)驗(yàn)結(jié)果令人驚訝,也引人深思。

具體來(lái)說(shuō),研究的主要發(fā)現(xiàn)如下:

1、整體表現(xiàn)堪憂。即使是表現(xiàn)最佳的模型 Gemini-2-Thinking,其 PRMScore 也僅為 68.8,勉強(qiáng)高于隨機(jī)猜測(cè)的 50.0。這表明,即使是最先進(jìn)的 PRMs,在多步過(guò)程評(píng)估中仍然有巨大的提升空間。

2、開(kāi)源 PRMs 表現(xiàn)更弱。開(kāi)源 PRMs 的平均 PRMScore 更低至 50.1,部分模型甚至不如隨機(jī)猜測(cè),揭示了其可靠性和潛在訓(xùn)練偏差的問(wèn)題。

3、“簡(jiǎn)潔性”成最大挑戰(zhàn)。在 “簡(jiǎn)潔性” 維度上,即使是表現(xiàn)相對(duì)較好的 ReasonEval-34B,其 PRMScore 也驟降至 51.5,表明 PRMs 在識(shí)別推理過(guò)程中的冗余步驟方面能力不足。

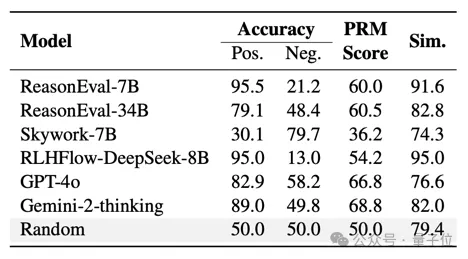

4、 “陽(yáng)性偏好”現(xiàn)象顯著。部分模型,例如 ReasonEval-7B 和 RLHFlow-DeepSeek-8B,在評(píng)估中表現(xiàn)出顯著的“陽(yáng)性偏好”,難以區(qū)分正確和錯(cuò)誤的步驟。

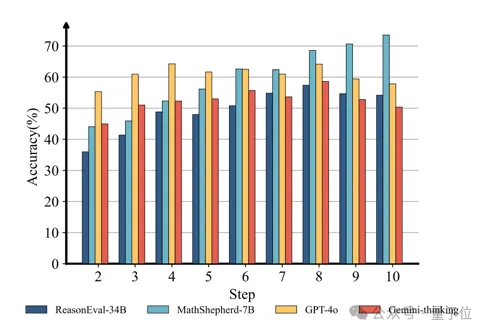

5、數(shù)據(jù)驅(qū)動(dòng)的洞察。研究發(fā)現(xiàn),錯(cuò)誤步驟出現(xiàn)的位置也會(huì)影響PRMs的判斷準(zhǔn)確率。總的來(lái)說(shuō),隨著錯(cuò)誤步驟位置的后移,PRMs 的表現(xiàn)會(huì)逐漸提升。

具體提出過(guò)程

下面介紹一下具體研究過(guò)程。

提出主要問(wèn)題

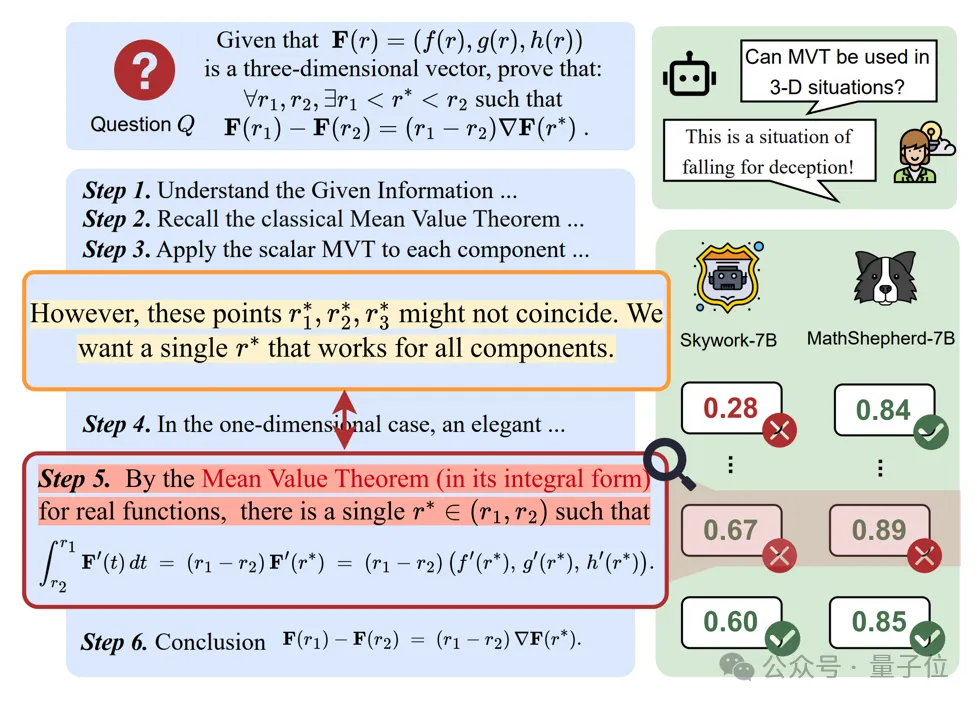

在一項(xiàng)需要舉出反例的證明題實(shí)踐中,研究人員觀察到一個(gè)有趣的現(xiàn)象:

即使大語(yǔ)言模型 (o1) 自身意識(shí)到當(dāng)前推理過(guò)程存在一些問(wèn)題,仍然會(huì)產(chǎn)生錯(cuò)誤的推理步驟。

更令人擔(dān)憂的是, 當(dāng)調(diào)用現(xiàn)有的 PRMs 去檢測(cè)剛剛 o1 生成的推理過(guò)程時(shí),結(jié)果卻發(fā)現(xiàn)多數(shù) PRMs 無(wú)法檢測(cè)出這種細(xì)粒度的錯(cuò)誤。

這一發(fā)現(xiàn)引出了一個(gè)關(guān)鍵問(wèn)題:當(dāng)前的 PRMs 是否具備檢測(cè)推理過(guò)程中細(xì)粒度錯(cuò)誤的能力?

下圖為,當(dāng)詢問(wèn)模型一道拉格朗日中值定理相關(guān)問(wèn)題時(shí),o1 和 PRMs 可能會(huì)產(chǎn)生的錯(cuò)誤。

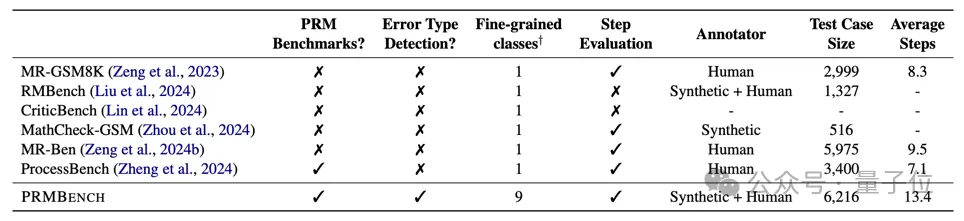

然而,現(xiàn)有針對(duì) PRMs 評(píng)測(cè)而設(shè)計(jì)的 benchmark 大多僅僅關(guān)注步驟評(píng)判的對(duì)錯(cuò),而忽視步驟評(píng)判的錯(cuò)誤類型, 缺乏對(duì)錯(cuò)誤類型的細(xì)致分類。

這也就意味著,目前缺少這樣能夠評(píng)測(cè) PRMs 在細(xì)粒度錯(cuò)誤上表現(xiàn)的綜合 benchmark。

而這,正是研究人員推出 PRMBench 這一精細(xì)化基準(zhǔn)的根本原因。

他們希望通過(guò) PRMBench,打破現(xiàn)有評(píng)估的局限,真正遴選出能夠有效識(shí)別細(xì)粒度錯(cuò)誤的“優(yōu)秀” PRM。

下圖為 PRMBench 與其他數(shù)據(jù)集對(duì)比。

PRMBench構(gòu)建

如下所示,PRMBench 包含三大評(píng)測(cè)主題:簡(jiǎn)潔性,合理性和敏感性。

- 數(shù)據(jù)來(lái)源:基于 PRM800K 構(gòu)建,首先篩選出其完全正確的問(wèn)題、答案以及解題步驟作為元數(shù)據(jù)。

- 錯(cuò)誤引入:針對(duì)多數(shù)評(píng)測(cè)主題(前8個(gè))使用 LLMs(特別是 GPT-4o)將各種細(xì)粒度的錯(cuò)誤引入到完全正確的解題推理步驟中。對(duì)于一題多解的情況,則使用多步推理增強(qiáng)過(guò)的語(yǔ)言模型為同一問(wèn)題生成不同的正確解法及其推理步驟。

- 人工驗(yàn)證:嚴(yán)格的人工審查,以確保引入錯(cuò)誤的質(zhì)量和相關(guān)性。

- 數(shù)據(jù)集統(tǒng)計(jì):包含 6,216 個(gè)精心設(shè)計(jì)的問(wèn)題,帶有 83,456 個(gè)步驟級(jí)別的標(biāo)簽。

- 評(píng)估對(duì)象:分為三個(gè)主要領(lǐng)域。簡(jiǎn)潔性評(píng)估冗余檢測(cè)能力(非冗余性、非循環(huán)邏輯);合理性評(píng)估PRM產(chǎn)生獎(jiǎng)勵(lì)的準(zhǔn)確性和正確性(評(píng)價(jià)合理性、步驟一致性、領(lǐng)域一致性、 置信度不變性);敏感性評(píng)估對(duì)變化和誤導(dǎo)性信息的魯棒性(前提條件敏感性、欺騙抵抗、多解一致性)。

實(shí)驗(yàn)與結(jié)果

研究人員測(cè)試了 15 個(gè)模型,包括開(kāi)源 PRMs (Skywork-PRM, Llemma-PRM, MATHMinos-Mistral,MathShepherd-Mistral, RLHFlow-PRM) 和提示為 Critic Models 的優(yōu)秀閉源語(yǔ)言模型 (GPT-4o, o1-mini,Gemini-2)。

評(píng)估指標(biāo)主要為:

- 負(fù) F1 分?jǐn)?shù) (Negative F1 Score):評(píng)估錯(cuò)誤檢測(cè)性能的主要指標(biāo)。

- PRMScore:將 F1 和負(fù) F1 相結(jié)合的統(tǒng)一、標(biāo)準(zhǔn)化的分?jǐn)?shù),以反映整體能力。

可以看出,整體而言 PRMs 在多步過(guò)程評(píng)估中表現(xiàn)出有限的能力,其得分通常僅略高于隨機(jī)猜測(cè)。

同時(shí), 開(kāi)源 PRMs 的表現(xiàn)通常不如將強(qiáng)力通用語(yǔ)言模型(如o1, Gemini-thinking等)提示為 Critic Model 的表現(xiàn)更好。

而且相較于其他評(píng)測(cè)主題,檢測(cè)冗余 (簡(jiǎn)潔性) 被證明對(duì) PRMs 來(lái)說(shuō)尤其困難。

另外,通過(guò) PRMBench 下模型對(duì)于正確標(biāo)簽測(cè)試樣例(陽(yáng)性數(shù)據(jù))和錯(cuò)誤標(biāo)簽測(cè)試樣例(陰性數(shù)據(jù))的得分對(duì)比及相似度來(lái)看。

許多 PRMs 表現(xiàn)出對(duì)正確標(biāo)簽的偏好,難以正確識(shí)別錯(cuò)誤標(biāo)簽測(cè)試樣例(陰性數(shù)據(jù))。

且從推理步驟位于推理鏈中不同位置對(duì)模型 PRMScore 的影響來(lái)看,PRMs 的性能往往會(huì)隨著推理步驟位于推理鏈中的位置逐漸靠后而提高。

最后從不同 Few shot 數(shù)目對(duì)于提示為 Critic Model 的通用語(yǔ)言模型表現(xiàn)影響來(lái)看,少樣本 ICL 的影響有限。

在 reward 過(guò)程中使用不同數(shù)量示例的 In-Context Learning 對(duì)閉源模型的性能影響不大。

小結(jié)一下,PRMBench 的發(fā)布,提醒我們重新審視現(xiàn)有 PRMs 的能力邊界。

按照研究團(tuán)隊(duì)的說(shuō)法,“我們希望 PRMBench 能夠成為推動(dòng) PRM 評(píng)估和發(fā)展研究的堅(jiān)實(shí)基石”。

更多細(xì)節(jié)歡迎查閱原論文。

論文鏈接:https://arxiv.org/abs/2501.03124

項(xiàng)目主頁(yè):https://prmbench.github.io/

Code:https://github.com/ssmisya/PRMBench

Data:https://huggingface.co/datasets/hitsmy/PRMBench_Preview