港大馬毅團隊等開源新作:用編碼率正則化重構視覺自監督學習范式,“少即是多”

最新開源的視覺預訓練方法,馬毅團隊、微軟研究院、UC伯克利等聯合出品!

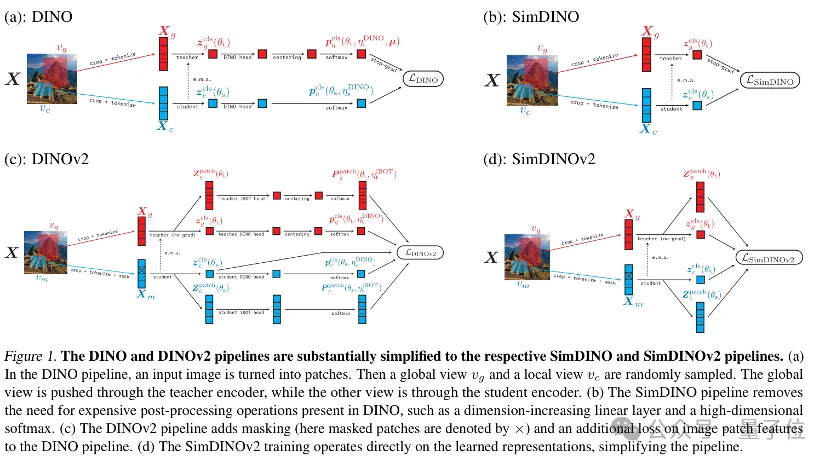

SimDINO和SimDINOv2,通過編碼率正則化簡化DINO和DINOv2模型訓練流程得到的兩個最新模型。

在目前視覺預訓練領域,DINO和DINOv2是最強視覺模型梯隊選手,也是目前最常用的方法。在多模態大模型火熱的當下,DINOv2也經常被用作VLM中的視覺編碼器提供視覺特征。

此外,圖靈獎得主、Meta首席AI科學家楊立昆團隊近期關于世界模型的工作,也基于DINOv2而來。

(當然了,DINO模型本身就是四年前Meta AI團隊提出的)

但DINO系列目前仍然需要基于非常復雜的工程方法來實現。

而SimDINO通過去除DINO中復雜的后處理步驟等,解決了DINO系列的訓練難題。

更令人驚喜的是,簡化后的模型不僅訓練更容易,性能反而更強。

或許這就是“簡單即是美”的設計理念在深度學習中的重要價值?(手動狗頭)

馬毅表示:

我們不是在修補DINO,而是在重新發現視覺表示學習的本質規律。

核心方法:化繁為簡

自監督學習(Self-Supervised Learning,SSL)在處理大規模未標記圖像數據方面取得了顯著進展。

在CV領域,DINO系列模型堪稱自監督學習的標桿選手。

這個無需人工標注就能從海量圖像中自主學習特征的模型,不僅在下游任務中屢創佳績,更成為多模態大模型視覺編碼器的標配。

但是,DINO系列模型的強能力,伴隨著「需要被精心呵護」:

- 需要精心設計的溫度調度策略(溫度參數τ要精確到小數點后三位)

- 依賴復雜的中心化-銳化操作(堪比精密儀器的校準流程)

- 必須搭配高維原型投影層(特征維度動輒破萬)

這些“保命裝置”雖然能防止模型陷入特征崩潰,卻讓訓練過程變成了超參數調優的噩夢。并且當研究人員嘗試改進模型架構或適配新領域時,往往牽一發而動全身,稍有不慎就會讓整個系統停擺。

為了解決這些問題,SimDINO和SimDINOv2模型閃亮登場~

通過引入編碼率正則化,簡化訓練流程,提高模型的魯棒性和性能。

這倆模型的核心思想,是通過編碼率正則化防止表示崩潰,從而去除原始DINO和DINOv2訓練流程中許多經驗性設計組件。

具體方法包括:

- 移除經驗性組件:刪除權重歸一化的線性層、平衡操作(如中心化、銳化)以及各種超參數(如溫度調度、中心化動量)等。

- 引入編碼率正則化:在損失函數中添加一個簡單的編碼率正則化項,以防止表示崩潰。

SimDINO和SimDINOv2模型的主要創新點除了上述2種方法外,還有一點,即簡化的訓練流程。

通過上述2種具體方法的改進,SimDINO和SimDINOv2的訓練流程更加簡潔,減少了對超參數的依賴,提高了訓練的穩定性和效率。

引入編碼率正則化,訓練更穩定、性能更強

回顧自監督對比學習“同類相聚,異類相斥”的原始出發點,研究團隊發現,DINO中許多復雜設計(如輸出層高維投影、教師網絡輸出中心化-銳化操作、溫度調節等)都是在間接地利用負樣本信息來防止模型習得的表示“崩潰”。

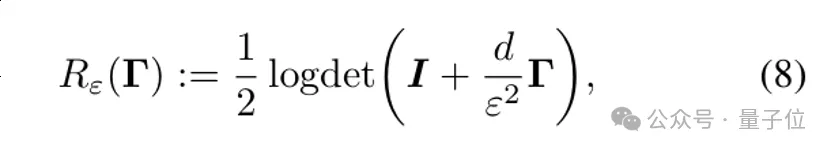

而SimDINO系列研究團隊提出這一需求,可以轉而使用馬毅提出的數據編碼率失真估計方法(可參考MCR2等系列工作),采用顯示度量模型表征的質量作為正則化項。

基于這一發現,研究人員提出了一個解決方案:

引入編碼率(coding rate)正則化,通過在損失函數中添加一個顯式的編碼率正則項來避免表示崩潰。

這個簡單的改動就能替代原本復雜的設計,將訓練流程向簡約靠近。

而簡化的模型訓練流程可以帶來幾個關鍵優勢,即「更清晰的優化目標、更少的組件依賴、更容易的理論分析、更好的可擴展性」。

具體而言,SimDINO保留了DINO模型的EMA自蒸餾方案和多視圖數據增強方法,但在對比學習方案上進行了修改。

拋棄輸出層高維原型投影+交叉熵多分類,直接使用歐幾里得距離/余弦相似度比較學生網絡(student network)和教師網絡(teacher network)生成的特征。

加入編碼率正則化項促使模型學習到更具區分性的表示,移除教師網絡輸出中心化-銳化操作、溫度調節等避免表示崩潰的技巧。

通過引入編碼率正則化,SimDINO能夠有效防止特征崩潰,確保學習到的信息具有較大的信息熵,從而提高模型的泛化能力。

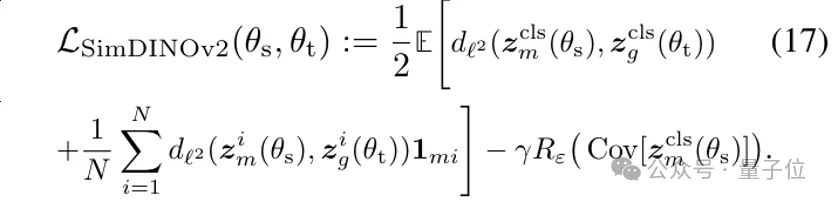

SimDINOv2 則進一步將DINOv2 引入的 iBOT機制進行替換。

它直接使用余弦相似度監督掩碼區域token與教師網絡表示間的對齊,而Sinkhorn-Knopp centering、KoLeo正則化等復雜設計也被簡化移除。

相比于原版DINO, SimDINO的訓練流程更為簡潔,去除了許多繁瑣的組件和超參數,降低了模型訓練的復雜度,使得研究人員和工程師更容易理解和實現這些模型。

從實驗角度看,這一系列操作可以讓模型訓練更穩定,性能也更強。

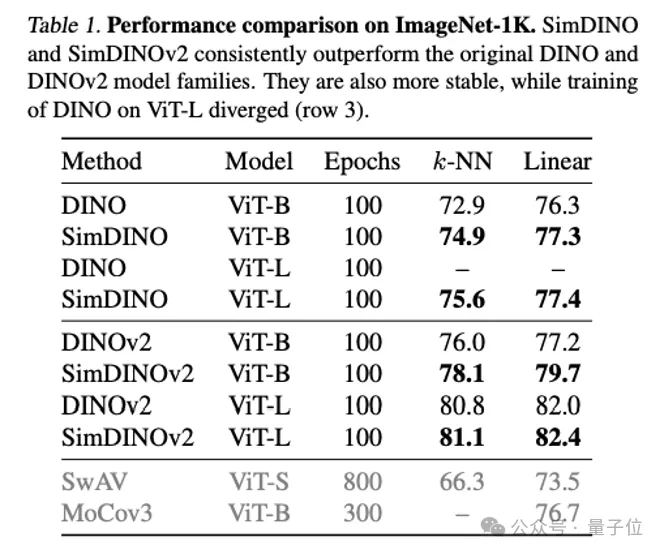

各種評估均優于DINO系列

為了驗證SimDINO和SimDINOv2的有效性,研究團隊在多個數據集和任務上進行了廣泛的實驗評估,包括圖像分類、目標檢測、語義分割以及視頻對象分割。

實驗結果表明,SimDINO系列在計算效率、訓練穩定性和下游任務性能上均優于DINO系列。

ImageNet-1K圖像分類

SimDINO和SimDINOv2在ImageNet-1K上進行了評估,包括k-NN 分類和線性評估(linear probing)。

還與DINO、DINOv2進行了對比。

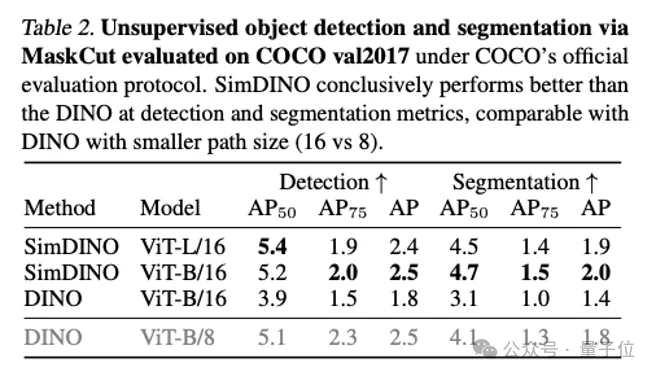

COCO val2017無監督目標檢測與實例分割

在目標檢測任務中,研究團隊采用MaskCut作為基礎檢測框架,并在COCO val2017數據集上進行了評估。

具體來說,主要對比了AP50、AP75和AP三個指標:

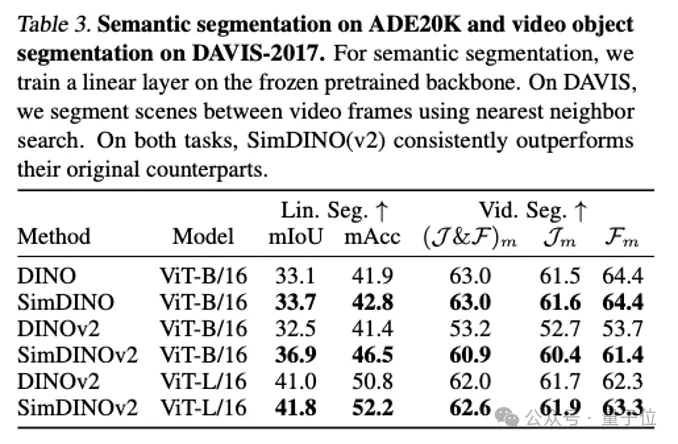

ADE20K語義分割和DAVIS-2017視頻對象分割

在語義分割任務上,研究團隊采用linear head并在ADE20K數據集上進行了評估。

這個任務上主要對比了 mIoU(平均交并比)和 mAcc(平均像素精度)。

特別要提到的是,SimDINO還在DAVIS-2017上進行了評估,包括 (J&F)m、Jm和Fm三個標準指標。

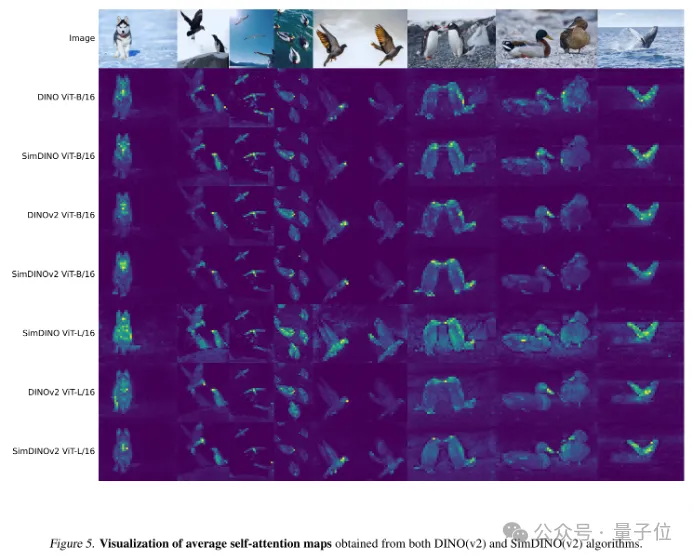

結果顯示,它在定性的特征可視化分析上也展現出了DINO系列工作中表現突出的語義表達能力涌現現象。

與此同時,SimDINO和SimDINOv2對超參數和數據的變化更穩健了。

其它

此外,項目論文中通過理論分析,提出了一個關于SimDINO超參數選擇的理論:

如何平衡編碼率正則化項和距離項的梯度范數。

通過理論推導,作者給出了一個關于超參數γ的選擇方法,使得兩個項的梯度范數在優化過程中保持平衡。

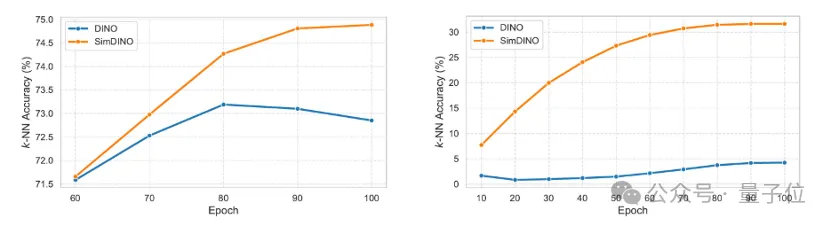

下圖顯示的是在SimDINO和DINO下訓練 ViT-B/16的訓練動態。

X軸表示訓練周期(epochs),Y軸表示在ImageNet-1K上的k-NN評估性能。

其中,左圖顯示的是兩個模型均在ImageNet-1K數據集上訓練。

為更好地展示優化過程,研究團隊省略了早期訓練階段的數據。

右圖顯示的是兩個模型均在 COCO train2017 數據集(大約是 ImageNet-1K的1/10)上訓練。

作為一個驗證實驗,該結果表明SimDINO需要更少的超參數調優,并且優化過程更加簡單。

研究團隊

SimDINO系列由多所學校與機構的研究者共同完成,包括UC伯克利、憶生科技、微軟研究院、香港大學等。

一作是UC伯克利三年級博士生吳梓陽,導師是馬毅。

他主要研究方向為表征學習與多模態學習,致力于通過數學與統計理論構建高效、可解釋的深度學習模型。

此前,吳梓陽本碩均就讀于康奈爾大學。

在論文最后,SimDINO研究團隊進一步提出和建議了SimDINO的幾個潛在改進方向:

- 在SimDINO框架基礎上進一步探索不需要自蒸餾優化的自監督目標。

- 簡化后的框架為自監督學習的理論分析提供了更好的切入點。

- 將”顯式化隱式設計選擇”的范式推廣到其他框架,啟發并探索其他模型的簡化改進方法。

論文地址:https://arxiv.org/abs/2502.10385

項目主頁:https://robinwu218.github.io/SimDINO

GitHub:https://github.com/RobinWu218/SimDINO