RAG(二)深度解析GraphRAG:如何基于知識(shí)圖譜提升RAG性能

前面了解了RAG的開(kāi)山之作,今天來(lái)看下微軟提出的GraphRAG是如何提升RAG性能的。

首先了解下研究動(dòng)機(jī):

傳統(tǒng)的RAG方法在處理局部信息檢索方面表現(xiàn)出色,但對(duì)于涉及整個(gè)文本語(yǔ)料庫(kù)的全局性問(wèn)題,如“數(shù)據(jù)集中有哪些主要主題?”這樣的問(wèn)題,它們的表現(xiàn)不佳。

更合適的任務(wù)框架應(yīng)當(dāng)是查詢(xún)聚焦型摘要(Query-Focused Summarization,QFS),特別是抽象式摘要,它可以生成自然語(yǔ)言的總結(jié)而不僅僅是摘錄片段。隨著LLM的發(fā)展,GPT、Llama 和 Gemini 系列等模型可以通過(guò)上下文學(xué)習(xí)來(lái)總結(jié)任何在其上下文窗口內(nèi)提供的內(nèi)容,但是,對(duì)于需要對(duì)整個(gè)語(yǔ)料庫(kù)進(jìn)行查詢(xún)聚焦型抽象摘要的情況,尤其是當(dāng)文本量遠(yuǎn)超出了LLM上下文窗口的限制時(shí),仍然存在挑戰(zhàn)。

研究人員希望結(jié)合兩種方法的優(yōu)點(diǎn),即RAG的精確性和QFS的大規(guī)模文本處理能力,以更有效地回答全局性質(zhì)的問(wèn)題。

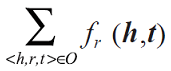

因此,來(lái)自微軟的研究團(tuán)隊(duì)提出GraphRAG,利用LLM構(gòu)建了一個(gè)基于圖的文本索引。此索引不僅包括節(jié)點(diǎn)(例如實(shí)體),還包括邊(例如關(guān)系)和協(xié)變量(例如聲明)。通過(guò)這種方法,Graph RAG能夠更好地捕捉文本之間的關(guān)聯(lián),并支持對(duì)大規(guī)模文本集合的全局理解和摘要。

項(xiàng)目地址:https://aka.ms/graphrag

下面詳細(xì)介紹下方法實(shí)現(xiàn):

1、方法介紹

圖1為GraphRAG的pipeline和實(shí)現(xiàn)細(xì)節(jié),主要分為以下幾個(gè)部分:

源文檔(Source Documents) → 文本塊(Text Chunks)

拿到一個(gè)文檔,無(wú)論是構(gòu)建一個(gè)圖譜還是傳統(tǒng)的RAG方法,第一步都是從原始文檔中提取文本,并將其分割成適合后續(xù)處理的文本塊。

這里就涉及到文本塊的分割粒度問(wèn)題:較長(zhǎng)文本塊,減少對(duì)LLM的調(diào)用次數(shù),但可能由于LLM上下文窗口長(zhǎng)度的限制而導(dǎo)致召回率下降。較短文本塊,雖然增加了調(diào)用次數(shù),但有助于保持較高的召回率,因?yàn)槊總€(gè)塊的信息量較小,更容易完整地捕捉到其中的關(guān)鍵信息。

如圖2,在 HotPotQA 數(shù)據(jù)集上,單輪提取的情況下,使用600 token大小的文本塊幾乎可以提取兩倍于2400 token大小文本塊的實(shí)體引用數(shù)量。這是因?yàn)檩^長(zhǎng)的文本塊可能會(huì)導(dǎo)致某些重要信息“丟失在中間”,特別是在LLM上下文窗口長(zhǎng)度固定的情況下。

這里作者沒(méi)有給出實(shí)際的分塊方法,實(shí)際上,根據(jù)具體應(yīng)用場(chǎng)景的需求來(lái)選擇合適的文本塊大小。通常來(lái)說(shuō),較小的文本塊更適合保證高召回率,而較大的文本塊則可能更經(jīng)濟(jì)高效,尤其是在處理非常大的文檔集合時(shí)。為了確保連續(xù)文本塊之間不會(huì)遺漏重要的上下文信息,可以在相鄰文本塊之間設(shè)置一定的重疊。例如,在論文中提到的數(shù)據(jù)集處理中,文本塊大小為600 tokens,且相鄰塊之間有100 tokens的重疊。

文本塊 → 元素實(shí)例(Element Instances)

在劃分好文本塊之后,一個(gè)基本要求是從每個(gè)文本塊中識(shí)別并抽取圖節(jié)點(diǎn)和邊的實(shí)例。

具體來(lái)說(shuō),通過(guò)一個(gè)多部分的LLM提示來(lái)完成,首先識(shí)別所有實(shí)體(包括名稱(chēng)、類(lèi)型和描述),然后識(shí)別清楚相關(guān)的實(shí)體之間的關(guān)系(包括源實(shí)體、目標(biāo)實(shí)體及其關(guān)系描述)。最后,所有類(lèi)型的元素實(shí)例(實(shí)體和關(guān)系)都被組織成一個(gè)統(tǒng)一的、由分隔符分隔的元組列表輸出。

為了使提示適應(yīng)特定領(lǐng)域的文檔語(yǔ)料庫(kù),可以為L(zhǎng)LM提供用于上下文學(xué)習(xí)的少量示例。例如,默認(rèn)提示可能適用于廣泛類(lèi)別的“命名實(shí)體”(如人名、地名、組織名),但對(duì)于具有專(zhuān)業(yè)知識(shí)的領(lǐng)域(如科學(xué)、醫(yī)學(xué)、法律等),則可以通過(guò)提供專(zhuān)門(mén)化的示例來(lái)優(yōu)化提取效果。另外,還支持對(duì)與提取的節(jié)點(diǎn)實(shí)例關(guān)聯(lián)的任何附加協(xié)變量進(jìn)行二次提取。默認(rèn)協(xié)變量提示旨在提取與檢測(cè)到的實(shí)體相關(guān)聯(lián)的聲明,包括主題、對(duì)象、類(lèi)型、描述、源文本跨度以及開(kāi)始和結(jié)束日期。

為了平衡效率和質(zhì)量,使用多個(gè)“gleaning”輪次來(lái)鼓勵(lì)LLM捕捉任何之前可能遺漏的實(shí)體。這是一個(gè)多階段的過(guò)程:

- 評(píng)估完整性:首先詢(xún)問(wèn)LLM是否所有實(shí)體都已被提取,使用logit偏置強(qiáng)制模型做出二選一的回答(是/否)。

- 繼續(xù)挖掘:如果LLM回答有實(shí)體被遺漏,則通過(guò)提示告知“上次提取中遺漏了許多實(shí)體”,促使LLM補(bǔ)充這些遺漏的實(shí)體。

- 實(shí)驗(yàn)驗(yàn)證:這種方法允許使用較大的文本塊而不降低質(zhì)量或引入噪音,如圖2所示,在HotPotQA數(shù)據(jù)集上,600 token大小的文本塊幾乎能提取兩倍于2400 token大小文本塊的實(shí)體引用數(shù)量,但通過(guò)增加遍歷次數(shù)(gleanings),可以顯著提升較大文本塊上的實(shí)體檢測(cè)數(shù)量和質(zhì)量。

元素實(shí)例 → 元素摘要(Element Summaries)

使用LLM“提取”源文本中的實(shí)體、關(guān)系和聲明描述實(shí)際上已經(jīng)是一種抽象摘要生成的形式。這意味著LLM不僅僅是在簡(jiǎn)單地識(shí)別這些元素,而是在創(chuàng)造獨(dú)立有意義的概念摘要。這些概念可能是隱含的,而不是由文本本身明確陳述的(例如,隱含關(guān)系的存在)。

為了將所有此類(lèi)實(shí)例級(jí)摘要轉(zhuǎn)換為每個(gè)圖元素(即實(shí)體節(jié)點(diǎn)、關(guān)系邊和聲明協(xié)變量)的單個(gè)描述性文本塊,需要對(duì)匹配的實(shí)例組進(jìn)行進(jìn)一步的LLM摘要生成。這個(gè)過(guò)程確保了每個(gè)圖元素都有一個(gè)單一、連貫且描述性的文本塊,從而提高了信息的清晰度和組織性。

這里存在的一個(gè)潛在的問(wèn)題是,LLM可能不會(huì)始終以相同的文本格式提取對(duì)同一實(shí)體的引用,這可能導(dǎo)致重復(fù)的實(shí)體元素,進(jìn)而產(chǎn)生圖中的重復(fù)節(jié)點(diǎn)。

但是對(duì)于LLM來(lái)說(shuō),這又是很容易解決的一個(gè)問(wèn)題:由于緊密相關(guān)的“社區(qū)”將在接下來(lái)的步驟中被檢測(cè)并總結(jié),而且LLM能夠理解多個(gè)名稱(chēng)變化背后共同的實(shí)體,因此整個(gè)方法對(duì)于這些變化具有魯棒性。只要所有變化都通過(guò)足夠的連接指向一組緊密相關(guān)的實(shí)體,整體方法就可以保持一致性和準(zhǔn)確性。換句話(huà)說(shuō),即使存在不同的命名方式或拼寫(xiě)變化,LLM依然能夠識(shí)別它們代表的是同一個(gè)實(shí)體,從而避免了不必要的重復(fù)。

總體而言,在潛在噪聲圖結(jié)構(gòu)中對(duì)同質(zhì)節(jié)點(diǎn)使用豐富的描述性文本,這與LLM的能力和全局查詢(xún)聚焦摘要生成的需求相一致。通過(guò)這種方式,不僅捕捉到了文檔中的顯式信息,也涵蓋了那些隱含但重要的概念。這些特性也將圖索引與典型的知識(shí)圖區(qū)分開(kāi)。傳統(tǒng)的知識(shí)圖依賴(lài)于簡(jiǎn)潔且一致的知識(shí)三元組(主體、謂詞、客體)進(jìn)行下游推理任務(wù),而圖索引則更注重描述性和靈活性,旨在支持更廣泛的認(rèn)知活動(dòng)和復(fù)雜的查詢(xún)?nèi)蝿?wù)。

最終輸出的是經(jīng)過(guò)LLM總結(jié)后的描述性文本塊,這些文本塊代表了圖中的各個(gè)元素(實(shí)體、關(guān)系和聲明)。每個(gè)元素現(xiàn)在都有一個(gè)簡(jiǎn)明而全面的描述,這不僅有助于理解該元素本身,還便于在后續(xù)步驟中對(duì)其進(jìn)行處理和分析。

元素摘要 → 圖社區(qū)(Graph Communities)

基于提取出的實(shí)體、關(guān)系和聲明,創(chuàng)建一個(gè)圖結(jié)構(gòu),其中實(shí)體作為節(jié)點(diǎn),關(guān)系作為邊,邊權(quán)重代表關(guān)系實(shí)例的歸一化計(jì)數(shù)。給定這樣的圖,使用社區(qū)檢測(cè)算法將圖劃分為多個(gè)節(jié)點(diǎn)社區(qū),每個(gè)社區(qū)由一組緊密相連的節(jié)點(diǎn)組成,這些節(jié)點(diǎn)之間的連接比與其他節(jié)點(diǎn)的連接更為緊密。

GraphRAG中的社區(qū)算法采用Leiden算法,因?yàn)樗軌蚋咝У鼗謴?fù)大規(guī)模圖的層次社區(qū)結(jié)構(gòu)。此層次結(jié)構(gòu)的每個(gè)級(jí)別都提供了一個(gè)社區(qū)劃分,以互斥且集體窮盡的方式覆蓋圖的節(jié)點(diǎn),從而實(shí)現(xiàn)分治的全局摘要生成。

最終輸出的是一個(gè)經(jīng)過(guò)社區(qū)檢測(cè)算法處理后的圖結(jié)構(gòu),其中原始節(jié)點(diǎn)被劃分為若干個(gè)社區(qū)。每個(gè)社區(qū)包含了一組緊密相關(guān)的節(jié)點(diǎn),這些節(jié)點(diǎn)之間的連接強(qiáng)度高于與外部節(jié)點(diǎn)的連接。這樣的社區(qū)劃分不僅有助于理解數(shù)據(jù)的整體結(jié)構(gòu),也為后續(xù)的查詢(xún)聚焦型摘要生成提供了基礎(chǔ)。

圖社區(qū) → 社區(qū)摘要(Community Summaries)

接下來(lái)就是為每個(gè)社區(qū)生成獨(dú)立有用的、類(lèi)似報(bào)告的摘要,以幫助用戶(hù)理解數(shù)據(jù)集的全局結(jié)構(gòu)和語(yǔ)義。這些社區(qū)摘要可以用于后續(xù)的查詢(xún)聚焦型摘要生成,特別是在處理需要對(duì)整個(gè)語(yǔ)料庫(kù)進(jìn)行綜合理解的復(fù)雜查詢(xún)。

對(duì)于大型數(shù)據(jù)集,單個(gè)社區(qū)可能包含大量信息,如何有效地將這些信息濃縮成有意義的摘要是一個(gè)挑戰(zhàn)。GraphRAG分為葉級(jí)社區(qū)和高級(jí)社區(qū)生成:

- 葉級(jí)社區(qū)摘要生成:葉級(jí)社區(qū)(即最底層社區(qū))的元素摘要(節(jié)點(diǎn)、邊、協(xié)變量)被優(yōu)先考慮,即對(duì)于葉級(jí)社區(qū),首先按源節(jié)點(diǎn)和目標(biāo)節(jié)點(diǎn)的度(邊的權(quán)重)的降序排列,然后,依次將源節(jié)點(diǎn)、目標(biāo)節(jié)點(diǎn)、相關(guān)協(xié)變量以及邊本身的信息添加到LLM的上下文窗口中,直到達(dá)到token限制。這確保了最重要和最具代表性的信息被優(yōu)先考慮。

- 更高級(jí)別社區(qū)摘要生成:如果所有元素摘要都能適應(yīng)上下文窗口的token限制,則直接生成該社區(qū)的摘要。如果無(wú)法全部適應(yīng),則按元素摘要tokens數(shù)量遞減的順序?qū)ψ由鐓^(qū)進(jìn)行排名,并迭代的用較短的子社區(qū)摘要替換其關(guān)聯(lián)的較長(zhǎng)元素摘要,直到適應(yīng)上下文窗口。這種方法允許在保持信息完整性的同時(shí),減少token使用量。

社區(qū)摘要 → 社區(qū)答案 (Community Answer)→ 全局答案(Global Answer)

給定用戶(hù)查詢(xún),上一步生成的社區(qū)摘要可用于生成最終答案,這是一個(gè)多階段過(guò)程。社區(qū)結(jié)構(gòu)的層次性質(zhì)也意味著可以使用不同級(jí)別的社區(qū)摘要來(lái)回答問(wèn)題。

這里存在一個(gè)問(wèn)題:層次社區(qū)結(jié)構(gòu)中的特定級(jí)別是否提供了摘要細(xì)節(jié)和范圍的最佳平衡,以應(yīng)對(duì)一般理解問(wèn)題。

對(duì)于給定的社區(qū)級(jí)別,任何用戶(hù)查詢(xún)的全局答案生成如下:

- 準(zhǔn)備社區(qū)摘要:為了確保相關(guān)信息均勻分布,而不是集中在單個(gè)上下文窗口中,首先將社區(qū)摘要隨機(jī)打亂,并分成預(yù)定義token大小的塊。這樣可以避免某些重要信息因超出上下文窗口限制而被忽略,保證了信息的完整性和多樣性。

- 映射社區(qū)答案:對(duì)于每個(gè)分塊,使用LLM并行生成中間答案。這意味著每個(gè)文本塊都會(huì)產(chǎn)生一個(gè)獨(dú)立的初步回答。LM還被要求為每個(gè)生成的答案提供一個(gè)0-100的評(píng)分,指示該答案對(duì)于回答目標(biāo)問(wèn)題的幫助程度。這有助于后續(xù)篩選最有用的信息。

- 歸約為全局答案:中間社區(qū)答案按幫助性分?jǐn)?shù)的降序排序,并迭代地添加到新的上下文窗口中,直到達(dá)到 token 限制。此最終上下文用于生成返回給用戶(hù)的全局答案。

2、實(shí)驗(yàn)設(shè)置

數(shù)據(jù)集

為了評(píng)估Graph RAG的有效性,作者選擇了兩個(gè)具有代表性的數(shù)據(jù)集,每個(gè)數(shù)據(jù)集大約包含一百萬(wàn)token,相當(dāng)于約10本小說(shuō)的文字量。這些數(shù)據(jù)集反映了用戶(hù)在現(xiàn)實(shí)世界活動(dòng)中可能遇到的文檔集合類(lèi)型。

- 播客轉(zhuǎn)錄文本(Podcast Transcripts):由微軟CTO Kevin Scott主持的技術(shù)播客《Behind the Tech》的編譯轉(zhuǎn)錄文本。包含1669個(gè)600-token文本塊,塊間有100-token重疊(約100萬(wàn)tokens)。

- 新聞文章(News Articles):從2013年9月到2023年12月期間發(fā)布的涵蓋娛樂(lè)、商業(yè)、體育、技術(shù)、健康和科學(xué)等多個(gè)類(lèi)別的新聞文章。包含3197個(gè)600-token文本塊,塊間有100-token重疊(約170萬(wàn)tokens)。

測(cè)試問(wèn)題生成

為了生成適用于全局認(rèn)知任務(wù)的問(wèn)題,作者采用了一種以活動(dòng)為中心的方法自動(dòng)化生成問(wèn)題。這種方法確保了問(wèn)題只傳達(dá)對(duì)數(shù)據(jù)集內(nèi)容的高層次理解,而不是具體細(xì)節(jié),從而更適合評(píng)估RAG系統(tǒng)在更廣泛的認(rèn)知任務(wù)中的表現(xiàn)。

- 活動(dòng)中心法:給定一個(gè)數(shù)據(jù)集的簡(jiǎn)短描述,要求LLM識(shí)別N個(gè)潛在用戶(hù)和每個(gè)用戶(hù)的N個(gè)任務(wù),然后為每個(gè)(用戶(hù),任務(wù))組合生成N個(gè)需要理解整個(gè)語(yǔ)料庫(kù)的問(wèn)題。

- 示例問(wèn)題:例如,對(duì)于播客轉(zhuǎn)錄文本,問(wèn)題可能涉及“哪些劇集主要討論科技政策和政府監(jiān)管?”;對(duì)于新聞文章,則可能是“當(dāng)前哪些健康話(huà)題可以整合到健康教育課程中?”。

- 數(shù)量:對(duì)于每個(gè)數(shù)據(jù)集,N=5,共生成125個(gè)測(cè)試問(wèn)題。

為了全面評(píng)估Graph RAG的性能,作者比較了六種不同的條件,包括使用不同層級(jí)社區(qū)摘要的Graph RAG方法、直接對(duì)源文本進(jìn)行映射-歸約摘要的方法(TS),以及樸素的語(yǔ)義搜索RAG方法(SS)。具體描述如下:

- C0:使用根級(jí)社區(qū)摘要(數(shù)量最少)來(lái)回答用戶(hù)查詢(xún)。

- C1:使用高級(jí)社區(qū)摘要來(lái)回答查詢(xún)。這些是C0的子社區(qū)(如果存在),否則是C0社區(qū)的向下投影。

- C2:使用中級(jí)社區(qū)摘要來(lái)回答查詢(xún)。這些是C1的子社區(qū)(如果存在),否則是C1社區(qū)的向下投影。

- C3:使用低級(jí)社區(qū)摘要(數(shù)量最多)來(lái)回答查詢(xún)。這些是C2的子社區(qū)(如果存在),否則是C2社區(qū)的向下投影。

- TS:直接對(duì)源文本進(jìn)行映射-歸約摘要的方法,類(lèi)似于Graph RAG的最后步驟,但直接作用于原始文本而非社區(qū)摘要。

- SS:一種樸素的RAG實(shí)現(xiàn),通過(guò)檢索文本塊并將其添加到上下文窗口中直到達(dá)到指定的token限制。

評(píng)價(jià)指標(biāo)(Metrics)

為了評(píng)估不同條件下生成的答案質(zhì)量,作者選擇了一個(gè)基于LLM的頭對(duì)頭比較方法,定義了四個(gè)目標(biāo)度量標(biāo)準(zhǔn),旨在捕捉對(duì)認(rèn)知活動(dòng)有益的質(zhì)量特征:

- 全面性(Comprehensiveness):答案提供的細(xì)節(jié)覆蓋了多少方面和細(xì)節(jié)?

- 多樣性(Diversity):答案在提供不同視角和見(jiàn)解上有多豐富?

- 賦能性(Empowerment):答案在幫助讀者理解和做出明智判斷上有何效果?

- 直接性(Directness):答案如何具體且明確地解決提問(wèn)?

表2顯示了LLM生成的評(píng)估示例:

3、實(shí)驗(yàn)結(jié)果

索引過(guò)程生成了一個(gè)由8564個(gè)節(jié)點(diǎn)和20691條邊組成的播客數(shù)據(jù)集圖,以及一個(gè)由15754個(gè)節(jié)點(diǎn)和19520條邊組成的更大的新聞數(shù)據(jù)集圖。表3顯示了不同級(jí)別的圖社區(qū)層次結(jié)構(gòu)中社區(qū)摘要的數(shù)量。

Graph RAG vs Na?ve RAG

- 全面性(Comprehensiveness):

Graph RAG vs Na?ve RAG:所有全局方法(C0, C1, C2, C3, TS)在全面性方面均優(yōu)于樸素RAG(SS)。這是因?yàn)槿址椒軌蚋玫夭蹲胶驼蟻?lái)自多個(gè)社區(qū)摘要的信息,提供更廣泛的內(nèi)容覆蓋。

層級(jí)選擇的影響:使用中間層和低層社區(qū)摘要的Graph RAG(C2, C3)表現(xiàn)尤為突出,在全面性上超過(guò)了直接總結(jié)源文本的方法(TS),并且在相同指標(biāo)下具有更低的token成本。 - 多樣性(Diversity):

Graph RAG的優(yōu)勢(shì):Graph RAG方法在多樣性方面同樣表現(xiàn)出色,特別是當(dāng)使用較低層次的社區(qū)摘要(C2, C3)。這些方法能夠提供更加豐富多樣的視角和見(jiàn)解,涵蓋了更多的子話(huà)題和細(xì)節(jié)。

原因分析:由于較低層次的社區(qū)摘要包含更詳細(xì)的子社區(qū)信息,因此它們可以提供更廣泛且深入的回答,避免了高層次摘要可能遺漏的具體內(nèi)容。 - 賦能性(Empowerment):

全局方法與樸素RAG(SS)以及Graph RAG方法與源文本摘要生成(TS)的結(jié)果參差不齊。臨時(shí)使用LLM分析LLM推理表明,提供具體示例、引用和引文的能力被認(rèn)為是幫助用戶(hù)達(dá)成明智理解的關(guān)鍵。調(diào)整元素提取提示可能有助于在Graph RAG索引中保留更多這些細(xì)節(jié)。 - 直接性(Directness):

平衡考量:雖然直接性是衡量答案是否具體且明確地解決提問(wèn)的一個(gè)重要標(biāo)準(zhǔn),但它通常與全面性和多樣性呈反比關(guān)系。因此,作者并未期望任何一種方法能在所有四個(gè)度量標(biāo)準(zhǔn)上都占據(jù)優(yōu)勢(shì)。

Graph RAG的表現(xiàn):盡管如此,Graph RAG在保持高全面性和多樣性的前提下,依然能夠在直接性方面提供清晰且有針對(duì)性的回答。

社區(qū)摘要 vs. 源文本

社區(qū)摘要通常在答案的全面性和多樣性方面提供了小幅但一致的改進(jìn),除了根級(jí)摘要。

表3還說(shuō)明了Graph RAG與源文本摘要生成相比的可擴(kuò)展性?xún)?yōu)勢(shì):對(duì)于低級(jí)社區(qū)摘要(C3),Graph RAG需要少26-33%的上下文token,而對(duì)于根級(jí)社區(qū)摘要(C0),它需要少97%以上的token。與其他全局方法相比,性能略有下降,根級(jí)Graph RAG提供了一種高度高效的方法,用于迭代式問(wèn)答,這是理解活動(dòng)的特征,同時(shí)在全面性(72%勝率)和多樣性(62%勝率)方面保留了優(yōu)于樸素RAG的優(yōu)勢(shì)。

4、總結(jié)

在大模型時(shí)代,都不看好知識(shí)圖譜的發(fā)展,其實(shí)將知識(shí)圖譜和LLM結(jié)合,能夠更好的將開(kāi)放域知識(shí)引入LLM,GraphRAG就是一個(gè)LLM和圖譜結(jié)合非常好的例子。

GraphRAG對(duì)于需要全文理解,摘要生成等任務(wù),是一個(gè)非常好的解決方案,但是這里存在一個(gè)巨大的隱患,圖譜構(gòu)建的過(guò)程,可能需要大量的資源和時(shí)間。

對(duì)于GraphRAG和RAG的使用,更多的還是根據(jù)任務(wù)需求來(lái)決定。