CVPR2025 | MobileMamba:輕量級Mamba網絡新突破,兼顧多感受野、高效推理與超強精度

1. 一眼概覽

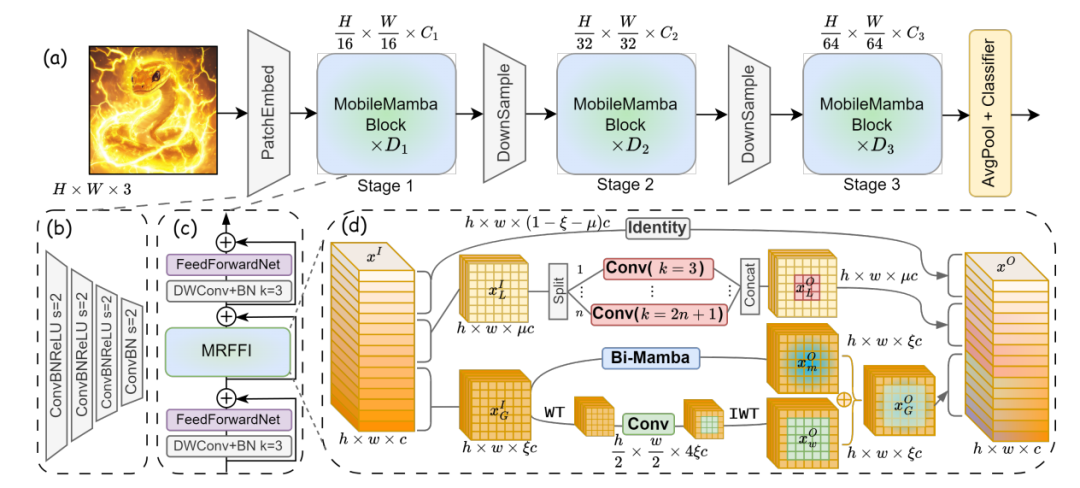

MobileMamba 提出了一種輕量級多感受野視覺 Mamba 網絡,通過三階段網絡設計和 MRFFI(Multi-Receptive Field Feature Interaction) 模塊,在提升模型推理速度的同時,實現更高精度,超越現有 CNN、ViT 和 Mamba 結構。

2. 核心問題

當前輕量級視覺模型主要基于 CNN 和 Transformer:

? CNN 局部感受野限制了全局建模能力。

? Transformer 具備全局感受野,但高分辨率下計算復雜度高(O(N2))。

? 現有 Mamba 輕量級模型雖然 FLOPs 低,但推理速度較慢。

MobileMamba 旨在:

? 優化 Mamba 的推理速度,在保證低 FLOPs 的情況下提高吞吐量。

? 增強多尺度感受野交互,兼顧長短距離特征捕獲和高頻細節提取。

? 適應高分辨率任務,在分類、目標檢測、語義分割等任務上提升表現。

3. 技術亮點

(1)三階段網絡設計

? 通過權衡四階段和三階段網絡,選用三階段架構,在相同吞吐量下提升精度,或在相同精度下提升吞吐量。

(2)MRFFI(多感受野特征交互)模塊

? WTE-Mamba(長程小波變換增強 Mamba):結合全局建模與高頻邊緣信息提取。

? MK-DeConv(多核深度卷積):提取不同尺度信息,增強局部感受野。

? 消除冗余身份映射(Eliminate Redundant Identity):減少通道冗余,提高計算效率。

(3)訓練 & 測試策略優化

? 知識蒸餾(Knowledge Distillation) 提高輕量級模型的學習能力。

? 擴展訓練輪次(Extended Training Epochs) 進一步提升精度上限。

? 歸一化層融合(Normalization Layer Fusion) 在測試時加速推理。

4. 方法框架

圖片

圖片

MobileMamba 通過以下核心步驟優化推理和特征提取:

(1)多感受野特征交互(MRFFI)

? 通過 WTE-Mamba 進行長程信息提取,同時結合小波變換增強高頻特征。

? MK-DeConv 采用不同大小的卷積核進行局部信息交互,提高多尺度感知能力。

? 通過 消除冗余身份映射 降低計算成本,提高推理速度。

(2)輕量級 Mamba 結構

? 采用三階段設計,減少計算量,提高吞吐量。

? 結合 多方向掃描和低秩狀態空間映射,提升計算效率。

(3)優化訓練與推理

? 知識蒸餾:從更強的教師模型學習,提高小模型性能。

? 延長訓練輪數:實驗發現 300 輪未完全收斂,延長到 1000 輪可提升準確率。

? 歸一化層融合:在推理時減少計算冗余,提高計算效率。

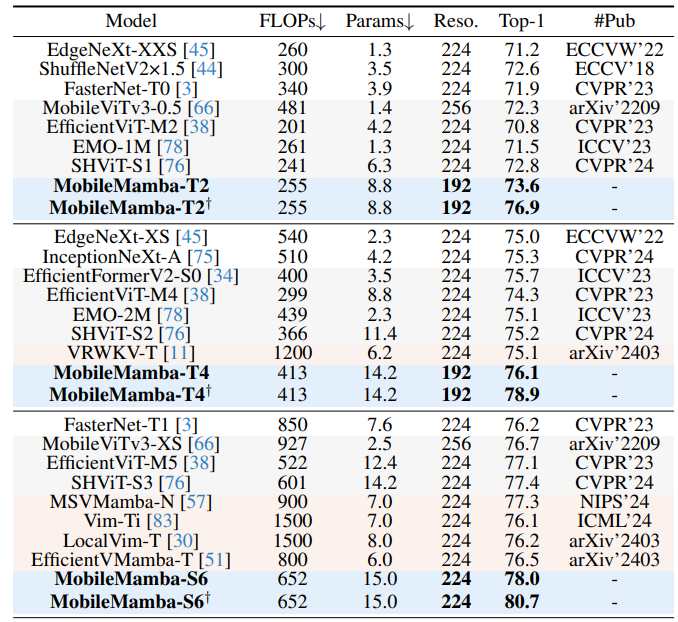

5. 實驗結果速覽

圖片

圖片

MobileMamba 在多個基準測試中展現了優越性能:

? ImageNet-1K 分類

? MobileMamba-B4 83.6% Top-1,比 EfficientVMamba 提升 +1.8%,且推理速度提升 ×3.5 倍。

? 目標檢測(COCO)

? Mask R-CNN:相比 EMO 提升 mAP +1.3↑,吞吐量 +57%↑。

? RetinaNet:比 EfficientVMamba 提升 mAP +2.1↑,推理速度提升 ×4.3 倍。

? 語義分割(ADE20K)

? Semantic FPN:比 EdgeViT 提升 mIoU +1.1↑,FLOPs 僅為其 20%。

? PSPNet:比 MobileViTv2 提升 mIoU +0.4↑,FLOPs 僅 11%。

6. 實用價值與應用

? 邊緣設備視覺計算:適用于智能手機、嵌入式設備、物聯網(IoT)等資源受限場景。

? 自動駕駛與監控:在高分辨率場景下提供高效視覺計算,適用于目標檢測、分割任務。

? 醫療影像分析:通過多感受野特性,提取關鍵醫學影像特征,提高診斷效率。

7. 開放問題

MobileMamba 的多感受野特征交互策略是否適用于其他任務,如視頻理解或 3D 視覺?

如何進一步優化 MobileMamba 以提升 CPU/移動端推理速度?

能否結合 LoRA 或其他參數高效微調方法,提升 MobileMamba 在特定任務上的適應性?