對話27歲博導張林峰:模型壓縮獲CVPR滿分有點意外,上海交大像我這樣年輕老師很多

上海交大、27歲、最年輕博導,留給張林峰的標簽不多了(Doge)。

最新引發關注的,是他實實在在的一個論文成果——

他們提出了一種新的數據集蒸餾方法,結果獲得了CVPR 2025滿分。

通過引入一個輔助的神經網絡,只需一塊6年前的2080Ti,就能做大模型數據蒸餾。與前SOTA相比,新方法的顯存占用只有1/300,并且速度提升了20倍。

不過對于這一結果,張林峰表示有點意外。但能肯定的是「數據蒸餾」這一范式會成為接下來模型壓縮的趨勢之一。

實際上模型壓縮這個領域其實并不新。作為機器學習中的一個分支,它旨在減少模型的復雜度、存儲空間或計算資源需求,同時盡可能保持其性能。像大家熟知的剪枝、量化、蒸餾都是模型壓縮的傳統方法。

隨著大模型浪潮深入,「大力出奇跡」范式開始受到質疑,由DeepSeek為代表帶起的「高效低成本」的趨勢,讓模型壓縮再度受到業內關注,回到舞臺中央。

而始終在這個領域深耕的張林峰,對于模型壓縮怎么走?如何走?他有著自己的見解。量子位與張林峰展開聊了聊。

大模型壓縮:加速底座模型

從張林峰團隊最近幾個研究開始看起。

首先說道說道被CVPR評為滿分論文的NFCM。它的核心是引入了一個新的分布差異度量NCFD,并將數據集蒸餾問題轉化為一個minmax優化問題。

通過交替優化合成數據以最小化NCFD,以及優化采樣網絡以最大化NCFD,NCFM在提升合成數據質量的同時,不斷增強分布差異度量的敏感性和有效性。

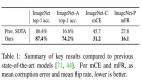

在多個基準數據集上,NCFM都取得了顯著的性能提升,并展現出可擴展性。在CIFAR數據集上,NCFM只需2GB左右的GPU內存就能實現無損的數據集蒸餾,用2080Ti即可實現。并且,NCFM在連續學習、神經架構搜索等下游任務上也展現了優異的性能。

這其實代表著張林峰團隊所做的一個方向:通過數據的角度去加速模型。

當前AI模型需要基于海量數據進行訓練,這顯著增加了大型模型的訓練成本。我們研究如何更高效地利用數據,更科學地清洗和合成數據,并利用合成數據進一步增強生成模型,從而實現數據高效的人工智能。

具體是什么意思?

張林峰解釋道,一個模型的計算,抽象出來就是參數w和數據x去算矩陣乘法。按照之前的思路,就是對參數w進行壓縮,但一旦參數改變就需要重新訓練,避免它損失那么多信息。既然這個思路現在實現不了,那就嘗試來壓縮數據x。

當訓練數據集都是精挑細選的高質量數據,在通過這些高質量數據去進行合成,訓練成本就會可以降低,同時也不會出現過擬合的情況。

現階段,他們有個目標就是通過數據壓縮來提高訓練的效率,他們內部有個指標,那就是訓練節省的成本/挑選數據成本是>1的,這也就證明這一技術思路是可行且有價值的。但目前還只能在一些階段和場景中可行。

最近,他們發表在ACL2025的一篇文章已經在大模型微調訓練階段實現了這個目標,通過上下文學習大幅度提高了后訓練數據篩選的速度和精度(http://arxiv.org/abs/2505.12212)。

未來有可能的話,參數壓縮和數據壓縮其實可以天然結合起來。

除了數據視角下的模型壓縮,他們另一個方向在于:模型訓練階段刪掉token,讓訓練成本變低。或者在推理階段刪掉token,讓模型推理速度變快。

比如,他們發現在最近火熱的擴散語言模型上,可以通過刪除token實現最高9倍的加速而幾乎沒有性能損失(https://github.com/maomaocun/dLLM-cache)。在多模態大模型上,可以刪除圖像視頻中80%甚至90%的token,仍然能保持很高的精度……

現在他們已經將這一探索從語言模型延伸到了視覺生成板塊。

他們提出了一個叫做Toca,token級別的特征緩存(Token-wise Caching)的方法。

這是首次從token級別實現了擴散模型在圖像和視頻生成上,無需訓練就實現兩倍以上的加速。這解決的是Diffusion Transformer計算成本高的難題。

之前的緩存方法忽略了不同的token對特征緩存表現出不同的敏感性,而對某些token的特征緩存可能導致生成質量整體上高達10倍的破壞。

他們的方法允許自適應地選擇最適合進行緩存的token,并進一步為不同類型和深度的神經網絡層應用不同的緩存比率。

這個思路還可以針對不同任務做專門優化,比如在圖像編輯任務上,只有被編輯的區域是需要關注和計算的,沒有被編輯區域上的計算可以盡量的減少。基于這個思路,他們把token級別的特征緩存又用到了圖像編輯任務上(https://eff-edit.github.io/)。

而最新的TaylorSeer正是這一思路的延續。他們希望TaylorSeer能夠將特征緩存的范式從復用轉移到預測,像預言家一樣預言下一步的特征是什么。

他們發現擴散模型在特征空間上隨時間步的變化是非常穩定而連續的,這說明可以直接基于直接時間步的特征用泰勒展開預測出下一步的特征,而不需要真正的去計算。

從思路上講,傳統的擴散模型緩存方法是緩存上一步的特征,在下一步上進行“直接復用”;我們的方法是緩存上一步的特征,對下一步特征進行“預測”,其精度顯然會超過直接復用的方式。

最終在DiT、FLUX、Hunyuan Video、WAN、FramePacker、SDXL等模型上都實現了接近5倍的加速效果,此外音頻生成、圖像超分辨率、圖像編輯、甚至是具身智能等任務上也進行了成功的嘗試。

加速后的模型在使用八卡GPU推理時,已經可以讓HunyuanVideo對視頻的生成速度逼近于播放速度。

這一系列研究成果已經開源,并且逐漸在各種模型中部署。

https://github.com/Shenyi-Z/TaylorSeer

張林峰透露,他們現在的一個長期目標是以極低地成本即插即用地加速任意的開源視頻生成模型,最終讓視頻生成模型的生成速度超過視頻的播放速度。

這就意味著,我們在播放一個視頻的時候,它在后臺同時生成一個視頻,感知層面上講幾乎是實時生成視頻的。

從這幾個研究中,其實能看到張林峰團隊的幾個方向,同時也代表著模型壓縮的幾個趨勢,比如數據視角下的模型壓縮;從語言模型延伸到多模態生成模型的加速。

但總歸目的只有一個:降低大模型的部署成本,使其更好地應用于現實世界。

從本科大三就直至現在助理教授這一身份,張林峰始終在探索這一方向。他坦言從技術到自身心境都發生了很多變化。

從「模型壓縮」到「大模型壓縮」

最早是在2018年底,張林峰彼時沒有考慮到那么多,只是覺得方向好玩,再者工業界也比較關注這一方向。

現在回想,他表示:

雖然做過很多調研,但也不可能預感到大模型時代的到來。

當時他大四一篇自蒸餾的文章,奠定了他之后方向的基礎,也給整個學界和工業界一個思路,時至今日被引數超過了1100+,并被同方向大神MIT副教授韓松(2023年斯隆研究獎得主、深鑒科技聯合創始人),寫進了《TinyML and Efficient Deep Learning Computing》這門課程的Lecture 9《Knowledge Distillation》。

這篇文章是《Be your own teacher: lmprove the performance of convolutional neuranetworks via self distillation》(《通過自蒸餾提高卷積神經網絡的性能》),發表于ICCV2019。

它提出了一種自蒸餾通用訓練框架——使用模型的深層來蒸餾淺層。

該方法將目標CNN按深度和原始結構劃分為幾個淺層部分,在每個淺層部分后設置一個由瓶頸層和全連接層組成的分類器(僅在訓練時使用,推理時可移除)。

訓練時,所有淺層部分及其分類器作為學生模型,通過蒸餾從最深層部分(視為教師模型)獲取知識。在顯著提高CNN性能的同時,訓練時間也更短。

這篇論文證明了知識蒸餾中的教師模型并非必需,而是自己同時扮演老師和學生,推動了無教師知識蒸餾領域的發展。

如今再來看知識蒸餾,他認為知識蒸餾的發展可以分為三個階段。

第一個階段是強的大模型來當老師,來訓練弱的小模型(學生模型)。

第二個階段就是自蒸餾,相當于是老師和學生其實是同一種模型,能力是差不多的,自己教自己然后讓自己變得更為強大,這其實在目前垂直領域中智能體應用中很常見。

第三個階段,現階段整個科研社區比較關注的一個領域,就是從弱到強蒸餾——讓一個小的弱模型當老師,然后讓一個強的模型當學生,通過弱的模型去提升強的模型。這一方向十分具有前瞻性,因為如果一旦能實現,這就說明可以實現AI的進化,模型可以越來越強。

不過這樣的想法,如果放在當時并不會受到太多關注。甚至模型壓縮這個研究方向一度險遭停滯:是不是要轉行了?!

2020年時期,模型開始從「越來越小」的方向發展,從一開始的幾十兆、幾百兆到后來幾兆、甚至壓縮到幾KB模型。模型壓縮似乎沒有什么余地,張林峰感到「沒什么能做的」。

結果轉機是在大模型出現,大家驚呼:哇塞,模型還能這么大哈?

張林峰透露,很多外行或者不懂AI的人問他,你看現在都講大模型,結果你做模型壓縮,是不是與時代背道而馳?

他表示,實際上模型越大,其實就越需要壓縮。

我們現在每天都盼著,哪天再出來一個10萬億的,最好再出來一個百萬億的模型,那就更開心了。

雖然都是偏應用項目,與過去做模型壓縮相比,張林峰一個明顯的感知就是研究越來越fancy了。

本科畢業時他用自蒸餾給圖像分類模型做加速,結果做出來的Demo給身邊人看,結果他們都表示:so what?突然有一瞬間他覺得這個項目好像沒有什么意思——因為只是給圖像做了個分類。

而現在技術帶來的改變是肉眼可見、即時可感知的。比如視頻生成提速5倍,原本需要50秒生成的結果,現在只需10秒就可以搞定。

這些具象化的產出天然具備趣味屬性——無論是生成圖像、邏輯推理還是視覺理解,所帶來的成就感也就非常直觀。

不過還只是表象的變化,技術層面的區別還是不小。

主要體現在這幾個方面:一個是目標轉變,另一個則是技術復雜性的差異。

傳統模型壓縮以結構優化為核心,找到最佳的架構,允許犧牲已經學到的知識(如減少卷積層數、通道數),通過后續重新訓練即可恢復性能。像剪枝、量化、蒸餾就是比較經典的模型壓縮的方法。

而以千億參數的大模型來講,則需要需平衡結構效率與知識保留,壓縮過程必須最小化知識損失。因為如果要重新將大模型跑起來是算力、數據、工程經驗等多重考驗。現實情況是每個做模型壓縮的人并不具備真正讓模型在壓縮中丟掉的知識再學會來的這個能力。

相反現在數據視角下的模型壓縮里很多工作,完全不需要訓練,整個成本就會低很多:

大概就是租個GPU的費用就可以搞定。

從本質上講,這種不需要訓練的方法,是在利用模型本身具有的冗余性,然后將這種冗余性減少。

不過當高度精煉的模型出來,是不是不需要模型壓縮了?!

面對這一問題時,張林峰表示:確實存在。

不過現在這個階段,大家還是在朝著大模型這一方向走,特別像視頻生成這個方向。總的來說,道阻且長。

希望不要以年齡來定義

像這樣年紀輕輕就當上助理教授開始展露頭角,張林峰只是一個代表。僅在他們學院就有很多年輕老師,甚至比他還要小。

張林峰談到,年輕老師一上來肯定精力會多一點,對于學生的指導也會更多一點。很多熱愛科研的同學,入門可能需要有個人能手把手去帶,那年輕老師就非常適合這個位置,大家共同從零到一地去產出成果。

如果拋開年齡標簽,張林峰坦言自己跟大多數做科研的人一樣,希望別人用他們做過的科研成果來記住他們。

比如做知識蒸餾的、做模型壓縮的、做數據視角下讓模型變得更快的。

我就希望大家就記住我的是我做出過什么工作,而不只是我的名字。

張林峰團隊也跟他一樣,一整個主打年輕化風格,一撥是他自己的學生;另一撥就是研究助理,大部分是本科生。

對于進來的學生,張林峰表示只需滿足兩點要求。

一個是Motivation,真正喜歡做科研的,覺得這個方向很好玩。另一個則是有基礎的編程能力。除此之外,沒有其他任何要求。也就意味著很多非計算機專業學生也有機會進組做研究,而且現在也不止他們組,其實這種跨專業參與的現象非常明顯。

最后,還問了問張林峰,看到當前這么多大模型創業團隊,是否有興趣創業呢?

他思考了一會兒表示:看有沒有這樣更好的成果轉化機會,畢竟做科研還是很燒錢的。

但是反正如果沒有找到特別好的點的話,我也不想就是為了創業去創業,但是我會一直關注的。

好哦,沒有否認。