LLM「啊哈時刻」竟會自我糾正,單體數學性能暴漲!UIUC華人一作

AI不僅能解答復雜的數學題,還能像老師一樣檢查自己的答案。

不僅如此,發現錯誤后自己立刻改正——這一切都不需要任何人幫忙!

近日,UIUC聯手馬里蘭大學全華人研究團隊最新研究Self-rewarding correction for mathematical reasoning,實現了上述目標。

該研究團隊打造了一款「自我獎勵推理模型」,讓大模型 (LLM) 從生成推理路徑到自我評估,再到糾正錯誤,全部一氣呵成。

不僅性能碾壓傳統方法,連計算成本都大幅降低!

論文地址:https://arxiv.org/abs/2502.19613

LLM在數學和編程等推理任務中展現了驚人的能力,特別是在OpenAI o1發布后,具備強大推理能力的LLM以及提升推理的方法引起了更多關注。

這類模型的一個理想特性是能夠檢測自己生成回答中的不一致和錯誤,并通過反饋糾正這些錯誤,生成更好的回答,這種過程常被稱為自我糾正。

研究表明,LLM可以根據外部真實獎勵反饋改進初始回答,并決定何時停止自我糾正循環,這種方法在數學推理和一般任務中都證明是有效的。

然而,這些獎勵模型通常本身也是LLM,在推理時需要運行多個模型,增加了計算成本和部署復雜性。

相比之下,若沒有外部獎勵反饋,當前LLM很難僅憑自身能力改進初始回答,這一局限被稱為內在自我糾正的不足。

近期研究表明,LLM本身可以通過生成方式產生獎勵信號。

例如,「LLM作為評判者」方法提示LLM評估文本輸出,實際上替代了人類反饋。

另一個新興方向是生成式獎勵模型,將評估任務轉化為遵循指令的問題,利用生成特定標記的概率作為獎勵值,這些方法利用了LLM的下一標記預測能力,將生成和評估整合到一個統一框架中。

在這些見解的基礎上,研究人員探討了自我獎勵推理模型,從而將三種能力集成到單一的LLM中。

地址:https://github.com/RLHFlow/Self-rewarding-reasoning-LLM

自我獎勵推理語言模型

研究人員將自我獎勵推理過程形式化為一個多輪馬爾可夫決策過程(MDP)。

在觀察到初始提示后,LLM將生成一個初始推理嘗試。然后,LLM通過生成一個評估來自我獎勵其響應。

如果模型評估其答案為正確,生成過程即停止。否則,LLM進入下一步,生成一個改進的響應和評估,其中生成過程基于更新后的狀態。

自我改進過程持續進行,直到模型產生一個自我評估,判斷答案為正確。

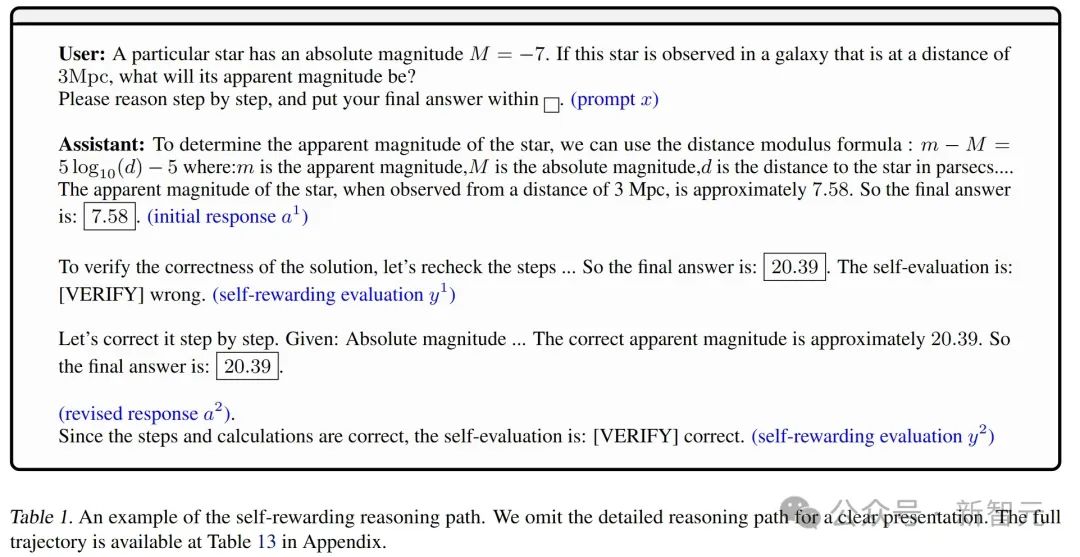

在本研究中,團隊使用了ToRA驗證腳本,該腳本基于Python符號數學庫SymPy。下表1是自我獎勵推理路徑示例。

遵循LLMs的標準后訓練實踐,研究團隊采用了兩階段方法:

1 自我獎勵指令跟隨微調(IFT)。從初始LLM(例如,一個通用聊天機器人)開始,他們通過順序拒絕采樣過程收集演示數據,并進行微調,得到改進模型,該模型集成了自我獎勵推理能力。

2 強化學習(RL)優化。進一步使用強化學習優化上一步的改進模型,以其作為參考模型。這一階段可以進一步提升模型評估正確性和改進先前響應的能力。

自我獎勵指令跟隨微調

通過標記預測進行自我獎勵。為了訓練LLMs評估推理步驟,研究團隊將此任務形式化為一個指令跟隨任務。

具體來說,他們允許模型在評估中包含推理,同時要求它們輸出特定標記以指示評估結果。

他們嘗試了不同的標記選擇,例如:

(i) 提示「最近的最終答案是否正確(是或否)?」并以「Yes」和「No」作為響應標記;

(ii) 明確的標記,如「『VERIFY』correct」和「『VERIFY』wrong」。

他們的實驗顯示這些選擇之間存在顯著的性能差異。

在推理過程中,他們從分布中采樣評估標記。這能夠使用標準的推理流程,而無需任何特定調整。(參見表1的示例)

通過順序拒絕采樣的數據收集:研究人員采用了一種拒絕采樣方法,生成大量自我糾正軌跡,并僅保留所需的軌跡。

他們按順序提示基礎模型并分別生成不同的步驟。然后,將它們組合成包含自我獎勵和自我糾正模式的較長CoT(思維鏈)軌跡。

數據收集過程包括以下步驟:

1 生成初始推理響應:從MATH和GSM8K等數據集的訓練提示中采樣,每條提示生成N_1=50個初始響應作為基礎軌跡。

2 自我獎勵信號采樣:對于每個提示和初始響應,進一步采樣N_2=8個自我評估,并僅保留一個與真實結果 (ground truth) 相同的評估結果。然后,使用真實驗證器r? 將其分為Gcorrect和Gwrong。

3 糾正采樣:對于Gwrong中的每個提示和初始響應,他們通過提供初始響應錯誤的反饋,采樣M_1=8個完成結果,以收集成功修正錯誤響應的軌跡。而對于Gcorrect中的每個提示和初始響應,也告訴模型該響應是錯誤的,并收集M_2=4個完成結果。

通過這樣做,他們還希望在錯誤判斷的情況下額外收集「正確到正確」的軌跡。

最終,他們收集了8×|Gwrong|+4×|Gcorrect|條完整軌跡。

下表2中提供了一個數據收集過程的示例。由于資源限制,他們將迭代次數限制為兩次,并對每個基礎樣本最多保留一條軌跡。

KL正則化的強化學習

在這一階段,研究團隊使用強化學習進一步增強自我獎勵的IFT模型。他們考慮了深度強化學習方法和直接對齊算法。

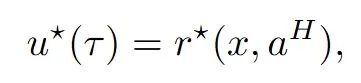

學習信號:為了便于強化學習階段,他們假設存在一個針對軌跡τ的軌跡級獎勵函數。然而,與RLHF中的BT模型或先前數學推理文獻中的結果監督獎勵 (ORM)從數據中學習代理獎勵不同,他們主要使用Oracle獎勵:

驗證最終結果是否正確。其主要優點是Oracle獎勵可以在很大程度上減輕獎勵操控的風險。這在最近的文獻中也被稱為基于規則的強化學習 。

他們還將研究額外的規則設計,用于獎勵值分配 (PPO訓練) 或數據排序 (DPO訓練),其中隱含的u^*由使用的規則集決定。

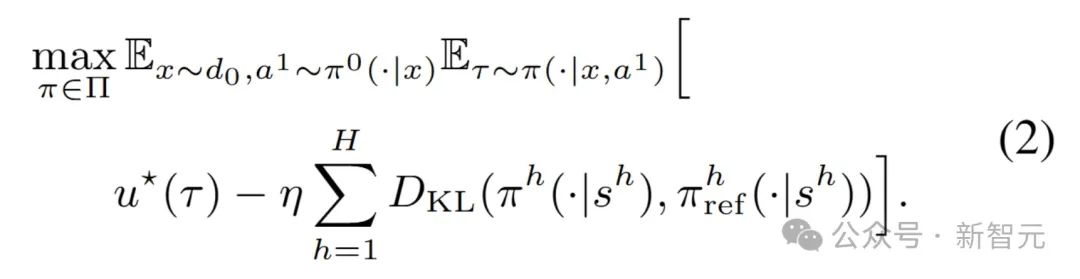

遵循標準的RLHF 方法,研究團隊優化以下KL正則化目標:

最優策略及其相關的優化值滿足以下最優性條件。

簡單來說,通過定義「最優值」和「最優策略」,讓LLM在有限步驟內根據外部指令調整行為,同時用獎勵機制(比如判斷結果對錯)來提升表現。

為了避免計算太復雜,研究團隊還用了一種叫「直接偏好優化」(DPO) 的方法,通過比較不同選擇的好壞來訓練,讓它更聰明地完成任務。

換句話說,這個模型就像教LLM玩一個游戲:先告訴它目標是什么(比如答對題),然后通過反復嘗試和反饋(比如「這個錯了,換個方法」),讓LLM學會如何在幾步之內找到正確答案,最后得出一個能衡量它表現的「損失函數」。

主要實驗

任務、數據集與數據格式

使用標準基準評估模型的數學推理能力,包括MATH500、OlympiadBench和Minerva Math。

這些數據集規模適中,確保模型評估的可靠性和高效性,涵蓋代數、幾何、概率、數論和微積分等主題。

在訓練階段,主要使用NumiaMath-CoT數據集中的提示。具體而言,使用50K子集進行自我獎勵IFT階段,10K子集用于驗證和模型選擇,其余數據用于強化學習訓練。

在推理過程中,模型最多生成4096個token,并使用VLLM 0.5.4加速推理過程。

評估指標

采用兩類指標來評估模型性能:(1)數學推理與自我修正能力;(2)獎勵模型的準確性。

首先考慮以下指標來評估模型的數學推理和自我修正能力。

- 第一次嘗試的準確性(Turn 1):第一次回答的準確性;

- 最終準確性(Final accuracy):最終答案的準確性;

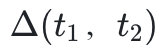

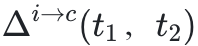

:從首次嘗試到最終答案的準確性提升;

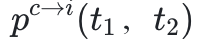

:從首次嘗試到最終答案的準確性提升; :從錯誤(incorrect)到正確(correct)的問題占比;

:從錯誤(incorrect)到正確(correct)的問題占比; :從正確到錯誤的問題占比。

:從正確到錯誤的問題占比。

由于自我獎勵推理框架的特性,引入了額外的衡量獎勵模型準確性的指標。

同時,將對提出的框架進行更全面的分析,使用稍簡化的模板,并在計算在面對誤導性獎勵時,將正確答案修改為錯誤答案的比例。

- 獎勵模型準確率(RM Accuracy (a, b)):針對正確和錯誤軌跡的分類準確率。其中,a表示真陽性率(正確軌跡的識別率),b表示真陰性率(錯誤軌跡的識別率);

- 比例

:在面對誤導性獎勵時,將正確答案修改為錯誤答案的概率。

:在面對誤導性獎勵時,將正確答案修改為錯誤答案的概率。

在所有評估中,遵循慣例,使用零樣本思維鏈提示(zero-shot CoT prompting)和貪婪解碼(greedy decoding)方法,基于Qwen-2.5-Math模型進行評估。

主要結果

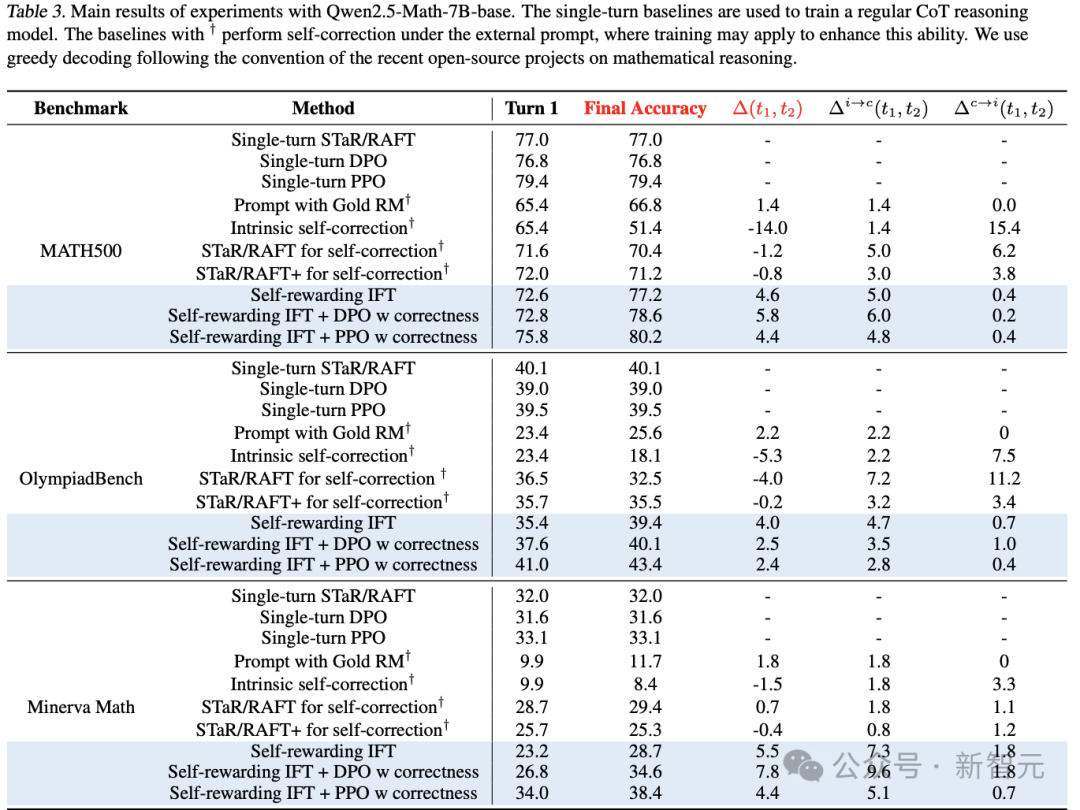

表3中報告了主要結果。需要注意的是,由于四舍五入,可能存在0.1的誤差。

表3. Qwen2.5-Math-7B-base 實驗的主要結果

單輪基線模型用于訓練常規的CoT推理模型。帶有?符號的基線模型在外部提示下執行自我修正,其中訓練可能用于增強這種能力。遵循近期開源數學推理項目的慣例,使用貪婪解碼方法進行評估。

內在自我修正與提示通常失敗

首先觀察到,在沒有明確獎勵信號的情況下,內在的自我修正通常會降低最終測試的準確性。

分析輸出結果,發現模型傾向于修改初始響應,而不管其正確性如何,因為它們缺乏機制來確定何時應該優化答案,何時應該終止修正過程。

此外,即使提供了真實獎勵,在錯誤到正確轉換方面,僅通過提示的基礎模型也只能取得微小的改進。

還注意到,STaR/RAFT方法(通過對修正的錯誤嘗試進行微調)未能顯著提升性能。

此外,在修改初始嘗試時,STaR/RAFT+變體(包含正確到正確的軌跡)變得更加保守。雖然這減少了錯誤的修正(?c→i(t1, t2)),但也降低了 ,最終導致測試準確性下降。

,最終導致測試準確性下降。

這些發現與之前的研究一致,凸顯了內在自我修正的局限性,即使通過訓練也難以克服。

新模型顯著優于現有的自我修正基線方法

在所有任務中,自我獎勵推理模型通過更高的?(t1, t2)持續提升了最終準確性,優于基線方法。

注意到,在具有自我修正行為的合成軌跡上進行微調,能夠顯著提高模型的 ,這表明模型更擅長修正自我生成響應中的錯誤。

,這表明模型更擅長修正自我生成響應中的錯誤。

與STaR/RAFT不同,通過自我獎勵IFT訓練的模型還表現出顯著更低的 ,表明由于額外的自我獎勵信號,它們更擅長識別何時停止修正。

,表明由于額外的自我獎勵信號,它們更擅長識別何時停止修正。

由于STaR/RAFT(+)和自我獎勵IFT使用了相同的數據合成方法(拒絕采樣),但基于不同的自我修正框架,這些結果凸顯了自我獎勵推理框架的優勢。

新模型相比單輪基線方法提升了最終準確性

自我自我獎勵推理模型(經過RL訓練)還與單輪對應的模型進行了比較。

無論是PPO還是DPO,自我獎勵推理模型由于額外的修正步驟,均實現了更高的最終測試準確性。

例如,自我獎勵IFT + PPO模型在OlympiadBench上的最終準確性為43.4%,在Minerva Math上為38.4%,而其單輪對應模型分別為39.5%和33.1%。

同樣,使用DPO的自我獎勵推理模型在MATH500上達到78.6%,在OlympiadBench上為40.1%,在Minerva Math上為34.6%,而單輪DPO模型分別為76.8%、39.0%和31.6%。

然而,由于額外的修正步驟,自我獎勵模型在推理過程中使用了更多的token。

深度強化學習算法優于直接對齊算法

可以觀察到,PPO(近端策略優化)在性能上大幅優于迭代DPO(直接偏好優化)。

例如,經過PPO訓練的模型在Olympiad Bench上的最終準確性為43.4%,而DPO方法僅為40.1%。

這表明,當絕對獎勵信號可用時,強制偏好結構(如Bradley-Terry模型)可能是不必要的,甚至可能降低性能。

另一個可能的原因是DPO在數據利用上的局限性。

注意到,在實驗設置中,只能為40%到60%的提示收集到比較對。

對于剩余的提示,模型要么沒有生成任何正確軌跡,要么所有軌跡都是正確的。因此,DPO使用的訓練數據少于PPO,這可能是其準確性較低的原因之一。

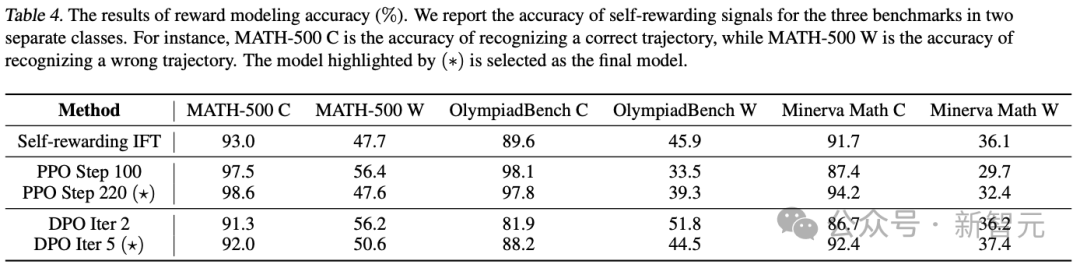

獎勵模型(RM)準確性

由于自我獎勵框架將生成器和獎勵模型統一起來,所以評估了模型作為獎勵模型的準確性。

Qwen2.5-Math-7B-base有時可能無法嚴格遵循格式,可能是因為模型未經過指令微調。

然而,這種情況發生的比例不到10%,因此重點關注包含評估步驟的樣本,并進一步引入人工監督以總結統計數據。

在表4中報告了結果。

表4. 獎勵模型準確性結果(%)

在三個基準測試中,自我獎勵信號在兩類情況下的準確性。例如,MATH-500 C表示識別正確軌跡的準確性,而MATH-500 W表示識別錯誤軌跡的準確性。標有(?)的模型被選為最終模型。

RL階段的學習動態

盡管RL訓練提高了最終準確性,但最終測試準確性由第一輪準確性(turn-1 accuracy)和?(t1, t2)共同決定。

研究團隊特別注意到,最終準確性的提升主要來自更高的第一輪準確性,因為經過RL訓練的模型,通常具有更高的第一輪準確性,但同時也表現出較低的 。

。

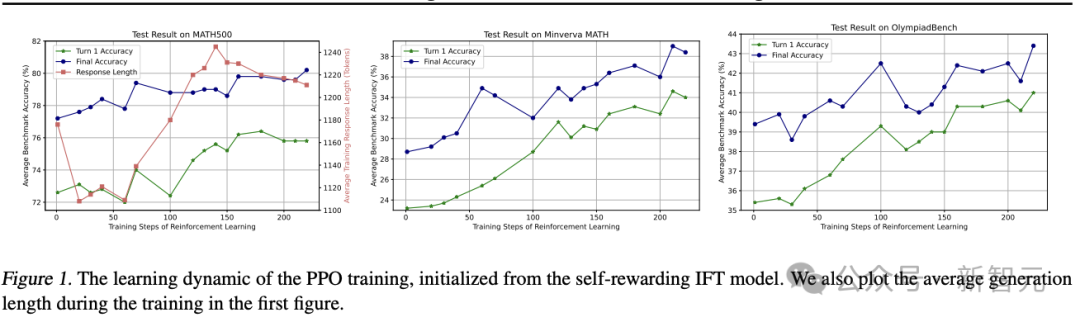

為了理解RL訓練的學習動態,在圖1中繪制了三個基準測試的測試準確性隨RL訓練步驟的變化情況。

研究團隊觀察到,在RL訓練的早期階段,第一輪準確性和最終準確性均有所提升,且它們之間的差距?(t1, t2)也有所增加或保持穩定水平。

然而,在訓練步驟達到100左右時,最終準確性的提升主要來自更高的第一輪準確性,且兩者之間的差距縮小。

還在圖中繪制了平均生成長度的變化。

最初,長度有所減少,因為Qwen2.5-Math-7B-base模型傾向于生成大量Python代碼,導致響應較長。

代碼通常占用大量token,可能導致推理路徑不完整,并且這種行為會被獎勵信號抑制。

隨后,生成長度在下一階段增加,表明RL訓練也鼓勵了反思和自我修正能力。

最終,生成長度再次減少,同時伴隨著更高的第一輪準確性和更小的?(t1, t2)。

基于兩輪對話框架的更多實驗結果

數據格式:簡化的兩輪對話框架

此前,將多個推理步驟合并為一個長的思維鏈(CoT)軌跡,這與常見的實踐一致。

然而,這種方法對新研究提出了重大挑戰,因為模型(尤其是Qwen2.5-Math-7B-base)往往無法嚴格遵循基于歷史評估或修正響應的指令。

例如,即使自我評估結果為「[VERIFY] wrong」,模型有時仍會生成評估結果并選擇是否修正響應。

此外,模型可能執行多輪自我評估和修正,但這些步驟緊密耦合,無法輕松解耦為獨立的階段。

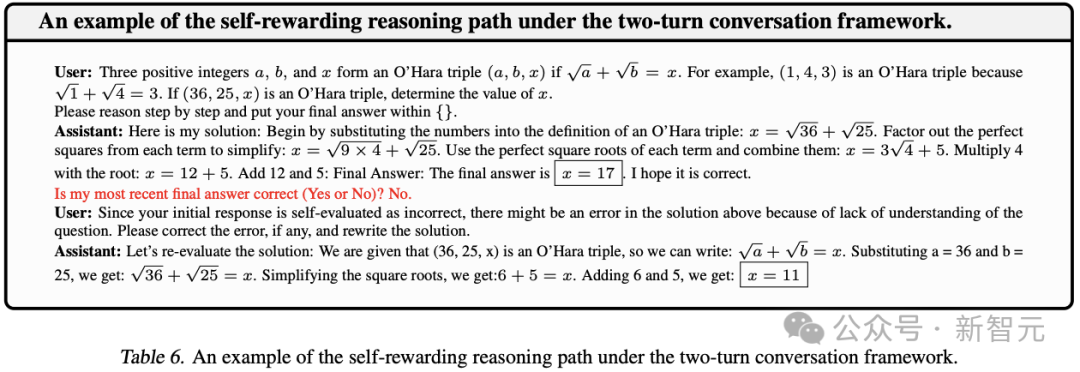

為了解決這些問題,研究團隊采用了簡化的兩輪對話框架,其中用戶在不同步驟之間提供明確的指令。

具體而言,在接收到數學問題后,模型首先生成思維鏈推理a?和自我評估y。然后,用戶根據自我評估y提供一個確定性指令o:

- 由于你的初始響應自我評估為錯誤,上述解決方案可能因對問題的理解不足而存在錯誤。請修正錯誤(如有)并重寫解決方案。將最終答案放在方框內;

- 由于你的初始響應自我評估為正確,請確認其正確性并提供進一步的修改。將最終答案放在方框內。

同時,在收集數據時,根據設計的模板,自我獎勵信號直接由真實獎勵(ground-truth oracle reward)確定,無需額外的推理。

盡管這種簡化可能會降低獎勵模型的準確性,但通過修改自我獎勵信號,有助于受控實驗。

參見表6中的示例。

Llama模型與Qwen模型實驗結果幾乎一致

Llama模型的實驗與Qwen模型的結果高度一致。

實驗表明,Llama模型表現出與Qwen模型相似的趨勢。

具體而言,內在自我修正(無論是否結合類似STaR/RAFT的訓練)無法可靠地修正自我生成響應中的錯誤。

模型傾向于修改其初始響應,而不管其正確性如何,這使得這些方法主要對較弱模型有益。

然而,對于在第一次嘗試中就能解決大多數問題的較強模型,內在自我修正和STaR/RAFT方法顯著降低了第二輪準確性。

相比之下,自我獎勵IFT模型通過有效修正錯誤并保留已經正確的響應,持續提升了第一輪準確性。

這證明了所提出框架的通用性。

為了進一步評估自我獎勵IFT模型,將自我獎勵信號與真實獎勵(oracle reward)保持一樣,以消除獎勵信號質量的影響,并直接評估模型修正錯誤響應的能力。

實驗表明其修正能力有所提升。

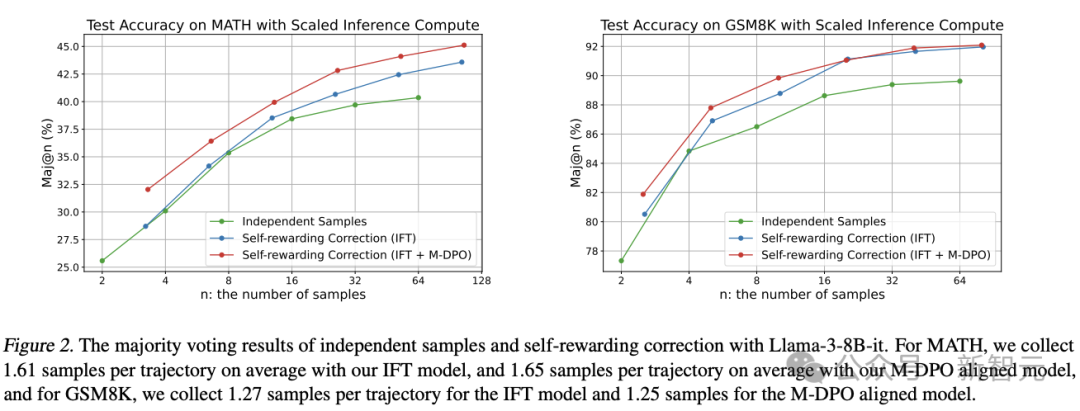

新框架提高了計算擴展的效率

自我修正需要生成多個LLM響應,因此在相同的推理預算下比較模型性能至關重要。

在響應數量受限的情況下,先前的自我修正方法,通常表現不如自一致性方法。

為了解決這一問題,在按比例分配的測試計算預算下,對自我獎勵修正進行分析,采樣N條推理路徑,并使用多數投票確定最終輸出。

圖2報告了結果。

圖2. Llama-3-8B-it的獨立采樣與自我獎勵修正的多數投票結果

在實驗中,對于MATH任務,IFT模型平均每條軌跡收集1.61個樣本,M-DPO對齊模型平均每條軌跡收集1.65個樣本;對于GSM8K任務,IFT模型平均每條軌跡收集1.27個樣本,M-DPO對齊模型平均每條軌跡收集1.25個樣本。

對于MATH和GSM8K任務,在固定的推理預算下,自我獎勵修正模型始終優于獨立采樣方法。

數據分布的消融研究

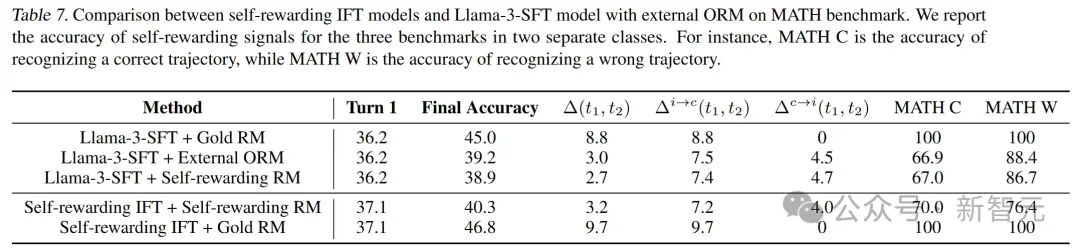

自我獎勵IFT模型優于使用外部ORM的自我糾正。為了更好地理解自我獎勵信號的動態,研究團隊將自我獎勵IFT模型與在相同數據集上訓練的外部ORM(結果監督獎勵模型)進行了比較,結果見下表7。

他們觀察到,自我獎勵IFT模型在第二輪準確性 (turn-2 accuracy)和?(t1, t2)上均優于使用外部ORM的自我糾正方法。這凸顯了將生成器和獎勵模型統一于單一LLM的潛力。

然而,他們也注意到,外部ORM(用于評估Llama-3-SFT策略)和自我獎勵RM(用于評估自我獎勵IFT策略)在獎勵模型準確性上存在顯著差距。

具體來說,自我獎勵IFT方法(自我獎勵IFT策略+自我獎勵RM)在識別正確軌跡時的準確率為70.0%,略高于Llama-3-SFT策略+外部ORM的66.9%。

但對于錯誤答案的軌跡,自我獎勵IFT模型的準確率為76.4%,遠低于Llama-3-SFT策略+外部ORM的88.4%。

為了深入探究這一差異,他們使用自我獎勵RM來指導Llama-3-SFT策略的自我糾正。

有趣的是,在這種設置下,Llama-3-SFT 的獎勵模型準確性與外部ORM更為接近,這表明可能存在分布外 (OOD) 問題。

具體而言,在自我獎勵IFT階段,策略從Llama-3-SFT轉變為自我獎勵IFT策略,而獎勵模型是在原始Llama-3-SFT策略生成的數據上訓練的。

此外,即使使用自我獎勵RM和外部ORM評估相同的Llama-3-SFT策略,也觀察到自我獎勵訓練略微降低了獎勵模型的能力,這主要歸因于模型容量的限制。

RL訓練中的額外規則設計

研究團隊還對下列策略進行了初步實驗,以分析它們對模型性能的影響。

PPO訓練的獎勵分配策略

DPO訓練的數據排序策略

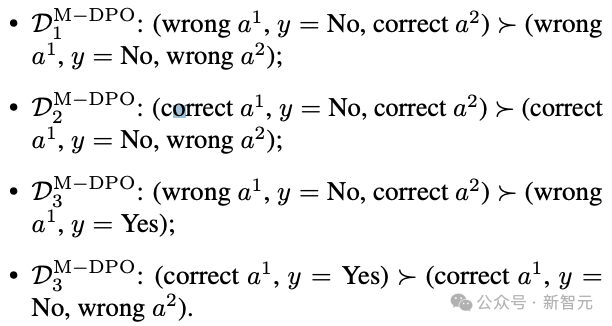

多輪DPO訓練中排序策略的影響

對于固定的(x, a?),研究團隊嘗試了以下排序策略:

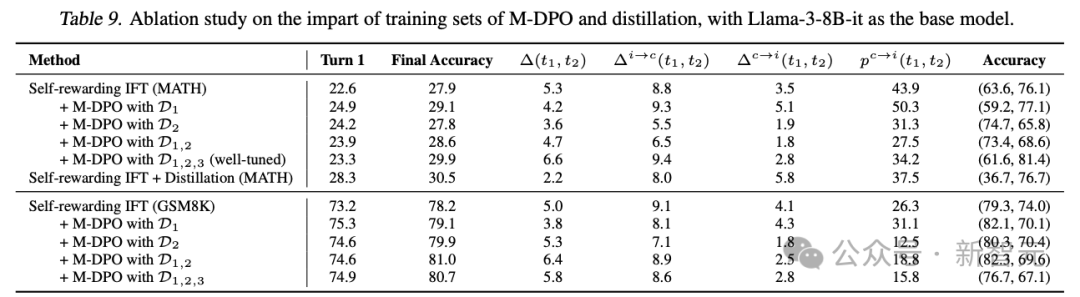

為了簡化實驗,僅對模型進行了一次迭代訓練。結果如表9所示。

表9. 使用Llama-3-8B-it作為基礎模型,對M-DPO和蒸餾訓練集影響的消融研究。

在不同的基礎模型和任務中,觀察到模型在將正確的初始答案錯誤分類為錯誤時更加保守。因此,經過M-DPO微調的模型顯著降低了 。

。

相應地,M-DPO方法進一步增強了自我獎勵推理語言模型,提高了第二輪準確性和?(t1, t2)。有趣的是,盡管訓練過程中并未明確涉及a?的生成,但第二輪中的修正能力自然遷移,從而提高了第一輪準確性。

然而,當超過某個閾值時,過低的 可能使模型過于保守,最終降低修正率

可能使模型過于保守,最終降低修正率 。

。

這一點在使用僅D_M-DPO2的實驗中得到了驗證,其中 在MATH任務中從8.8%降至5.6%。相反,使用D_M-DPO1進行訓練會鼓勵模型修改其初始響應,表現為更高的p_c→i(t1, t2),并略微增強了修正能力。

在MATH任務中從8.8%降至5.6%。相反,使用D_M-DPO1進行訓練會鼓勵模型修改其初始響應,表現為更高的p_c→i(t1, t2),并略微增強了修正能力。

在GSM8K任務中,使用D_M-DPO1訓練的模型的有較低的 ,這主要是由于獎勵模型準確性較低和第一輪準確性較高所致。

,這主要是由于獎勵模型準確性較低和第一輪準確性較高所致。

如果考慮修正軌跡的比例,自我獎勵IFT實現了45.9%,而M-DPO對齊模型略優于它,達到46.4%。

此外,結合D_M-DPO1和D_M-DPO2通常能產生接近最優的結果,通過使模型更清楚何時修改其初始響應來達到平衡。

DPO訓練無法一致提升獎勵模型準確性

在實驗過程中,研究人員觀察到M-DPO訓練也會改變a?的生成分布,從而不可預測地影響獎勵模型的準確性。

盡管在D_M-DPO3中包含了比較對,并盡力調整該數據集中的數據組合,但仍然面臨正確答案識別性能下降的問題。

此外,對于簡單的平衡D_M-DPO3(例如在GSM8K中),兩類獎勵模型的準確性都變得更差。

無論是哪種情況,獎勵模型的準確性并未得到一致提升。

懷疑這是由于DPO隱式獎勵(log π/π_ref)與采樣概率log π之間的不匹配所致。

同樣,對于PPO訓練,可能也需要采用多輪設計,而新研究僅對部分響應施加KL正則化,并允許模型更容易地調整自我獎勵階段。

PPO訓練中的額外規則設計

還研究了PPO訓練中不同的獎勵信號設計,旨在增強自我修正能力,特別是在訓練的后期階段。

具體而言,嘗試了以下兩種方法:

- 如果第一次嘗試錯誤且最終答案正確,則分配1.5的獎勵;否則,最終答案正確分配1.0,錯誤分配0.0。

- 將學習分為兩個階段。在第一階段,我們僅使用基于正確性的獎勵進行訓練;然后從第一階段初始化模型,并應用第一種方案中的修改獎勵分配。

研究人員觀察到,模型很容易利用第一種獎勵設計中的漏洞,即它們故意在第一次嘗試中預測錯誤答案,然后在第二輪中修正它。

盡管簡單的獎勵修改失敗了,但預計更復雜的多輪RL策略可以進一步改進RL訓練。

主要作者

Wei Xiong

目前,Wei Xiong是伊利諾伊大學厄巴納-香檳分校(UIUC)計算機科學博士生。

2023年8月,他從香港科技大學獲數學碩士學位;2021年,從中國科學技術大學獲數學與電子工程雙學士學位,其中統計專業績點第一,電子工程排名第二。

他的研究興趣主要集中在基于人類反饋的強化學習(RLHF),用于對齊大型語言模型。

Chenlu Ye

她是伊利諾伊大學厄巴納-香檳分校(UIUC)計算機科學博士生。

2024年8月,她從香港科技大學獲人工智能與信息處理(IIP - AI)碩士(MPhil)學位。她從中國科學技術大學獲得統計學學士學位。

Hanning Zhang

伊利諾伊大學厄巴納-香檳分校(UIUC)計算機科學碩士一年級學生,導師是張彤教授。

2024年畢業于香港科技大學(HKUST),主修計算機科學。曾擔任張彤教授指導下的研究實習生,研究主題LLM幻覺和對齊。2023年夏季,在Blender Lab擔任研究實習生,導師是季恒教授。

研究興趣包括自然語言處理(NLP)和大模型(LLMs)。對LLM對齊有廣泛的興趣。正在研究數學推理的獎勵建模。過去還研究過LLM幻覺。