LeCun力薦!進化算法淘汰77%低質數據:RIP方法讓模型性能狂飆60%

在LLM的開發中,推動模型進步的主要驅動力是精心挑選高質量的訓練示例。雖然Scaling Law的確能實現「力大磚飛」,但僅僅增加數據量并不能保證模型性能的提升,數據的質量才是關鍵。低質量的數據可能會引入噪聲,影響模型的訓練效果。

那么,有什么方法能自動篩選出,甚至是自動創建出高質量又兼具多樣性的數據集?

最近,Meta、UC伯克利、NYU等機構的學者提出了一種最新方法,簡稱RIP,讓低質量數據「一路走好」的同時,也是在暗示——只有成功存活下來的數據才是高質量的數據。

論文地址:https://arxiv.org/abs/2501.18578

受到進化算法的啟發,RIP在Alpacaeval2、Arena-Hard、Wildbench等多個有影響力的基準上實現了大幅提升,獲得了LeCun的轉贊。

RIP方法概述

拒絕指令偏好(RIP)的基礎是兩個核心假設。

第一個假設是,低質量prompt很可能產生低質量響應。具體來說,那些意義不明確、模糊或包含沖突信息的提示詞,很可能導致嘈雜或不準確的模型響應。這些提示詞不應該作為之后用于指令微調(SFT)的訓練數據。

第二個假設是,低質量prompt很可能產生具有更大差異的響應。

低質量prompt會引入不確定性和模糊性,可能存在多種解釋,因此LLM可能會猜測或填補提示詞中的空白,這導致多次響應之間的差異性更高。雖然其中一些響應可能與prompt的原始意圖一致,但其他響應可能顯著偏離。

從這一點上進行逆向思考,我們就可以將模型多次響應的方差視為評估提示詞質量的指標。方差越小,表明提示詞的質量更高。

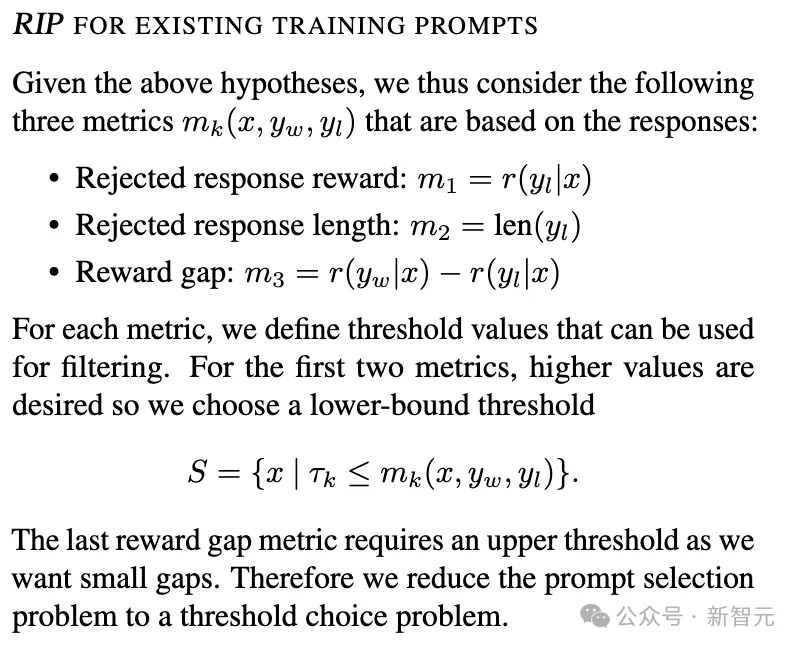

基于上述兩個假設,RIP方法就可以測量被拒絕的響應質量(下圖m_1),以及被選擇和被拒絕的響應之間的獎勵差距(reward gap,下圖m_3),從而評估數據的完整性。

上圖中定義的3個關鍵指標分別有如下含義:

m_1:被拒絕響應的的質量。

m_2:被拒絕響應的長度,較長的被拒絕響應可能意味著提示更復雜或更模糊。

m_3:被選擇與被拒絕響應之間的獎勵差距,較小的差距可能表明提示更清晰、更具體。

基于這種方法,RIP可以用于篩選、構建高質量數據集。給定一組提示詞X={x} ,RIP旨在找到一個子集S?X ,S可用于微調大模型?。

RIP如同設定一個優勝劣汰的提示詞斗獸場,提示詞對應的響應要么獲勝(被選擇),要么失敗(被拒絕)。響應對及其獎勵可以來自人類偏好數據,也可以由模型本身?生成,然后使用其它大模型進行評分。

除了過濾現有訓練集,RIP也可以用于構建高質量合成數據集。

用于生成合成數據時,首先篩選出一組高質量的提示作為種子池,然后使用這些種子提示詞作為少量樣本,引導模型生成新的提示詞。

這些新生成的提示詞可以進一步通過RIP進行篩選,以確保合成數據的質量,這種方法被稱為Self-RIP。

實驗結果與分析

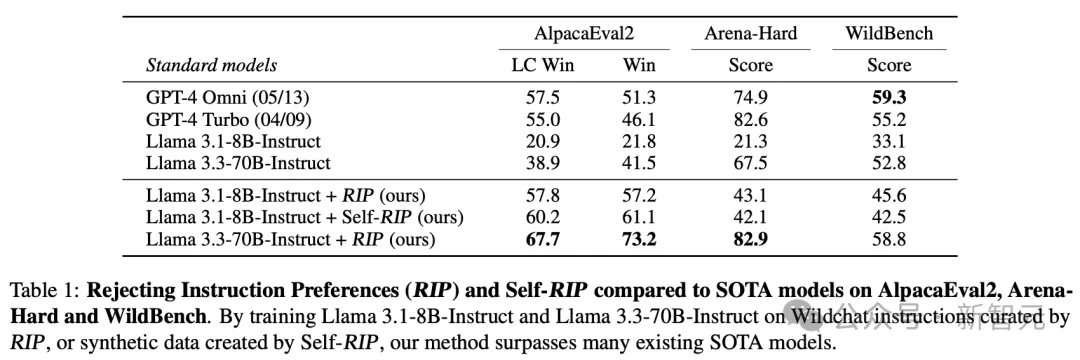

RIP在多個實驗中都取得了顯著的性能提升,尤其是在人類編寫的提示上,表現出了顯著的優勢。

例如,在包含超過25萬條人工編寫提示詞的WildChat數據集上,通過Llama 3.1-405B-Instruct評估響應的質量,為每個回答需進行 10 次獨立評估,每次給出0到10分的評分,并使用平均分作為最終獎勵。

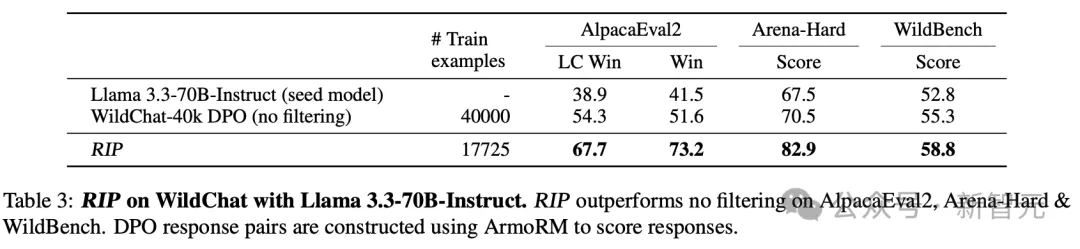

如下表所示,RIP只需要不到一半的訓練樣本,就能在多個指標上實現顯著提升。

使用RIP過濾出高質量的提示詞后,RIP顯著提高了Llama3.1-8B-Instruct DPO基線的性能。

在更大參數的模型上,RIP同樣有效。過濾顯著提升了Llama 3.3-70B-Instruct模型的性能,AlpacaEval2 LC勝率從38.9提升至67.7,Arena Hard從67.5提升至82.9,WildBench從52.8提升至58.8。

這些結果表明,RIP能夠有效地篩選出高質量的提示,從而提升模型的性能。

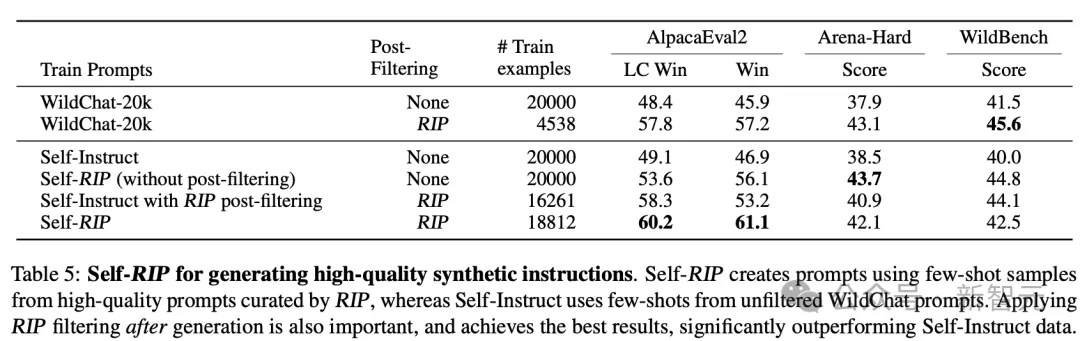

應Self-RIP方法 ,基于少樣本生成而不進行后過濾得到20k大小的數據集,可以讓模型在AlpacaEval2上的LC勝率從 48.4%提高到53.6%,Arena-Hard勝率從37.9%提高到43.7%,以及在WildBench上的WB-Score從41.5提高到44.8。這進一步說明了在高質量指令上訓練的重要性。

當應用完整的Self-RIP方法并使用后過濾(post-filtering)時,訓練效果進一步改善,實現了最佳的AlpacaEval2 LC勝率60.2%。

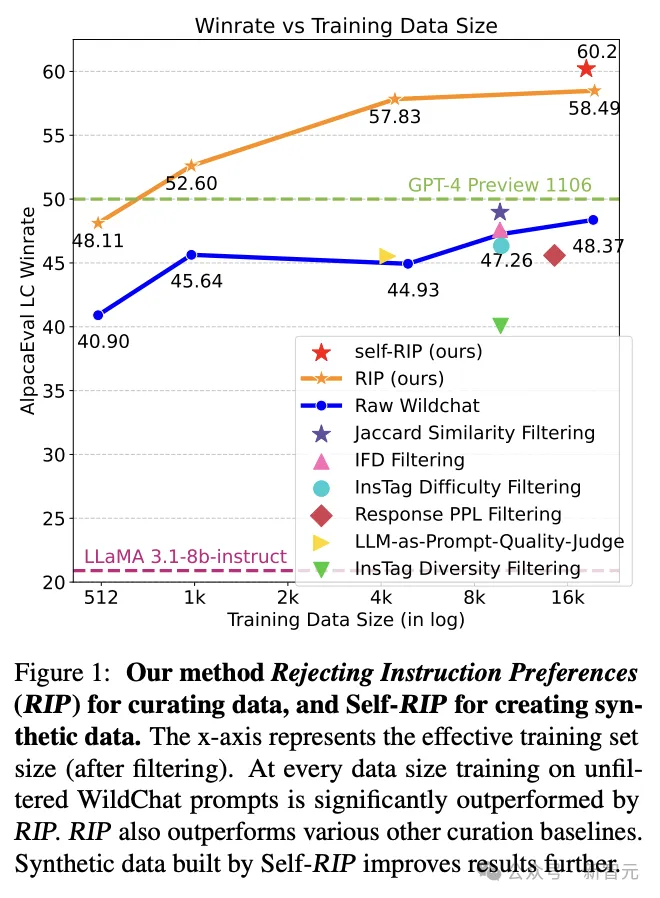

RIP在與其他篩選方法的比較中也表現出色。與基于提示的篩選方法(如InsTag Diversity/Difficulty Filtering)相比,RIP在所有基準測試中都取得了更高的分數。

此外,與基于提示和選擇響應的篩選方法(如PPL和IFD)相比,RIP也表現出更好的性能。這些結果表明,RIP在篩選提示時考慮了更多的因素,從而能夠更準確地評估提示的質量。

圖1:不同訓練數據大小下,使用RIP及self-RIP之后的模型訓練效果提升。

總體來看,RIP借鑒進化算法,為LLM的訓練提供了一種簡單卻新穎的思路。相比人類編寫的和模型生成的提示詞,使用RIP過濾后的提示詞集合,在進行指令微調后,模型性能有顯著提升。

未來的研究可以在此基礎上進行進一步的探索和改進。例如,可以研究如何優化評估模型,以提高其對響應質量的評估準確性;可以探索如何降低RIP方法的計算成本,使其更適合大規模數據的處理;還可以研究進行安全性評估——探索使用RIP進行安全性過濾,在現有系統中構建專門用于安全性的獎勵模型。