清華姚班校友等揭Transformer致命缺陷,OpenAI科學家緊急回應:學術界節奏太慢

誰能想到,一篇于2023年發表的LLM論文,竟然在一年半之后又「火」了。

聊天機器人開始面臨根本性的限制

論文中,來自Ai2、華盛頓大學等機構研究人員稱,Transformer在組合能力上存在限制。

以基本的乘法為例,讓「GPT-4」計算兩個三位數的乘積,最初的正確率僅有59%。當乘數增加到4位數時,準確率直接暴降到4%。

論文地址:https://arxiv.org/abs/2305.18654

與此同時,Quanta Magazined還在報道中引用了曾是哥大博士的彭炳輝于2024發表的論文,去論證Transformer存在著根本性的限制。

論文地址:https://arxiv.org/abs/2402.08164

論文地址:https://arxiv.org/abs/2412.02975

一作彭炳輝和導師同樣驗證了,由于Transformer缺乏組合能力,由此導致LLM產生了幻覺。

他們指出,「如果一個大模型只有單層Transformer結構,總參數量小于域的大小,AI便無法解決組合任務」。

實際上,這些研究本身并沒有什么,但QM卻稱之為「最近」。評論區瞬間被網友們吐槽淹沒了。

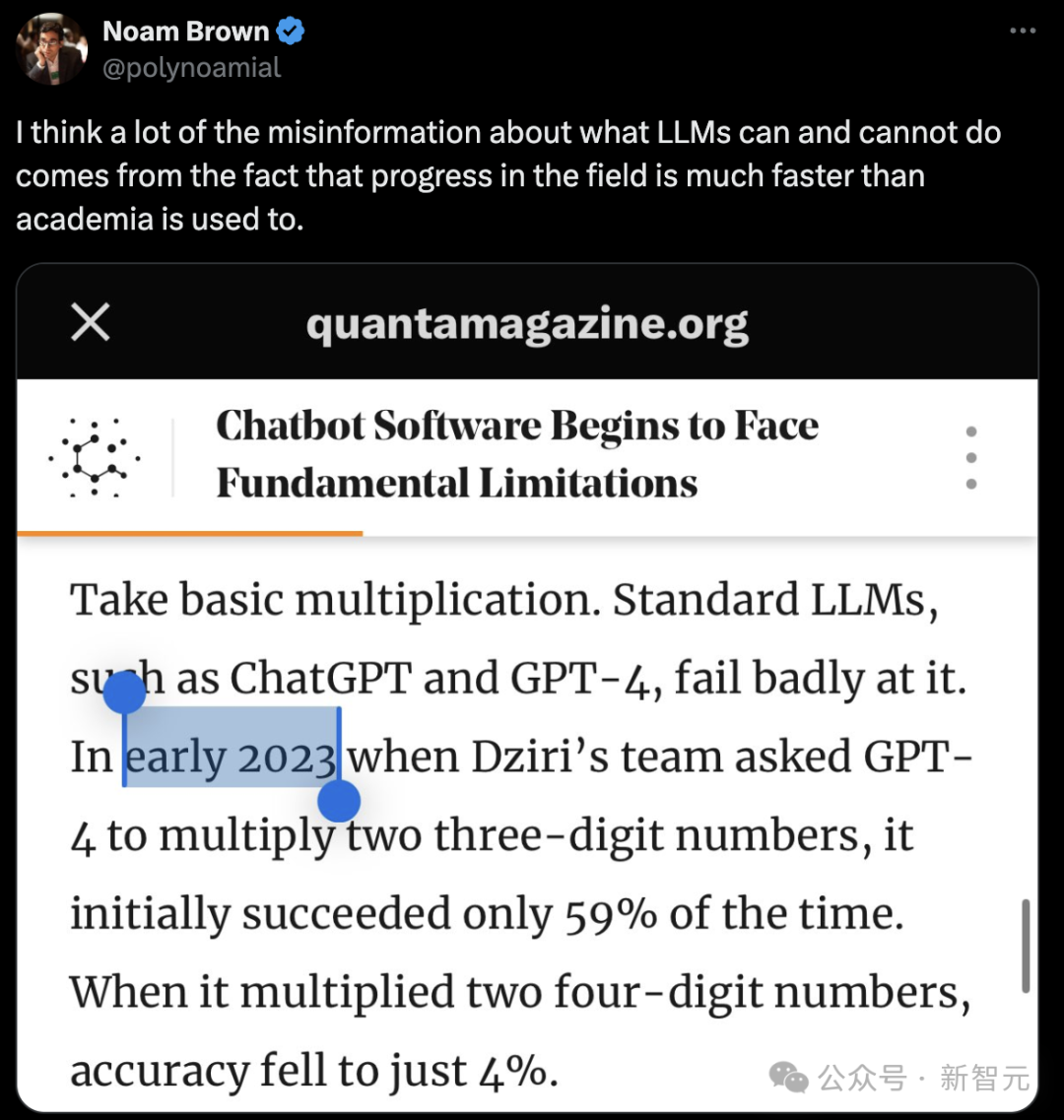

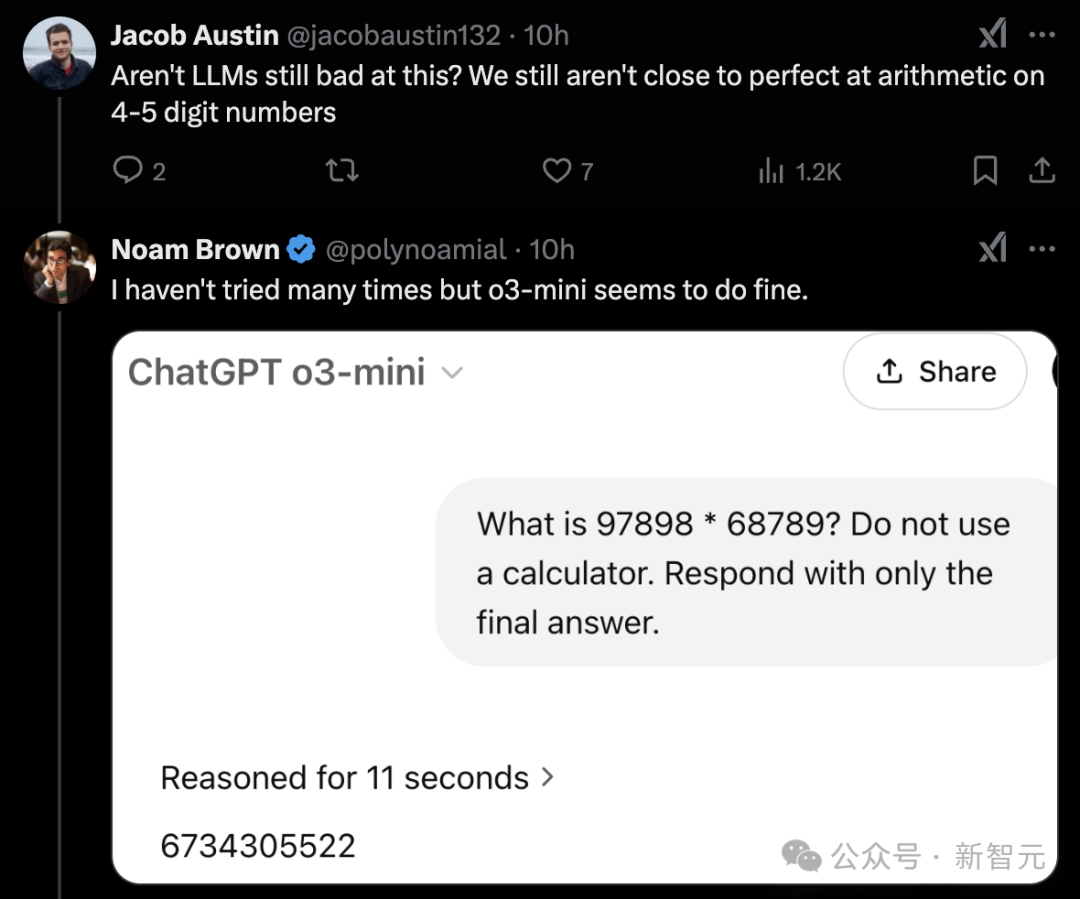

OpenAI研究員Noam Brown直言,「學術界研究節奏相對較慢,而LLM領域大發展速度遠超其慣常步調」。

DeepMind研究科學家對此進行了反駁,我們在4-5位的算數運算上仍未達到完美的水平。

這些論文中的觀點,如今都還成立嗎?

四位數相乘,GPT-4正確率4%

艾倫人工智能研究所的科學家Nouha Dziri及其團隊,對以ChatGPT為代表LLM進行測試,讓它們嘗試解決這類邏輯難題,模型的表現并不理想。

Dziri指出,當面對復雜任務時,LLM很難依據訓練數據之外的信息進行推理,只能做近似推斷,極有可能出錯。

需要整合多個子問題的答案,才能得出最終結果的任務被稱為組合性任務。

Nouha Dziri團隊研究發現,大部分LLM僅依靠預測序列中的下一個詞進行訓練,在應對組合性推理任務時,存在根本性缺陷。

多數LLM采用的Transformer架構,在處理這類問題時,會受到數學層面的限制。

盡管科學家在突破Transformer的限制方面取得了一定成果,但這些成果越來越像是權宜之計。

這類模型存在基礎計算瓶頸,或許是時候考慮轉變研究思路了。

「這項研究的真正目的,是幫助學界判斷,Transformer是否是適合通用學習的架構。」紐約大學的機器學習專家Andrew Wilson說道。

OpenAI的o1和GPT-4、谷歌的Gemini、Anthropic的Claude,是在幾乎所有能獲取到的互聯網數據上進行訓練的。

LLM掌握了語法,積累了大量的語義知識。這些經過預訓練的模型,還能進一步訓練或優化,完成更復雜的任務,像總結復雜文檔,生成游戲代碼。

它強大到仿佛真的會推理,但同時也在一些方面表現得極差,笨得讓人吃驚。

以基礎乘法運算為例,像ChatGPT和GPT-4這樣常見的LLM表現糟糕。

2023年初,Dziri團隊對GPT-4進行測試,讓它計算兩個三位數相乘,最初的正確率僅為59%。當計算兩個四位數相乘時,準確率更是急劇下降,只剩下4%。

團隊還測試了LLM在謎題任務上的表現,結果同樣不理想。

當謎題是兩座房子,每座房子對應兩個屬性時,GPT-4還能每次都答對。但當謎題難度升級為四座房子,每座房子對應四個屬性時,正確率就銳減至10%。

《國際生活》上的原始謎題版本,也就是五座房子,每座房子對應五個屬性的情況,GPT-4的正確率直接歸零。

Dziri認為「它只是在模仿自己見過的東西,并沒有真正理解。」

LLM存在難以突破的限制

與此同時,另一個研究團隊采用了不同的方法,來理解LLM為什么在處理組合性任務時會遇到困難。

當時,正在哥大讀博的彭炳輝與導師Christos Papadimitriou等人一起研究LLM為什么會產生幻覺,生成與事實不符的錯誤信息。

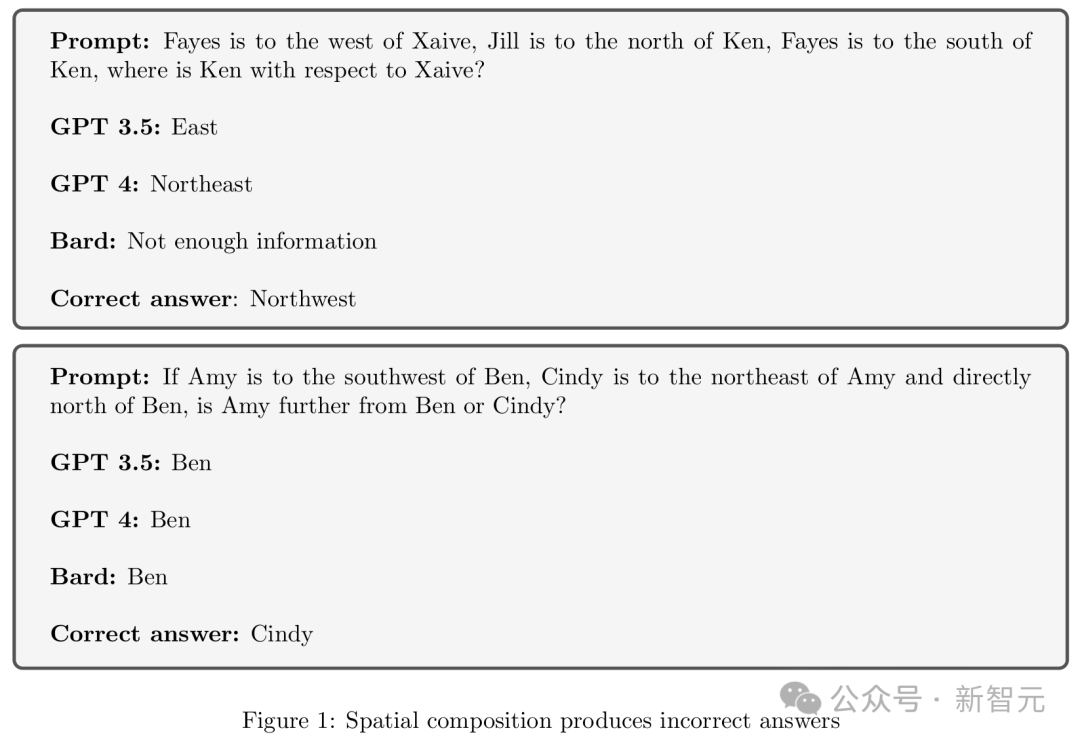

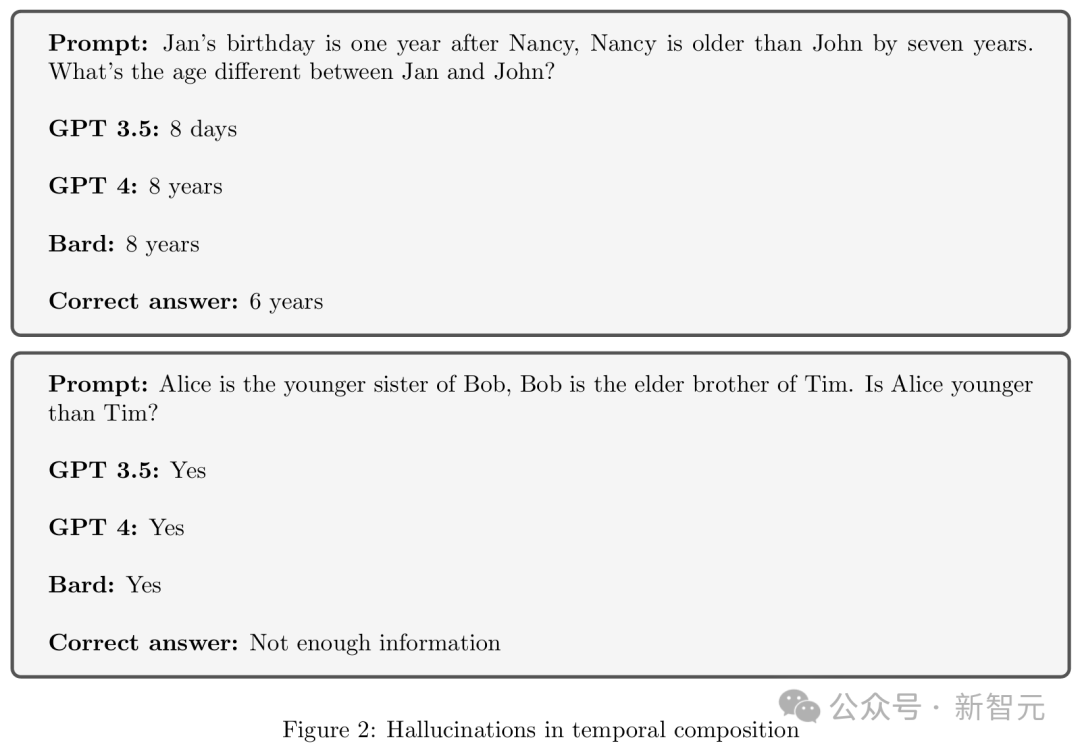

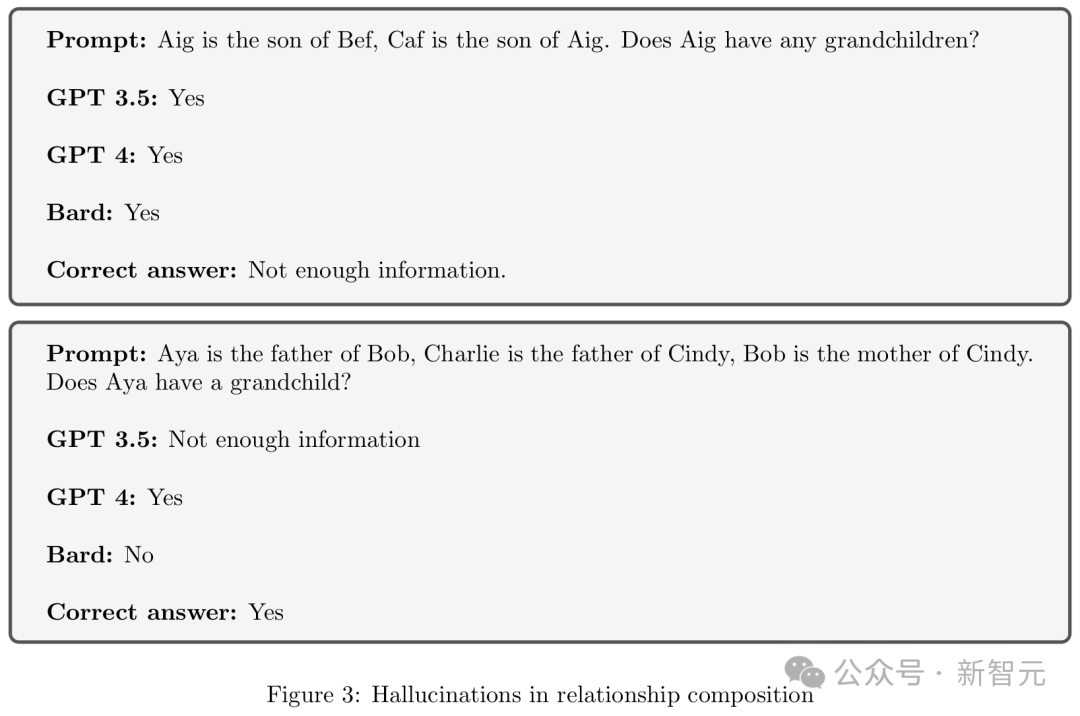

下面三張圖中的例子,分別展示了LLM在空間構成、時間構成和關系構成上產生的幻覺。

對此,團隊懷疑原因在于Transformer缺乏「組合能力」。

假設給LLM輸入兩條信息:一是弗雷德里克·肖邦的父親是尼古拉·肖邦,二是尼古拉·肖邦出生于1771年4月15日。然后問它:弗雷德里克·肖邦的父親的出生日期是什么?

這時,LLM需要把這兩條信息整合起來,才能作答。

實際上,它要解答的是一個嵌套問題,先找出弗雷德里克·肖邦的父親是誰,再回答這個人的出生日期。

要是LLM給出的答案不對,出現了所謂的「幻覺」,很可能就是因為它沒能成功完成這種組合性任務。

為了驗證這個猜想,團隊首先研究了一種簡單Transformer的特性。

這種模型只有一層,在預測下一個單詞時,會根據句子中單詞的順序和位置來判斷。現代LLM通常包含多層這樣的結構。

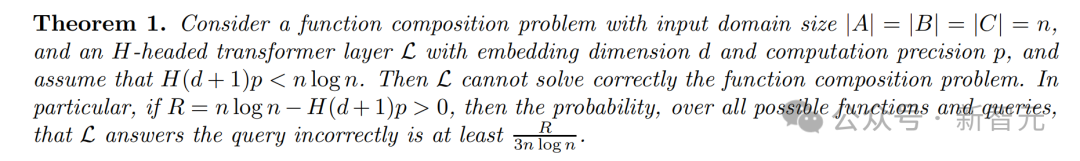

團隊找到了Transformer層的復雜程度和域大小(也就是表示問題所需的比特數)之間的聯系。

通過研究這個簡單模型,他們證明了一個數學限制條件。

如果單層Transformer的總參數數量小于域的大小,從理論上來說,Transformer就解決不了組合性任務。

僅有一個Transformer層的LLM,在數學層面存在明顯的局限性。

雖說這是一個很有說服力的理論成果,但它的實際影響還不明確,因為現代LLM要復雜得多。

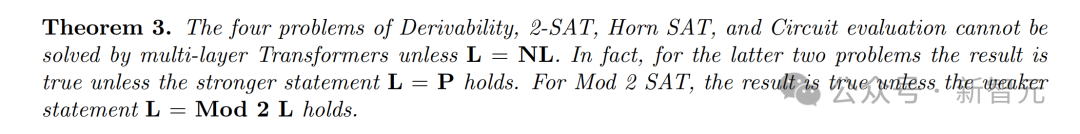

于是,團隊換了一種方法來研究更復雜的Transformer的能力。他們運用計算復雜性理論,通過分析解決問題所需的時間、內存等資源,來探究問題的本質。

他們借助一個著名的猜想證實,即使是多層Transformer在解決復雜的組合性問題時,計算能力也存在限制。

2024年12月,彭炳輝和加州大學伯克利分校的研究員發表了一項證明。這次,他們拋開計算復雜性理論的猜想,直接證實了多層Transformer確實無法解決某些復雜的組合性任務。

彭炳輝說:「模型規模增大后,確實能解決更具挑戰性的問題。但要是同時擴大問題的規模,就算模型變得更大,解決起來照樣棘手。」

這充分表明,Transformer架構存在著難以逾越的局限性。

但這并不意味著LLM的終結。

紐約大學的Wilson指出,雖然存在這些局限性,研究人員已經開始改進Transformer,幫助它們更好地處理包括算術在內的各類問題。

馬里蘭大學的計算機科學家Tom Goldstein和他的同事在給Transformer輸入數字時做了些調整,他們在每個數字里嵌入額外的位置信息,再訓練加法運算模型。

經過20位數訓練的模型,在進行100位數加法時,準確率能穩定達到98%;而沒有嵌入額外位置信息的模型,準確率只有3%左右。

這表明,也許有一些基礎的改進方法可以采用,這樣就能在這些問題上取得重大進展,而無需重新設計整個架構。

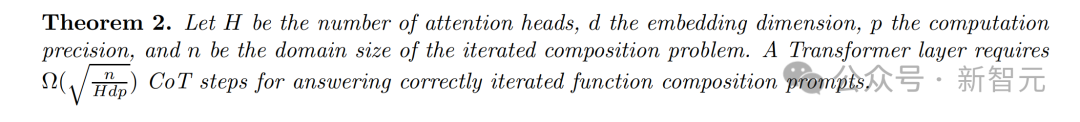

除了擴大模型規模,還有一種克服LLM局限性的辦法,就是在提示中給出問題的逐步解決步驟,即思維鏈提示。

研究顯示,這種方法能讓GPT-4這類LLM,具備解決更多相關任務的能力。

斯坦福大學博士生Haotian Ye表示:「我們很好奇,為什么它這么有效,能帶來這么多突破。」

他在北大讀本科時,就曾對比過Transformer在使用思維鏈提示與否時的表現。

他們借助計算機科學的另一分支——電路復雜性理論進行論證,解釋了思維鏈提示是如何把一個大問題拆解成一系列小問題,進而讓Transformer處理更復雜的組合性任務。

不過Haotian Ye也提醒,這并不意味著模型用了思維鏈提示,就真能解決這些難題。

這項研究關注的是理論能力,而模型的訓練方式,決定了它們能在多大程度上發揮出這一理論上限。

LLM本質上是在匹配以前見過的模式,它們的能力受到數學限制。嵌入技巧和思維鏈提示,只是拓展了它們處理更復雜模式匹配的能力。

從數學原理來看,總能找到一些組合性任務,其復雜程度超出了給定系統的處理能力。

Dziri表示:「我們必須徹底弄清楚模型內部是如何運作的。要是能搞明白它們執行任務和推理的方式,或許就能對它們進行優化改進。要是不清楚,那就真的很難開展任何工作了。」

作者介紹

彭炳輝,現任加州大學伯克利分校西蒙斯研究所的博士后研究員。此前,在哥倫比亞大學獲得博士學位,導師是Xi Chen和Christos Papadimitriou。并在清華大學姚班獲得學士學位。

彭炳輝的研究領域廣泛,涉及機器學習理論、博弈論以及理論計算機科學。最近,他尤其關注計算理論與AI之間的相互作用。