DeepSeek-R1全面超越OpenAI o1:開源大模型訓練范式革新

人工智能在過去十年中的發展令人驚嘆。其中,2017 年 Google 發布的“Attention Is All You Need”論文奠定了神經網絡架構的重要基礎,推動了大規模語言模型(LLM)的突破。

OpenAI 早期專注于強化學習(RL),但在 Transformer 結構問世后,迅速調整方向,借助 Google 的開源研究開發出強大的 LLM。然而,盡管 OpenAI 最初以“開放”為宗旨,近年來卻逐漸轉向封閉模式,自 GPT-2 以來,其所有模型進展均未再公開。

最近,OpenAI 發布了名為 “o1” 的新模型,專注于增強長鏈式思維(Chain-of-Thought)和強化學習,以提升解決復雜問題的能力。然而,該模型的具體訓練細節仍未公開。

但這一切正在改變。

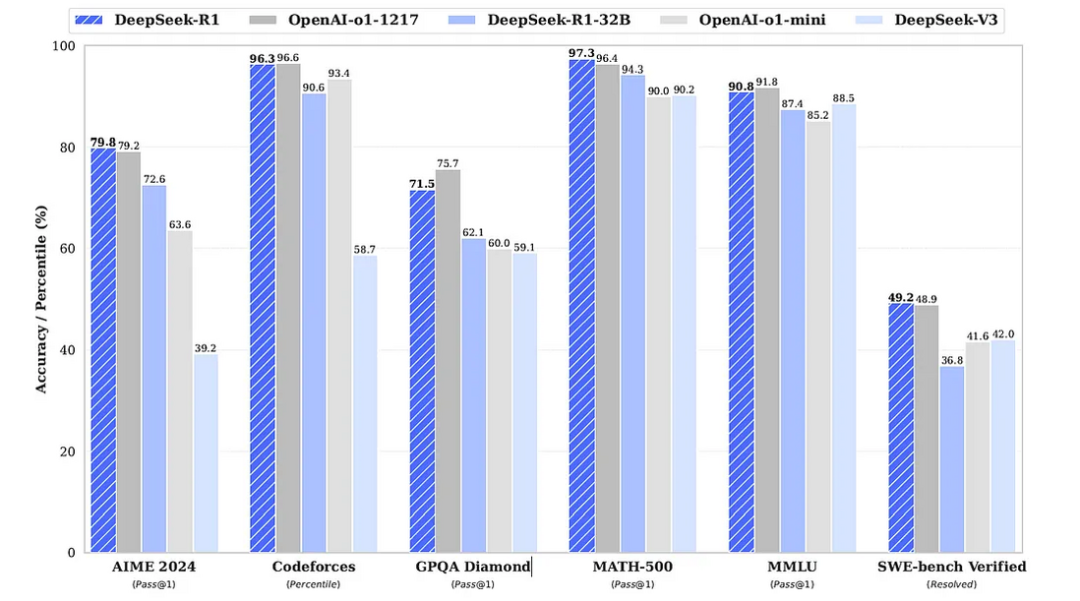

中國 AI 公司 DeepSeek 近期發布了新一代模型 DeepSeek-R1,在復雜領域的推理能力上媲美 OpenAI 的 o1,甚至在多個數學和編程基準測試上超越了它。

圖片

圖片

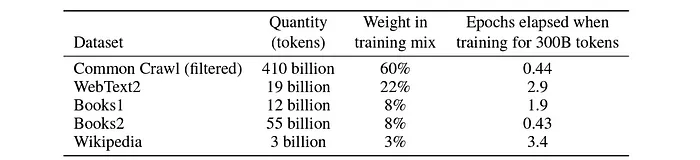

LLM 的標準訓練流程

訓練大規模語言模型通常從大規模文本數據的收集開始。這些數據可能來自公開網絡資源或專有數據集。

圖片

圖片

隨后,這些數據經過清理、格式化、分詞,并轉換為文本嵌入,供模型進行自監督學習。這一階段稱為預訓練,幫助模型掌握語法、語義和上下文關系。

在此基礎上,模型會經過 監督微調(SFT),用于提升特定任務(如數學推理、編程、翻譯等)的能力。

為了確保模型生成的內容符合人類偏好,通常會通過基于人類反饋的強化學習(RLHF)進行優化,例如使用 PPO(近端策略優化) 或 DPO(直接偏好優化)。

強化學習在長鏈式思維的優化上發揮著關鍵作用,這也是 DeepSeek-R1 能夠展現強大推理能力的核心原因。

突破 SFT 訓練方式,直接使用強化學習

DeepSeek 團隊以 DeepSeek-V3-Base 作為預訓練基礎模型,并跳過了傳統的 SFT 過程,直接使用強化學習(RL)來提升推理能力。這使得模型能夠在沒有監督數據的情況下,自我進化并提升推理能力。

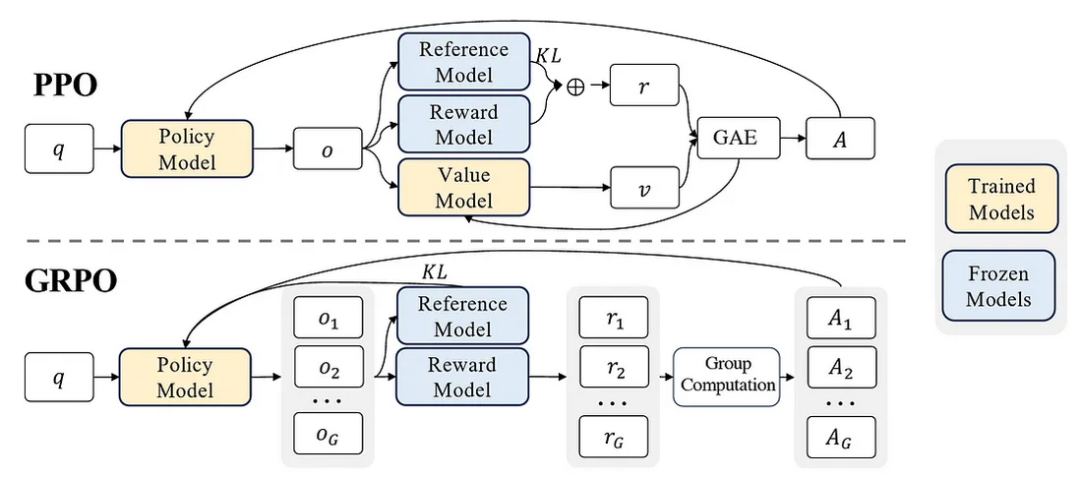

在強化學習中,DeepSeek 團隊并未采用 OpenAI 開發的 PPO,而是提出了一種自研算法 GRPO(組相對策略優化)。

PPO vs. GRPO

- PPO 依賴“策略模型”和“價值模型”計算優勢估計(Advantage Estimation),計算成本較高。

- GRPO 直接根據一組樣本的相對獎勵計算優勢估計,避免了價值模型的計算,提高訓練效率并降低成本。

強化學習獎勵機制

DeepSeek-R1 采用基于規則的獎勵系統,而非神經網絡獎勵模型,以減少計算開銷并避免“獎勵作弊”現象。

- 準確性獎勵:依據答案的正確性給予分數。

- 格式獎勵:若模型在回答中遵循特定格式,則額外加分。例如,推理過程包裹在 <think></think> 標簽中,最終答案位于 <answer></answer> 標簽內。

經過這一訓練階段,模型進化為 DeepSeek-R1-Zero,并展現出驚人的推理能力。

圖片

圖片

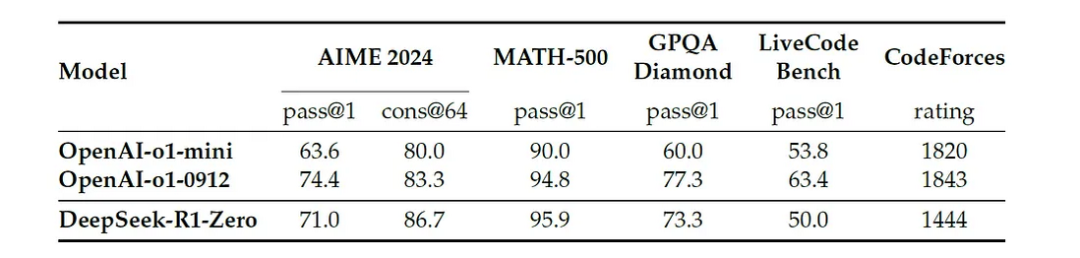

DeepSeek-R1-Zero 訓練效果

隨著強化學習的持續進行,**DeepSeek-R1-Zero 在 AIME(2024)數學競賽上的首答正確率(pass@1)從 15.6% 提升至 71%**,幾乎與 OpenAI o1 持平。

圖片

圖片

進一步測試表明,在 cons@64 指標上,DeepSeek-R1-Zero 甚至超越了 OpenAI o1(83.3% vs 86.7%)!

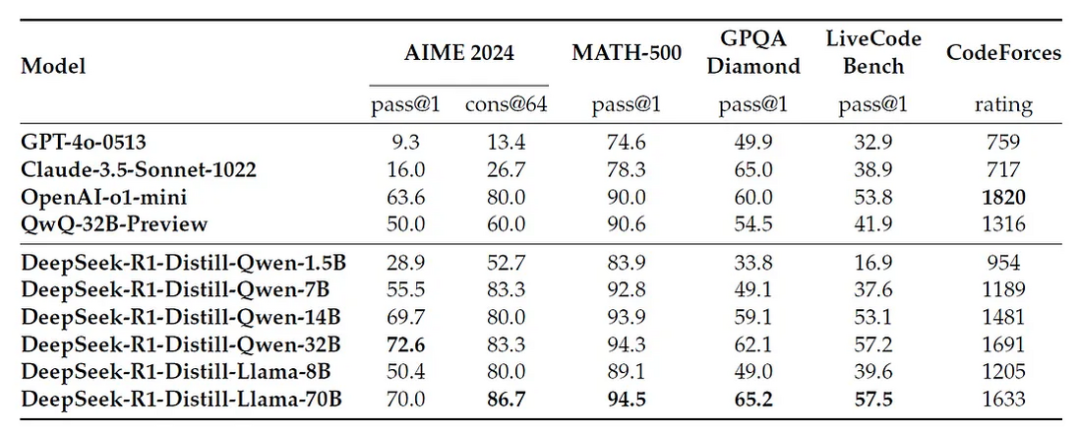

強化學習訓練中的關鍵現象

- 模型逐漸增加計算時間,并生成更多推理步驟,以深入思考復雜問題。

- 自我反思、自我糾正 等能力自然出現,使其能夠回顧并調整推理過程。

- 在訓練過程中,研究人員觀察到模型在推理某個復雜數學問題時,突然意識到自己可以更深入思考,并主動重新評估之前的推理步驟——這種現象被稱為“頓悟時刻(Aha Moment)”。

圖片

圖片

補充 SFT 以優化模型表達能力

盡管純強化學習訓練提升了推理能力,但 DeepSeek-R1-Zero 仍然存在一些問題,例如:

- 輸出格式混亂,影響可讀性。

- 回答可能混雜多種語言。

為此,研究人員引入了一小部分 長鏈式思維(CoT)數據 進行 SFT,確保模型能夠清晰表達推理過程。隨后,再次使用強化學習優化推理能力,同時引入語言一致性獎勵,確保生成的內容保持單一語言表達。

最終,模型演化為 DeepSeek-R1。

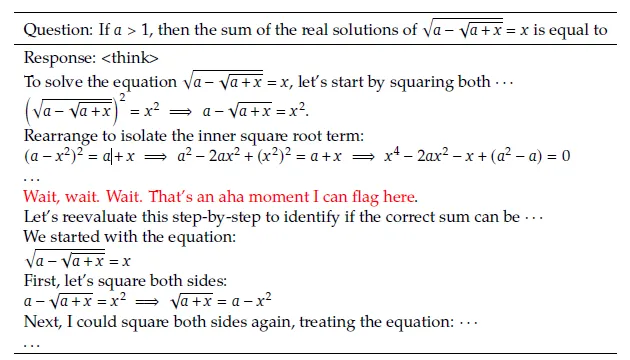

DeepSeek-R1 超越 OpenAI o1 的測試表現

DeepSeek-R1 在多個基準測試上展現出卓越表現,尤其是在:

- 數學推理(AIME、MATH-500)

- 編程能力(LiveCodeBench、SWE Verified、Codeforces)

此外,DeepSeek-R1 還在長上下文理解、事實性問答、寫作任務等領域超過了自家的 DeepSeek-V3,并在格式化指令跟隨能力上表現優異。

圖片

圖片

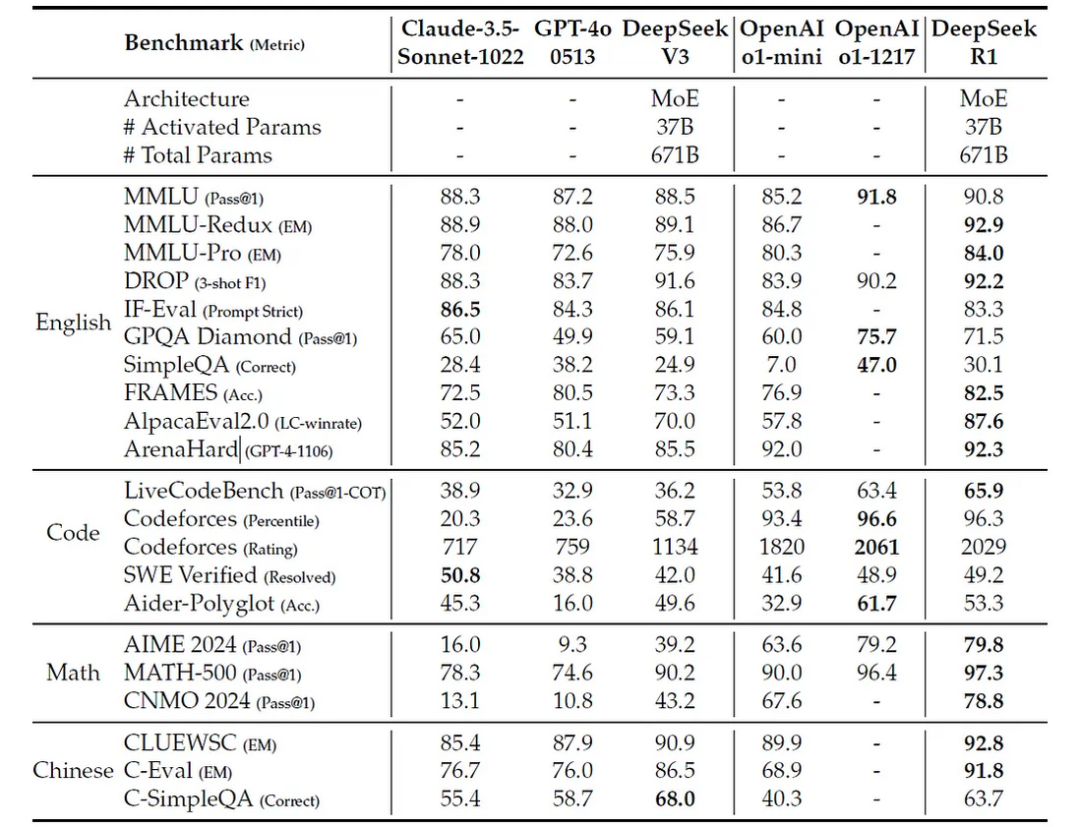

小型模型的蒸餾研究團隊使用 知識蒸餾 方法,將 DeepSeek-R1 的知識遷移至更小的 Qwen 和 Llama 模型,如:

- DeepSeek-R1-Distill-Qwen-32B 超越 OpenAI o1-mini。

- DeepSeek-R1-Distill-Llama-70B 在多數測試中遠勝對手。

為了進一步優化,研究人員還嘗試對 Qwen-32B 進行 RL 訓練,最終得到 DeepSeek-R1-Zero-Qwen-32B,其推理能力達到 Qwen 旗下最強模型 QwQ-32B-Preview 的水平。

圖片

圖片

訓練成本與推理費用

DeepSeek-R1 采用 6710 億參數的 專家混合架構(MoE),但訓練成本遠低于 OpenAI 和 Meta 的同類模型。

- DeepSeek-R1 訓練成本約為 10M(相比之下,GPT-4 訓練成本約 $100M,o1 可能更高)。

- 推理費用僅 60 / 100 萬 tokens,后者比 DeepSeek-R1 貴 27 倍。

DeepSeek-R1 未來展望

盡管 DeepSeek-R1 在某些任務上仍遜于 DeepSeek-V3(如函數調用、多輪對話、JSON 生成等),但其開源研究已經對 AI 領域產生深遠影響。

Hugging Face 目前已發布開源復現版 Open-R1,預計未來將有更多基于 DeepSeek-R1 的項目涌現。

這一突破不僅提升了開源 LLM 的競爭力,更加速了 AI 技術的民主化進程!