字節版Operator搶跑OpenAI? 直接免費開源, 網友:怒省200美元!

一線大模型,正在全面進入智能體時代。

1 月 24 日凌晨 2 點,OpenAI 面向月供 200 美元的 ChatGPT Pro 用戶發布了自家的 Computer Use 智能體:Operator。

OpenAI 甚至給 Operator 開設了單獨的產品界面,將它視為與 ChatGPT、Sora 并列的關系,這也符合 Sam Altman、黃仁勛、扎克伯格等科技大佬對于「2025 年將是 AI 智能體之年」的趨勢判斷。

實際上 Operator 只是最近一段時間,全球大模型公司智能體集中發布浪潮的一部分。早于 Operator 發布前兩天,字節跳動豆包大模型團隊就已經公布了同類型智能體:UI-TARS。

據悉,UI-TARS 的名字來源于電影《星際穿越》的 TARS 機器人,預示著它具備高度的智能和自主思考能力。

重點是:UI-TARS 是開源的!大家可以免費使用。而且,UI-TARS 還有對應的詳細技術報告可供學習。所以,無論從應用普及還是學術研究的角度來看,UI-TARS 都將成為一股重要的力量,推動智能體時代加速到來。

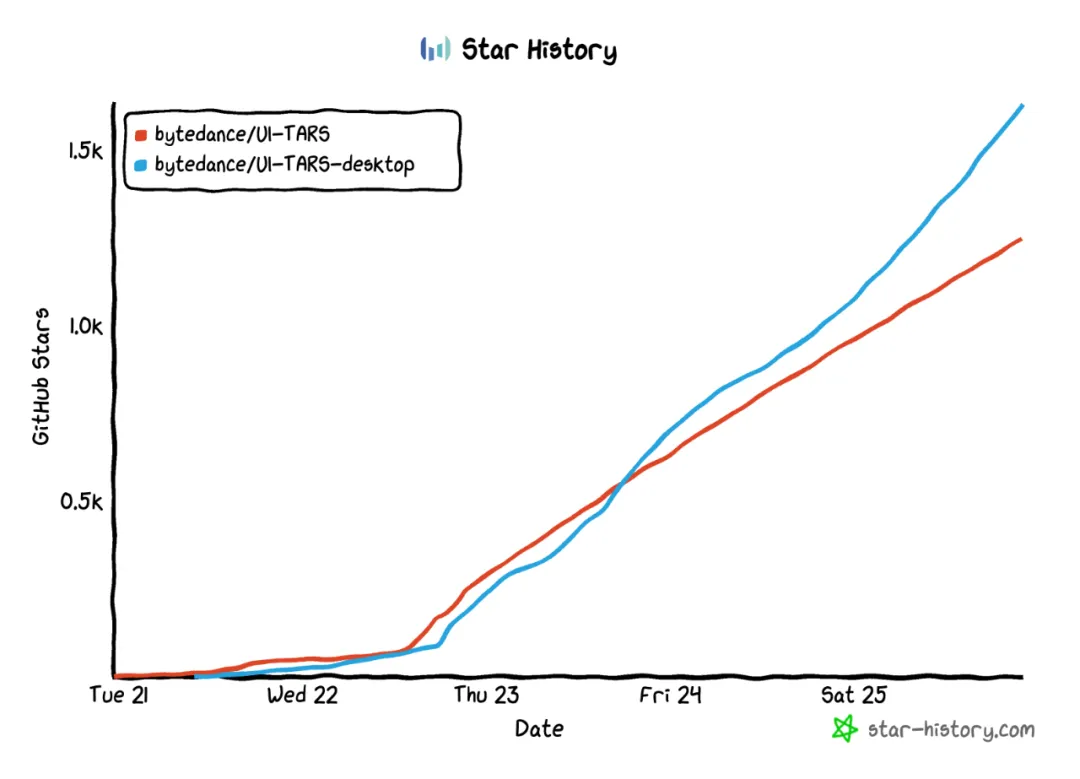

發布三四天,UI-TARS 的 GitHub star 量就突破了 1k,支持 Windows 和 Mac 系統的 UI-TARS-desktop 客戶端達到了 1.6k stars,可見這種質量的開源智能體項目在社區是非常稀缺的。

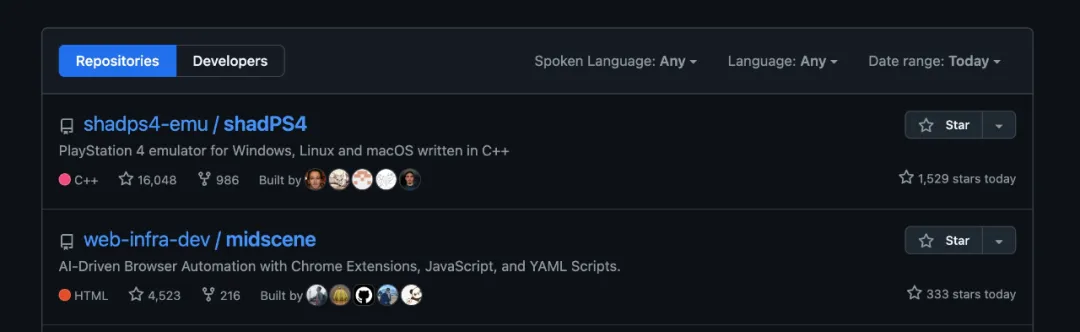

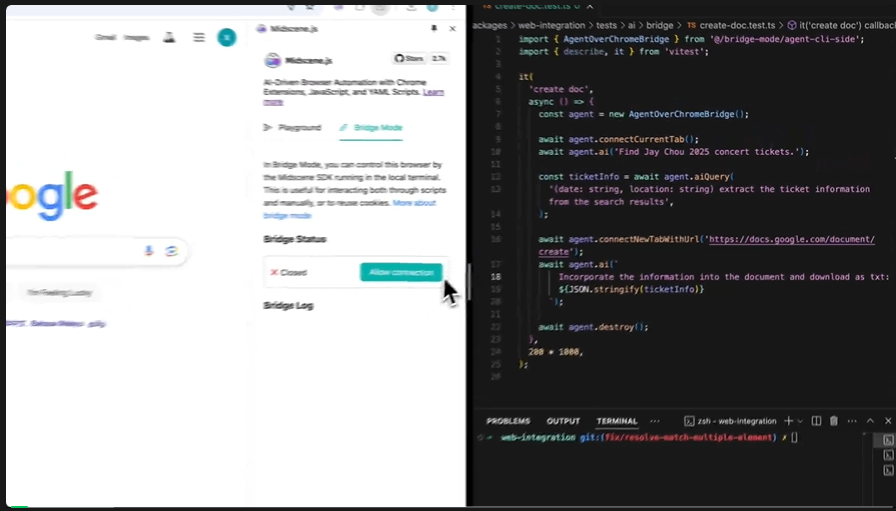

此前在業內小有名聲的 Web 自動化框架 Midscene.js ,在接入 UI-TARS 之后也增加了大量 star 關注,上榜 Github Trending。

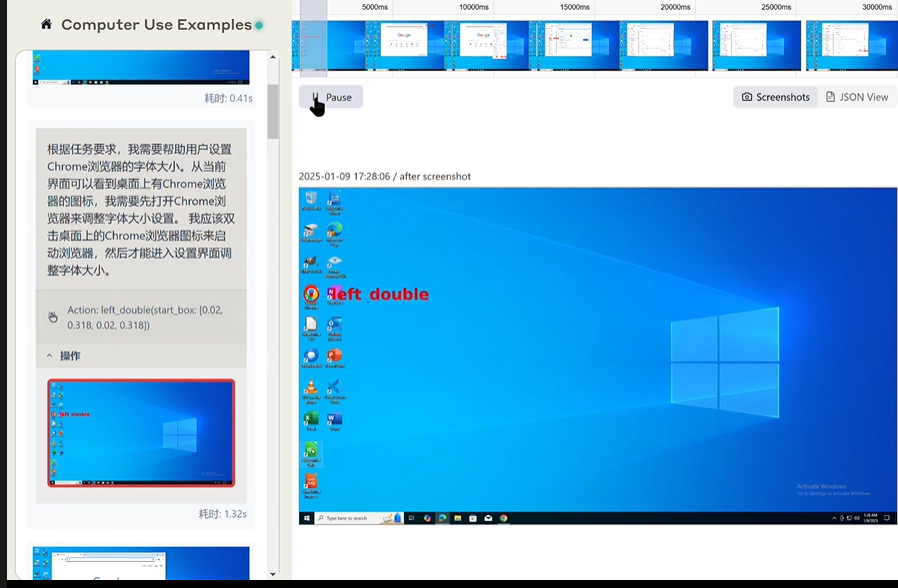

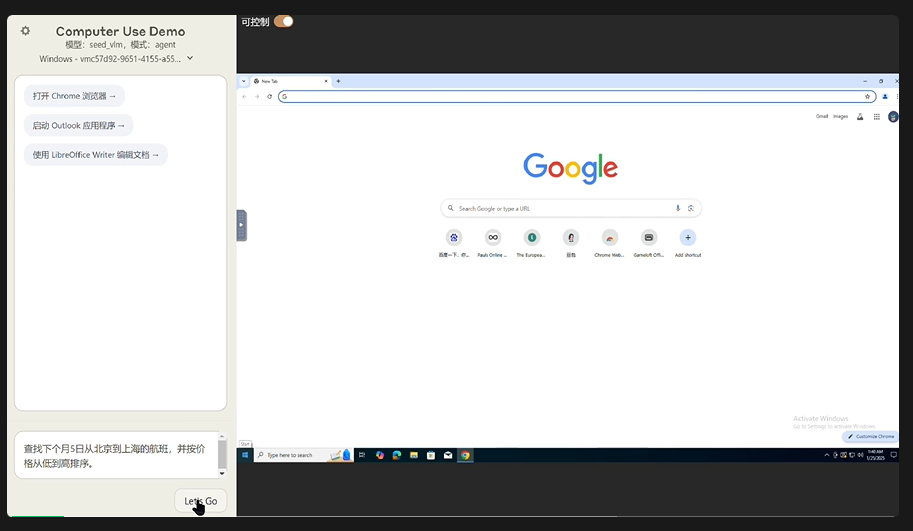

下面是 UI TARS 實測效果。可以看到,它不僅能像 Operator 一樣控制瀏覽器和執行推理,并且只要是能顯示在屏幕上的,它都能操作。

UI-TARS 幫用戶調整 Chrome 瀏覽器的字體大小。可以看到,UI-TARS 似乎有一些內置的知識可以支持自己的思考,比如它知道通過 Chrome 右上角三個點的圖標可以訪問「設置」,并且能精準地在屏幕上找到這三個點。

UI-TARS 幫用戶訂機票。它不僅能根據設置搜索到對應機票,還可以按照價格排序。

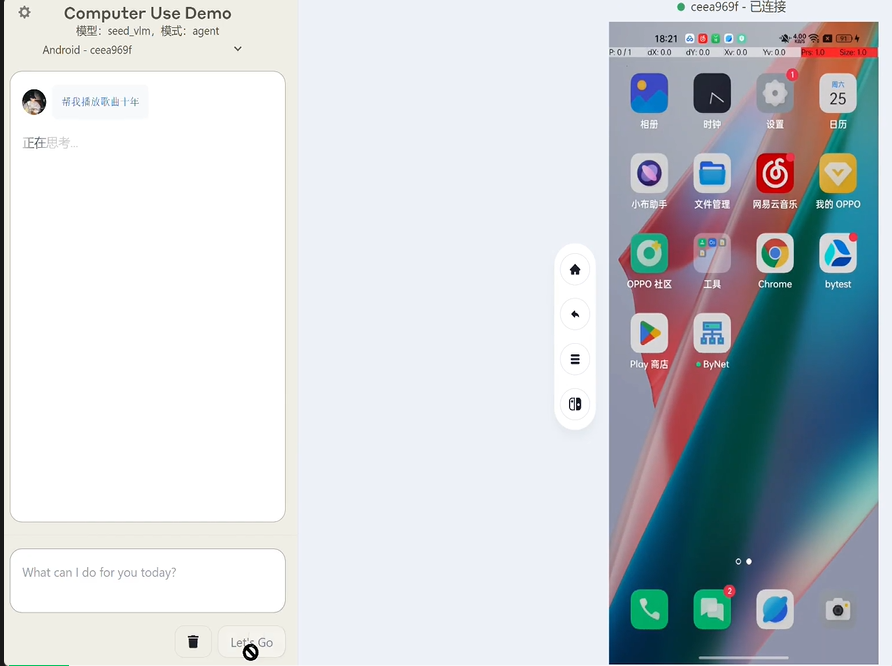

有意思的是,相比于 Operator 只能操控電腦,UI-TARS 還能操控手機。

UI-TARS 幫用戶播放歌曲

與字節開源的 UI 自動化工具 Midscene.js 放到一起,UI-TARS 還能發揮更大的價值 —— 支持目標驅動、兼容畫布操作、允許私有化部署、執行效率躍升等等,開發者能明顯感受到其中的變化。

聯合應用 Midscene.js 與 UI-TARS ,用 JS 代碼驅動編排任務,搜集周杰倫演唱會的信息,并寫入 Google Docs。

目前,已經有許多海內外用戶在測試 UI-TARS,并給出了非常積極的反饋。

比如,Lepton AI 聯合創始人謝亞東嘗試用 UI-TARS-7B-SFT 和 midscene.js 開發了一個 Web Agent。

- UI-TARS PC 客戶端:https://github.com/bytedance/UI-TARS-desktop

- Midscene.js 瀏覽器控制:https://github.com/web-infra-dev/midscene

UI-TARS 為啥操作準?

端到端的智能體架構創新

與 OpenAI 商業化優先相對的是,字節的 UI-TARS 優先公開且開源了技術文檔。我們可以看到 UI-TARS 技術路線的創新之處。

- 論文標題:UI-TARS: Pioneering Automated GUI Interaction with Native Agents

- 論文地址:https://arxiv.org/pdf/2501.12326

- 開源地址:https://github.com/bytedance/UI-TARS

具體地講,UI-TARS 具有以下幾項創新點:

- 增強感知(Enhanced Perception):利用大規模 GUI 截圖數據集,實現對 UI 元素的上下文感知理解并生成精確描述;

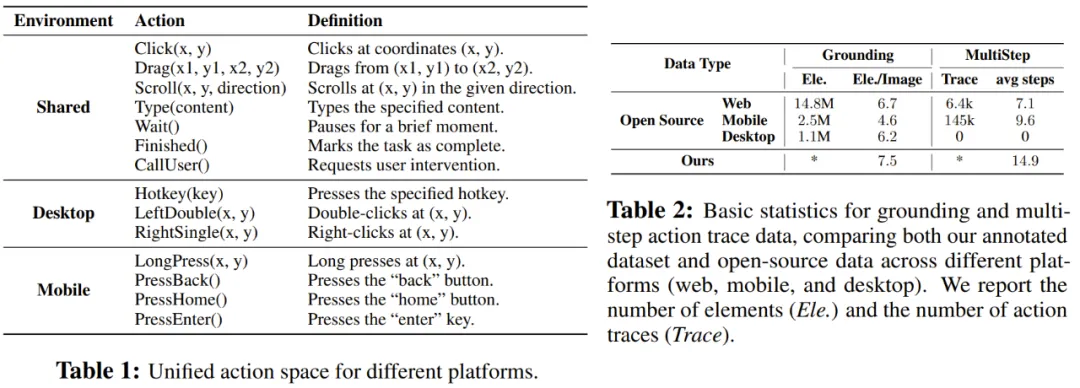

- 統一動作建模(Unified Action Modeling):將動作標準化處理到跨平臺的統一空間中,并通過大規模動作軌跡實現精確定位和交互;

- System 2 推理(System-2 Reasoning):將深思熟慮的推理納入多步決策,并涵蓋任務分解、反思思維等多種推理模式。

- 迭代式反思訓練(Iterative Training with Reflective Online Traces):通過在數百臺虛擬機上自動收集、過濾和反射細化新的交互軌跡來解決數據瓶頸問題。同時基于迭代訓練和反思訓練,UI-TARS 持續從錯誤中學習,并在最少的人為干預下適應不可預見的情況。

字節豆包大模型團隊認為,如果想要 AI 智能體真正實現類人的自主任務執行能力,就必須解決當前通用大模型直接應用在 GUI(圖形用戶界面)智能體上存在的一些技術缺陷與不足。

首先,用戶指令的執行需要提取特定元素的坐標信息,而通用大模型通常缺乏所需要的精確數值理解能力。其次,通用大模型在處理目標驅動場景時往往理解不到位,這就需要開發者提供詳細的自然語言說明操作步驟,增加了開發者的負擔。最后,同時發送圖片信息與元素描述不可避免地造成模型調用過程中消耗大量的 token,會導致性能損耗,成本升高。

在 Operator 中,OpenAI 通過 GPT-4o 的視覺能力和強化學習實現的高級推理相結合,讓智能體可以像人類一樣與圖形界面進行交互,靈活地執行任務。

UI-TARS 也很好地解決了上述瓶頸,它依托強大的通用多模態語言模型進行視覺識別,并面向智能 UI 交互進行了定向訓練。這樣做的結果便是:UI-TARS 在 GUI 智能體領域能夠發揮出遠勝于其他通用模型或 GUI 模型的表現,與此同時可以兼容各種形式的操作系統。

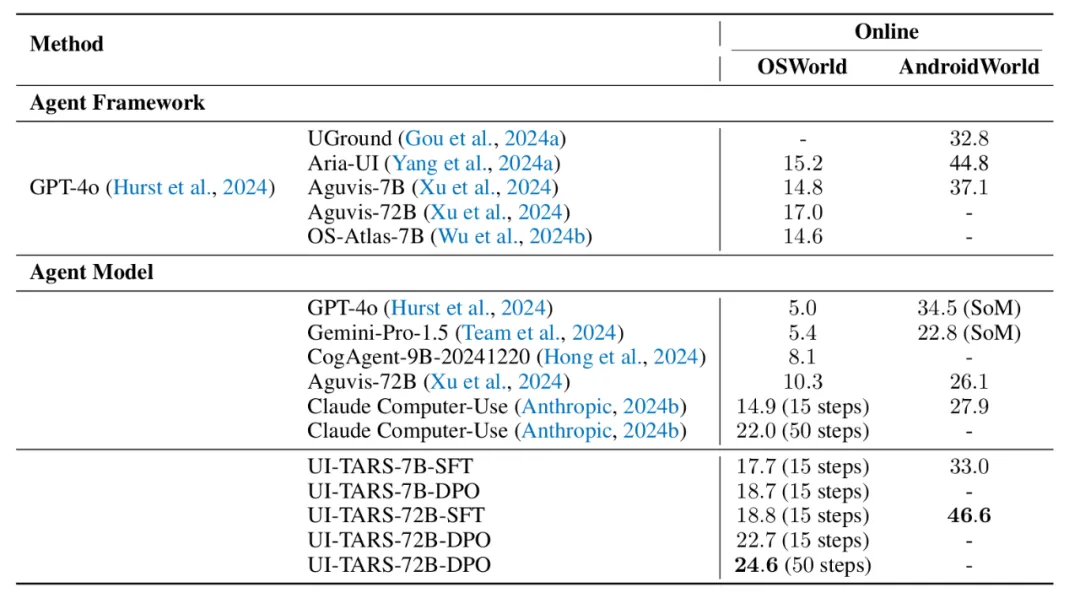

效果好不好,我們用權威基準測試結果來說話。在線動態環境可以模擬真實世界場景的交互,而 GUI 智能體通過實時執行操作來改變環境狀態,從而可以滿足用戶需求。

其中在 OSWorld 上,當限定的最大步數為 15 時,UI-TARS 的任務成功率可達 22.7%,超過了 Claude 的 14.9%,也超過了 Operator 的 19.7%。而當限定步數提升到 50 步時,UI-TARS 的成功率達到了 24.6%,同樣也超過 Claude,但根據 OpenAI 公布的數據,Operator 在 50 步時的表現達到了 32.6%,相對 UI-TARS 有明顯優勢。這意味著 test-time scaling 是 UI-TARS 下一步需要升級的方向。

不僅如此,在基于 Andriod 操作系統的 AndroidWorld 基準上,UI-TARS 獲得了 46.6% 的任務成功率,大幅超過了 GPT-4o 的 34.5%。

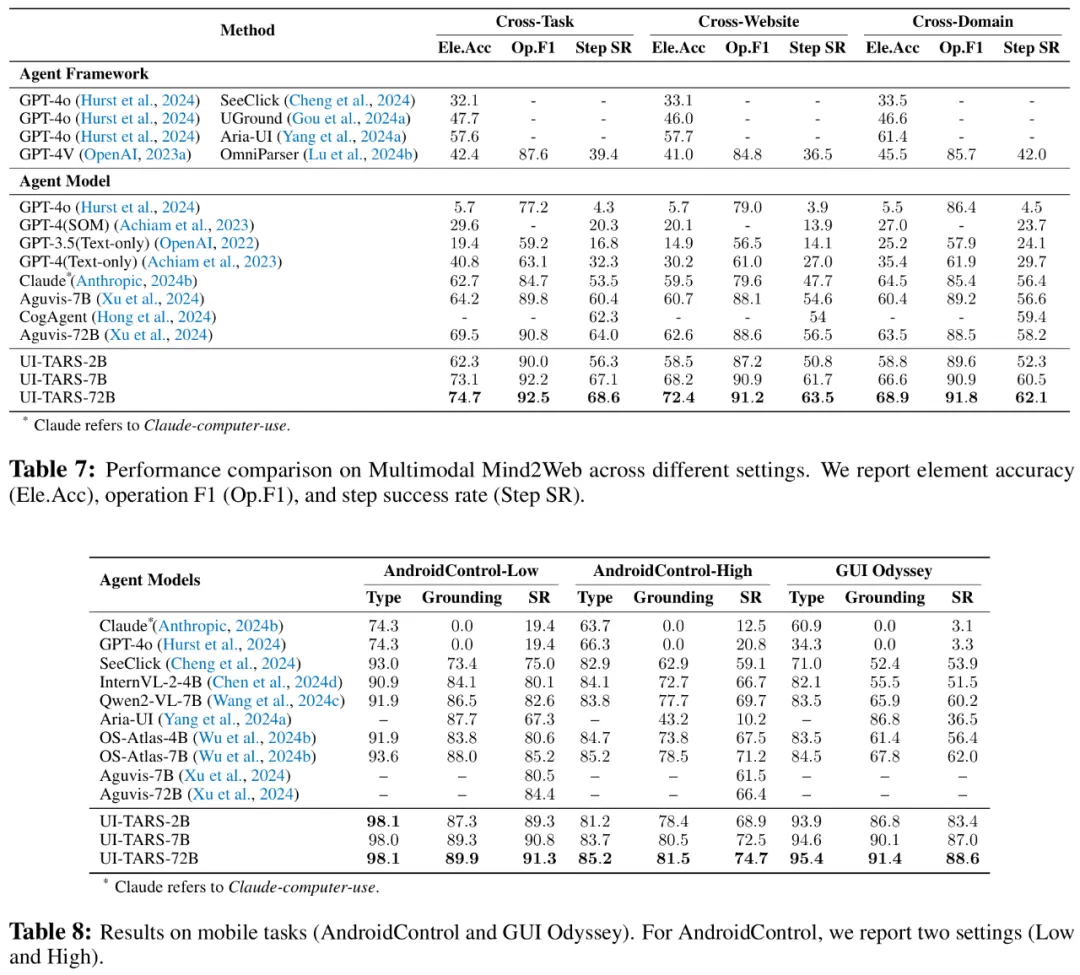

除了在線動態環境中實現能力新 SOTA 之外,UI-TARS 同樣在 Multimodal Mind2Web(用于創建和評估執行語言指令的 web 智能體)以及 Android Control(評估移動端環境中的規劃和動作執行能力)、GUI Odyssey(專注于移動端環境中跨應用導航任務)等三個離線靜態、預定義環境相關的基準測試中表現領先。

更進一步,UI-TARS 的智能體系統是端到端的,這被認為是智能體 AI 的下一個方向。

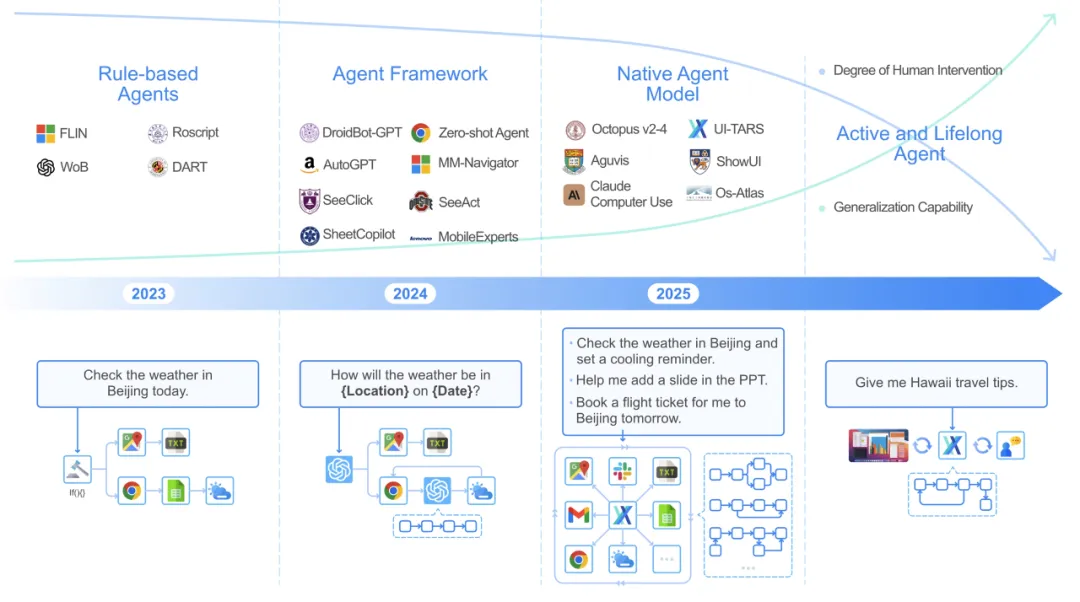

自 GPT-4 出現后,智能體成為了 AI 領域研究的熱門領域,最近又經歷了一次范式革新。首先是智能體框架(Agent Framework),其主要利用高性能基礎模型(如 GPT-4o)的理解和推理能力來增強任務的靈活性。他們實現了自動化和靈活的交互,也可以借助更多模塊不斷增強,或完成多智能體協作,但它仍然依賴人為定義的工作流來構建其操作。因此,智能體框架會面臨適應性較差、模塊不兼容等問題,維護開銷較大。

在當前階段,一些研究團隊已經提出了智能體模型(Agent Model)新范式,其中任務以端到端的方式學習和執行,將感知、推理、記憶和動作統一在一個不斷發展的模型中。

這種方法從根本上實現了數據驅動,讓智能體可以無縫適應新任務、界面或用戶需求,無需依賴手動制作的提示或預定義規則,擁有強大泛化能力,也可以進行自我改進。

向人類看齊

充分利用 System 2 推理能力

在生成式 AI 技術突破后,人們希望讓人工智能實現人腦「快慢系統」的思考方式。其中「System 1」負責快速的、直覺的、無意識的匹配。當給定一個問題時,System 1 匹配相關答案并直接輸出。但這些答案缺乏推理過程,直接用習慣性的結果進行匹配。

作為對比,「System 2」相對較慢,沒有 System 1 的快速匹配過程,但它帶有更多的邏輯推理和序列推理,這是一個有意識的帶規劃、帶認知的過程。

結合兩套系統的優勢,我們就能實現更加復雜準確的推理,構建起認知智能,這也是 UI-TARS 想要實現的目標。

在技術報告中,UI-TARS 的定位是「一個原生 GUI 智能體模型,其設計目標是在不依賴繁瑣的人工設計規則或級聯模塊的情況下進行運作。」

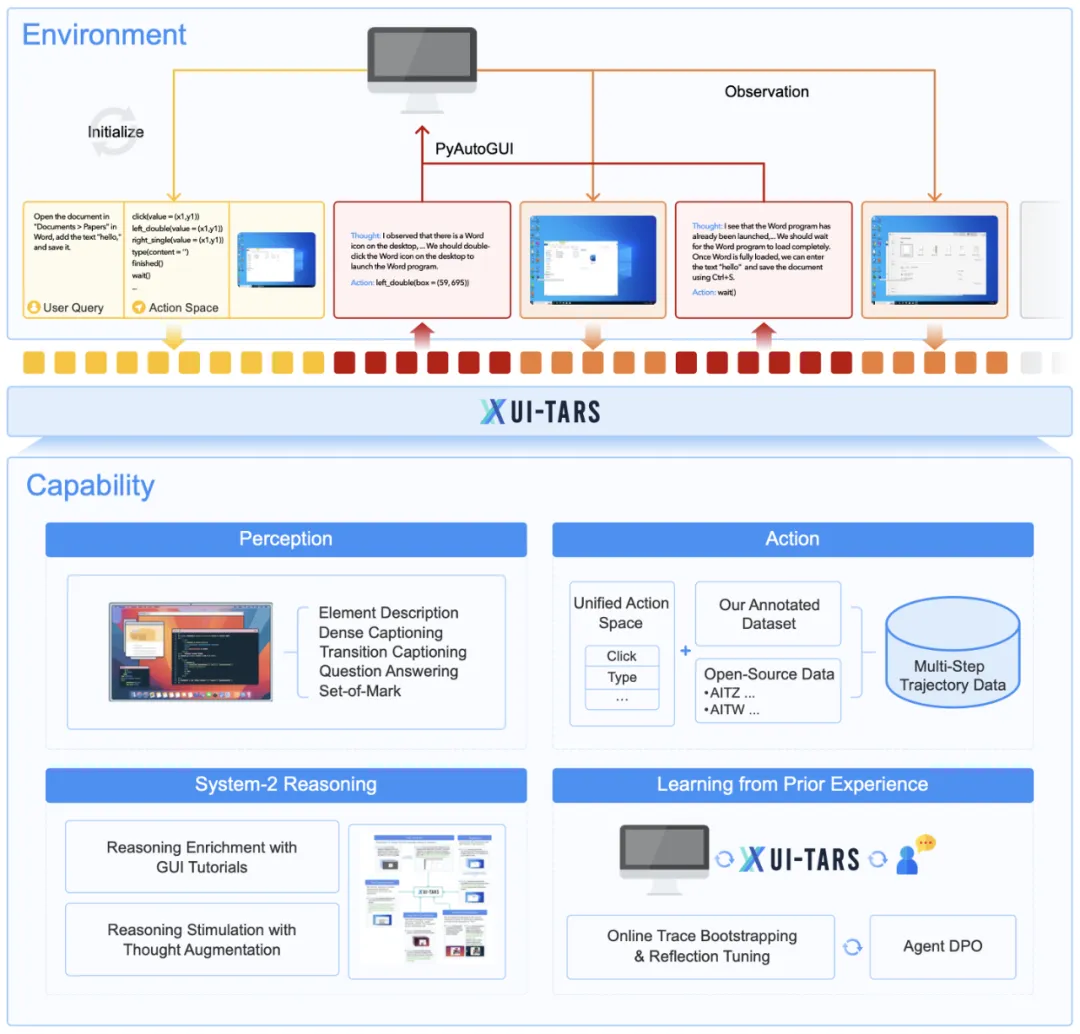

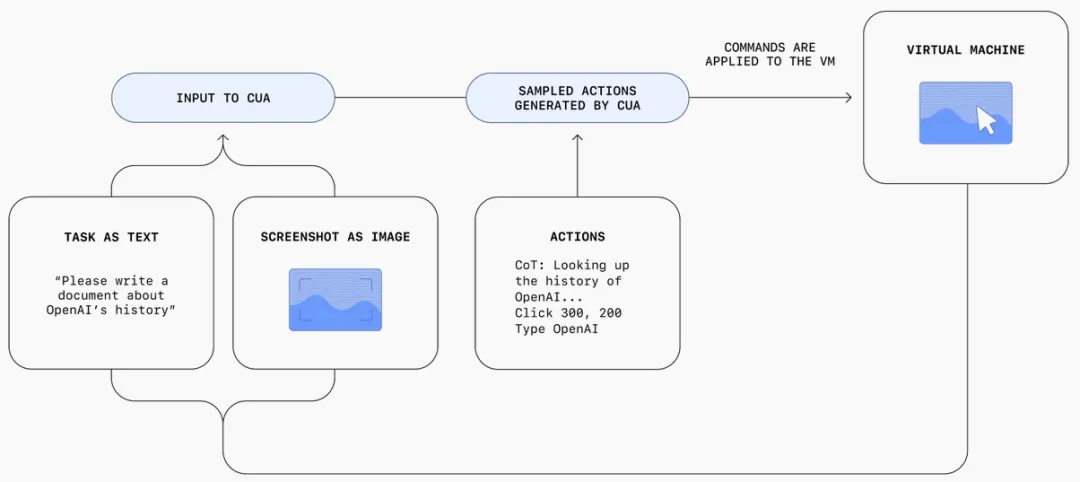

從功能上看,UI-TARS 可直接感知屏幕截圖、應用推理過程并自主生成有效操作。此外,UI-TARS 還可以學習之前的經驗,通過利用環境反饋來迭代改進其性能。下圖展示了其整體架構。

整體來說,UI-TARS 的能力都是圍繞感知、推理、動作以及經驗學習進行的。對比一下 OpenAI Operator 的架構(如下),有一定的相似之處。

具體來說,給定一個初始任務指令,為了完成任務,UI-TARS 會迭代式地接收來自設備的觀察結果并執行相應的操作。在每個時間步驟,UI-TARS 會以任務指令、先前交互的歷史和當前觀察為輸入,基于預定義的動作空間輸出動作。執行完動作之后,設備會提供后續觀察,持續迭代。

為了進一步增強智能體的推理能力,并讓決策更加深思熟慮,研究團隊還集成了一個以「思維(thoughts)」形式出現的推理組件,該組件會在每個動作之前生成。

這些「思維」能反映 System 2 思維的反思性質。它們是至關重要的中間步驟,可引導智能體在繼續之前重新考慮以前的動作和觀察,與環境細致互動,構成反思性交互,從而確保每個決定都是意圖明確的并且都是經過仔細思考的。

數據集、推理與長期記憶

UI-TARS 集成了一系列創新

了解了 UI-TARS 的技術框架,我們再繼續深入其各個層面的細節,看看這個 Computer Use 智能體的優良表現究竟來自何處。同時,這也或許能讓我們洞見一二 Operator 等其它同類智能體的設計思路。

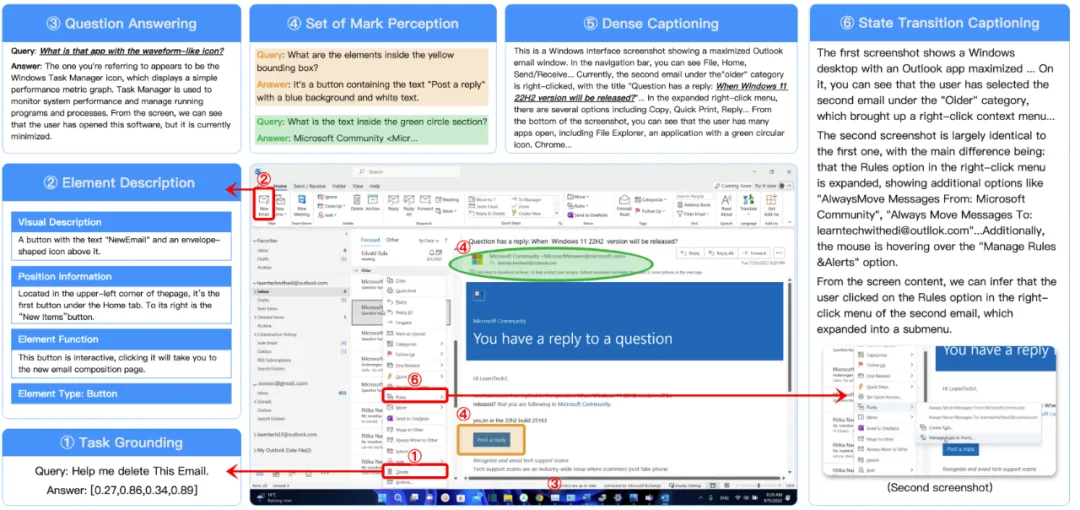

要訓練 GUI 智能體,還需要過數據這一關。字節豆包大模型團隊采用原生智能體方法,直接處理 GUI 截圖輸入,利用大規模統一數據集來提升性能。

具體實施包括:收集大規模數據集;為界面元素創建結構化描述 (類型、視覺、位置、功能);提供密集描述包括空間關系和整體布局;標注狀態轉換數據;合成多樣化問答數據集;增加 Set-of-Mark 提示,在界面上添加不同屬性的標記,幫助模型定位識別元素。

通過這些步驟,UI-TARS 能更好地理解和處理 GUI 任務。

感知與 grounding 數據樣本

研究團隊還進行了統一的動作空間建模與 grounding,在增強模型準確理解和定位視覺元素的能力的同時,讓模型學會一些連續的多步軌跡,在完成一些任務時可以不假思索地完成,類似于 System 1 思維。下表 1 給出了不同平臺的統一動作空間,而表 2 則展示了 grounding 與多步動作軌跡數據的基本統計信息。

那么,UI-TARS 是如何將 System 2 推理能力整合進來的呢?

具體來說,該團隊采用的做法是首先使用 GUI 教程來增強模型的推理能力 —— 他們為此編排了一個 6M 規模的高質量 GUI 教程,平均每個教程包含 510 個文本 token 與 3.3 張圖像。

然后,再使用思維增強來進行推理模擬,也就是通過標注「思維」來填補感知與動作之間的空白,從而增強前面提到的動作軌跡數據。這些思維使模型能夠顯式地表示其決策過程,從而更好地與任務目標對齊。

整體來看,UI-TARS 和 Operator 在短程推理上表現類似,但 Operator 在長程推理方面目前仍有優勢。這也預示著目前學術界已經具有了基礎的 Agent Model,而 Agent test-time scaling 是下一步需要升級的方向。

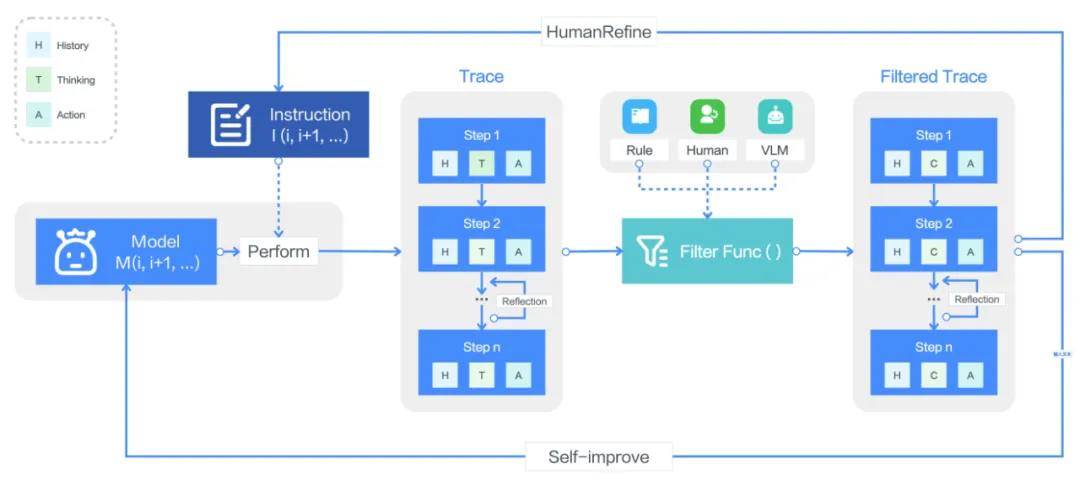

有了推理能力后,該團隊還讓 UI-TARS 具備了可從長期記憶學習之前的經驗的能力。這樣一來,這個智能體就能在使用之中不斷迭代進步了。這主要涉及三個過程,即在線軌跡 bootstrapping、反思微調、Agent DPO。

在線軌跡 bootstrapping 的過程如下圖所示,簡單來說先讓智能體在目標 GUI 環境內基于指令生成一些原始軌跡,再對其進行過濾,得到高質量數據。然后利用結果軌跡來實現自我提升。

反思微調則是讓模型看到自己犯下的真實世界錯誤與其糾正方案,從而讓模型學會從次優決策中恢復。

Agent DPO 可通過直接編碼對正確動作的偏好(而非錯誤動作)來優化 UI-TARS,從而更好地利用可用數據。

總之,通過這些技術創新,UI-TARS 擁有了強大的完成復雜任務的能力。

智能體 AI 的時代

已經開啟

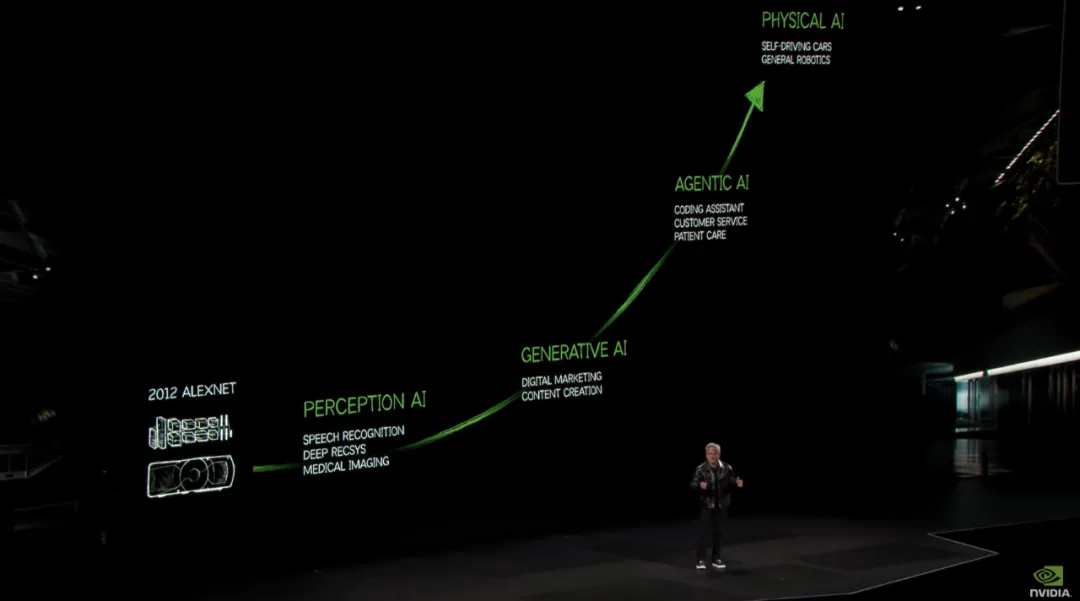

今年一開年,英偉達創始人、CEO 黃仁勛在 CES 展會開幕 Keynote 上就定了個調:2025 年是智能體 AI 的時代。

如果說基礎模型構建起的生成式 AI 可以為我們輸出有用的信息,能「看」會「用」、會自我糾錯的智能體則可以做到更加主動,在大模型智能之上幫助我們高效完成各種任務。

正如 OpenAI 創始成員、特斯拉前 AI 高級總監 Andrej Karpathy 所說,在 AI 智能體技術逐漸成熟、通用化之后,我們可以成為自動化系統的管理人,就像駕駛者監督自動駕駛一樣 —— 不過在數字世界里,AI 施展拳腳的機會要更多,應用速度也會更快。

最近國內外公司的技術進展,可以說為智能體 AI 時代開了個好頭。今天,智能體可以幫你訂外賣、搶票、肝游戲;明天,由智能體組成的小組可以來幫你來完成更加長期而復雜的任務,直到一個業務體系,人人都能成為智能體的 CEO。

- UI-TARS 論文:https://arxiv.org/pdf/2501.12326

- 開源地址:https://github.com/bytedance/UI-TARS