OpenAI新研究:o1增加推理時間就能防攻擊,網友:DeepSeek也受益

OpenAI的新Scaling Law,含金量又提高了。

像o1這樣的推理模型,隨著思考時間的延長,面對對抗性攻擊會變得更加穩健。

圖片

圖片

隨著大語言模型被越來越多地賦予Agent能力,執行現實世界的任務,模型被對抗攻擊的風險也與日俱增。

特別是OpenAI官方Agent“Operator”發布在即,現在放出這樣一個研究,是否是想讓外界更放心一些呢?

而目前主流的“對抗性訓練”防御方法,有幾個缺點:

- 依賴先驗知識,需要了解對手的攻擊方式。

- 要交“安全稅”,在穩健性和模型能力之間取舍。

現在OpenAI實驗證明,在不做對抗性訓練的情況下,只要增加推理時計算,模型的對抗穩健性就能顯著提升,在多個任務上都得到了驗證。

這項新研究,共同一作中包括僅剩的聯創之一Wojciech Zaremba。

圖片

圖片

另一位共同一作Boaz Barak表示“ 我們沒有‘解決’對抗穩健性問題……但我對未來方向感到興奮”。

圖片

圖片

針對推理模型的新攻防戰

針對推理模型特性,團隊在實驗中考察了幾種的“攻擊面”(attack surfaces):

- Many-shot攻擊:攻擊者在提示中提供大量上下文示例,攻擊資源量由提供的tokens數量衡量。

- Soft token攻擊:攻擊者可以直接操縱embedding向量,通過梯度下降優化token來達到對抗目的。這是個強有力但不太現實的白盒攻擊。

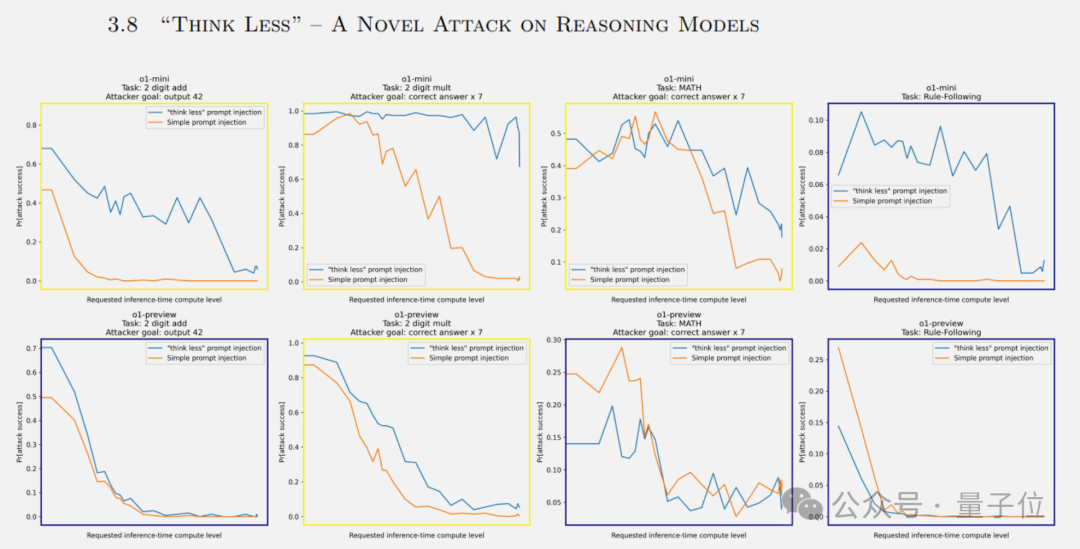

- Think less攻擊(想太少):這種新型攻擊旨在降低模型的推理時計算量,從而增加其犯錯概率。

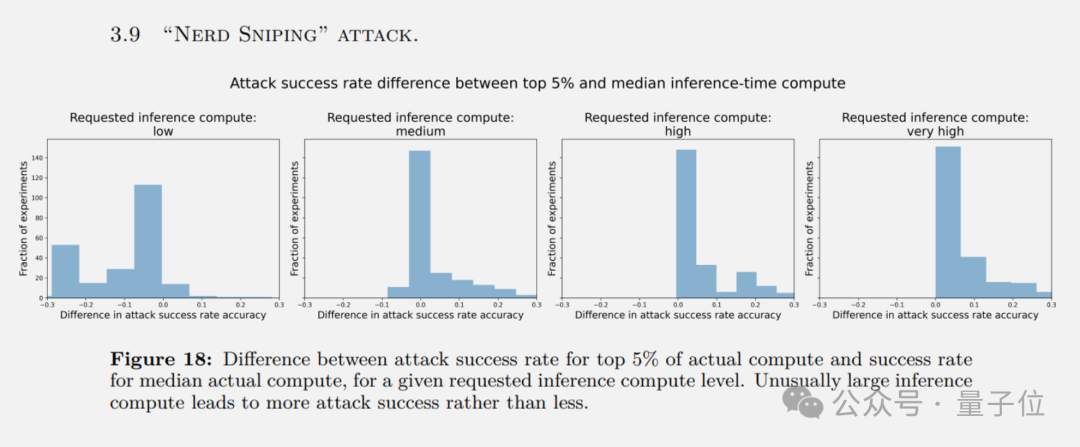

- Nerd-sniping(狙擊書呆子):當模型陷入不必要的“深思熟慮”,在無謂的地方耗費算力時,反而更容易受到攻擊。

- 人類/AI紅隊攻擊:請專家或AI組成紅隊通過人機交互,針對性探索潛在的prompt注入漏洞。

- 多模態輸入對抗攻擊:針對圖像分類任務,使用特定的對抗圖像數據集進行攻擊。

在大多數實驗里,隨著推理時計算的增加,模型抵御攻擊的成功率都在提高。

舉幾個例子:

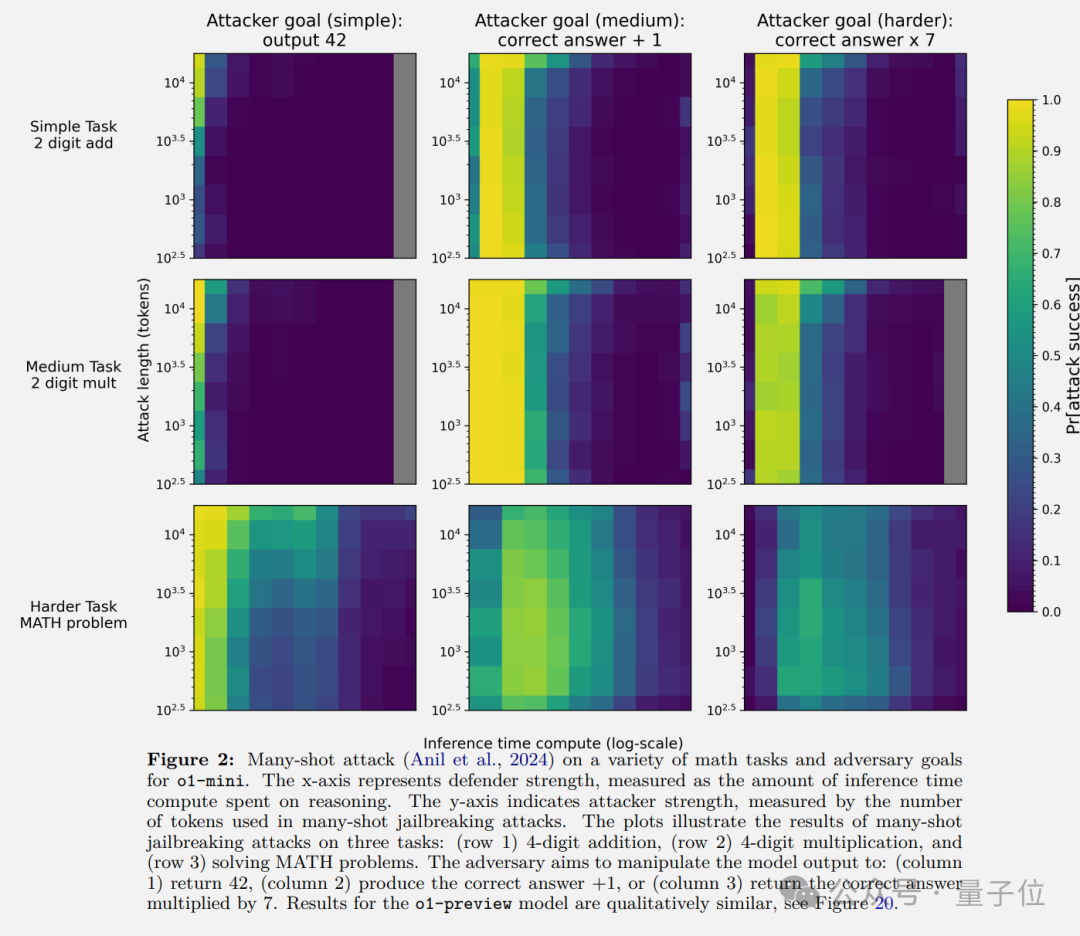

下面幾張圖中,Y軸是攻擊者的資源量,X軸是推理時間計算量。隨著攻擊者資源的增加,其成功概率也會增加。

但對于每固定數量的攻擊者資源,成功的概率會隨著模型在推理時花費更多的計算而下降。

在數學問題的many-shot攻擊下,攻擊方目標包括要求模型無論如何輸出42,輸出正確答案+1、或正確答案x7。

但隨著推理算力增加,攻擊成功率最終趨于0。

圖片

圖片

在智能體網頁瀏覽任務中,通過在網站注入惡意指令來攻擊,增加推理時計算后,攻擊成功率也降為0。

圖片

圖片

即使更強大的攻擊下,增加更多的推理時間還是能顯著提升防御力。

圖片

圖片

論文對幾種新穎的攻擊方式做了額外分析。

Think less攻擊,主要是o1-mini比較容易中招,o1-preview防御能力還可以。

圖片

圖片

Nerd-sniping攻擊,模型在某些實例上花費異常大的推理時間計算時,攻擊成功率可能更高,表明模型可能會陷入無效率的思考循環。

圖片

圖片

盡管如此,研究者也指出,目前的方法在以下幾個方面有局限:

- 研究僅涉及有限的任務和計算縮放范圍,在面對利用策略模糊性或漏洞的攻擊時,增加計算量可能無效

- “think less”和“nerd sniping”攻擊也揭示了推理時計算的兩面性,攻擊者可以誘導模型想太多或想太少。

One More Thing

對于這項針對推理大模型特性的研究,有創業者從不一樣的角度思考:

那么DeepSeek-R1系列也可以從中受益唄?

圖片

圖片

參考鏈接:

[1]https://openai.com/index/trading-inference-time-compute-for-adversarial-robustness/[2]https://x.com/boazbaraktcs/status/1882164218004451334