追平滿血版o1的國產多模態模型終于來了!訓練細節全部公開

春節前最后一周,能媲美 Open AI 滿血版 o1(Full Version,而非 preview)的模型終于出現了!

剛剛(),月之暗面公布了他們的 Kimi k 系列模型最新版本 ——k1.5 多模態思考模型。新模型在數學、代碼、多模態推理能力等方面全面對標 Open AI 滿血版 o1,而且是 OpenAI 之外首個多模態 o1。尤其是 kimi-k1.5-short,成為 SOTA short cot 模型,并大幅領先 GPT-4o 和 Claude 3.5 Sonnet(提升幅度高達 550%)。

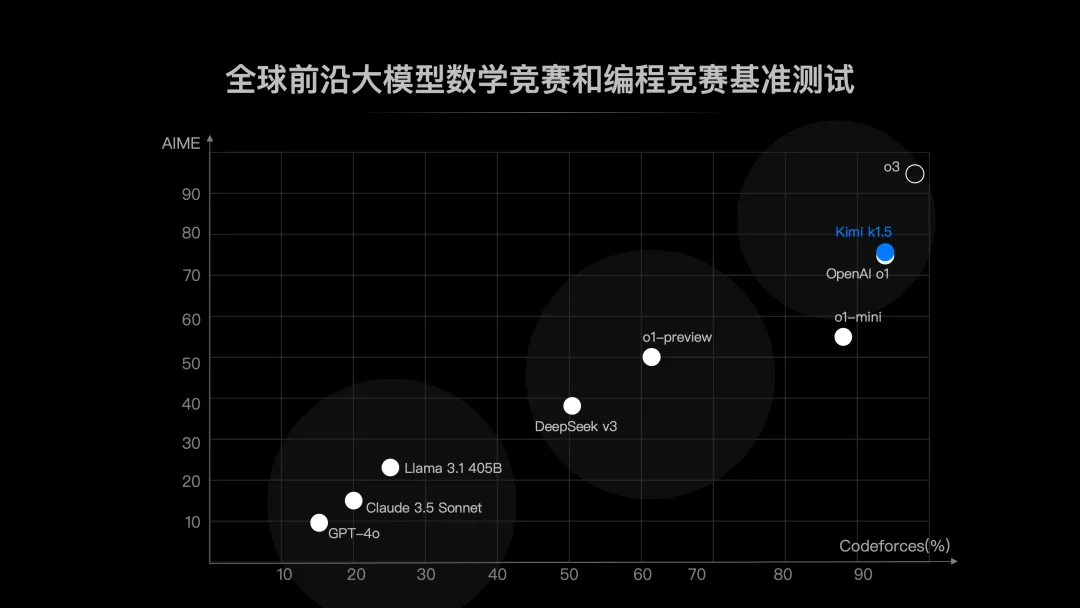

這是 Open AI 之外,首次有模型在數學和代碼能力上達到滿血 o1,月之暗面也是國內第一個達到該水平的 AI 公司。在此之前,部分模型在各類 Benchmark 上可以達到 50 分、60 分的水平(相當于 o1-preview),而 o1 滿血版是 80 分、90 分水平,Kimi k1.5 的成績令人眼前一亮。

這一切是怎么做到的呢?在 Kimi 技術團隊同步發布的技術報告中,我們可以看到他們在新技術范式下的模型訓練技術探索之路。

- 技術報告:Kimi k1.5:借助大語言模型實現強化學習的 Scaling

- 報告鏈接:https://github.com/MoonshotAI/kimi-k1.5

這種技術透明度在當前競爭激烈的大模型市場上并不多見。在談及為什么要這么做時,月之暗面表示,「因為我們意識到,AGI 之旅才剛剛開始。我們想讓更多技術人才了解我們在做的事情,加入我們一起做到更多」。

Kimi k1.5 多項測試,全部 SOTA

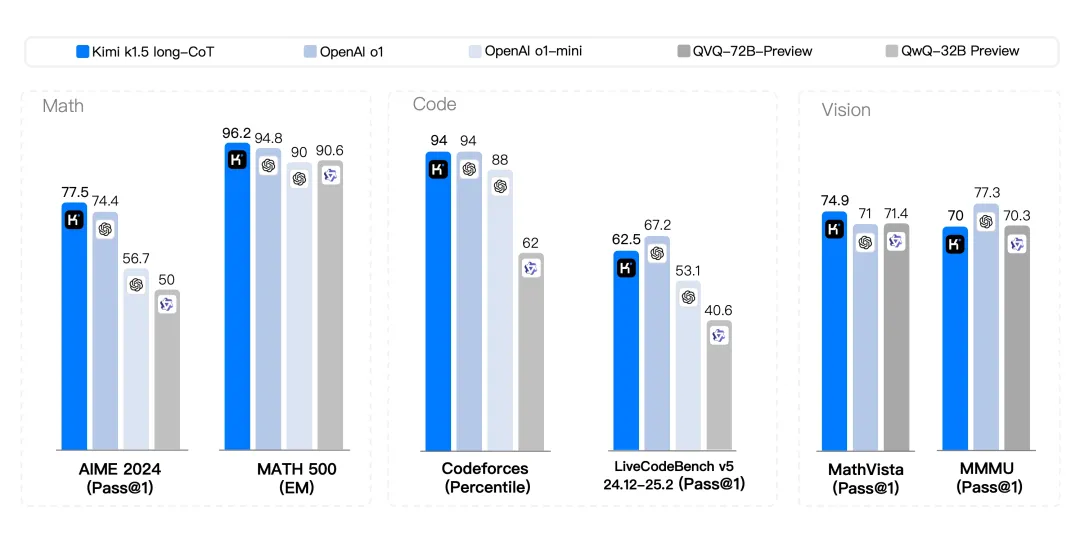

從技術報告來看,Kimi k1.5 多模態推理模型實現了 SOTA (state-of-the-art)級別的推理和通用能力,具體而言:

在 long-CoT 模式下,Kimi k1.5 在數學、代碼及多模態推理能力上,達到長思考 SOTA 模型 OpenAI o1 正式版的水平。Kimi k1.5 在 AIME 上達到 77.5 分,在 MATH 500 上達到 96.2 分,在 Codeforces 上達到 94 百分位,在 MathVista 上達到 74.9 分。

這應該是全球范圍內,OpenAI 之外的公司首次實現 o1 滿血版性能。此前的模型只能達到 o1-preview 或 o1-mini 的推理能力。

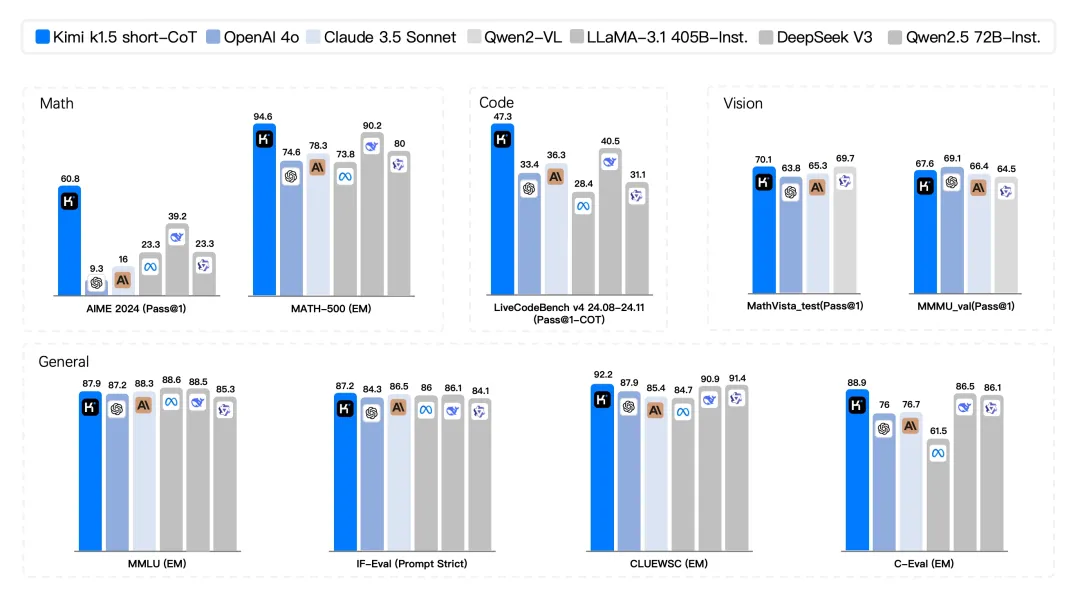

在 short-CoT 模式下,Kimi k1.5 在數學、代碼、視覺多模態和通用能力上,也達到了全球范圍內短思考 SOTA 模型 ,并大幅領先 GPT-4o 和 Claude 3.5 Sonnet 的水平。比如,Kimi k1.5 在 AIME 上達到 60.8 分,MATH500 上達到 94.6 分,LiveCodeBench 上達到 47.3 分。

不僅如此,從全球前沿大模型數學競賽和編程競賽基準測試來看,Kimi k1.5 的表現也相當不錯,處于全球第一梯隊,而這兩項測試代表了人類智商巔峰。

總之,從 Benchmark 數據來看,k1.5 的推理能力實現了很大提升,可以幫助我們解鎖更難的代碼、數學、生活等問題。

Kimi k1.5 是怎么練成的?

隨著模型尺寸逐漸增大,預訓練階段參數 scaling up 帶來的邊際收益開始遞減,如果想要深度提升模型推理能力和長程問題能力,基于強化學習的 Post-Training 將會成為下一個突破點 [1],因為 scaling 強化學習為人工智能的持續進步開辟了新的維度,它使得大語言模型能夠通過帶有獎勵的探索學習來擴展其訓練數據,從而也實現計算規模的擴展。

大的方向非常明確,然而,此前發表的研究工作尚未產生具有競爭力的結果。

有鑒于此,Kimi 技術團隊在 Kimi k1.5 的訓練實踐中全面探索了 RL 訓練技術、多模態數據配方和基礎設施優化。

難得的是,他們探索出的 RL 框架簡單、有效,無需依賴蒙特卡洛樹搜索、價值函數和過程獎勵模型等更復雜的技術也能取得優異的性能。

此外,他們還提出了有效的 long2short 技術,利用 Long-CoT 技術來改進 Short-CoT 模型,使得模型在短鏈思維推理方面取得了最佳成果。

簡單、有效的 RL 框架

Kimi 技術團隊設計的簡單而有效的 RL 框架離不開兩個關鍵要素:長上下文 scaling 和改進的策略優化。

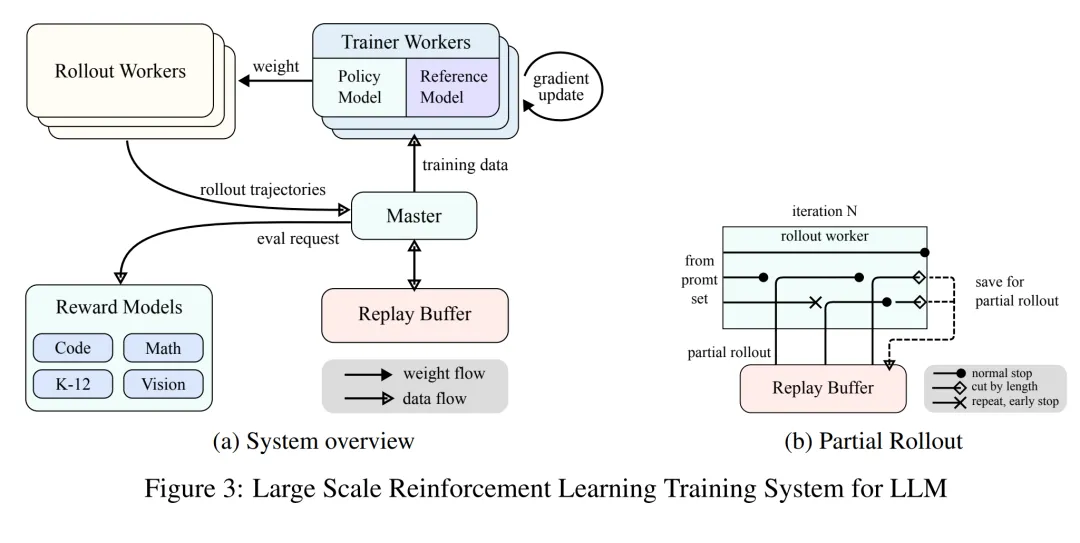

先說長上下文 scaling。他們將強化學習的上下文窗口 scale 到 128k,并觀察到隨著上下文長度的增加,模型性能持續改善。新方法背后的一個關鍵理念是使用 partial rollout 來提高訓練效率 —— 即通過重用大量以前的軌跡來采樣新的軌跡,避免從頭重新生成新軌跡的成本。技術團隊的觀察表明,上下文長度是大語言模型強化學習持續 scaling 的一個關鍵維度。

再來看策略優化的改進。他們推導出了一個具有 long-CoT 的強化學習公式,并采用在線鏡像下降法的變體來實現穩健的策略優化。通過有效的采樣策略、長度懲罰和數據配方的優化,他們進一步改進了該算法。

通過將這兩個關鍵要素結合,Kimi 技術團隊建立了一個用于 LLM 學習的簡化強化學習框架。由于該框架能夠 scale 上下文長度,學習到的 CoT 展現出規劃、反思和糾正的特性。增加的上下文長度具有增加搜索步驟數量的效果。因此,他們表明無需依賴蒙特卡洛樹搜索、價值函數和過程獎勵模型等更復雜的技術也能實現強大的性能。

此外,他們的模型還在文本和視覺數據上進行了聯合訓練,具備對這兩種模態進行聯合推理的能力。

long2short 技術

盡管 long-CoT 模型在性能上表現出色,但與標準的 short-CoT LLM 相比,它在測試時消耗的 token 數量更多。然而,Kimi 技術團隊發現將 long-CoT 模型的思維先驗遷移到 short-CoT 模型中是可能的,從而在有限的測試 token 預算下提升性能。

他們提出了幾種解決這一 long2short 問題的方法,包括模型融合、最短拒絕采樣、DPO 以及 long2short RL。以下是這些方法的詳細描述:

- 模型融合。團隊人員發現模型融合(Model Merging)有助于保持模型的泛化能力。他們還發現,在融合 long-CoT 模型和 short-CoT 模型時,模型融合也能有效提升 token 效率。這種方法通過將 long-CoT 模型與 short-CoT 模型結合,從而在不進行訓練的情況下獲得一個新模型。具體來說,他們通過簡單地平均兩個模型的權重來實現融合。

- 最短拒絕采樣。研究者觀察到,模型在回答相同問題時生成的響應長度存在較大差異。基于此,他們設計了最短拒絕采樣(Shortest Rejection Sampling)方法。該方法對同一個問題采樣 n 次(實驗中,n=8),并選擇最短的正確響應進行監督微調。

- DPO。與最短拒絕采樣類似,團隊人員利用 Long CoT 模型生成多個響應樣本。并選擇最短的正確解決方案作為正樣本,而較長的響應則被視為負樣本,包括錯誤的較長響應和正確的較長響應。這些正負樣本對構成了用于 DPO 訓練的成對偏好數據。

- Long2short RL。在標準的 RL 訓練階段之后,團隊人員選擇一個在性能和 token 效率之間達到最佳平衡的模型作為基礎模型,并進行單獨的 long2short RL 訓練階段。在這個第二階段中,他們還應用了長度懲罰機制,從而顯著減少最大 rollout 長度,以進一步懲罰那些超出期望長度但可能正確的響應。

除了以上這些,Kimi k1.5 的技術報告還透露了很多信息。感興趣的讀者可以去閱讀原文。

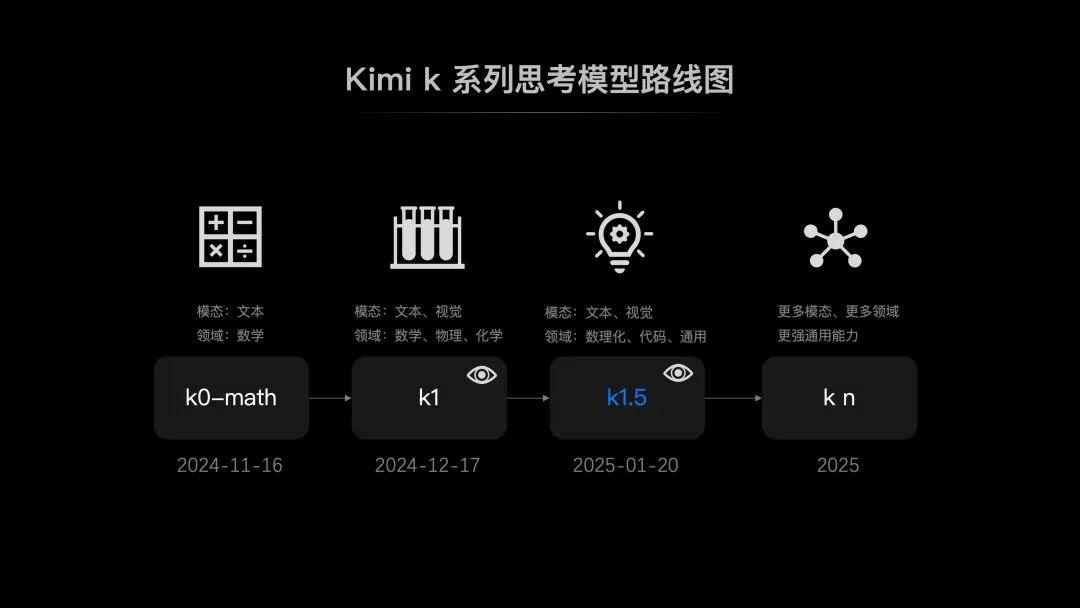

2025:加速升級 k 系列強化學習模型

OpenAI 于 2024 年 5 月、9 月推出的 GPT-4o、o1 兩個模型,分別代表了多模態理解、強化學習兩條技術路線。在這兩條路線上,國內 AI 公司都在陸續發力,并在最近展開了激烈競爭。如今,Kimi 模型在能力上最接近 o1,這讓外界對這家公司在 2025 年的表現充滿了期待。

月之暗面表示,2025 年,他們會繼續加速升級 k 系列強化學習模型,帶來更多模態、更多領域的能力和更強的通用能力。

我們也期待新模型的早日上線!