o1也會「想太多」?騰訊AI Lab與上海交大揭秘o1模型過度思考問題

本文的共同通訊作者為涂兆鵬和王瑞,涂兆鵬為騰訊專家研究員,研究方向為深度學(xué)習(xí)和大模型,在國際頂級期刊和會議上發(fā)表學(xué)術(shù)論文一百余篇,引用超過9000次。擔(dān)任SCI期刊NeuroComputing副主編,多次擔(dān)任ACL、EMNLP、ICLR等國際頂級會議領(lǐng)域主席。王瑞為上海交通大學(xué)副教授,研究方向為計算語言學(xué)。共同第一作者為上海交通大學(xué)博士生陳星宇、何志威,騰訊AI Lab高級研究員徐嘉豪、梁添。

本文將介紹首個關(guān)于 o1 類長思維鏈模型過度思考現(xiàn)象。該工作由騰訊 AI Lab 與上海交通大學(xué)團隊共同完成。

- 論文題目:Do NOT Think That Much for 2+3=? On the Overthinking of o1-Like LLMs

- 論文地址:https://arxiv.org/pdf/2412.21187

背景與動機

自 OpenAI 發(fā)布 o1 模型以來,它超強的邏輯推理以及難題解決能力就引發(fā)了廣泛關(guān)注。o1 模型通過模擬人類的深度思考過程,在思維鏈中運用如自我反思、糾錯以及探索多種解法等推理策略,展現(xiàn)了強大的長時間推理(Inference-Time Scaling)性能。依靠這種機制,o1 模型能夠不斷優(yōu)化自身的答案質(zhì)量。然而,在 o1 成功的光環(huán)下,一個潛在問題逐漸被放大 —— 過度思考。

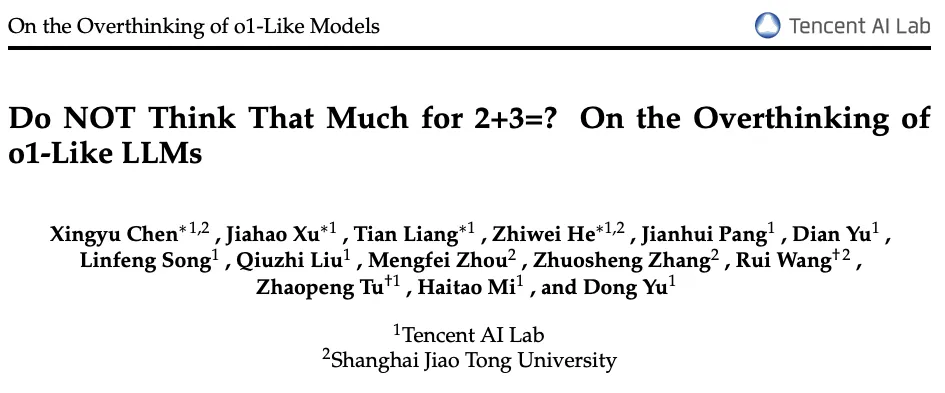

隨著 o1 模型的問世,許多類似的模型也陸續(xù)出現(xiàn),比如 Qwen 團隊開源的 QwQ-32B-Preview [1] 以及 Deepseek 推出的 R1-Preview [2] 模型。這些模型在推理時同樣具備 “深度思考” 的特性,但也暴露出了類似的問題:在不必要的情況下生成過長的思維鏈反而浪費了計算資源。舉一個簡單的例子,對于問題 “2+3=?”,不同模型的回答長度如下圖所示:

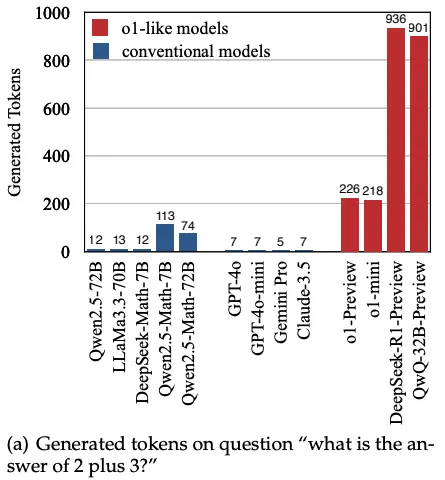

傳統(tǒng)模型的回答通常只需要極少的 token 就能給出答案,然而對于 o1 模型,其消耗的推理 token 直接達到了 200 以上。更極端的是,Deepseek-R1-Preview 和 QwQ-32B-Preview 的 token 消耗甚至達到了 900!為什么 QwQ 模型會產(chǎn)生如此之長的輸出?研究團隊進一步分析了 QwQ 對這個問題的答案,結(jié)果見下圖右欄:

QwQ-32B-Preview 模型會在推理過程中嘗試多種不同的解題策略。對于簡單的加法問題,模型探索了直接使用數(shù)學(xué)計算、數(shù)軸移動模擬,以及類比數(shù)蘋果等方法,經(jīng)歷了多輪推理后才最終確定結(jié)果。盡管這種思維鏈策略對于復(fù)雜問題的解答非常有幫助,但在應(yīng)對簡單問題時,反復(fù)驗證已有的答案和進行過于寬泛的探索顯然是一種計算資源的浪費。為了更好地研究這個問題,研究團隊對這類 o1 模型的過度思考現(xiàn)象進行了更細致的定義和深入分析。

過度思考現(xiàn)象

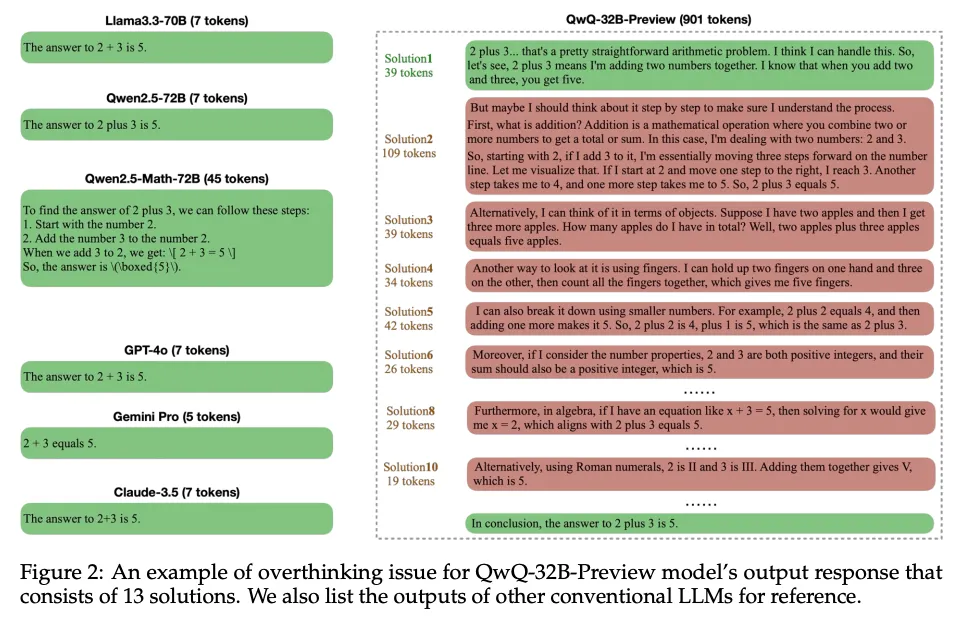

文章首先定義了模型回復(fù)中的獨立解答(Solution):每當模型完整地得到一次對輸入問題的答案(無論對錯),這就被認為是一個獨立解答。如例子所示,每一個解答都包含了答案 “5”。基于這個定義,研究人員在三個不同的數(shù)據(jù)集上統(tǒng)計了 Qwen-QwQ-32B-Preview 模型和 Deepseek-R1-Preview 模型的解答數(shù)量分布(解答的判斷和抽取由 Llama-3.3-70B 模型完成):

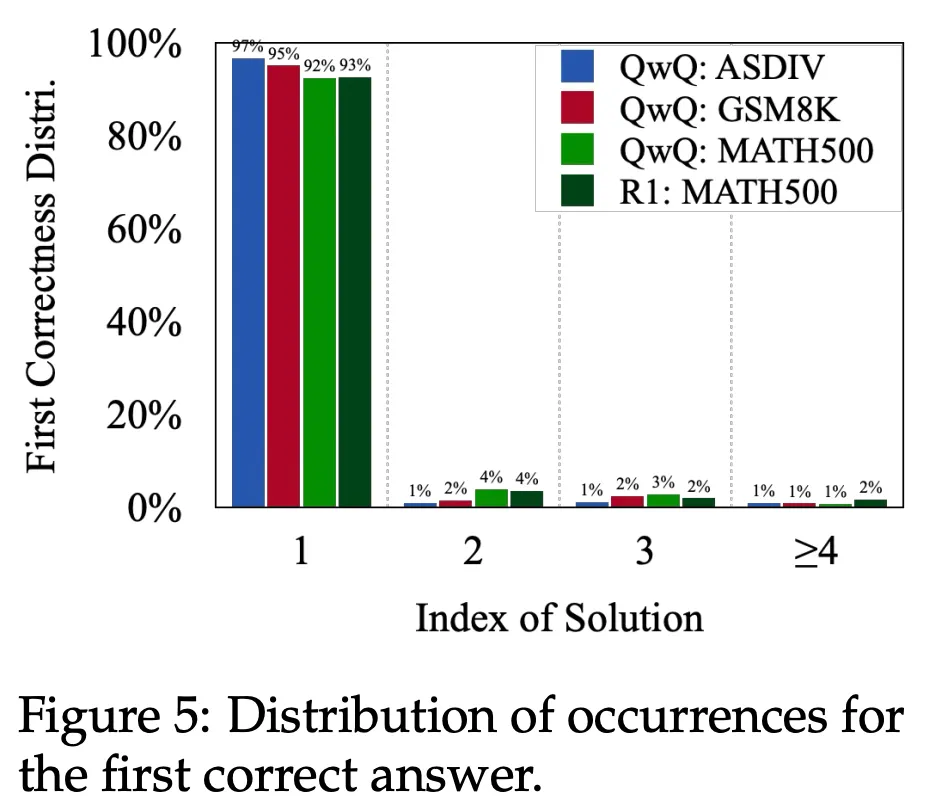

其中,ASDIV [3] 是一個包含小學(xué)難度數(shù)學(xué)題的測試集,GSM8K [4] 是常用的初級難度數(shù)學(xué)題測試集,MATH500 [5] 是高中數(shù)學(xué)競賽難度的測試集。如圖所示,無論是對于 QwQ 模型還是 R1 模型,包含 2-4 個解答的樣本占了所有樣本的 70% 以上,可見這種 Solution-Level 的反思行為在當前的類 o1 模型中十分普遍。那么這些解答本身是否都是必須的呢?下圖展示了在不同數(shù)據(jù)集上,模型首次得到正確答案的解答位置:

令人驚訝的是,對 QwQ 模型和 R1 模型的實驗分析顯示,它們在超 90% 的情況下,都能在第一次嘗試中就成功輸出正確答案。也就是說,后續(xù)多輪思考對答案正確率的提升幾乎沒有實質(zhì)性貢獻。這一現(xiàn)象進一步驗證了此前對模型過度思考的觀察:絕大多數(shù)情況下,模型的多輪反思可能只是在反復(fù)驗證已有的答案,從而造成了資源浪費。

然而,這種現(xiàn)象也引發(fā)了不同觀點的爭論。一些研究者認為,o1 類模型的一個核心特性在于其能夠自主探索問題的不同解法。從這一角度來看,如果模型在推理過程中使用了多種不同的思路來解決問題,那么這種多樣化的探索不僅有助于加深模型對問題的理解,還體現(xiàn)了模型的自主探索能力,不應(yīng)簡單地視為 “過度思考”。為了更深入地剖析這一問題,研究團隊進一步提出了一種分析方法。他們利用 GPT-4o 對模型的回答進行分類,具體包括以下步驟:

- 推理策略分類:對每一個解答進行推理策略的標注,將采用相同推理方式的回答歸為同一類。例如,對于 “2+3=?” 這樣的問題,可能涉及的推理策略包括數(shù)學(xué)運算模擬、數(shù)軸移動和實物類比等。

- 多樣性分析:在歸類的基礎(chǔ)上,分析并統(tǒng)計不同解答之間的推理策略多樣性。

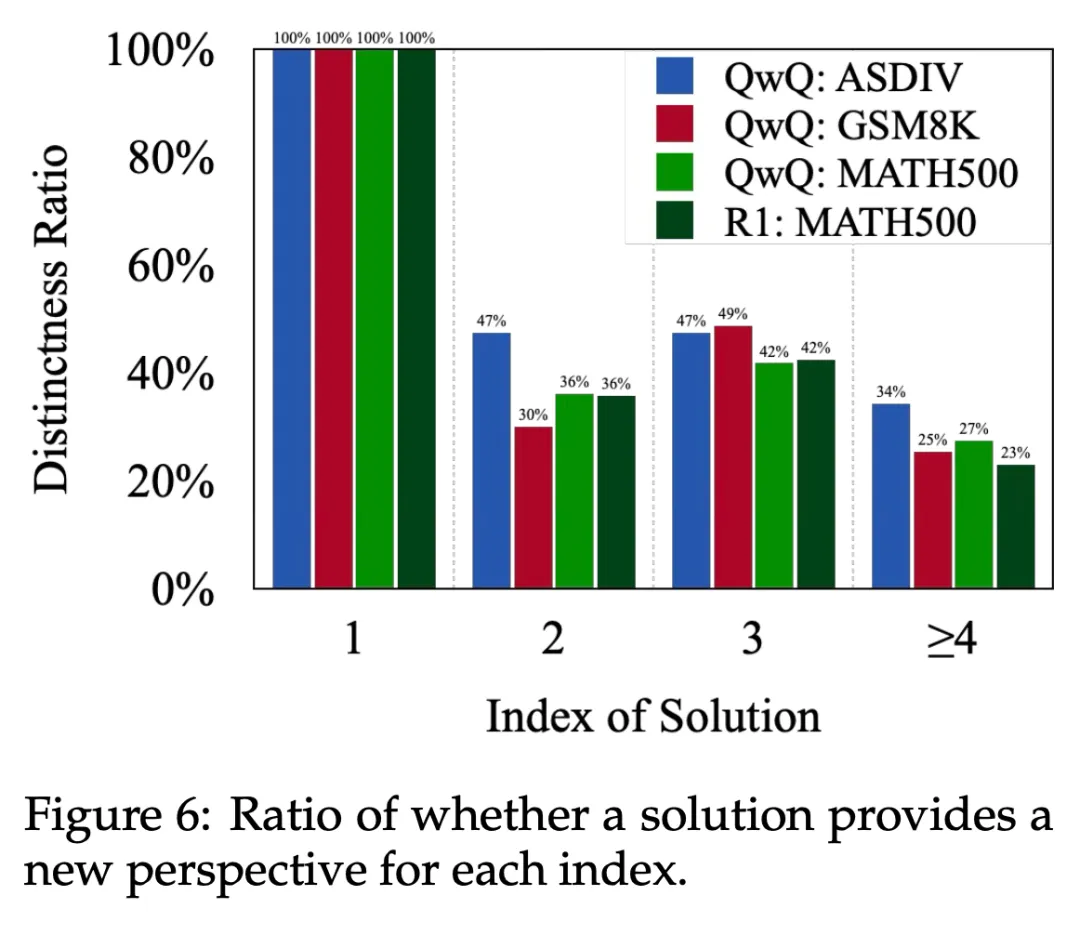

通過這一方法,研究者能夠量化推理過程中是否存在真正意義上的 “多樣化探索”。這種分析為我們提供了衡量模型行為的一種新視角:當模型的不同解答策略高度相似甚至重復(fù)時,可以說明多輪推理的貢獻是有限的;而當推理策略的多樣性伴隨著思考層次的提升而增加時,則反映了模型對問題理解的進一步加深。這種視角能夠幫助我們更準確地區(qū)分 “有效的自主探索” 和 “低效的重復(fù)推理”。如下圖所示:

圖中展示了每個位置的解答引入新推理思路的可能性。第一個位置的解答總會是 “新的思路”,因此其概率為 100%。但隨著推理位置的后移,解答中帶來新推理思路的可能性逐漸降低。這一趨勢表明,越到后續(xù)位置,模型越傾向于重復(fù)先前的推理思路,從而導(dǎo)致其推理行為變得冗余且低效。從這個角度來看,模型的后續(xù)解答更多是一種無效的重復(fù)思考。

通過上述分析,我們可以發(fā)現(xiàn)這些過度思考所產(chǎn)生的解答往往具備以下兩個關(guān)鍵特征:

- 新解答對答案的正確性沒有貢獻:模型往往在一開始就已經(jīng)成功得出正確答案,后續(xù)的多輪反復(fù)檢驗是多余且不必要的。

- 新解答未能引入實質(zhì)性新思路:模型后續(xù)的解答僅以不同的表述方式重復(fù)了早先已有的結(jié)論,而沒有真正擴展推理的深度或視角。

過度思考指標

基于這一發(fā)現(xiàn),研究團隊進一步定義了兩個衡量模型 “過度思考” 現(xiàn)象的核心指標:

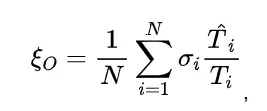

1. 產(chǎn)出效率(Outcome Efficiency):用于衡量模型回復(fù)中每一個解答對最終答案的貢獻,等于正確解答中的 token 數(shù)除以完整回復(fù)的總 token 數(shù)。計算公式為:

其中,N 為樣本數(shù), 為模型第 i 個樣本的回復(fù)中第一個正確解答的 token 數(shù)目,

為模型第 i 個樣本的回復(fù)中第一個正確解答的 token 數(shù)目, 為第i個樣本的整個回復(fù)的 token 數(shù)量,

為第i個樣本的整個回復(fù)的 token 數(shù)量, 代表第i個樣本是否正確。直觀地看,一個模型得到正確解答之后進行反思的輪數(shù)越少,正確解答在整個回復(fù)中的占比就越大,產(chǎn)出效率就越高。

代表第i個樣本是否正確。直觀地看,一個模型得到正確解答之后進行反思的輪數(shù)越少,正確解答在整個回復(fù)中的占比就越大,產(chǎn)出效率就越高。

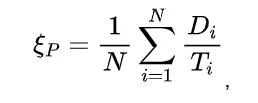

2. 過程效率(Process Efficiency):用于衡量模型回復(fù)中每一個解答對推理策略多樣性的貢獻,等于回復(fù)中屬于不同思路的總 token 數(shù)目除以整個回復(fù)的 token 數(shù)目,計算公式為:

其中 N 為樣本數(shù), 為第i個樣本的整個回復(fù) token 數(shù)量,

為第i個樣本的整個回復(fù) token 數(shù)量, 為第i個樣本中所有屬于不同推理策略的 token 總數(shù)。該指標衡量的是模型進行多輪反思的有效性,回答中涉及的不同的推理策略越多,

為第i個樣本中所有屬于不同推理策略的 token 總數(shù)。該指標衡量的是模型進行多輪反思的有效性,回答中涉及的不同的推理策略越多, 就會越大,那么過程效率就會越高。

就會越大,那么過程效率就會越高。

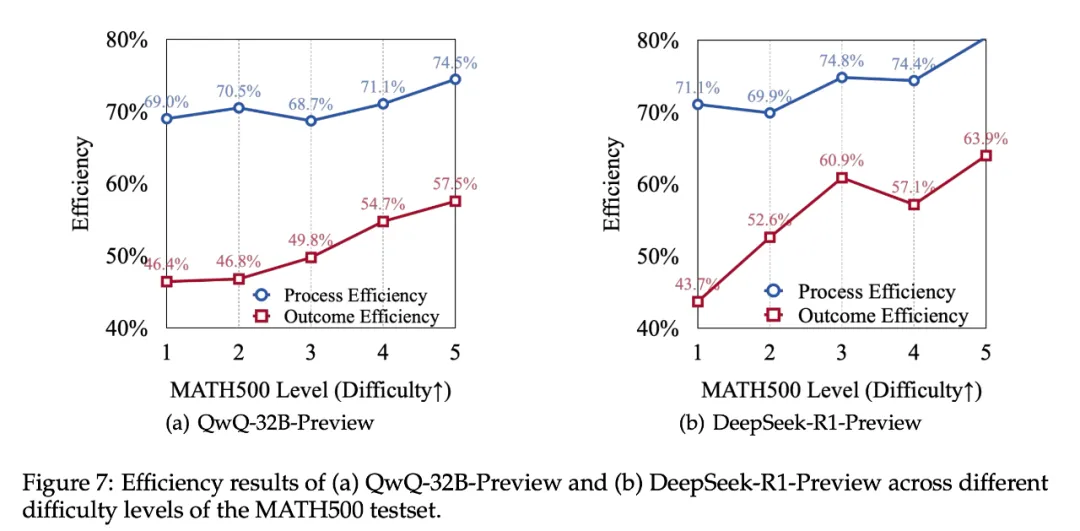

基于這兩個指標,研究者們統(tǒng)計了 QwQ 模型和 R1 模型在 MATH500 數(shù)據(jù)集上的效率指標表現(xiàn):

從圖中可以觀察到,R1 模型在效率上略優(yōu)于 QwQ 模型,但兩個模型都不同程度地暴露出 “過度思考” 的問題。對于難度最低的等級 1 問題,研究者發(fā)現(xiàn)兩個模型的表現(xiàn)都有如下特點:

- 產(chǎn)出效率不足一半:兩個模型在這種簡單任務(wù)上的產(chǎn)出效率均未超過 50%,意味著模型在取得正確答案后,依然生成了超過必要推理步驟至少一倍的額外推理內(nèi)容。這符合上文的研究發(fā)現(xiàn):正確答案通常在推理的較早階段得到,但模型的后續(xù)行為中存在大量冗余推理。

- 思考過程效率較低:模型的整體過程效率只有 70% 左右,這意味著約 30% 的思考步驟是在重復(fù)無效的推理。這種重復(fù)的行為不僅未能提升正確率,也沒有引入新的解題思路,從而造成了計算資源的浪費。

從以上分析可見,現(xiàn)有的 o1 類模型都普遍存在不同程度的 “過度思考” 現(xiàn)象,且這一問題在應(yīng)對簡單任務(wù)時尤為嚴重。這些現(xiàn)象突顯了當前 o1 類模型推理機制中的不足,也意味著在模型的長思維鏈優(yōu)化和推理資源分配方面仍有較大的改進空間。為此,研究者們提出了幾種方法,旨在緩解模型的過度思考現(xiàn)象,提升推理效率。

緩解過度思考

由于目標是減少模型的過度思考但不損害模型的推理能力,因此最直接的想法就是通過偏好優(yōu)化算法來鼓勵模型生成更精簡的回復(fù)。研究者們使用開源的 Qwen-QwQ-32B-Preview 模型作為實驗的基座模型,基于該模型在 PRM12K [10] 的數(shù)據(jù)集上的多次采樣結(jié)果,選擇最長的模型回復(fù)作為偏好優(yōu)化的負樣本,而對于正樣本的選擇,有如下幾種策略:

- 最短回復(fù)(Shortest Response):使用模型采樣結(jié)果中最短的生成結(jié)果作為正樣本。

- 首個正確回答(First-Correct Solutions, FCS):使用模型采樣結(jié)果中最短的首次得到正確答案的解答作為正樣本,拋棄所有后續(xù)的思考。

- 首個正確回答 + 驗算(FCS+Reflection):由于絕大多數(shù)的采樣結(jié)果都是在第一個解答中就出現(xiàn)了正確答案,僅保留首個正確回答可能會使得模型退化,因此研究者們在第一次得到正確答案后,額外保留了一輪反思的內(nèi)容。

- 最多樣回復(fù)(Greedily Diverse Solutions,GDS):除了單純地對長度進行控制,另一個優(yōu)化思路是盡可能保留更多樣化的思考軌跡,因此研究者們在 FCS 方法的基礎(chǔ)上,盡可能多地保留了包含不同推理策略的解答。

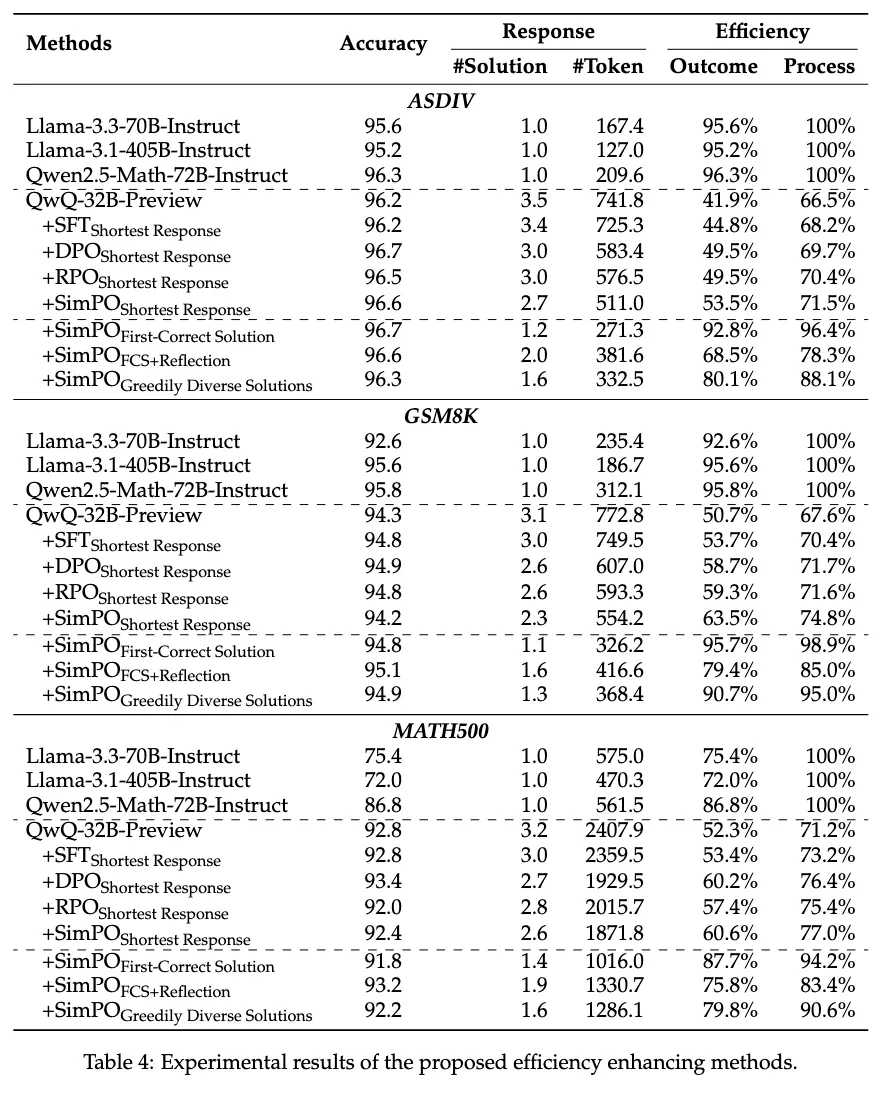

基于以上幾種偏好數(shù)據(jù),研究者們嘗試了最基礎(chǔ)的 SFT 以及多種偏好優(yōu)化算法,如 DPO [6],RPO [7][8] 以及 SimPO [8]。實驗結(jié)果如下:

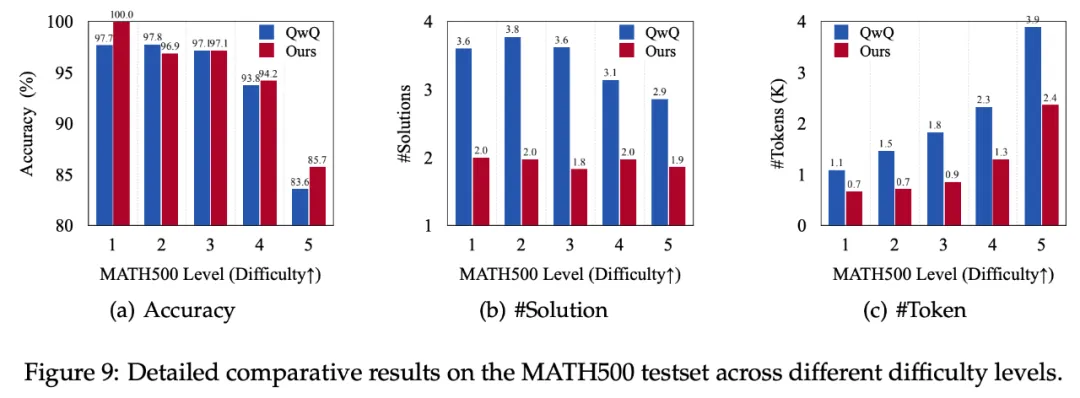

表格中的 SFT 方法是指僅使用正樣本進行微調(diào)。從表格中可以看出,在同樣的 “最短回復(fù)” 設(shè)置下,SimPO 有著最好的優(yōu)化效果,而基于 SimPO 的進一步實驗表明,使用首個正確回答 + 驗算作為正樣本的策略能夠很好地取得效率和性能的平衡,能夠在保持模型性能的同時大幅度地減少輸出的 token 數(shù)目以及平均解答輪數(shù),并有效地提高產(chǎn)出效率和過程效率。為了進一步分析方法的有效性,研究者們分析了 MATH500 測試集的不同難度下 SimPO+FCS+Reflection 方法的表現(xiàn),如下圖所示:

有意思是,文中提出的方法在最簡單的難度 1 的問題上,僅使用了相比于原來 63.6% 的 token 數(shù)目便達到了 100% 的正確率,而且在難題(難度 4 和 5)上,文中的方法能夠在提升性能的同時大幅度減少輸出的冗余,這展示了提出的方法在減緩過度思考上的有效性。

總結(jié)

這篇論文聚焦于 o1 類推理模型面臨的一個核心挑戰(zhàn):如何合理控制推理過程中的計算量,提升思考效率。文章通過分析實驗揭示了一個普遍問題 ——o1 類模型在處理簡單問題時容易陷入過度思考,從而增加了不必要的計算消耗。基于對此現(xiàn)象的詳細分析,研究者提出了一系列有效的優(yōu)化方法,能夠在保持模型性能的同時,大幅減少冗余推理,提升推理效率。這些方法的實驗結(jié)果表明,它們顯著優(yōu)化了模型在簡單任務(wù)上的資源利用情況,為實現(xiàn) “高效思考” 的目標邁出了重要一步。未來的研究將重點探索以下方向:

- 自適應(yīng)調(diào)控策略:開發(fā)讓模型根據(jù)問題復(fù)雜程度動態(tài)調(diào)整推理深度的機制,更智能地分配計算資源;

- 更精細的效率評估指標:設(shè)計能夠覆蓋更廣泛推理軌跡的指標,從而更全面地評估模型的思考效率。

這項研究不僅提升了 o1 類模型的推理,同時也為未來更高效、更智能的推理機制提供了重要的理論基礎(chǔ)與實踐參考。