數據不夠致Scaling Law撞墻?CMU和DeepMind新方法可讓VLM自己生成記憶

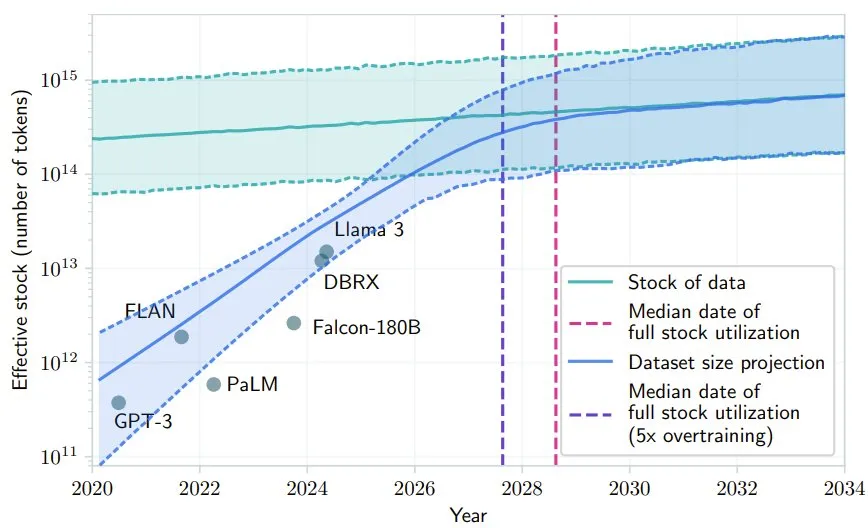

最近 AI 社區很多人都在討論 Scaling Law 是否撞墻的問題。其中,一個支持 Scaling Law 撞墻論的理由是 AI 幾乎已經快要耗盡已有的高質量數據,比如有一項研究就預計,如果 LLM 保持現在的發展勢頭,到 2028 年左右,已有的數據儲量將被全部利用完。

圖源:Will we run out of data? Limits of LLM scaling based on human-generated data

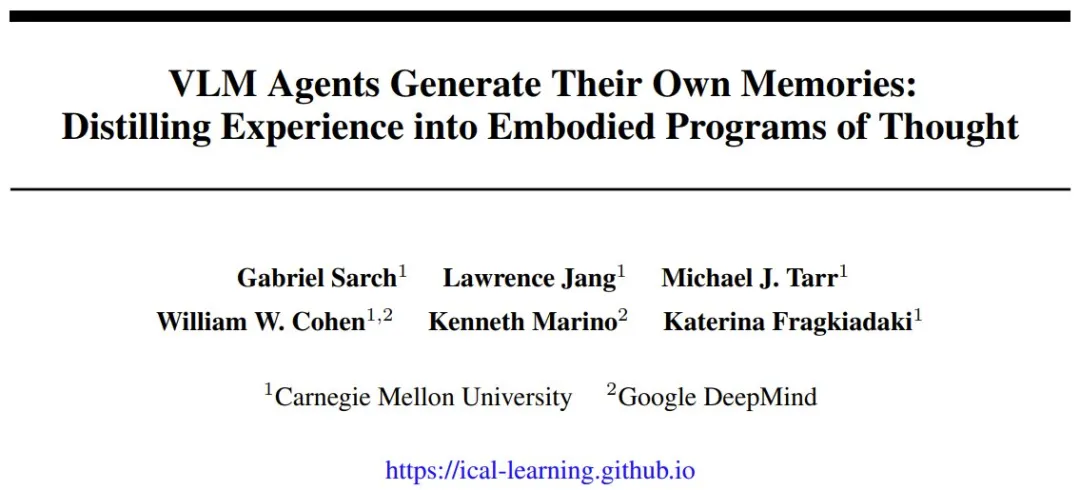

卡內基?梅隆大學(CMU)和 Google DeepMind 的一篇標題為「VLM 智能體生成自己的記憶:將經驗蒸餾成具身思維程序」的研究發現,通過使用低質量數據和反饋,或許能夠解決這個高質量數據不足的問題。其中提出的 ICAL 可讓 LLM 和 VLM 根據次優演示和人工反饋創建有效的提示詞,從而改善決策并減少對專家演示的依賴。該論文是 NeurIPS 2024 的 Spotlight 論文,項目代碼也已發布。

- 論文標題:VLM Agents Generate Their Own Memories: Distilling Experience into Embodied Programs of Thought

- 論文地址:https://openreview.net/pdf?id=5G7MRfPngt

- 項目地址:https://ical-learning.github.io/

- 代碼地址:https://github.com/Gabesarch/ICAL

我們知道,人類具有非常出色的少樣本學習能力,通過將觀察到的行為與內部世界模型相結合,可以從單一任務演示快速泛化到相關的情況。人類能分辨出與成功相關或不相關的因素,并預測可能的失敗。通過反復練習和反饋,人類能很快找到正確的抽象,從而幫助模仿和調整任務以適應各種情況。這個過程可促進在各種任務和環境中不斷改進和遷移知識。

最近有研究探索了使用大型語言模型(LLM)和視覺 - 語言模型(VLM)來從軌跡和經驗中提取高層級見解。這些見解是模型通過內省(introspection)產生的,而通過將它們附加到提示詞之后,可以提升其性能 —— 這就用到了它們強大的上下文學習能力。

現有的方法通常更關注語言上的任務獎勵信號、存儲失敗之后的人類更正、使用領域專家來人工編寫或人工挑選示例(無需內省)、或使用語言來塑造策略和獎勵。關鍵在于,這些方法通常都是基于文本的,并不包含任何視覺提示或演示,或者僅在失敗的情況下使用自省,但這只是人類和機器整合經驗和提取見解的幾種方式之一。

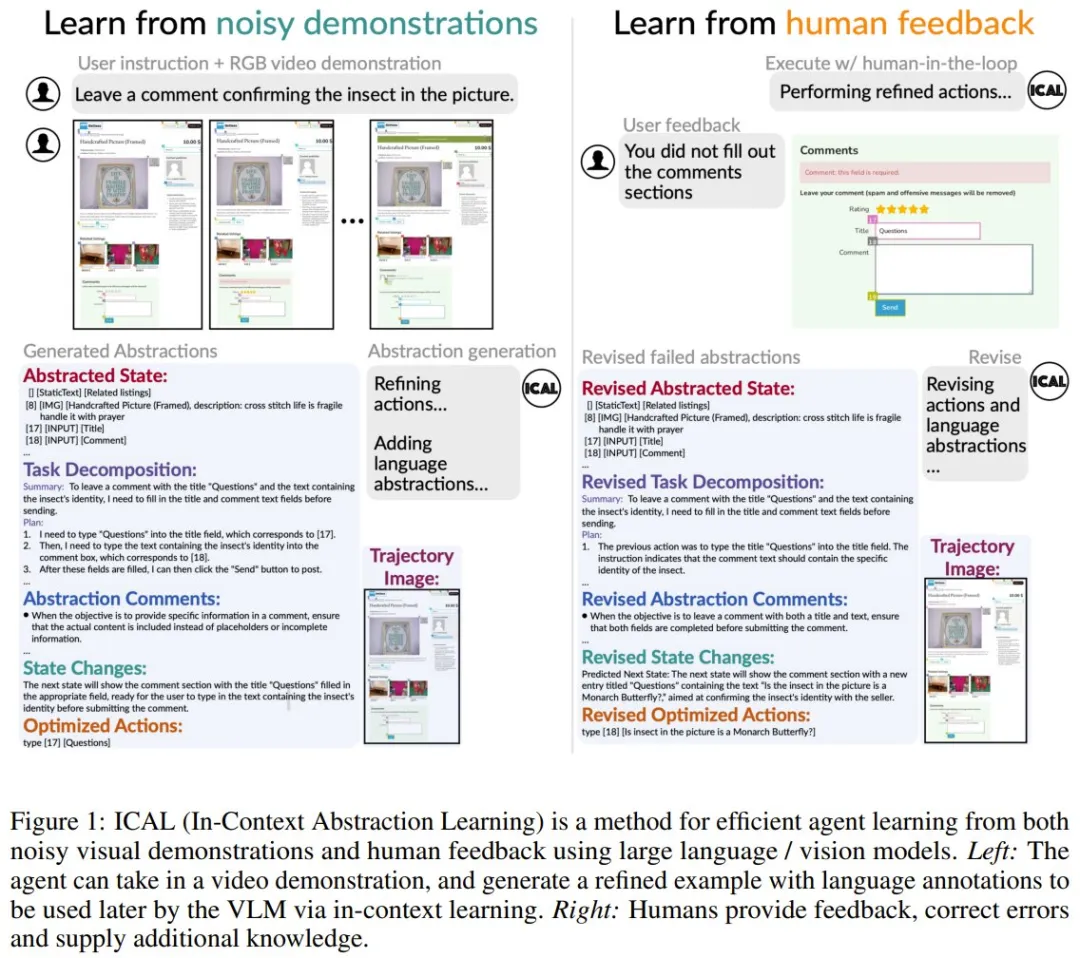

而 CMU 和 DeepMind 這個研究團隊的做法是:給定次優的演示和人類自然語言反饋,通過學習上下文經驗抽象來讓 VLM 學習解決新任務。這種方法被命名為 In-Context Abstraction Learning(ICAL),即上下文抽象學習。

上下文抽象學習究竟如何學習?

ICAL 這種方法可通過提示,讓 VLM 創建用于不熟悉領域的多模態抽象。

我們知道,之前的研究工作通常僅存儲和檢索成功的動作規劃或軌跡。但 ICAL 不一樣,強調的是學習抽象(abstraction),而這種所謂的抽象實際上包含了有關任務的動態和關鍵知識,如圖 1 所示。

具體來說,ICAL 可處理四種類型的認知抽象:

- 任務和因果關系,確定實現目標所需的基本原則或行動,以及要素如何通過因果關系相互關聯;

- 對象狀態的變化,描述對象將采取的各種形式或條件;

- 時間抽象,將任務分解為子目標;

- 任務建構(task construals),突出任務中的關鍵視覺細節。

當具有最優或次優演示時,ICAL 可通過提示 VLM 將這些演示轉換為優化后的軌跡,同時創建相關的語言和視覺抽象。然后在人類的自然語言反饋的引導下,通過在環境中執行這些軌跡來優化這些抽象。

這個抽象生成過程的每一步都會使用之前推導出的抽象,讓模型不僅可以提升自己的執行效果,還能提升自己的抽象能力。

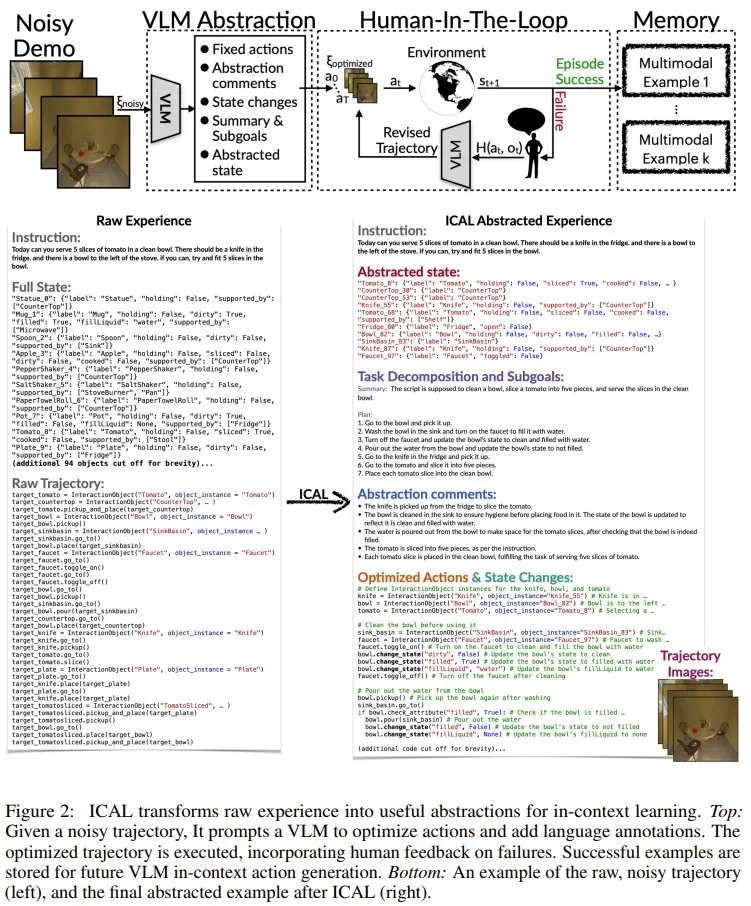

圖 2 給出了 ICAL 的概覽。

其中,每一輪迭代都始于一個有噪聲的軌跡。ICAL 會分兩個階段對其進行抽象:

- 抽象階段(F_abstract):VLM 會借助語言評論來糾正錯誤,并讓序列更加豐富。這一階段處理的抽象前文已有介紹,而相關的具體提示詞等請參看原論文附錄部分。

- 有人類參與的階段(human-in-the-loop,記為 F_hitl):在此階段,序列會在環境中執行,其抽象過程由以自然語言傳達的人類反饋指導。這一階段的具體流程可分為 6 步:優化軌跡的執行、監控與干預、反饋整合與軌跡修正、環境重置與重試、成功標準與反饋限度、保存示例。具體詳情請訪問原論文。

在成功執行軌跡之后,它將被存檔在一個持續增長的范例庫中。這些范例會被用作智能體的上下文參考,用于在學習階段和推理階段為未曾見過的指令和環境提供參考。

總體而言,這種學習到的抽象可以總結有關動作序列、狀態遷移、規則和關注區域的關鍵信息,并可通過自由形式的自然語言和視覺表征明確地表達出來。

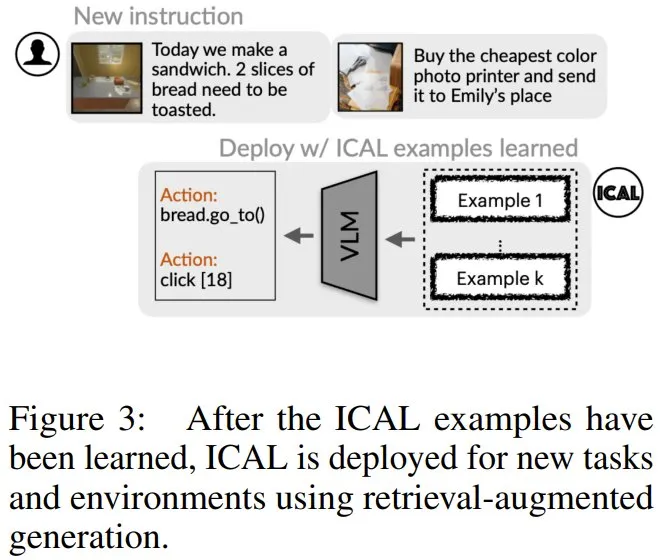

學習得到 ICAL 樣本之后,就可以使用檢索增強式生成部署起來,用于新任務和新環境。

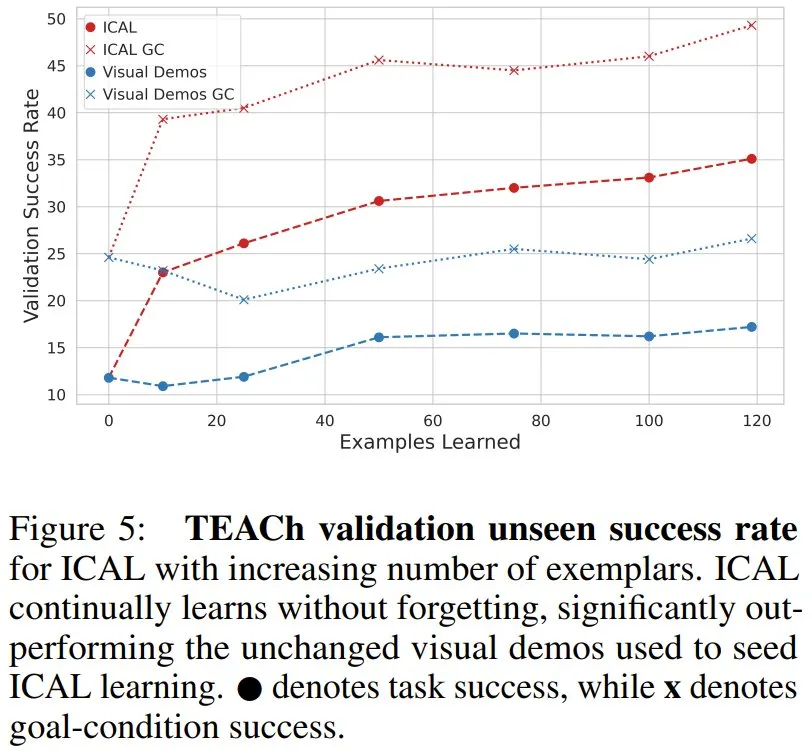

實驗表明 ICAL 確實可行

研究者在 TEACh 和 VisualWebArena 中測試了 ICAL 的任務規劃能力,并在 Ego4D 基準測試中測試其動作預測能力。其中,TEACh 針對的是家庭環境中的對話式教學,VisualWebArena 則是多模態自動化網絡任務,Ego4D 則是用于視頻動作預測。

首先,該團隊發現,在家庭環境的指令遵循任務中,ICAL 優于固定的演示。

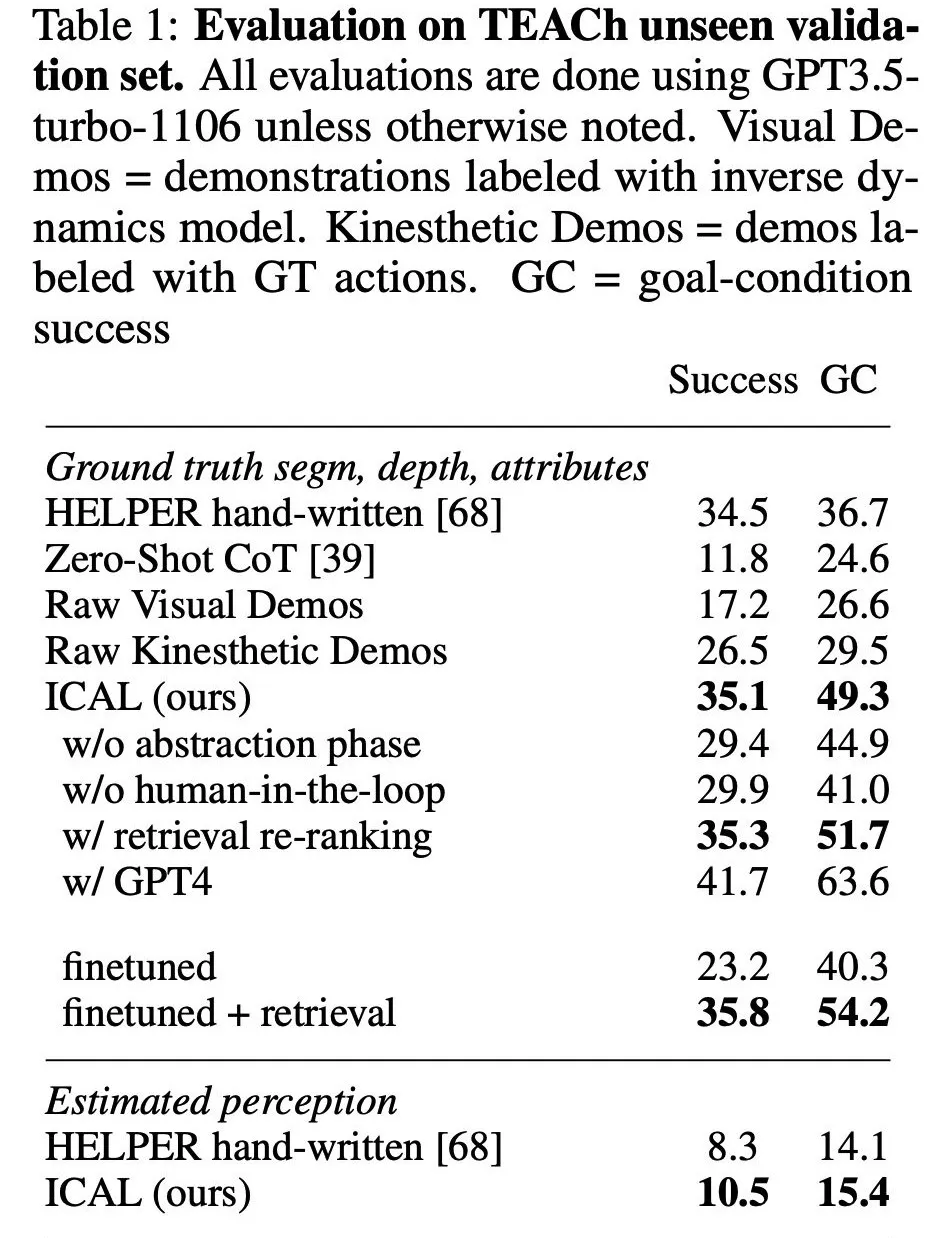

表 1 列出了在未曾見過的 TEACh 驗證集上的研究結果,其中評估了在新指令、房屋和物體上的性能。

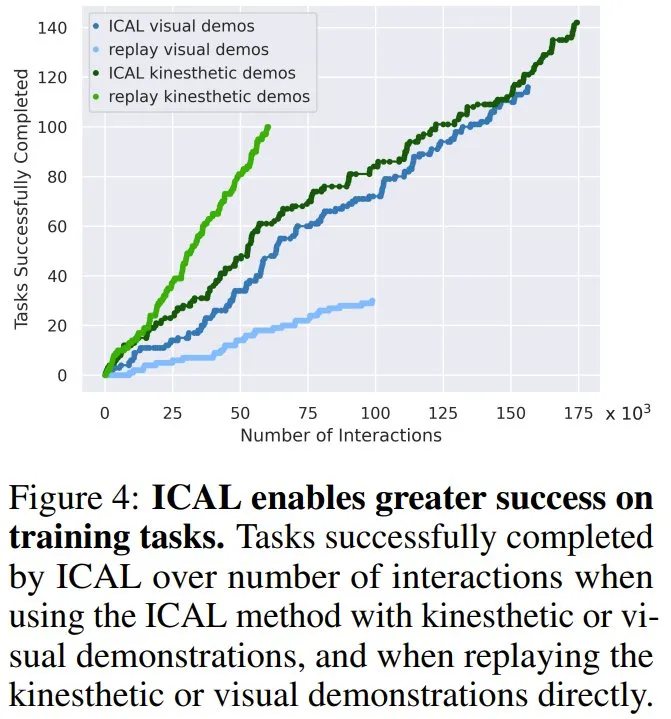

如圖 4 所示,與模仿原始軌跡相比,ICAL 對有噪聲的軌跡進行了修正,使訓練任務的成功率更高,動覺演示和視覺演示的成功率分別提高了 42% 和 86%。這表明 ICAL 不僅增加了有用的抽象概念,還糾正了被動視頻演示中的錯誤,提高了在原始演示環境中的成功率。

如表 1 所示,在未見過的任務上,ICAL 的表現優于作為上下文示例的未被處理的演示,其成功率比帶有預測動作的原始演示提高了 17.9%,比帶有真實動作注釋的演示提高了 8.6%。這凸顯了新提出的抽象方法在提高樣本質量以改進上下文學習方面的有效性,這不同于之前的主要方法,即保存和檢索成功的行動規劃或軌跡但不進行抽象。

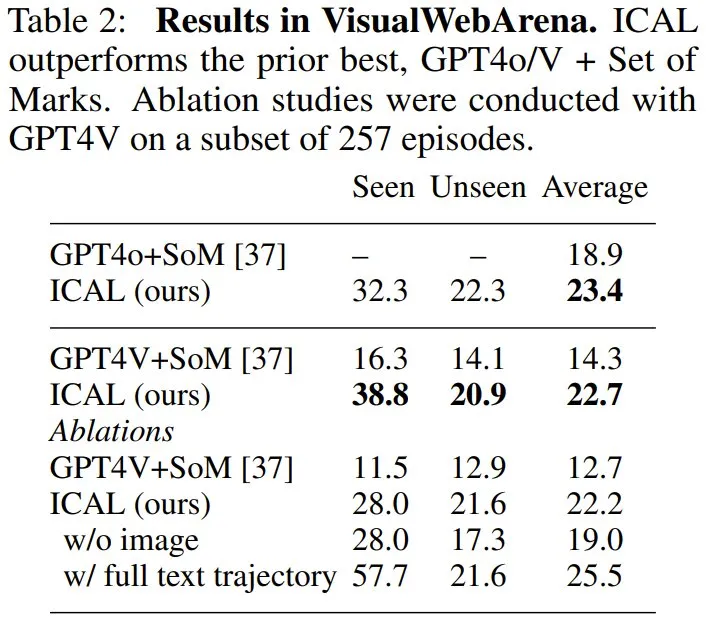

另外,在視覺網絡任務上,ICAL 也獲得了 SOTA 性能。在 VisualWebArena 上,新智能體超過了 GPT4 + Set of Marks 的組合,使用 GPT4V 時從 14.3% 提高到 22.7%,使用 GPT4o 時從 18.9% 提高到 23.4%。

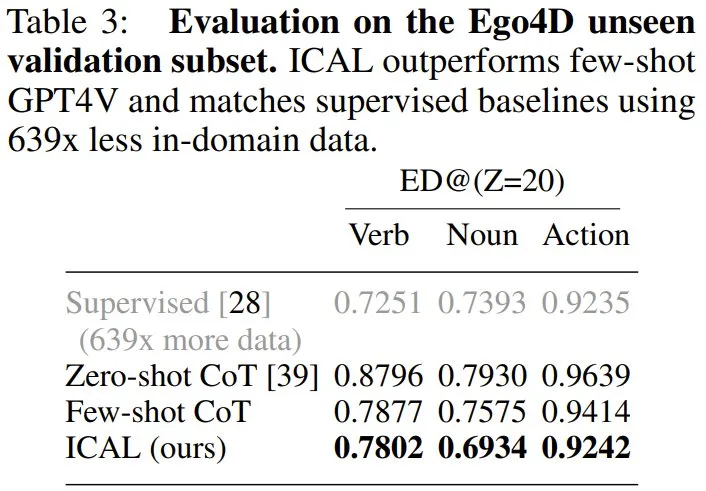

在 Ego4D 設置中,ICAL 的表現優于使用思維鏈的少樣本 GPT4V,分別將名詞和動作編輯距離縮短了 6.4 和 1.7,并且與完全監督式方法相差無幾 —— 但使用的領域內訓練數據減少了 639 倍。

總體來說,新方法可顯著減少對專家示例的依賴,并且相比于使用「缺乏此類抽象的動作規劃和軌跡」的上下文學習,新方法始終更優。

此外,隨著示例數量增長,ICAL 也能獲得明顯的提升。這表明這種新方法也能很好地 Scaling。