微軟開(kāi)源視頻Tokenizer新SOTA!顯著優(yōu)于Cosmos Tokenizer和Open-Sora

Sora、Genie等模型會(huì)都用到的Tokenizer,微軟下手了——

開(kāi)源了一套全能的Video Tokenizer,名為VidTok。

Sora等視頻生成模型工作中,都會(huì)利用Tokenizer將原始的高維視頻數(shù)據(jù)(如圖像和視頻幀)轉(zhuǎn)換為更為緊湊的視覺(jué)Token,再以視覺(jué)Token為目標(biāo)訓(xùn)練生成模型。

而最新的VidTok,在連續(xù)和離散、不同壓縮率等多種設(shè)定下,各項(xiàng)指標(biāo)均顯著優(yōu)于SOTA模型。

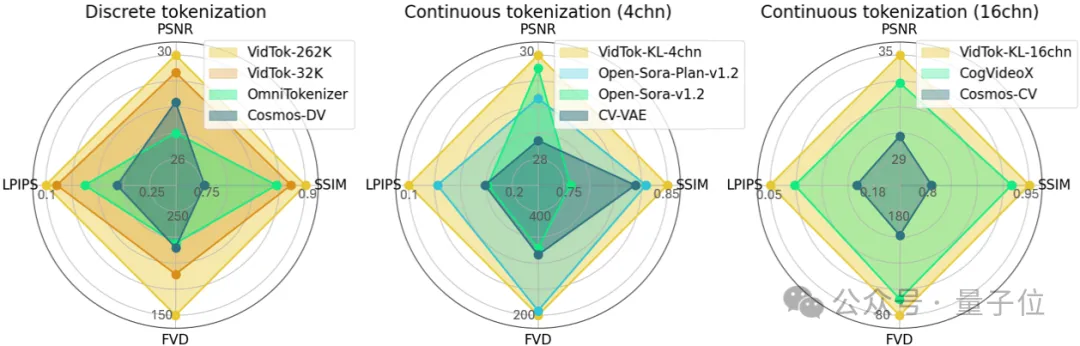

以下是涵蓋PSNR、SSIM、FVD、LPIPS指標(biāo)的性能比較雷達(dá)圖,面積越大表示性能越好。

從圖中可以看出對(duì)于離散Tokenizer,VidTok顯著優(yōu)于英偉達(dá)Cosmos Tokenizer;對(duì)于連續(xù)Tokenizer,VidTok也比Open-Sora、CogVideoX有更高的性能。

這項(xiàng)研究由來(lái)自微軟亞研院、上海交通大學(xué)、北京大學(xué)的研究人員共同完成。

目前,VidTok代碼不僅開(kāi)源了,還支持用戶在自定義數(shù)據(jù)集上的微調(diào),為研究者和開(kāi)發(fā)者提供了一個(gè)高性能、易用的工具平臺(tái)。

性能全面領(lǐng)先,適用各種場(chǎng)景

近年來(lái),視頻生成以及基于此的世界模型已經(jīng)成為人工智能領(lǐng)域的熱門研究方向,這兩者的核心在于對(duì)視頻內(nèi)容的高效建模。

視頻中蘊(yùn)含了豐富的視覺(jué)信息,不僅能夠提供真實(shí)的視覺(jué)體驗(yàn),更能作為具身場(chǎng)景中模型理解世界的中間媒介。

然而,由于視頻像素級(jí)表示信息高度冗余,如何通過(guò)Tokenizer對(duì)視頻數(shù)據(jù)進(jìn)行高效壓縮和表示成為關(guān)鍵課題。

當(dāng)下很多工作如Sora,Genie等都會(huì)通過(guò)Tokenizer將原始的高維視頻數(shù)據(jù)(如圖像和視頻幀)轉(zhuǎn)換為更為緊湊的視覺(jué)Token,再以視覺(jué)Token為目標(biāo)訓(xùn)練生成模型。

可以說(shuō),視覺(jué)Token的表示能力對(duì)于最終的效果至關(guān)重要,甚至決定了模型能力的上限。

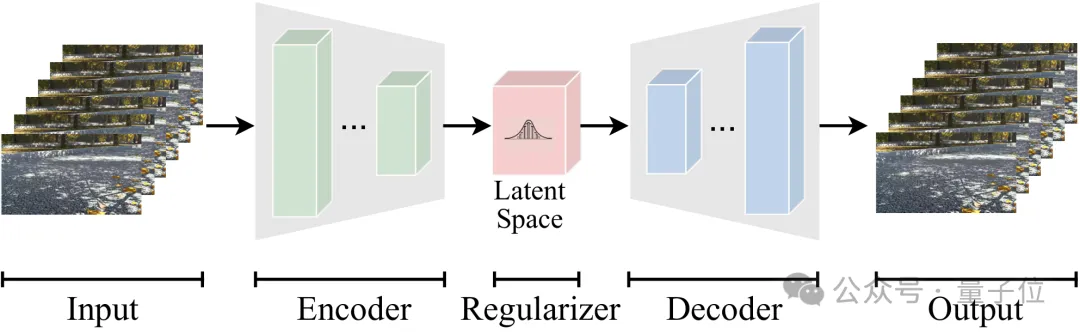

Tokenizer的主要作用是將高維的原始數(shù)據(jù)轉(zhuǎn)換為隱空間中高效的壓縮表示,使得信息的生成和處理可以在該隱空間中進(jìn)行。上圖展示了一個(gè)視頻的Token化過(guò)程,通過(guò)轉(zhuǎn)換為Token建模,能夠有效降低模型訓(xùn)練和推理時(shí)的計(jì)算需求。

根據(jù)不同的使用需求,視頻Tokenizer通常有如下分類:

- 連續(xù)型和離散型。根據(jù)隱空間的數(shù)值分布,Tokenizer可以分為連續(xù)型和離散型,分別適用于從連續(xù)分布中采樣的模型(如擴(kuò)散模型等)和從離散分布中采樣的模型(如語(yǔ)言模型等)。

- 因果型和非因果型。因果結(jié)構(gòu)使得模型只依賴歷史幀來(lái)對(duì)當(dāng)前幀進(jìn)行Tokenization,這與真實(shí)世界系統(tǒng)的因果性質(zhì)保持一致。非因果模型則可以同時(shí)根據(jù)歷史幀和未來(lái)幀對(duì)當(dāng)前幀進(jìn)行Tokenization,通常具有更優(yōu)的重建質(zhì)量。

- 不同的壓縮率模型。Sora等眾多工作采用了如4x8x8的視頻壓縮率(時(shí)間壓縮4倍、空間壓縮8倍),實(shí)現(xiàn)更高的視頻壓縮率而保持高質(zhì)量的視頻重建是目前的研究趨勢(shì)。

目前業(yè)界領(lǐng)先的視頻模型多為閉源狀態(tài),而開(kāi)源的視頻Tokenizer大多受限于單一的模型設(shè)定或欠佳的重建質(zhì)量,導(dǎo)致可用性較差。

由此,來(lái)自微軟亞研院、上海交通大學(xué)和北京大學(xué)的研究人員最近正式發(fā)布了開(kāi)源視頻Tokenizer——VidTok。

在測(cè)試中,VidTok性能全面領(lǐng)先,適用各種場(chǎng)景。

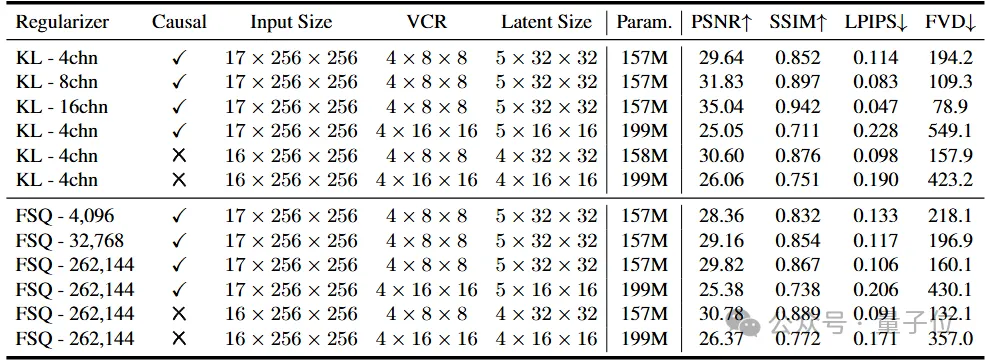

如下表所示,VidTok支持多樣化的隱空間且具有靈活的壓縮率,同時(shí)支持因果和非因果模型,以適應(yīng)不同的使用需求。

- 對(duì)于連續(xù)型Tokenizer,支持不同的視頻壓縮率、不同的隱空間通道數(shù),同時(shí)支持因果和非因果模型。

- 對(duì)于離散型Tokenizer,支持不同的視頻壓縮率、不同的碼本大小,同時(shí)支持因果和非因果模型。

更多模型在持續(xù)更新中。

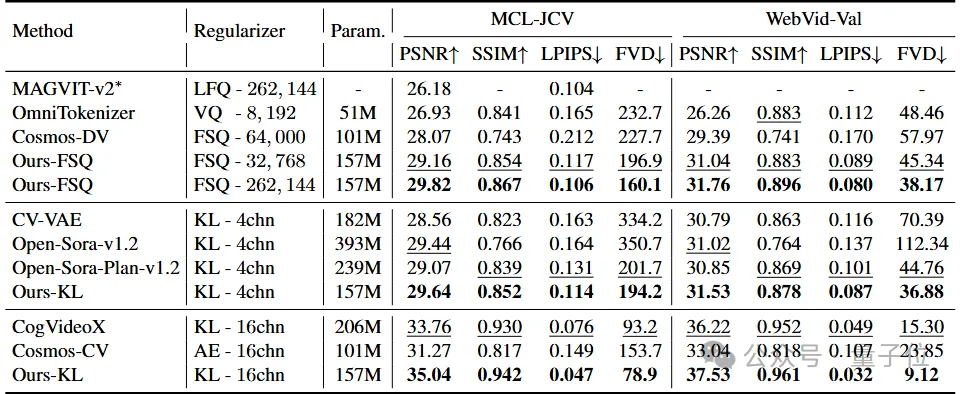

為了全面評(píng)估VidTok在各個(gè)設(shè)定下的重建性能,作者將VidTok與最先進(jìn)的連續(xù)和離散視頻Tokenizer分別進(jìn)行了對(duì)齊設(shè)定下的比較。所有模型均為4x8x8倍視頻壓縮率的因果模型,主要包含以下三種設(shè)定:

- VidTok-FSQ:離散型,碼本大小各異。基線方法包括MAGVIT-v2,OmniTokenizer,Cosmos-DV等。

- VidTok-KL-4chn:連續(xù)型,隱空間通道數(shù)為4。基線方法包括CV-VAE,Open-Sora-v1.2,Open-Sora-Plan-v1.2等。

- VidTok-KL-16chn:連續(xù)型,隱空間通道數(shù)為16。基線方法包括CogVideoX,Cosmos-CV等。

定量實(shí)驗(yàn)結(jié)果表明,VidTok在上述三種設(shè)定下均達(dá)到了SOTA性能,在常見(jiàn)的視頻質(zhì)量評(píng)估指標(biāo)PSNR、SSIM、FVD、LPIPS上具有全面的優(yōu)勢(shì)。

與現(xiàn)有的離散Tokenizer相比,VidTok即使在使用更小的碼本大小時(shí)(例如32,768),也展現(xiàn)出了更優(yōu)的重建性能。

在連續(xù)Tokenizer的設(shè)定下,無(wú)論隱空間通道數(shù)是4還是16,VidTok在所有評(píng)估指標(biāo)上相比基線方法均取得了全面的提升。值得注意的是,這些提升是在沒(méi)有模型大小優(yōu)勢(shì)的情況下達(dá)成的。

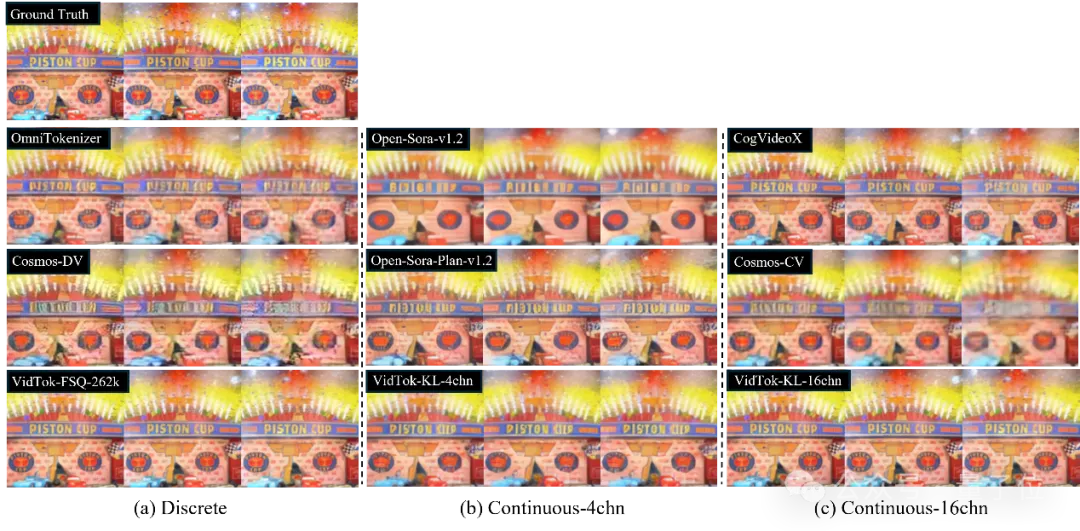

除此之外,團(tuán)隊(duì)還進(jìn)行了定性分析。

上圖中展示了以上三種設(shè)定下的與基線方法的對(duì)比結(jié)果。

從視頻幀的重建質(zhì)量可以看出,與現(xiàn)有的方法相比,VidTok在各種模型設(shè)定下,均展現(xiàn)出了最優(yōu)的重建細(xì)節(jié)保真度和主觀視覺(jué)質(zhì)量。證明了VidTok作為多功能視頻Tokenizer的有效性。

所以VidTok是如何做到的?

VidTok的技術(shù)亮點(diǎn)解析

相對(duì)于現(xiàn)有的視頻Tokenizer,VidTok在模型架構(gòu)、量化技術(shù)、訓(xùn)練策略上分別做了創(chuàng)新。

高效的混合模型架構(gòu)設(shè)計(jì)

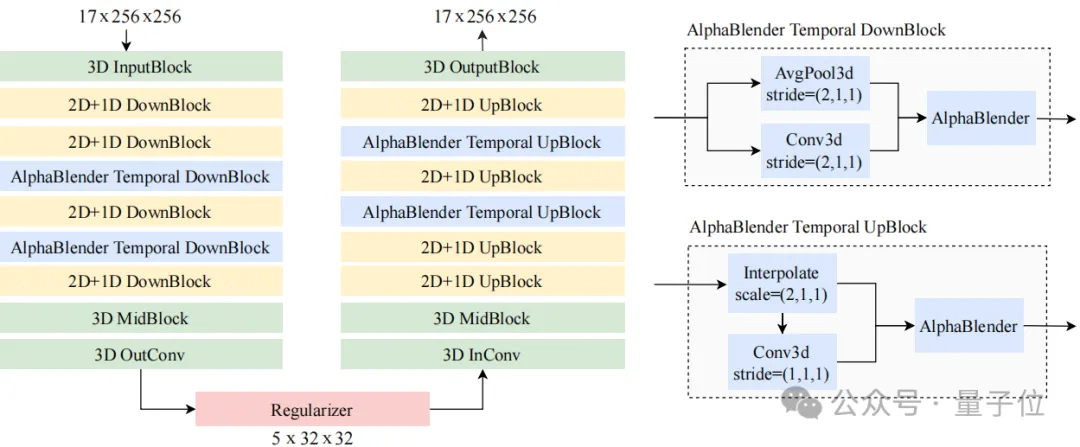

VidTok采用經(jīng)典的3D編碼器-解碼器結(jié)構(gòu),同時(shí)創(chuàng)新性地結(jié)合了3D、2D和1D卷積,有效地解耦空間和時(shí)間采樣。

在現(xiàn)有研究中普遍認(rèn)為,盡管計(jì)算成本較高,完全的3D架構(gòu)提供了更優(yōu)的重建質(zhì)量。然而,VidTok發(fā)現(xiàn)將部分3D卷積替換為2D和1D卷積的組合,可以有效地解耦空間和時(shí)間采樣,在降低計(jì)算需求的同時(shí),保持了高水平的重建質(zhì)量。

詳細(xì)的網(wǎng)絡(luò)架構(gòu)如上圖所示。VidTok分別處理空間采樣和時(shí)間采樣模塊,并在時(shí)間采樣模塊中引入了AlphaBlender操作符。其余組件,包括輸入/輸出層和瓶頸層,則利用3D卷積來(lái)促進(jìn)信息融合。此外,整個(gè)架構(gòu)中引入了層歸一化以增強(qiáng)穩(wěn)定性和性能。實(shí)驗(yàn)證明該架構(gòu)在重建質(zhì)量和計(jì)算量之間取得了平衡。

先進(jìn)的量化技術(shù)

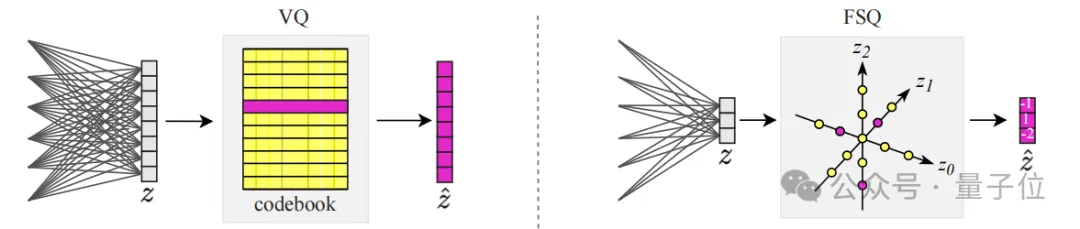

VidTok引入了有限標(biāo)量量化(FSQ)技術(shù),無(wú)需顯式學(xué)習(xí)碼本,顯著提高了模型的訓(xùn)練穩(wěn)定性和重建性能。

有限標(biāo)量量化(FSQ)由「Finite scalar quantization: Vq-vae made simple」提出,其核心原理是,在隱空間表征中,每個(gè)標(biāo)量條目通過(guò)四舍五入獨(dú)立量化到最近的預(yù)定義標(biāo)量值。

與傳統(tǒng)VQ相比,F(xiàn)SQ無(wú)需學(xué)習(xí)顯式的碼本,從而提高了訓(xùn)練的穩(wěn)定性。實(shí)驗(yàn)表明,F(xiàn)SQ在碼本利用率、重建質(zhì)量和訓(xùn)練穩(wěn)定性方面具有顯著優(yōu)勢(shì),作為一種先進(jìn)的量化技術(shù),有效提升了離散Tokenizer的性能。

增強(qiáng)的訓(xùn)練策略

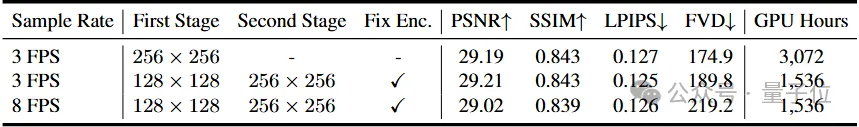

VidTok采用分階段訓(xùn)練策略,訓(xùn)練時(shí)間減少了50%,而重建質(zhì)量不受影響。

視頻Tokenizer的訓(xùn)練通常是計(jì)算密集的,要求大量計(jì)算資源(例如對(duì)于256x256分辨率的視頻需要3,072GPU小時(shí)的訓(xùn)練時(shí)長(zhǎng))。這就需要開(kāi)發(fā)有效的策略來(lái)降低計(jì)算成本,同時(shí)保持模型性能。

VidTok采用一種兩階段訓(xùn)練方法來(lái)應(yīng)對(duì)這一挑戰(zhàn):首先在低分辨率視頻上對(duì)完整模型進(jìn)行預(yù)訓(xùn)練,然后僅在高分辨率視頻上微調(diào)解碼器。這種訓(xùn)練策略顯著降低了計(jì)算成本——訓(xùn)練時(shí)間減少了一半(從3,072GPU小時(shí)降至1,536GPU 小時(shí)),而保持重建視頻質(zhì)量不變。

該兩階段訓(xùn)練的另一優(yōu)勢(shì)是,由于第二階段只會(huì)微調(diào)解碼器,因此模型可以快速適應(yīng)到新的領(lǐng)域數(shù)據(jù)中,而不會(huì)影響隱空間數(shù)據(jù)分布。

此外,由于視頻Tokenizer旨在建模輸入視頻的運(yùn)動(dòng)動(dòng)態(tài),因此在模型中有效表示這些動(dòng)態(tài)至關(guān)重要。VidTok使用較低幀率的數(shù)據(jù)進(jìn)行訓(xùn)練,顯著增強(qiáng)了模型捕捉和表示運(yùn)動(dòng)動(dòng)態(tài)的能力,獲得了更好的重建質(zhì)量。

VidTok的開(kāi)源為視頻生成、世界模型領(lǐng)域提供了新的工具,特別是在當(dāng)前業(yè)內(nèi)許多領(lǐng)先模型仍未開(kāi)源的背景下。

團(tuán)隊(duì)表示,VidTok支持后續(xù)微調(diào)也為其他應(yīng)用提供了更廣闊的使用空間,研究者可輕松將VidTok應(yīng)用于特定領(lǐng)域數(shù)據(jù)集,為目標(biāo)場(chǎng)景優(yōu)化性能。

更多細(xì)節(jié)內(nèi)容感興趣的童鞋可參閱原論文。

論文地址:https://arxiv.org/abs/2412.13061。

項(xiàng)目地址:https://github.com/microsoft/vidtok。