無需訓練、即插即用,新算法大幅增強視頻生成質量|NUS&上海AI Lab&UT Austin

無需額外模型訓練、即插即用,全新的視頻生成增強算法——Enhance-A-Video來了!

和最近人氣超高的混元視頻生成模型(HunyuanVideo)對比來看,加入Enhance-A-Video的版本在生成畫面中表現出了更加豐富的細節和更高的語義契合度,生成內容和用戶輸入的文本提示更匹配:

研究團隊成員來自新加坡國立大學、上海AI實驗室和德克薩斯大學奧斯汀分校。

簡單來說,新算法通過調整時間注意力層輸出的一個關鍵參數,能夠在幾乎不增加推理負擔的情況下,大幅提升生成視頻的細節表現和時序連貫性。

Enhance-A-Video還兼容多種主流視頻生成模型,無需修改基礎架構即可直接應用。

比如CogVideoX-2B + Enhance-A-Video:

還有OpenSora-V1.2 + Enhance-A-Video:

實驗結果顯示,Enhance-A-Video在提升視頻質量方面表現卓越,尤其是在對比度、清晰度以及細節真實性上有顯著改進。

新算法一經發布,其強大的泛化能力也是迅速得到了社區的認可。

很多網友已將該算法集成到多個主流推理框架中,包括ComfyUI-Hunyuan和ComfyUI-LTX。

對比一下網友Kijai發布的原始混元模型和增強后的效果,可以看到模型生成畫面更加自然,動態表現也更加流暢:

△Comfy-UI測試結果,左邊為原始視頻,右邊為增強視頻

LTX-Video的研究人員Nir Zabari還成功將它應用到了LTXV模型中,顯著提升了生成視頻在動作一致性和細節呈現方面的表現。

這一成果表明,Enhance-A-Video不僅適用于特定模型,還能廣泛適配于不同的視頻生成框架。

研究背景:提升視頻生成質量需求強烈

近年來,以Diffusion Transformer(DiT)為代表的視頻生成技術[1]迅猛發展,能夠根據文本描述生成多樣化的視頻內容。

然而,現有方法仍面臨以下挑戰:

- 時序不連貫:幀與幀之間缺乏一致性;

- 細節模糊:畫面紋理缺乏清晰度;

- 畫面抖動:動態效果不夠穩定。

這些問題顯著影響了生成視頻的實用性和觀看體驗,如何提升 AI 生成視頻的質量成為當前研究的關鍵問題之一。

為了解決上述問題,Enhance-A-Video應運而生。其核心原理是通過一個增強系數,優化時間注意力的分布,從而實現以下優勢:

- 高效增強:快速提升視頻質量;

- 無需訓練:可直接應用于現有生成模型;

- 即插即用:靈活適配多種場景和需求。

設計動機:時間注意力的優化潛力

時間注意力(Temporal Attention)在DiT模型中負責信息的幀間傳遞,對生成視頻的連貫性和細節保留至關重要。

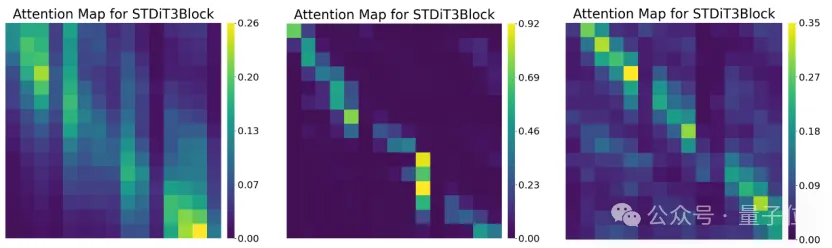

通過對不同DiT層的時間注意力分布進行可視化分析,研究人員發現:

在部分DiT層中,時間注意力的分布存在顯著差異:跨幀注意力(非對角線部分)的強度明顯低于單幀自注意力(對角線部分)。

這一現象可能導致幀間信息傳遞不足,進而影響視頻的一致性和細節表現。

基于這一觀察,作者提出了一個關鍵假設:能否通過利用時間注意力來提高視頻質量?

△不同DiT層的時間注意力分布圖

這一假設的靈感來源于大語言模型(LLM)中的溫度系數(τ)調節機制。

在文本生成中,通過調整Softmax的溫度參數可以平衡一致性與多樣性[2]:

- 增大τ,生成結果更加多樣化。

- 減小τ,生成結果更連貫一致。

類似地,在視頻生成中,時間注意力的溫度系數可以直接影響幀間相關性強度,為Enhance-A-Video的設計提供了理論基礎。

方法概述:無需訓練的動態增強方案

基于上述觀察與思考,作者首次發現時間注意力的溫度系數決定了不同幀之間的相關性強度,相關性強度越高意味著每一幀生成時,在時間上下文維度所考慮的范圍越廣。

由此想法出發,作者提出了一種調整時間注意力層輸出,無需訓練的視頻增強方法,該方法可以直接應用于現有的AI視頻生成模型。

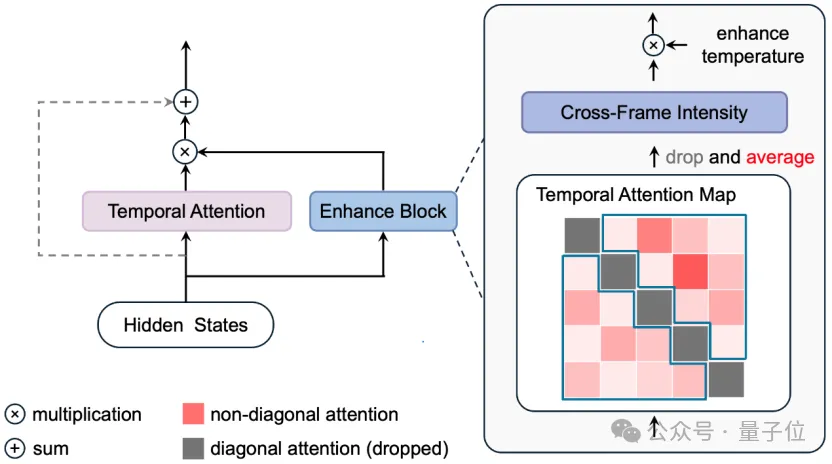

△Enhance-A-Video框架圖

Enhance-A-Video的核心設計是通過動態調節時間注意力層的輸出,實現對幀間一致性和細節表現的優化。

具體方法分為以下幾步:

1.并行增強模塊

在時間注意力層的基礎上增加一個并行分支,計算時間注意力分布圖。

輸入時間注意力層的隱藏狀態也被傳入增強模塊。

2.計算跨幀強度(CFI)

從時間注意力分布圖中提取非對角線元素的平均值,作為跨幀強度(Cross-Frame Intensity, CFI)。

3.動態增強控制

引入增強溫度參數(Enhance Temperature),將其與CFI的乘積作為增強模塊的輸出系數。

利用該系數動態調整時間注意力層輸出的特征增強強度。

通過這一策略,Enhance-A-Video 能夠高效地提升視頻的幀間一致性和細節表現,而無需對原始模型進行重新訓練。

為AI視頻生成技術提供新思考

這項研究提出了首個無需訓練、即插即用的AI生成視頻質量增強方法——Enhance-A-Video,針對當前生成視頻質量的關鍵問題,圍繞時間注意力機制展開創新設計,主要貢獻如下:

- 創新性方法:通過在時間注意力層計算交叉幀強度,引入增強溫度參數,提升幀間一致性與細節表現力。

- 高效性與通用性:無需訓練,直接適配主流視頻生成模型。

- 顯著性能提升:在HunyuanVideo等模型上解決了細節缺失和時序不一致等問題。

未來他們還會在此基礎上進一步開展工作,包括:

- 自適應增強:研究自動調節增強溫度參數機制,優化一致性與多樣性平衡。

- 擴展適用性:優化方法設計以適配大規模模型和多模態場景。

- 質量評價:構建更完善的視頻生成質量評價體系。

作者表示,期待本研究為AI視頻生成技術的實際應用與質量提升提供新的思路和支持!

開源代碼鏈接:https://github.com/NUS-HPC-AI-Lab/Enhance-A-Video

相關博客鏈接:https://oahzxl.github.io/Enhance_A_Video/

參考文獻:

[1]Brooks, Tim, Bill Peebles, Connor Holmes, Will DePue, Yufei Guo, Li Jing, David Schnurr, Joe Taylor, Troy Luhman, Eric Luhman, Clarence Ng, Ricky Wang and Aditya Ramesh. “Video generation models as world simulators.“ OpenAI Research (2024).

[2]Renze, Matthew and Erhan Guven. “The Effect of Sampling Temperature on Problem Solving in Large Language Models.” ArXiv abs/2402.05201 (2024).