空間智能新進(jìn)展:教機(jī)器人組裝宜家家具,首次實(shí)現(xiàn)操作步驟與真實(shí)視頻對(duì)齊

斯坦福吳佳俊團(tuán)隊(duì),給機(jī)器人設(shè)計(jì)了一套組裝宜家家具的視頻教程!

具體來說,團(tuán)隊(duì)提出了用于機(jī)器人的大型多模態(tài)數(shù)據(jù)集IKEA Video Manuals,已入選NeurIPS。

圖片

圖片

數(shù)據(jù)集涵蓋了6大類IKEA家具,每種家具都包含完整的3D模型、組裝說明書和實(shí)際組裝視頻。

而且劃分精細(xì),拆解出的安裝子步驟多達(dá)1000多個(gè)。

圖片

圖片

作者介紹,該數(shù)據(jù)集首次實(shí)現(xiàn)了組裝指令在真實(shí)場(chǎng)景中的4D對(duì)齊,為研究這一復(fù)雜問題提供了重要基準(zhǔn)。

知名科技博主、前微軟策略研究者Robert Scoble說,有了這個(gè)數(shù)據(jù)集,機(jī)器人將可以學(xué)會(huì)自己組裝家具。

圖片

圖片

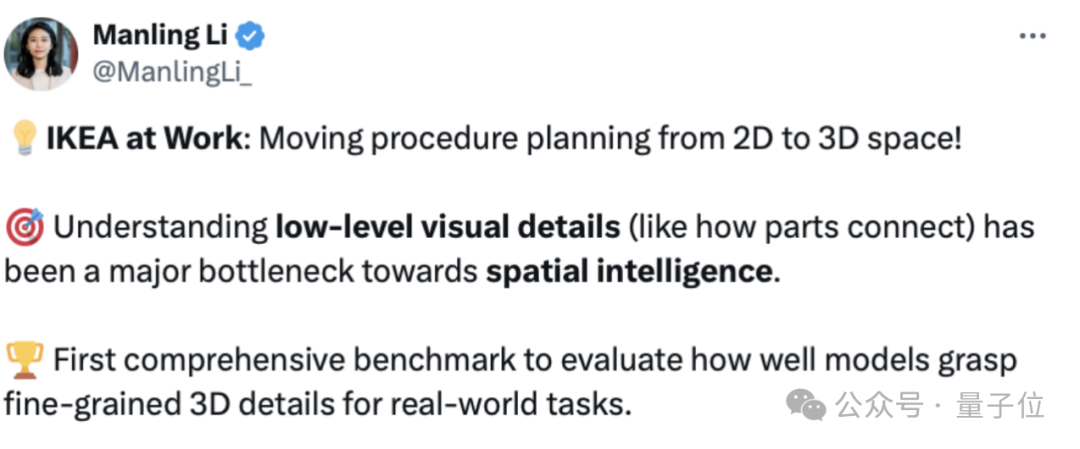

團(tuán)隊(duì)成員、斯坦福訪問學(xué)者李曼玲(Manling Li)表示,這是空間智能領(lǐng)域的一項(xiàng)重要工作:

這項(xiàng)工作將組裝規(guī)劃從2D推進(jìn)到3D空間,通過理解底層視覺細(xì)節(jié),解決了空間智能研究中的一個(gè)主要瓶頸。

圖片

圖片

1120個(gè)子步驟詳述組裝過程

IKEA Video Manuals數(shù)據(jù)集中,涵蓋了6大類36種IKEA家具,從簡(jiǎn)單的凳子到復(fù)雜的柜子,呈現(xiàn)了不同難度的組裝任務(wù)。

圖片

圖片

每一款家具,都包括以下三種模態(tài):

- 安裝說明書,提供了任務(wù)的整體分解和關(guān)鍵步驟;

- 真實(shí)組裝視頻,展示了詳細(xì)的組裝過程;

- 3D模型,定義了部件之間的精確空間關(guān)系。

并且這三種模態(tài)并非簡(jiǎn)單地堆砌在一起,作者通過對(duì)視頻和操作步驟的拆解,將三種模態(tài)進(jìn)行了精細(xì)的對(duì)齊。

圖片

圖片

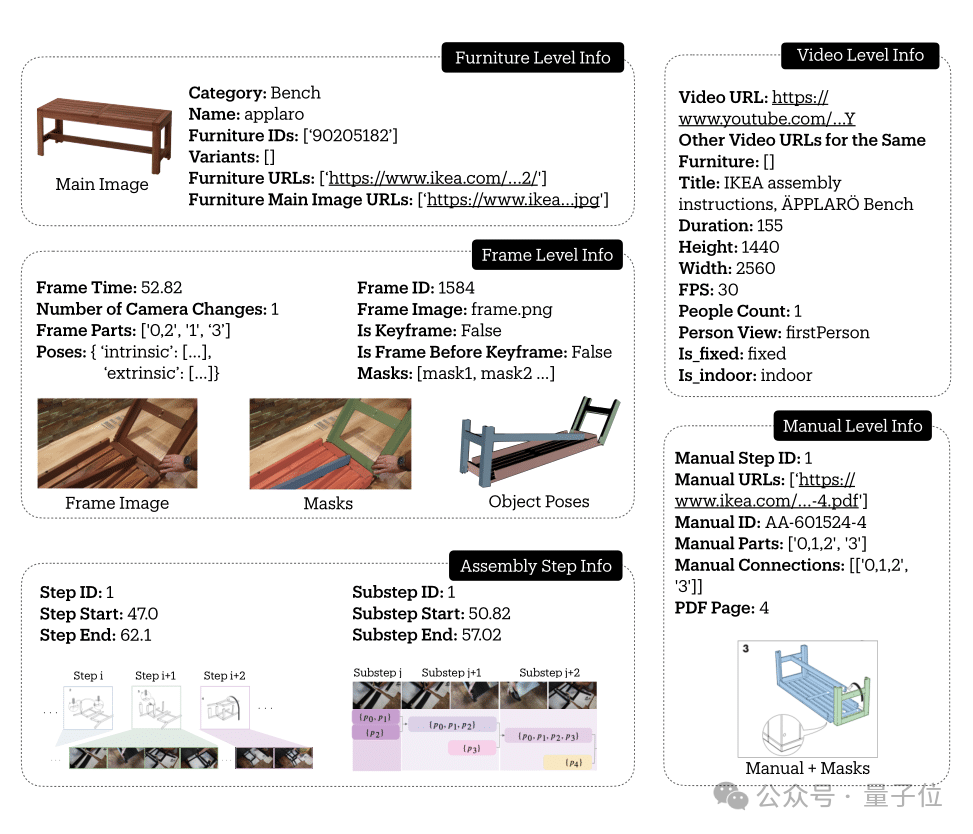

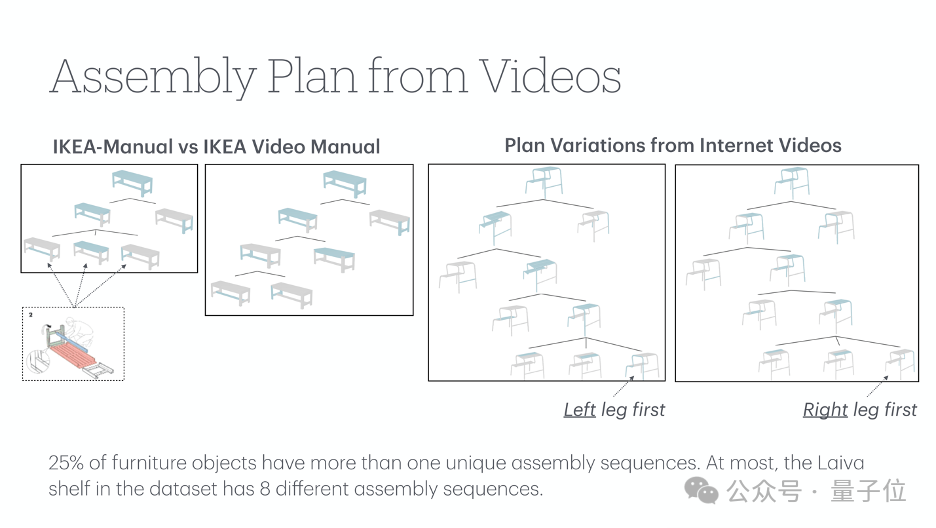

舉個(gè)例子,在這樣一條關(guān)于長(zhǎng)凳的數(shù)據(jù)當(dāng)中,包含了其基本概況、視頻信息、關(guān)鍵幀信息,以及安裝步驟。

從下圖中可以看出,安裝步驟當(dāng)中有主要步驟和子步驟的劃分,還標(biāo)注了對(duì)應(yīng)的視頻位置。

圖片

圖片

整個(gè)數(shù)據(jù)集中,共包含了137個(gè)手冊(cè)步驟,根據(jù)安裝視頻被細(xì)分為了1120個(gè)具體子步驟,捕捉了完整的組裝過程。

并且通過6D Pose追蹤,每個(gè)部件的空間軌跡都被精確記錄,最終在視頻幀、家具組裝說明書和3D模型之間建立了密集的對(duì)應(yīng)關(guān)系。

時(shí)空信息精細(xì)標(biāo)注

IKEA Video Manuals數(shù)據(jù)集是在IKEA-Manual和IKEA Assembly in the Wild(IAW)兩個(gè)數(shù)據(jù)集的基礎(chǔ)上建立的。

其中,IKEA-Manual數(shù)據(jù)集提供了模型及其對(duì)應(yīng)說明書,IAW則包含了大量用戶組裝宜家家具的視頻片段。

這些視頻來自90多個(gè)不同的環(huán)境,包括室內(nèi)外場(chǎng)景、不同光照條件,真實(shí)反映了家具組裝的多樣性。

圖片

圖片

與在實(shí)驗(yàn)室環(huán)境下采集的數(shù)據(jù)相比,這些真實(shí)視頻帶來了更豐富的挑戰(zhàn):

- 部件經(jīng)常被手或其他物體遮擋;

- 相似部件識(shí)別(如四條一模一樣的桌子腿);

- 攝像機(jī)頻繁移動(dòng)、變焦,帶來參數(shù)估計(jì)的困難;

- 室內(nèi)外場(chǎng)景、不同光照條件下的多樣性。

圖片

圖片

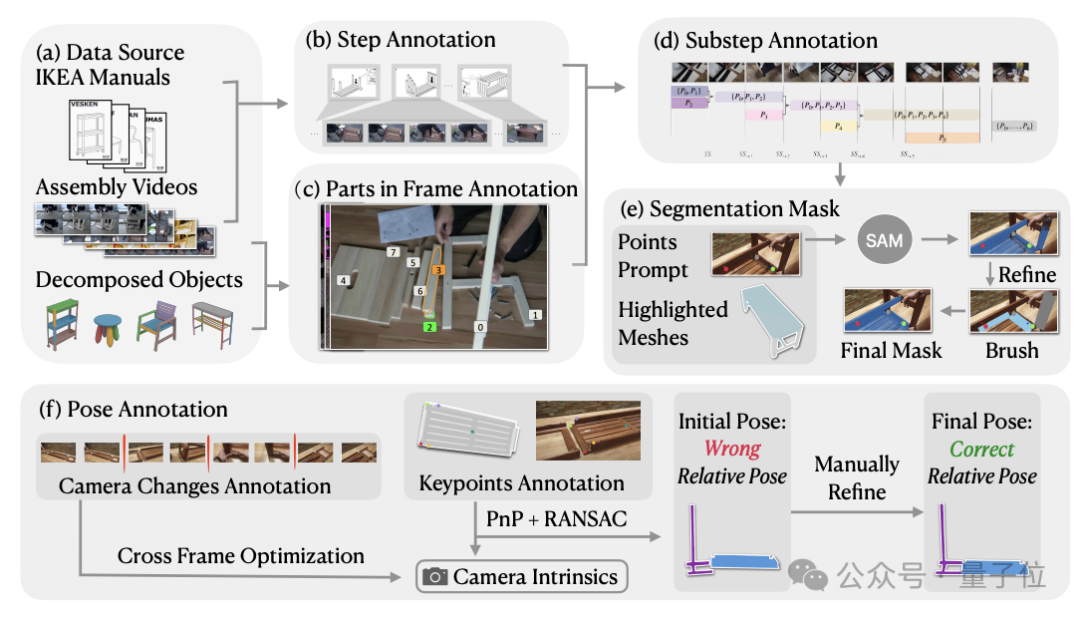

為了獲得高質(zhì)量的標(biāo)注,應(yīng)對(duì)真實(shí)視頻帶來的挑戰(zhàn),研究團(tuán)隊(duì)建立了一套可靠的標(biāo)注系統(tǒng):

- 識(shí)別并標(biāo)注相機(jī)參數(shù)變化的關(guān)鍵幀,確保片段內(nèi)的一致性;

- 結(jié)合2D-3D對(duì)應(yīng)點(diǎn)和RANSAC算法進(jìn)行相機(jī)參數(shù)估計(jì);

- 通過多視角驗(yàn)證和時(shí)序約束保證標(biāo)注質(zhì)量。

圖片

圖片

首先,研究者們首先定義了一套層次化的裝配過程描述框架,將整個(gè)裝配過程分為步驟、子步驟和視頻幀等多個(gè)層級(jí)。

作者首先從IAW數(shù)據(jù)集中提取每個(gè)手動(dòng)步驟的視頻片段,并將每個(gè)視頻片段分解為更小的間隔(子步驟)。

對(duì)于每個(gè)子步驟,作者以1FPS的速度采樣視頻幀,并在每個(gè)子步驟的第一幀中標(biāo)注出家具部件。

圖片

圖片

為了在整個(gè)組裝視頻中對(duì)家具部件進(jìn)行跟蹤,作者還在采樣幀中為3D部件注釋了2D圖像分割掩碼。

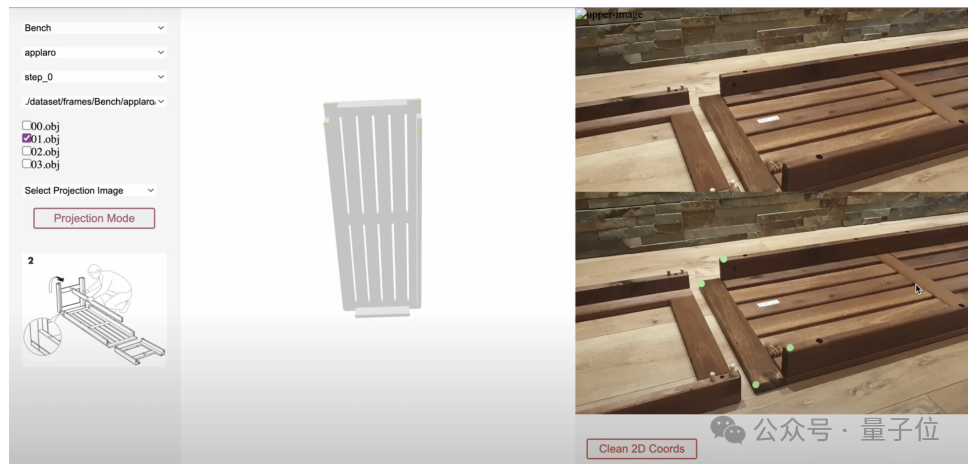

為了促進(jìn)注釋過程,研究團(tuán)隊(duì)開發(fā)了一個(gè)顯示輔助2D和3D信息的Web界面,同時(shí)該界面還可基于Segment Anything Model(SAM)模型進(jìn)行交互式掩碼注釋。

圖片

圖片

標(biāo)注過程中,標(biāo)注人員會(huì)在3D模型上選中零件,然后在2D視頻幀上指示其大致位置,并將其輸入到SAM模型中以實(shí)時(shí)生成2D分割掩碼。

為了解決SAM在提取具有相似紋理的部分之間或低光區(qū)域的邊界方面的固有局限,作者還允許標(biāo)注人員使用畫筆和橡皮擦工具進(jìn)行手動(dòng)調(diào)整。

此外,作者還要估計(jì)視頻中的相機(jī)參數(shù),為此研究者們首先人工標(biāo)記出視頻幀中可能出現(xiàn)相機(jī)運(yùn)動(dòng)(如焦距變化、切換視角等)的位置,然后標(biāo)注出視頻幀和3D模型之間的2D-3D對(duì)應(yīng)關(guān)鍵點(diǎn)。

最后,結(jié)合這兩類標(biāo)注信息,研究者們使用PnP (Perspective-n-Point)算法估計(jì)出每段視頻的相機(jī)內(nèi)參數(shù),得到相機(jī)參數(shù)的初始估計(jì)后,利用交互式工具來細(xì)化每個(gè)視頻幀中零件的6D姿態(tài)。

空間模型能力評(píng)估

基于IKEA Video Manuals數(shù)據(jù)集,團(tuán)隊(duì)設(shè)計(jì)了多個(gè)核心任務(wù)來評(píng)估當(dāng)前AI系統(tǒng)在理解和執(zhí)行家具組裝,以及空間推理(spatial reasoning)方面的能力。

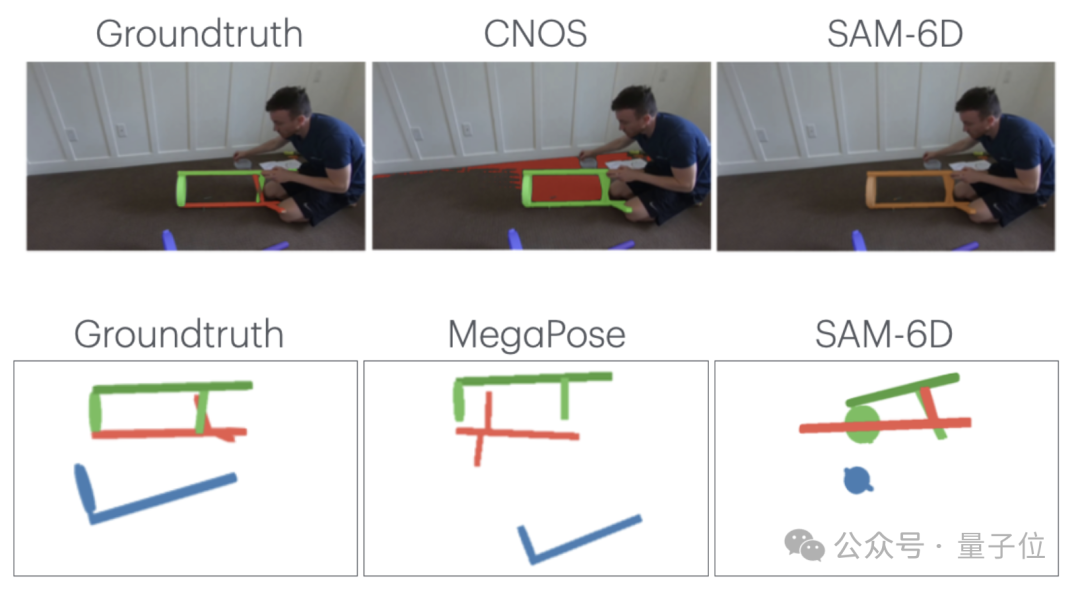

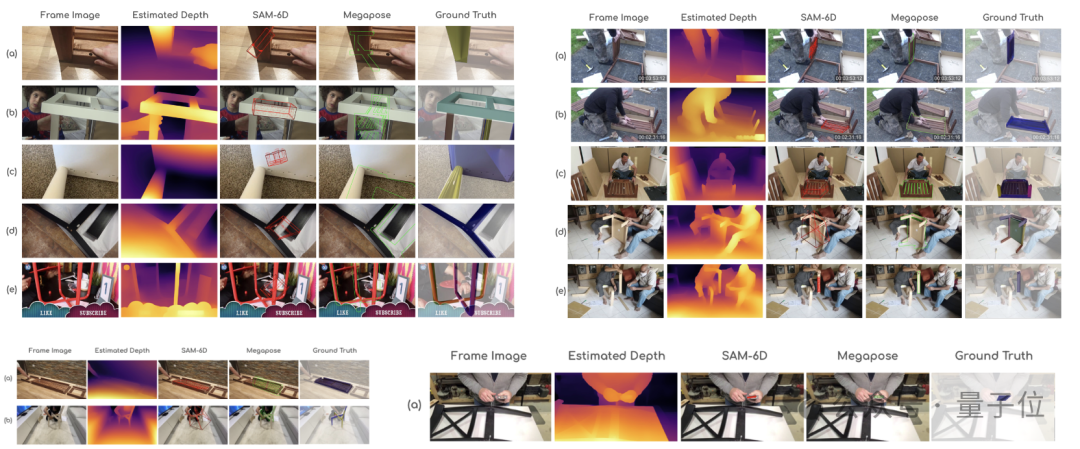

首先是基于3D模型的分割(Segmentation)與姿態(tài)估計(jì) (Pose Estimation)。

此類任務(wù)輸入3D模型和視頻幀,要求AI準(zhǔn)確分割出特定部件區(qū)域,并估計(jì)其在視頻中的6自由度姿態(tài)。

圖片

圖片

△上:基于3D模型的分割,下:基于3D模型的姿態(tài)估計(jì)

實(shí)驗(yàn)測(cè)試了最新的分割模型(CNOS, SAM-6D)和姿態(tài)估計(jì)模型(MegaPose)。

分析發(fā)現(xiàn),它們?cè)谝韵聢?chǎng)景表現(xiàn)不佳:

- 遮擋問題:手部遮擋、近距離拍攝導(dǎo)致部分可見、遮擋引起的深度估計(jì)誤差;

- 特征缺失:缺乏紋理的部件難以分割、對(duì)稱部件的方向難以判斷;

- 特殊拍攝角度(如俯視)導(dǎo)致的尺度誤判。

圖片

圖片

△上:遮擋問題,左下:特征缺失,右下:特殊角度

第二類任務(wù)是視頻目標(biāo)分割,作者對(duì)比測(cè)試了兩個(gè)最新的視頻追蹤模型SAM2和Cutie。

結(jié)果顯示,在真實(shí)組裝場(chǎng)景中,這些模型同樣面臨著三大挑戰(zhàn)。

一是相機(jī)的運(yùn)動(dòng),可能導(dǎo)致目標(biāo)丟失。

圖片

圖片

二是難以區(qū)分外觀相似的部件(如多個(gè)相同的桌腿)。

圖片

圖片

最后,保持長(zhǎng)時(shí)間追蹤的準(zhǔn)確度也存在一定難度。

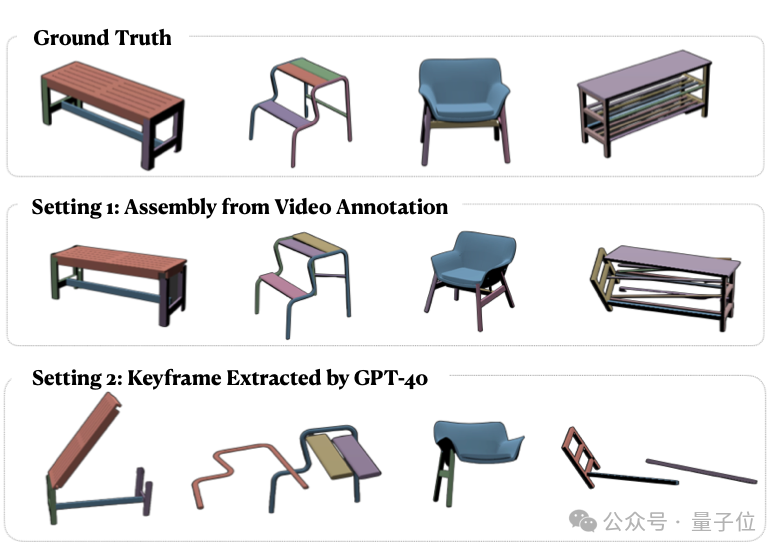

第三類任務(wù),是基于視頻的形狀組裝。

團(tuán)隊(duì)提出了一個(gè)創(chuàng)新的組裝系統(tǒng),包含關(guān)鍵幀檢測(cè)、部件識(shí)別、姿態(tài)估計(jì)和迭代組裝四個(gè)步驟。

實(shí)驗(yàn)采用兩種設(shè)置:

- 使用GPT-4V自動(dòng)檢測(cè)關(guān)鍵幀:結(jié)果不理想,Chamfer Distance達(dá)0.55,且1/3的測(cè)試視頻未能完成組裝;

- 使用人工標(biāo)注的關(guān)鍵幀:由于姿態(tài)估計(jì)模型的局限性,最終Chamfer Distance仍達(dá)0.33。

圖片

圖片

這些實(shí)驗(yàn)結(jié)果揭示了當(dāng)前AI模型的兩個(gè)關(guān)鍵局限:

- 視頻理解能力不足:當(dāng)前的視頻模型對(duì)時(shí)序信息的分析仍然較弱,往往停留在單幀圖像分析的層面;

- 空間推理受限:在真實(shí)場(chǎng)景的復(fù)雜條件下(如光照變化、視角改變、部件遮擋等),現(xiàn)有模型的空間推理能力仍顯不足。

作者簡(jiǎn)介

本項(xiàng)目第一作者,是斯坦福大學(xué)計(jì)算機(jī)科學(xué)碩士生劉雨濃(Yunong Liu)目前在斯坦福SVL實(shí)驗(yàn)室(Vision and Learning Lab),由吳佳俊教授指導(dǎo)。

圖片

圖片

她本科畢業(yè)于愛丁堡大學(xué)電子與計(jì)算機(jī)科學(xué)專業(yè)(榮譽(yù)學(xué)位),曾在德克薩斯大學(xué)奧斯汀分校從事研究實(shí)習(xí)。

斯坦福大學(xué)助理教授、清華姚班校友吳佳俊,是本項(xiàng)目的指導(dǎo)教授。

圖片

圖片

另據(jù)論文信息顯示,斯坦福大學(xué)博士后研究員劉蔚宇(Weiyu Liu),與吳佳俊具有同等貢獻(xiàn)。

圖片

圖片

此外,Salesforce AI Research研究主任Juan Carlos Niebles,西北大學(xué)計(jì)算機(jī)科學(xué)系助理教授、斯坦福訪問學(xué)者李曼玲(Manling Li)等人亦參與了此項(xiàng)目。

圖片

圖片

圖片

圖片

其他作者情況如下:

圖片

圖片

項(xiàng)目主頁:https://yunongliu1.github.io/ikea-video-manual/論文地址:https://arxiv.org/abs/2411.11409