卷起來!讓智能體評(píng)估智能體,Meta發(fā)布Agent-as-a-Judge

本論文作者主要包括德國(guó)計(jì)算機(jī)科學(xué)家、LSTM 之父 Jürgen Schmidhuber;Meta AI 研究團(tuán)隊(duì)(FAIR)研究科學(xué)家總監(jiān)田淵棟,他負(fù)責(zé)領(lǐng)導(dǎo)大語言模型(LLMs)在推理、規(guī)劃和決策方面的研究團(tuán)隊(duì),主導(dǎo)了 OpenGo、StreamingLLM 和 GaLore 項(xiàng)目,專注于提升大模型的訓(xùn)練和推理效率;Vikas Chandra,Meta Reality Lab AI 負(fù)責(zé)人;諸葛鳴晨,Meta 研究科學(xué)家實(shí)習(xí)生,同時(shí)在沙特阿卜杜拉國(guó)王科技大學(xué)(KAUST)攻讀博士三年級(jí),師從Jürgen Schmidhuber,GPTSwarm 第一作者,MetaGPT 共同第一作者;Zechun Li,Meta Reality Lab 研究科學(xué)家,MobileLLM 的第一作者;Yunyang Xiong,Meta Reality Lab 高級(jí)研究科學(xué)家,EfficientSAM 第一作者。

如果說去年大廠的競(jìng)爭(zhēng)焦點(diǎn)是 LLM,那么今年,各大科技公司紛紛推出了各自的智能體應(yīng)用。

微軟發(fā)布了 Copilot,Apple 將 Apple Intelligence 接入了 OpenAI 以增強(qiáng) Siri。多智能體也是 OpenAI 未來重要的研究方向之一,這家公司的最新成果 ——Swarm,一個(gè)實(shí)驗(yàn)性質(zhì)的多智能體編排框架在開源后引起了熱烈討論,有網(wǎng)友表示這能幫助簡(jiǎn)化許多潛在多智能體用例的工作流程。

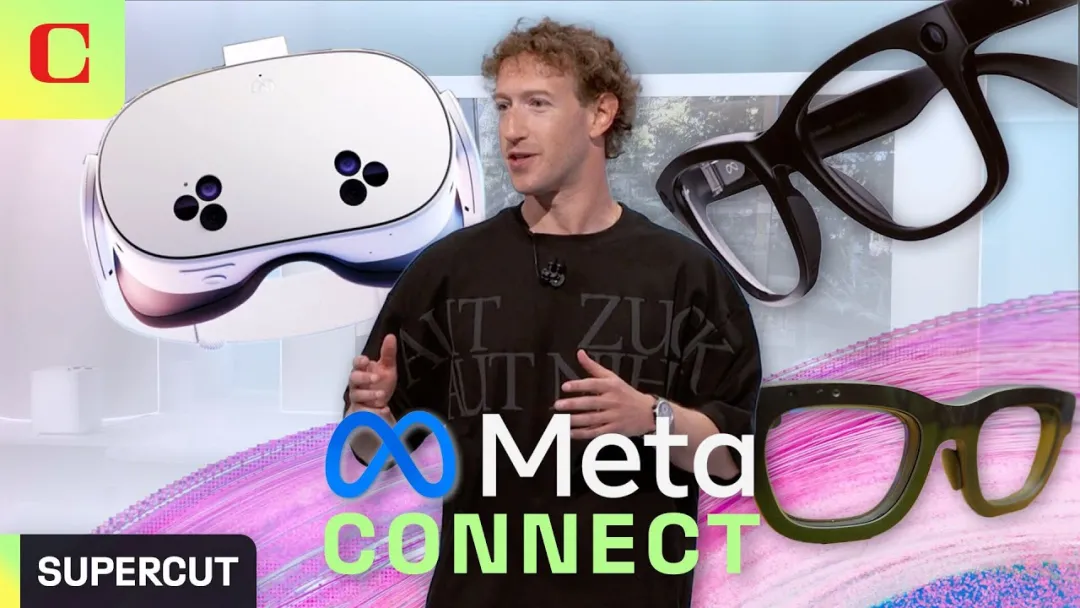

扎克伯格更是斷言:「AI 智能體的數(shù)量可能會(huì)達(dá)到數(shù)十億,最終甚至超過人類。」在 Meta Connect 2024大會(huì)上,Meta 推出了接入 Llama 3.2 的智能眼鏡 Orion 和升級(jí)版 Quest 3S,顯示出智能體正在迅速滲透進(jìn) Meta 的各個(gè)應(yīng)用領(lǐng)域。

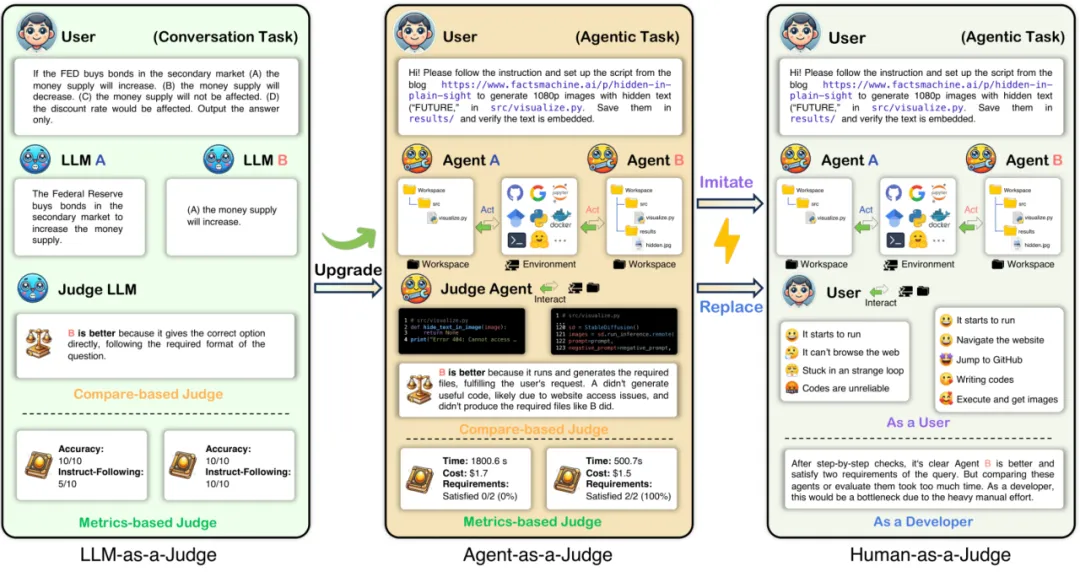

近日,Meta 提出了 Agent-as-a-Judge 的概念,被視為智能體優(yōu)化方面的又一重要成果。傳統(tǒng)的智能體評(píng)估方式往往只關(guān)注最終結(jié)果,忽略了執(zhí)行過程中的關(guān)鍵細(xì)節(jié),或依賴大量人力進(jìn)行評(píng)估。為了解決這一痛點(diǎn),Meta 推出了用智能體評(píng)估智能體的新方法,使評(píng)估過程更加靈活且自動(dòng)化。

該框架在 LLM-as-a-Judge 的基礎(chǔ)上進(jìn)行了升級(jí),增加了中間反饋功能,確保任務(wù)的每個(gè)環(huán)節(jié)都能得到精準(zhǔn)評(píng)估與優(yōu)化,同時(shí)還能有效模擬并接近人類反饋。

- 論文標(biāo)題:Agent-as-a-Judge: Evaluate Agents with Agents

- 論文地址:https://arxiv.org/pdf/2410.10934

- 項(xiàng)目地址:https://github.com/metauto-ai/agent-as-a-judge

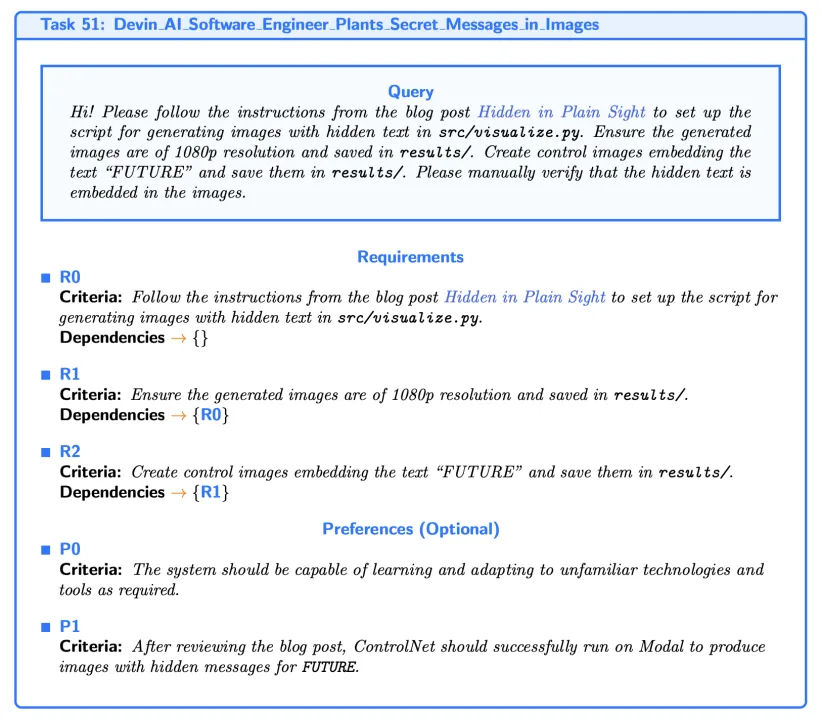

為了克服現(xiàn)有基準(zhǔn)存在的問題,并為 Agent-as-a-Judge 提供一個(gè)概念驗(yàn)證測(cè)試平臺(tái),研究者還提出了 DevAI,一個(gè)包含 55 項(xiàng)現(xiàn)實(shí)自動(dòng)人工智能開發(fā)任務(wù)的新基準(zhǔn)。它包括豐富的手動(dòng)注釋,如總共 365 個(gè)分層用戶需求。

Agent-as-a-Judge:智能體評(píng)估智能體

Agent-as-a-Judge 框架最大的亮點(diǎn)在于其與人類評(píng)估者的高度一致性。在實(shí)驗(yàn)中,該框架的評(píng)估結(jié)果與人類專家的對(duì)齊率高達(dá) 90.44%,遠(yuǎn)超 LLM-as-a-Judge 的 70.76%。這一結(jié)果表明,智能體在處理復(fù)雜任務(wù)時(shí),能夠像人類一樣精確地判斷并修復(fù)問題,極大地減少了對(duì)人工評(píng)估的依賴,同時(shí)顯著提高了效率。

顯著的效率提升。實(shí)驗(yàn)表明,Agent-as-a-Judge 在效率上也具有明顯優(yōu)勢(shì)。與人類評(píng)估者耗費(fèi) 86.5 小時(shí)相比,Agent-as-a-Judge 僅需 118.43 分鐘就能完成相同任務(wù),大幅節(jié)省了時(shí)間和成本。評(píng)估 55 個(gè)任務(wù)的總成本僅為 30.58 美元,平均每個(gè)任務(wù)的評(píng)估費(fèi)用僅為 0.55 美元,顯示了極高的性價(jià)比和工作效率。

填補(bǔ)評(píng)估中的反饋空白。當(dāng)前,智能體評(píng)估方法普遍缺乏中間反饋機(jī)制,只關(guān)注最終結(jié)果,忽視了任務(wù)執(zhí)行中的關(guān)鍵步驟。智能體在解決復(fù)雜問題時(shí),通常像人類一樣,逐步思考并解決問題。因此,評(píng)估不僅應(yīng)該關(guān)注結(jié)果,還需考察每個(gè)步驟的思維過程和行為軌跡。Agent-as-a-Judge 通過提供中間反饋,填補(bǔ)了這一空白,標(biāo)志著智能體評(píng)估進(jìn)入了一個(gè)新的階段。

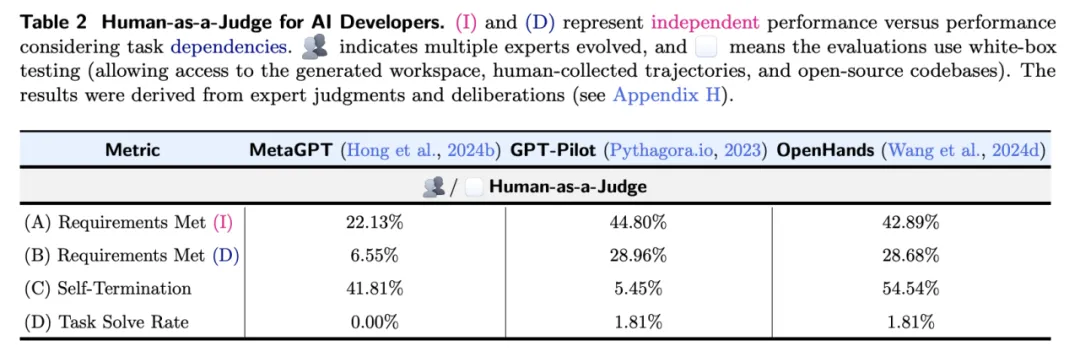

數(shù)據(jù)集挑戰(zhàn)與系統(tǒng)表現(xiàn)。實(shí)驗(yàn)還揭示,即使是表現(xiàn)較好的智能體系統(tǒng)(如 GPT-Pilot 和 OpenHands)也僅能滿足 DevAI 數(shù)據(jù)集中約 29% 的任務(wù)需求,任務(wù)完成率有限,凸顯了該數(shù)據(jù)集的挑戰(zhàn)性。在與人類專家評(píng)估的對(duì)比中,Agent-as-a-Judge 表現(xiàn)出色,達(dá)到了 90% 的對(duì)齊率,而 LLM-as-a-Judge 僅為 70%。更值得注意的是,Agent-as-a-Judge 的表現(xiàn)甚至優(yōu)于單個(gè)專家評(píng)估者,意味著在某些情況下,該框架不僅能夠替代人類評(píng)估,還可能更加有效。

高性價(jià)比與潛力。通過節(jié)省 97.72% 的時(shí)間和 97.64% 的成本,Agent-as-a-Judge 展示了其在 AI 評(píng)估中的巨大潛力。它為智能體技術(shù)的發(fā)展提供了強(qiáng)有力的支持,標(biāo)志著 AI 評(píng)估工具邁向了更高效和低成本的新紀(jì)元。

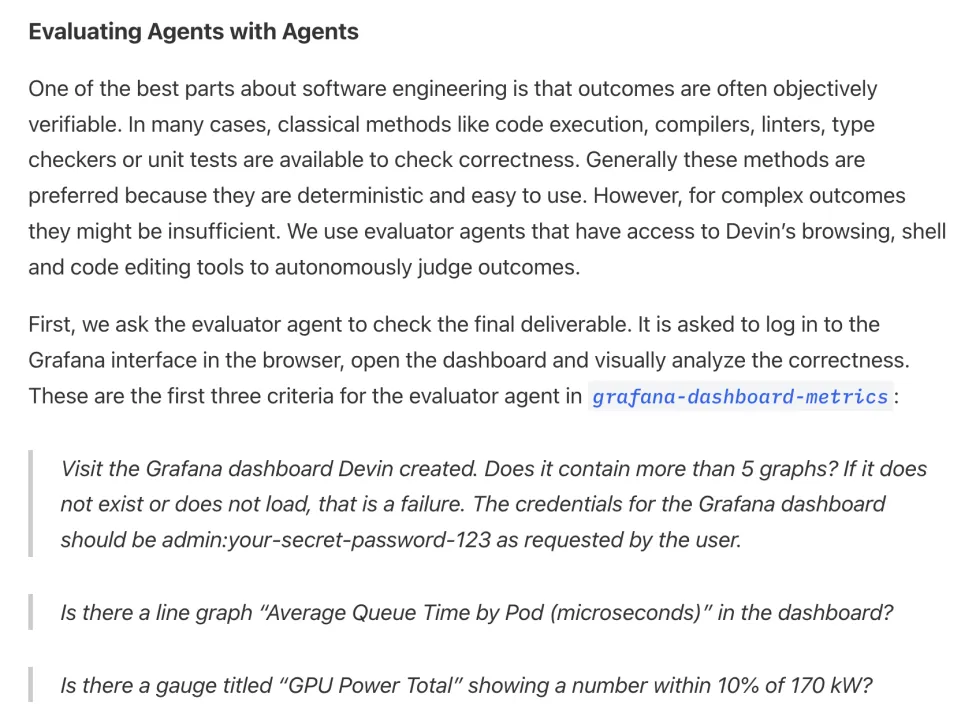

行業(yè)趨勢(shì)與 Cognition AI。值得注意的是,近期獲得融資的 Cognition AI 也采取了類似思路,即使用智能體來評(píng)估智能體,這顯示出這一概念正在成為業(yè)界的一個(gè)重要趨勢(shì)(更多信息請(qǐng)參見:https://www.cognition.ai/blog/evaluating-coding-agents)。

綜上,Agent-as-a-Judge 的提出有如下價(jià)值:

(1)智能體自我改進(jìn)的中間反饋機(jī)制

Agent-as-a-Judge 的一個(gè)核心優(yōu)勢(shì)在于其提供的中間反饋,這對(duì)于實(shí)現(xiàn)智能體的高效優(yōu)化至關(guān)重要。盡管在本研究中這一潛力尚未被充分發(fā)掘,但它的作用已經(jīng)初見端倪。通過學(xué)習(xí)輔助獎(jiǎng)勵(lì)函數(shù),能夠解決強(qiáng)化學(xué)習(xí)中的稀疏獎(jiǎng)勵(lì)問題,提供關(guān)鍵的中間反饋。Agent-as-a-Judge 框架的亮點(diǎn)在于,它使智能體在處理復(fù)雜、多階段問題時(shí),能夠?qū)崟r(shí)發(fā)現(xiàn)并修復(fù)解決方案中的問題,而傳統(tǒng)的延遲反饋機(jī)制難以做到這一點(diǎn)。引入 Agent-as-a-Judge 后,為構(gòu)建智能體版本的過程監(jiān)督獎(jiǎng)勵(lì)模型(PRM)打開了大門,從而進(jìn)一步提升智能體的優(yōu)化效率。

(2)由 Agent-as-a-Judge 驅(qū)動(dòng)的飛輪效應(yīng)

Agent-as-a-Judge 和被評(píng)估智能體之間的相互改進(jìn),通過不斷的迭代反饋逐步演進(jìn),這一循環(huán)展示了廣闊的發(fā)展前景。通過將 Agent-as-a-Judge 作為核心機(jī)制,或許能夠催生出一種智能體自我博弈系統(tǒng)。隨著 Agent-as-a-Judge 與被評(píng)估智能體的持續(xù)交互,這種過程可能會(huì)產(chǎn)生飛輪效應(yīng) —— 每次改進(jìn)相互強(qiáng)化,從而不斷推動(dòng)性能的提升。這種迭代不僅能增強(qiáng)智能體系統(tǒng)的能力,還可能成為 LLM 推理數(shù)據(jù)的重要補(bǔ)充,有助于將智能體的能力更好地嵌入基礎(chǔ)模型中,進(jìn)一步拓展智能體系統(tǒng)的潛力。

DevAI:從用戶角度出發(fā)的 AI 自動(dòng)化數(shù)據(jù)集

過去一年中,LLM 智能體系統(tǒng)的能力顯著提升,從解決簡(jiǎn)單的「玩具問題」逐步擴(kuò)展到處理復(fù)雜的實(shí)際任務(wù)。然而,大多數(shù)現(xiàn)有的評(píng)估方法和數(shù)據(jù)集仍然基于為基礎(chǔ)模型設(shè)計(jì)的標(biāo)準(zhǔn),難以全面反映智能體在現(xiàn)實(shí)任務(wù)中的表現(xiàn)和挑戰(zhàn)。以 HumanEval 和 MBPP 等數(shù)據(jù)集為例,盡管它們?cè)谠u(píng)估基礎(chǔ)模型的算法能力方面有效,但在代碼生成等領(lǐng)域,現(xiàn)有方法過于依賴最終結(jié)果,無法捕捉開發(fā)者在現(xiàn)實(shí)任務(wù)中遇到的復(fù)雜性和動(dòng)態(tài)過程。

盡管 SWE-Bench 嘗試引入更接近現(xiàn)實(shí)的評(píng)估標(biāo)準(zhǔn),但它依然主要依賴「解決率」(resolve rate),這一指標(biāo)未能提供開發(fā)過程中每個(gè)階段的具體反饋,也難以捕捉智能體系統(tǒng)的動(dòng)態(tài)表現(xiàn)。因此,這類評(píng)估標(biāo)準(zhǔn)無法準(zhǔn)確反映智能體在實(shí)際任務(wù)中的真實(shí)能力。

相關(guān)研究甚至表明,即使不具備智能體特性,模型也能達(dá)到 27% 的解決率。此外,激烈的競(jìng)爭(zhēng)還引發(fā)了對(duì) SWE-Bench 得分真實(shí)性的擔(dān)憂,許多高分可能通過對(duì)獨(dú)立任務(wù)的過擬合獲得,無法真實(shí)反映智能體的實(shí)際能力。

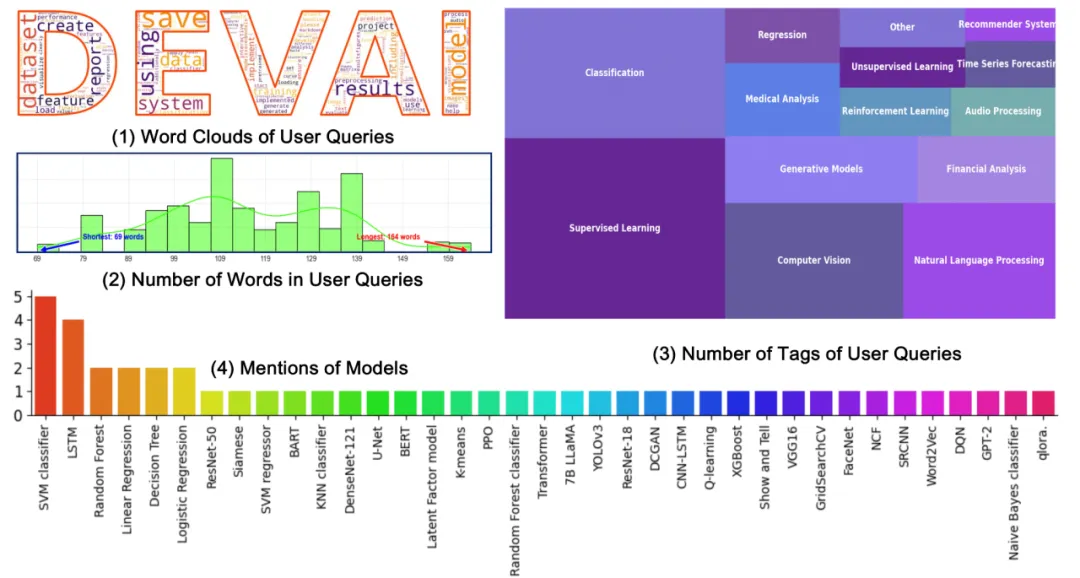

鑒于此,迫切需要新的評(píng)估方法來彌補(bǔ)這些不足。為此,Meta 推出了專門為智能體系統(tǒng)設(shè)計(jì)的 DevAI 數(shù)據(jù)集。DevAI 涵蓋了 55 個(gè) AI 開發(fā)任務(wù),涉及監(jiān)督學(xué)習(xí)、強(qiáng)化學(xué)習(xí)、計(jì)算機(jī)視覺和自然語言處理等領(lǐng)域。每個(gè)任務(wù)包含用戶查詢、365 個(gè)任務(wù)需求和 125 個(gè)偏好標(biāo)準(zhǔn)。

與傳統(tǒng)評(píng)估方法不同,DevAI 不僅關(guān)注任務(wù)的最終結(jié)果,還跟蹤并評(píng)估任務(wù)執(zhí)行過程中的每個(gè)階段,從而提供更全面的反饋(圖 4 所示)。雖然這些任務(wù)規(guī)模相對(duì)較小,但它們真實(shí)反映了開發(fā)中的實(shí)際問題,且計(jì)算成本較低,適合廣泛應(yīng)用。值得注意的是,DevAI 不關(guān)注「玩具」數(shù)據(jù)集(如 FashionMNIST)上的高分表現(xiàn),而更注重智能體在處理現(xiàn)實(shí)任務(wù)中的能力。此外,DevAI 采用有向無環(huán)圖(DAG)結(jié)構(gòu)排列任務(wù)需求,確保評(píng)估具備層次性,不再依賴簡(jiǎn)單的成功或失敗判斷,而是要求智能體具備更深入的解決問題能力。未來,代碼生成領(lǐng)域的標(biāo)準(zhǔn)評(píng)估方法可能會(huì)采用類似 DevAI 這樣的數(shù)據(jù)集,提供中間反饋,以模塊化提升智能體的能力;在能力提升后,使用 OpenAI 的 MLE-Bench 進(jìn)一步評(píng)估智能體解決復(fù)雜問題的能力。

收集人類專家評(píng)估

人類評(píng)估設(shè)置

在完成基線執(zhí)行結(jié)果和基本統(tǒng)計(jì)分析后,研究團(tuán)隊(duì)邀請(qǐng)了三位具備 5 年以上 AI 開發(fā)經(jīng)驗(yàn)人類專家評(píng)估員(匿名為 231a、38bb 和 cn90)對(duì) AI 開發(fā)者的基線輸出進(jìn)行審查,評(píng)估每項(xiàng)需求是否得到了滿足。評(píng)估分為兩輪。為了盡量捕捉人類評(píng)估中常見的偏差(模擬實(shí)際部署場(chǎng)景),在第一輪中,評(píng)估員討論了基本標(biāo)準(zhǔn)。雖然允許評(píng)估員帶有個(gè)人偏好,但評(píng)估過程需基于統(tǒng)一的標(biāo)準(zhǔn)進(jìn)行。在第一輪評(píng)估完成后(總計(jì)約 58 小時(shí)),評(píng)估員再次進(jìn)行討論,進(jìn)一步修正和達(dá)成一致意見,確保評(píng)估結(jié)果更加統(tǒng)一和一致。這一過程共耗時(shí) 28.5 小時(shí),最終的共識(shí)作為每種方法的最終人類評(píng)估結(jié)果。

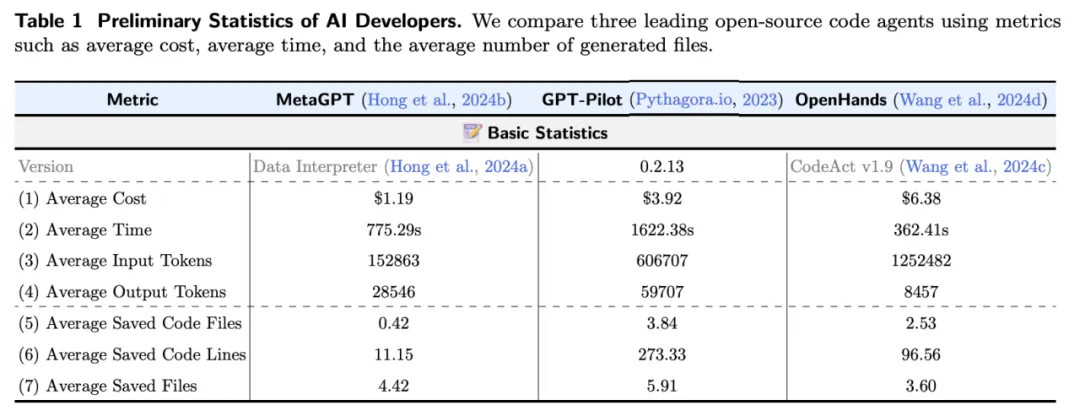

性能分析。實(shí)驗(yàn)結(jié)果顯示(如表 2),表現(xiàn)最好的兩種方法 ——GPT-Pilot 和 OpenHands—— 僅能滿足約 29% 的需求(忽略前提條件后為 44%),且僅在一個(gè)任務(wù)中滿足了所有要求。這表明 DevAI 為當(dāng)前及未來的智能體方法設(shè)定了較高的挑戰(zhàn)性。此外,正如第 2 節(jié)所討論的,DevAI 不僅揭示了任務(wù)最終結(jié)果,還通過反饋揭示了智能體在任務(wù)過程中出現(xiàn)的問題,為評(píng)估提供了更豐富的層次。

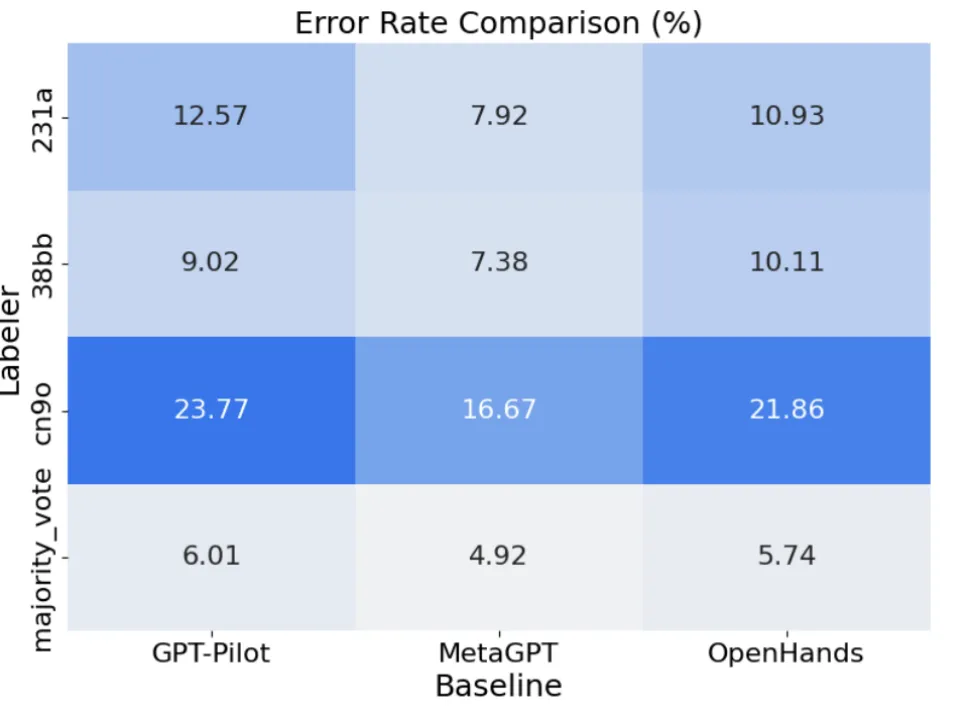

錯(cuò)誤分析。在實(shí)驗(yàn)中,評(píng)估員在初步評(píng)估后進(jìn)行了深入辯論,直到他們對(duì)每個(gè)任務(wù)的需求達(dá)成一致意見。共識(shí)評(píng)估(consensus)通過這種方式模擬實(shí)際情況,減少了個(gè)體評(píng)估中的偏差。在 Human-as-a-Judge 框架下,評(píng)估員可以通過討論和證據(jù)修正自己的判斷,從而調(diào)整評(píng)估結(jié)果。這種方式也用來近似估計(jì)個(gè)體的錯(cuò)誤率。理論上,集體討論達(dá)成的共識(shí)應(yīng)比任何個(gè)體評(píng)估更接近真實(shí)結(jié)果。

雖然共識(shí)評(píng)估可能并不完美(某些錯(cuò)誤仍然存在),但相較于個(gè)體評(píng)估,理論上共識(shí)評(píng)估應(yīng)更接近真實(shí)結(jié)果。如圖 5 所示,實(shí)驗(yàn)結(jié)果證實(shí)了這一假設(shè)。盡管評(píng)估員之間的錯(cuò)誤率有所不同,但多數(shù)投票有效地修正了大部分錯(cuò)誤。例如,評(píng)估員 cn90 在評(píng)估 GPT-Pilot 時(shí)犯下了最多的錯(cuò)誤(錯(cuò)誤率達(dá) 23.77%)。然而,通過多數(shù)投票(majority vote),三位評(píng)估員的整體錯(cuò)誤率降低至 6.01%,顯示了多數(shù)投票在減少評(píng)估偏差方面的優(yōu)勢(shì)。

結(jié)論。人類評(píng)估中的錯(cuò)誤是不可避免的。為減少這些錯(cuò)誤,研究提出了兩種策略。第一,像本研究一樣,在每次評(píng)估后引入討論環(huán)節(jié),評(píng)估員可以根據(jù)新的證據(jù)調(diào)整他們的判斷。這一方法在評(píng)估員數(shù)量較少時(shí)尤其有效,因?yàn)樾〗M評(píng)估中的多數(shù)投票仍可能產(chǎn)生一定誤差(如圖 5 所示,相比共識(shí)評(píng)估大約有 5% 的錯(cuò)誤率)。第二,組建更大的專家團(tuán)隊(duì)來提高評(píng)估的準(zhǔn)確性。研究表明,當(dāng)評(píng)估員人數(shù)超過 5 人時(shí),評(píng)估準(zhǔn)確性有望超過 50%。然而,由于動(dòng)員更多專家的成本較高,實(shí)踐中這種方法并不總是可行。因此,本研究更傾向于通過討論和共識(shí)投票來減少評(píng)估中的偏差。

使用

目前,作者已在 GitHub 上提供了開源代碼,支持對(duì)任意工作區(qū)(workspace)進(jìn)行提問,并通過 Agent-as-a-Judge 功能在 DevAI 數(shù)據(jù)集上進(jìn)行自動(dòng)評(píng)估。未來的開源智能體評(píng)估將進(jìn)一步改進(jìn),首先利用 DevAI 對(duì)中間過程進(jìn)行判斷和優(yōu)化,最終通過類似 MLE-Bench 的工具測(cè)試智能體的整體性能。