港大新型圖基礎模型AnyGraph:挑戰Scaling Law,精準建模多樣化結構模式和特征空間

新型圖基礎模型來了——

AnyGraph,基于圖混合專家(MoE)架構,專門為實現圖模型跨場景泛化而生。

通過MoE架構、路由算法、SVD方法和MLP網絡等,AnyGraph解決了跨域和域內圖異構性問題,并進行了高效跨域模型訓練。

能夠精準建模多樣化的結構模式和特征空間。

在38個不同領域數據集上進行實驗,AnyGraph在零樣本預測、擴展定律、消融實驗和效率實驗等方面均表現出色。

AnyGraph由來自香港大學的研究人員完成。

關于AnyGraph的更多細節我們接著往下看。

AnyGraph長啥樣?

隨著圖結構數據在各個領域的日益普及,對具有出色泛化能力的圖學習模型的需求愈發迫切。

現實應用中,圖學習模型需有效應對分布偏移并適應新的圖領域,但當前的先進模型在真正的泛化性能方面往往表現不足,嚴重依賴繁重的微調過程,難以適應實際應用中多樣的圖結構和分布。

受成功的基礎模型在理解視覺和語言數據方面的啟發,通用的圖基礎模型具有巨大潛力,可從多樣的圖結構數據中學習可遷移的表示,從而高效適應各種圖領域和任務。

然而,構建有效的自適應圖基礎模型面臨諸多挑戰,包括:

- 結構異質性:不同圖數據集的結構特性和數據分布多樣,如節點度分布和圖結構復雜度的差異,有效處理這種多樣性對開發統一模型至關重要。

- 特征異質性:圖的節點和邊特征具有異質性,包括特征的類型、維度和語義的差異,有效處理特征異質性對構建通用圖模型至關重要。

- 快速適應能力:有效圖基礎模型應能快速適應新的圖數據集和領域,無需大量重新訓練或微調,能快速調整參數和學習策略以應對新圖數據的結構和分布特征。

- 擴展定律:像計算機視覺和自然語言處理領域的成功基礎模型一樣,圖基礎模型應能展現出擴展定律,即性能隨著模型規模或訓練數據集的增加而系統提升,通過利用這一現象,圖基礎模型能解鎖前所未有的能力和泛化能力。

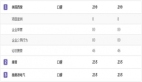

為應對這些挑戰,該論文提出了基于混合專家(MoE)架構的 AnyGraph模型。

圖混合專家框架

解決跨域圖異構性

為了建模不同應用領域之間的異構圖結構模式,AnyGraph采用了一種混合專家(Mixture-of-Expert,MoE)的模型架構。

該架構由多個圖專家模型組成,每個模型都可以獨立對輸入的圖數據進行預測。

在設計中,不同的專家模型應當負責處理具有特定模式的圖數據。

AnyGraph設計了一種路由算法,用于將輸入的圖數據分配給最善于處理它的專家模型,進行訓練或者預測。

圖專家路由算法

基于圖自監督學習任務的有效性,AnyGraph的路由算法采用一種自監督的損失函數,通過計算專家模型在輸入圖上的自監督損失大小,來衡量模型與該輸入數據的匹配程度。

具體來說,AnyGraph在輸入圖數據中采樣一定的邊作為正例,并隨機采樣同樣數量的節點對作為負例。

通過計算專家模型對兩種邊預測分數的差值,可以看出模型對正例的識別能力,用于代表模型與數據的匹配程度。

基于訓練頻率的路由修正

盡管上述方法可以高效、準確地找到最善于處理輸入數據的專家模型,但該方法常常造成一種“贏者通吃”的次優結果:

由于訓練早期的各種隨機因素,極少數專家模型,甚至一個模型,形成了對其他專家模型的優勢,路由算法因此不再將訓練數據分配給其他模型,造成了其他模型基本未經訓練、而最優模型過于通用無法專精的結果。

這種情況與原本的設計不同,無法做到每個模型專注于處理特定類別的圖數據。

因此,AnyGraph維護每個專家的訓練次數信息,將其納入匹配分數的計算中去,為較少經歷訓練的專家模型提供更多的訓練機會。

AnyGraph的快速適應能力

值得注意的是,基于上述MoE架構,AnyGraph在每次訓練和測試的過程中,僅需要激活它1/K的模型參數。

這意味著計算時間和存儲開銷上的極大優化,使其相對于同參數的其它非MoE模型具有極大的效率和適應性優勢。

因此,AnyGraph在應對新數據時可以進行高效的微調;當面臨和一些原始訓練數據差距極大的情況時,還可以避免新數據對原本的模型參數產生過大的影響。

自適應且高效的圖專家模型

解決域內圖異構性

不同圖數據的鄰接矩陣和特征通常具有不同的維度,為了彌合這一差距,AnyGraph的圖專家模型進行結構和特征統一,具有不同維度的鄰接矩陣和節點特征矩陣被映射為具有固定維度的初始節點表征。

基于奇異值分解(SVD)在提取重要隱特征方面的有效性,AnyGraph利用SVD方法來構建這一統一映射過程。

具體來說,研究人員使用SVD對鄰接矩陣和特征矩陣分別進行特征分解,每次得到兩個具有固定維度的節點特征矩陣,以及一個特征值對焦矩陣。

研究人員將這些信息進行整合、歸一化,得到具有相同維度的節點初始特征矩陣,而這些矩陣記錄了原始鄰接矩陣和特征矩陣的信息,又具有了相同的維度。

使用SVD進行這一過程具有一些潛在的優勢。

SVD這種壓縮方法會按照隱含特征維度的重要程度進行排序,也就是說,其結果的第一個特征維度是SVD認為最重要的維度,而最后一個維度是其認為最不重要的特征維度。

這一特性潛在地規整了不同數據集之間的SVD特征,后續模型可以根據這一特點更容易地學習通用的預測網絡。

高效且強大的特征編碼

為了在保持效率的同時獲得對圖特征建模的強大能力,AnyGraph的圖專家模型采用多層感知機網絡(MLP)進行可學習的預測。

值得注意的是,每個專家模型都只采用了簡單的MLP網絡,這種設計無法進行復雜的圖關系建模,例如GAT和GraphTransformer中的結構學習能力。

但AnyGraph在頂層采用了MoE架構,它的設計初衷是通過多樣化但簡單的特征變換來處理總體上復雜的圖學習任務。通過集成多個特征變換MLP,AnyGraph可以成功覆蓋不同的圖數據子集,達到強大的圖預測能力。

高效的跨域模型訓練

為了最大化AnyGraph的跨圖泛化能力,AnyGraph的訓練樣本是由不同數據集的訓練樣本混合并隨機排序得到。

每個批次的訓練樣本包含一個圖、該圖當中一個批次的邊、該圖的預處理信息(初始節點表征和分配的最佳專家模型)。

AnyGraph采用廣泛應用的邊預測任務作為預訓練任務,使用交叉熵損失作為優化目標。在訓練過程中,研究人員會進行定期的特征和結構擴充,包括重新進行基于SVD的表征初始化、在專家路由時進行結構采樣。

AnyGraph效果如何?

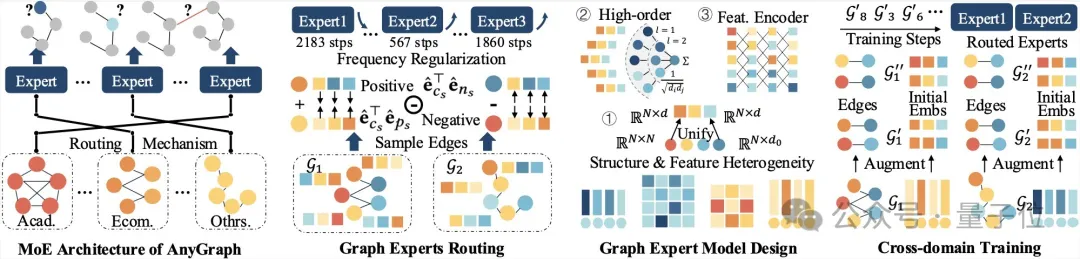

AnyGraph的實驗驗證采用了38個來自不同應用領域的圖數據集,包括鏈路預測和節點分類兩個類別,涵蓋電商場景(用戶的購買、瀏覽和評分行為,商品間的共現關系),學術網絡(論文的引用關系及學者的合作關系),生物信息網絡(藥品、蛋白質之間的相互影響關系),以及諸如郵件網絡、網站之間的鏈接關系、以及道路網絡。

為了更好地進行跨數據集的綜合性評價,實驗將所有數據集劃分為兩個數據集集合Link1和Link2,它們在總體上和單個領域內都具有相近數量的邊,但各自包含的數據集不具有相同來源和相同的特征構建方法。

研究人員使用其中一個訓練模型,并在另一個集合上進行零樣本測試。此外,所有數據集還按照應用領域劃分成了電商、學術網絡和其他三種類別,以進行更細致的領域測試,其他類別主要由生物信息網絡組成,包含了其他較小的類別。

零樣本預測能力

首先進行了AnyGraph和基線方法的對比實驗,基線方法包括圖神經網絡、圖預訓練方法、圖提示微調方法、以及兩種圖基礎模型。

可以觀察到在不同數據集上的零樣本預測優勢。

此外,圖預訓練和提示微調方法在跨數據集場景下常常表現出更差的效果,這凸顯了跨數據、跨場景進行預訓練的困難,這樣做很難提取具有通用性的不變特征。

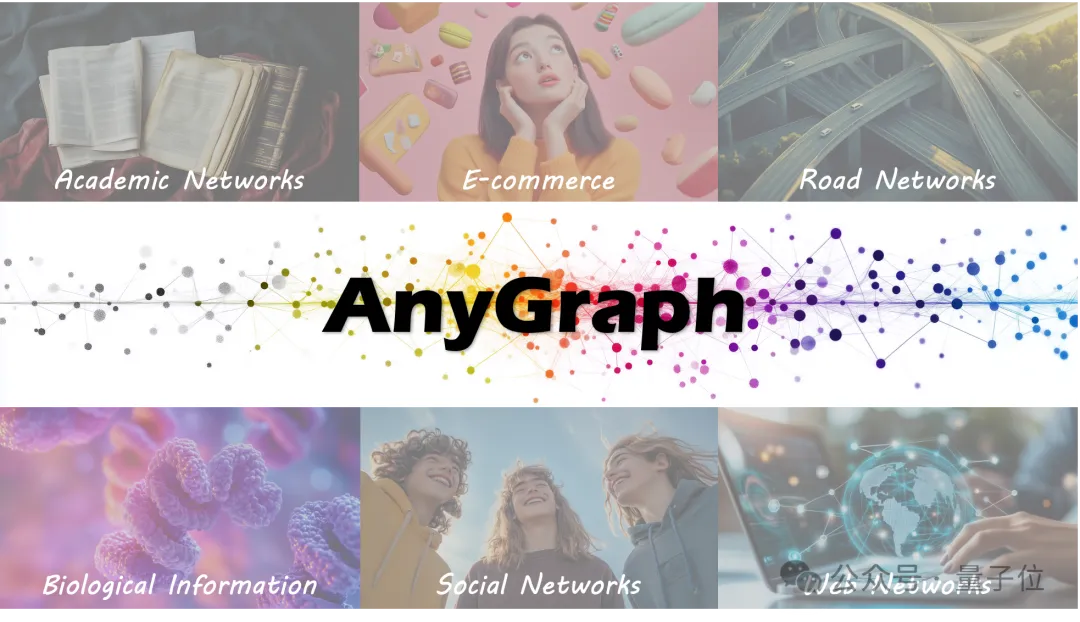

AnyGraph的擴展定律

在調整模型參數量和訓練數據量的情況下,實驗測試了AnyGraph的零樣本和全樣本預測性能。

可以觀察到,盡管全樣本預測性能很早就出現了收斂,但零樣本預測能力卻能夠隨著參數量和數據量的增長而不斷增長,并出現了一些突變性的增長。

這體現了AnyGraph的零樣本預測能力符合擴展定律的特點,并提示了它的涌現能力。

研究人員認為,這種圖模型的擴展定律有兩個關鍵因素。

首先,測試任務需要具有一定的難度,而全樣本的圖監督學習任務過于容易,模型的擴展定律很容易遇到邊際效應。

其次,對于跨場景、跨圖的圖預測來說,它固有的特征和結構異質性問題使得MoE這樣的松散模型結構更容易捕捉通用的不變性特征。

此外,研究人員觀測到當訓練數據總量不足時,引入新的訓練數據反而可能造成模型效果的下降,這源于訓練數據具有特別的分布特點、在模型中引入了bias。當模型訓練數據充足時,這一問題就自然消解了。

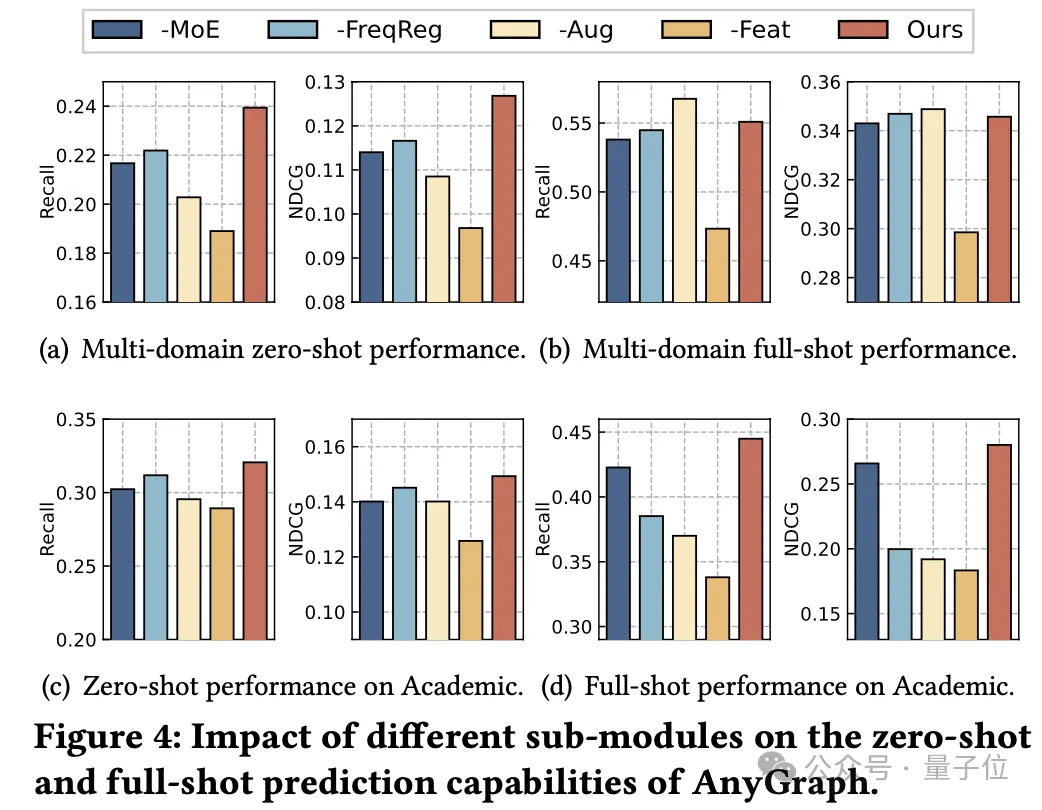

消融實驗

消融實驗驗證了AnyGraph的以下關鍵性設計:MoE架構、對節點特征的利用、路由算法中的訓練頻率正則、訓練過程中的數據擴充。

結果顯示了這些設計對模型的零樣本和全樣本預測性能存在顯著的正面影響。

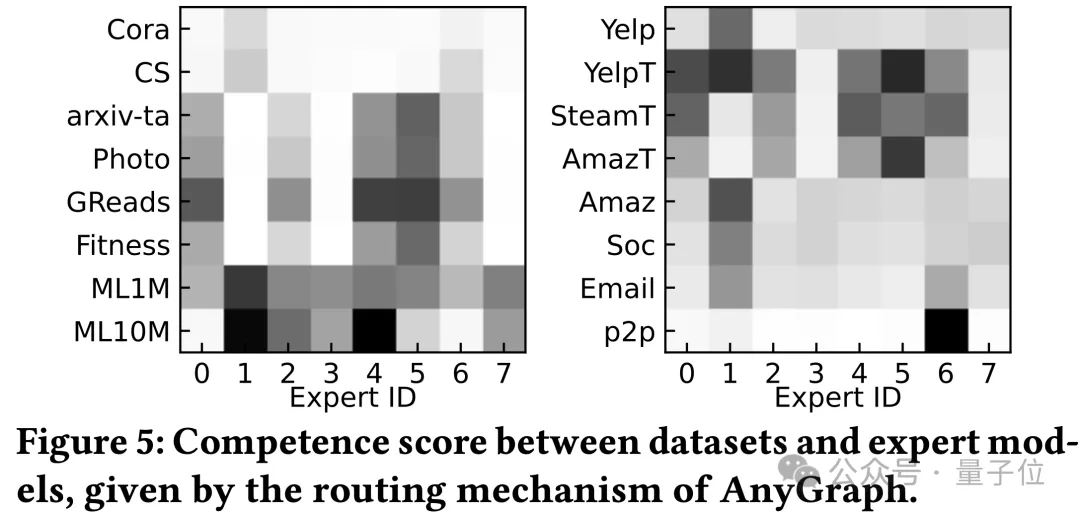

路由算法研究

上圖展示了AnyGraph路由機制的分配結果。

可以看到,具有相同來源(例如ML1M和ML10M)、具有相同特征構建方法(例如arxiv-ta、Photo、GReads、Fitness)的數據集,通常會被分配給相同的專家模型,這體現了路由機制能夠準確捕捉數據集的不同特點,分配給不同的專家模型進行處理。

效率實驗

為了驗證模型的效率和快速適應能力,研究人員測試了AnyGraph在微調時的效果增長曲線,以及固定訓練步數的時間開銷。

可以看到,由于AnyGraph采用了MoE架構,它僅需要激活小部份的參數進行訓練,這極大地減少了模型的訓練時間。

同時,由于AnyGraph出色的零樣本預測能力,以及它基于MoE架構的快速調整能力,AnyGraph可以更快、更好地進行模型微調。

項目地址:https://github.com/HKUDS/AnyGraph

論文鏈接:https://arxiv.org/pdf/2408.10700

實驗室主頁:https://sites.google.com/view/chaoh