Hint-AD:面向可解釋端到端!語言與感知-預(yù)測-規(guī)劃全面對齊,助力多項任務(wù)SOTA

本文經(jīng)自動駕駛之心公眾號授權(quán)轉(zhuǎn)載,轉(zhuǎn)載請聯(lián)系出處。

寫在前面&出發(fā)點

自動駕駛中的端到端架構(gòu)在可解釋性方面面臨重大挑戰(zhàn),這阻礙了人機(jī)之間的信任。為了執(zhí)行諸如駕駛解釋和3D字幕生成等任務(wù),已探索過了人性化的自然語言。然而,以往的工作主要關(guān)注于聲明式可解釋性的范式,其中自然語言解釋并未以自動駕駛系統(tǒng)的中間輸出為基礎(chǔ),導(dǎo)致這些解釋僅具有聲明性質(zhì)。相比之下,對齊式可解釋性在語言與自動駕駛系統(tǒng)的中間輸出之間建立了聯(lián)系。在此,我們介紹了Hint-AD,這是一個集成的自動駕駛-語言系統(tǒng),能夠生成與自動駕駛模型的整體感知-預(yù)測-規(guī)劃輸出相對齊的語言。通過整合中間輸出和一個用于有效特征適應(yīng)的整體標(biāo)記混合子網(wǎng),Hint-AD實現(xiàn)了理想的準(zhǔn)確性,在包括駕駛解釋、3D密集字幕生成和指令預(yù)測在內(nèi)的駕駛語言任務(wù)中取得了最先進(jìn)的成果。

為了促進(jìn)對nuScenes上駕駛解釋任務(wù)的進(jìn)一步研究,我們還引入了一個人工標(biāo)注的數(shù)據(jù)集Nu-X。代碼、數(shù)據(jù)集和模型均可在網(wǎng)上公開獲取,網(wǎng)址為:https://air-discover.github.io/Hint-AD/

背景介紹

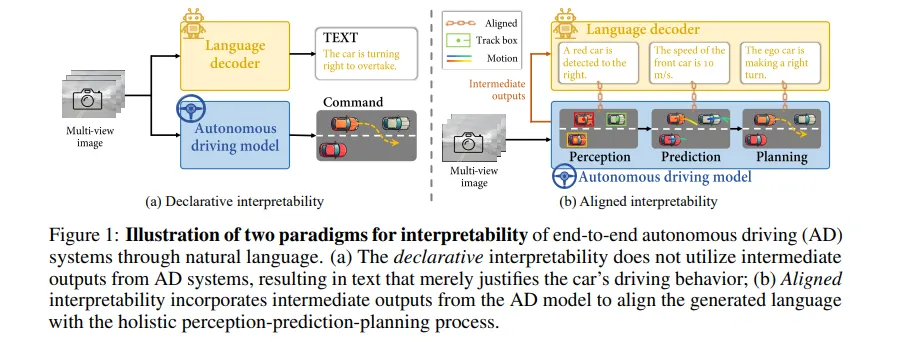

端到端的感知規(guī)劃架構(gòu)在自動駕駛(AD)和一般具身智能中至關(guān)重要,因為它具有利用大量數(shù)據(jù)進(jìn)行自監(jiān)督訓(xùn)練的潛力。然而,這些系統(tǒng)面臨著嚴(yán)峻的可解釋性挑戰(zhàn),在具身智能問題中,如自動駕駛,可解釋性問題尤為突出。當(dāng)自動駕駛系統(tǒng)直接輸出控制信號時,人類乘客很難信任其決策。為了解決這個問題,自然語言作為一種高度用戶友好的溝通媒介,已被探索用于通過諸如駕駛解釋、3D密集字幕和視覺問答(VQA)等任務(wù)來增強(qiáng)可解釋性。雖然人類駕駛員認(rèn)識到BEV軌跡作為解釋正在發(fā)生什么(WHAT)的價值,但語言提供了為什么發(fā)生這種情況(WHY)的補(bǔ)充視角。這些方法可以根據(jù)單一標(biāo)準(zhǔn)分為聲明式可解釋性和對齊式可解釋性:即生成的語言是否與自動駕駛系統(tǒng)的中間輸出對齊(圖1)。

- 聲明式可解釋性如近期在駕駛解釋、3D密集字幕和視覺問答等方面的研究所示,它直接生成自然語言,而不依賴于自動駕駛系統(tǒng)的中間輸入。這種方法經(jīng)常會產(chǎn)生幻覺,因為語言沒有基于全面的中間輸出,只是駕駛行為的合理化解釋。

- 對齊式可解釋性要求語言與自動駕駛模型的內(nèi)部狀態(tài)保持一致。據(jù)我們所知,這種方法首先由[14]提出,他們將自動駕駛模型的注意力狀態(tài)與語言解碼器對齊,后來的工作將語言解碼器與內(nèi)部決策狀態(tài)對齊。

然而,現(xiàn)有研究忽視了語言解碼器與自動駕駛流程中的完整感知-預(yù)測-規(guī)劃輸出之間的對應(yīng)關(guān)系,導(dǎo)致語言任務(wù)與自動駕駛?cè)蝿?wù)之間存在差異。通過自動駕駛流程的中間輸出來提高駕駛場景中語言任務(wù)準(zhǔn)確性的潛力尚未被探索。為此,這里提出了Hint-AD,一個集成的自動駕駛-語言框架,旨在與自動駕駛模型的感知-預(yù)測-規(guī)劃過程進(jìn)行全面對齊,并生成高精度的語言,以促進(jìn)自動駕駛的可解釋性。

我們開發(fā)了兩種方法來實現(xiàn)語言與自動駕駛模型之間的全面對齊以及語言輸出的準(zhǔn)確性:

(a) 開發(fā)了一個整體token混合模塊,該模塊將自動駕駛模型的中間輸出token適應(yīng)于語言解碼器,重點在于穩(wěn)健的特征提取和融合;

(b) 引入了一個對齊任務(wù)作為在線數(shù)據(jù)集,以將語言輸出與自動駕駛模型的中間輸出對齊,要求語言解碼器在整個訓(xùn)練過程中解釋自動駕駛模型推理過程中生成的中間token。

在UniAD和VAD這兩個最先進(jìn)的自動駕駛模型上實現(xiàn)了Hint-AD,這兩個模型分別采用了光柵化和矢量化表示,以證明Hint-AD的通用性。實驗結(jié)果表明,Hint-AD在各種語言任務(wù)上均達(dá)到了最先進(jìn)的性能,包括駕駛解釋(CIDEr得分比基線高出20.4%)、3D密集字幕(CIDEr得分比基線高出185%)、視覺問答(準(zhǔn)確率提高1.2%)和駕駛指令預(yù)測(準(zhǔn)確率提高1.2%)。對齊任務(wù)顯著提高了語言輸出與自動駕駛模型中間表示之間的一致性。此外,我們還貢獻(xiàn)了一個基于nuScenes的人類標(biāo)注的駕駛解釋數(shù)據(jù)集Nu-X,以解決這個廣泛使用的自動駕駛數(shù)據(jù)集上缺乏駕駛解釋數(shù)據(jù)的問題。

相關(guān)工作介紹

端到端自動駕駛系統(tǒng)旨在構(gòu)建一種能夠處理傳感器數(shù)據(jù)并直接輸出車輛控制信號的架構(gòu)。這些系統(tǒng)因能夠解決傳統(tǒng)模塊化設(shè)計中存在的誤差累積問題而備受研究關(guān)注,傳統(tǒng)模塊化設(shè)計將感知和規(guī)劃分為不同的模塊。其中,UniAD和VAD等杰出例子將模塊化感知任務(wù)(如目標(biāo)跟蹤、地圖構(gòu)建、運動預(yù)測和軌跡規(guī)劃)集成在一個統(tǒng)一的框架內(nèi)。此外,還開發(fā)了用于端到端自動駕駛的離線數(shù)據(jù)集。

自動駕駛的可解釋性,即為自動駕駛規(guī)劃提供全面解釋的能力,對于自動駕駛系統(tǒng)中的用戶信任和系統(tǒng)透明度至關(guān)重要。自然語言作為一種與用戶溝通的用戶友好型媒介,已被探索用于通過駕駛解釋、視覺問答(VQA)和3D密集字幕等方式來提高自動駕駛的可解釋性。以前的工作主要集中在聲明式可解釋性上,一些方法使用視覺信息實現(xiàn)了駕駛解釋任務(wù)。但是,自動駕駛模型的中間輸出并未與語言輸出對齊。其它論文提出了語言輸出應(yīng)基于自動駕駛系統(tǒng)內(nèi)部狀態(tài)的概念。也有人探索了將語言解碼器與自動駕駛模型內(nèi)部決策狀態(tài)對齊的方法,但據(jù)我們所知,以前的工作尚未實現(xiàn)與自動駕駛模型整個感知-預(yù)測-規(guī)劃過程的全面對齊。

Hint-AD方法

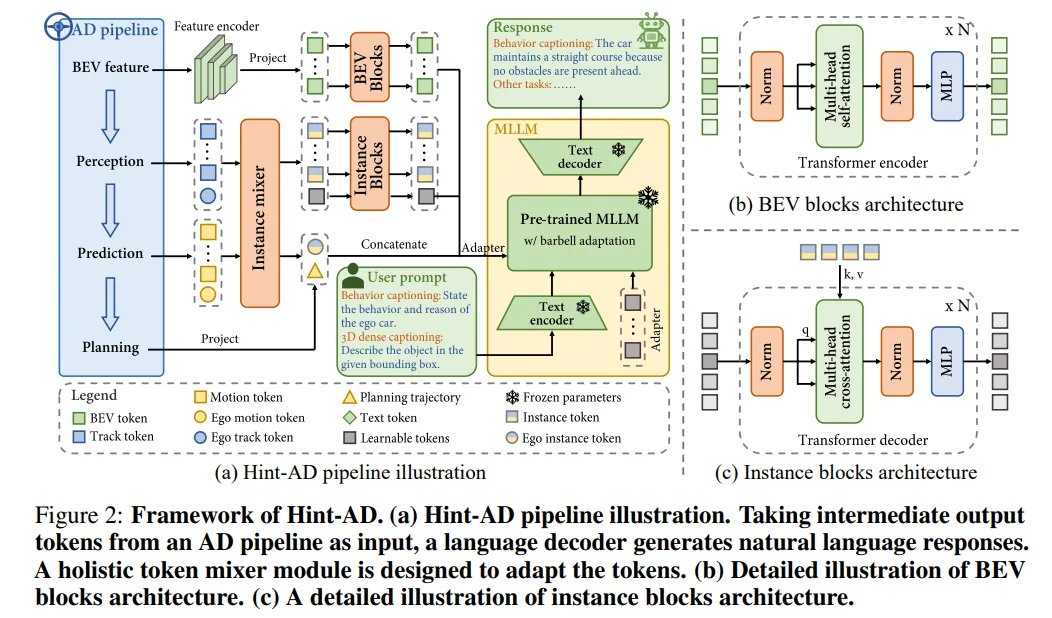

為了探索自然語言與端到端自動駕駛框架中的中間結(jié)果之間的全面對齊,我們提出了一個名為Hint-AD的新型框架,該框架包含三個模塊:整體token混合器、語言解碼器和傳統(tǒng)自動駕駛框架。Hint-AD的概覽如圖2所示。圖2中的現(xiàn)有自動駕駛流程可以是任何將自動駕駛分解為感知、預(yù)測和規(guī)劃的端到端自動駕駛系統(tǒng)。為了不失一般性,在UniAD(作為Hint-UniAD)和VAD(作為Hint-VAD)的基礎(chǔ)上實現(xiàn)了我們的方法,它們分別使用光柵化和矢量化表示。

1)Hint-AD的整體框架

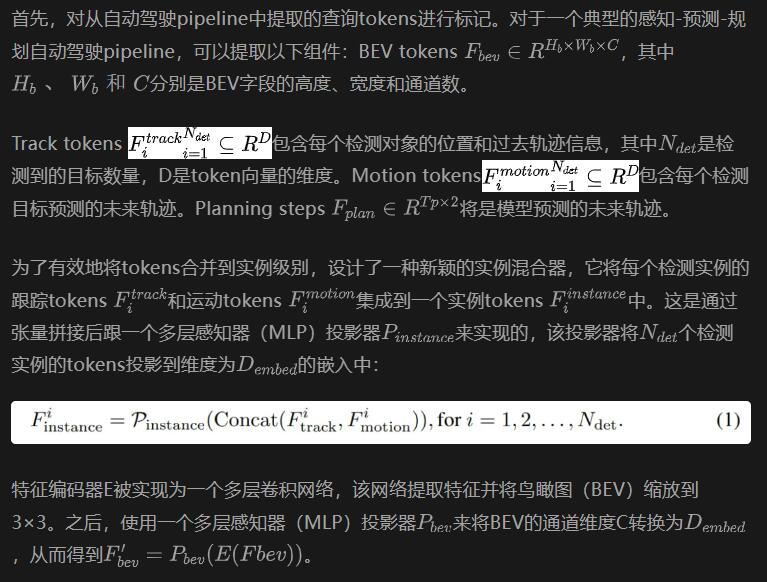

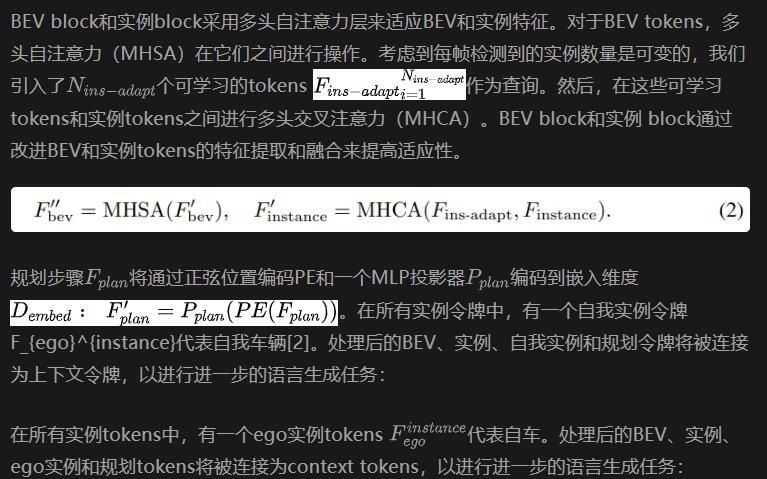

首先,從現(xiàn)有的感知-預(yù)測-規(guī)劃架構(gòu)的自動駕駛模型中提取中間查詢token,生成跟蹤token、運動token和規(guī)劃token。其次,整體token混合器模塊將對token進(jìn)行適配,以作為語言解碼器的輸入。在此模塊中,設(shè)計了一個實例混合器來合并每個檢測實例的實例級跟蹤和運動信息。還引入了鳥瞰圖(BEV)block和實例block以進(jìn)行進(jìn)一步的特征提取,并將長度可變的實例token轉(zhuǎn)換為固定長度。所有處理過的token都被連接起來作為文本生成的上context tokens。最后,context tokens被格式化為prompt tokens,并與文本提示一起放入語言解碼器中。我們采用了一種杠鈴式適應(yīng)范式,以實現(xiàn)語言解碼器對context的高效理解。

為了在訓(xùn)練過程中使語言和自動駕駛pipeline的中間結(jié)果對齊,加入了額外的訓(xùn)練數(shù)據(jù),稱為對齊任務(wù),這些數(shù)據(jù)在訓(xùn)練過程中在線構(gòu)建。

2)Holistic token mixer

從自動駕駛pipeline中提取的查詢tokens對于語言解碼器來說并不是直接可理解的。針對這一問題,我們提出了一個整體token混合器架構(gòu)。Hint-UniAD和Hint-VAD的具體實現(xiàn)略有不同。主要遵循Hint-UniAD的設(shè)計,而Hint-VAD的小幅調(diào)整則在附錄中給出。

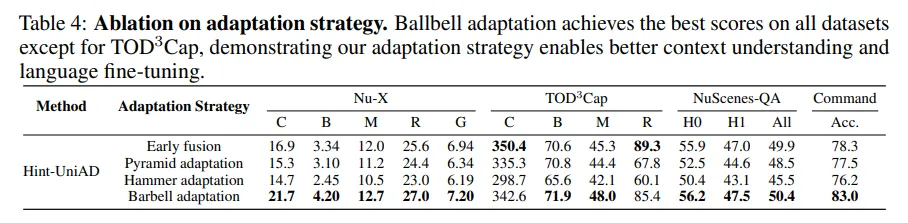

3) Language decoder with barbell adaptation

將適配器放置在前端和后端的理由是,前端適配器有助于理解context信息,而后端適配器則增強(qiáng)了語言的微調(diào)。這種設(shè)計平衡了對高級context理解和精確語言適應(yīng)的需求。在訓(xùn)練過程中,采用交叉熵?fù)p失作為字幕損失,僅對答案tokens進(jìn)行監(jiān)督。

4)Aligning language and intermediate outputs

為了使語言與自動駕駛模型的中間輸出對齊,語言解碼器需要對自動駕駛模型推理步驟中生成的每個token(即跟蹤tokens中目標(biāo)的位置)所包含的信息進(jìn)行基于context的理解。我們通過在訓(xùn)練過程中添加一個在線對齊任務(wù)數(shù)據(jù)集來實現(xiàn)這一點。

在對齊任務(wù)中,給定自動駕駛模型的中間輸入,會生成一組提示-答案對(圖3)。該任務(wù)包括四種類型的對齊:(a)計數(shù)對齊,要求語言解碼器根據(jù)跟蹤tokens解釋幀中每種類型實例的數(shù)量;(b)位置對齊,要求模型根據(jù)特定實例token提供跟蹤實例的位置;(c)運動對齊,涉及解碼實例tokens中包含的速度信息;(d)規(guī)劃對齊,要求語言解碼器輸出規(guī)劃tokens中包含的未來軌跡點。

對齊任務(wù)中的所有問答對都是在訓(xùn)練過程中在線生成的。對齊任務(wù)極大地提高了語言解碼器對中間令牌的上下文理解能力,從而大大提高了自動駕駛字幕的準(zhǔn)確性。

5)Training pipeline

Hint-AD的整個訓(xùn)練流程包括兩個階段。在第一階段,端到端的自動駕駛(AD)模型被獨立訓(xùn)練。在第二階段,凍結(jié)AD模型和大規(guī)模語言模型(MLLM)的所有參數(shù),僅更新整體token混合器和適配器的參數(shù)。第二階段的總可訓(xùn)練參數(shù)為87M。

實驗設(shè)置

1)數(shù)據(jù)集和baselines

數(shù)據(jù)集。解釋是人類學(xué)習(xí)和理解的重要指導(dǎo)工具。特別是在端到端自動駕駛(AD)系統(tǒng)的背景下,人類用戶經(jīng)常尋求解釋來彌合傳感器輸入和AD行為之間的鴻溝 。目前,在自動駕駛研究中廣泛使用的nuScenes數(shù)據(jù)集 沒有提供此類解釋。為了彌補(bǔ)這一空白并促進(jìn)針對nuScenes的可解釋性研究,我們引入了Nu-X,這是一個全面、大規(guī)模、經(jīng)過人工標(biāo)注的解釋性數(shù)據(jù)集。Nu-X為nuScenes中的每一個34,000個關(guān)鍵幀提供了詳細(xì)的contextual信息和多樣化的語言表述。

一個解釋性句子通常包括敘述和推理 ,例如:“<敘述>汽車正在并入右側(cè)車道。<推理>為了超過前面的紅色汽車。”在我們的數(shù)據(jù)集中,每個標(biāo)題都包含這兩個部分。

為了提供全面的分析,所有Hint-AD架構(gòu)和基線都在以下數(shù)據(jù)集上進(jìn)行了訓(xùn)練和評估:(1)對齊任務(wù)數(shù)據(jù)集,旨在通過要求語言解碼器解釋每個中間標(biāo)記來將語言與AD模型的中間輸出對齊,訓(xùn)練過程中在線生成真實答案;(2)TOD3Cap ,一個3D密集字幕數(shù)據(jù)集,為nuScenes中的64.3K個戶外目標(biāo)提供目標(biāo)描述,并標(biāo)注了外觀、運動、環(huán)境和目標(biāo)間空間關(guān)系;(3)NuScenesQA ,一個VQA數(shù)據(jù)集,覆蓋了nuScenes的34K幀,包含五種問題類型,包括存在性、計數(shù)、查詢對象、查詢狀態(tài)和比較;(4)駕駛指令數(shù)據(jù)集,我們在nuScenes上進(jìn)行了標(biāo)注,由方向和速度指令組成。

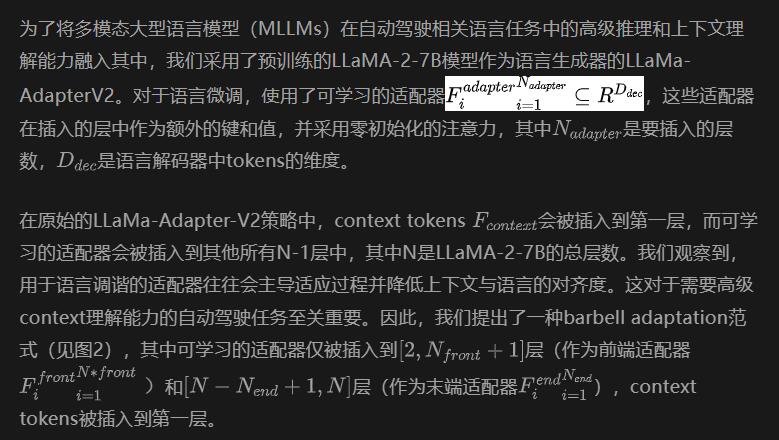

基線模型。我們選擇了基準(zhǔn)方法,這些方法既包括了語言生成領(lǐng)域的關(guān)鍵里程碑,也包括了自動駕駛背景下最先進(jìn)的方法:(1)ADAPT 采用自回歸方式,通過視覺-語言轉(zhuǎn)換器生成句子。在文本和視頻標(biāo)記上使用了交叉注意力和稀疏注意力掩碼;(2)BEV+Adapter 僅以鳥瞰圖(BEV)特征作為輸入,并使用LLaMA-Adapter-V2(與Hint-AD相同)作為語言解碼器;(3)BEVDet+MCAN 使用模塊化協(xié)同注意力網(wǎng)絡(luò)(MCAN),其中包含用于單獨的語言和視覺理解的自注意力層。堆疊的交叉注意力層用于跨模型特征交互。輸入采用了來自BEVDet 的檢測結(jié)果;(4)Vote2Cap-DETR 基于transformer架構(gòu),具有兩個并行的特定于任務(wù)的頭。查詢被解耦為定位查詢和字幕查詢;(5)TOD3Cap 利用基于查詢的檢測頭從BEV特征中生成一組3D目標(biāo)proposal。然后,這些特征通過LLaMA-Adapter處理,作為語言模型的提示來生成密集字幕;(6)GPT-4o 是OpenAI開發(fā)的多模態(tài)模型,具備最先進(jìn)的視覺能力,同時文本生成性能與其前身GPT-4相當(dāng);(7)Gemini-1.5 是谷歌開發(fā)的一款開創(chuàng)性的大型語言模型,專為處理具有擴(kuò)展context長度的多模態(tài)輸入而設(shè)計。

2)Comparing with baseline models

量化結(jié)果。在四個數(shù)據(jù)集上,針對不同類型的輸入和主干模塊分別展示了結(jié)果。對于Nu-X和TOD3Cap數(shù)據(jù)集,我們采用了四種標(biāo)準(zhǔn)的圖像字幕評估指標(biāo),包括CIDEr (C) 、BLEU (B) 、METEOR (M) 和 Rouge (R) 。由于Nu-X中駕駛解釋的全面性,還采用了GPT-3.5評分(G)來評估Nu-X。在測試TOD3Cap時,為匹配預(yù)測和真實邊界框設(shè)置了0.25的閾值。對于NuScenes-QA和Command數(shù)據(jù)集,我們直接將生成的文本與真實文本進(jìn)行比較以獲得準(zhǔn)確率。根據(jù)推理復(fù)雜性,QA被分為zero-hop (H0) and one-hop (H1)。從表1中可以得出以下結(jié)論:

Hint-UniAD和Hint-VAD在多任務(wù)測試中均表現(xiàn)出高性能。兩個系統(tǒng)均在Nu-X數(shù)據(jù)集上取得了最先進(jìn)的結(jié)果,CIDEr分?jǐn)?shù)比最佳基線(BEV+Adapter)高出3.8分(20.4%)。值得注意的是,Hint-UniAD在TOD3Cap任務(wù)上表現(xiàn)出顯著優(yōu)越的性能,CIDEr分?jǐn)?shù)提高了222.3分(185%)。盡管HintVAD在該任務(wù)上的表現(xiàn)略低,但附錄C.3中討論了可能的解釋。此外,在NuScenes-QA和Command數(shù)據(jù)集上,Hint-VAD的總體準(zhǔn)確率分別比最佳基線高出0.6分和1.2分。這些結(jié)果凸顯了所提出的Hint-AD架構(gòu)的有效性。

定性結(jié)果。圖3展示了一些定性結(jié)果。Hint-AD生成的文本顯示出對場景的深刻理解,并且與自動駕駛模型的中間結(jié)果恰當(dāng)?shù)乇3忠恢隆?/p>

3)language和模型的對齊分析

量化語言與自動駕駛(AD)模型中間輸出之間的一致性,我們對語言解碼器的輸出與AD感知模塊的預(yù)測進(jìn)行了評估,這些預(yù)測是在驗證集上實時生成的。我們設(shè)計了四種不一致性協(xié)議:(a)計數(shù)不一致性(CD),用于衡量解碼head和跟蹤模型給出的每個類別實例數(shù)量之間的差異;(b)位置不一致性(PD),用于衡量特定實例的位置差異;(c)運動不一致性(MD),用于衡量速度差異,計算為字幕中速度與感知系統(tǒng)預(yù)測速度之間的平均距離;(d)規(guī)劃不一致性(PLD),用于衡量軌跡點之間的差異。對Hint-AD進(jìn)行了測試,包括對齊可解釋性(原始設(shè)計)和聲明性可解釋性。與在聲明性可解釋性范式下運行的模型相比,對齊語言解碼器的性能顯著更優(yōu),這表明包括整體token混合器和對齊任務(wù)在內(nèi)的對齊設(shè)計是有效的。

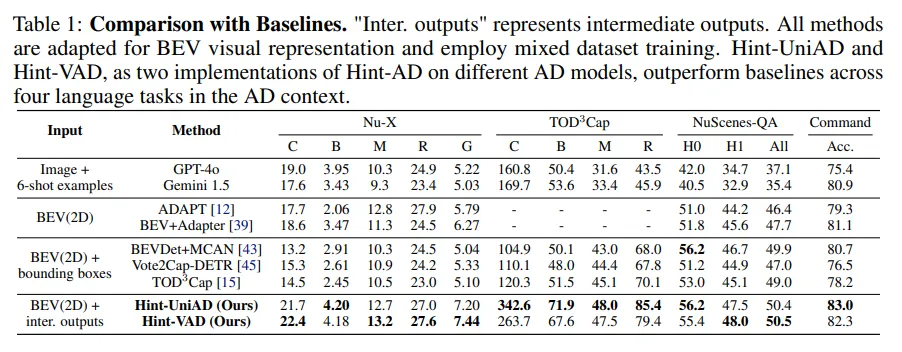

4)消融實驗

整體對齊的有效性。為了評估整體語言-自動駕駛(AD)對齊在語言任務(wù)準(zhǔn)確性上的有效性,我們通過從語言解碼器的輸入中移除跟蹤、運動和規(guī)劃tokens來進(jìn)行了一項消融研究。表2中的結(jié)果表明,使用所有tokens可實現(xiàn)最高性能。跟蹤tokens通過位置信息增強(qiáng)了3D密集字幕,而規(guī)劃tokens則通過提供未來軌跡數(shù)據(jù)改進(jìn)了命令預(yù)測。

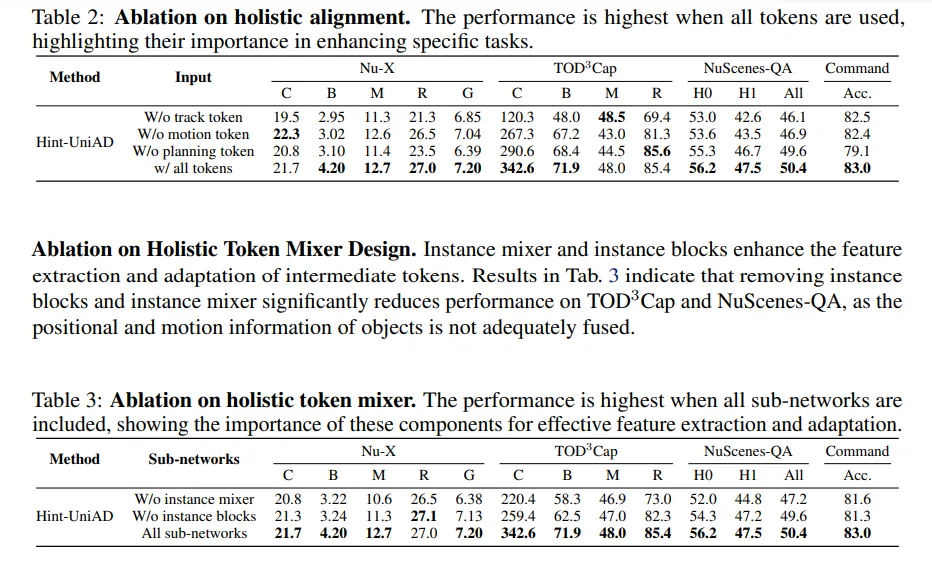

整體token混合器設(shè)計的消融研究。實例混合器和實例block增強(qiáng)了中間tokens的特征提取和適應(yīng)性。表3中的結(jié)果表明,移除實例block和實例混合器會顯著降低TOD3Cap和NuScenes-QA的性能,因為物體的位置和運動信息沒有得到充分融合。

一些結(jié)論

本工作提出了Hint-AD,這是一個集成的自動駕駛(AD)-語言框架,它將語言生成與自動駕駛模型的整體感知-預(yù)測-規(guī)劃過程對齊,從而在多個自動駕駛字幕任務(wù)中實現(xiàn)了最先進(jìn)的性能。同時,作為對齊可解釋性實現(xiàn)的一項探索性研究,以下限制仍有待進(jìn)一步研究解決:

- 由于其針對特定流程的性質(zhì),中間輸出格式的任何更改都需要對令牌混合器的設(shè)計進(jìn)行修改。對于純端到端模型(如黑盒模型),則需要進(jìn)行調(diào)整以有效處理潛在輸出。

- 基于LLaMA的語言解碼器相對耗時。有必要進(jìn)一步研究更小的模型替代方案,如MiniChat-1.5-3B和StableLM-3B-4E1T。

隨著大型語言模型(LLM)理解自動駕駛模型中間輸出的潛力日益顯現(xiàn),未來研究可以進(jìn)一步深入這一領(lǐng)域,并通過對齊可解釋性增強(qiáng)用戶對自動駕駛模型的信任。