Post-Training有多重要?AI2研究員長文詳解前沿模型的后訓練秘籍

隨著LLM學界和工業界日新月異的發展,不僅預訓練所用的算力和數據正在瘋狂內卷,后訓練(post-training)的對齊和微調方法也在不斷更新。

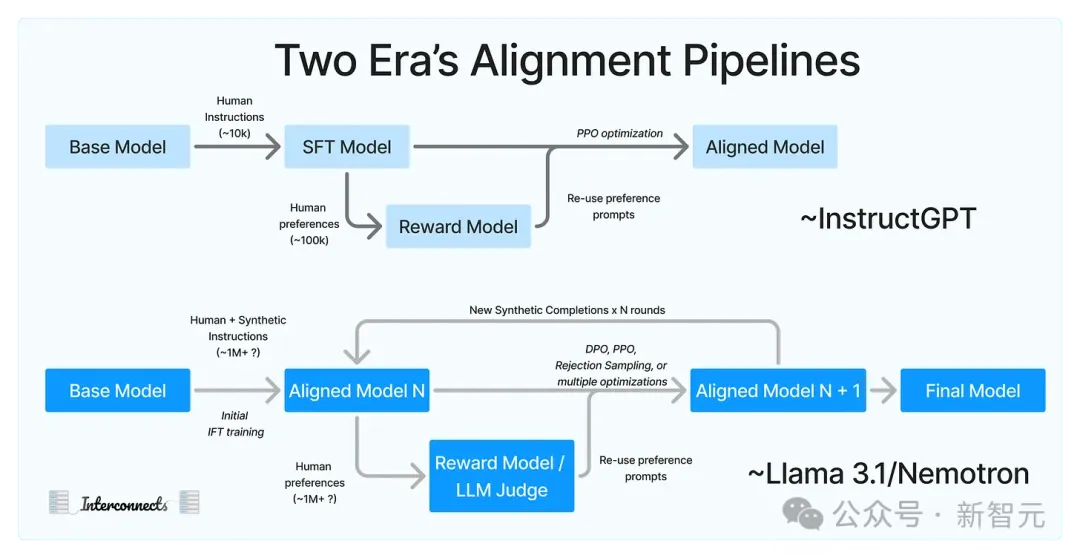

InstructGPT、WebGPT等較早發布的模型使用標準RLHF方法,其中的數據管理風格和規模似乎已經過時。

最近幾個月來,Meta、谷歌和英偉達等AI巨頭紛紛發布開源模型,附帶發布詳盡的論文或報告,包括Llama 3.1、Nemotron 340B、Gemma 2,以及Apple Intellegence的基礎模型報告。

從這些披露的信息中,我們可以看到后訓練方法的一些前沿變化趨勢。Allen AI研究科學家Nathan Lambert最近就這個話題發布了一篇文章。

原文地址:https://www.interconnects.ai/p/frontier-model-post-training

Nathan Lambert博士畢業于UC伯克利,曾在HuggingFace領導RLHF團隊,目前是Allen AI的機器學習研究員。

他在文章中指出,合成數據、迭代訓練、人類偏好標簽和大量過濾,是這些模型所用后訓練方法的共同特點。具體來說,新的后訓練配方建立在以下預設的基礎上:

- 合成數據的質量可能高于人類數據,特別是對于具有挑戰性的任務

- RLHF可以比指令微調擴展到更大規模

- 需要多輪訓練和生成才能得到最佳模型

- 數據過濾是訓練中最重要的部分

這些假設在很大程度上相互交織,構成了可以擴展到大型團隊的訓練方案,非常適用于科技巨頭。文章的具體內容對以上四點分別做出了詳細闡釋。

新的標準Pipeline

如果我們認為ChatBot Arena分數衡量了模型的后訓練表現,這就很大程度上與風格和魯棒性相關,幾乎所有的主要實驗室都通過迭代訓練獲得了顯著收益。

我們還沒有看到Gemini 2或GPT-5發布,它們也許會重置目前的后訓練范式,并有可能解鎖我們對模型更深層次的控制能力。

但從目前來看,各個頂級實驗室所用的方法明顯趨同,這種趨勢比預期中要清晰得多。

人類偏好數據

最初的RLHF管道的重點是人類數據,主要有兩種形式:1)用于對專門任務進行指令微調的人類數據;2)有關任務完成度的人類偏好數據。

這類微調數據集成本高昂且被嚴格保護,據我所知,唯一的公開的應該只有Lambert在HuggingFace團隊時發布的No Robots。

倉庫地址:https://huggingface.co/datasets/HuggingFaceH4/no_robots

人類偏好數據很大程度上與特定模型的改進有關。但即使在數據可以開放的情況下,也不能確定可以將一個模型的偏好遷移至另一個模型。

Lambert在HuggingFace時曾和團隊做過類似的嘗試,但在小型付費數據合同上失敗了。

現在,唯一用到人類數據的方面就是偏好數據。從Llama 2披露的數據和其他傳聞來看,Meta可能在偏好數據上花費了10M-20M美元,甚至更多。這還僅限于最終發布的模型,不包括更廣泛的實驗和評估。

Nemotron則使用大量合成數據來替代人類數據,但相對而言,這個模型的微調并不那么出色。

對開放社區而言,有一個迫在眉睫的挑戰,但同時也是機遇:弄清這類數據中的人為干預的程度,能否用LLM-as-a-Judge或獎勵模型等方法代替。

擴展RLHF

Llama 3的對齊負責人Thomas Scialom在播客節目Latent Space上曾說道:

RLHF的可擴展性要高得多。它成本更低、更容易操作,并且通常會帶來更好的性能。

他還表示,自己會將「100%的對齊數據預算用于RL階段所需的對齊數據,而不是在指令上花費更多時間。」

開源的對齊工作中大多專注于擴展指令微調(IFT,或稱為 SFT)。IFT容易操作、適用于多種任務,而且方便與合成數據共同使用。

但很明顯,產業界僅將IFT作為擴展RLHF的起點。SFT數據主要關注以前模型未能覆蓋的特定領域,然后在此基礎上擴展RLHF。

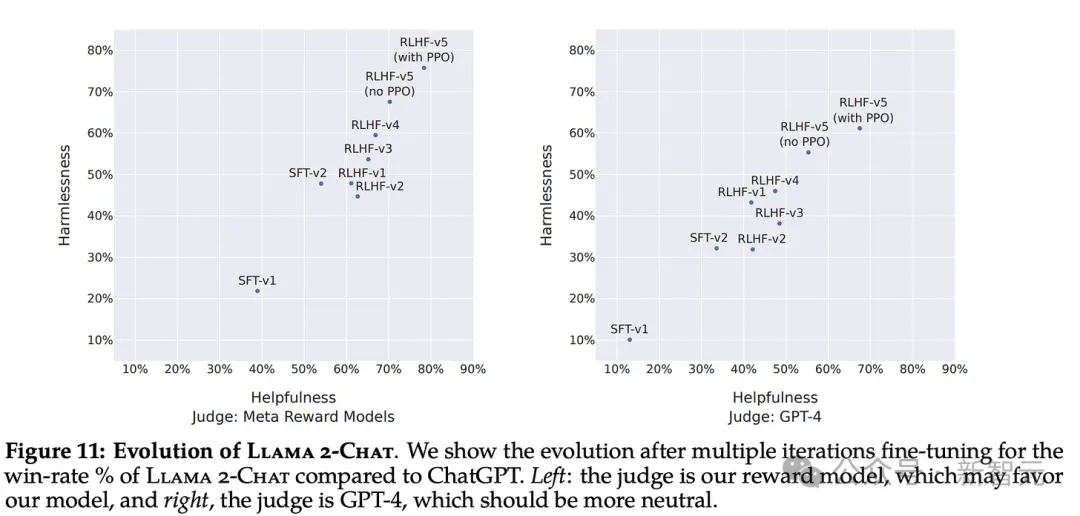

RLHF是一個迭代過程,模型的生成過程可以讓它繼續改進。Llama 2和 Nemotron論文中詳細介紹了5輪訓練,但我們不知道這個數字是否有上限。

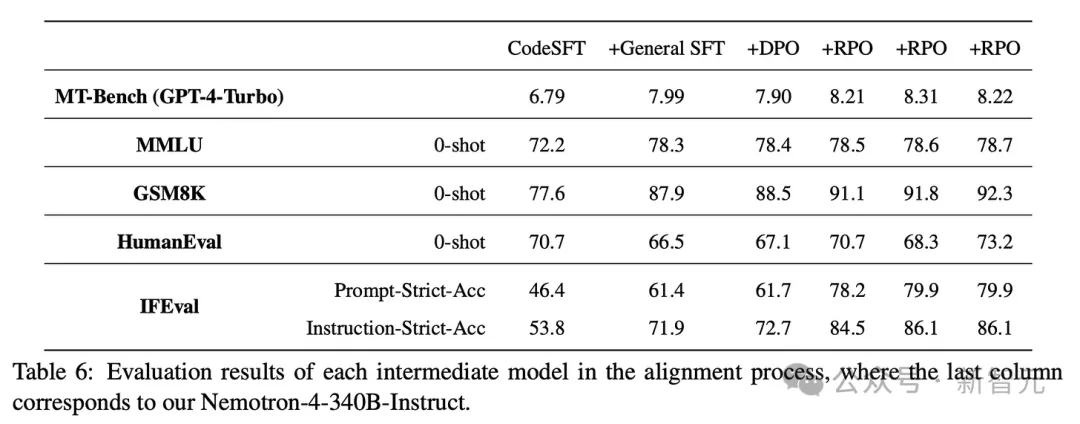

Llama 3.1進行了6輪偏好數據的訓練,Llama 2是5輪,Nemotron是4輪,之前還有多輪指令微調。

對于人類偏好數據而言,進行多輪迭代可能主要出于可行性方面的考量:

1. 數據從注釋公司分批傳送到實驗室

2. 進行多輪小規模的訓練可以降低最終產品交付的風險。與其等待所有數據到位后才開始訓練,不如讓模型逐漸步入正軌

這類現實因素看起來無關緊要,但往往會觸發某種行業規范。

下面這張圖片來自Llama 2論文,記錄了5輪拒絕采樣和PPO相關的數據。

Nemotron還進行了2輪SFT微調和4輪對齊。其中,RPO是用DPO優化器加權的獎勵模型。

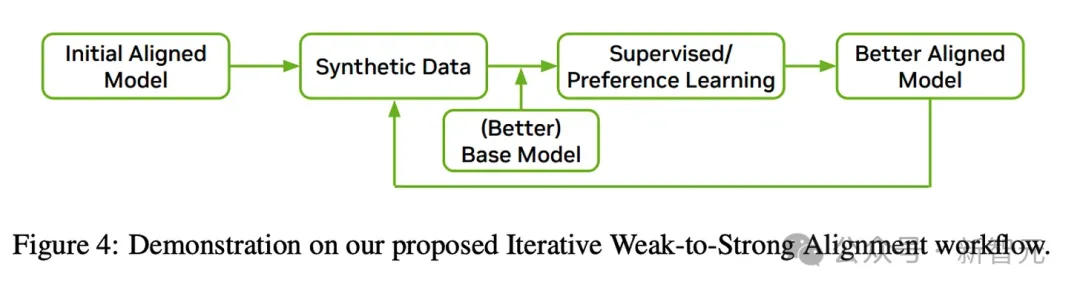

類似的迭代RLHF方法可以追溯到Anthropic提出的「憲法人工智能」,但開源社區似乎沒有大規模復現這個結果。

目前,學術界正在關注「在線DPO訓練」,這在方向上是相似的,但對各輪之間數據沒有那么關注。這種方法目前仍需要大量手動操作,但一旦實現流程自動化,在線DPO將成為未來。

事實上,各個團隊對后訓練階段的算法選擇不應該如此一成不變。DPO和PPO各有優劣,前者更容易擴展,但PPO啟發的方法(如在線RL)具有更高的性能上限。

目前這些方案主要出于簡潔性考量,因為這些團隊仍然相對較新并且正在構建模塊化系統,Llama 3后訓練團隊中一名成員的說法也證實了這種具備工程簡潔性的方法。

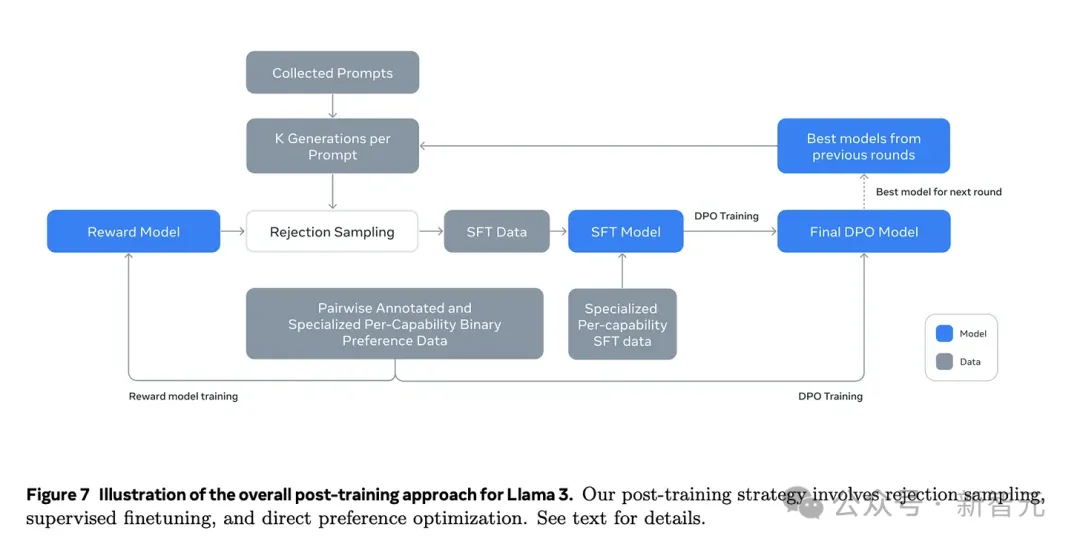

Llama 3有一個簡單的后訓練循環:拒絕采樣、SFT 和 DPO。這不僅在經驗層面有最佳性能,還實現了可復現性。而且,團隊可以異步探索許多不同的工作流(例如編碼、數學),將數據匯集到同一個簡單的循環中。

合成數據

這種新的RLHF循環中,很重要的一環是在大多數任務上超越人類能力的合成指令數據。

如果可以讓模型有一點點提升、生成更好的指令,那就「重新開始」,更新檢查點。

Meta在論文中明確表示,他們「使用405B模型來提高我們較小模型的后訓練質量」;谷歌通過蒸餾出Gemini Flash來做到這一點,但實際上大多數前沿模型可能都包含一些類似步驟。

我聽說OpenAI正在使用50萬億token的數據訓練下一代模型,其中大部分為合成數據。去年有一個傳言,Anthropic擁有「預訓練規模的憲法AI語料庫」,現在看來這也很合理。

這些AI公司意識到合成數據的重要性應該是在12~18個月之前,當他們不再使用模型輸出進行自我迭代訓練的時候。但Meta不一樣,因為受益于其他更好的開放模型。

看看當今的后訓練就可以清楚知道,合成數據造成模型崩潰的問題被過分夸大了。只有在人為設置的環境中,丟棄原始數據、只留下生成的新數據時,才會發生模型崩潰。

數據質量是王道

Llama 3.1報告的大部分內容都是關于數據管理的細節,其中每個相關的子領域都需要廣泛而具體的管理說明。

這與我所知的OpenAI John Schulman領導的后訓練團隊以及其他類似團隊的工作情況相符——指定一個特定領域,獲得相關數據,然后模型就會變得更好。

但如果沒有大量的數據過濾和管理,上述的RLHF方法都不起作用。

在Allen AI,我們在后訓練流程中開始更加優先考慮數據,可以立即感受到模型提升速度的變化。

案例分析——Nemotron和Llama

Llama的后訓練流程如下:

Nemotron的這張圖比較簡略:

綜合起來可以看到大多數方法的共同點。

但下面這張圖表,以及大多數行業研究論文都忽視了數據。

Llama 3.1等模型到報告中有提及了很多細節,比如正則化、對損失函數的調整、模型平均等等,但這些都是模型性能的邊際收益,很大程度上超出了核心微調循環的范圍。

到了一定的時間節點,這些細節都會變得微不足道。