譯者 | 李睿

審校 | 重樓

一、LLM的起源:NLP和神經(jīng)網(wǎng)絡(luò)

大型語言模型(LLM)的創(chuàng)建并非一蹴而就。語言模型的第一個(gè)概念始于被稱為自然語言處理(NLP)的基于規(guī)則的系統(tǒng)。這些系統(tǒng)遵循預(yù)定義的規(guī)則,根據(jù)文本輸入做出決策并推斷結(jié)論。這些系統(tǒng)依靠if-else語句處理關(guān)鍵字信息,并生成預(yù)定的輸出。可以將其想象成一個(gè)決策樹,如果輸入包含X、Y、Z或沒有包含這些字母,則輸出則是預(yù)先確定的響應(yīng)。例如:如果輸入包含關(guān)鍵字“母親(mother)”,則輸出“你母親怎么樣了?(How is your mother)”。否則,輸出“你能詳細(xì)說明一下嗎?”

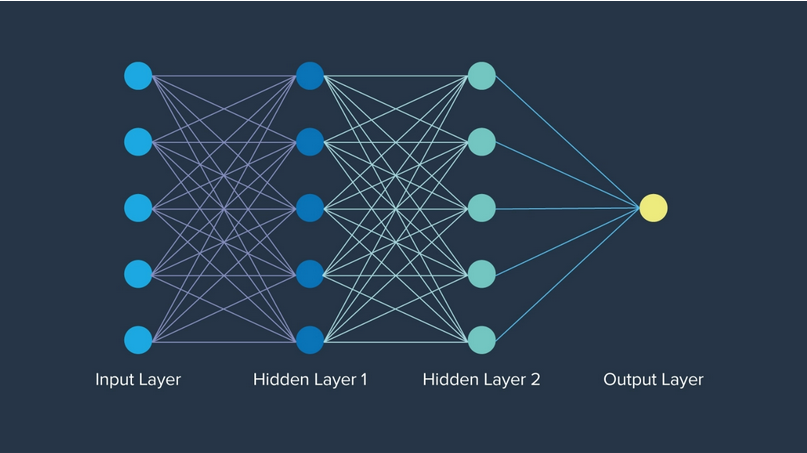

最早取得的重大進(jìn)展的是神經(jīng)網(wǎng)絡(luò)。1943年,數(shù)學(xué)家沃倫·麥卡洛克受到人腦神經(jīng)元功能的啟發(fā),首次提出“神經(jīng)網(wǎng)絡(luò)”這一概念。神經(jīng)網(wǎng)絡(luò)甚至比“人工智能”這個(gè)術(shù)語早了大約12年。每一層的神經(jīng)元網(wǎng)絡(luò)都以特定的方式組織,其中每個(gè)節(jié)點(diǎn)都有一個(gè)權(quán)重,決定了它在網(wǎng)絡(luò)中的重要性。最終,神經(jīng)網(wǎng)絡(luò)打開了封閉的大門,為人工智能的發(fā)展奠定了基礎(chǔ)。

二、LLM的演化:嵌入、LSTM、注意力與Transformer

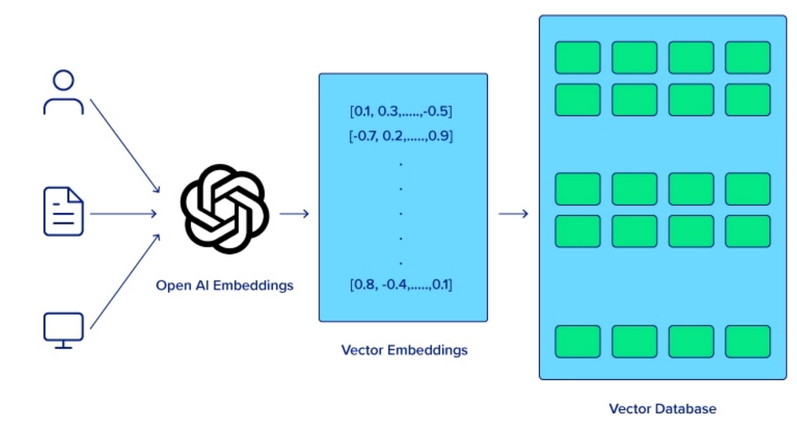

計(jì)算機(jī)無法像人類一樣理解句子中單詞的含義。為了提高計(jì)算機(jī)對(duì)語義分析的理解能力,必須首先應(yīng)用單詞嵌入技術(shù),該技術(shù)使模型能夠捕獲相鄰單詞之間的關(guān)系,從而提高各種NLP任務(wù)的性能。然而,需要有一種方法將單詞嵌入存儲(chǔ)在內(nèi)存中。

長(zhǎng)短期記憶(LSTM)和門控循環(huán)單元(GRU)在神經(jīng)網(wǎng)絡(luò)中是一個(gè)巨大的飛躍,它們能夠比傳統(tǒng)神經(jīng)網(wǎng)絡(luò)更有效地處理序列數(shù)據(jù)。雖然LSTM在某些情況下已不再使用,但這些模型為更復(fù)雜的語言理解和生成任務(wù)鋪平了道路,這些任務(wù)最終導(dǎo)致了Transformer模型的誕生。

三、現(xiàn)代LLM:注意力、Transformer和LLM變體

注意力機(jī)制的引入改變了游戲規(guī)則,使模型在進(jìn)行預(yù)測(cè)時(shí)能夠?qū)W⒂谳斎胄蛄械牟煌糠帧ransformer模型是谷歌公司8名科學(xué)家在2017年發(fā)表的一篇開創(chuàng)性論文《注意力是你所需要的》中引入的,它利用注意力機(jī)制同時(shí)處理整個(gè)序列,極大地提高了效率和性能。而這些科學(xué)家當(dāng)時(shí)沒有意識(shí)到他們的論文將在創(chuàng)造和開發(fā)人工智能技術(shù)方面產(chǎn)生巨大的影響。

在這篇論文發(fā)表之后,谷歌的BERT在2018年被開發(fā)出來,并被譽(yù)為為所有NLP任務(wù)的基線。作為一個(gè)開源模型,它被用于眾多項(xiàng)目中,為人工智能社區(qū)提供了構(gòu)建項(xiàng)目和成長(zhǎng)的機(jī)會(huì)。它的場(chǎng)景理解能力,預(yù)先訓(xùn)練的本質(zhì)和微調(diào)選項(xiàng),以及Transformer模型的演示,為開發(fā)更大的模型奠定了基礎(chǔ)。

除了BERT之外,OpenAI公司還發(fā)布了GPT-1,這是他們的Transformer模型的第一次迭代。GPT-1擁有1.17億個(gè)參數(shù),隨后GPT-2(2019年發(fā)布)實(shí)現(xiàn)了巨大飛躍,參數(shù)量增長(zhǎng)至15億個(gè),而GPT-3(2020年發(fā)布)更是達(dá)到了驚人的1750億個(gè)參數(shù)。OpenAI公司基于GPT-3的聊天機(jī)器人ChatGPT在兩年后的2022年11月30日發(fā)布,并引發(fā)巨大的應(yīng)用熱潮,真正實(shí)現(xiàn)了強(qiáng)大人工智能模型的民主化。因此,用戶需要了解BERT和GPT-3的區(qū)別。

四、哪些技術(shù)進(jìn)步正在推動(dòng)LLM的未來發(fā)展?

硬件的進(jìn)步、算法和方法的改進(jìn)以及多模態(tài)的集成都促進(jìn)了大型語言模型的發(fā)展。隨著業(yè)界找到有效利用LLM的新方法,持續(xù)的進(jìn)步將為每個(gè)應(yīng)用程序量身定制,并最終徹底改變計(jì)算領(lǐng)域。

1.硬件的進(jìn)步

改進(jìn)LLM的最簡(jiǎn)單和最直接的方法是改進(jìn)模型運(yùn)行的實(shí)際硬件。圖形處理單元(GPU)等專用硬件的發(fā)展顯著地加快了大型語言模型的訓(xùn)練和推理。GPU具有并行處理能力,已經(jīng)成為處理LLM所需的大量數(shù)據(jù)和復(fù)雜計(jì)算的必要條件。

OpenAI公司使用NVIDIA GPU為其GPT模型提供動(dòng)力,并成為首批NVIDIA DGX客戶之一。從人工智能的興起到人工智能的持續(xù)發(fā)展,NVIDIA與OpenAI的合作不斷加深,NVIDIA公司首席執(zhí)行官親自交付了首批NVIDIA DGX-1,以及最新的NVIDIA DGX H200。這些GPU內(nèi)置了海量?jī)?nèi)存和并行計(jì)算能力,以支持訓(xùn)練、部署和推理的高性能。

2.算法和架構(gòu)的改進(jìn)

Transformer架構(gòu)以其對(duì)LLM的幫助而著稱。這種架構(gòu)的引入對(duì)LLM的發(fā)展至關(guān)重要,它能夠同時(shí)而不是順序處理整個(gè)序列,極大地提高了模型的效率和性能。

對(duì)于Transformer架構(gòu),以及它如何繼續(xù)發(fā)展大型語言模型,人們?nèi)匀豢梢杂懈嗟钠诖?/p>

- 對(duì)Transformer模型不斷改進(jìn),包括改進(jìn)注意力機(jī)制和優(yōu)化技術(shù),將開發(fā)更準(zhǔn)確、更快的模型。

- 研究新型架構(gòu),例如稀疏Transformer和高效注意力機(jī)制,旨在減少計(jì)算需求的同時(shí)保持或提高性能。

3.多模態(tài)輸入的集成

LLM的未來在于它們處理多模態(tài)輸入的能力,整合文本、圖像、音頻和潛在的其他數(shù)據(jù)形式,以創(chuàng)建更豐富、更具場(chǎng)景感知的模型。像OpenAI公司的CLIP和DALL-E這樣的多模態(tài)模型已經(jīng)展示了結(jié)合視覺和文本信息的潛力,使圖像生成、字幕等應(yīng)用成為可能。

這些集成允許LLM執(zhí)行更復(fù)雜的任務(wù),例如從文本和視覺線索中理解場(chǎng)景,這最終使它們更加通用和強(qiáng)大。

五、LLM的未來

這些進(jìn)步并沒有停止,隨著LLM的創(chuàng)建者計(jì)劃在他們的工作中融入更多創(chuàng)新的技術(shù)和系統(tǒng),還會(huì)有更多的進(jìn)步。并非LLM的每一次改進(jìn)都需要更高的計(jì)算要求或更深入的概念理解。一個(gè)關(guān)鍵的改進(jìn)是開發(fā)更小、更用戶友好的模型。

雖然這些模型可能無法與“Mammoth LLM”(例如GPT-4和LLaMA 3)的有效性相媲美,但重要的是要記住,并非所有任務(wù)都需要大量復(fù)雜的計(jì)算。盡管它們的規(guī)模較大,但Mixtral 8x7B和Mistal 7B等先進(jìn)的較小模型仍然可以提供令人印象深刻的性能。以下是一些有望推動(dòng)LLM發(fā)展和改進(jìn)的關(guān)鍵領(lǐng)域和技術(shù):

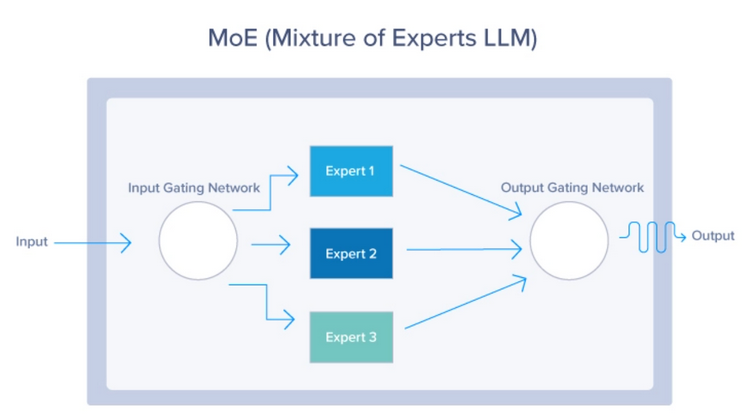

1.混合專家(MoE)

混合專家(MoE)模型使用動(dòng)態(tài)路由機(jī)制為每個(gè)輸入只激活模型參數(shù)的一個(gè)子集。這種方法允許模型有效地?cái)U(kuò)展,根據(jù)輸入場(chǎng)景激活最相關(guān)的“專家”,如下圖所示。MoE模型提供了一種在不增加計(jì)算成本的情況下擴(kuò)展LLM的方法。通過在任何給定時(shí)間僅利用整個(gè)模型的一小部分,這些模型可以使用更少的資源,同時(shí)仍然提供出色的性能。

2.檢索增強(qiáng)生成(RAG)系統(tǒng)

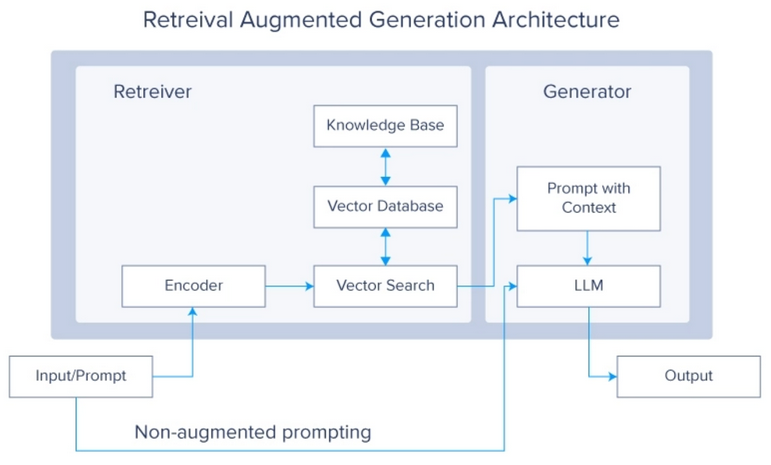

檢索增強(qiáng)生成(RAG)系統(tǒng)是當(dāng)前LLM領(lǐng)域的一個(gè)非常熱門的話題。這個(gè)概念提出了一個(gè)問題:當(dāng)可以簡(jiǎn)單地使LLM從外部源檢索所需的數(shù)據(jù)時(shí),為什么要使用更多的數(shù)據(jù)訓(xùn)練LLM?然后,這些數(shù)據(jù)被用來生成最終答案。

RAG系統(tǒng)通過在生成過程中從大型外部數(shù)據(jù)庫檢索相關(guān)信息來增強(qiáng)LLM。這種集成允許模型訪問并整合最新的和特定領(lǐng)域的知識(shí),從而提高其準(zhǔn)確性和相關(guān)性。LLM的生成能力與檢索系統(tǒng)的精度相結(jié)合,產(chǎn)生了一個(gè)強(qiáng)大的混合模型,該模型能夠在保持與外部數(shù)據(jù)源同步的同時(shí)生成高質(zhì)量的響應(yīng)。

3.元學(xué)習(xí)

元學(xué)習(xí)方法使LLM能夠?qū)W習(xí)如何學(xué)習(xí),從而使它們能夠迅速適應(yīng)新任務(wù)和領(lǐng)域,而所需的訓(xùn)練量極少。

元學(xué)習(xí)的概念取決于以下幾個(gè)關(guān)鍵概念:

小樣本學(xué)習(xí):通過小樣本學(xué)習(xí)訓(xùn)練LLM理解和執(zhí)行新任務(wù),只需幾個(gè)例子就可以理解和執(zhí)行新任務(wù),從而大幅減少了有效學(xué)習(xí)所需的數(shù)據(jù)量。這使得它們?cè)谔幚砀鞣N場(chǎng)景時(shí)具有高度的通用性和高效性。

自監(jiān)督學(xué)習(xí):LLM使用大量未標(biāo)記的數(shù)據(jù)來生成標(biāo)簽并學(xué)習(xí)表示。這種形式的學(xué)習(xí)允許模型創(chuàng)建對(duì)語言結(jié)構(gòu)和語義的豐富理解,然后針對(duì)特定應(yīng)用進(jìn)行微調(diào)。

強(qiáng)化學(xué)習(xí):在這種方法中,LLM通過與環(huán)境互動(dòng)并接受獎(jiǎng)勵(lì)或懲罰形式的反饋來學(xué)習(xí)。這有助于模型優(yōu)化它們的行為,并隨著時(shí)間的推移改進(jìn)決策過程。

結(jié)論

LLM是現(xiàn)代科技的奇跡。它們的功能復(fù)雜,規(guī)模龐大,并且具有開創(chuàng)性的進(jìn)展。本文探討了這些非凡進(jìn)步的未來潛力,從人工智能領(lǐng)域的早期開始,也深入研究了神經(jīng)網(wǎng)絡(luò)和注意力機(jī)制等關(guān)鍵創(chuàng)新。

本文還研究了用于增強(qiáng)這些模型的多種策略,包括硬件的改進(jìn)、內(nèi)部機(jī)制的改進(jìn)以及新架構(gòu)的開發(fā)。到目前為止,希望人們對(duì)LLM及其在不久的將來的發(fā)展軌跡有了更清晰、更全面的了解。

原文標(biāo)題:History and Future of LLMs,作者:Kevin Vu

鏈接:https://dzone.com/articles/history-and-future-of-LLMs。