Llama 4訓練已開啟!Meta科學家最新采訪,揭秘Llama 3.1是如何煉成的

剛剛發(fā)布的開源「巨無霸」Llama 3.1雖然自帶論文,但依舊激起了廣大網(wǎng)友強烈的好奇心和求知欲。

Llama 3.1都使用了哪些數(shù)據(jù)?其中有多少合成數(shù)據(jù)?為什么不使用MoE架構(gòu)?

后訓練與RLHF流程是如何進行的?模型評估是如何進行的?

我們什么時候可以見到Llama 4?Meta是否會發(fā)展agent?

恰逢Llama 3.1剛剛發(fā)布,Meta科學家就現(xiàn)身播客節(jié)目Latent Space,秉持著開源分享的精神,對以上問題都作出了清晰的回答。

受訪者Thomas Scialom現(xiàn)任Meta的人工智能研究科學家,領(lǐng)導了Llama 2和Llama 3的后訓練,并參加了CodeLlama、Toolformer、Bloom、GAIA等多個項目。

以下是采訪內(nèi)容的節(jié)選。

Llama 3.1研發(fā)思路

如何決定參數(shù)規(guī)模

其實LLM的參數(shù)規(guī)模的選擇需要考慮多種因素,包括scaling law、訓練時間、GPU和硬件的約束等等。

而且,不能只考慮Meta所用的硬件,還有整個AI社區(qū),并不是每個人都在使用H100,還有很多不同的GPU型號和顯存大小。

再加上,目前廣泛應(yīng)用于推理階段的量化技術(shù),比如可以用FP16或FP8精度,這會改變推理和訓練/微調(diào)成本的比重。

以上這些限制因素,都讓模型規(guī)模的選擇成為一個非常具有挑戰(zhàn)性的問題。

總體而言,著重考慮的是目前已有的算力,在Scaling Law和訓練token總量的限制內(nèi),我們進行了一些權(quán)衡,找到了一個有合適推理效率的平衡點。

之所以做到405B這么大規(guī)模,其實原因很簡單——我們想做出最好的模型,一個真正與GPT-4比肩的開源模型。(現(xiàn)在是GPT-4o了)雖然目前還沒有完全達到目標,但差距正在逐漸縮小。

正如小扎之前宣布的,Meta囤積了越來越多的GPU,因此下一代模型將繼續(xù)擴展。

對于網(wǎng)友們所說的,無法在家里運行Llama 3.1,這很有可能是事實。但如果進行FP8量化,依舊可以用128k的上下文窗口在單節(jié)點上運行。

從另一個角度來看,我們還是要寄希望于開源社區(qū)的力量。Llama 1和Llama 2剛剛發(fā)布時,大家同樣認為模型太大了,但兩周后它就能在樹莓派上運行了。

雖然不能確定Llama 3.1也會和以前一樣,但通過將模型開源,我們希望可以看到類似的趨勢。

重新審視Scaling Law

我們所熟知的Scaling Law主要關(guān)注兩個維度,即模型權(quán)重和訓練量,包括訓練時的step、epoch和token總量等等。

基本上,論文的發(fā)現(xiàn)就是,模型規(guī)模是重要因素。因此,GPT-3犯了一個錯誤——模型參數(shù)量遠遠超出了token總量的要求。

論文地址:https://arxiv.org/pdf/2001.08361

這也正是之后的Chinchilla所發(fā)現(xiàn)和強調(diào)的,相比最初的Scaling Law,他們更強調(diào)了訓練數(shù)據(jù)token總量的重要性。

論文地址:https://arxiv.org/pdf/2203.15556

Chinchilla論文想要找到「算力最優(yōu)化」的訓練方式,認為在有限算力的前提下,存在一個模型參數(shù)量和訓練token數(shù)的最佳比率。

如果你希望在論文的基準測試中得到最優(yōu)模型,那么Chinchilla本身沒有問題;但Meta要發(fā)布的旗艦?zāi)P瓦€需要更高的推理效率。

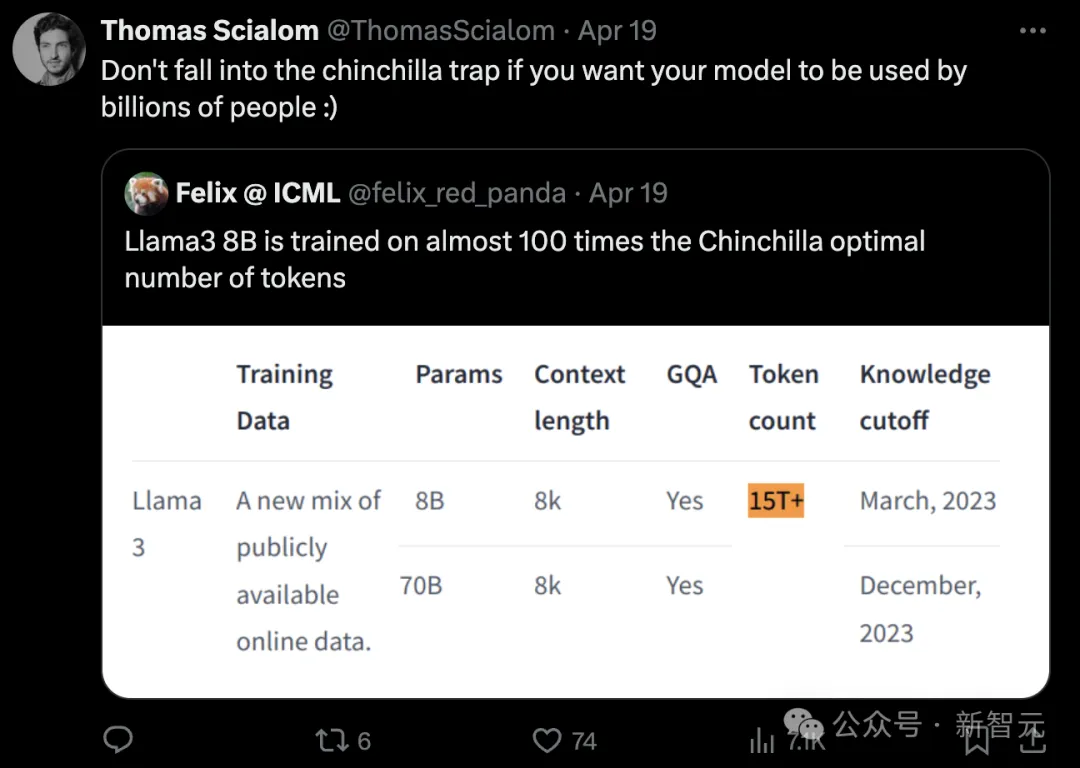

因此,我們選擇增加訓練的token數(shù),并增加訓練時長,讓模型達到「過度訓練」的狀態(tài)。

這不符合Chinchilla定律,也會付出額外的算力,但我們希望讓模型有更好的推理表現(xiàn),從而更多地應(yīng)用于開源社區(qū),因此需要做出一些超越Chinchilla定律的選擇。

事實上,這也是Llama 1的研發(fā)人員所做的事情。我所說的「不要陷入Chinchilla陷阱」就是這個意思。

模型架構(gòu)

相比Llama 2, Llama 3的架構(gòu)沒有太多變化,但是在擴展數(shù)據(jù)的規(guī)模和質(zhì)量方面,我們作出了很多努力,數(shù)據(jù)集從2T token增加到15T token。

架構(gòu)方面,我認為將來會有更多改進,甚至不僅僅局限于Transformer。

目前的Tranformer架構(gòu)仍然缺少靈活性,比如,我認為對每個token使用等量的算力是沒有意義的,因此還有很多研究的空間。

關(guān)于「為什么不使用MoE架構(gòu)」,這個是我經(jīng)常聽到的質(zhì)疑,其中的原因有多個方面。

我認為,稠密模型只是MoE的一個特定變體,你可以把它看作只有一個專家的MoE,因此這只是一個還沒有優(yōu)化的超參數(shù)而已。

但我們目前正在進行一些工作,未來可能會在這個超參數(shù)上繼續(xù)探索。

關(guān)于合成數(shù)據(jù)

關(guān)于數(shù)據(jù),我的直覺是,公開互聯(lián)網(wǎng)上充斥著過多文本垃圾,用這些token訓練模型是對算力的浪費。

在為Llama 2抓取數(shù)據(jù)時,我們就使用Llama作為分類器,用于過濾出高質(zhì)量的token,并打上主題標簽,比如這段文本是和數(shù)學、法律還是政治有關(guān),這樣可以實現(xiàn)主題的均衡和多樣性。

Llama 3的后訓練過程完全沒有使用人工書寫的答案,僅依靠從Llama 2獲得的合成數(shù)據(jù)。

我非常看好合成數(shù)據(jù),而且隨著模型性能提升,情況也會變得更好。

LLM的評估與改進

目前的模型研發(fā)有一個趨勢,就是針對基準分數(shù)進行模型的后訓練改進。

模型評估是一個開放的研究問題,目前還沒有很好的答案,尤其是面對同一個模型有如此多的功能。

當你試圖提升模型在某個基準上的分數(shù)時,這就不再是一個好的基準了,因為可能會存在過擬合,分數(shù)提升未必可以遷移成為相似的能力。

因此,語言模型的評估,尤其是訓練后評估,是一個非常困難的問題。我們嘗試過很多方法,包括用獎勵模型,model-as-a-judge、使用多樣化的提示、多樣化的基準測試……

我感覺為Llama 2進行評估要比今天容易多了,當時的模型性能比現(xiàn)在相差很多。現(xiàn)在的模型變得如此好,以至于很難找到能擊潰模型的合適prompt,進行性能比較并查看邊界情況。

比較模型的其中一個好辦法就是進行多輪RLHF。每次上傳新模型時,只需在所有帶標注的prompt上進行采樣,讓新舊模型分別回答,再自動計算勝率。

Llama 4與Agent

Meta已經(jīng)在6月開始訓練Llama 4模型,而且重點可能圍繞agent技術(shù),并且已經(jīng)在Toolformer等agent工具上進行了一些工作。

論文地址:https://arxiv.org/pdf/2302.04761

但同時也要意識到,如果沒有一個優(yōu)秀的指令模型,Toolformer擴展和未來能力也會大大受限,因此我們研發(fā)了Llama 2和Llama 3。

此外,Meta也曾在一年前發(fā)布GAIA基準,用于評估模型解決現(xiàn)實世界問題的能力。

在這個基準的排行榜上,基于GPT-3的agent系統(tǒng)得分幾乎接近于零,但GPT-4驅(qū)動的系統(tǒng)就有很好的成績,比如30%~40%,這其中就體現(xiàn)出模型的智力差距。

在我看來,agent的各種能力,比如函數(shù)調(diào)用、遵循復雜指令、預(yù)先規(guī)劃、多步驟推理等等,和模型的這種智力差距是類似的。

論文地址:https://arxiv.org/pdf/2311.12983

現(xiàn)在有了足夠強大的Llama 3,我將重新專注于agent的構(gòu)建。如果能實現(xiàn)良好的模型互聯(lián),形成一個復雜的agnent系統(tǒng),將獲得幾個數(shù)量級的擴展,從而實現(xiàn)規(guī)劃、回溯、網(wǎng)頁導航、代碼執(zhí)行等多種功能。