給爆火的Llama 2劃重點,Huggingface機器學習科學家寫了篇分析文章

Meta 發布的免費可商用版本 Llama 2 刷屏整個網絡。

此前,Llama 1 版本因為開源協議問題,一直不可免費商用。現在,隨著 Llama 2 的發布,這一限制正式被打破。

Llama 2 模型系列包含 70 億、130 億和 700 億三種模型,此外 Meta 還訓練了一個 340 億參數變體,但并沒有發布,只在技術報告中提到了。

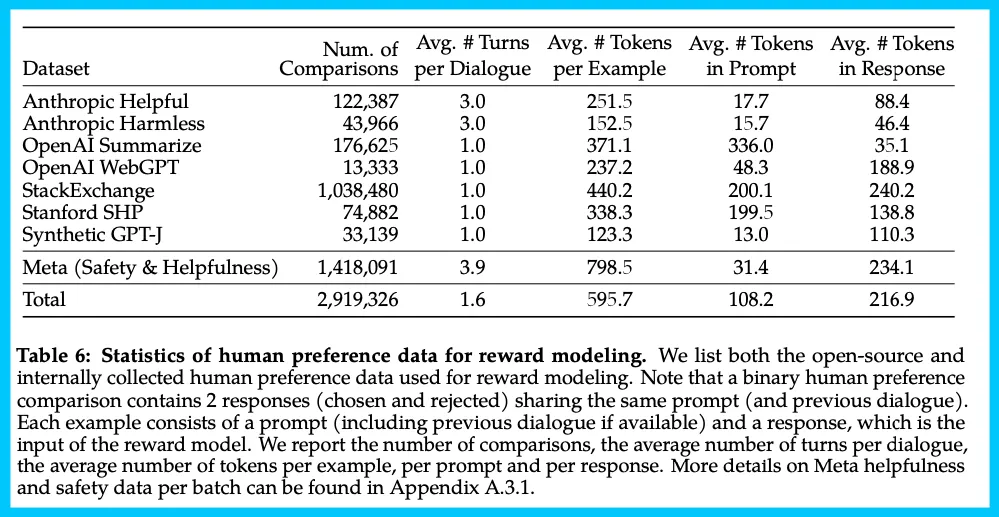

發布之初, Llama -2-70B-Chat 迅速登頂 Hugging Face 的 Open LLM Leaderboard。

圖片

圖片

可以說, Llama 2 是 Llama 1 模型的延續,不論是在數據質量、訓練技術、性能評估、安全訓練等方面都進行了實質性的技術擴展。

Meta 的這一發布,對于開源來說是一個巨大的飛躍,但對于閉源提供商來說卻是一個巨大的打擊,因為這個模型提供了更高的可定制性和更低的成本。

相信大家很想了解關于 Llama 2 的更多信息,除了官方公開的技術資料外,來自 Huggingface 的機器學習科學家 Nathan Lambert 根據論文內容也為我們整理了一份詳細的資料,文章還融入了他自己的見解。

Llama 2 論文地址:https://ai.meta.com/research/publications/llama-2-open-foundation-and-fine-tuned-chat-models/

Nathan Lambert 從以下幾個方面展開介紹:

- 模型:Meta 發布了多個模型,70 億、130 億、700 億、340 億參數變體 ,以及 Llama 2-Chat。Meta 將預訓練語料庫的大小增加了 40%,將模型的上下文長度增加了一倍至 4k,并采用了分組查詢注意力機制;(注:Llama 2 是否可被定義為「開源模型」目前還存在爭議,作者在最新的更正版本中認為它不是。)

- 性能:Llama 2 模型系列除了在大多數基準測試中優于開源模型之外,根據 Meta 對有用性和安全性的人工評估,它或許也是閉源模型的合適替代品;

- 成本:Meta 動用了巨大的預算,預計該項目的總成本將在2000萬至4500萬美元之間。單就數據來說,如果按市場價格計算,準備偏好數據花費約為 800 萬美元,數據團隊非常龐大;

- 團隊組織:一些關于 Meta AI 組織變化的跡象,這個團隊和 Yann Lecun 以及原始 FAIR 成員似乎不同;

- 代碼、數學以及推理:文中對代碼數據和 RLHF 的討論并不多;

- 多回合一致性(Multi-turn consistency):文中提出了一種新技術 ——Ghost Attention (GAtt),這種方法有助于控制多個回合的對話流;

- 獎勵模型:研究使用兩種獎勵模型來達到安全性 - 有用性的權衡;

- RLHF 過程:本文采用兩階段的 RLHF 方法,首先使用拒絕抽樣(Rejection Sampling),然后結合近端策略優化(Proximal Policy Optimization,PPO)進行拒絕抽樣 + 近端策略優化處理。論文還指出,RLHF 非常重要,且 LLM 出色的寫作能力,基本上是由 RLHF 驅動的;

- 安全和危害性評估:論文用大量篇幅介紹了安全評估(幾乎占據論文一半)、上下文蒸餾以及 RLHF 用于安全目的;

- 許可:該模型可用于商業用途,除非你的產品月活用戶數 >= 7 億,需要填寫表格以獲取訪問權限。

Nathan Lambert 猜測,Llama 2 很可能已經訓練了幾個月,他預計下一個版本也正在醞釀之中。

基礎模型

Llama 2 在架構和其他方面與原始 Llama 非常相似,但 Llama 2 增加了上下文長度并采用了分組查詢注意力(GQA,grouped-query attention)機制。Llama 2 大多數更改都是針對數據和訓練過程的。增加上下文長度可以滿足聊天的可用性要求,分組查詢注意力機制可以提高推理速度。

Llama 2 的訓練語料庫包含了來自公開可用資源的混合數據,并且不包括 Meta 產品或服務相關的數據。此次,Meta 努力刪除了包含大量個人隱私信息網站的數據。此外,Llama 2 預訓練模型是在 2 萬億的 token 上訓練的,這樣可以在性能和成本之間取得良好的平衡。

Meta 公開的論文大部分內容是關于評估和微調的,而不是重新創建一個強大的基礎模型。這一做法可能會強化 Meta 作為開源大語言模型領導者的地位。

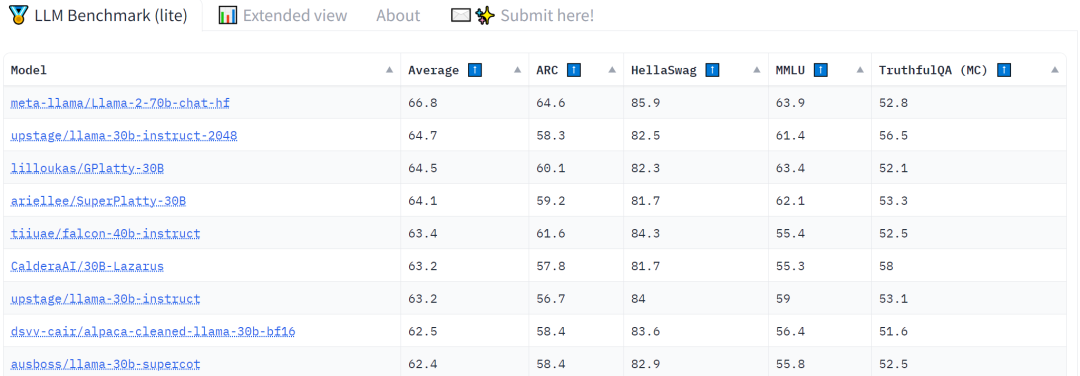

下圖為 Llama 2-Chat 的訓練 pipeline。Meta 在偏好數據上訓練獎勵模型,然后用強化學習對其進行優化,以提高模型質量。

圖片

圖片

偏好數據

Nathan Lambert 表示,通過 Meta 發布的論文,他證實了一個謠言,即 Meta 贊同獎勵模型是 RLHF 的關鍵,也是模型的關鍵。為了獲得一個好的獎勵模型,Meta 不得不努力收集偏好數據,這些數據遠遠超過了開源社區目前使用的數據量。

關于數據的更多信息如下:

- Meta 收集了大量的二元比較數據,如「顯著更好、更好、稍微更好」,而不是其他更復雜的反饋數據類型;

- Meta 將數據收集的重點放在有用性和安全性上,在數據收集時對每個數據供應商使用單獨的指導方針;

- Meta 為收集的數據添加了額外的安全元數據(safety metadata),以顯示在每個回合中模型的哪些響應是安全的;

- Meta 采用了迭代式的數據收集方法:人工注釋以每周一批的方式進行收集。隨著收集到的偏好數據增多,獎勵模型也得到了改善。

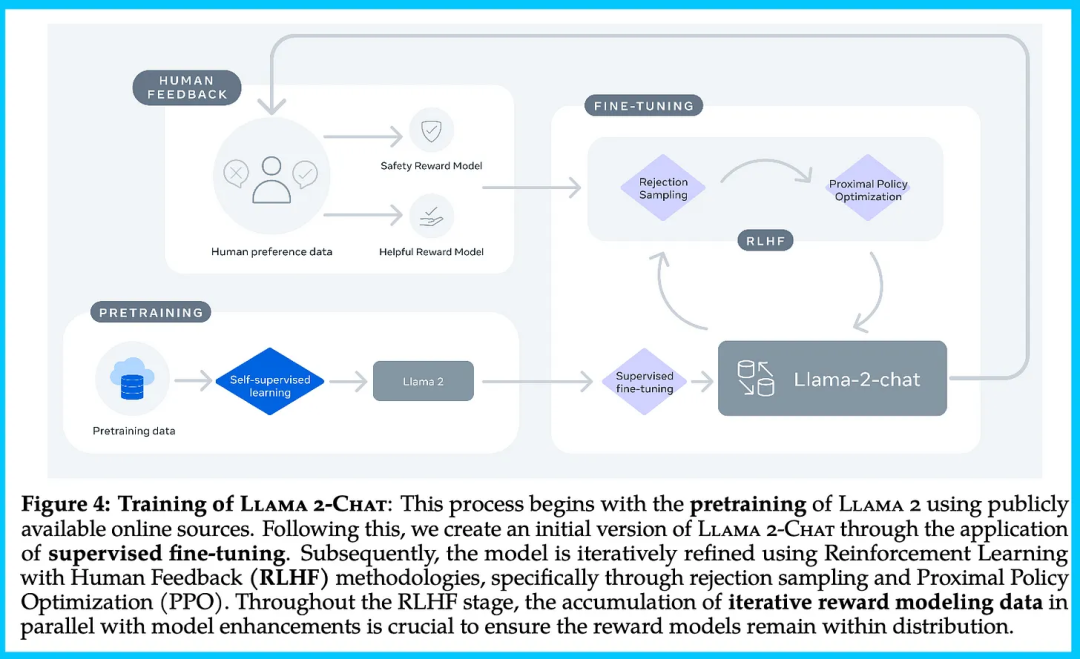

Nathan Lambert 預測,假設供應商收費接近市場價格,那么 Meta 這次發布僅數據成本可能超過 800 萬美元。下表總結了 Meta 長期以來收集到的獎勵建模數據,并將其與多個開源偏好數據集進行了對比。

圖片

圖片

獎勵模型

關于獎勵模型有兩個重要細節:

- 兩個獎勵模型被用來區分有用性和安全性的目標上;

- 獎勵模型在迭代部署時,以確定所需的偏好數據量。

首先,論文指出他們訓練了兩個獨立的獎勵模型,一個針對有用性進行優化(稱為 Helpfulness RM),另一個針對安全性進行優化(稱為 Safety RM)。這兩個模型都基于基礎語言模型構建,用線性回歸層替代了標準語言模型的頭部。他們沒有指明模型來自哪個 checkpoint,而是使用最新的聊天模型來最小化 RLHF 訓練中的分布不匹配。

在這個過程中還有一些值得注意的技術細節:

- 在沒有詳細解釋為什么需要的情況下,Meta 仍然保留了一些 Anthropic 的無害數據;

- 只訓練了一個 epoch,這是為了避免獎勵模型容易出現過擬合;

- 獎勵模型的平均準確率仍然只在 65-70%,但當標注者的偏好一致性較強時,準確率可達 80-90%。

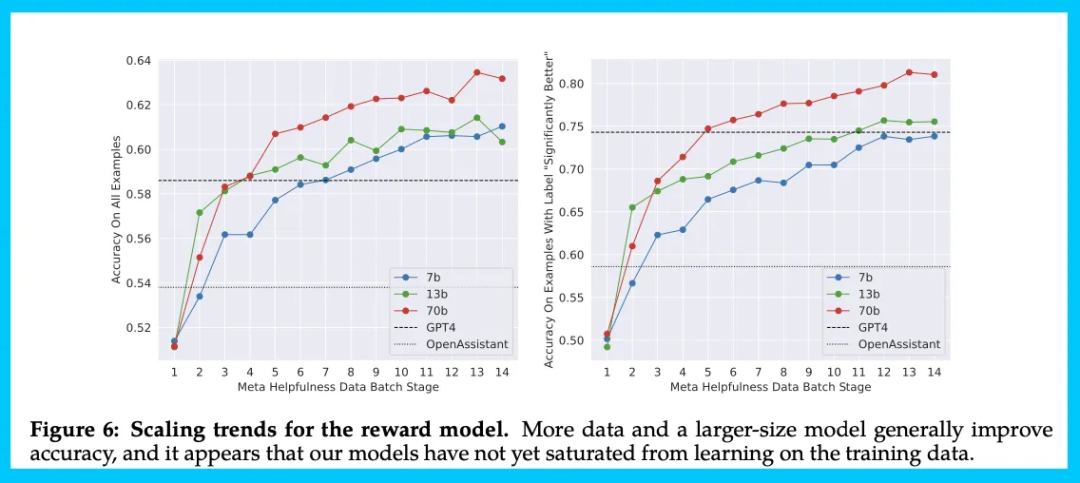

下圖展示了獎勵模型的準確性是如何隨著時間的推移而變化的。

圖片

圖片

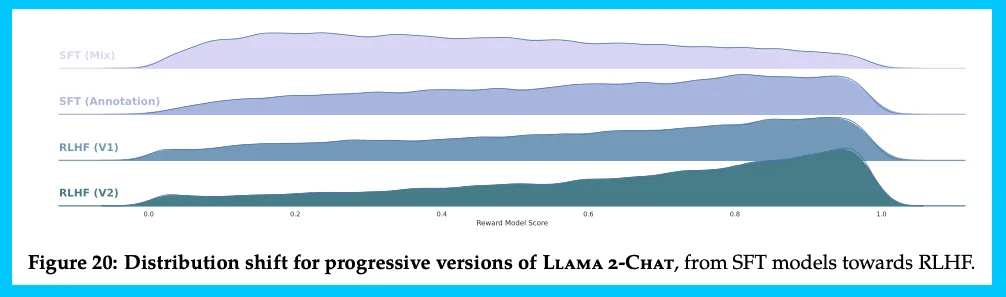

RLHF 和微調

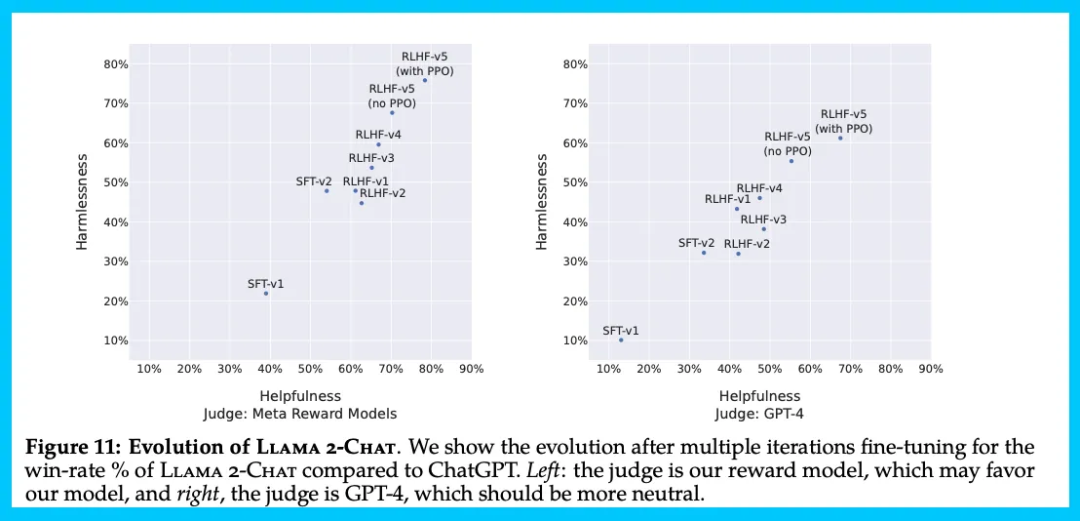

Meta 展示了他們如何利用 RLHF 來有意義地改進模型。他們迭代的訓練了 5 個 RLHF 版本,RLHF- V1,…, RLHF-V5。

圖片

圖片

從一開始,Meta 就指出了數據質量對模型的重要性。

Meta 在論文中表示:「Quality Is All You Need。我們可以從不同的來源獲取第三方 SFT( Supervised Fine-Tuning )數據,但我們發現很多數據缺乏多樣性,并且質量也不高,尤其是將 LLM 模型與對話式指令進行對齊的數據。我們將來自第三方的數據集示例置于一旁,并使用少量的、但質量更高的、來自我們自己供應商的注釋示例,結果性能顯著改善。」

Meta 發現,注釋數達到數萬個的 SFT 足以實現高質量的結果。因而,Meta 在收集了總共 27540 個注釋后停止了 SFT 的注釋工作。

Meta 還觀察到,不同的注釋平臺和供應商提供的數據可能會導致下游模型性能的不同,這表明即使是供應商注釋的數據,后續檢查也是很重要的。Meta 為了驗證數據質量,他們仔細檢查了一組包含 180 個示例的數據,并將人工提供的注釋與模型通過人工審查生成的樣本進行比較。

數據質量建立起來后,Meta 開始專注于強化學習組件:

Meta 在論文中表示:「強化學習在我們的研究中表現非常高效,尤其是考慮到其成本和時間效率。我們的研究結果強調了 RLHF 成功的關鍵因素在于它在整個注釋過程中促進了人類和 LLM 之間的協同作用。」

Meta 的這一表述非常有趣,因為這是第一篇明確指出 RLHF 在本質上提高了模型性能上限的論文,而其他研究團隊則認為 RLHF 很重要,但只將其視為一種安全工具。

Nathan Lambert 認為,高效的 RLHF 需要至少一個中等規模的團隊。一個由 1-3 人組成的團隊可以發布一個優秀的指令模型,但他認為這種 RLHF 至少需要 6-10 人的團隊。隨著時間的推移,這個數字可能會減少。

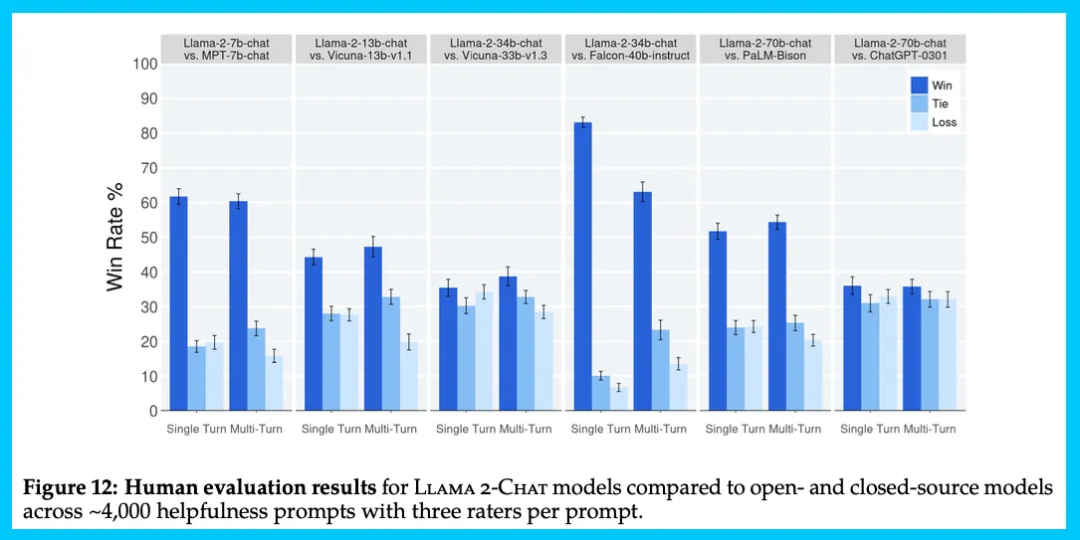

評估

論文從很多方面評估了他們的模型。下圖將 Llama 2-Chat 模型的人類評估結果與開源和閉源模型進行比較:結果顯示,Llama 2-Chat 模型在單回合和多回合提示上均顯著優于開源模型。特別是,Llama 2-Chat 7B 模型在 60% 的提示上勝過 MPT-7B-chat 模型。而 Llama 2-Chat 34B 模型在與容量相當的 Vicuna-33B 和 Falcon 40B 模型對戰中,總體勝率超過 75%。

圖片

圖片

圖 11 報告了不同的 SFT 和 RLHF 版本在安全性和有用性兩個維度上的進展:

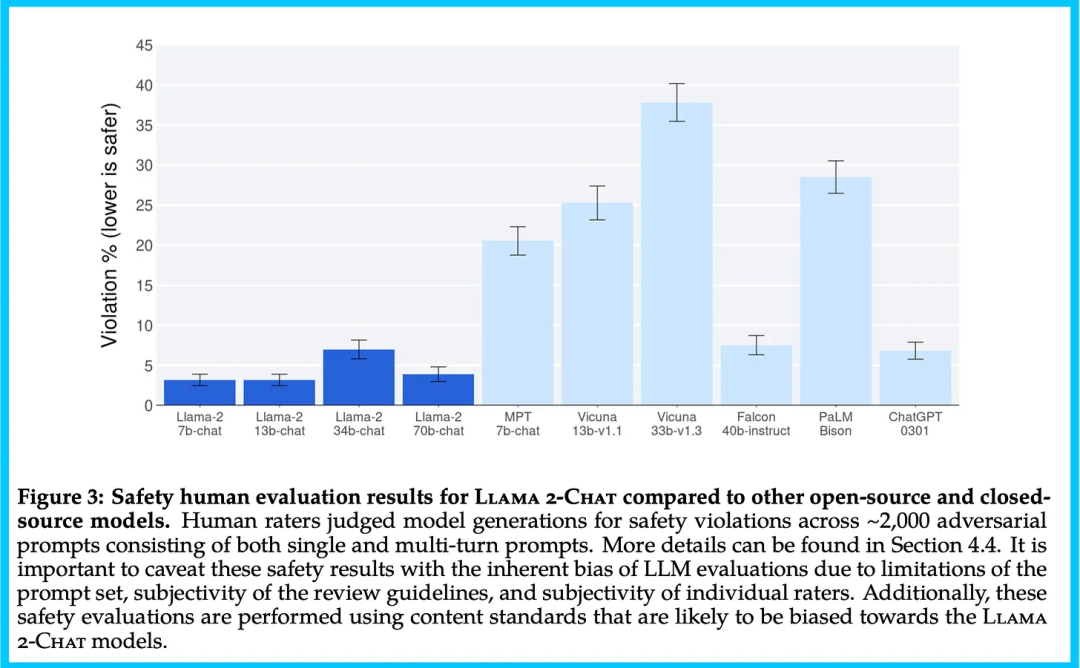

下圖為安全性的一些結果,包括偏見、紅隊測試(red-teaming)、預訓練步驟等等。

圖片

圖片

以上就是 NATHAN LAMBERT 博客的主要內容,后續關于 Llama 2 的分析文章他還在準備中,感興趣的讀者可以關注一下。