擴散模型也能推薦短視頻!港大騰訊提出新范式DiffMM

想象一下你在刷短視頻,系統(tǒng)想要推薦你可能會喜歡的內(nèi)容。

但是,如果系統(tǒng)只知道你過去看過什么,而不了解你喜歡視頻的哪些方面(比如是畫面、文字描述還是背景音樂),那么推薦可能就不會那么精準(zhǔn)。

對此,來自港大和騰訊的研究人員推出了全新多模態(tài)推薦系統(tǒng)范式——DiffMM。

簡單來說,DiffMM創(chuàng)建了一個包含用戶和視頻信息的圖,這個圖會考慮視頻的各種元素。

然后它通過一種特殊的方法(圖擴散)來增強這個圖,讓模型更好地理解用戶和視頻之間的關(guān)系。

最后,它使用一種叫做對比學(xué)習(xí)的技術(shù),來確保不同元素(比如視覺和聲音)之間的一致性,這樣推薦系統(tǒng)就能更好地理解用戶的喜好。

為了測試效果,團隊在三個公共數(shù)據(jù)集上進行了大量實驗,結(jié)果證明DiffMM相比于各種競爭性基線模型均達到SOTA。

目前相關(guān)論文已公開,代碼也已開源。

模型方法

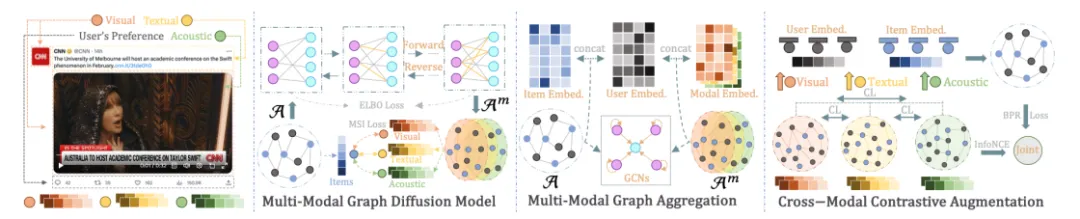

DiffMM的總體框架圖如下所示,主要包含三個部分:

- 多模態(tài)圖擴散模型,通過生成擴散模型實現(xiàn)多模態(tài)信息引導(dǎo)的模態(tài)感知用戶-物品圖生成;

- 多模態(tài)圖聚合,通過在生成的模態(tài)感知用戶-物品圖上進行圖卷積操作以實現(xiàn)多模態(tài)信息聚合;

- 跨模態(tài)對比增強,通過對比學(xué)習(xí)的方式來利用不同模態(tài)下用戶-物品交互模式的一致性,進一步增強模型的性能。

多模態(tài)圖擴散

受到擴散模型在保留其生成輸出中的基本數(shù)據(jù)模式方面的成功的啟發(fā),DiffMM框架提出了一種新穎的多模態(tài)推薦系統(tǒng)方法。

具體而言,作者引入了一個多模態(tài)圖擴散模塊,用于生成包含模態(tài)信息的用戶-物品交互圖,從而增強對用戶偏好的建模。

該框架專注于解決多模態(tài)推薦系統(tǒng)中無關(guān)或噪聲模態(tài)特征的負面影響。

為實現(xiàn)這一目標(biāo),作者使用模態(tài)感知去噪擴散概率模型將用戶-物品協(xié)同信號與多模態(tài)信息統(tǒng)一起來。

具體而言,作者逐步破壞原始用戶-物品圖中的交互,并通過概率擴散過程進行迭代學(xué)習(xí)來恢復(fù)原始交互。

這種迭代去噪訓(xùn)練有效地將模態(tài)信息納入用戶-物品交互圖的生成中,同時減輕了噪聲模態(tài)特征的負面影響。

此外,為實現(xiàn)模態(tài)感知的圖生成,作者提出了一種新穎的模態(tài)感知信號注入機制,用于指導(dǎo)交互恢復(fù)過程。這個機制在有效地將多模態(tài)信息納入用戶-物品交互圖的生成中起到了關(guān)鍵作用。

通過利用擴散模型的能力和模態(tài)感知信號注入機制,DiffMM框架為增強多模態(tài)推薦器提供了一個強大而有效的解決方案。

圖概率擴散范式

在用戶-物品交互上進行圖擴散包含兩個關(guān)鍵工程。

第一個過程稱為前向過程,它通過逐步引入高斯噪聲來破壞原始的用戶-物品圖。這一步驟逐漸破壞了用戶和物品之間的交互,模擬了噪聲模態(tài)特征的負面影響。

第二個過程稱為逆向過程,它專注于學(xué)習(xí)和去噪受損的圖連接結(jié)構(gòu)。這個過程旨在通過逐步改進受損的圖來恢復(fù)用戶和物品之間的原始交互。

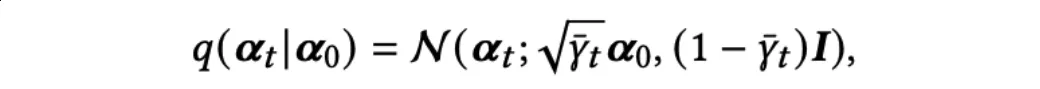

對于前向圖擴散過程,考慮用戶??和物品集合??中每個物品的交互,定義為 ????=[ ,

, ,…,

,…, ],這里

],這里 等于0或1表示用戶??是否和物品??有發(fā)生交互。首先將擴散過程進行初始化: ??0= ????,這個前向過程之后在??步中逐漸添加高斯噪聲,以馬爾可夫鏈的形式構(gòu)建??1:??。

等于0或1表示用戶??是否和物品??有發(fā)生交互。首先將擴散過程進行初始化: ??0= ????,這個前向過程之后在??步中逐漸添加高斯噪聲,以馬爾可夫鏈的形式構(gòu)建??1:??。

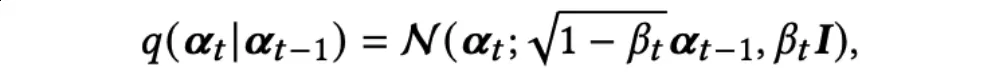

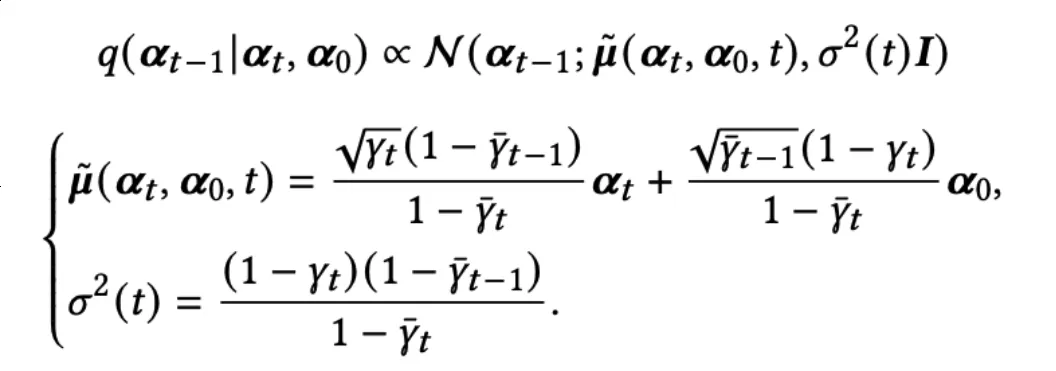

具體而言,從??t-1到??t的過程參數(shù)化為:

當(dāng)??→∞時,狀態(tài)????逐漸趨向于一個標(biāo)準(zhǔn)的高斯分布。作者使用重參數(shù)技巧以及獨立高斯噪聲可相加的性質(zhì),直接從??0得到??t:

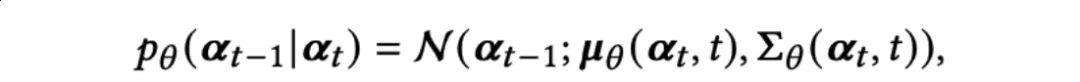

對于逆向圖擴散過程,DiffMM旨在消除從??t引入的噪聲,逐步恢復(fù)??t-1。這個過程使得多模態(tài)擴散能夠有效地捕捉復(fù)雜的生成過程中的微小變化。從????開始,去噪過程逐步恢復(fù)用戶-物品交互,逆向過程展開如下:

作者使用參數(shù)為??的神經(jīng)網(wǎng)絡(luò)來生成一個高斯分布的均值????(??t,t)和協(xié)方差 ????(??t,t)。

模態(tài)感知的圖擴散優(yōu)化

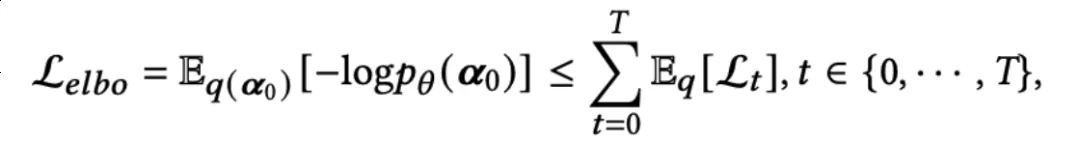

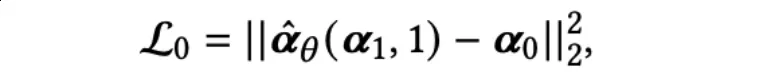

擴散模型的優(yōu)化目標(biāo)是引導(dǎo)逆向圖擴散過程。為了實現(xiàn)這一目標(biāo),應(yīng)優(yōu)化??0的負對數(shù)似然的Evidence Lower Bound (ELBO):

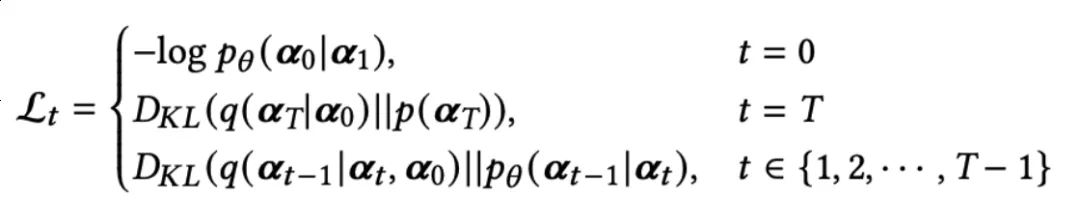

對于??t,有三種情況:

這里,??0是??0的負重建誤差;????是一個在優(yōu)化中可以忽略的常量項,因為它不包含可優(yōu)化的參數(shù);????(t?{1,2,…,T-1})旨在通過KL離散度使分布????(??t-1|??t)和可計算的分布q(??t-1|??t,??0)對齊。

為了實現(xiàn)圖擴散的優(yōu)化,作者設(shè)計了一個神經(jīng)網(wǎng)絡(luò),以在反向過程中進行去噪處理。根據(jù)貝葉斯法則,q(??t-1|??t,??0)可被表示為如下近似表達:

更進一步,??t可以表示為:

這里, (??t,t)是基于??t和時間t預(yù)測的??0,作者使用神經(jīng)網(wǎng)絡(luò)來實現(xiàn)它。具體而言,作者使用一個多層感知器(MLP)來實現(xiàn)

(??t,t)是基于??t和時間t預(yù)測的??0,作者使用神經(jīng)網(wǎng)絡(luò)來實現(xiàn)它。具體而言,作者使用一個多層感知器(MLP)來實現(xiàn) ,該MLP以??t和時間t的嵌入表示作為輸入來預(yù)測??0。對于??0,可以被表示為:

,該MLP以??t和時間t的嵌入表示作為輸入來預(yù)測??0。對于??0,可以被表示為:

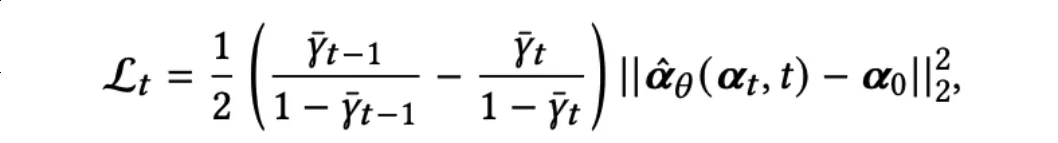

在實際實現(xiàn)中,作者從 {1,2,…,??} 中均勻采樣來得到時間步t:

多模態(tài)圖擴散的目標(biāo)是通過模態(tài)感知的用戶-物品圖來增強推薦系統(tǒng)。

為此,作者設(shè)計了一種模態(tài)感知信號注入(MSI)機制,引導(dǎo)擴散模塊生成帶有相應(yīng)模態(tài)的多個用戶-物品圖。

具體而言,作者將對齊的物品模態(tài)特征與預(yù)測的模態(tài)感知用戶-物品交互概率進行聚合。

同時,作者還將物品id嵌入????與觀察到的用戶-物品交互??0進行聚合。

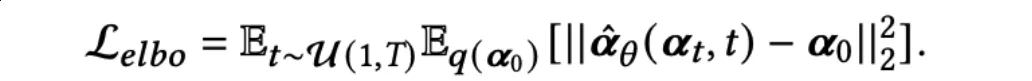

最后,計算上述兩個聚合嵌入之間的均方誤差損失,并與??e??bo一起進行優(yōu)化。形式化地,模態(tài)??的均方誤差損失如下所示:

跨模態(tài)對比增強

在多模態(tài)推薦場景中,不同物品模態(tài)(例如:視覺、文本和音頻)上的用戶交互模式存在一定程度的一致性。

例如,在短視頻的情況下,其視覺和音頻特征可以共同吸引用戶觀看。

因此,用戶的視覺偏好和音頻偏好可能以復(fù)雜的方式交織在一起。為了捕捉和利用這種模態(tài)相關(guān)的一致性來提高推薦系統(tǒng)的性能,作者設(shè)計了兩種基于不同錨點的模態(tài)感知對比學(xué)習(xí)范式。

一種范式以不同的模態(tài)視圖作為錨點,另一種范式則以主視圖(協(xié)同過濾)作為錨點。

模態(tài)感知的對比視圖

為了生成特定模態(tài)的用戶/物品嵌入表示作為對比視圖,作者使用了基于GNN的表示學(xué)習(xí)方法。

具體而言,在圖擴散模型生成的模態(tài)感知用戶-物品圖上進行消息傳遞。

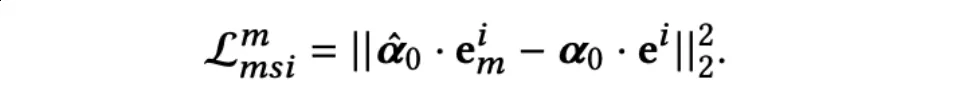

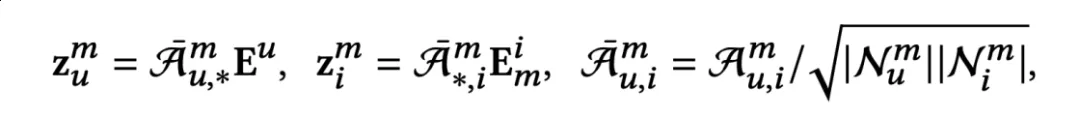

首先,作者將物品原始模態(tài)信息轉(zhuǎn)化為相同維度的物品模態(tài)特征:

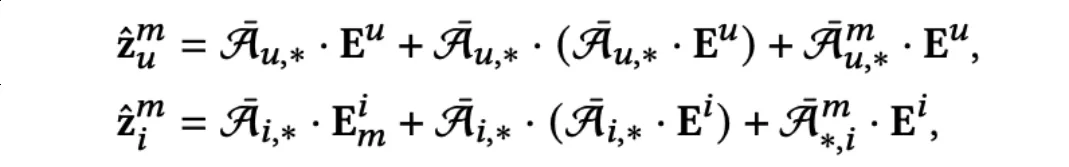

接下來,對用戶嵌入和物品模態(tài)特征進行信息聚合,得到聚合的模態(tài)感知嵌入??m∈?d:

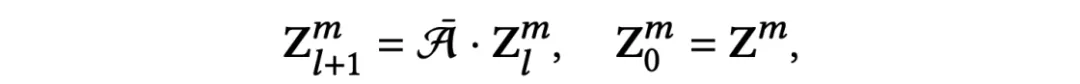

這里,??m∈???×??表示通過圖擴散模型生成的模態(tài)感知圖。為了獲得多模態(tài)感知的高階協(xié)同信息,作者進一步在原始用戶-物品交互圖??進行了迭代的消息傳遞:

模態(tài)感知的對比增強

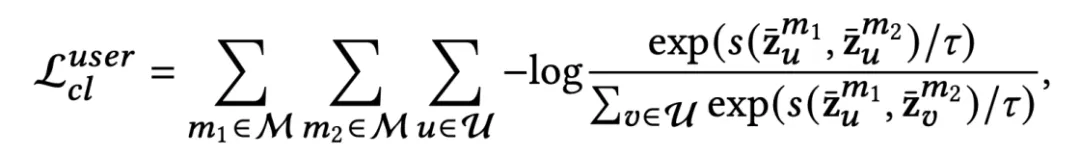

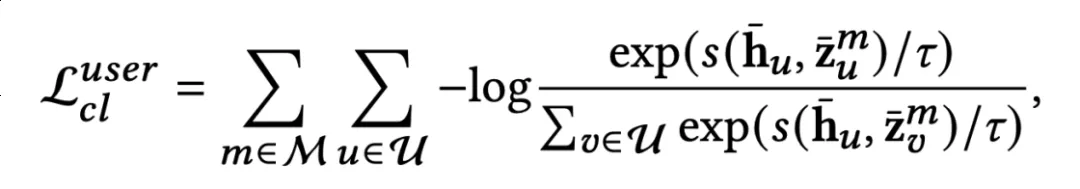

通過模態(tài)感知的對比視圖,作者采用了兩種不同的對比方法。

其中一種利用不同的模態(tài)視圖作為錨點,而另一種則使用主視圖作為錨點。

前者的思想是基于用戶在不同模態(tài)中的行為模式具有關(guān)聯(lián)性,而后者則希望用戶在不同模態(tài)中的行為模式可以引導(dǎo)及提升主視圖的偏好表達。這里的主視圖指通過GNN在多個模態(tài)感知圖上聚合再進一步融合得到的用戶與物品表達。兩種對比方法的對比損失(InfoNCE loss)分別如下所示。

模態(tài)視圖作為錨點:

主視圖作為錨點:

多模態(tài)圖聚合

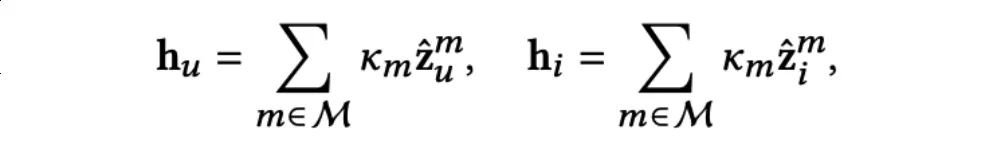

為了生成最終的用戶(物品)表示以進行預(yù)測,作者首先對所有的模態(tài)感知嵌入和相應(yīng)的模態(tài)感知用戶-物品圖進行聚合:

之后通過一個可學(xué)習(xí)的參數(shù)化向量Km控制各個模態(tài)的權(quán)重,以求和的方式融合各個模態(tài)的表示:

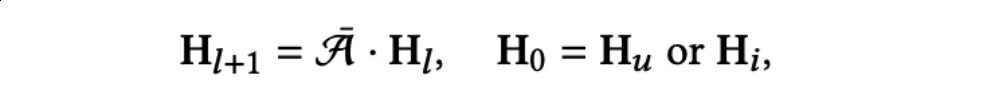

之后在原始的用戶-物品交互圖??上進行消息傳遞,以利用高階的協(xié)同信號:

多任務(wù)模型訓(xùn)練

DiffMM的訓(xùn)練包含兩個部分:對于推薦任務(wù)的訓(xùn)練和對于多模態(tài)圖擴散模型的訓(xùn)練。

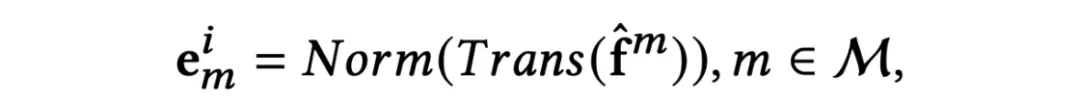

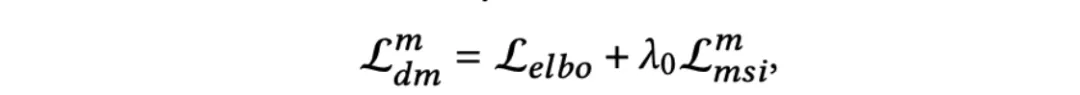

對于擴散模型的聯(lián)合訓(xùn)練,也包括兩個部分:ELBO損失和MSI損失。對于模態(tài)??的擴散模型去噪網(wǎng)絡(luò)的優(yōu)化損失如下:

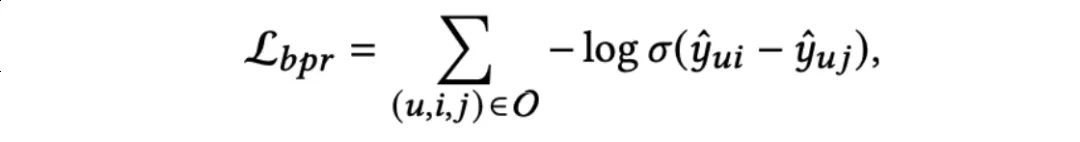

對于推薦任務(wù)的訓(xùn)練,作者引入了經(jīng)典的貝葉斯個性化排名(BPR)損失和多模態(tài)對比增強損失??c??,BPR損失定義如下:

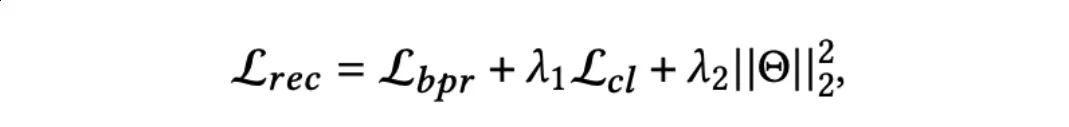

推薦任務(wù)的聯(lián)合優(yōu)化目標(biāo)如下:

實驗結(jié)果

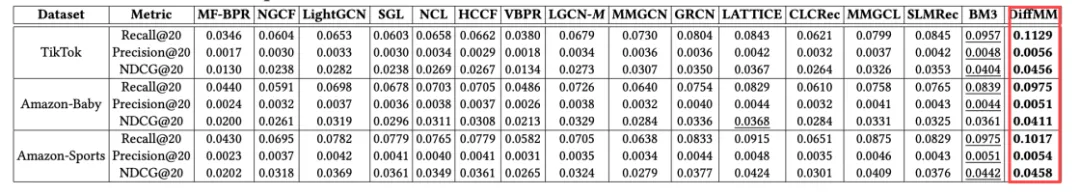

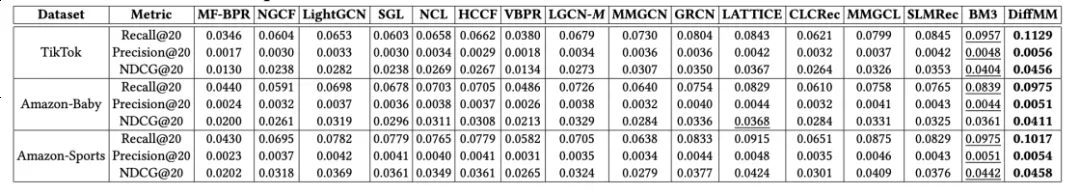

作者在三個公開數(shù)據(jù)集上對比了多個類型最新的基線模型,包括傳統(tǒng)的協(xié)同過濾方法,基于GNN的方法,生成擴散推薦方法,自監(jiān)督推薦方法以及SOTA的多模態(tài)推薦方法。

通過廣泛而充分的實驗,結(jié)果表明提出的DiffMM在總體性能上具有最優(yōu)的性能。

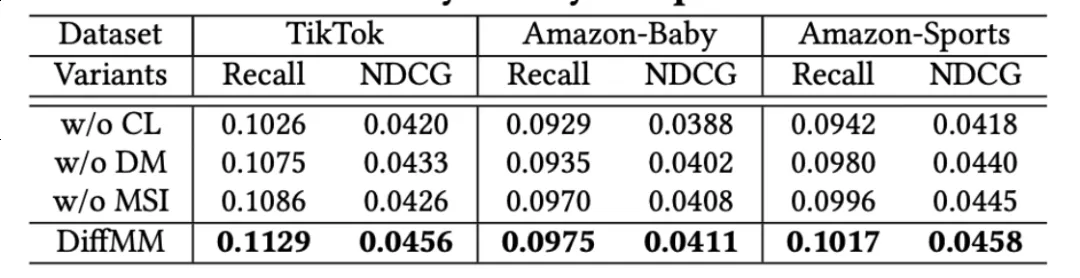

為了驗證所提出方法各個模塊的有效性,作者進行了細致的消融實驗,實驗結(jié)果表明所提出的各個子組件均有提升推薦效果的功能:

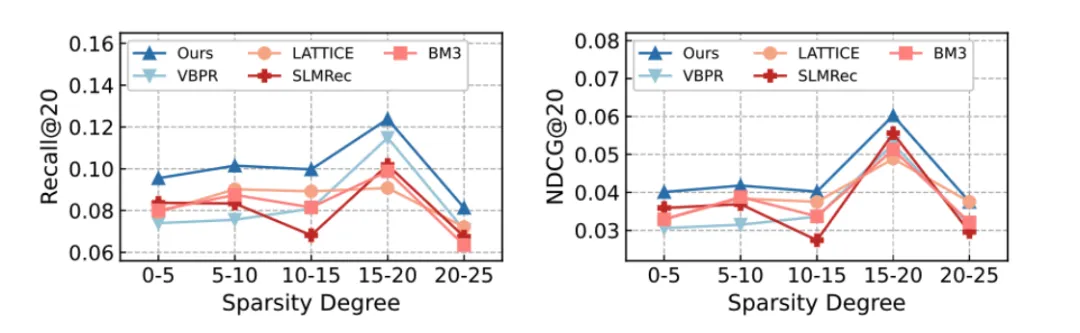

作者進一步探索了DiffMM在數(shù)據(jù)稀疏問題上的表現(xiàn),實驗結(jié)果表明DIffMM中的跨模態(tài)對比學(xué)習(xí)方式可以有效緩解數(shù)據(jù)稀疏的問題,它通過使用圖擴散模型生成的模態(tài)感知用戶-物品圖來獲得高質(zhì)量的自監(jiān)督信號。

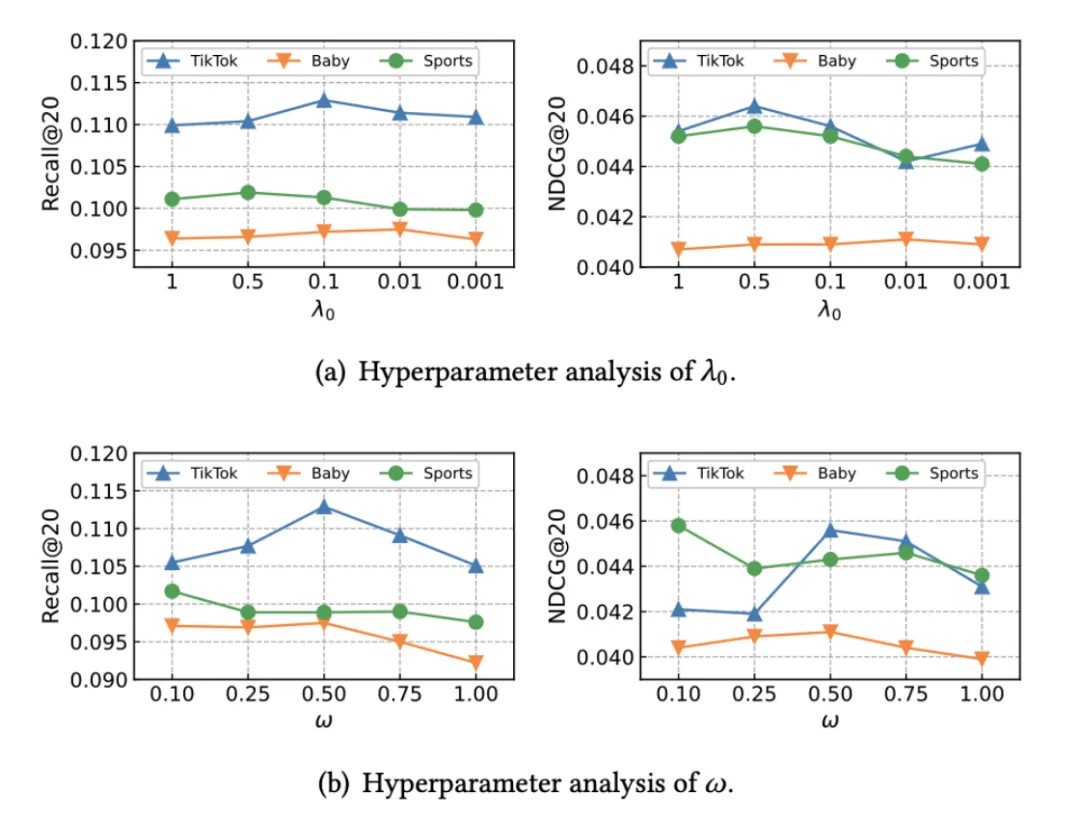

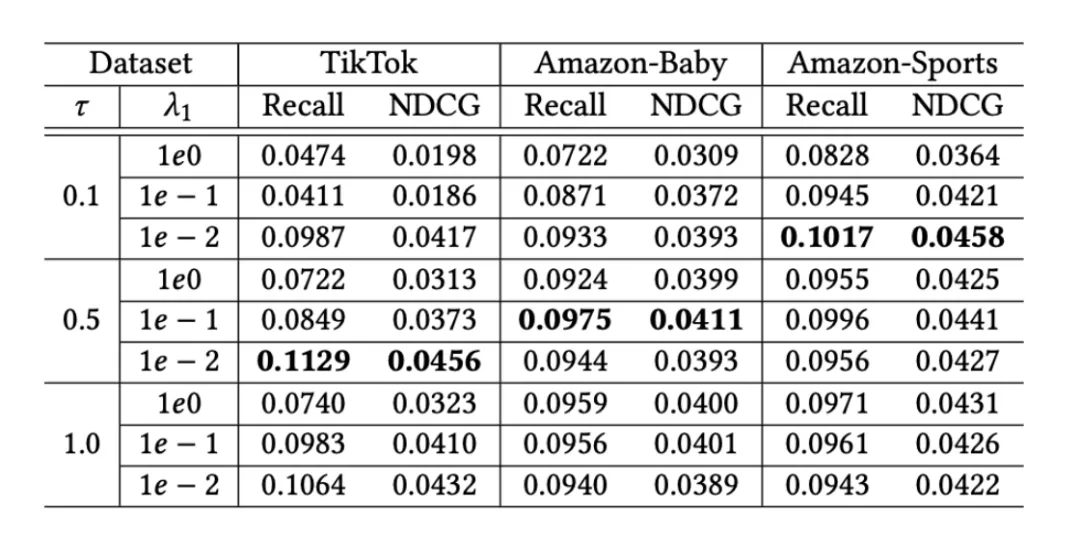

對于所提出的DiffMM,作者對一些重要的超參數(shù)進行了分析,包括多模態(tài)圖聚合模塊中的超參數(shù)、模態(tài)感知擴散模型中的MSI權(quán)重、以及多模態(tài)對比增強范式中的溫度系數(shù)等:

為了更直觀地評估所提出的模態(tài)感知圖擴散模型對推薦系統(tǒng)性能的影響,作者研究了模態(tài)感知用戶-物品圖(由DiffMM生成)和通過邊丟棄進行隨機增強的用戶-物品圖之間的融合比率對于自監(jiān)督增強對比視圖構(gòu)建的影響。

融合比率為0表示僅使用模態(tài)感知的用戶-物品圖來構(gòu)建對比視圖,而融合比率為1則表示僅使用隨機增強方法。

結(jié)果明確表明,在兩個數(shù)據(jù)集中,融合比率的增加導(dǎo)致模型性能的下降。

這一發(fā)現(xiàn)表明模態(tài)感知的圖擴散模型通過提供模態(tài)感知的對比視圖而不是隨機增強視圖來增強跨模態(tài)對比學(xué)習(xí)的優(yōu)越性。這個優(yōu)勢可以歸因于基于圖擴散的生成方法對潛在交互模式的有效建模,以及通過精心設(shè)計的生成機制將多模態(tài)上下文納入到用戶-物品交互圖的擴散過程中。

總結(jié)

本文介紹了一種新的多模態(tài)推薦模型DiffMM,它通過結(jié)合模態(tài)意識豐富了概率擴散范式。

該方法利用多模態(tài)圖擴散模型重構(gòu)了模態(tài)感知的用戶-項目圖,同時利用跨模態(tài)數(shù)據(jù)增強模塊的優(yōu)勢提供有價值的自監(jiān)督信號。

為了評估DiffMM的有效性,作者進行了大量的實驗,并將其與幾種競爭基線模型進行了比較,結(jié)果證明了DiffMM在推薦性能方面的優(yōu)越性。

論文:https://arxiv.org/abs/2406.11781

代碼:https://github.com/HKUDS/DiffMM