首個開源、原生多模態生成大模型:一鍵生成 「煎雞蛋」圖文菜譜

生成式人工智能研究實驗室(GAIR,主頁:https://plms.ai/)由上海交通大學劉鵬飛副教授2023年4月回國創建,是國內首個聚焦于生成式人工智能的高校研究組。匯聚了來自于CMU、復旦、交大(ACM班、IEEE試點班等)等頂尖高校的年輕本碩博人才。實驗室專注于三大核心領域:大模型基礎研究、對齊系統和社會影響,致力于培養頂尖人工智能人才(具有原創、批判精神等)、開發尖端的生成式人工智能技術,賦能人類解決復雜問題,提升人類生活質量。

自LLaMa自回歸文本生成大模型耀眼登場以來,整個AI界翹首以盼,期待一個能夠真正實現原生、自回歸圖文生成的開源大模型。17個月的漫長等待,我們見證了以文本為核心的LLaVa的崛起,目睹了基于Diffusion的Dalle的驚艷,卻始終未能一睹那個能夠完美融合文字與圖像的模型真容。

直到今天,Anole的誕生,終于填補了這一空白,滿足了AI研究者和開發者的殷切期盼,讓每個人都可以用開發LLaMa的方式去開發多模態大模型。

想象一下,你只需敲擊幾個鍵盤,就能喚醒一位虛擬大廚,為你展示一道完美煎蛋的每一個精妙步驟。這不再是科幻,而是由上海交通大學GAIR團隊帶來的創新成果——Anole模型。

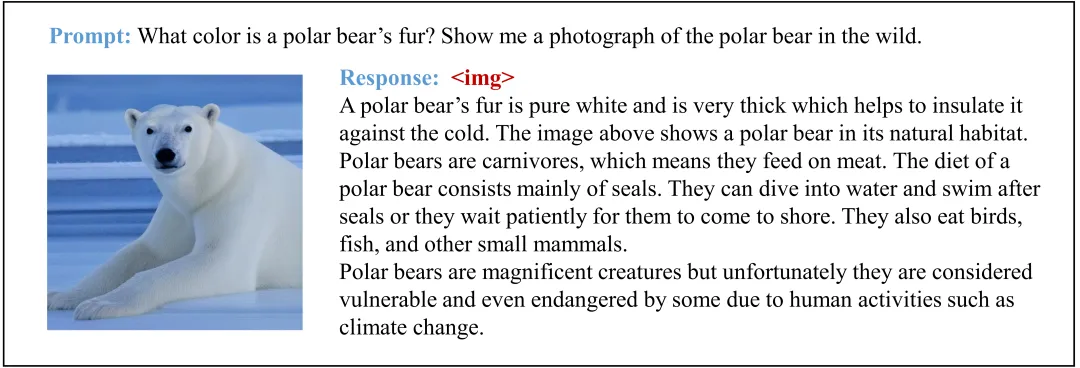

Anole是多模態大模型領域發展的一次重要技術突破,作為全球首個完全開源、自回歸、原生的(文本與圖片一起從頭訓練)多模態大模型。無需復雜的擴散模型,Anole憑借純粹的"token"自回歸預測,就能實現文字與圖像的無縫交織。如圖所示,當你在Anole的界面上輸入"用圖片和文字講解煎雞蛋的每一步"時,它會瞬間化身為你的私人廚藝導師。一系列生動形象的步驟圖隨即呈現,每一幅圖都配有清晰明了的文字說明,仿佛一位耐心的大廚在為你量身定制教程。

這僅僅是Anole眾多強大功能中的一個。接下來,讓我們深入了解這個創新的多模態生成模型及其背后的技術。

- 項目主頁:https://gair-nlp.github.io/anole

- Github: https://github.com/GAIR-NLP/anole

- Huggingface: https://huggingface.co/GAIR/Anole-7b-v0.1

Anole是首個能夠實現交錯圖文生成的開源、自回歸、原生訓練的大型多模態模型(無需使用穩定擴散技術)。雖然它建立在Meta 開源的Chameleon[1]的優勢基礎之上,但Anole新增了生成連貫的交替文本和圖像序列這一復雜任務。通過使用精心構建的的約6,000張圖像數據集進行創新性微調,Anole以最少的額外訓練實現了出色的圖像生成和理解能力。這種高效的方法,加上其開源特性,使Anole成為加速多模態AI研究和開發的催化劑。初步測試表明,Anole具有卓越的能力,能夠遵循細致入微的指令,產生高質量的圖像和交錯的文本-圖像內容,與用戶提示密切吻合。

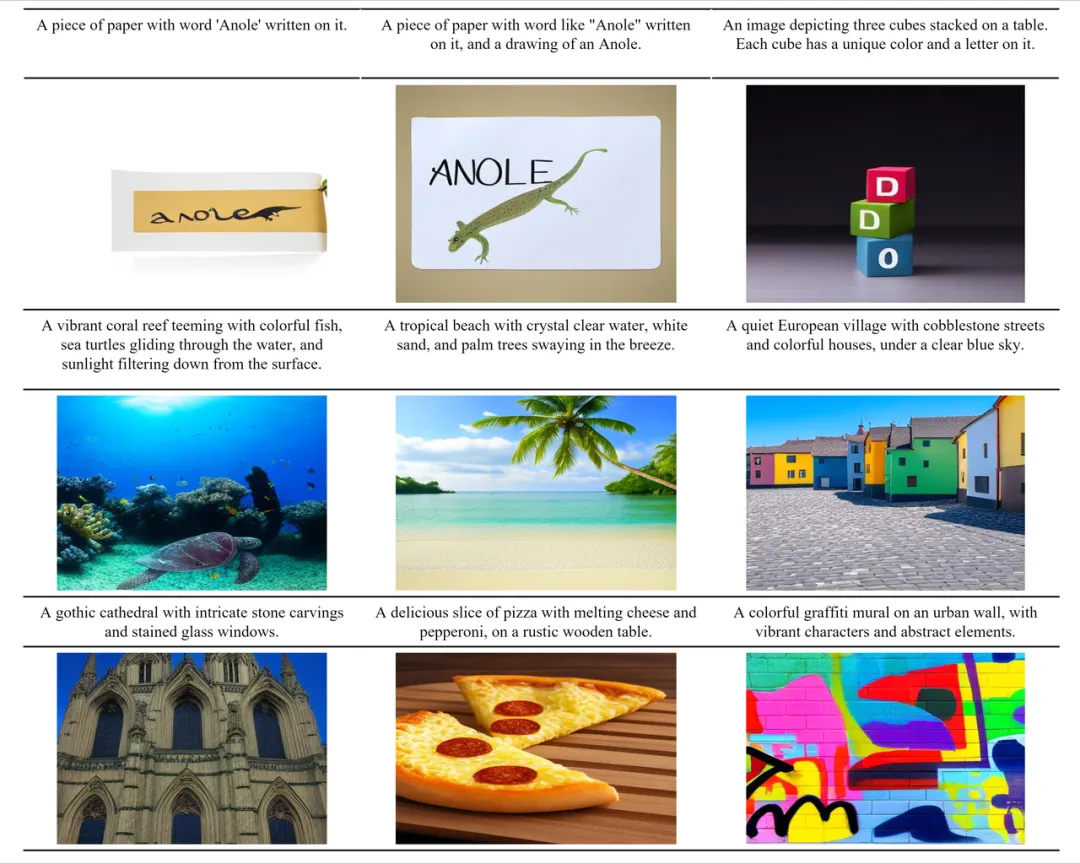

除了具備常規多模態模型的“文本生成”和“多模態理解”能力外,Anole還展現了出色的圖文交錯生成和文本生成圖像的能力。

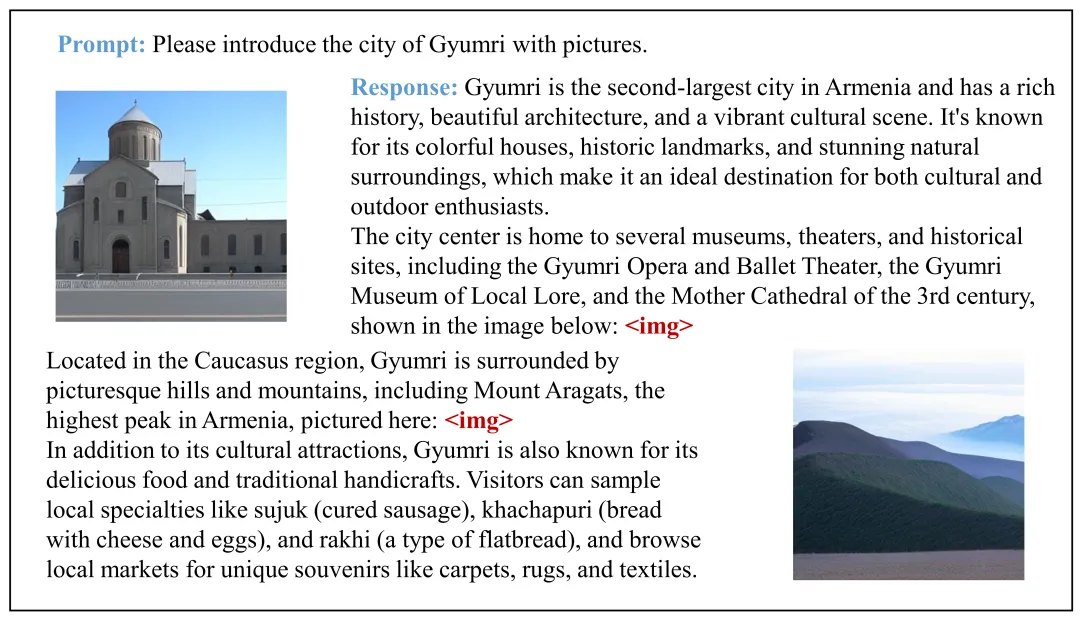

- 文本 → 圖片 + 文本:能夠生成圖像并附帶相關文本描述。除開上文中使用Anole以生成一系列煎蛋步驟的圖片并附上相關描述文字的例子外。模型還可以生成其他圖文交錯的數據。這種能力在初步測試中表現良好,能夠生成有意義的圖像并準確傳達文本信息。

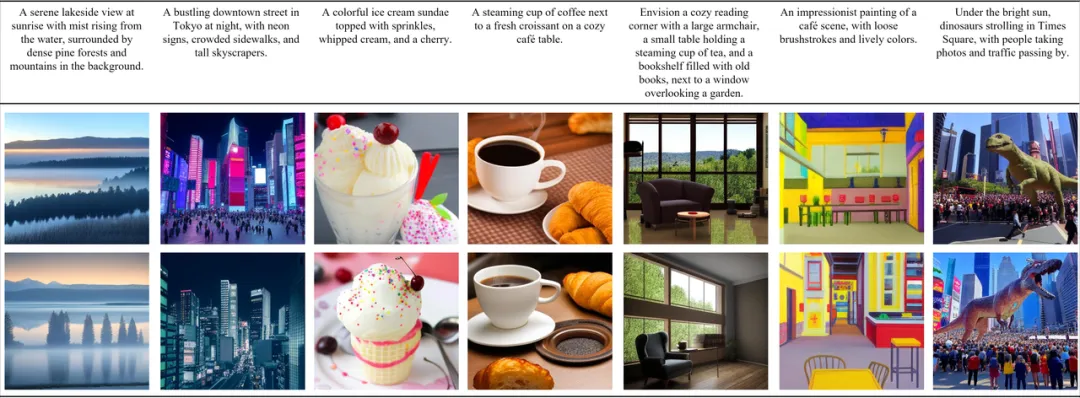

- 文本 → 圖片:能夠根據文本生成圖像。

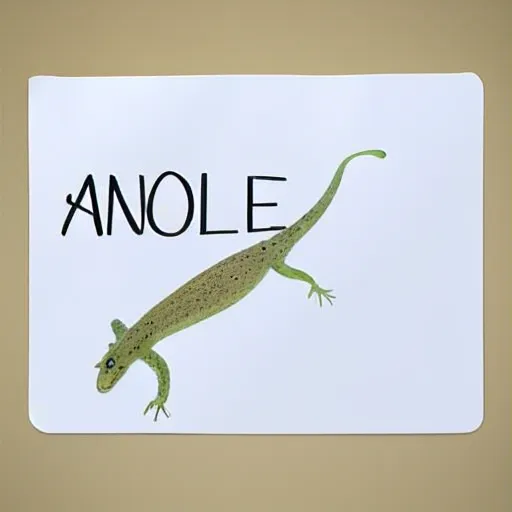

指令: A piece of paper with word like "Anole" written on it, and a drawing of an Anole.

生成結果:

指令: An image depicting three cubes stacked on a table. Each cube has a random color and a letter on it.

生成結果:

更多例子:

訓練技術

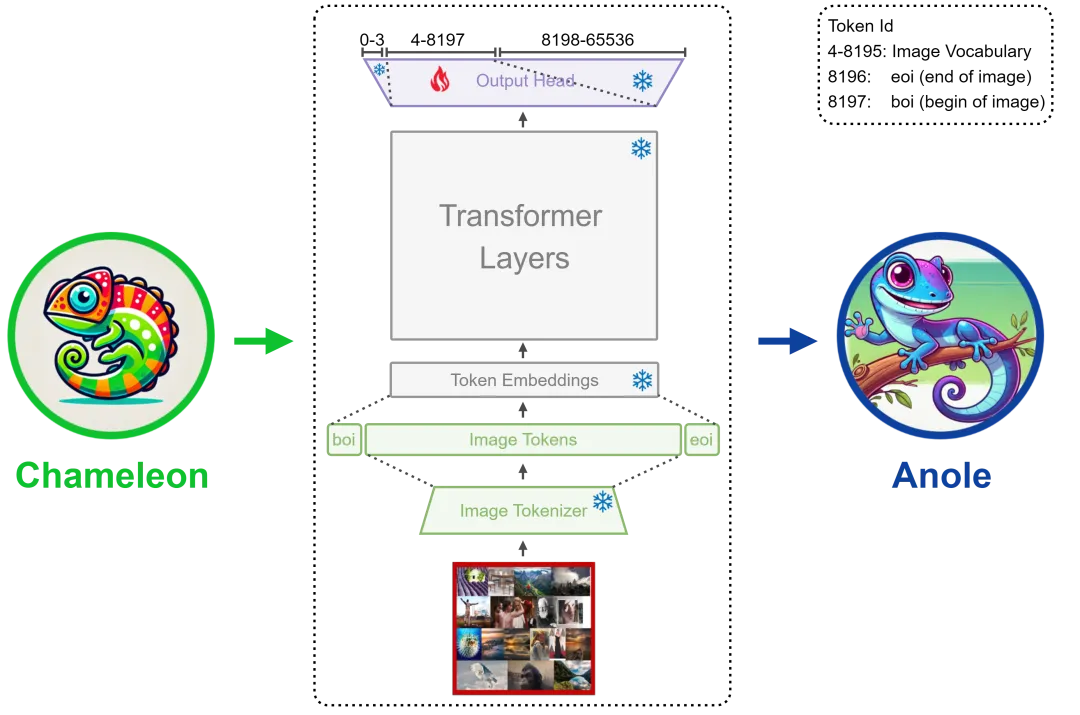

近年來,多模態AI技術取得了顯著進展,Meta AI推出的Chameleon模型便是其中的代表。Chameleon通過在預訓練期間融合圖像和文本語料的方法,展示了在視覺和語言整合方面的潛力。然而,盡管Chameleon具有突破性,其圖像生成的關鍵網絡參數并未開源,限制了其進一步的研究和實際應用。

Chameleon的預訓練數據本身就包含了文本和圖像兩種模態,理論上賦予了它圖像生成的能力。我們的目標是在不影響其文本理解、生成和多模態理解能力的前提下,激活這種能力。為實現這一目標,我們凍結了Chameleon的大部分參數,僅對transformer的輸出頭層中與圖像token ID對應的logits進行了微調。

具體而言,Anole具體如下特性:

- 快速高效的微調手段:通過創新的局部微調方法,只調整不到40m參數,在短時間內(8 個 A100 GPU 上大約 30 分鐘),便成功激發出Chameleon的圖像生成能力,使研究人員和開發者能夠充分利用并基于Chameleon的架構進行后續的多模態AI研究工作。

- 少即是多(Less is More)的微調數據:僅需5,859個圖片樣本便可有效激發Chameleon的圖像生成能力,展示了在大型多模態模型中恢復復雜功能的高效性。

- 全面的微調和推理代碼:提供了一整套用于微調、推理Chameleon和Anole的代碼庫,顯著降低了開發和實驗的門檻。

- 豐富的資源以提升可及性:提供了豐富的數據資源和詳細的教程,旨在幫助各級別的研究人員更容易上手和實驗。

全方位開源

值得注意的是,GAIR團隊已經對 Anole項目進行完全開源(提供了開源的模型權重、推理與訓練代碼和詳細使用教程),以確保每個感興趣的研究者都能重現這些結果,可以微調模型,創建自己的風格變體。該項目旨在建立和共享一個具有完整圖文理解和生成能力的多模態模型,并通過完全開源實現多模態技術民主化,讓更多人可以加入多模態大模型的開發中。

當前版本(v1.0)具體提供了如下的資源:

- 模型微調代碼(基于HuggingFace Trainer)

- 權重轉換代碼(Hf->Meta & Meta->Hf)

- 與圖像生成有關的推理代碼:包括文生圖以及圖文交互

- 5k+圖片用于微調模型以賦予其圖像生成的能力

更重要的是,Anole 為學術界開啟了一系列重要且富有挑戰性的研究方向。具體而言:

- 它為探索統一的基于分詞器的多模態模型(token-based)的性能上限提供了新的途徑,使得與擴散模型 (diffusion-based) 等方法的比較成為可能。

- 同時,它推動了高效交錯文本-圖像解碼技術的發展,這對實時應用至關重要(比如動漫生成、教材生成)

- 此外,Anole 為探索這類復雜模型的最優微調策略創造了契機,并提出了如何確保生成圖像安全性和倫理使用等亟待解決的問題。

從根本上說,Anole 不僅是一個強大的工具,更是為未來研究提供了沃土,為 AI 社區構建了一個穩固的資源和基礎設施平臺,使其能夠在此基礎上不斷創新和發展。這種開放的方法有望加速多模態 AI 的進展,有可能帶來突破性成果,而這些成果在過去因缺乏先進模型和技術的獲取途徑而難以實現。