蘋果為什么要用「小模型」?

在WWDC 2024上,蘋果重新定義了AI——Apple Intelligence。

這是一款深度集成到iOS 18、iPadOS 18和macOS Sequoia中的個人智能系統(tǒng)。

與其他科技大廠不同的是,「蘋果牌」AI并沒有奉行「越大越好」的宗旨。

相反,蘋果的態(tài)度更加務(wù)實,優(yōu)先考慮用戶體驗,更強(qiáng)調(diào)AI模型的定制化。

將生成式AI無縫融入操作系統(tǒng),——從某種意義上來說,這是一種非常「蘋果」的做法。

Apple Intelligence由多個功能強(qiáng)大的生成模型組成,這些模型專門用于用戶的日常任務(wù),可以即時適應(yīng)用戶當(dāng)前的活動。

Apple Intelligence內(nèi)置的基礎(chǔ)模型針對用戶體驗進(jìn)行了微調(diào),例如編寫和優(yōu)化文本、摘要、確定通知的優(yōu)先級、為對話創(chuàng)建有趣的圖像,以及簡化跨App的交互。

蘋果傾向于利用設(shè)備端的小模型搞定這些事情,當(dāng)然用戶也可以選擇使用ChatGPT等第三方的服務(wù),但這時數(shù)據(jù)方面的責(zé)任就跟蘋果沒有關(guān)系了。

蘋果著重介紹了其中兩個模型:一個約30億參數(shù)的設(shè)備端語言模型,以及一個更大的基于服務(wù)器的語言模型(可通過私有云計算在蘋果服務(wù)器上運(yùn)行)。

Keep Small

蘋果基礎(chǔ)模型概覽

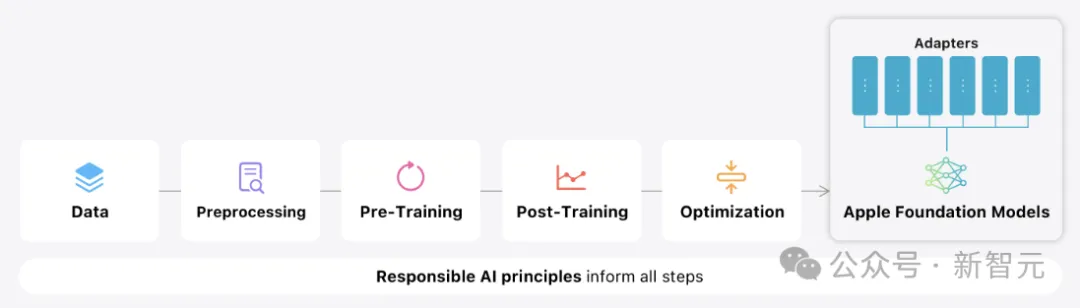

預(yù)訓(xùn)練

蘋果的基礎(chǔ)模型是在AXLearn框架上訓(xùn)練的。

AXLearn是蘋果在2023年發(fā)布的一個開源項目,它建立在JAX和XLA之上,使蘋果能夠在各種訓(xùn)練硬件和云平臺上以高效率和可擴(kuò)展性訓(xùn)練模型,包括TPU、云端和本地GPU。

蘋果結(jié)合使用數(shù)據(jù)并行、張量并行、序列并行和完全分片數(shù)據(jù)并行 (FSDP)來沿數(shù)據(jù)、模型和序列長度等多個維度擴(kuò)展訓(xùn)練。

蘋果使用網(wǎng)絡(luò)爬蟲AppleBot來收集公開可用的數(shù)據(jù),——如果Web發(fā)布者不希望自己的內(nèi)容被Apple Intelligence用于訓(xùn)練,蘋果也提供了各種粒度的控制方案。

蘋果表示,在訓(xùn)練基礎(chǔ)模型時,從不使用用戶的私人個人數(shù)據(jù)或用戶交互,并且蘋果應(yīng)用過濾器來刪除互聯(lián)網(wǎng)上公開的個人身份信息(比如社會保險和信用卡號)。

除了過濾之外,蘋果還通過數(shù)據(jù)提取、重復(fù)數(shù)據(jù)刪除和基于模型的分類器的應(yīng)用,以識別高質(zhì)量的文檔。

后處理

眾所周知,數(shù)據(jù)質(zhì)量對于模型的成功至關(guān)重要。

蘋果在訓(xùn)練管道中使用混合數(shù)據(jù)策略,結(jié)合人工注釋和合成數(shù)據(jù),并執(zhí)行徹底的數(shù)據(jù)管理和過濾程序。

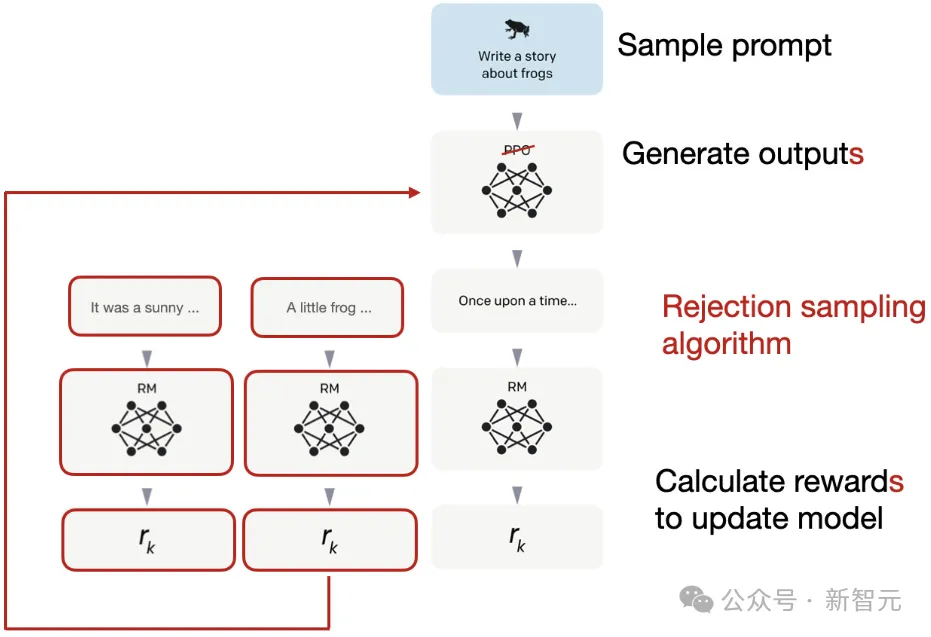

蘋果在后處理階段開發(fā)了兩種新穎的算法:

1. 拒絕抽樣微調(diào)算法(rejection sampling fine-tuning algorithm);

2. 基于人類反饋的強(qiáng)化學(xué)習(xí)(RLHF)算法,采用鏡像下降策略優(yōu)化和留一法優(yōu)勢估計器(leave-one-out advantage estimator)。

這兩種算法可以顯著提高模型的指令遵循質(zhì)量。

優(yōu)化

除了確保生成模型具有強(qiáng)大功能外,蘋果還使用了一系列創(chuàng)新技術(shù)在設(shè)備上和私有云上對其進(jìn)行優(yōu)化,以提高速度和效率。

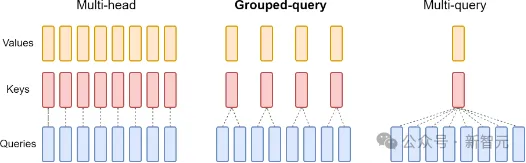

設(shè)備端模型和服務(wù)器模型都使用分組查詢注意力(grouped-query-attention),來優(yōu)化其推理性能。

蘋果使用共享的輸入和輸出詞匯表,來降低內(nèi)存需求和推理成本,保證了共享嵌入張量的映射沒有重復(fù)。

設(shè)備端模型使用49K的詞匯大小,而服務(wù)器模型使用100K的詞匯大小。

對于設(shè)備端推理,蘋果使用low-bit palletization,來滿足必要的內(nèi)存、功耗和性能要求。

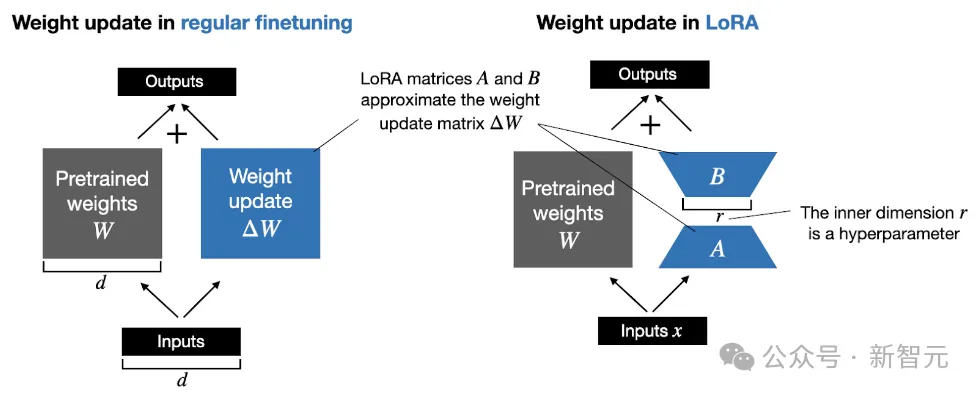

為了保持模型質(zhì)量,蘋果開發(fā)了一個使用LoRA適配器的新框架,混合使用2比特和4比特的配置策略(平均每個權(quán)重3.5比特),以實現(xiàn)與未壓縮模型相同的精度。

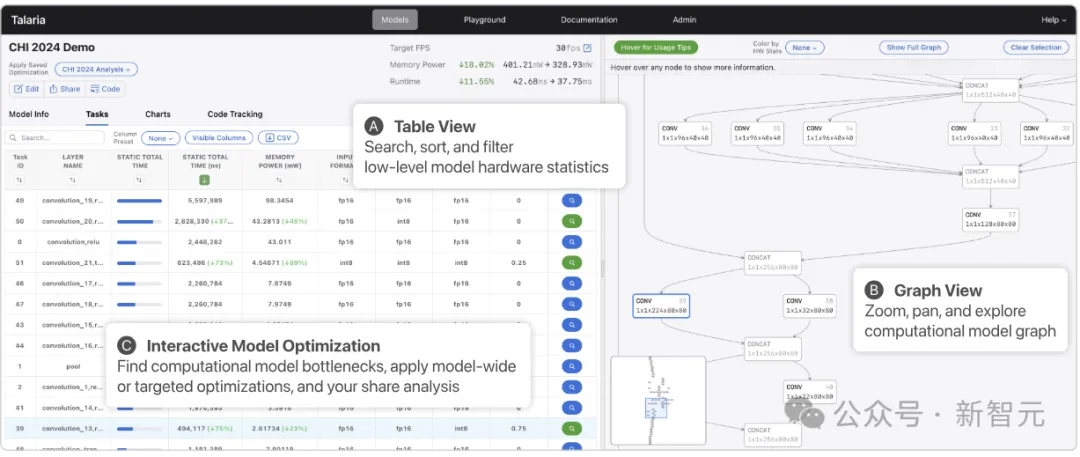

此外,蘋果還使用交互式模型延遲和功耗分析工具Talaria來更好地指導(dǎo)每個操作的比特率選擇。

利用激活量化和嵌入量化,可以在蘋果的神經(jīng)引擎上實現(xiàn)高效的鍵值緩存(KV cache)更新。

通過上面的這些優(yōu)化,iPhone 15 Pro能夠達(dá)到約0.6毫秒的延遲,以及每秒30個token的生成速率。

適配器

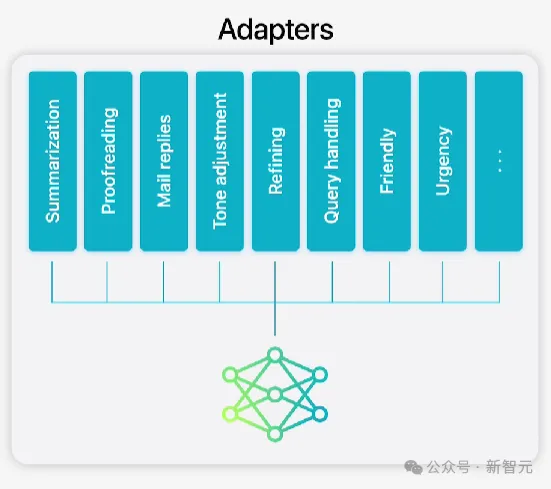

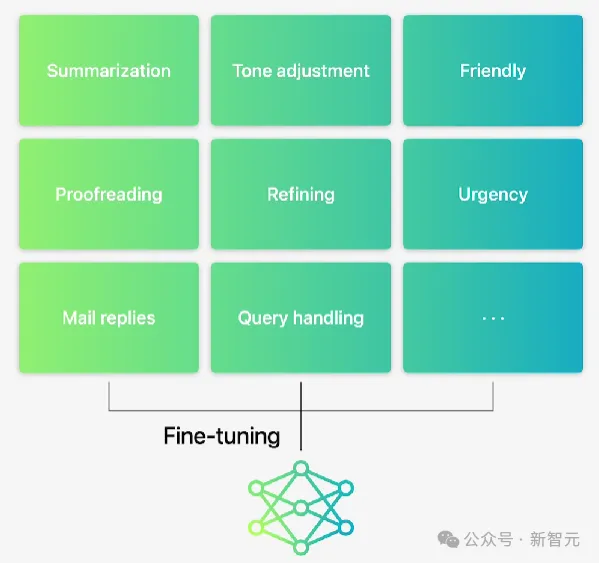

蘋果的基礎(chǔ)模型針對用戶的日常活動進(jìn)行了微調(diào),可以動態(tài)地專注于手頭的任務(wù)。

做法是將小型神經(jīng)網(wǎng)絡(luò)作為模塊(適配器,adapter),插入到預(yù)訓(xùn)練模型的各個層中,以實現(xiàn)針對特定任務(wù)的微調(diào)。

此外,蘋果調(diào)整了注意力矩陣、注意力投影矩陣和前饋網(wǎng)絡(luò)中的全連接層,以適應(yīng)Transformer架構(gòu)的的解碼層。

通過僅微調(diào)適配器層,基本預(yù)訓(xùn)練模型的原始參數(shù)保持不變,從而保留模型的一般知識,同時又能支持特定任務(wù)。

Apple Intelligence包含一組廣泛的適配器,這是擴(kuò)展基礎(chǔ)模型功能的有效方法。

蘋果使用16位表示適配器參數(shù)的值,對于30億個參數(shù)的設(shè)備模型,16級適配器的參數(shù)通常需要10兆字節(jié)。

適配器模型可以動態(tài)加載、臨時緩存在內(nèi)存中并進(jìn)行交換,保證了操作系統(tǒng)的響應(yīng)能力。

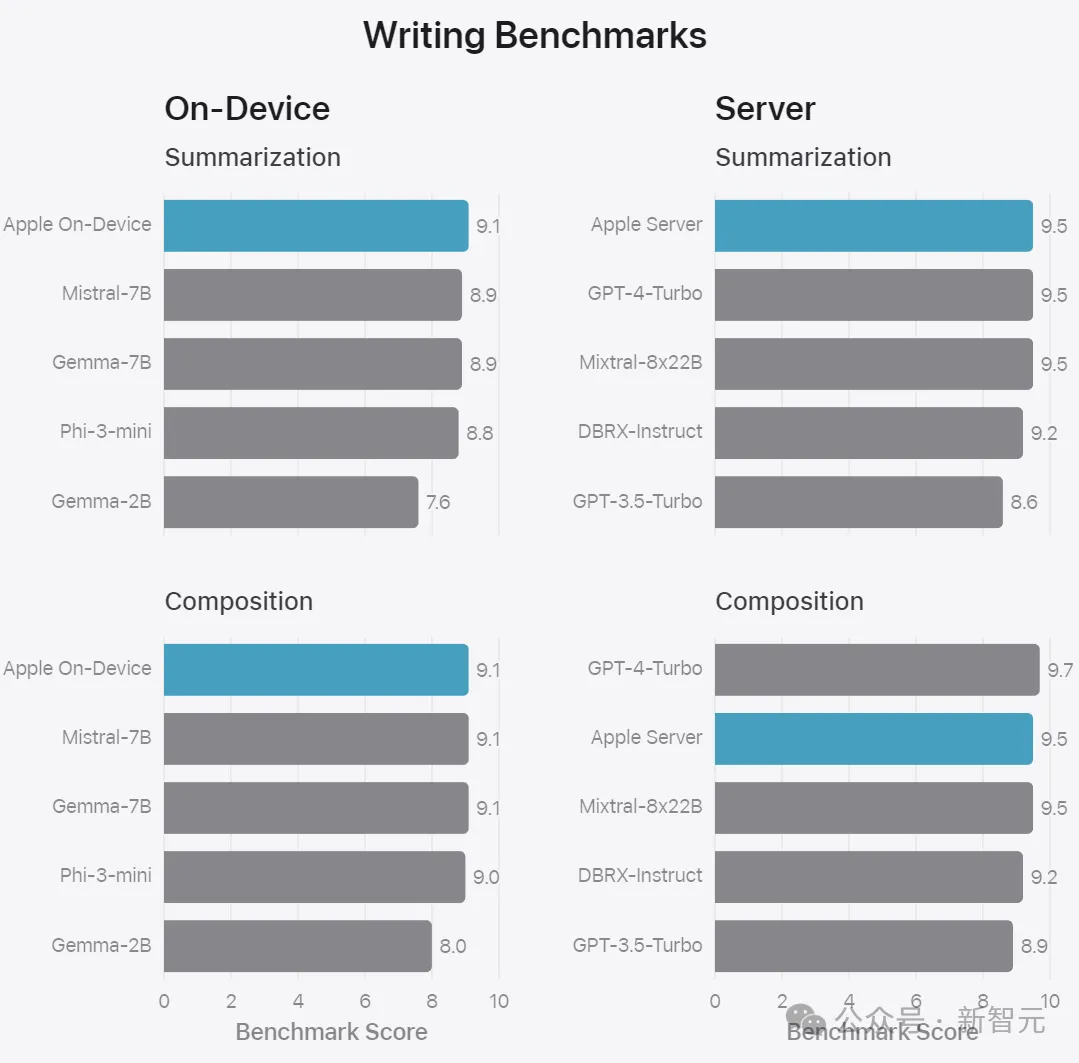

性能評估

因為用戶體驗是最高優(yōu)先級,所以在對模型進(jìn)行基準(zhǔn)測試時,蘋果專注于人工評估。

摘要

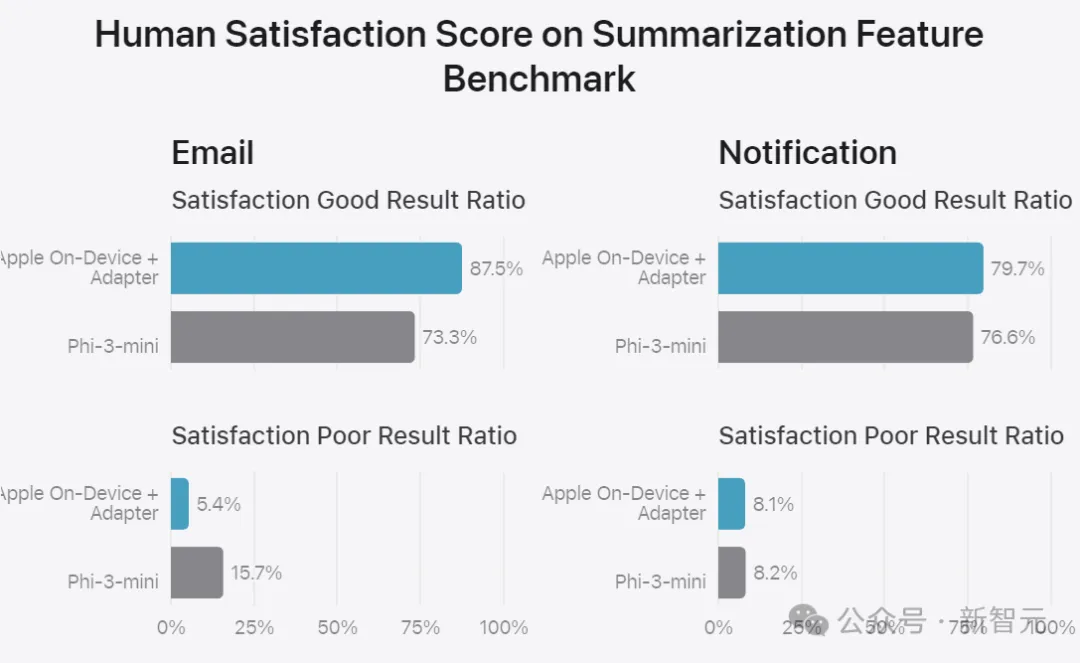

蘋果的訓(xùn)練數(shù)據(jù)基于從更大的服務(wù)器模型生成的合成摘要,并通過拒絕抽樣策略進(jìn)行過濾,僅保留高質(zhì)量的摘要。

為了評估特定于產(chǎn)品的摘要,這里使用一組750個響應(yīng),針對每個用例進(jìn)行了仔細(xì)抽樣。

評估數(shù)據(jù)集涵蓋了蘋果的產(chǎn)品功能在生產(chǎn)中可能面臨的各種輸入,包括不同內(nèi)容類型和長度的單個文檔和堆疊文檔的分層組合。

另外,評估摘要功能也要考慮到一些固有風(fēng)險,比如,模型偶爾會忽略掉一些重要的細(xì)節(jié)。

根據(jù)評分者在五個維度上的打分,摘要被分類為好、中、差。

實驗結(jié)果表明,與同類模型相比,帶有適配器的模型可以生成更好的摘要。

并且在超過99%的針對性對抗性示例中,摘要適配器并沒有放大敏感內(nèi)容。

基礎(chǔ)功能

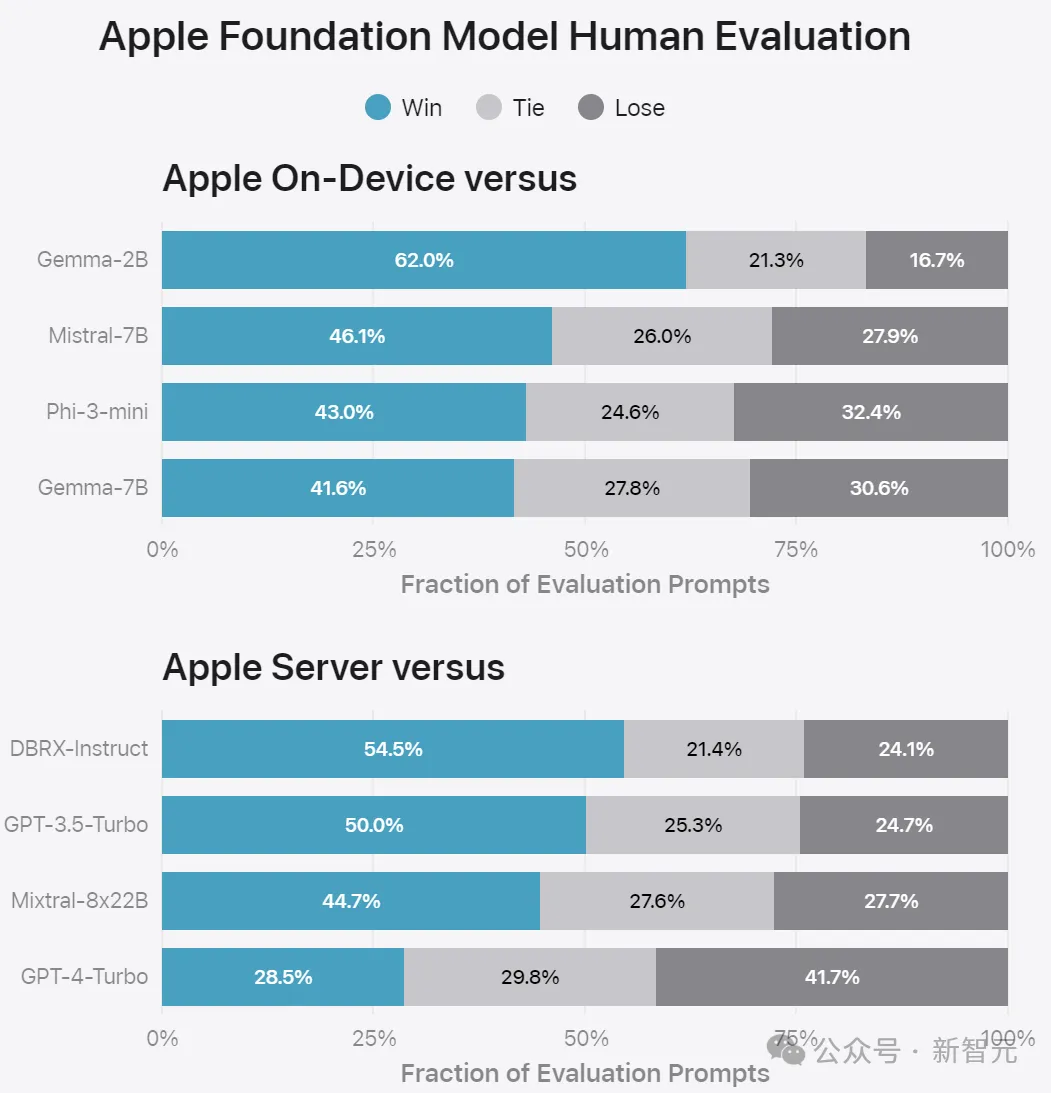

對于設(shè)備端和服務(wù)器模型的一般功能,蘋果利用一套全面的真實世界提示來評估通用模型的功能。

這些提示在不同的難度級別上各不相同,涵蓋頭腦風(fēng)暴、分類、封閉式問答、編碼、提取、數(shù)學(xué)推理、開放式問答、重寫、安全、總結(jié)和寫作等主要類別。

將蘋果的模型與開源模型(Phi-3、Gemma、Mistral、DBRX)和類似規(guī)模的商業(yè)模型(GPT-3.5-Turbo、GPT-4-Turbo)進(jìn)行比較。

實驗表明,與大多數(shù)競品相比,蘋果的模型更受人工評分師的青睞。

蘋果的3B設(shè)備端模型性能優(yōu)于Phi-3-mini、Mistral-7B和Gemma-7B等大型模型;而蘋果的服務(wù)器模型也要優(yōu)于DBRX-Instruct、Mixtral-8x22B和GPT-3.5-Turbo,同時效率更高。

安全性

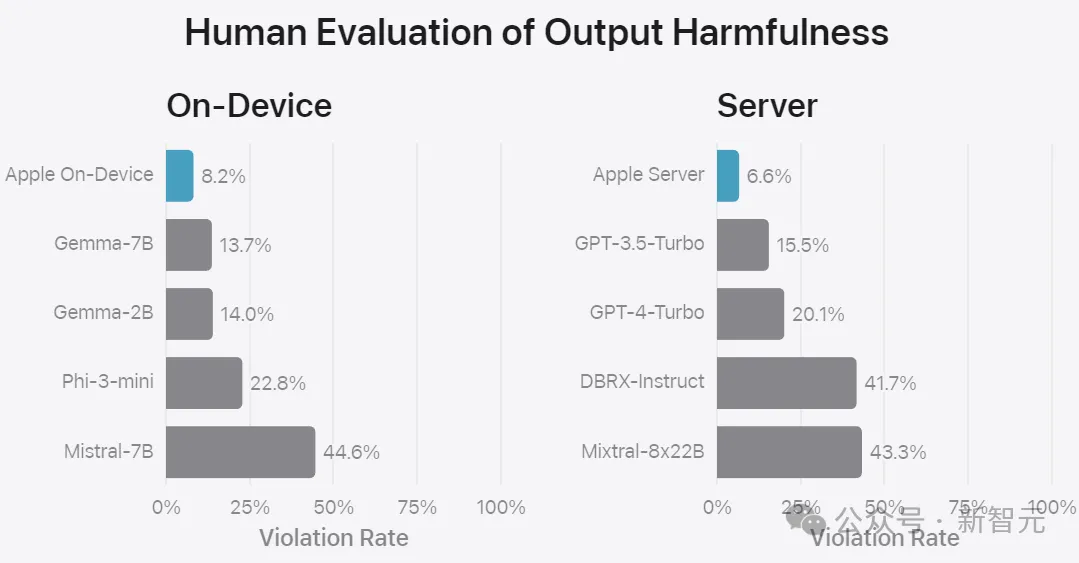

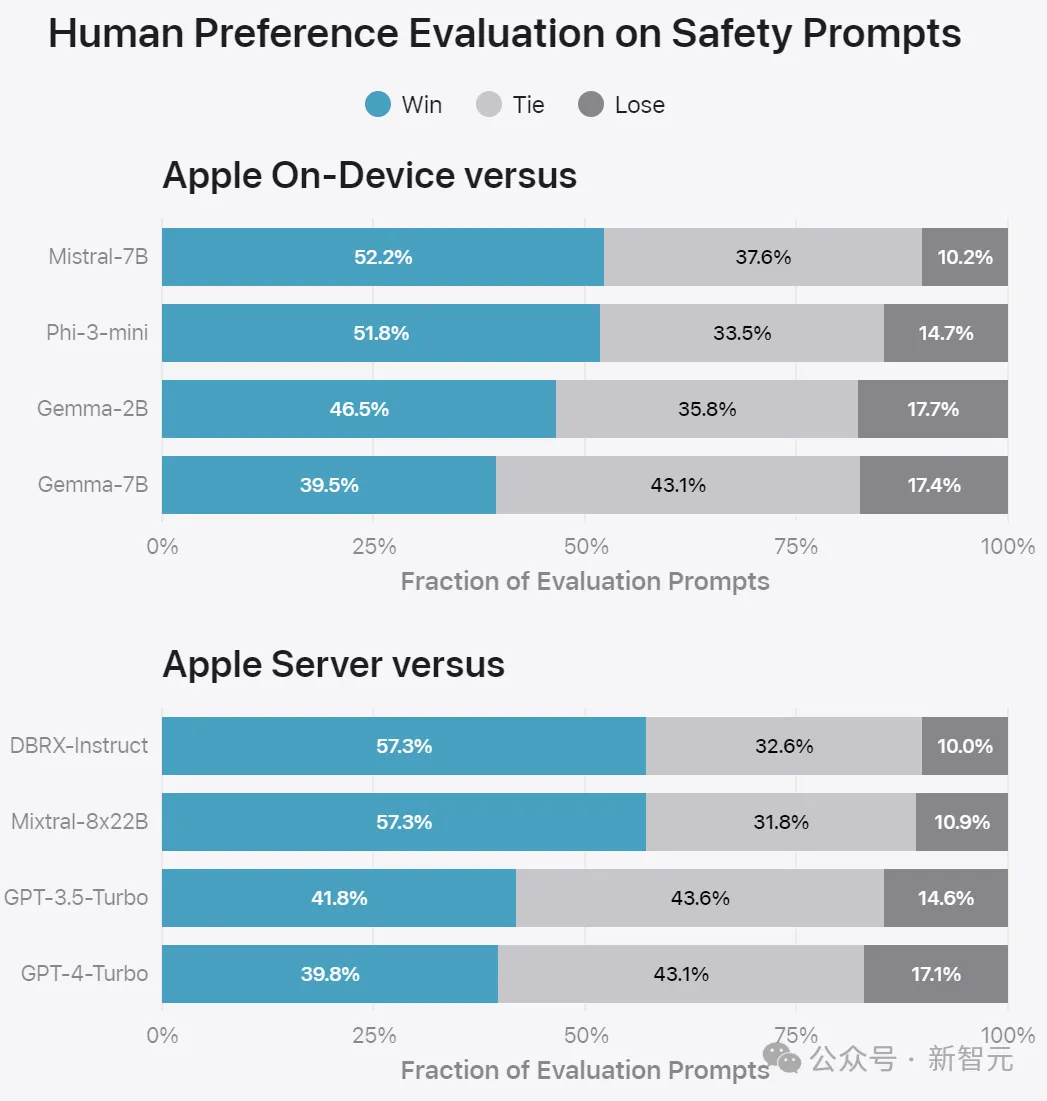

蘋果使用一組不同的對抗性提示來測試模型在有害內(nèi)容、敏感主題和事實性方面的表現(xiàn)。

測量每個模型的違規(guī)率,同樣采用人工評估:

上圖顯示了在安全提示方面與競品的PK。人工評分員發(fā)現(xiàn)蘋果的回答更安全、更有幫助。

指令遵循

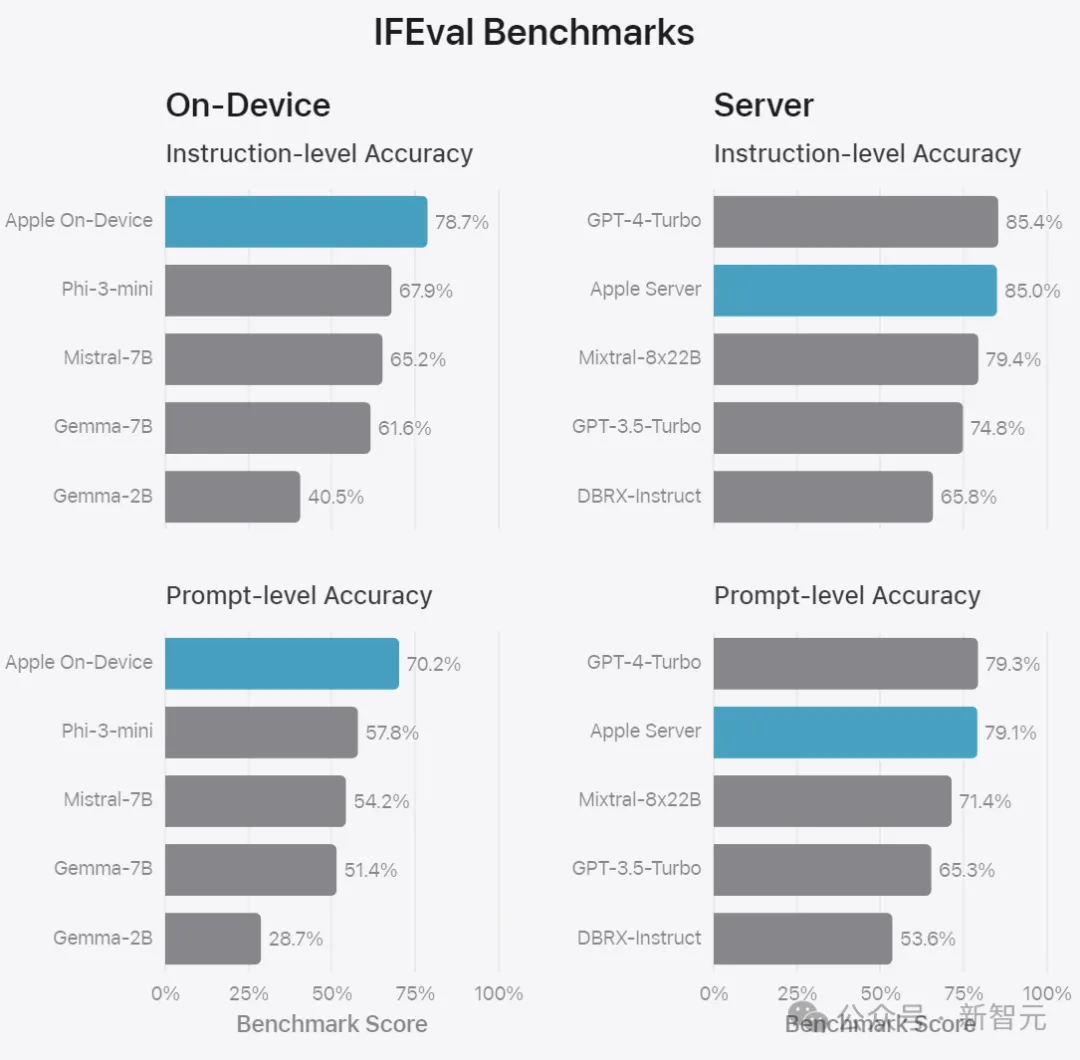

為了進(jìn)一步評估模型,蘋果還使用指令跟蹤評估(IFEval)基準(zhǔn)測試來比較同類模型的能力。

結(jié)果表明,蘋果的設(shè)備端和服務(wù)器模型都比同等規(guī)模的開源和商業(yè)模型更好地遵循詳細(xì)說明。

最后是根據(jù)內(nèi)部總結(jié)和作文基準(zhǔn)評估模型的寫作能力,包括各種寫作說明,這些結(jié)果不涉及用于特定功能的適配器。