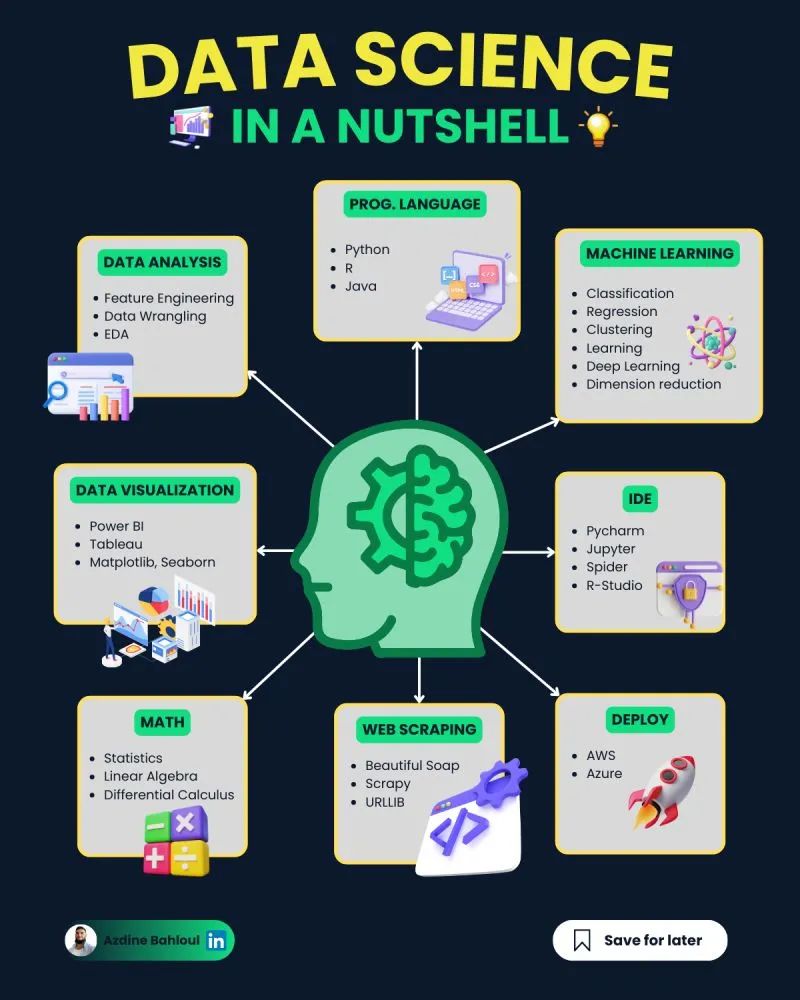

這里是老碼農眼中的數據科學的基本知識概覽,并非將讀者塑造成專業的數據工程師。相反,目標是為那些對數據產品感興趣,但又不需要深入其復雜細節的人士,提供一個基礎性的理解框架。

圖片

圖片

(本文參考了這一框架)

1. 數學技能

1.1 線性代數

數據集被表示為矩陣,因此,線性代數是機器學習中最重要的數學技能,用于數據預處理、數據轉換和模型評估,至少包括:

- 向量

- 矩陣

- 矩陣轉置

- 矩陣的逆

- 矩陣的行列式

- 點積

- 特征值

- 特征向量

1.2 微積分

大多數機器學習模型都是使用具有幾個特征或預測因子的數據集來構建的。因此,熟悉多元微積分對于建立機器學習模型非常重要,至少包括:

- 多元函數

- 導數和梯度

- 步長函數,Sigmoid 函數,Logit 函數,ReLU 函數

- 函數的繪制

- 函數的最小值和最大值

1.3 優化方法

大多數機器學習算法通過最小化目標函數來執行預測建模,從而必須應用于測試數據以獲得預測標簽的權重,至少包括:

- 成本函數/目標函數

- 似然函數

- 誤差函數

- 梯度下降法算法及其變體(例如隨機梯度下降算法)

圖片

圖片

2. 編程技能

首先,要會一些SQL,具體可以參見《全棧必備之SQL簡明手冊》。

另外,尤其是面向數據的產品經理應該掌握Python 的基礎編程。

- 基本的Python 語法 和編程方法

- 能夠使用Jupyter notebook

- 能夠使用 Python 庫,如 NumPy、 pylab、 seborn、 matplotlib、scikit-learn、 TensorFlow、 PyTorch

不必成為程序員, 但應該有一些編程的技能, 我對自己家的少年也是這樣希望的。

3. 數據基礎

在處理數據時,熟悉各種文件格式如CSV、PDF和文本文件的操作至關重要。使用諸如Pandas和NumPy等強大的Python庫可以有效地讀取、寫入和處理這些格式的數據。例如,Pandas提供了易于使用的函數來導入和導出CSV文件,而PDF文件的處理則可能需要專門的工具,如PyPDF2或pdfminer,來提取文本或表格數據。

數據清理是數據分析的關鍵環節之一,涉及移除重復值、處理缺失數據和糾正錯誤的數據。估算數據可能包括使用統計方法填充缺失值,或者基于現有數據估算概率。泛化數據則是將具體的數據點歸納為更廣泛的類別,如將年齡分組。Pandas庫在這些方面提供了豐富的功能,使得數據預處理變得更加高效和可靠。

數據的導入和導出也是數據科學中不可忽視的技能。無論是從數據庫中獲取數據,還是將處理后的數據存入SQLite或MySQL數據庫,熟練地操作數據存儲對于數據分析師來說都是必須的。此外,掌握如何將數據從一種格式轉換到另一種格式,或是如何簡化數據結構以便于分析,都是此環節的一部分。

此外,學習數據轉換和降維技術也非常重要。協方差矩陣幫助我們理解不同變量間的相互關系。主成分分析(PCA)和線性判別分析(LDA)則是兩種廣泛用于降維的技術,它們能夠幫助我們從高維數據集中提取最重要的特征,從而簡化模型并減少計算負擔。這些技術通過數學轉換來識別數據中的趨勢和模式,是構建有效機器學習模型的重要步驟。

4. 統計基礎

統計和概率在數據分析與機器學習中的使用是多方面的,它們對于特征的可視化、數據預處理、特征轉換、數據插補、降維、特征工程以及模型評估等關鍵步驟至關重要。通過利用統計方法,我們能夠更加深入地理解數據的分布特性,從而進行有效的數據預處理和特征轉換。例如,通過標準化或歸一化處理,可以確保不同規模和分布的數據能夠被模型有效處理。此外,概率論的應用使得我們能夠通過隨機模擬和假設檢驗來推斷數據的特性,為數據增強提供了理論基礎,尤其是在處理缺失數據的時候。

統計學博大精深,但似乎至少要掌握:

- 均值

- 標準差/方差

- 中位數

- 相關系數和協方差矩陣

- 概率分布:平均、二項式,泊松,指數、正態

- 貝葉斯定理

- 指標:精度,召回,正預測值,負預測值,混淆矩陣,ROC 曲線

- A/B 測試

5. 數據可視化基礎

一個好的數據可視化一般由5個組件構成的,這些組件必須拼湊在一起才能生產出最終的數據產品:

1)數據組件: 決定如何可視化數據的重要的第一步是知道它是什么類型的數據,例如,分類數據,離散數據,連續數據,時間序列數據等。

2)幾何成分: 決定什么樣的可視化適合你的數據,例如,散點圖,線圖,條形圖,直方圖,Q-Q 圖,平滑密度,箱形圖,對圖,熱圖等。

3)映射組件: 決定使用哪個變量作為 x 變量,以及使用哪個變量作為 y 變量。數據集是一個具有多個特征的多維數據集的時候,這一點很重要。

4)縮放成分: 決定使用什么樣的縮放方式,例如,線性縮放,對數縮放等。

5)標簽組件: 包括軸標簽、標題、圖例、要使用的字體大小等。

重要的數據可視化工具包括 Python 的 matplotlib 包等。

6. 線性回歸

學習簡單和多重線性回歸分析的基本原理,用來觀測監督式學習的連續性結果。線性回歸,作為一種基礎且強大的預測方法,通過建立自變量(解釋變量)與因變量(響應變量)之間的線性關系來預測數值型數據。簡單線性回歸涉及一個自變量和一個因變量,而多重線性回歸則包含多個自變量,能夠提供更為復雜的預測模型。常見工具如下:

- NumPy

- scipy

- sklearn

使用這些工具進行數據處理和模型構建,可以提升處理實際問題的能力。通過不斷實驗和調整模型,學可以逐漸培養出直覺和技能,以識別和使用最適合特定數據集的回歸方法。

7. 機器學習基礎

在監督式學習中,連續變量預測主要是如上所述的回歸分析,對于離散變量的預測而言,需要掌握:

- 邏輯回歸

- 支持向量機(SVM)分類器

- KNN分類

- 決策樹

- 隨機森林

- 樸素貝葉斯

對于非監督式學習而言,主要是Kmeans 聚類。用于機器學習的 Python 工具主要有sklearn、 Pytorch、 TensorFlow。

其中,sklearn是一個功能強大的機器學習庫,它提供了眾多簡化數據處理和模型訓練的模塊。例如,對于Kmeans聚類而言,sklearn中不僅包含了該算法的高效實現,同時還提供了豐富的數據預處理工具,使得從數據清洗到模型訓練的過程變得簡單快捷。

Pytorch和TensorFlow則是兩個更為廣泛的機器學習框架,它們支持完整的深度學習算法開發。Pytorch以其獨特的動態計算圖特性,能夠直觀地構建復雜的神經網絡模型,并且有著良好的社區支持和豐富的資源。另一方面,TensorFlow則以其穩定性和大規模生產能力著稱,尤其適合部署復雜的機器學習模型到生產環境。

在選擇這三個工具時,用戶應考慮自己的需求、已有的編程知識以及希望投入的時間。對于快速實驗和教育目的,sklearn通常是足夠的。而對于需要深入探索深度學習模型的研究或項目,Pytorch和TensorFlow則更加適合。

8. 時間序列分析基礎

時間序列分析基礎包括對時間序列數據的基本認識、核心概念的理解,以及分析方法的掌握。時間序列分析是一種統計方法,用于分析和預測按時間順序排列的數據點。

時間序列是一組按時間順序排列的觀測值,例如環境科學中某個地區的氣溫變化數據。時間序列分析的重要性在于它能夠揭示數據中的趨勢、季節性、周期性和隨機性等特征,從而為理解現象背后的內在機制提供線索,并對未來進行預測。

在結果依賴于時間的情況下使用預測模型,有三種基本方法:

- 指數平滑模型

- ARIMA是指數平滑的一種推廣

- GARCH,一種類似 ARIMA 的方差分析模型。

這3種技術都可以在 Python中實現。

9. 生產力工具基礎

了解如何使用基本的生產力工具是必不可少的。

對于 Python 來說,Anaconda是最佳生產力工具。AWS 和 Azure 等高級生產力工具也是值得學習的重要工具。

除了熟練運用這些工具外,理解它們如何在大數據處理、機器學習、以及云服務管理中發揮作用,也是提升工作效率的關鍵。Anaconda不僅提供了Python和R語言的數據處理能力,更通過其集成的環境管理功能,使得庫和框架的安裝、管理變得輕松便捷。AWS和Azure等平臺則擴展了這一能力,至云端計算與存儲,讓數據科學家能夠在全球范圍內協作和部署模型。掌握如AWS的EC2、S3服務,以及Azure的虛擬機和存儲賬戶等資源,將使數據工程師能夠在需求變化時迅速調整資源,優化成本和性能。此外,了解如何利用這些云平臺提供的機器學習服務,例如AWS Sagemaker或Azure Machine Learning,可以大大縮短從模型開發到部署的周期。總之,這些高級生產力工具會在數據工程領域為你帶來優勢。

圖片

圖片

10. 項目管理

在構建任何數據項目或者機器學習模型之前,仔細地坐下來并計劃需要完成的目標任務是非常重要的。了解要解決的問題、數據集的性質、要構建的模型類型、模型將如何訓練、測試和評估。

項目規劃不僅涉及明確目標和確定時間表,還要包括資源分配、風險評估以及預算管理。在數據科學項目中,這意味著要考慮到數據的獲取和清洗可能需要的時間,模型的選擇和調整所需的實驗次數,以及最終模型部署和維護的長期成本。

識別關鍵路徑則更加具體地關注那些對整個項目進度最為關鍵的環節,如數據收集的延遲、模型訓練的效率,或是模型評估的準確性。對這些關鍵環節進行跟蹤,意味著項目管理需要具備靈活性,以適應數據科學項目特有的迭代性和不確定性。例如,當一個機器學習模型在測試階段表現不佳時,可能需要重新回到數據準備階段,或者重新選擇模型。這種靈活的項目管理模式,結合了傳統的項目管理原則和數據項目特有的實踐,是確保成功的關鍵。