ACL 2024論文蓋棺定論:大語言模型≠世界模擬器,Yann LeCun:太對(duì)了

最近兩天,一篇入選 ACL 2024 的論文《Can Language Models Serve as Text-Based World Simulators?》在社交媒體 X 上引發(fā)了熱議,就連圖靈獎(jiǎng)得主 Yann LeCun 也參與了進(jìn)來。

這篇論文探討的問題是:當(dāng)前語言模型本身是否可以充當(dāng)世界模擬器,并正確預(yù)測(cè)動(dòng)作如何改變不同的世界狀態(tài),從而避免大量手動(dòng)編碼的需要呢?

針對(duì)這一問題,來自亞利桑那大學(xué)、紐約大學(xué)、約翰斯?霍普金斯大學(xué)、微軟研究院、 艾倫人工智能研究所等機(jī)構(gòu)的研究者在「基于文本的模擬器」上下文中給出了他們的答案。

他們認(rèn)為:語言模型并不能作為世界模擬器使用。比如,GPT-4 在模擬基于常識(shí)任務(wù)(如燒開水)的狀態(tài)變化時(shí),準(zhǔn)確率僅為約 60%。

x 地址:https://x.com/peterjansen_ai/status/1801687501557665841

x 地址:https://x.com/peterjansen_ai/status/1801687501557665841

Yann LeCun 對(duì)這篇論文的發(fā)現(xiàn)表示了認(rèn)同,并認(rèn)為「沒有世界模型,也就沒有規(guī)劃。」

X 地址:https://x.com/ylecun/status/1801978192950927511

X 地址:https://x.com/ylecun/status/1801978192950927511

不過也有人表達(dá)了不同的觀點(diǎn):當(dāng)前 LLM(沒有進(jìn)行針對(duì)性任務(wù)訓(xùn)練)的準(zhǔn)確率可以達(dá)到 60%,這不就說明了它們至少是「一定程度上的世界模型」嗎?并且會(huì)隨著 LLM 的迭代而持續(xù)改進(jìn)。LeCun 又表示,世界模型不會(huì)是 LLM。

回到論文中,研究者構(gòu)建并使用了一個(gè)全新的基準(zhǔn),他們稱為「ByteSized32-State-Prediction」,包含了一個(gè)文本游戲狀態(tài)轉(zhuǎn)換和隨附游戲任務(wù)組成的數(shù)據(jù)集。他們首次使用該基準(zhǔn)來直接量化大語言模型(LLM)作為基于文本的世界模擬器的性能。

通過在這個(gè)數(shù)據(jù)集上測(cè)試 GPT-4,研究者發(fā)現(xiàn):盡管它的性能令人印象深刻,但如果沒有進(jìn)一步的創(chuàng)新,它仍然是一個(gè)不可靠的世界模擬器。

因此,研究者認(rèn)為,他們的工作既為當(dāng)前 LLM 的能力和弱點(diǎn)提供了新的見解,也為跟蹤新模型出現(xiàn)時(shí)的未來進(jìn)展提供了一個(gè)新的基準(zhǔn)。

論文地址:https://arxiv.org/pdf/2406.06485

方法概覽

研究者探究了 LLM 在基于文本的虛擬環(huán)境中充當(dāng)世界模擬器的能力,在這種環(huán)境中,智能體接收觀察結(jié)果并以自然語言提出操作以完成某些目標(biāo)。

每個(gè)文本環(huán)境都可以正式表示為具有 7 元組 (S,A,T,O,R,C,D) 的目標(biāo)條件部分可觀察馬爾可夫決策過程 (POMDP),S 表示狀態(tài)空間,A 表示動(dòng)作空間,T : S×A→S 表示轉(zhuǎn)換函數(shù),O 表示觀察函數(shù),R : S×A→R 表示獎(jiǎng)勵(lì)函數(shù),C 表示描述目標(biāo)和動(dòng)作語義的自然語言「上下文消息」,D : S×A→{0,1} 表示二元完成指示函數(shù)。

大模型模擬器(LLM-Sim)任務(wù)

研究者提出了一個(gè)預(yù)測(cè)任務(wù),稱它為 LLM as-a-Simulator (LLM-Sim),用來定量評(píng)估語言模型作為可靠模擬器的能力。

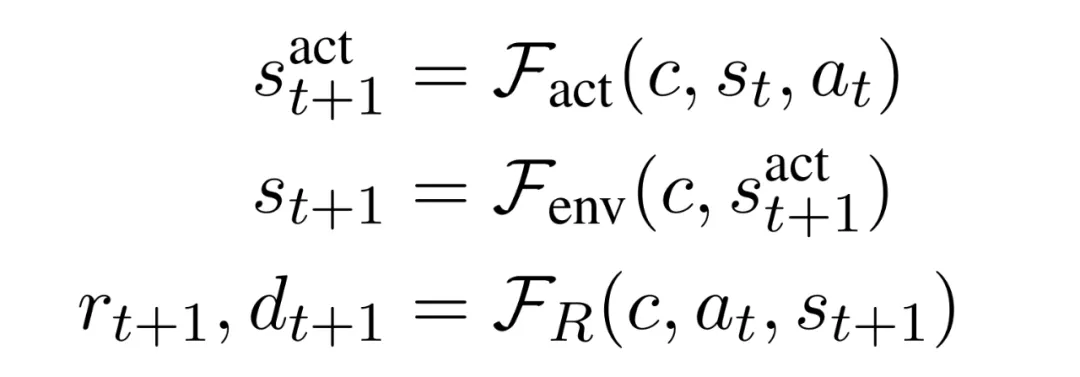

LLM-Sim 任務(wù)是將一個(gè)函數(shù) F : C×S×A→S×R×{0,1} 作為世界模擬器來實(shí)現(xiàn)。在實(shí)踐中,完整狀態(tài)轉(zhuǎn)換模擬器 F 應(yīng)該考慮兩種類型的狀態(tài)轉(zhuǎn)換:動(dòng)作驅(qū)動(dòng)轉(zhuǎn)換和環(huán)境驅(qū)動(dòng)轉(zhuǎn)換。

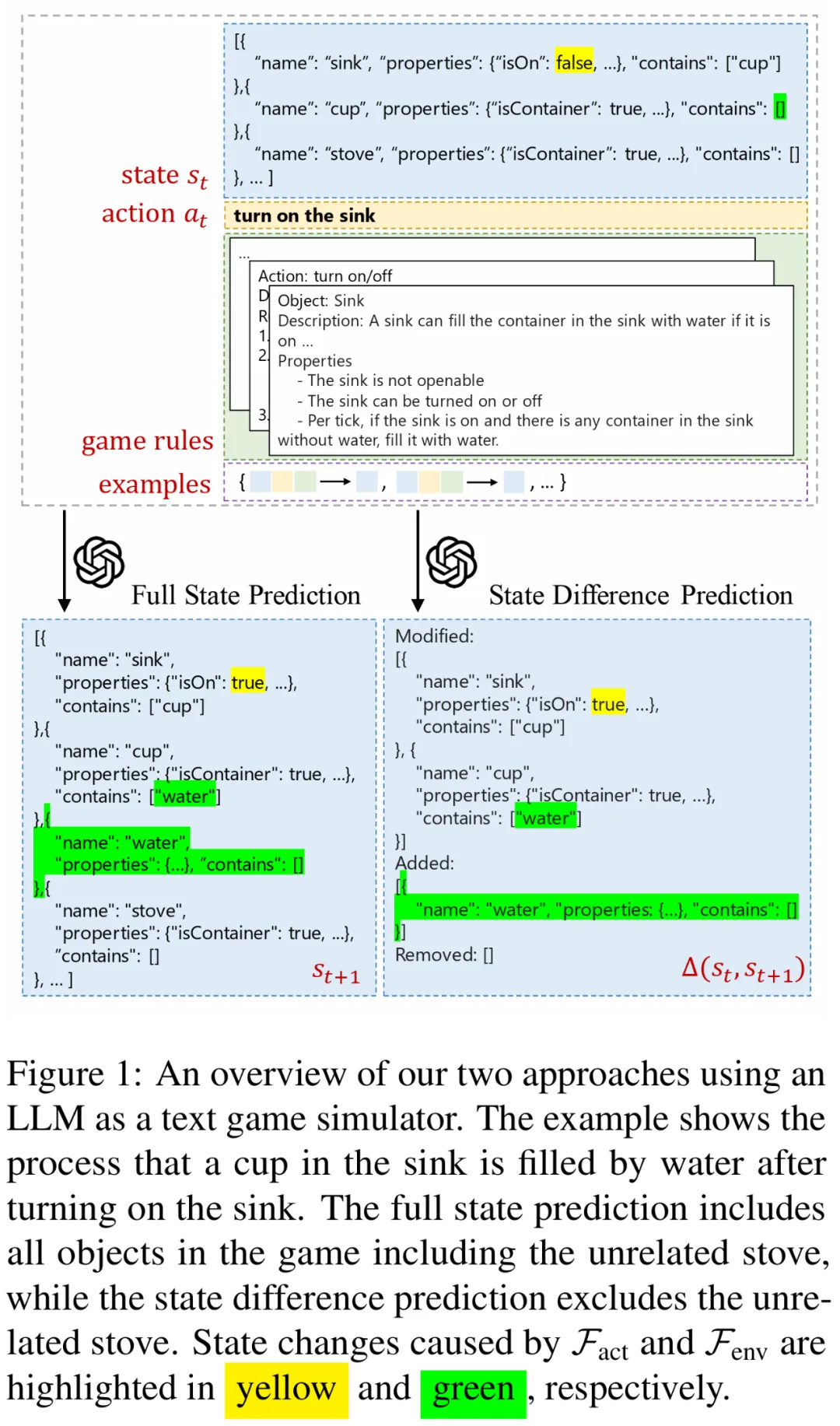

圖 1 為使用 LLM 作為文本游戲模擬器的示例:打開水槽后,水槽中的杯子被水填滿的過程。動(dòng)作驅(qū)動(dòng)轉(zhuǎn)換是采取打開水槽的動(dòng)作后,水槽被打開(isOn=true);而環(huán)境驅(qū)動(dòng)轉(zhuǎn)換是在水槽打開時(shí),水填滿水槽中的杯子。

為了更好地理解 LLM 對(duì)每個(gè)轉(zhuǎn)換進(jìn)行建模的能力,研究者進(jìn)一步將模擬器函數(shù) F 分解為三個(gè)步驟:

- 動(dòng)作驅(qū)動(dòng)轉(zhuǎn)換模擬器:給定 c、s_t 和 a_t, F_act:C×S×A→S 預(yù)測(cè) s^act_t+1,其中 s^act_t+1 表示動(dòng)作引起的直接狀態(tài)變化。

- 環(huán)境驅(qū)動(dòng)轉(zhuǎn)換模擬器:給定 c 和 s^act_t+1,F(xiàn)_env:C×S→S 預(yù)測(cè) s_t+1,其中 s_t+1 是任何環(huán)境驅(qū)動(dòng)轉(zhuǎn)換后產(chǎn)生的狀態(tài)。

- 游戲進(jìn)度模擬器:給定 c、s_t+1 和 a_t, F_R:C×S×A→R×{0,1} 預(yù)測(cè)獎(jiǎng)勵(lì) r_t+1 和游戲完成狀態(tài) d_t+1。

此外,研究者考慮了 LLM-Sim 任務(wù)的兩種變體

- 完整狀態(tài)預(yù)測(cè):LLM 輸出完整狀態(tài)。

- 狀態(tài)差異預(yù)測(cè):LLM 僅輸出輸入和輸出狀態(tài)之間的差異。

數(shù)據(jù)和評(píng)估

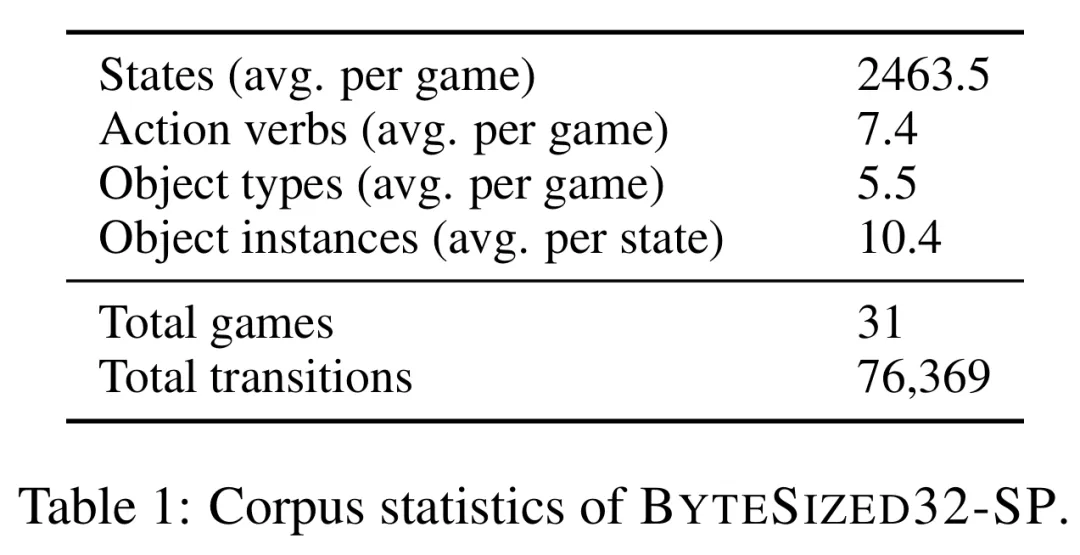

為了完成這一任務(wù),研究者引入了一個(gè)新的文本游戲狀態(tài)轉(zhuǎn)換數(shù)據(jù)集。該數(shù)據(jù)集為 「BYTESIZED32-State-Prediction (BYTESIZED32-SP) 」,它包含 76,369 個(gè)轉(zhuǎn)換,表示為 (c,s_t,rt,d_t,a_t,s^act_t+1,s_t+1,r_t+1,d_t+1) 元組。這些轉(zhuǎn)換是從 31 個(gè)不同的文本游戲中收集的。

下表 1 總結(jié)了額外語料庫(kù)統(tǒng)計(jì)數(shù)據(jù)。

LLM-Sim 上的性能由模型相對(duì)于測(cè)試樣本數(shù)據(jù)集上的真實(shí)標(biāo)簽的預(yù)測(cè)準(zhǔn)確性來決定。根據(jù)實(shí)驗(yàn)條件,LLM 必須模擬對(duì)象屬性(模擬 F_act、F_env 或 F)和 / 或游戲進(jìn)度(模擬 F_R 或 F),定義如下:

- 對(duì)象屬性:游戲中所有對(duì)象、每個(gè)對(duì)象的屬性(如溫度、大小),以及與其他對(duì)象的關(guān)系(如在另一個(gè)對(duì)象內(nèi)或之上)。

- 游戲進(jìn)度:智能體相對(duì)于總體目標(biāo)的狀態(tài),包括當(dāng)前累積的獎(jiǎng)勵(lì)、游戲是否已終止以及總體目標(biāo)是否已實(shí)現(xiàn)。

研究者注意到,在每種情況下,LLM 都提供了 ground truth 先前狀態(tài)(當(dāng)函數(shù)為 F_env 時(shí),先前狀態(tài)為 s^act_t+1 )以及整體任務(wù)上下文。也就是說,LLM 始終執(zhí)行單步預(yù)測(cè)。

實(shí)驗(yàn)結(jié)果

上圖 1 演示了研究者使用上下文學(xué)習(xí)評(píng)估 LLM-Sim 任務(wù)中模型的性能。他們?cè)u(píng)估了 GPT-4 在完整狀態(tài)和狀態(tài)差異預(yù)測(cè)機(jī)制中的準(zhǔn)確性。該模型接收先前狀態(tài)(編碼為 JSON 對(duì)象)、先前操作和上下文消息,并生成后續(xù)狀態(tài)(作為完整的 JSON 對(duì)象或差異)。

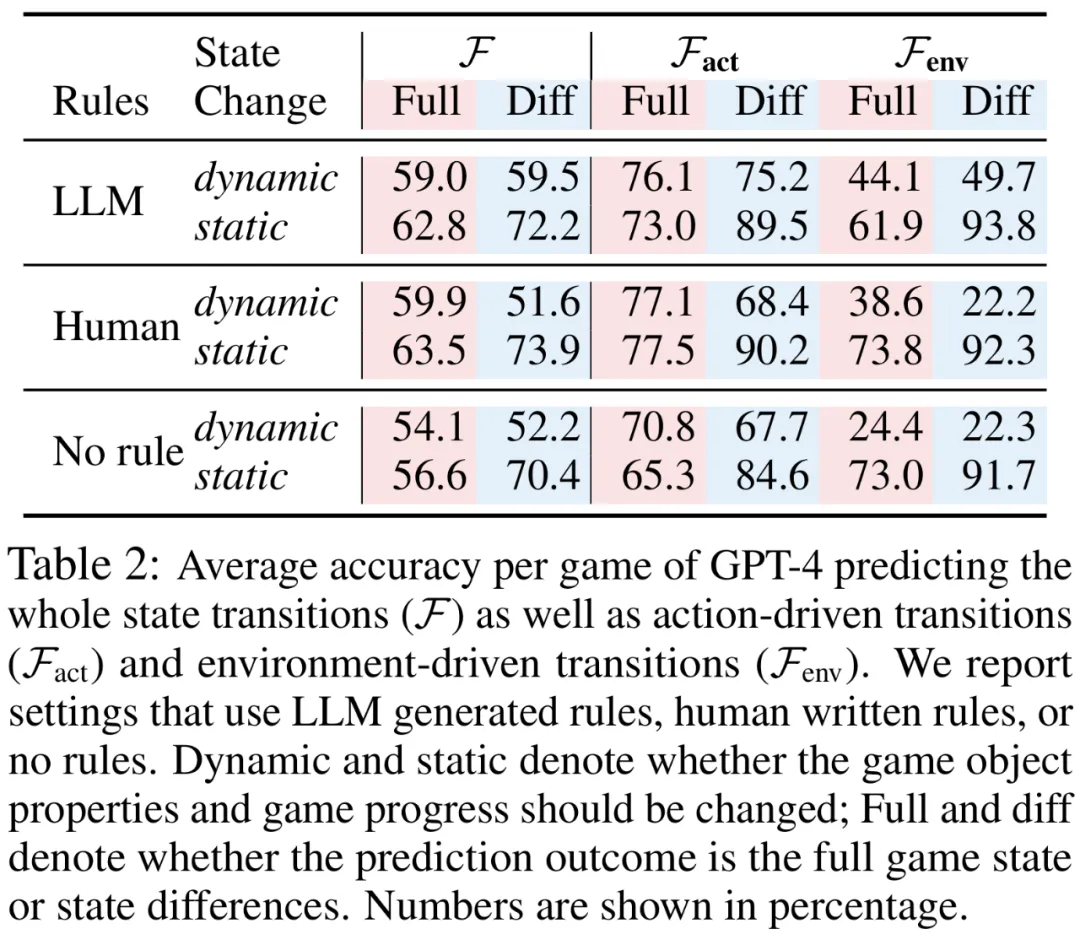

下表 2 展示了 GPT-4 模擬完整狀態(tài)轉(zhuǎn)換的準(zhǔn)確性,以及單獨(dú)模擬動(dòng)作驅(qū)動(dòng)轉(zhuǎn)換和環(huán)境驅(qū)動(dòng)轉(zhuǎn)換的準(zhǔn)確性。

研究者得出了以下幾項(xiàng)重要發(fā)現(xiàn):

預(yù)測(cè)動(dòng)作驅(qū)動(dòng)轉(zhuǎn)換比預(yù)測(cè)環(huán)境驅(qū)動(dòng)轉(zhuǎn)換更容易。在最好的情況下,GPT-4 能夠正確模擬 77.1% 的動(dòng)態(tài)動(dòng)作驅(qū)動(dòng)轉(zhuǎn)換。相比之下,GPT-4 最多只能正確模擬 49.7% 的動(dòng)態(tài)環(huán)境驅(qū)動(dòng)轉(zhuǎn)換。

預(yù)測(cè)靜態(tài)轉(zhuǎn)換比動(dòng)態(tài)轉(zhuǎn)換更容易。不出所料,在大多數(shù)情況下,對(duì)靜態(tài)轉(zhuǎn)換進(jìn)行建模比對(duì)動(dòng)態(tài)轉(zhuǎn)換進(jìn)行建模要容易得多。

對(duì)于動(dòng)態(tài)狀態(tài),預(yù)測(cè)完整游戲狀態(tài)更容易;而對(duì)于靜態(tài)狀態(tài),預(yù)測(cè)狀態(tài)差異更容易。預(yù)測(cè)動(dòng)態(tài)狀態(tài)的狀態(tài)差異可以顯著提高模擬靜態(tài)轉(zhuǎn)換的性能(>10%),而模擬動(dòng)態(tài)轉(zhuǎn)換時(shí)的性能會(huì)降低。

游戲規(guī)則很重要,LLM 能夠生成足夠好的游戲規(guī)則。當(dāng)上下文消息中未提供游戲規(guī)則時(shí),GPT-4 在所有三個(gè)模擬任務(wù)上的性能在大多數(shù)情況下都會(huì)下降。

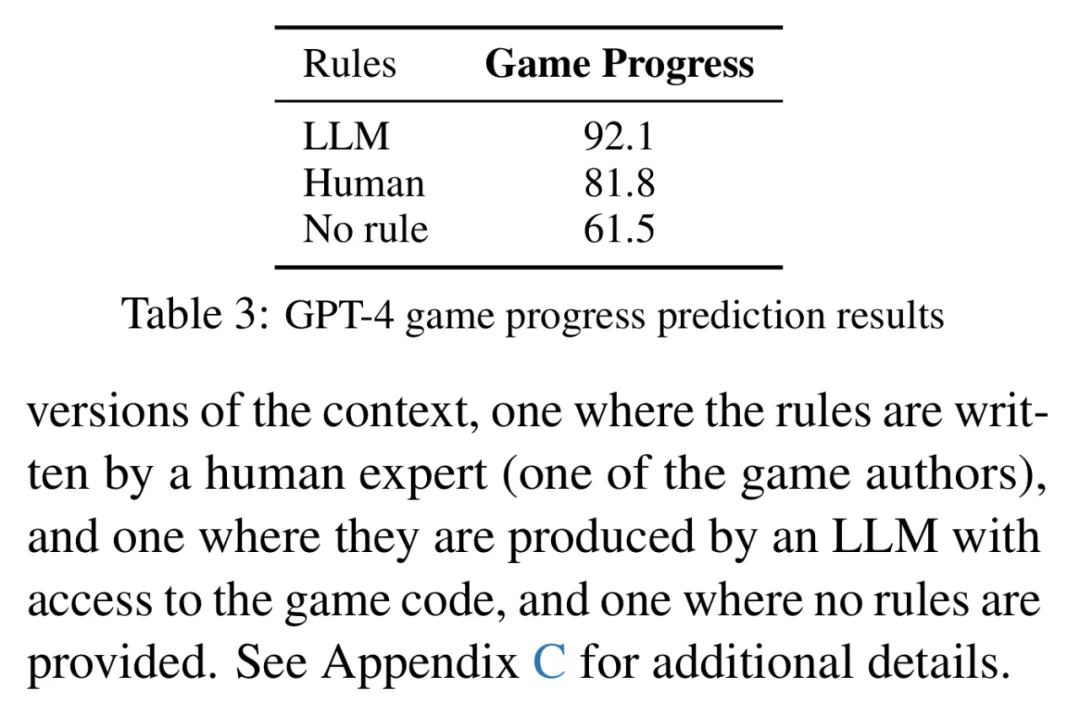

GPT-4 在大多數(shù)情況下都能預(yù)測(cè)游戲進(jìn)度。下表 3 展示了 GPT-4 預(yù)測(cè)游戲進(jìn)度的結(jié)果。在上下文中加入了游戲規(guī)則信息后,GPT-4 可以在 92.1% 的測(cè)試用例中正確預(yù)測(cè)游戲進(jìn)度。這些規(guī)則的存在在上下文中至關(guān)重要:如果沒有它們,GPT-4 的預(yù)測(cè)準(zhǔn)確率會(huì)下降到 61.5%。

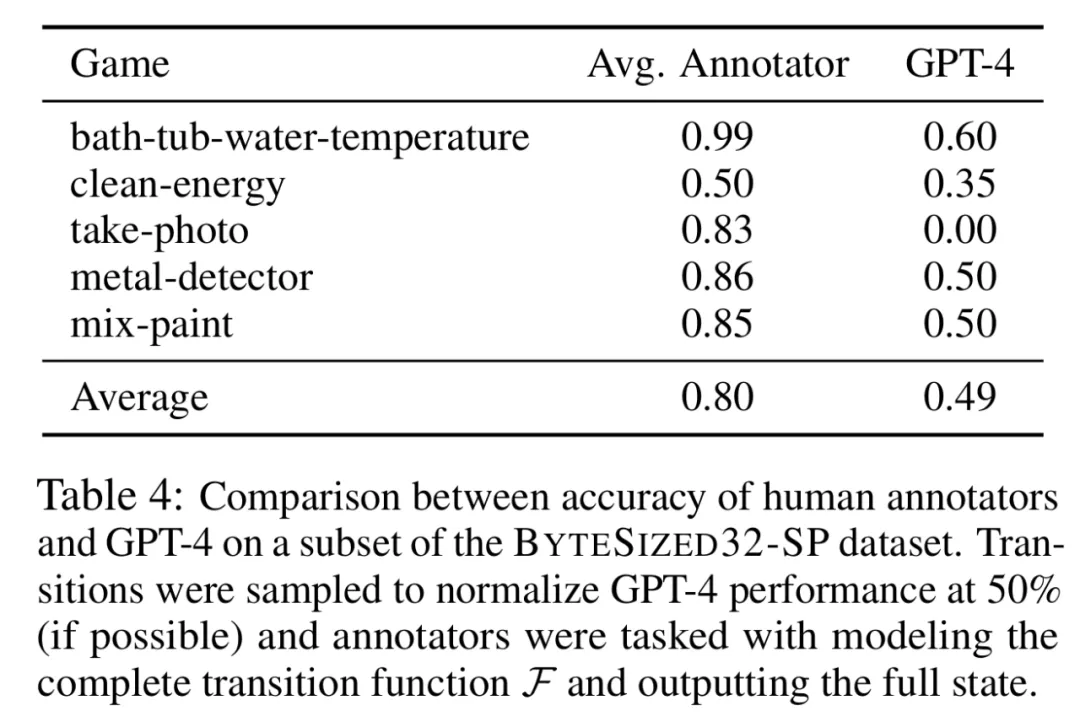

人類在 LLM-Sim 任務(wù)中的表現(xiàn)優(yōu)于 GPT-4。研究者對(duì) LLM-Sim 任務(wù)進(jìn)行了初步的人類研究。結(jié)果見下表 4。

結(jié)果發(fā)現(xiàn),人類的整體準(zhǔn)確率為 80%,而采樣的 LLM 的準(zhǔn)確率為 50%,并且不同注釋者之間的差異很小。這表明,雖然任務(wù)對(duì)于人類來說總體上是直觀且相對(duì)容易的,但對(duì)于 LLM 來說仍有很大的改進(jìn)空間。

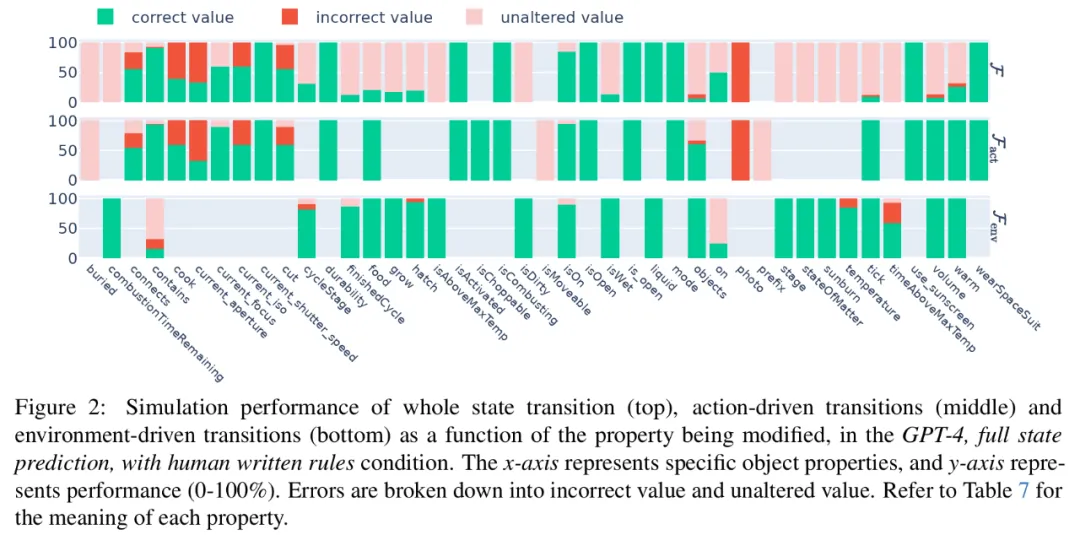

GPT-4 在需要算術(shù)、常識(shí)或科學(xué)知識(shí)時(shí)更容易出錯(cuò)。下圖 2 展示了在整體狀態(tài)轉(zhuǎn)換、動(dòng)作驅(qū)動(dòng)轉(zhuǎn)換和環(huán)境驅(qū)動(dòng)轉(zhuǎn)換中,預(yù)測(cè)結(jié)果的正確比例、將屬性設(shè)置為不正確值的比例或未能更改屬性值的比例。

我們可以觀察到,GPT-4 能夠很好地處理大多數(shù)簡(jiǎn)單的布爾值屬性。錯(cuò)誤集中出現(xiàn)在需要算術(shù)(如溫度、timeAboveMaxTemp)、常識(shí)(如 current_aperture、current_focus)或科學(xué)知識(shí)(如 on)的非平凡屬性上。

更多技術(shù)細(xì)節(jié)和實(shí)驗(yàn)結(jié)果請(qǐng)參閱原論文。