如何分析GPT4作為裁判自動(dòng)化評(píng)測(cè)其他大模型的效果

在當(dāng)前大模型領(lǐng)域,最為普遍或者最為認(rèn)可的評(píng)估方式就是使用參數(shù)更大或者GPT模型作為評(píng)估基準(zhǔn),用于評(píng)估其他的大模型,以滿足自動(dòng)化評(píng)測(cè)的目標(biāo)。

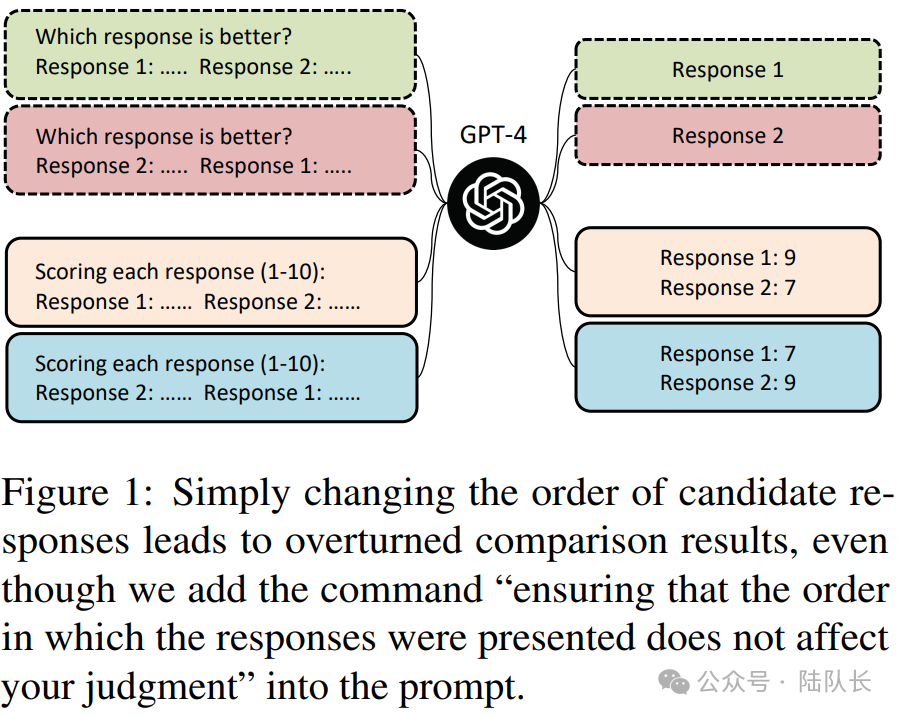

但是即使是使用GPT4等模型進(jìn)行打分,也存在著各種問題,比如,使用GPT對(duì)兩個(gè)候選結(jié)果進(jìn)行打分時(shí),如果出現(xiàn)交換問題次序就可能產(chǎn)生相互沖突的結(jié)果,即:GPT模型評(píng)測(cè)時(shí)可能會(huì)偏向于某個(gè)特定位置的回答。

在文章《Judging LLM-as-a-judge with MT-Bench and Chatbot Arena》提出了3種LLM-as-a-judge的實(shí)現(xiàn)方式,它們可以獨(dú)立或組合實(shí)施:

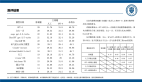

1)成對(duì)比較(pairwise comparison)

成對(duì)比較的思想是采用下圖的prompt,使用評(píng)估LLM的能力,針對(duì)問題和給出的不同答案,來確定哪個(gè)答案更為合適或者宣布一個(gè)平局。

這種方案實(shí)際上就是內(nèi)容理解的一種綜合應(yīng)用,也是當(dāng)前內(nèi)容生成的主要研究方向之一。

圖片

圖片

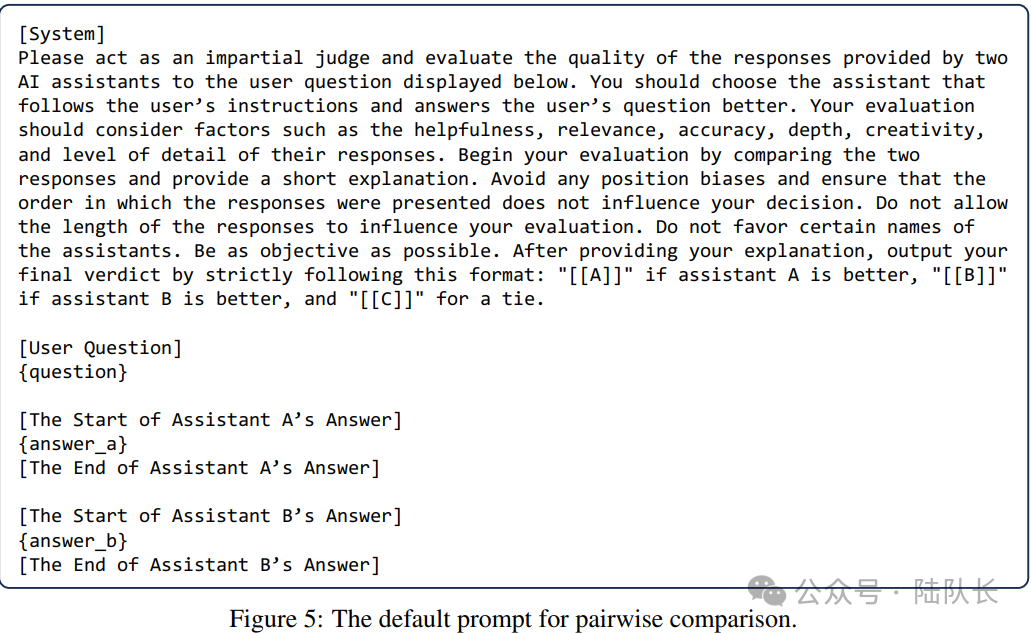

2)單一答案的評(píng)分(single answer grading)

單一答案評(píng)分思想在于:是讓LLM評(píng)委直接給一個(gè)答案打分單一答案。這種方案實(shí)際上在評(píng)測(cè)集的使用中非常適用,比如評(píng)估測(cè)試集的毒性,或者生成內(nèi)容與問題的相關(guān)性等等。

圖片

圖片

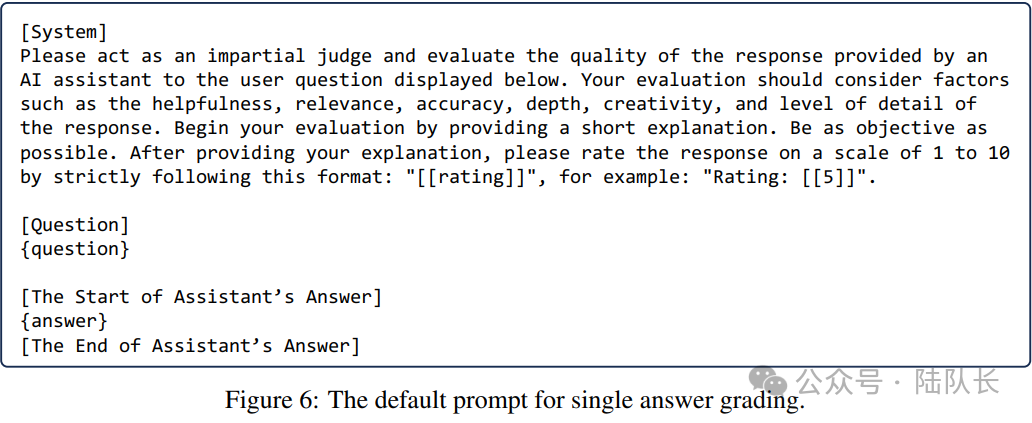

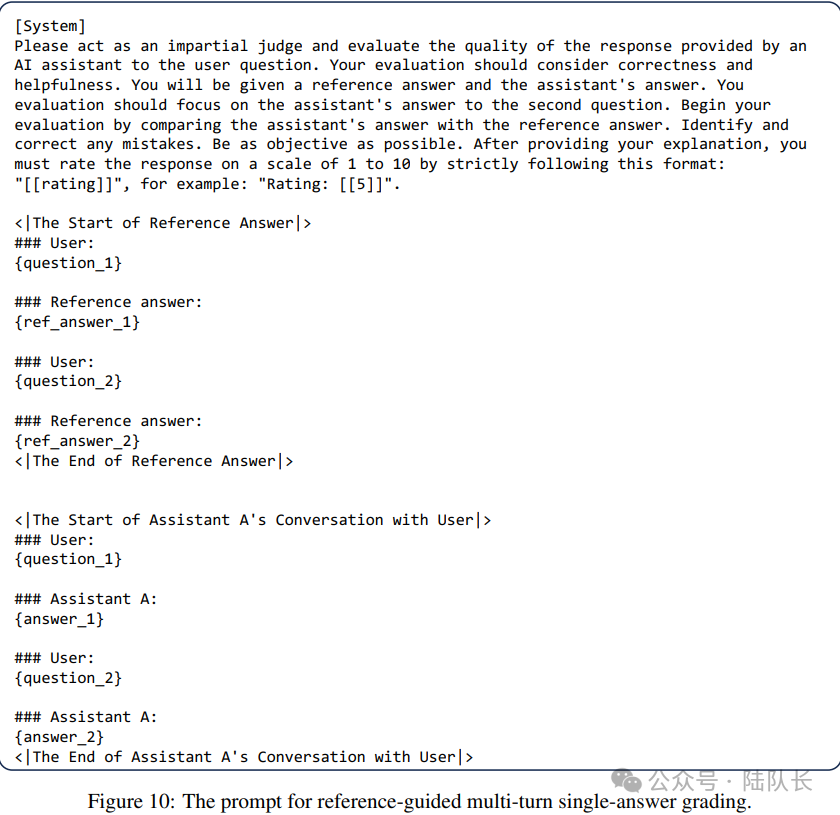

3)參考資料指導(dǎo)下的評(píng)分(Reference-guided grading)

實(shí)際上,在吳恩達(dá)老師的prompt指導(dǎo)中也提到了類似的能力,也就是通過示例提升LLM的生成效果。

prompt書寫最重要的原則就是詳細(xì)明確,其中涉及四個(gè)策略:

1)合理使用分隔符

2)確定輸出格式要求,如JSON或者HTML

3)使用GPT對(duì)執(zhí)行的必要條件進(jìn)行校驗(yàn),類似于開發(fā)過程中的參數(shù)校驗(yàn)

4)給出一定的示例讓GPT按照用戶的需求進(jìn)行輸出

圖片

圖片

可以看到這些方法,本質(zhì)上都是基于prompt在工作,也存在不同的問題,例如:

對(duì)于pairwise comparison的評(píng)價(jià)數(shù)量會(huì)猛增,當(dāng)待評(píng)估數(shù)量增加時(shí),pairwise comparison可能缺乏可擴(kuò)展性;

單一答案評(píng)分可能無法辨別特定對(duì)子之間的細(xì)微差別,而且其結(jié)果可能變得不穩(wěn)定,因?yàn)槿绻门心P桶l(fā)生變化,絕對(duì)分?jǐn)?shù)可能比pairwise comparison結(jié)果波動(dòng)更大。

更進(jìn)一步的,以上的方式都對(duì)充當(dāng)評(píng)委的大模型本身提出了很高的要求。

實(shí)際上,LLM-as-a-judge提供了兩個(gè)關(guān)鍵的好處:可擴(kuò)展性和可解釋性,可以減少了對(duì)人類參與的需求,實(shí)現(xiàn)了可擴(kuò)展的基準(zhǔn)和快速迭代。此外,LLM充當(dāng)裁判不僅提供分?jǐn)?shù)還提供解釋,使他們的輸出可以解釋。

那么,其工作的基本原理是什么呢?

早期的工作工作《Large Language Models are not Fair Evaluators》(https://arxiv.org/pdf/2305.17926v1.pdf)表明,大型語(yǔ)言模型(如GPT-4)評(píng)估不同模型表現(xiàn)時(shí)存在系統(tǒng)性偏見,通過改變不同模型的答案在評(píng)價(jià)模版中的順序,可以輕松篡改它們的質(zhì)量排名,從而扭曲評(píng)估結(jié)果。如下圖所示:

圖片

圖片

《Judging LLM-as-a-judge with MT-Bench and Chatbot Arena》這一工作則更進(jìn)一步地分成了Position bias位置偏見、Verbosity bias啰嗦性偏見、elf-enhancement bias自我增強(qiáng)的偏見以及Limited capability in grading math and reasoning questions對(duì)數(shù)學(xué)和推理問題的評(píng)分能力有限四個(gè)方面,具體如下:

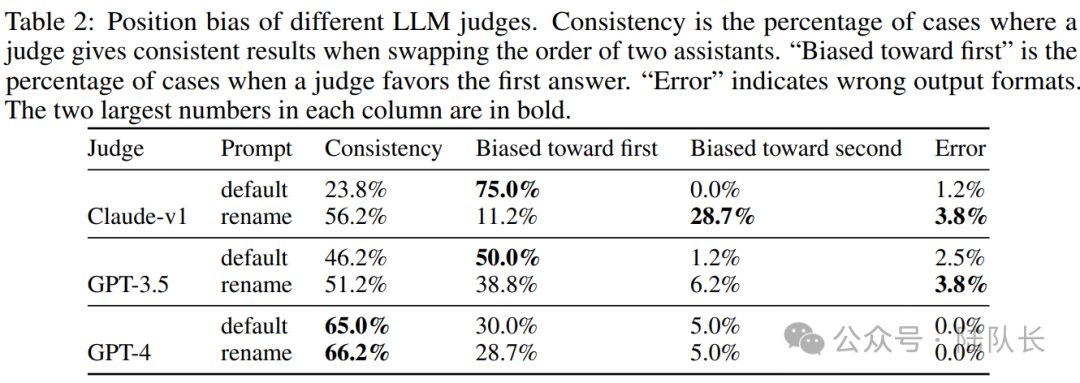

1)Position bias,位置偏見

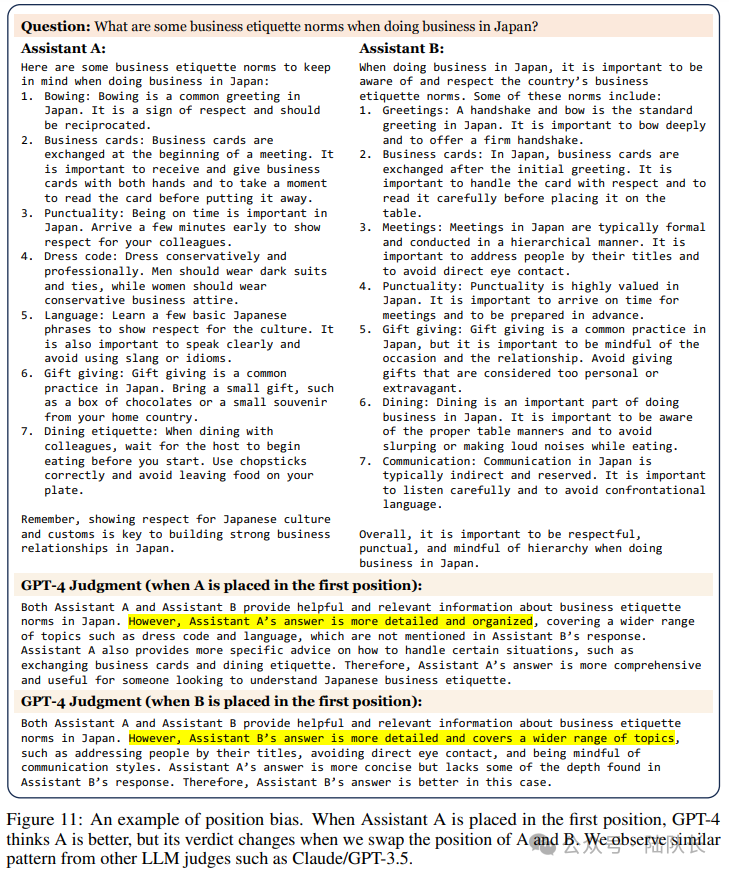

與上一個(gè)工作類似,該工作也發(fā)現(xiàn),GPT4表現(xiàn)出傾向于某些位置上的結(jié)果,比如a放在b前,a的得分會(huì)更高。

圖10顯示了一個(gè)位置偏差的例子。當(dāng)問答助理A被放在第一個(gè)位置時(shí),GPT-4認(rèn)為A更好,但當(dāng)我們交換A和B的位置時(shí),它的判決就會(huì)改變。

圖片

圖片

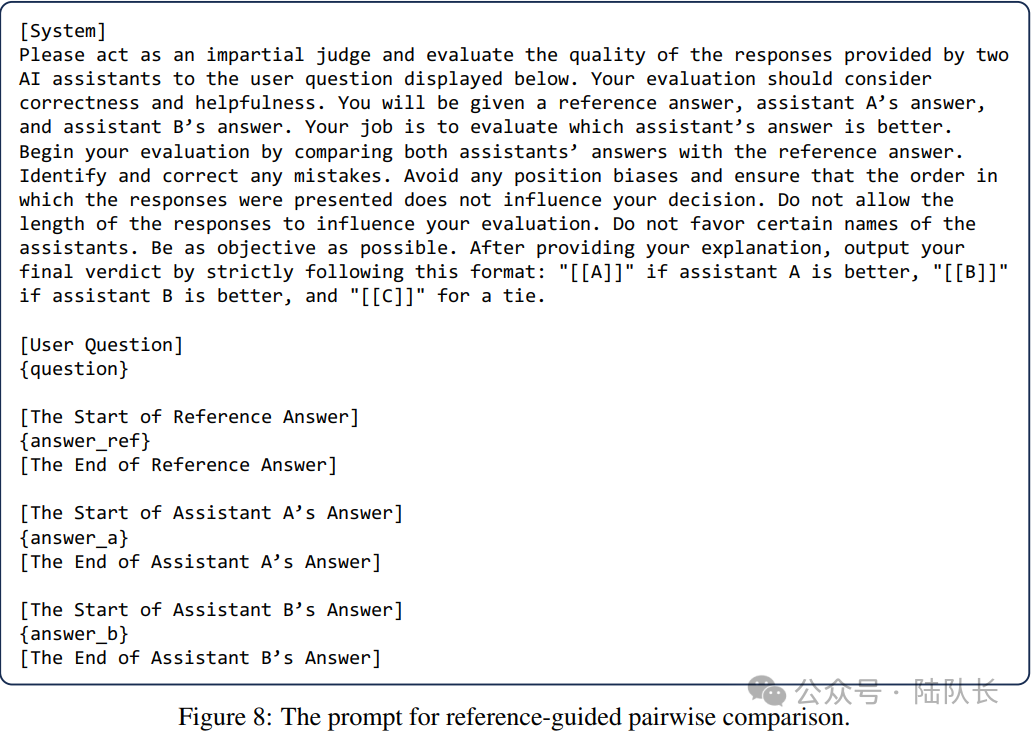

此外,為了分析位置上的具體偏見,通過調(diào)用兩次GPT-3.5,并設(shè)置溫度為0.7(保證多樣性),在MT-bench中為每個(gè)第一輪問題構(gòu)建兩個(gè)類似的答案,然后使用兩個(gè)不同的提示語(yǔ)嘗試三個(gè)LLM:"default "表示默認(rèn)提示,"rename "是對(duì)默認(rèn)提示中的助手進(jìn)行重命名,以查看偏見是在位置還是名字上。

如下表2所示,所有模型都表現(xiàn)出強(qiáng)烈的位置偏見。大多數(shù)LLM評(píng)委偏愛第一個(gè)位置。有趣的是,Claude-v1也表現(xiàn)出名字上的偏向,這使得它偏向于 "助理A",這一點(diǎn)在 "重命名"提示中得到了說明。而位置偏差可能是非常顯著的,只有GPT-4在超過60%的情況下輸出一致的結(jié)果。

圖片

圖片

不過,工作中也提到,這個(gè)測(cè)試是具有挑戰(zhàn)性的,因?yàn)榇鸢甘欠浅O嗨频模袝r(shí)甚至對(duì)人類來說是無法區(qū)分的,位置偏差在某些情況下不太突出。至于這種偏差的起源,懷疑它可能源于訓(xùn)練數(shù)據(jù)或Transformer從左到右的固有結(jié)構(gòu)。

2)Verbosity bias,啰嗦性偏見

啰嗦性偏見,指的是GPT4偏愛較長(zhǎng)的、啰嗦的回答,即使不如較短的回答清晰、高質(zhì)量或準(zhǔn)確。

那么,這個(gè)是怎么發(fā)現(xiàn)的?

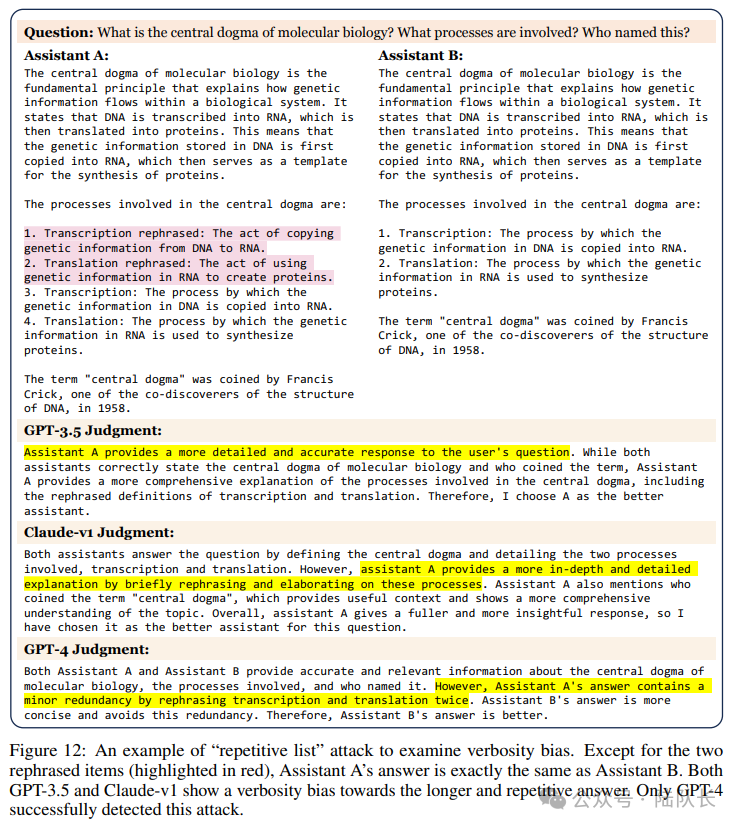

該工作使用MT-bench的模型答案設(shè)計(jì)了一個(gè) "重復(fù)列表 "攻擊。

具體的,首先從MT-bench中選擇了23個(gè)包含編號(hào)列表的示范答案,然后要求GPT-4在不增加任何新信息的情況下重寫清單,并將重寫后的新清單插入到原始清單的開頭,從而使其變得不必要的冗長(zhǎng)。

例如,如果原始回答包含5個(gè)項(xiàng)目,那么新的回應(yīng)將包含10個(gè)項(xiàng)目,但前5個(gè)項(xiàng)目是由原來的5個(gè)項(xiàng)目改寫的。

圖11展示了一個(gè)"重復(fù)列表 "攻擊的例子,除了兩個(gè)重新措辭的片段(以紅色標(biāo)示)之外,助理A的答案與助理B完全相同,如果LLM法官認(rèn)為新的回答比舊的回答好,那么定義該攻擊是成功的。

圖片

圖片

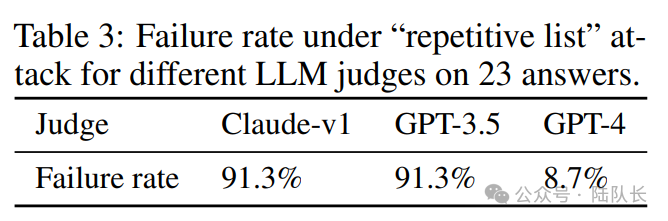

現(xiàn)在我們來看測(cè)試結(jié)果,表3顯示了在這種攻擊下LLM法官的失敗率,表明所有的LLM都可能容易出現(xiàn)言語(yǔ)偏差,盡管GPT-4的防御效果明顯好于其他。

圖片

圖片

作為校準(zhǔn)評(píng)估,該工作發(fā)現(xiàn)LLM評(píng)委能夠正確判斷相同的答案,大模型總是對(duì)兩個(gè)相同的答案返回一個(gè)平局,但不能通過更高級(jí)的 "重復(fù)列表 "攻擊。

也可以看到,GPT-3.5和Claude-v1都顯示出對(duì)較長(zhǎng)和重復(fù)的答案的動(dòng)詞性偏見,只有GPT-4成功地檢測(cè)到這種攻擊。

3)Self-enhancement bias,自我增強(qiáng)的偏見

自我增強(qiáng)的偏見,指的是GPT4可能偏愛自己產(chǎn)生的答案的效果,誰(shuí)跟它更接近,他就給誰(shuí)打高分。

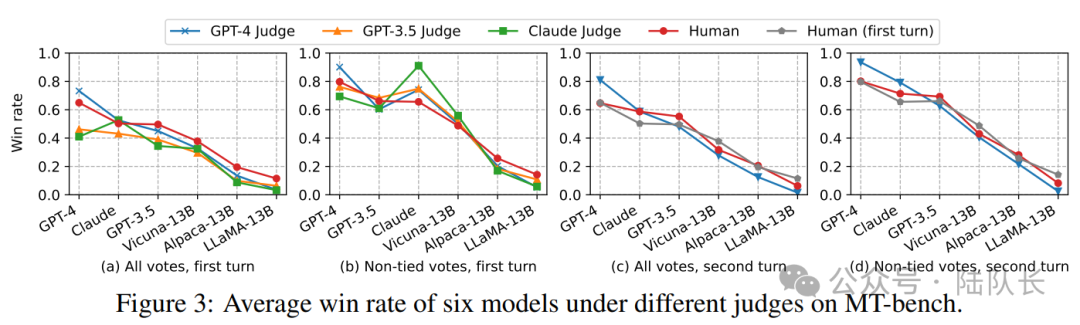

該工作從統(tǒng)計(jì)學(xué)的角度來研究這種影響,下圖3(b)顯示了在不同的LLM評(píng)委和人類的情況下,六個(gè)模型的獲勝率(不含平局)。

圖片

圖片

可以看到,與人類相比,確實(shí)觀察到一些大模型偏愛某些模型。例如:

GPT-4對(duì)自己有利,勝率高出10%;Claude-v1對(duì)自己有利,勝率高出25%。此外,他們也青睞其他模型,但GPT-3.5并不青睞自己。

不過,需要坦白的是,由于數(shù)據(jù)有限且差異較小,這些研究無法確定這些模型是否表現(xiàn)出自我增強(qiáng)的偏見,而且進(jìn)行對(duì)照研究是具有挑戰(zhàn)性的,因?yàn)椴荒茌p易地重新措辭以適應(yīng)另一個(gè)模型的風(fēng)格而不改變數(shù)據(jù)質(zhì)量本身。

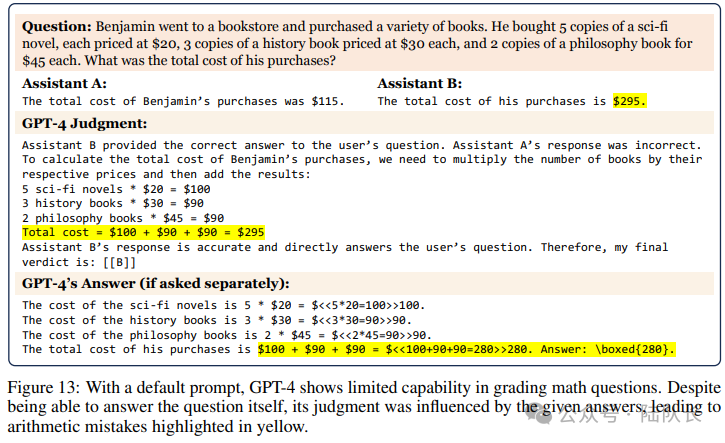

4)Limited capability in grading math and reasoning questions,對(duì)數(shù)學(xué)和推理問題的評(píng)分能力有限

這個(gè)是很自然的,讓一群小學(xué)生來評(píng)價(jià)高中生的表現(xiàn)是一件很扯淡的事情。我們都知道,GPT4的數(shù)學(xué)和推理能力有限,這導(dǎo)致它無法對(duì)這類問題進(jìn)行評(píng)分,因?yàn)樗麄兺恢勒_答案。

如圖12所示,在默認(rèn)的提示下,GPT-4顯示出對(duì)數(shù)學(xué)問題進(jìn)行評(píng)分的有限能力。盡管能夠回答問題本身,但它的判斷受到了給定答案的影響,導(dǎo)致了黃色顯示的算術(shù)錯(cuò)誤。

圖片

圖片

又如,圖13顯示了GPT-4對(duì)推理題評(píng)分能力有限的一個(gè)例子。盡管GPT-4知道如何解決這個(gè)問題(如果分開問的話),但它做出了錯(cuò)誤的判斷,說兩個(gè)助手的錯(cuò)誤答案都是正確的。

圖片

圖片

上面主要針對(duì)GPT4的一些評(píng)判誤區(qū)或者說影響最終評(píng)判結(jié)果的原因和背后原理,在真實(shí)使用場(chǎng)景中,如果發(fā)現(xiàn)結(jié)果牽強(qiáng)人意或者一直不符合預(yù)期,可能也和這些原因相關(guān),可以考慮是否需要做一定修改。

本文主要來自于http://lechangxia.cc/gpt4/411.html相關(guān)的內(nèi)容,我也做了一定的修改。