多個SOTA !OV-Uni3DETR:提高3D檢測在類別、場景和模態之間的普遍性(清華&港大)

本文經自動駕駛之心公眾號授權轉載,轉載請聯系出處。

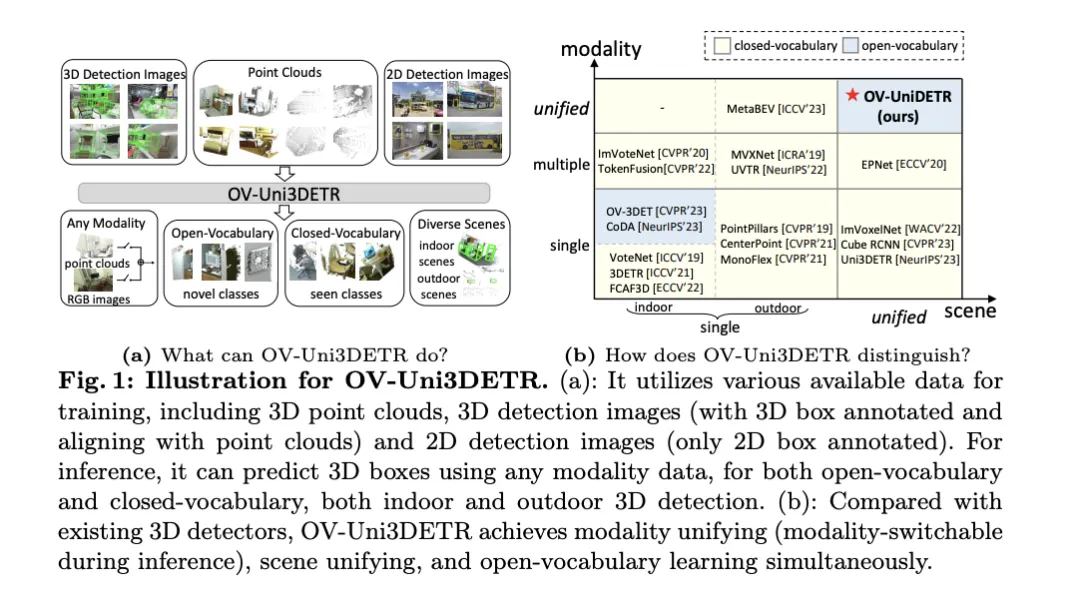

這篇論文聚焦于3D目標檢測的領域,特別是Open-Vocabulary的3D目標檢測。在傳統的3D目標檢測任務中,系統旨在預測真實場景中物體的定向3D邊界框和語義類別標簽,這通常依賴于點云或RGB圖像。盡管2D目標檢測技術因其普遍性而迅速發展,但相關研究表明,3D通用檢測的發展相比之下顯著滯后。當前,大多數3D目標檢測方法仍然依賴于完全監督學習,并受到特定輸入模式下完全標注數據的限制,只能識別訓練過程中出現的類別,無論是在室內還是室外場景中。

這篇論文指出,3D通用目標檢測面臨的挑戰主要包括:現有的3D檢測器僅能在封閉詞匯的情況下工作,因此只能檢測已見過的類別。緊迫需要Open-Vocabulary的3D目標檢測,以識別和定位訓練過程中未獲取的新類別目標實例。然而,現有的3D檢測數據集在大小和類別上與2D數據集相比都有限制,這限制了在定位新目標方面的泛化能力。此外,3D領域缺乏預訓練的圖像-文本模型,這進一步加劇了Open-Vocabulary3D檢測的挑戰。同時,缺乏一種針對多模態3D檢測的統一架構,現有的3D檢測器大多設計用于特定的輸入模態(點云、RGB圖像或兩者)和場景(室內或室外),這阻礙了有效利用來自不同模態和來源的數據,從而限制了對新目標的泛化能力。

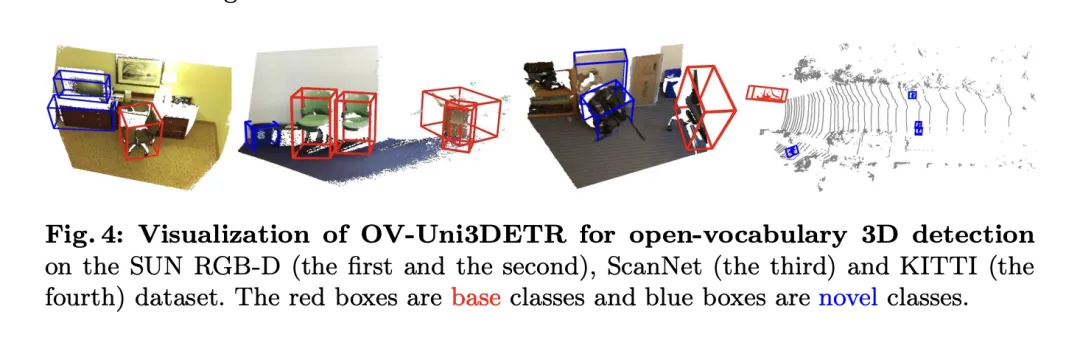

為了解決上述問題,論文提出了一種稱為OV-Uni3DETR的統一多模態3D檢測器。該檢測器在訓練期間能夠利用多模態和多來源數據,包括點云、帶有精確3D框標注并與點云對齊的3D檢測圖像,以及僅帶有2D框標注的2D檢測圖像。通過這種多模態學習方式,OV-Uni3DETR能夠在推理時處理任何模態的數據,實現測試時的模態切換,并在檢測基礎類別和新類別上表現出色。統一的結構進一步使OV-Uni3DETR能夠在室內和室外場景中進行檢測,具備Open-Vocabulary能力,從而顯著提高3D檢測器在類別、場景和模態之間的普遍性。

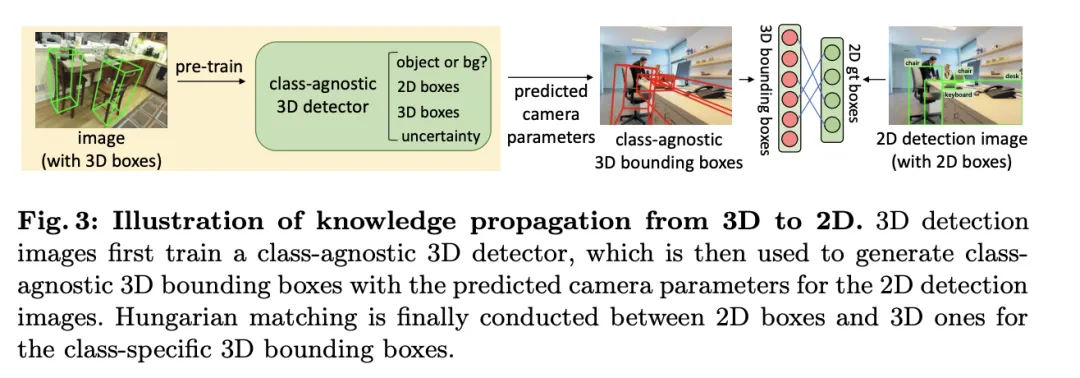

此外,針對如何泛化檢測器以識別新類別的問題,以及如何從沒有3D框標注的大量2D檢測圖像中學習的問題,論文提出了一種稱為周期模態傳播的方法——在2D和3D模態之間傳播知識以解決這兩個挑戰。通過這種方法,2D檢測器的豐富語義知識可以傳播到3D領域,以協助發現新的框,而3D檢測器的幾何知識則可以用于在2D檢測圖像中定位目標,并通過匈牙利匹配分配類別標簽。

論文的主要貢獻包括提出了一個能夠在不同模態和多樣化場景中檢測任何類別目標的統一Open-Vocabulary3D檢測器OV-Uni3DETR;提出了一個針對室內和室外場景的統一多模態架構;以及提出了2D和3D模態之間知識傳播循環的概念。通過這些創新,OV-Uni3DETR在多個3D檢測任務上實現了最先進的性能,并在Open-Vocabulary設置下顯著超過了之前的方法。這些成果表明,OV-Uni3DETR為3D基礎模型的未來發展邁出了重要一步。

OV-Uni3DETR方法詳解

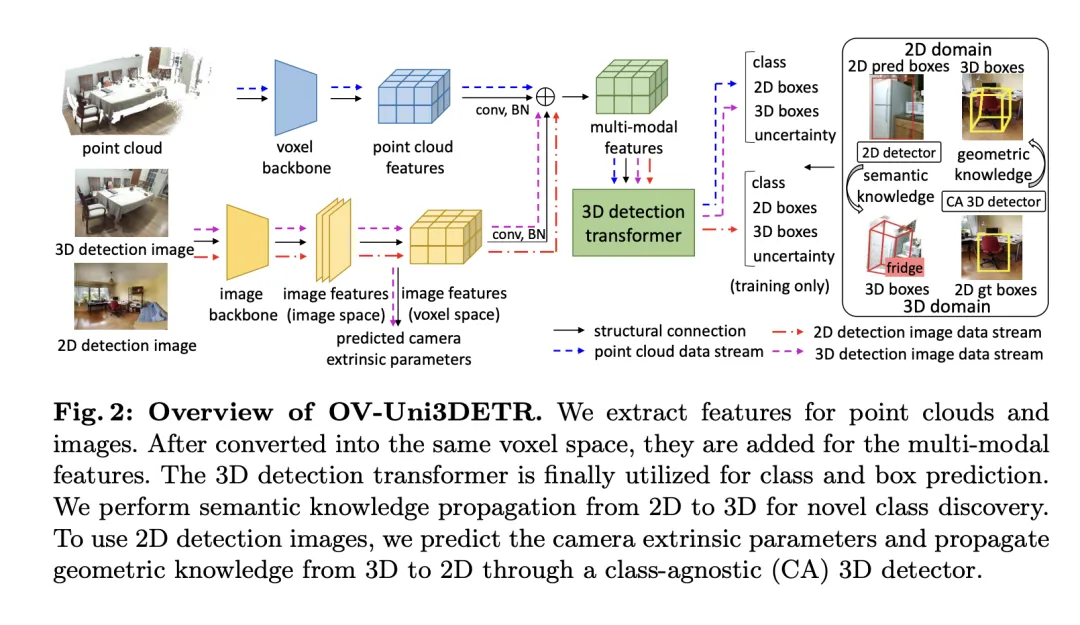

Multi-Modal Learning

這篇論文提出了一種多模態學習架構,專門針對3D目標檢測任務,通過整合點云數據和圖像數據來增強檢測性能。這種架構能夠處理在推理時可能缺失的某些傳感器模態,即具備測試時模態切換的能力。通過特定的網絡結構提取并整合來自兩種不同模態的特征,即3D點云特征和2D圖像特征,這些特征分別經過體素化處理和相機參數映射后,被融合用于后續的目標檢測任務。

關鍵的技術點包括使用3D卷積和批量歸一化來規范化和整合不同模態的特征,防止在特征級別上的不一致性導致某一模態被忽略。此外,采用隨機切換模態的訓練策略,確保模型能夠靈活地處理僅來自單一模態的數據,從而提高模型的魯棒性和適應性。

最終,該架構利用復合損失函數,結合了類別預測、2D和3D邊界框回歸的損失,以及一個用于加權回歸損失的不確定性預測,來優化整個檢測流程。這種多模態學習方法不僅提高了對現有類別的檢測性能,而且通過融合不同類型的數據,增強了對新類別的泛化能力。多模態架構最終預測類別標簽、4維2D框和7維3D框,用于2D和3D目標檢測。對于3D框回歸,使用L1損失和解耦IoU損失;對于2D框回歸,使用L1損失和GIoU損失。在Open-Vocabulary設置中,存在新類別樣本,這增加了訓練樣本的難度。因此,引入了不確定性預測 ,并用它來加權L1回歸損失。目標檢測學習的損失為:

,并用它來加權L1回歸損失。目標檢測學習的損失為:

對于某些3D場景,可能存在多視圖圖像,而不是單一的單眼圖像。對于它們中的每一個,提取圖像特征并使用各自的投影矩陣投影到體素空間。體素空間中的多個圖像特征被求和以獲取多模態特征。這種方法通過結合來自不同模態的信息,提高了模型對新類別的泛化能力,并增強了在多樣化輸入條件下的適應性。

Knowledge Propagation: 2D—3D

在介紹的多模態學習基礎上,文中針對Open-Vocabulary的3D檢測執行了一種稱為“知識傳播: ”的方法。Open-Vocabulary學習的核心問題是識別訓練過程中未經人工標注的新類別。由于獲取點云數據的難度,預訓練的視覺-語言模型尚未在點云領域被開發。點云數據與RGB圖像之間的模態差異限制了這些模型在3D檢測中的性能。

”的方法。Open-Vocabulary學習的核心問題是識別訓練過程中未經人工標注的新類別。由于獲取點云數據的難度,預訓練的視覺-語言模型尚未在點云領域被開發。點云數據與RGB圖像之間的模態差異限制了這些模型在3D檢測中的性能。

為了解決這個問題,提出利用預訓練的2DOpen-Vocabulary檢測器的語義知識,并為新類別生成相應的3D邊界框。這些生成的3D框將補充訓練時可用類別有限的3D真實標簽。

具體來說,首先使用2DOpen-Vocabulary檢測器生成2D邊界框或實例遮罩。考慮到在2D領域可用的數據和標注更為豐富,這些生成的2D框能夠實現更高的定位精度,并覆蓋更廣泛的類別范圍。然后,通過 將這些2D框投影到3D空間,以獲得相應的3D框。具體操作是使用

將這些2D框投影到3D空間,以獲得相應的3D框。具體操作是使用

將3D點投影到2D空間,找到2D框內的點,然后對2D框內的這些點進行聚類以消除離群值,從而獲得相應的3D框。由于預訓練的2D檢測器的存在,未標注的新目標可以在生成的3D框集中被發現。通過這種方式,從2D領域到生成的3D框傳播的豐富語義知識,極大地促進了3DOpen-Vocabulary檢測。對于多視圖圖像,分別生成3D框并將它們集成在一起以供最終使用。

在推理過程中,當點云和圖像都可用時,可以以類似的方式提取3D框。這些生成的3D框也可以視為3DOpen-Vocabulary檢測結果的一種形式。將這些3D框添加到多模態3D變換器的預測中,以補充可能缺失的目標,并通過3D非極大值抑制(NMS)過濾重疊的邊界框。由預訓練的2D檢測器分配的置信度得分通過預定的常數系統地除以,然后重新解釋為相應3D框的置信度得分。

實驗

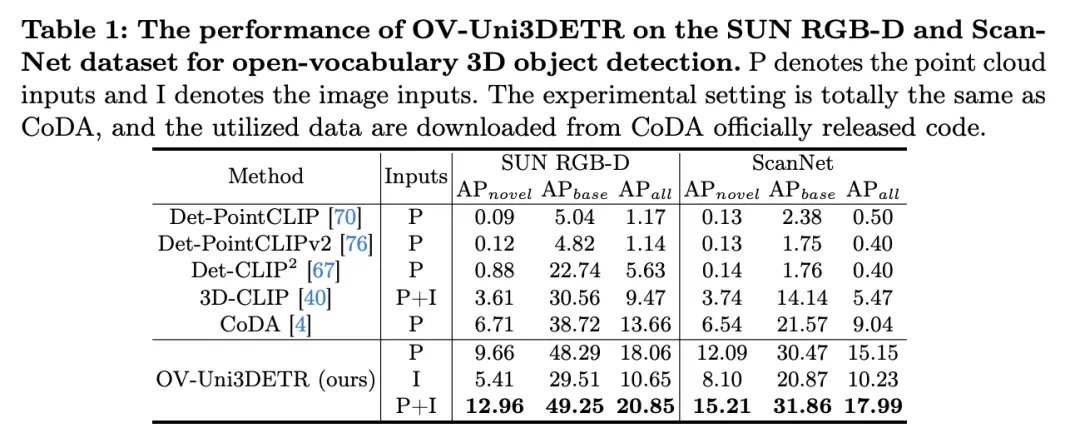

表格展示了OV-Uni3DETR在SUN RGB-D和ScanNet數據集上進行Open-Vocabulary3D目標檢測的性能。實驗設置與CoDA完全相同,使用的數據來自CoDA官方發布的代碼。性能指標包括新類別平均精度 、基類平均精度

、基類平均精度 和所有類平均精度

和所有類平均精度 。輸入類型包括點云(P)、圖像(I)以及它們的組合(P+I)。

。輸入類型包括點云(P)、圖像(I)以及它們的組合(P+I)。

分析這些結果,我們可以觀察到以下幾點:

- 多模態輸入的優勢:當使用點云和圖像的組合作為輸入時,OV-Uni3DETR在兩個數據集的所有評價指標上都取得了最高分,尤其是在新類別平均精度

上的提升最為顯著。這表明結合點云和圖像可以顯著提高模型對未見類別的檢測能力,以及整體檢測性能。

上的提升最為顯著。這表明結合點云和圖像可以顯著提高模型對未見類別的檢測能力,以及整體檢測性能。 - 對比其他方法:與其他基于點云的方法相比(如Det-PointCLIP、Det-PointCLIPv2、Det-CLIP、3D-CLIP和CoDA),OV-Uni3DETR在所有評價指標上都展現出優異的性能。這證明了OV-Uni3DETR在處理Open-Vocabulary3D目標檢測任務上的有效性,尤其是在利用多模態學習和知識傳播策略方面。

- 圖像與點云輸入的比較:僅使用圖像(I)作為輸入的OV-Uni3DETR雖然在性能上低于使用點云(P)作為輸入的情況,但依然表現出不錯的檢測能力。這證明了OV-Uni3DETR架構的靈活性和對單一模態數據的適應能力,同時也強調了融合多種模態數據對提升檢測性能的重要性。

- 在新類別上的表現:OV-Uni3DETR在新類別平均精度

上的表現尤其值得關注,這對于Open-Vocabulary檢測尤為關鍵。在SUN RGB-D數據集上,使用點云和圖像輸入時的

上的表現尤其值得關注,這對于Open-Vocabulary檢測尤為關鍵。在SUN RGB-D數據集上,使用點云和圖像輸入時的 達到了12.96%,在ScanNet數據集上達到了15.21%,這顯著高于其他方法,顯示了其在識別訓練過程中未見過的類別上的強大能力。

達到了12.96%,在ScanNet數據集上達到了15.21%,這顯著高于其他方法,顯示了其在識別訓練過程中未見過的類別上的強大能力。

總的來說,OV-Uni3DETR通過其統一的多模態學習架構,在Open-Vocabulary3D目標檢測任務上表現出卓越的性能,尤其是在結合點云和圖像數據時,能夠有效提升對新類別的檢測能力,證明了多模態輸入和知識傳播策略的有效性和重要性。

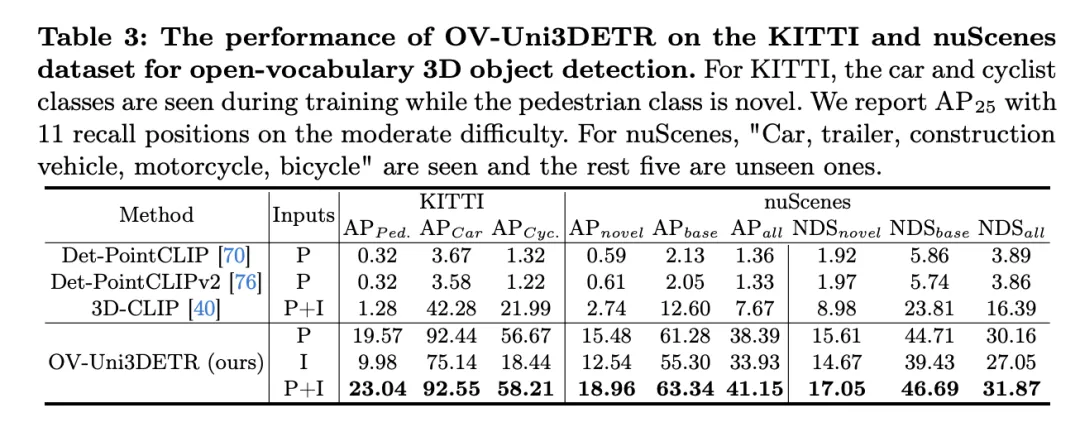

這個表格展示了OV-Uni3DETR在KITTI和nuScenes數據集上進行Open-Vocabulary3D目標檢測的性能,涵蓋了在訓練過程中已見(base)和未見(novel)的類別。對于KITTI數據集,"car"和"cyclist"類別在訓練過程中已見,而"pedestrian"類別是新穎的。性能使用在中等難度下的

指標來衡量,且采用了11個召回位置。對于nuScenes數據集,"car, trailer, construction vehicle, motorcycle, bicycle"是已見類別,剩余五個為未見類別。除了AP指標外,還報告了NDS(NuScenes Detection Score)來綜合評估檢測性能。

分析這些結果可以得出以下結論:

- 多模態輸入的顯著優勢:與僅使用點云(P)或圖像(I)作為輸入的情況相比,當同時使用點云和圖像(P+I)作為輸入時,OV-Uni3DETR在所有評價指標上都獲得了最高分。這一結果強調了多模態學習在提高對未見類別檢測能力和整體檢測性能方面的顯著優勢。

- Open-Vocabulary檢測的有效性:OV-Uni3DETR在處理未見類別時展現出了出色的性能,尤其是在KITTI數據集的"pedestrian"類別和nuScenes數據集的"novel"類別上。這表明了模型對新穎類別具有很強的泛化能力,是一個有效的Open-Vocabulary檢測解決方案。

- 與其他方法的對比:與其他基于點云的方法相比(如Det-PointCLIP、Det-PointCLIPv2和3D-CLIP),OV-Uni3DETR展現出了顯著的性能提升,無論是在已見還是未見類別的檢測上。這證明了其在處理Open-Vocabulary3D目標檢測任務上的先進性。

- 圖像輸入與點云輸入的對比:盡管使用圖像輸入的性能略低于使用點云輸入,但圖像輸入仍然能夠提供相對較高的檢測精度,這表明了OV-Uni3DETR架構的適應性和靈活性。

- 綜合評價指標:通過NDS評價指標的結果可以看出,OV-Uni3DETR不僅在識別準確性上表現出色,而且在整體檢測質量上也取得了很高的分數,尤其是在結合點云和圖像數據時。

OV-Uni3DETR在Open-Vocabulary3D目標檢測上展示了卓越的性能,特別是在處理未見類別和多模態數據方面。這些結果驗證了多模態輸入和知識傳播策略的有效性,以及OV-Uni3DETR在提升3D目標檢測任務泛化能力方面的潛力。

討論

這篇論文通過提出OV-Uni3DETR,一個統一的多模態3D檢測器,為Open-Vocabulary的3D目標檢測領域帶來了顯著的進步。該方法利用了多模態數據(點云和圖像)來提升檢測性能,并通過2D到3D的知識傳播策略,有效地擴展了模型對未見類別的識別能力。在多個公開數據集上的實驗結果證明了OV-Uni3DETR在新類別和基類上的出色性能,尤其是在結合點云和圖像輸入時,能夠顯著提高對新類別的檢測能力,同時在整體檢測性能上也達到了新的高度。

優點方面,OV-Uni3DETR首先展示了多模態學習在提升3D目標檢測性能中的潛力。通過整合點云和圖像數據,模型能夠從每種模態中學習到互補的特征,從而在豐富的場景和多樣的目標類別上實現更精確的檢測。其次,通過引入2D到3D的知識傳播機制,OV-Uni3DETR能夠利用豐富的2D圖像數據和預訓練的2D檢測模型來識別和定位訓練過程中未見過的新類別,這大大提高了模型的泛化能力。此外,該方法在處理Open-Vocabulary檢測時顯示出的強大能力,為3D檢測領域帶來了新的研究方向和潛在應用。

缺點方面,雖然OV-Uni3DETR在多個方面展現了其優勢,但也存在一些潛在的局限性。首先,多模態學習雖然能提高性能,但也增加了數據采集和處理的復雜性,尤其是在實際應用中,不同模態數據的同步和配準可能會帶來挑戰。其次,盡管知識傳播策略能有效利用2D數據來輔助3D檢測,但這種方法可能依賴于高質量的2D檢測模型和準確的3D-2D對齊技術,這在一些復雜環境中可能難以保證。此外,對于一些極其罕見的類別,即使是Open-Vocabulary檢測也可能面臨識別準確性的挑戰,這需要進一步的研究來解決。

OV-Uni3DETR通過其創新的多模態學習和知識傳播策略,在Open-Vocabulary3D目標檢測上取得了顯著的進展。雖然存在一些潛在的局限性,但其優點表明了這一方法在推動3D檢測技術發展和應用拓展方面的巨大潛力。未來的研究可以進一步探索如何克服這些局限性,以及如何將這些策略應用于更廣泛的3D感知任務中。

結論

在本文中,我們主要提出了OV-Uni3DETR,一種統一的多模態開放詞匯三維檢測器。借助于多模態學習和循環模態知識傳播,我們的OV-Uni3DETR很好地識別和定位了新類,實現了模態統一和場景統一。實驗證明,它在開放詞匯和封閉詞匯環境中,無論是室內還是室外場景,以及任何模態數據輸入中都有很強的能力。針對多模態環境下統一的開放詞匯三維檢測,我們相信我們的研究將推動后續研究沿著有希望但具有挑戰性的通用三維計算機視覺方向發展。