使用Kafka構(gòu)建實(shí)時(shí)音樂排行榜系統(tǒng),你學(xué)會了嗎?

初識Kafka:你的現(xiàn)場DJ

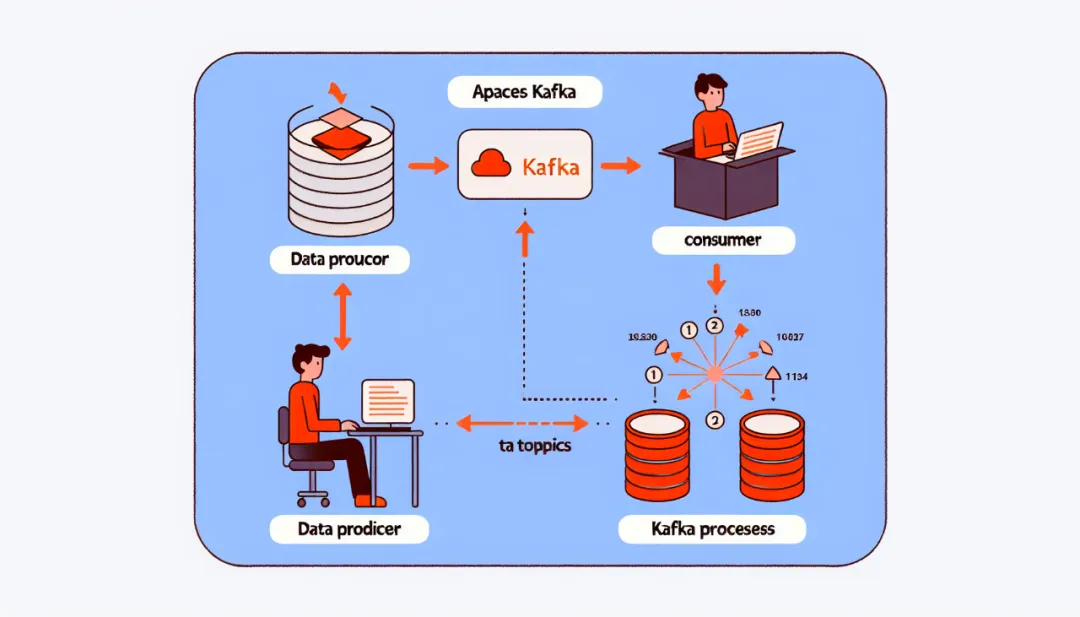

Apache Kafka是一個(gè)開源的流處理平臺,可用于處理和分析實(shí)時(shí)數(shù)據(jù)。就像一位DJ,Apache Kafka在數(shù)據(jù)的洪流之間表現(xiàn)出了無與倫比的調(diào)度能力。它可以從各種來源接收大量的實(shí)時(shí)數(shù)據(jù),如跟蹤用戶的在線活動,或者諸如音頻流的持續(xù)數(shù)據(jù)流,然后將這些數(shù)據(jù)正確分發(fā)到等待處理的程序。

Apache Kafka的核心構(gòu)件包括Producer(生產(chǎn)者), Consumer(消費(fèi)者), Broker(代理)和 Topic(主題)。Producer負(fù)責(zé)接收和發(fā)送數(shù)據(jù),Consumer從Kafka拉取數(shù)據(jù)進(jìn)行處理,所有的讀寫操作都通過Broker進(jìn)行調(diào)度,并以Topic作為數(shù)據(jù)的分類依據(jù)。

在音樂界的Kafka:強(qiáng)大的實(shí)時(shí)數(shù)據(jù)處理引擎

在音樂界,Apache Kafka可以實(shí)現(xiàn)榜單的實(shí)時(shí)更新,對聽眾的偏好進(jìn)行實(shí)時(shí)反饋,甚至還可以跟蹤和分析一首歌的流行度。所有這些都依賴于Kafka高效、可靠和可擴(kuò)展的流處理能力。

以普通的音樂播放器為例,當(dāng)用戶點(diǎn)擊播放鍵時(shí),播放器可以將這個(gè)行為作為一個(gè)事件發(fā)送到Kafka,其他正在監(jiān)聽這個(gè)類型事件的應(yīng)用程序,如排行榜生成器,可以實(shí)時(shí)接收到這個(gè)消息并更新榜單。

創(chuàng)建實(shí)時(shí)音樂排行榜:Kafka的應(yīng)用實(shí)例

首先,生成一條播放歌曲的事件,并發(fā)送到Kafka,這個(gè)過程是由Producer來完成的。每當(dāng)用戶點(diǎn)擊播放一首歌曲時(shí),前端網(wǎng)頁或APP就會生成一條播放歌曲的事件,然后調(diào)用后臺服務(wù)的API,將這個(gè)事件發(fā)送給后臺服務(wù)。后臺服務(wù)接收到這個(gè)事件后,將其轉(zhuǎn)化為Kafka所需要的格式,然后調(diào)用Kafka Producer API,將這條事件發(fā)送到Kafka。這個(gè)過程可能需要幾十毫秒到幾百毫秒,取決于網(wǎng)絡(luò)速度、代碼效率等因素。

然后,Kafka會接收到這條事件,并將其寫入存儲在硬盤上的日志文件,這個(gè)過程通常非常快,只需要幾毫秒。同時(shí),Kafka會將這個(gè)事件復(fù)制到其他的Broker上,以提高數(shù)據(jù)的可靠性。

接下來,排行榜程序作為Kafka的Consumer,會周期性地讀取Kafka的數(shù)據(jù)。排行榜程序可以設(shè)置自己的讀取速度,例如每秒讀取一次,或者每收到10條新的事件就讀取一次等。每次讀取,它都會得到一批新的播放歌曲的事件。然后,排行榜程序會把這批新的事件傳遞給排行榜算法,由算法根據(jù)這批事件來更新排行榜的狀態(tài)。

下面是一個(gè)使用Java Kafka客戶端API的例子:

生產(chǎn)者發(fā)送播放音樂的事件

import org.apache.kafka.clients.producer.*;

Properties props = new Properties();

props.put("bootstrap.servers", "localhost:9092");

props.put("key.serializer","org.apache.kafka.common.serialization.StringSerializer");

props.put("value.serializer", "org.apache.kafka.common.serialization.StringSerializer");

Producer<String, String> producer = new KafkaProducer<>(props);

try {

for(int i = 0; i < 100; i++)

producer.send(new ProducerRecord<String, String>("my-topic", Integer.toString(i), Integer.toString(i)));

}

catch (Exception e) {

e.printStackTrace();

}

finally {

producer.close();

}消費(fèi)者訂閱并處理播放音樂的事件

import org.apache.kafka.clients.consumer.*;

Properties props = new Properties();

props.put("bootstrap.servers", "localhost:9092");

props.put("group.id", "test");

props.put("enable.auto.commit", "true");

props.put("key.deserializer", "org.apache.kafka.common.serialization.StringDeserializer");

props.put("value.deserializer", "org.apache.kafka.common.serialization.StringDeserializer");

KafkaConsumer<String, String> consumer = new KafkaConsumer<>(props);

consumer.subscribe(Arrays.asList("my-topic"));

while (true) {

ConsumerRecords<String, String> records = consumer.poll(100);

for (ConsumerRecord<String, String> record : records)

System.out.printf("offset = %d, key = %s, value = %s%n", record.offset(), record.key(), record.value());

}同時(shí),這個(gè)消費(fèi)者還具有處理數(shù)據(jù)的職責(zé)。通常,我們會使用Multi-Threaded Processing或使用Kafka Streams庫來處理大量的并發(fā)數(shù)據(jù)。

圖片

圖片

常遇到的問題和解決辦法:Kafka的最佳實(shí)踐

在實(shí)際使用Kafka時(shí),我們可能會遇到各種問題。以下是一些最普遍的問題以及解決方案的代碼示例。

數(shù)據(jù)延遲:數(shù)據(jù)延遲可能是由許多因素引起的,包括網(wǎng)絡(luò)延遲、Kafka系統(tǒng)負(fù)載、消息生產(chǎn)者寫入的速度、同時(shí)處理的消費(fèi)者的數(shù)量,還有Kafka的內(nèi)部過程延遲等。

使用Kafka Streams進(jìn)行流處理是一種優(yōu)化數(shù)據(jù)延遲的方式。Kafka Streams API允許你在生產(chǎn)者和消費(fèi)者之間建立流處理管道,實(shí)現(xiàn)“實(shí)時(shí)”處理:

import org.apache.kafka.streams.*;

import org.apache.kafka.streams.kstream.*;

stream = new StreamsBuilder()

.stream("my-input-topic", Consumed.with(Serdes.String(), Serdes.String()))

.mapValues(value -> String.valueOf(value.length())) // Transform the values into their length.

.to("my-output-topic", Produced.with(Serdes.String(), Serdes.String())); // Write back to Kafka.

// Now run the Streams pipeline:

KafkaStreams streams = new KafkaStreams(builder.build(), props);

streams.start();以上代碼示例展示了如何運(yùn)用mapValues操作在Kafka Streams中將值轉(zhuǎn)換為它們的長度。通過創(chuàng)建一系列的流操作,可以實(shí)現(xiàn)復(fù)雜的數(shù)據(jù)轉(zhuǎn)換和處理,從而最小化延遲。

數(shù)據(jù)丟失:Kafka消息可能因?yàn)楦鞣N刪去丟失,如網(wǎng)絡(luò)問題,系統(tǒng)崩潰或Kafka內(nèi)部錯(cuò)誤等。

為防止消息丟失,你可以設(shè)置生產(chǎn)者的acks參數(shù)為all,這樣生產(chǎn)者會等待所有副本節(jié)點(diǎn)的應(yīng)答。這種方式可以最大限度的防止數(shù)據(jù)丟失:

Properties props = new Properties();

props.put("bootstrap.servers", "localhost:9092");

props.put("acks", "all"); // Wait for acknowledgments from all replicas

props.put("retries", 0); // If set to greater than zero the client will resend any record.

Producer<String, String> producer = new KafkaProducer<>(props);在消費(fèi)者側(cè),為防止數(shù)據(jù)丟失,你應(yīng)該定期提交偏移量,并且在程序啟動時(shí)從最近提交的偏移量開始消費(fèi),這可以防止重復(fù)數(shù)據(jù)和數(shù)據(jù)丟失:

Properties props = new Properties();

props.put("bootstrap.servers", "localhost:9092");

props.put("group.id", "group1");

props.put("enable.auto.commit", "false");

KafkaConsumer<String, String> consumer = new KafkaConsumer<>(props);

while (true) {

ConsumerRecords<String, String> records = consumer.poll(Duration.ofMillis(100));

for (ConsumerRecord<String, String> record : records) {

// process record

}

consumer.commitSync(); // manually commit the offset

}以上代碼展示了禁用自動提交偏移量,并在處理完記錄后手動提交偏移量。

本文介紹了Apache Kafka的基礎(chǔ)用法,并通過音樂排行榜實(shí)例展示其應(yīng)用。同時(shí),討論了如何應(yīng)對使用中的數(shù)據(jù)延遲與丟失問題并給出了解決方案。