7B模型超越GPT4-V!港科大等發布「圖推理問答」數據集GITQA:視覺圖可提升推理能力

圖神經網絡(GNNs)擅長利用圖的結構信息進行推理,但它們通常需要特定于領域的調優才能達到峰值性能,這阻礙了它們在不同任務之間的泛化性。

相比之下,基于大型語言模型(LLM)的圖推理具有更強的跨任務和泛化能力,但它們在特定任務上的性能往往遜色于專用的圖神經網絡模型。

無論是以圖神經網絡為代表的傳統圖推理還是新興的基于大型語言模型的圖推理,目前圖推理相關工作都忽視了視覺模態的圖信息。

然而,人類會通過視覺特征高效和準確地完成圖任務,例如判斷圖中是否存在環。

因此,探究視覺形態的圖信息在圖推理中的作用具有重要意義。

更具體地,將圖(Graph)繪制為圖片(Image),是否能賦予模型特殊的推理能力呢?這些圖片(稱為視覺圖 Visual Graph)是否能增強現有的基于其他模態的圖推理模型呢?

為了回答這些問題,來自香港科技大學和南方科技大學的研究團隊構建了首個包含視覺圖的推理問答數據集GITQA,并在GPT-4 turbo,GPT-4V等開源模型和Vicuna,LLaVA等閉源模型上進行了廣泛的實驗,證實了Visual Graph在圖推理中的作用,以及其可以和文本模態相互增強。

圖片

圖片

論文地址:https://arxiv.org/abs/2402.02130

項目主頁:https://v-graph.github.io/

在GITQA測試基準中,以LLaVA-7B/13B為基礎微調出的多模態模型GITA-7B/13B,展示出了超越GPT-4V的圖推理性能。

GITQA 多模態圖推理問答數據集

研究團隊通過將圖結構繪制為不同風格的視覺圖像,建立了GITQA數據集及其相應的測試基準,GITQA數據集包含超過423K個問答實例,每個實例包含相互對應的圖結構-文本-視覺信息及其相應的問答對。

GITQA數據集包含兩個版本:GITQA-Base和GITQA-Aug,其中GITQA-Base只包含單一風格的視覺圖。

GITQA-Aug則更加豐富,它對視覺圖進行了多種數據增強處理,包括改變布局、點的形狀、邊的寬度和點的風格等,從而提供了更多樣化的視覺圖表現。

圖片

圖片

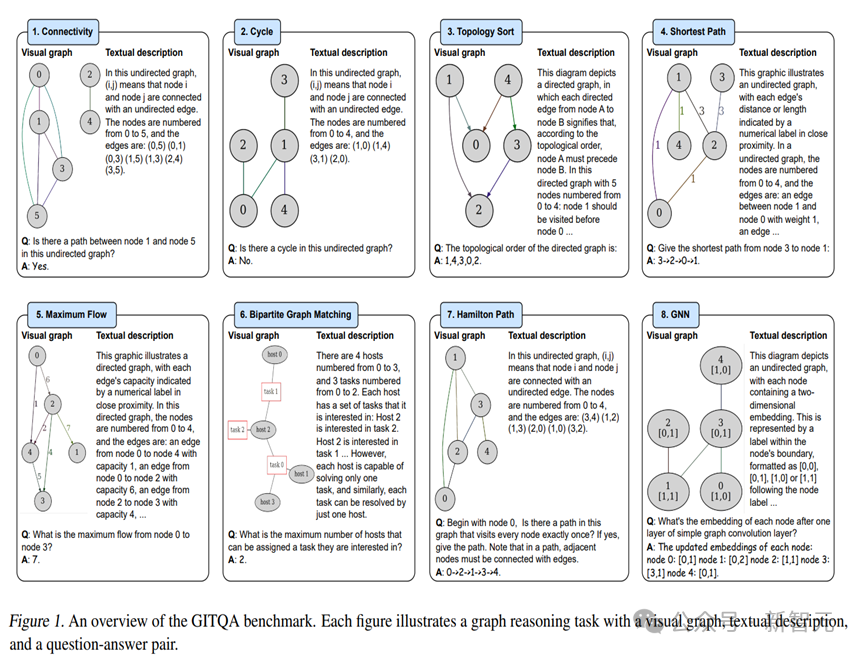

如圖1,GITQA測試基準包含8個具有代表性的圖推理任務:Connectivity(判斷圖中兩點是否聯通)、Cycle(判斷圖中是否有環)、TS(尋找圖的拓撲序)、 SP(尋找圖中兩點間的最短路徑)、 MaxFlow(計算圖中兩點間的最大流)、 BGM(計算二分圖的最大匹配)、 HP(尋找圖中的哈密頓路徑)和GNN(模擬GNN的消息傳遞)。

圖片

圖片

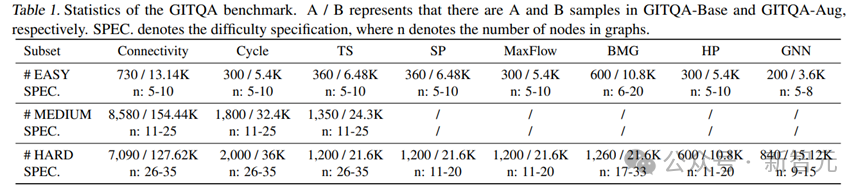

每個任務所對應的數據集都被按照圖結構的復雜程度被劃分為不同難度等級的子集(相關統計如表1)。

實驗及結果

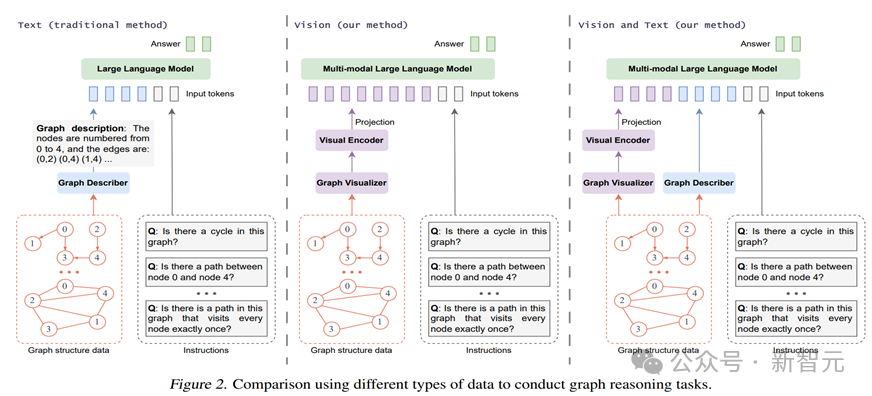

實驗一: 基于不同模態圖信息的模型的圖推理能力對比

研究團隊在GITQA-Base數據集上,根據不同的模態圖輸入類型(包括僅文本(T-Only)、僅視覺(V-Only)、以及文本加視覺(V+T)),評估了流行的閉源和開源大型語言模型(如GPT-4 turbo和Vicuna-7B/13B)以及大型多模態語言模型(如GPT-4V和LLaVA-7B/13B)的表現。如圖2所示。

圖片

圖片

具體來說,閉源模型GPT-4和GPT-4V執行零樣本推理,而對于開源模型Vicuna和LLaVA,則通過保持主干模型參數不變,僅訓練Projector和LoRA部分進行了微調(特別地,視覺+文本雙模態微調后的LLaVA模型被研究者命名為GITA)。

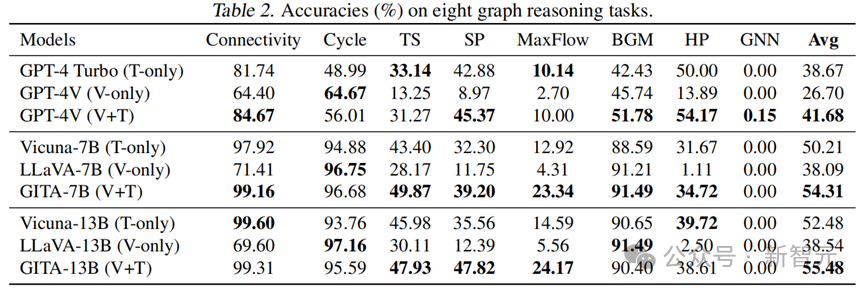

表2總結了所有八項圖推理任務的測試結果。

圖片

圖片

視覺模態 V.S. 文本模態

從表2中可以看到,在Cycle和BGM任務上,視覺模態的表現優于文本模態,而在其他五個任務上則不如文本模態。這揭示了視覺和文本在處理特定類型的圖推理任務上各具優勢。視覺和文本模態的相互增強

對于閉源模型,GPT-4V(V+T)在八個任務的平均準確率上遠高于GPT-4 Turbo(T-only)和GPT-4V(V-only)。

對于開源模型(7B,13B),同樣地,使用雙模態數據訓練出的GITA模型平均表現最佳。這些觀察結果驗證了同時使用視覺和文本信息能夠增強模型的圖推理能力,相比單模態模型可以實現更好的性能。

更具體地說,GITA-7B(V+T)在幾乎所有任務中表現優于LLaVA-7B(V-only)和Vicuna-7B(T-only)。而對于閉源模型,使用雙模態在八個任務中的五個上達到了最高準確率。微調后的LLaVA模型可超越GPT-4V

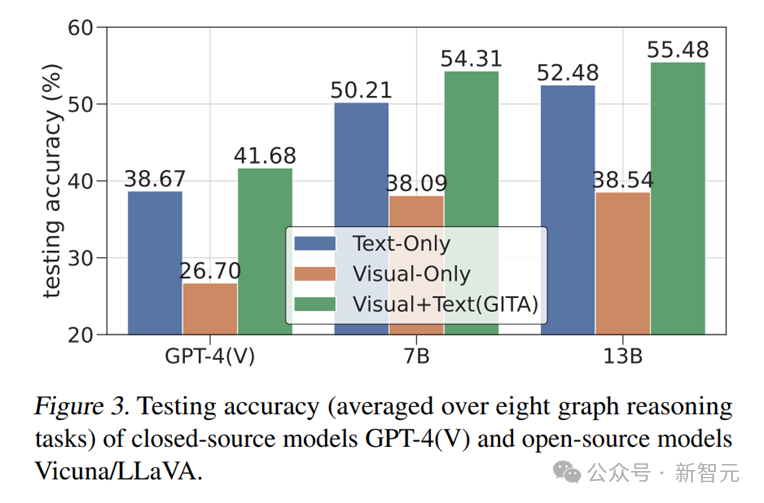

如表2和圖3所示,GITA-7B和GITA-13B模型,即經過雙模態微調的LLaVA-7B/13B模型,顯示出相較于GPT-4V超過13%的顯著性能提升。這一巨大的進步幅度表明,微調后的GITA模型能夠有效地從GITQA數據集中學習到出色的圖推理能力。

圖片

圖片

實驗二:難度等級對圖任務的影響

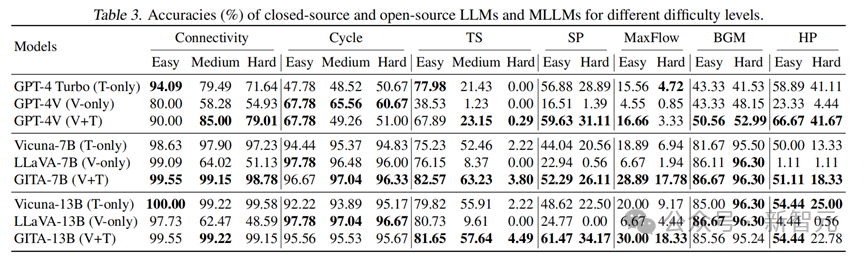

表3進一步給出了模型在不同難度級別上的測試精度,GNN任務由于對所有模型都太具挑戰被省略)。

在所有難度級別的Cycle和BGM任務中,單獨使用視覺模態的表現優于文本模態,并且與使用兩種模態的表現相當。

然而,對于其他任務,當難度從簡單增加到中等或困難時,只使用視覺模態的模型的性能顯著下降。

圖片

圖片

同樣,當難度增加時,只使用文本模態和使用視覺+文本模態的模型在這些任務上也會出現大幅度的性能下降。

對于Connectivity任務,GITA-7B(視覺+文本)和GITA-13B(視覺+文本)在所有三個挑戰級別上都表現出相當的性能。

然而,這種一致的模式在GPT-4V(視覺+文本)中并未觀察到,因為其性能隨著難度級別的增加而下降。

實驗三: 視覺圖的增強策略和風格偏好

研究團隊還探究了特別的數據增強策略在微調模型時的效果。

基于不同的增強策略,研究者將GITQA-Aug數據集劃分為四個增強子集: 布局增強數據集,節點形狀增強數據集,邊的寬度增強數據集,節點風格增強數據集。

圖片

圖片

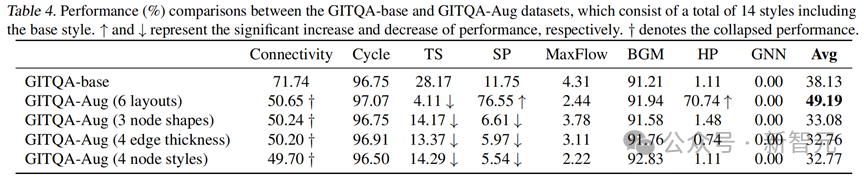

研究者在僅使用視覺圖信息的LLaVA-7B模型上對全部四個增強子集進行了單獨的微調,其推理性能與數據增強前的比較如表4所示。

可以明顯看出,模型在布局增強數據集上對于挑戰性任務的推理能力急劇提升(SP 上升64.8%,HP上升69.63%)。

而其他三種數據增強策略反而導致性能下降。

具體來說,模型在布局增強集上取得了優異的結果,比GITQA-Base集高出11%以上。相比之下,其他增廣集中八個任務的平均結果比基本集低約5%

圖片

圖片

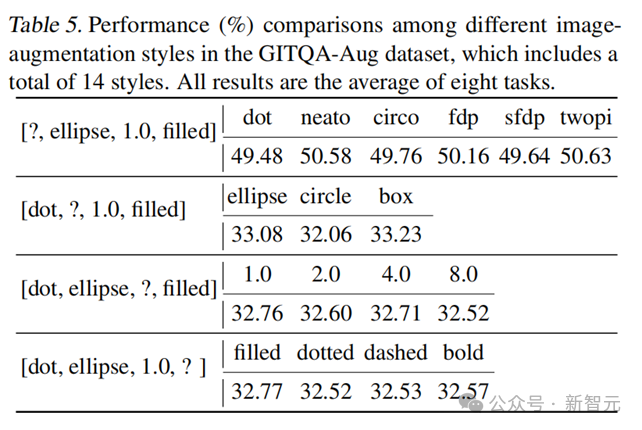

這些發現表明基于布局的數據增強為圖推理提供了更有效的視覺視角。進一步,研究者還測試了各個增強策略下,在同組內基于每種風格的Visual Graph推理的性能,如表5所示,展示出模型沒有明顯的風格偏好。