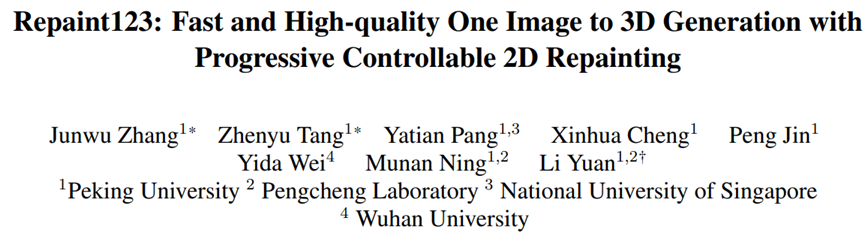

只需2分鐘,單視圖3D生成又快又好!北大等提出全新Repaint123方法

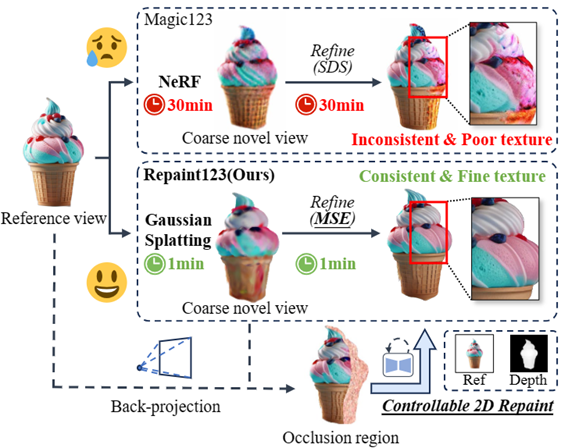

將一幅圖像轉(zhuǎn)換為3D的方法通常采用Score Distillation Sampling(SDS)的方法,盡管結(jié)果令人印象深刻,但仍然存在多個(gè)不足之處,包括多視角不一致、過度飽和、過度平滑的紋理,以及生成速度緩慢等問題。

為了解決這些問題,北京大學(xué)、新加坡國立大學(xué)、武漢大學(xué)等機(jī)構(gòu)的研究人員提出了Repaint123,以減輕多視角偏差、紋理退化,并加速生成過程。

論文地址:https://arxiv.org/pdf/2312.13271.pdf

GitHub:https://github.com/PKU-YuanGroup/repaint123

項(xiàng)目地址:https://pku-yuangroup.github.io/repaint123/

核心思想是將2D擴(kuò)散模型的強(qiáng)大圖像生成能力與再繪策略的紋理對齊能力結(jié)合起來,以生成具有一致性的高質(zhì)量多視角圖像。

作者進(jìn)一步提出了針對重疊區(qū)域的可見性感知自適應(yīng)再繪強(qiáng)度,以提高再繪過程中生成圖像的質(zhì)量。

生成的高質(zhì)量、多視角一致的圖像使得可以使用簡單的均方誤差(MSE)損失進(jìn)行快速的3D內(nèi)容生成。

作者進(jìn)行了大量實(shí)驗(yàn)證明,Repaint123能夠在2分鐘內(nèi)從零開始生成具有多視角一致性和精細(xì)紋理的高質(zhì)量3D內(nèi)容。

文章的主要貢獻(xiàn)點(diǎn)如下:

1. Repaint123全面考慮了圖像到3D生成的可控重繪過程,能夠生成多視角一致的高質(zhì)量圖片序列。

2. Repaint123提出了一個(gè)簡單的單視圖3D生成的baseline,粗模階段采用Zero123作為3D prior與SDS損失快速優(yōu)化Gaussian Splatting幾何(1分鐘),細(xì)模階段采用Stable Diffusion作為2D prior與MSE損失快速細(xì)化Mesh紋理(1分鐘)。

3. 大量的實(shí)驗(yàn)驗(yàn)證了Repaint123方法的有效性,可以在短短2分鐘內(nèi)從單一圖像中生成匹配2D生成的質(zhì)量的3D內(nèi)容。

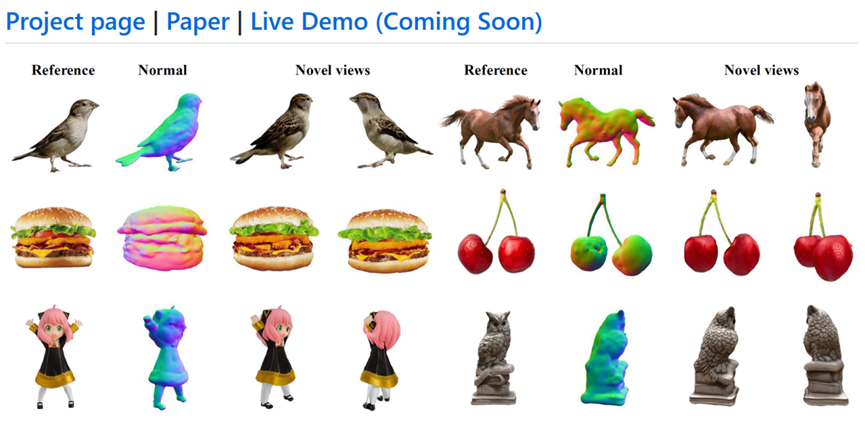

圖1:論文動機(jī):快速、一致、高質(zhì)量的單視角3D生成

具體方法:

Repaint123主要改進(jìn)集中于mesh細(xì)化階段,包含兩個(gè)部分:多視角一致的高質(zhì)量圖像序列生成,快速高質(zhì)量的3D重建。

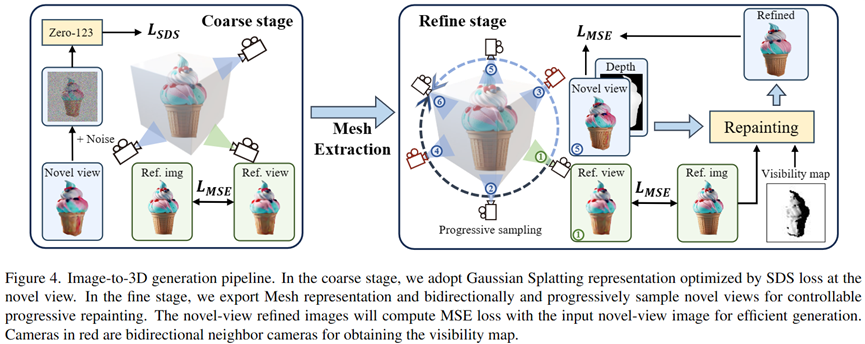

在粗模階段,作者采用3D Gaussian Splatting作為3D表征,通過SDS損失優(yōu)化的粗模幾何和紋理。

在細(xì)化階段,作者將粗模模型轉(zhuǎn)換為網(wǎng)格表示,并提出一種漸進(jìn)的、可控的紋理細(xì)化重繪方案。

首先,作者通過幾何控制和參考圖像的指導(dǎo)逐步重新繪制相對于先前優(yōu)化視圖的不可見區(qū)域,從而獲得新穎視圖的視圖一致性圖像。

然后,作者采用圖像提示進(jìn)行無分類器指導(dǎo),并設(shè)計(jì)自適應(yīng)重繪策略,以進(jìn)一步提高重疊區(qū)域的生成質(zhì)量。

最后,通過生成視圖一致的高質(zhì)量圖像,作者利用簡單的MSE損失來快速生成3D內(nèi)容。

多視角一致的高質(zhì)量圖像序列生成:

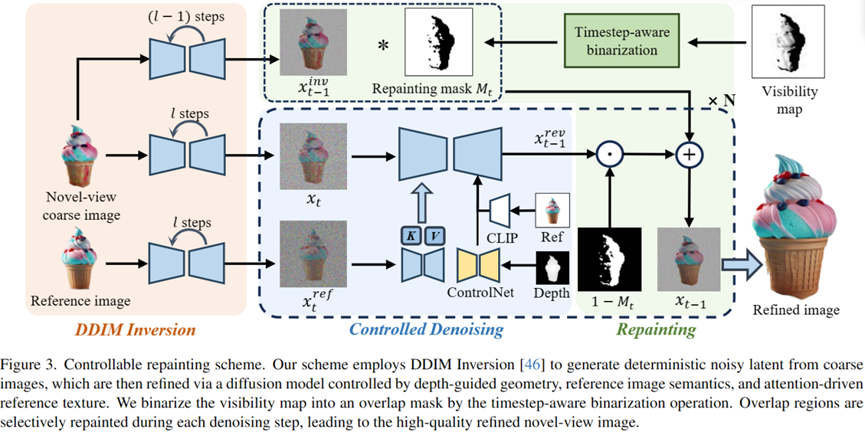

如圖2所示,多視角一致的高質(zhì)量圖像序列生成分為以下四個(gè)部分:

圖2:多視角一致的圖像生成流程

DDIM Inversion

為了保存粗模階段生成的3D一致的低頻紋理信息,作者使用DDIM Inversion將圖像反演到確定的latent, 為后續(xù)去噪生成忠實(shí)一致的圖片做基礎(chǔ)。

Controllable Denoising

為了控制幾何一致與長程紋理一致,在去噪階段作者使用ControlNet引入粗模渲染的深度圖作為幾何先驗(yàn), 注入?yún)⒖紙D的Attention特征進(jìn)行紋理遷移。

同時(shí),為了執(zhí)行Classifier-free guidance提升圖像質(zhì)量,論文使用CLIP將參考圖編碼為image prompt提示去噪網(wǎng)絡(luò)。

Obtain Occlusion Mask

為了從渲染出來的圖像In和深度圖--Dn的新穎視圖中獲得遮擋掩碼Mn,在給定Ir和Dr的重繪參考視圖Vr條件下,作者首先通過使用深度Dr縮放來自Vr的2D像素點(diǎn)至3D點(diǎn)云,然后從新視角Vn渲染3D點(diǎn)云Pr,得到深度圖Dn'。

作者認(rèn)為兩個(gè)新穎視圖深度圖(Dn和Dn')之間具有不同深度值的區(qū)域是遮擋掩碼中的遮擋區(qū)域。

Progressively Repainting both Occlusions and Overlaps

為了保證圖像序列重相鄰圖像的重疊區(qū)域像素級別對齊,作者使用了漸進(jìn)式局部重繪的策略,在保持重疊區(qū)域不變的情況下生成和諧一致的臨近區(qū)域,從參考視角依次類推到360°。

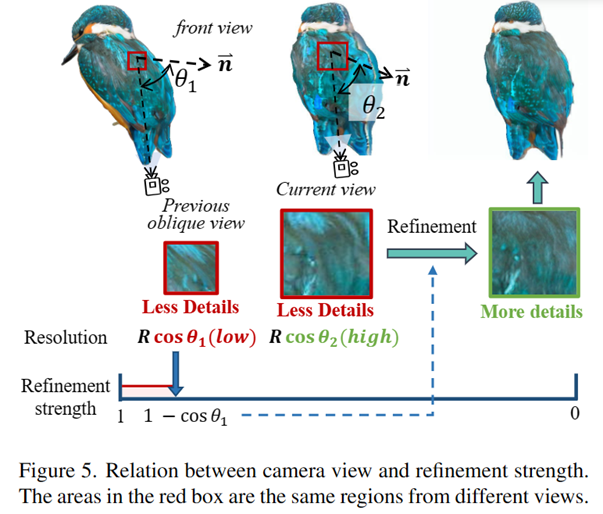

但是如圖3所示,作者發(fā)現(xiàn)重疊區(qū)域同樣需要進(jìn)行細(xì)化,因?yàn)橐粋€(gè)之前斜視的區(qū)域在正視時(shí)其可視分辨率變大,需要補(bǔ)充更多的高頻信息。

為了選擇合適的細(xì)化強(qiáng)度使得在提升質(zhì)量的同時(shí)保證忠實(shí)度,作者借鑒投影定理與圖像超分的思想,提出了一種簡單直接的能見度可感知的重繪策略來細(xì)化重疊區(qū)域,另細(xì)化強(qiáng)度等于1-cosθ*(其中θ*為之前所有相機(jī)視角與所視表面法向量夾角的最大值),從而自適應(yīng)地重繪重疊區(qū)域。

圖3:相機(jī)視角與細(xì)化強(qiáng)度的關(guān)系

快速高質(zhì)量的3D重建:

如圖4所示,作者采用了兩階段方法,先使用Gaussian Splatting表示來快速生成合理的幾何和粗糙的紋理,同時(shí)借助上述生成的多視角一致的高質(zhì)量圖像序列, 作者得以使用簡單的MSE loss進(jìn)行快速的3D紋理重建。

圖4:Repaint123兩階段單視角3D生成框架

實(shí)驗(yàn)結(jié)果

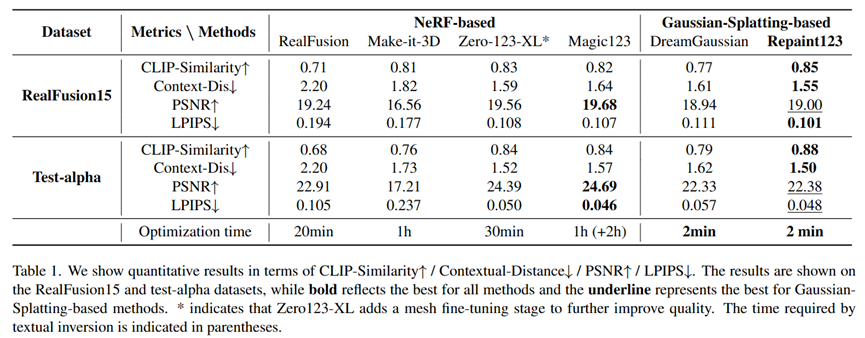

作者比較了多個(gè)單視圖生成任務(wù)方法,在RealFusion15和Test-alpha數(shù)據(jù)集上取得了一致性、質(zhì)量、速度三方面最先進(jìn)的效果。

單視圖3D生成可視化比較

單視圖3D生成定量比較

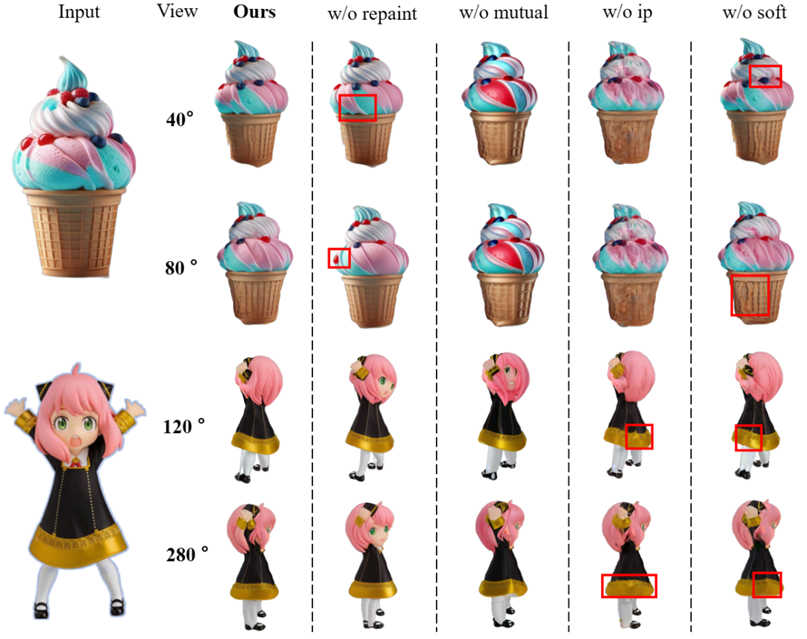

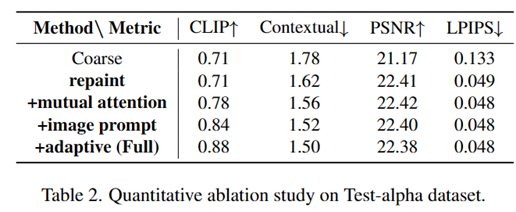

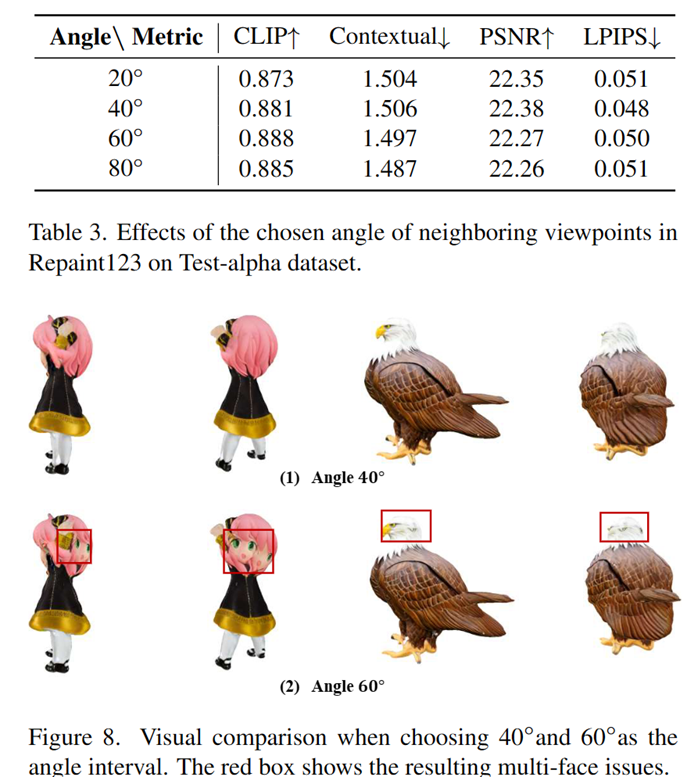

消融實(shí)驗(yàn)

同時(shí),作者也對論文使用的每個(gè)模塊的有效性以及視角轉(zhuǎn)動增量進(jìn)行了消融實(shí)驗(yàn):