《我的世界》化身AI小鎮(zhèn),NPC居民角色扮演如同真人

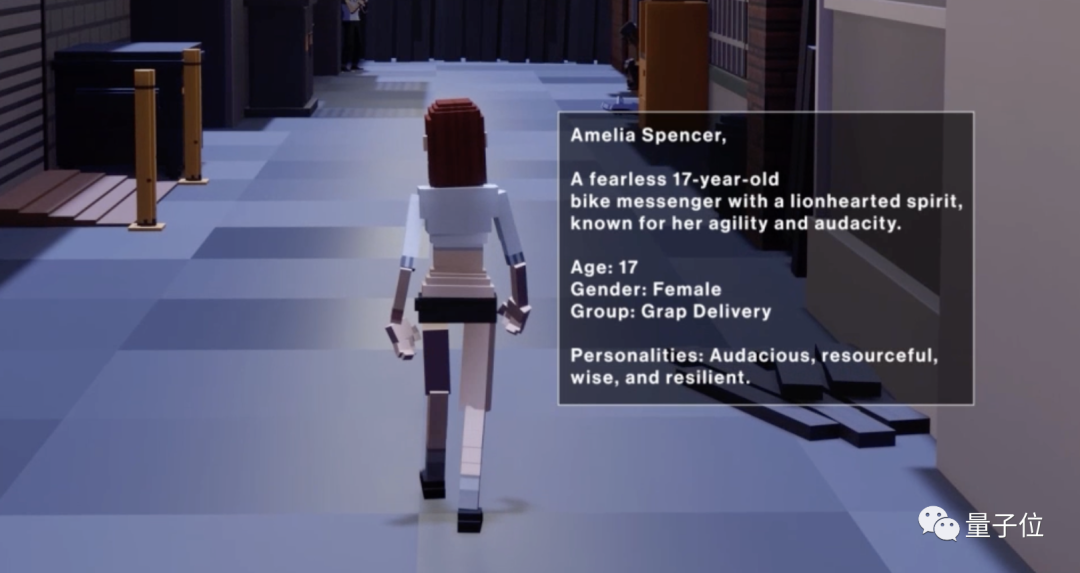

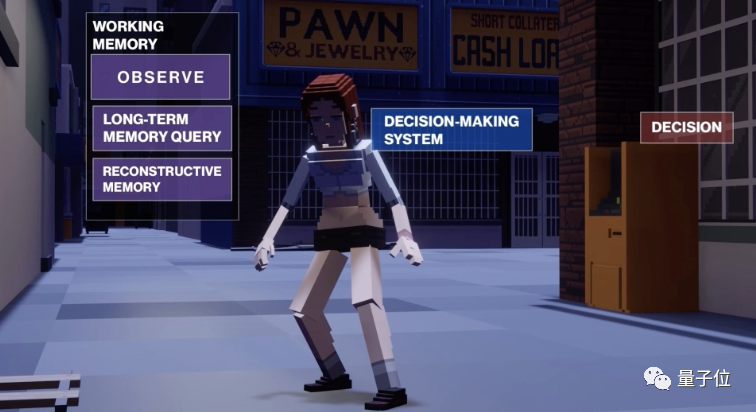

注意看,這個方塊人正在快速思考面前幾位“不速之客”的身份。

原來她是遇到了危險,意識到這一點之后,她馬上開始在腦海中搜索策略。

最終,她的方案是先逃跑然后尋求幫助,并馬上付諸行動。

與此同時,對面的人也在進行著和她一樣的思考……

這樣的一幅場景出現(xiàn)在了《我的世界》當中,而其中所有的人物都是由AI控制的。

他們有著各自的身份設(shè)定,比如前面提到的女孩是一個17歲、智勇雙全的快遞員。

他們擁有記憶和思考能力,在這個以《我的世界》為背景的小鎮(zhèn)中像人類一樣生活。

驅(qū)動他們的,是一款全新的、針對開放世界設(shè)計的、基于語言的AI角色扮演框架LARP。

這里的LA指的是Language Agent,同時LARP又是實時(Live Action)角色扮演的縮寫,可謂是一語雙關(guān)。

除了擁有更高的認知復雜度,相比于傳統(tǒng)的智能體框架,LARP還縮小了智能體與開放世界游戲之間的差距——

這類游戲往往沒有特定的“通關(guān)標準”,而是由玩家在其中自由探索,而傳統(tǒng)的游戲智能體常被用來完成特定目標。

此外,LARP的重點是突出模擬,使得智能體的行為更接近人類,為此研究者甚至特意引入了遺忘機制。

那么,LARP具體如何實現(xiàn)?馬上就來一探究竟。

多模塊協(xié)同控制智能體

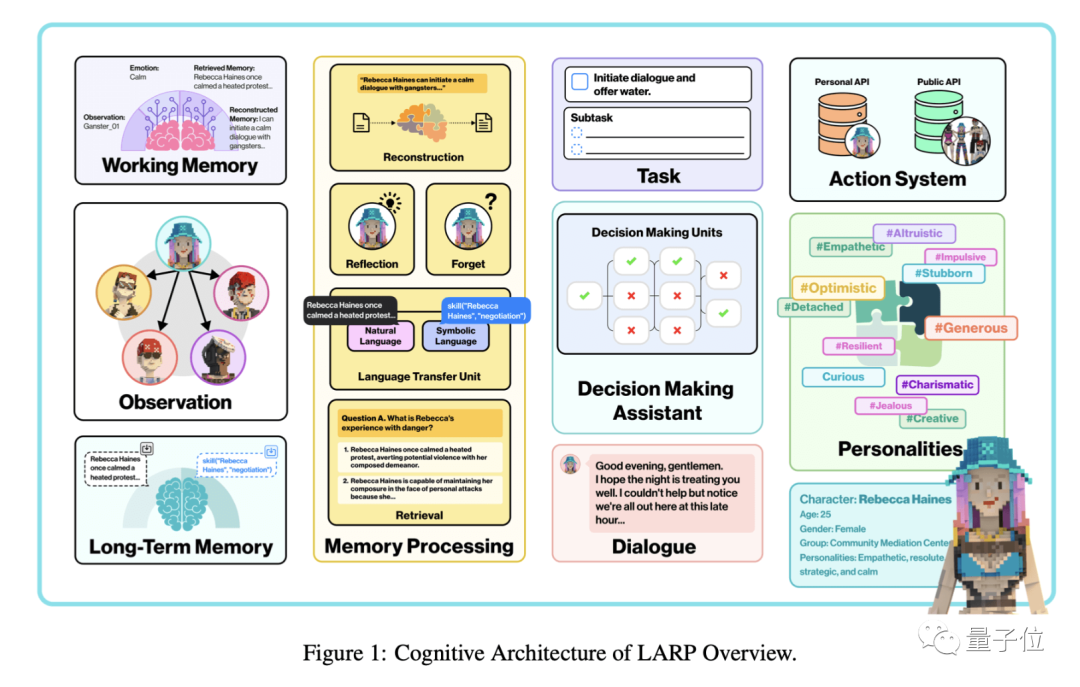

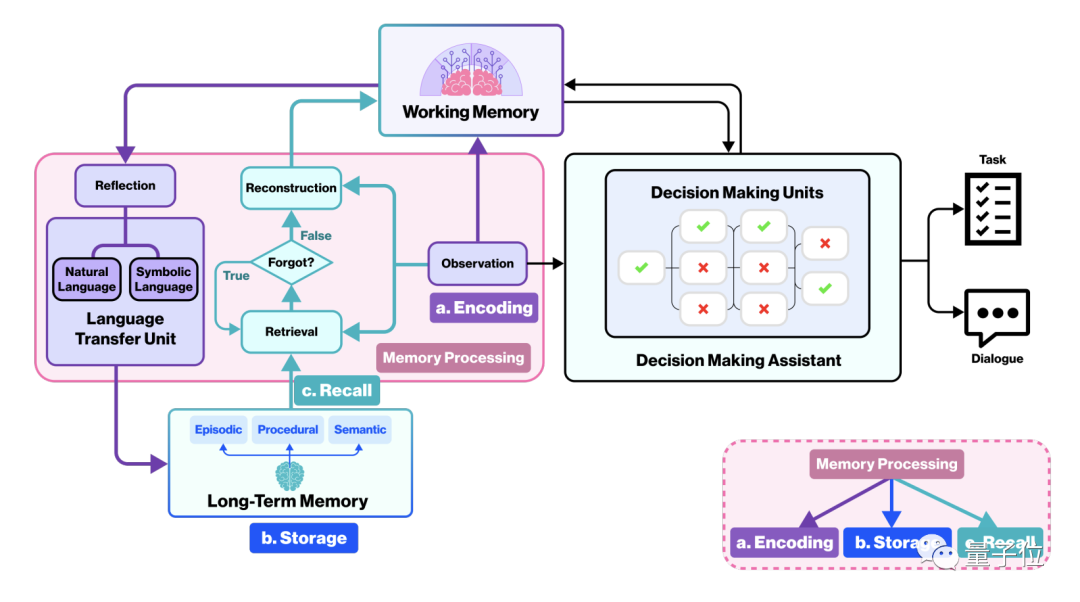

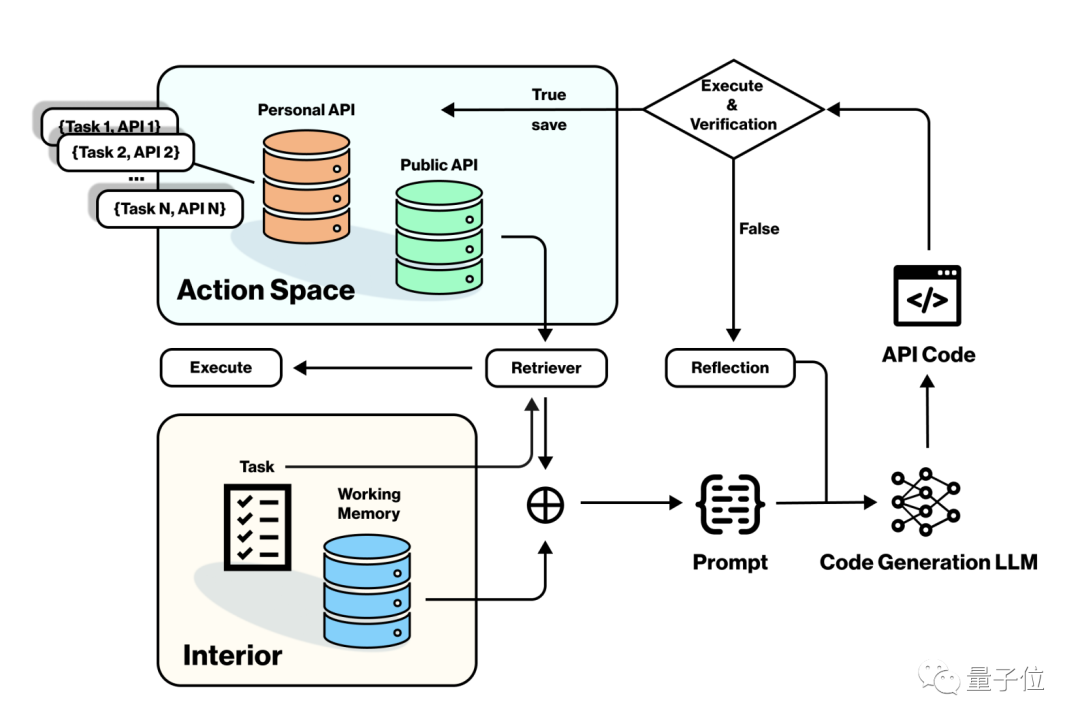

LARP的結(jié)構(gòu)是模塊化的,具體包括了認知、人格、記憶、決策等組成部分。

其中,記憶模塊又由長期記憶、工作(短期)記憶和記憶處理系統(tǒng)三個部分組成。

流程上,角色觀察到的環(huán)境等信息會以自然語言形式輸入記憶處理模塊,經(jīng)過編碼轉(zhuǎn)換并結(jié)合提取到的長期記憶,形成工作記憶;

然后工作記憶會輸入到?jīng)Q策模塊,最終產(chǎn)生決策或?qū)υ拑?nèi)容。

決策模塊的一個特點是會將一項大的目標拆解成子任務,同時利用其中的語言模型確定子任務的執(zhí)行順序。

模型所做出的決策,會通過環(huán)境交互模塊調(diào)用API來執(zhí)行,必要時還會調(diào)用回溯模塊進行代碼重建;

執(zhí)行成功后,角色的新技能會被儲存,成為新的長期記憶。

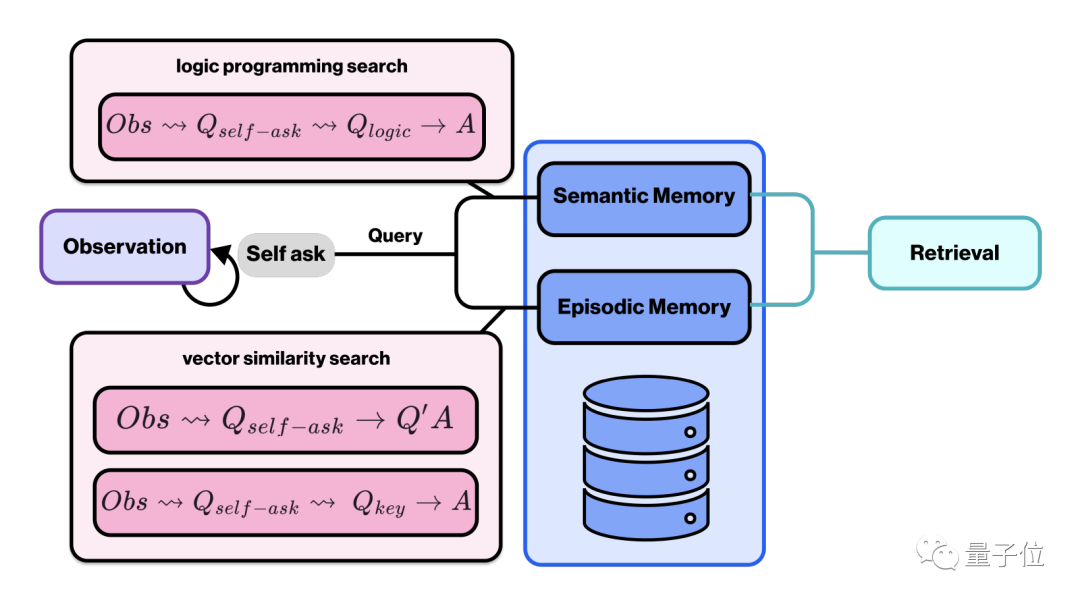

在長期記憶的提取的過程中,人物會根據(jù)觀察到的內(nèi)容進行自我提問,并通過邏輯語句、向量相似度和句子相似度三個維度進行查詢,從而提取答案。

其中邏輯語句用于語義(semantic)記憶的查詢,后兩者則用來查詢情景(episodic)記憶。

語義記憶是關(guān)于世界的一般性概念和事實知識,包含了游戲規(guī)則和相關(guān)世界觀;情景記憶則是游戲中的具體事件,與特定場景和經(jīng)歷相關(guān)。

前者內(nèi)容相對固定,而后者則會根據(jù)Agent的經(jīng)歷不斷積累。

為了讓LARP控制的智能體更像真人,研究團隊還特意引入了隨時間變化的遺忘機制。

當衰減參數(shù)σ超過一定閾值時,記憶提取會失敗,從而模擬遺忘過程,σ的計算方式則是依據(jù)心理學定律設(shè)定的:

σ = αλN (1 + βt) - ψ

λ代表記憶的重要性程度,N表示提取次數(shù),t代表最后一次提取后經(jīng)過的時間,ψ是角色自身的遺忘速率,α和β為縮放參數(shù)

這一公式由心理學家Wayne Wickelgren提出,是對艾賓浩斯遺忘曲線的一個補充。

而在人物性格的塑造上,研究人員在體現(xiàn)不同性格的數(shù)據(jù)集上預訓練出了基礎(chǔ)模型,并用專門構(gòu)建的指令數(shù)據(jù)集進行監(jiān)督微調(diào)。

同時,團隊還為角色的不同能力設(shè)計了多個數(shù)據(jù)集并訓練出了低秩適配模型,并于基礎(chǔ)模型動態(tài)整合,指導決策模塊生成符合人設(shè)的內(nèi)容。

同時,LARP中還設(shè)置了行動驗證和沖突識別模塊,確保模型為agent生成的內(nèi)容受游戲環(huán)境數(shù)據(jù)和先驗知識規(guī)范約束。

目前,LARP的GitHub頁面已經(jīng)建立,不過還處于空倉狀態(tài),代碼暫未發(fā)布。

隨著大模型研究的深入,智能體和群體智能實驗如今已成AI研究最熱門方向之一。

比如去年爆火的斯坦福AI小鎮(zhèn)、清華推出的“AI游戲公司”和“AI狼人殺”,都讓人們看到了多智能體協(xié)同的效益。

關(guān)于智能體的更多內(nèi)容,量子位智庫推出的《2023十大前沿科技報告中》也有詳細介紹。

論文地址:https://arxiv.org/abs/2312.17653