論文遭首屆ICLR拒稿、代碼被過度優化,word2vec作者Tomas Mikolov分享背后的故事

幾天前,NeurIPS 2023 公布了獲獎論文,其中時間檢驗獎頒給了十年前的 NeurIPS 論文「Distributed Representations of Words and Phrases and their Compositionality」。這項工作引入了開創性的詞嵌入技術 word2vec,展示了從大量非結構化文本中學習的能力,推動了自然語言處理新時代的到來。

這篇論文由當時都還在谷歌的 Tomas Mikolov、Ilya Sutskever、Kai Chen、Greg Corrado、Jeffrey Dean 等人撰寫,被引量超過 4 萬次。

不過,Word2vec 首篇論文是 Tomas Mikolov 等同一作者的「Efficient Estimation of Word Representations in Vector Space」。這篇論文的引用量也已經接近 4 萬。

論文地址:https://arxiv.org/abs/1301.3781

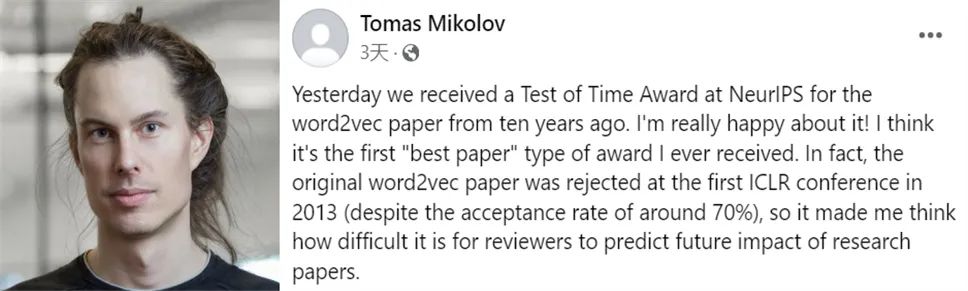

近日,Tomas Mikolov 分享了論文背后更多的故事,包括被首屆 ICLR 拒稿以及之后的進展等。

圖源:https://www.facebook.com/tomas.mikolov

以下為原貼內容,我們做了不改變原意的整理。

我非常高興 word2vec 論文獲得了 NeurIPS 2023 時間檢驗獎,這是我獲得的第一個最佳論文類型的獎項。實際上,word2vec 原始論文在 2013 年首屆 ICLR 會議被拒絕接收了(盡管接收率很高),這讓我想到審稿人預測論文的未來影響是多么困難。

這些年,我聽到了很多關于 word2vec 的評論,正面的還有負面的,但至今沒有在網絡上認真地發表過評論。我覺得研究界正在不斷地被一些研究人員的 PR 式宣傳淹沒,他們通過這樣的方式獲得他人的論文引用和注意力。我不想成為其中的一部分,但 10 年后,分享一些關于論文背后的故事可能會很有趣。

我經常聽到的一個評論是,代碼很難理解,以至于有些人認為是我故意地讓代碼不可讀。但我沒有那么邪惡,代碼最終被過度優化了,因為我等了好幾個月才被批準發布它。我也試圖讓代碼更快更短。回想起來,如果當時團隊中沒有 Greg Corrado 和 Jeff Dean,我懷疑自己是否會獲得批準。我認為 word2vec 可能是谷歌開源的第一個廣為人知的 AI 項目。

在 word2vec 發布一年多后,斯坦福 NLP 小組的 GloVe 項目也引發了很大爭議。雖然該項目從我們的項目中復刻了很多技巧,但總感覺 GloVe 倒倒退了一步:速度較慢,還需要更多內存,生成的向量質量比 word2vec 低。然而,GloVe 是基于在更多數據上預訓練的詞向量發布的,因而很受歡迎。之后,我們在 fastText 項目中修復了相關問題,在使用相同數據進行訓練時,word2vec 比 GloVe 好得多。

盡管 word2vec 是我被引用最多的論文,但我從未認為它是我最有影響力的項目。實際上,word2vec 代碼最初只是我之前項目 RNNLM 的一個子集,我感覺 RNNLM 很快就被人們遺忘了。但在我看來,它應該和 AlexNet 一樣具有革命性意義。

在這里,我列舉一些在 2010 年 RNNLM 中首次展示的想法:遞歸神經網絡的可擴展訓練、首次通過神經語言模型生成文本、動態評估、字符和子詞級別的神經語言建模、神經語言模型自適應(現在稱為微調)、首個公開可用的 LM 基準。

我發布了第一項研究,顯示當一切正確完成時,訓練數據越多,神經網絡就能比 n-gram 語言模型更勝一籌。這在今天聽起來是顯而易見的,但在當時這被廣泛認為是不可能的,甚至大多數谷歌員工都認為,數據越多,除了 n-gram 和平滑技術外,其他任何工作都是徒勞的。

我很幸運能在 2012 年加入谷歌 Brain 團隊,那里有很多大規模神經網絡的「信徒」,他們允許我參與 word2vec 項目,展示了它的潛力。但我不想給人留下到這里就足夠完美的印象。在 word2vec 之后,作為后續項目,我希望通過改進谷歌翻譯來普及神經語言模型。我確實與 Franz Och 和他的團隊開始了合作,在此期間我提出了幾種模型,這些模型可以補充基于短語的機器翻譯,甚至可以取代它。

其實在加入谷歌之前,我就提出了一個非常簡單的想法,通過在句子對(比如法語 - 英語)上訓練神經語言模型來實現端到端的翻譯,然后在看到第一句話后使用生成模式生成翻譯。這對短句子效果很好,但在長句子上就不那么奏效了。

我在谷歌 Brain 內部多次討論過這個項目,主要是與 Quoc 和 Ilya,在我轉到 Facebook AI 后他們接手了這個項目。我感到非常意外的是,他們最終以「從序列到序列(sequence to sequence)」為名發表了我的想法,不僅沒有提到我是共同作者,而且在長長的致謝部分提及了谷歌 Brain 中幾乎所有的人,唯獨沒有我。那時是資金大量涌入人工智能領域的時期,每一個想法都價值連城。看到深度學習社區迅速變成某種權力的游戲,我感到很悲哀。

總之,多年來人們對語言模型的興趣增長緩慢,但自從 ChatGPT 發布以來,人們對它的興趣呈爆炸式增長,看到這么多人終于將人工智能和語言聯系在一起,真的很酷。我們還沒有到達那個階段,我個人認為我們需要有新的發現來突破神經模型的泛化極限。我們無疑生活在一個激動人心的時代。但是,讓我們不要過分信任那些想要壟斷基于數十位甚至數百位科學家辛勤工作的技術,同時聲稱這一切都是為了人類的利益的人。

不過,Tomas Mikolov 的發言也讓人感嘆,他也要步 LSTM 之父 Jürgen Schmidhuber 的后塵嗎?

圖源:https://twitter.com/agihippo/status/1736107652407849208

你們怎么看呢?