一條磁力鏈接席卷AI圈,87GB種子直接開源8x7B MoE模型

「高端」的開源,往往采用最樸素的發布方式。

昨天,Mistral AI 在 X 平臺甩出一條磁力鏈接,宣布了新的開源動作。

沒有長篇官方博客,沒有刻意加速的 Demo,這家公司算是當下大模型領域的「一股清流」。

打開一看,發現是接近 87 GB 的種子:

參數配置什么樣?很多人放棄了周末,第一時間下載運行起來。

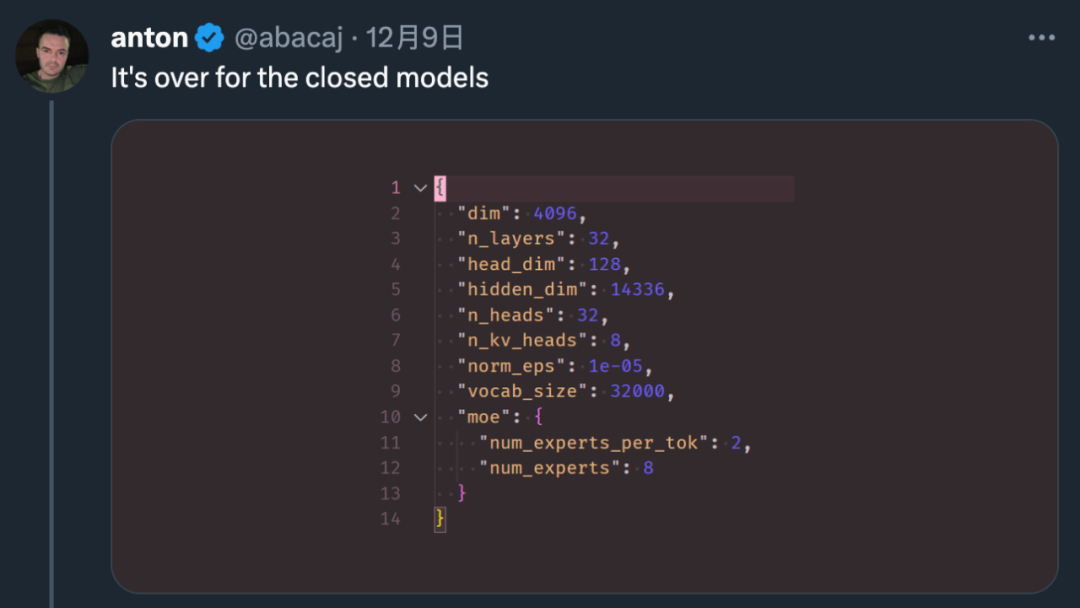

看上去,Mistral 8x7B 使用了與 GPT-4 非常相似的架構,但是「縮小版」:

- 8 個專家總數,而不是 16 名(減少一半)

- 每個專家為 7B 參數,而不是 166B(減少 24 倍)

- 42B 總參數(估計)而不是 1.8T(減少 42 倍)

- 與原始 GPT-4 相同的 32K 上下文

在發布后 24 小時內,已經有開發者做出了在線體驗網站:https://replicate.com/nateraw/mixtral-8x7b-32kseqlen

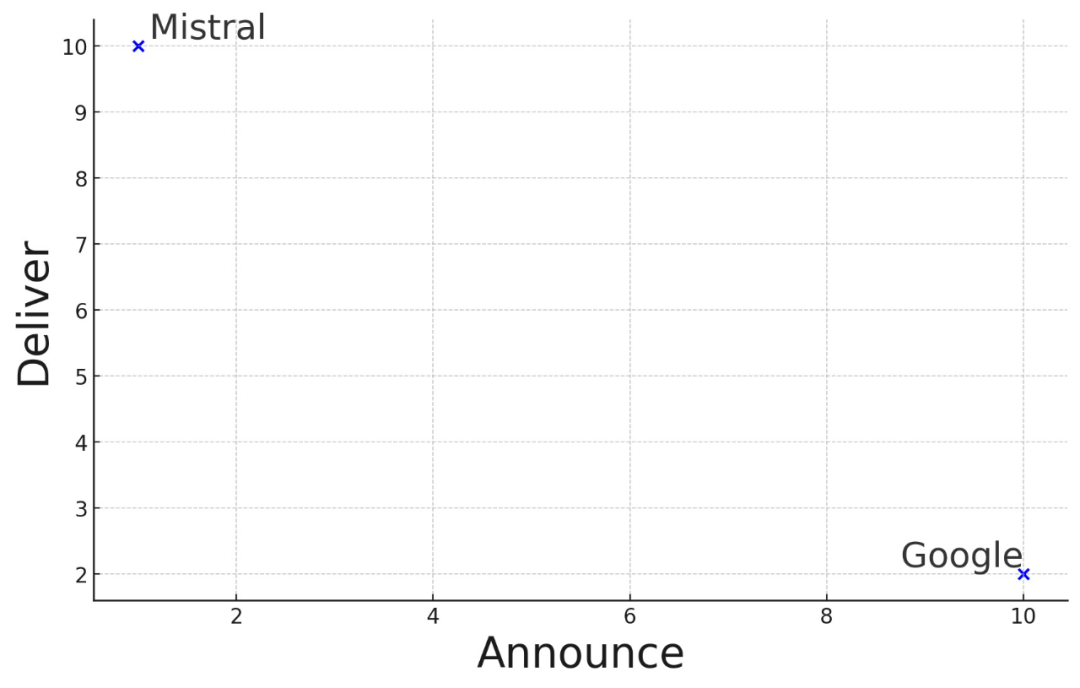

有研究者稱:「閉源大模型走到結局了。」

這周已經引發群嘲的谷歌,也再次被 Cue 到:

專家混合 (MoE) 是 LLM 中常用的一種技術,旨在提高其效率和準確性。這種方法的工作原理是將復雜的任務劃分為更小、更易于管理的子任務,每個子任務都由專門的迷你模型或「專家」處理。

具體來說,「專家層」是較小的神經網絡,經過訓練在特定領域具有高技能,每個專家處理相同的輸入,但處理方式與其特定的專業相一致;「門控網絡」是 MoE 架構的決策者,能評估哪位專家最適合給定的輸入數據。網絡計算輸入與每個專家之間的兼容性分數,然后使用這些分數來確定每個專家在任務中的參與程度。

我們都知道,OpenAI 團隊一直對 GPT-4 的參數量和訓練細節守口如瓶。早些時候,有人爆料 GPT-4 是采用了由 8 個專家模型組成的集成系統。后來又有傳聞稱,ChatGPT 也只是百億參數級的模型(大概在 200 億左右)。

傳聞無從證明,但 Mistral 8x7B 可能提供了一種「非常接近 GPT-4」的開源選項。從模型元數據中可以看出,對于每個 token 的推理,Mistral 8x7B 僅使用 2 個專家。

更讓人感覺有趣的是,這是該公司官方賬號自開通以來發布的第三條內容,兩次重要發布均無文字說明,配圖什么的更是不存在:

9 月底的那條鏈接發布的是 Mistral 7B,該模型至今仍被稱為「最好的 7B 模型」,在每個基準測試中都優于 Llama-2 13B,并且在代碼、數學和推理方面優于 LLaMA-1 34B。

Mistral AI 成立于 2023 年 5 月,是一家法國人工智能初創公司,也是為數不多來自歐洲的大模型開源領域的明星團隊。

Mistral AI 曾在 6 月獲得了創紀錄的 1.18 億美元種子輪融資,還是在僅有 7 頁 PPT 的情況下,據說這是歐洲歷史上最大的種子輪融資。

Mistral AI 團隊成員。

公司創始人之一 Arthur Mensch 曾在 10 月份向《金融時報》表示,Mistral AI 的技術比美國的一些強大競爭對手開發的技術更高效、成本更低。

技術實力的優越,也為這家公司帶來了投資者的持續關注。

近日,《金融時報》報道了 Mistral AI 新一輪融資的動態:新一輪融資約 4 億歐元,主要由股權組成,可能在下周官宣。目前,公司的最新估值在 20 億歐元左右。

知情人士透露,新一輪融資由硅谷著名風投 Andreessen Horowitz 牽頭,其他參與者還包括英偉達、Salesforce、General Catalyst、法國巴黎銀行等。

Mistral AI 的其他投資者還包括谷歌前 CEO 埃里克?施密特 (Eric Schmidt)、法國電信億萬富翁澤維爾?尼爾 (Xavier Niel) 和法國國家支持的投資銀行 Bpifrance。

這篇報道還提到,Arthur Mensch 表示「雖然公司尚未賺到任何錢,但預計這種情況將在年底前發生改變,因為該公司準備了一個新平臺,供客戶訪問其人工智能模型。」

參考鏈接:https://www.ft.com/content/ea29ddf8-91cb-45e8-86a0-f501ab7ad9bb