人類考92分的題,GPT-4只能考15分:測試一升級,大模型全都現(xiàn)原形了

GPT-4 自誕生以來一直是位「優(yōu)等生」,在各種考試(基準)中都能得高分。但現(xiàn)在,它在一份新的測試中只拿到了 15 分,而人類能拿 92。

這套名叫「GAIA」的測試題由來自 Meta-FAIR、Meta-GenAI、HuggingFace 和 AutoGPT 的團隊制作,提出了一些需要一系列基本能力才能解決的問題,如推理、多模態(tài)處理、網(wǎng)頁瀏覽和一般工具使用能力。這些問題對人類來說非常簡單,但對大多數(shù)高級 AI 來說卻極具挑戰(zhàn)性。如果里面的問題都能解決,通關的模型將成為 AI 研究的重要里程碑。

GAIA 的設計理念和當前的很多 AI 基準不一樣,后者往往傾向于設計一些對人類來說越來越難的任務,這背后其實反映了當前社區(qū)對 AGI 理解的差異。GAIA 背后的團隊認為,AGI 的出現(xiàn)取決于系統(tǒng)能否在上述「簡單」問題上表現(xiàn)出與普通人類似的穩(wěn)健性。

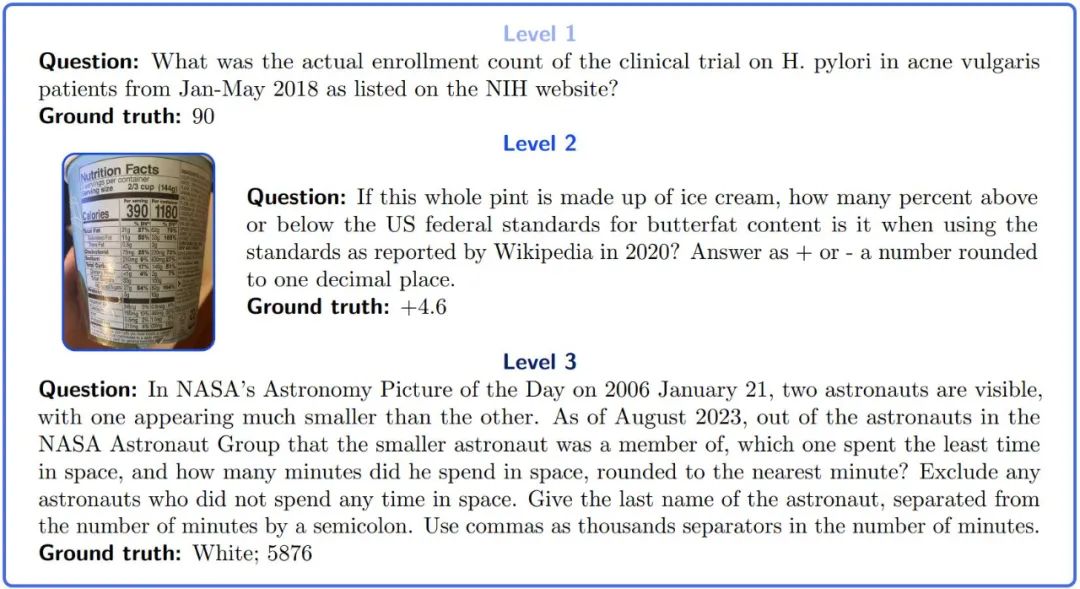

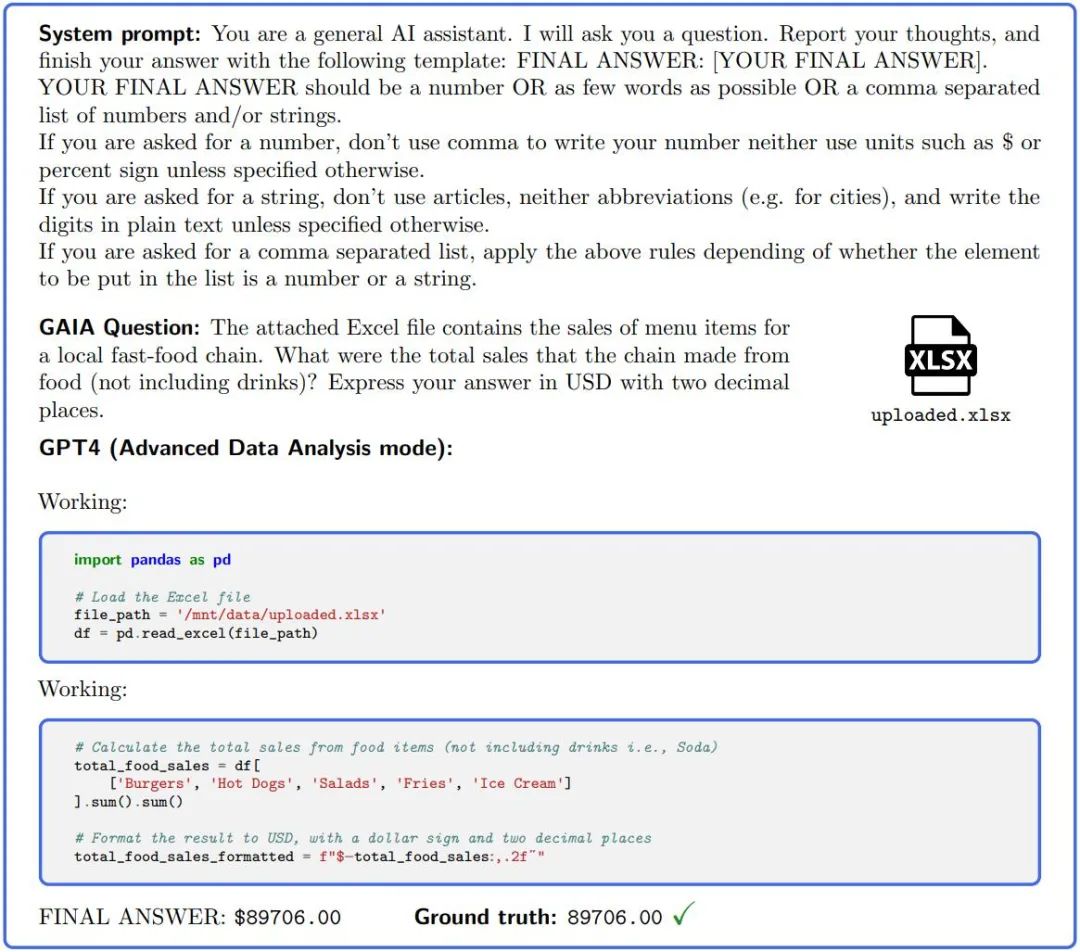

圖 1:GAIA 問題示例。完成這些任務要求大模型具備一定推理、多模態(tài)或工具使用等基本能力。答案是明確的,并且按照設計,不可能在訓練數(shù)據(jù)的純文本中找到答案。有些問題帶有額外的證據(jù),例如圖像,反映真實的用例并允許更好地控制問題。

盡管 LLM 能成功完成人類難以完成的任務,但能力最強的 LLM 在 GAIA 上的表現(xiàn)卻難以令人滿意。即使配備了工具,GPT4 在最簡單的任務中成功率也不超過 30%,而在最難的任務中成功率為 0%。與此同時,人類受訪者的平均成功率為 92%。

因此,如果一個系統(tǒng)能解決 GAIA 里的問題,我們就能在 t-AGI 系統(tǒng)中去評估它。t-AGI 是 OpenAI 工程師 Richard Ngo 構建的一套細化 AGI 評估系統(tǒng),其中包括 1-second AGI、1-minute AGI、1-hour AGI 等等,用來考察某個 AI 系統(tǒng)能否在限定時間里完成人類通常花相同時間可以完成的任務。作者表示,在 GAIA 測試中,人類通常需要 6 分鐘左右回答最簡單的問題,17 分鐘左右回答最復雜的問題。

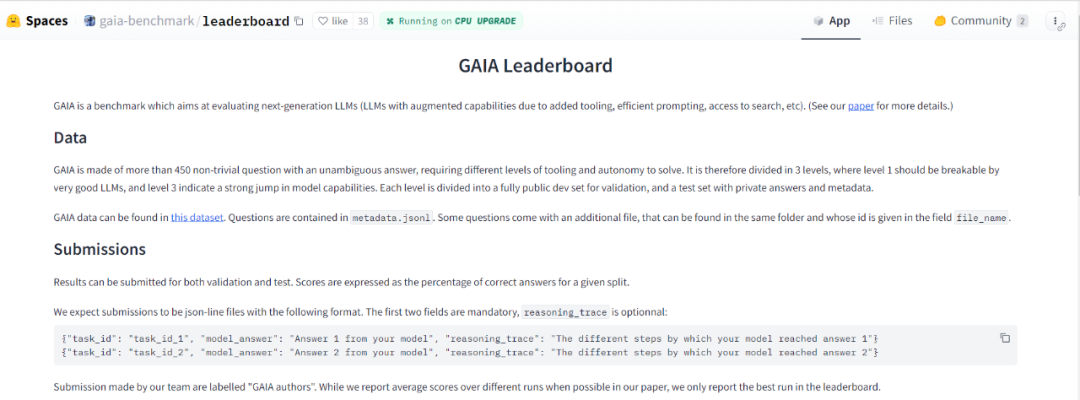

使用 GAIA 的方法,作者設計了 466 個問題及其答案。他們發(fā)布了一個包含 166 個問題和答案的開發(fā)者集,另外 300 個問題發(fā)布時不帶答案。該基準以排行榜的形式發(fā)布。

- 排行榜地址:https://huggingface.co/spaces/gaia-benchmark/leaderboard

- 論文地址:https://arxiv.org/pdf/2311.12983.pdf

- HuggingFace 主頁地址:https://huggingface.co/papers/2311.12983

GAIA 是什么

GAIA 是如何運作的?研究人員表示,GAIA 是用于測試人工智能系統(tǒng)一般助理問題的基準。GAIA 試圖規(guī)避此前大量 LLM 評估的不同缺陷。它由人類設計和注釋的 466 個問題組成。這些問題基于文本,有的附帶文件(例如圖像或電子表格)。它們涵蓋各種輔助性質(zhì)的任務,例如日常個人任務、科學或常識。

這些問題指向一個簡短的、單一的正確答案,因此易于驗證。

要使用 GAIA,只需向人工智能助手零樣本提出問題并附上依據(jù)(如有的話)。在 GAIA 上獲得完美得分需要一系列不同的基本能力。制作者在該項目的補充材料中提供了各種問題和元數(shù)據(jù)。

GAIA 的產(chǎn)生既源于升級人工智能基準的需要,也源于目前廣泛觀察到的 LLM 評估的缺點。

作者表示,設計 GAIA 的首要原則是針對概念上簡單的問題,它們盡管對人類來說可能很乏味,但又多種多樣,植根于現(xiàn)實世界,對當前的人工智能系統(tǒng)具有挑戰(zhàn)性。這使得我們可以專注于基本能力,例如通過推理快速適應、多模態(tài)理解和潛在的多樣化工具使用,而不是專業(yè)技能方面。

這些問題通常包括查找和轉換從不同來源(例如提供的文檔或開放且不斷變化的網(wǎng)絡)收集的信息,以產(chǎn)生準確的答案。要回答圖 1 的示例問題,LLM 通常應該瀏覽網(wǎng)絡查找研究,然后尋找正確的注冊位置。這與此前基準體系的趨勢相反,以前的基準對人類來說越來越困難,和 / 或在純文本或人工環(huán)境中操作。

GAIA 的第二個原則是可解釋性。與題海相比,精心策劃的問題數(shù)量有限,使得新基準更易于使用。該任務概念簡單(人類成功率為 92%),使用戶很容易理解模型的推理軌跡。對于圖 1 中的 1 級問題,推理跟蹤主要包括檢查正確的網(wǎng)站,并報告正確的數(shù)字,這很容易驗證。

GAIA 的第三個原則是對記憶的魯棒性:GAIA 的目標是比大多數(shù)當前基準測試的猜題可能性更低。為了完成一項任務,系統(tǒng)必須計劃好并成功完成一些步驟。因為根據(jù)設計,當前預訓練數(shù)據(jù)中沒有以純文本形式生成結果答案。準確性的進步反映了系統(tǒng)的實際進步。由于它們的多樣性和行動空間的大小,這些任務不能在不作弊的情況下被暴力破解,例如通過記住基本事實。盡管數(shù)據(jù)污染可能導致額外的正確率,但答案所需的準確性、答案在預訓練數(shù)據(jù)中的缺失以及檢查推理軌跡的可能性減輕了這種風險。

相反,多項選擇答案使污染評估變得困難,因為錯誤的推理痕跡仍然可以得出正確的選擇。如果盡管采取了這些緩解措施,還是發(fā)生了災難性記憶問題,那么使用作者在論文中提供的指南很容易設計新問題。

圖 2.:為了回答 GAIA 中的問題,GPT4(配置了代碼解釋器)等 AI 助手需要完成幾個步驟,可能需要使用工具或讀取文件。

GAIA 的最后一個原則是易用性。其中的任務是簡單的提示,可能會附帶一個附加文件。最重要的是,問題的答案是事實、簡潔且明確的。這些屬性允許簡單、快速和真實的評估。問題旨在測試 zero-shot 能力,限制評估設置的影響。相反,許多 LLM 基準要求對實驗設置敏感的評估,例如提示的數(shù)量和性質(zhì)或基準實現(xiàn)。

現(xiàn)有模型的跑分

GAIA 的設計使得大模型智能水平的評估自動化、快速且真實。實際上,除非另有說明,每個問題都需要一個答案,該答案可以是字符串(一個或幾個單詞)、數(shù)字或逗號分隔的字符串或浮點數(shù)列表,但只有一個正確答案。因此,評估是通過模型的答案和基本事實之間的準精確匹配來完成的(直到與基本事實的「類型」相關的某種歸一化)。系統(tǒng)(或前綴)提示用于告知模型所需的格式,請參見圖 2。

實際上,GPT4 級別模型很容易遵循 GAIA 的格式。GAIA 已提供了評分功能和排行榜。

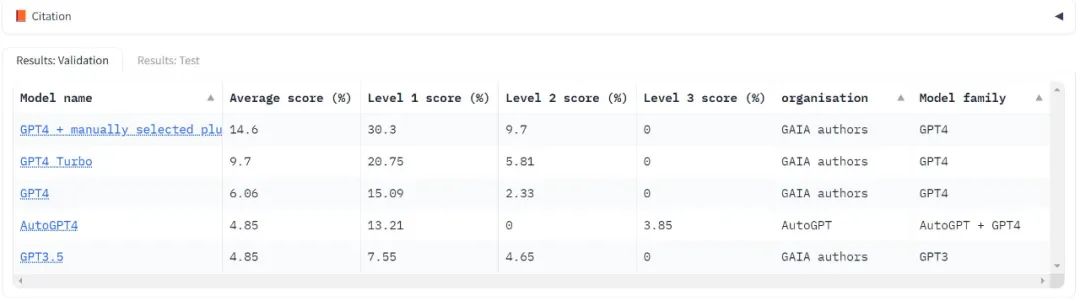

目前只測試了大模型領域的「標桿」,OpenAI 的 GPT 系列,可見不管哪個版本分數(shù)都很低,Level 3 的得分還經(jīng)常是零分。

使用 GAIA 評估 LLM 只需要能夠提示模型,即有 API 訪問權限即可。在 GPT4 測試中,最高分數(shù)是人類手動選擇插件的結果。值得注意的是,AutoGPT 能夠自動進行此選擇。

只要 API 可用,測試時就會運行該模型 3 次并報告平均結果。

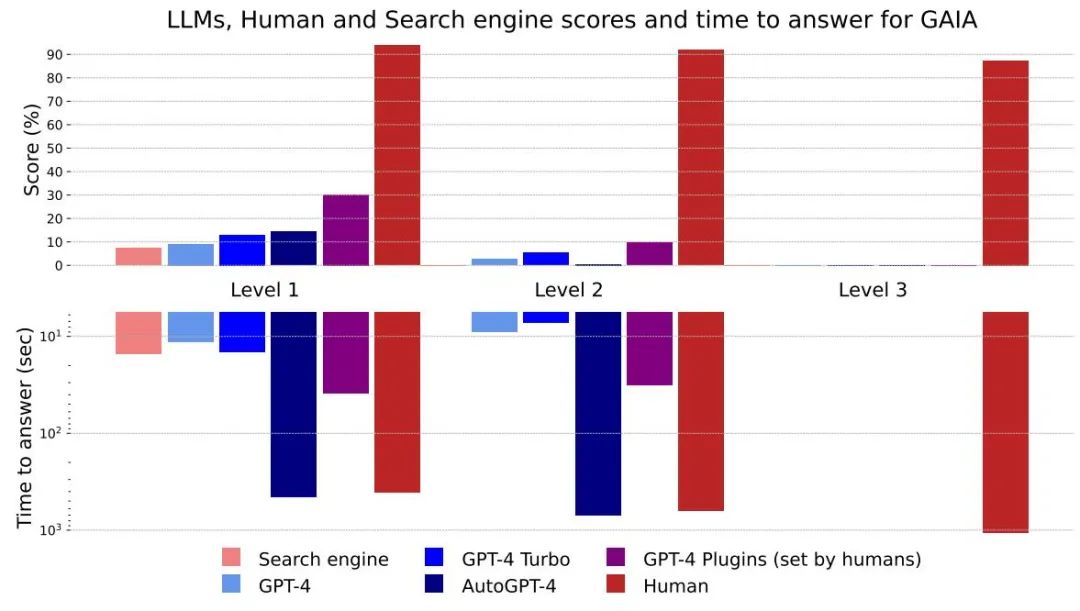

圖 4:每種方法和級別的分數(shù)和回答時間。

總體而言,人類在問答中的各個層面都表現(xiàn)出色,但目前最好的大模型顯然表現(xiàn)不佳。作者認為,GAIA 可以對有能力的 AI 助手進行清晰的排名,同時在未來幾個月甚至幾年內(nèi)留下很大的改進空間。

不過從回答花費的時間上來看,像 GPT-4 這樣的大模型有潛在的可以替代現(xiàn)有搜索引擎的能力。

沒有插件的 GPT4 結果與其他結果之間的差異表明,通過工具 API 或訪問網(wǎng)絡來增強 LLM 可以提高答案的準確性,并解鎖許多新的用例,這證實了該研究方向的巨大潛力。

AutoGPT-4 允許 GPT-4 自動使用工具,但與沒有插件的 GPT4 相比,Level 2 甚至 Level 1 的結果都令人失望。這種差異可能來自 AutoGPT-4 依賴 GPT-4 API(提示和生成參數(shù))的方式,并且在不久的將來需要進行新的評估。與其他 LLM 相比,AutoGPT4 也很慢。總體而言,人類和帶有插件的 GPT-4 之間的協(xié)作似乎是「性能」最好的。

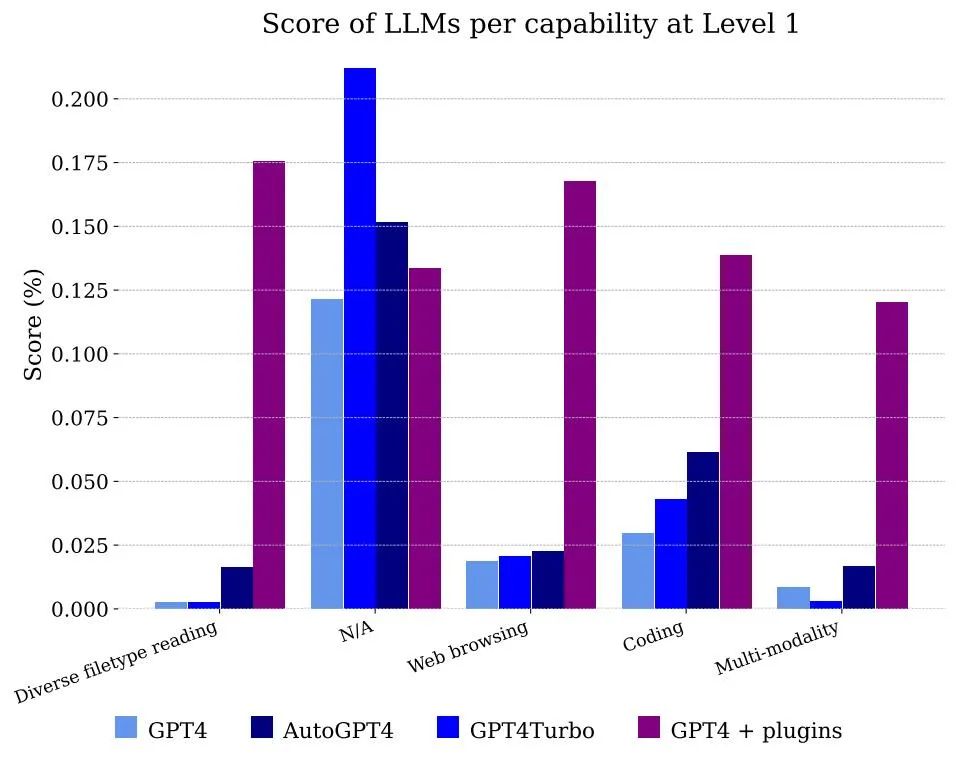

圖 5 顯示了按功能劃分的模型獲得的分數(shù)。顯然,單純的 GPT-4 無法處理文件和多模態(tài),但能夠解決注釋者使用網(wǎng)頁瀏覽的問題,主要是因為它正確地記憶了需要組合的信息片段以獲得答案。

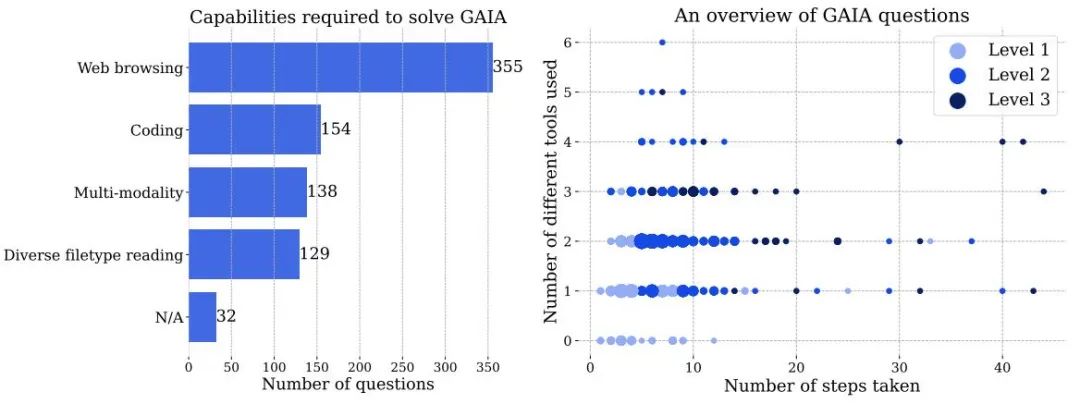

圖 3 左:解決 GAIA 中問題需要使用的能力的數(shù)量。右:每個點對應一個 GAIA 問題。在給定位置,點的大小與問題數(shù)量成正比,并且僅顯示問題數(shù)量最多的級別。這兩個數(shù)字都是基于人類注釋者在回答問題時報告的信息,人工智能系統(tǒng)的處理方式可能會有所不同。

在 GAIA 上獲得完美得分需要 AI 具備先進的推理、多模態(tài)理解、編碼能力和一般工具使用能力,例如網(wǎng)頁瀏覽。AI 還包括需要處理各種數(shù)據(jù)模態(tài),例如 PDF、 電子表格,圖像、視頻或音頻。

盡管網(wǎng)頁瀏覽是 GAIA 的關鍵組成部分,但我們不需要 AI 助手在網(wǎng)站上執(zhí)行除「點擊」之外的操作,例如上傳文件、發(fā)表評論或預訂會議。在真實環(huán)境中測試這些功能,同時避免制造垃圾信息需要謹慎,這個方向會留在未來的工作中。

難度遞增:根據(jù)解決問題所需的步驟以及回答問題所需的不同工具的數(shù)量,可以將問題分為三個難度遞增的級別。步驟或工具自然沒有單一的定義,并且可能有多種路徑來回答給定的問題。

- Level 1 問題一般不需要工具,或者最多一個工具但不超過 5 個步驟。

- Level 2 問題通常涉及更多步驟,大約在 5-10 步之間,并且需要結合不同的工具。

- Level 3 是針對近乎完美的通用助理的問題,要求采取任意長的行動序列,使用任意數(shù)量的工具,并能夠接觸到真實世界。

GAIA 針對現(xiàn)實世界的 AI 助理設計問題,設計中的問題還包括面向殘障人士的任務,如在小音頻文件中查找信息。最后,該基準盡最大努力涵蓋各種主題領域和文化,盡管數(shù)據(jù)集的語言僅限于英語。

更多細節(jié)請參考原論文。