效果超越SDXL!港中大博士生推出超真實人像合成工具,訓練用了3.4億張圖

為了讓AI畫出的人更加逼真,港中大博士生用了3.4億張圖像專門訓練畫人。

人物的表情、姿態,環境的空間關系、光線都能合理布局,可謂立體感十足。

就連爆火的SDXL也不是它的對手,話不多說,直接上圖!

這個模型的名字叫HyperHuman,主打的就是一個真實立體。

它解決了Stable Diffusion等傳統AI繪圖工具在畫人時圖像不連貫、姿態不自然的問題。

而且不僅畫得好,也更加“聽話”,畫出的內容能更好地匹配提示詞。

那么下面就來具體看看HyperHuman都能創作出哪些作品吧!

無論是孩子還是老人,各個年齡段的人人物形象HyperHuman都可以畫。

人物的動作、表情自然,空間關系看著也很合理。

不僅是圖本身看上去真實,和提示文本的匹配也十分精確。

人物之外,HyperHuman能繪制出的場景類型也多種多樣。

無論是單人還是多人,是滑雪或者沖浪……

如果和其他模型對比一下的話……

很明顯,在這組提示詞中,其他模型基本上都沒能正確畫出停止標志,而HyperHuman則正確地繪制了出來。

A man on a motorcycle that is on a road that has grass fields on both sides and a stop sign.

而在這一組中,其他模型的作品或者不知所云,或者出現各種細節問題,更有甚者畫出的人長了三只腳,但HyperHuman依舊是穩定發揮。

Mastering the art of skateboarding is profoundly beneficial.

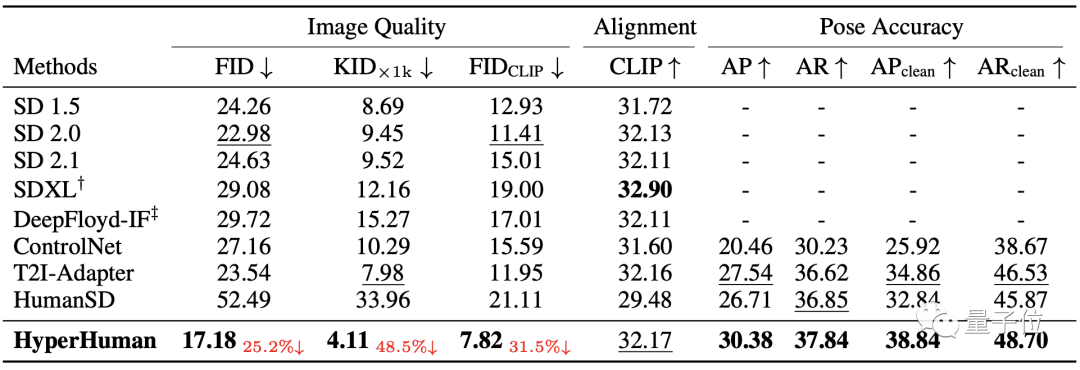

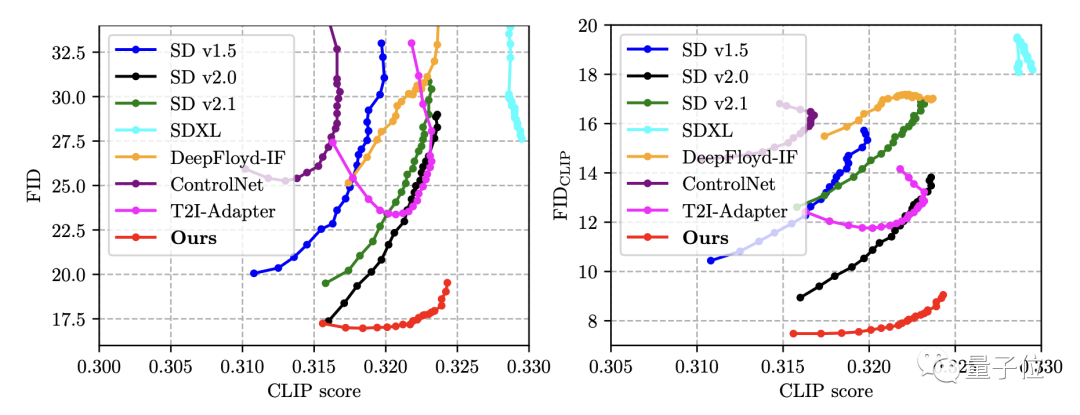

不僅是直觀感受,在數據上HyperHuman也是全面碾壓包括SD2.0在內的一眾競爭對手。

圖像質量方面,HyperHuman的FID、KID兩項指標(均為數值越低效果越好)都超過了其他模型四分之一以上。

姿勢準確度上,HyperHuman的兩項評分也明顯勝過了ControlNet等其他模型。

那么,HyperHuman又是如何實現的呢?

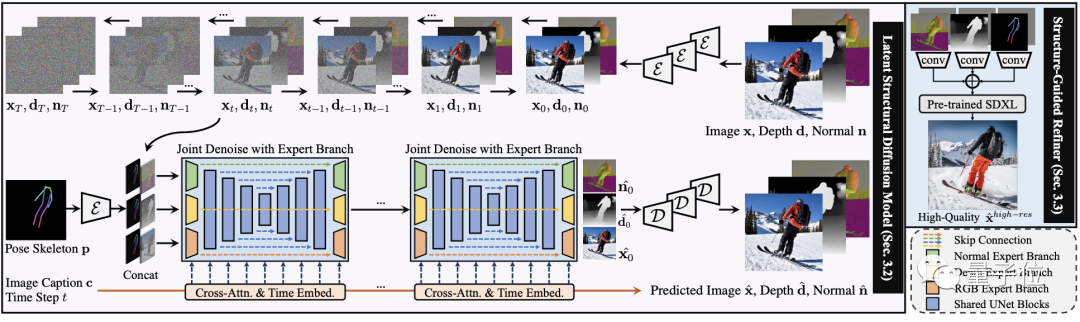

聯合學習,分步生成

為了提高HyperHuman的效果,研究團隊一共提出了兩個思路。

首先是同時學習圖片的顏色、深度圖和法線圖。

顏色反映外觀,深度圖反映物體位置,法線圖反映表面角度。將它們一起學習,可以讓模型更好地理解圖片內容。

第二點則是分階段生成,先使用文本和骨架點作為條件,生成顏色、深度和法線三者的初步合成結果。

然后以前面生成的條件作為指引,生成更高分辨率和質量的圖片。

具體實現上,HyperHuman和SDXL一樣也是采用擴散模型。

具體而言,HyperHuman使用的是“潛在結構(latent structal)”模型。

它的核心包括以下兩個模塊:

- 聯合去噪模塊:具有多個輸入輸出分支的統一網絡結構,在顏色、深度和法線圖三個維度同時去除噪聲。

- 結構指導模塊:用上一步產生的結果作為條件和指引,實現結構到紋理的精細化生成。

此外,為了提高魯棒性,模型在生成過程中還會選擇的的對一些條件進行取舍。

訓練數據方面,開發者將LAION-2B和COYO兩個數據集中的公開資源進行整合并處理、標注,得到了約3.4億張圖像的HumanVerse數據集。

結果在基于COCO 2014數據集的多個繪圖模型橫評中,HyperHuman(紅色)都取得了最佳成績,如果考慮文本匹配度,HyperHuman更是一騎絕塵。

△FID數值越低成績越好

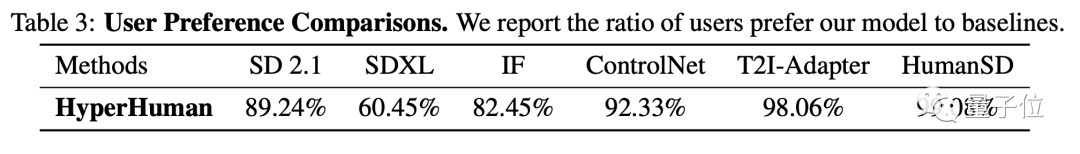

除了測試數據,研究人員還招募了100名用戶,調查了他們更青睞于哪種模型的作品。

他們被要求選出更逼真、質量更好的圖像,結果和另外多種模型相比,HyperHuman都更受歡迎。

作者簡介

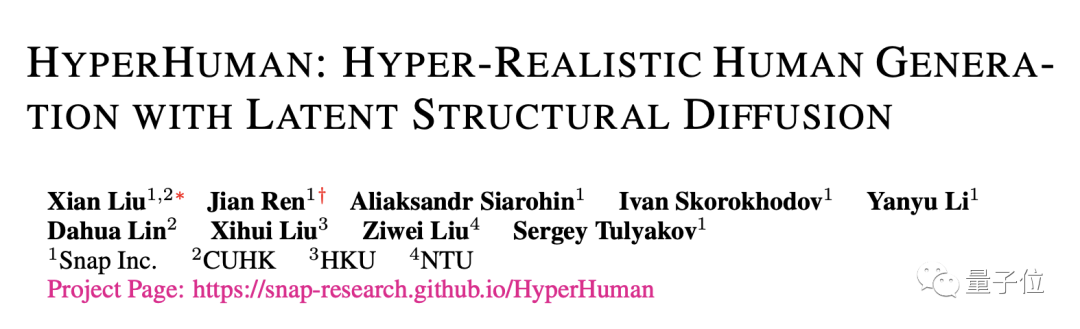

HyperHuman論文第一作者是香港中文大學博士生Xian Liu。

HyperHuman是他在Snap公司實習期間完成的,Snap的Sergey Tulyakov等人也參與了本項目。

此外還有香港大學和南洋理工大學的學者對HyperHuman亦有貢獻。